Antworten Nr. 1

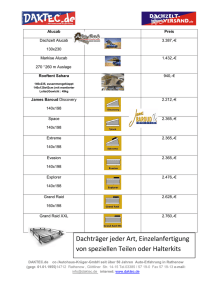

Werbung

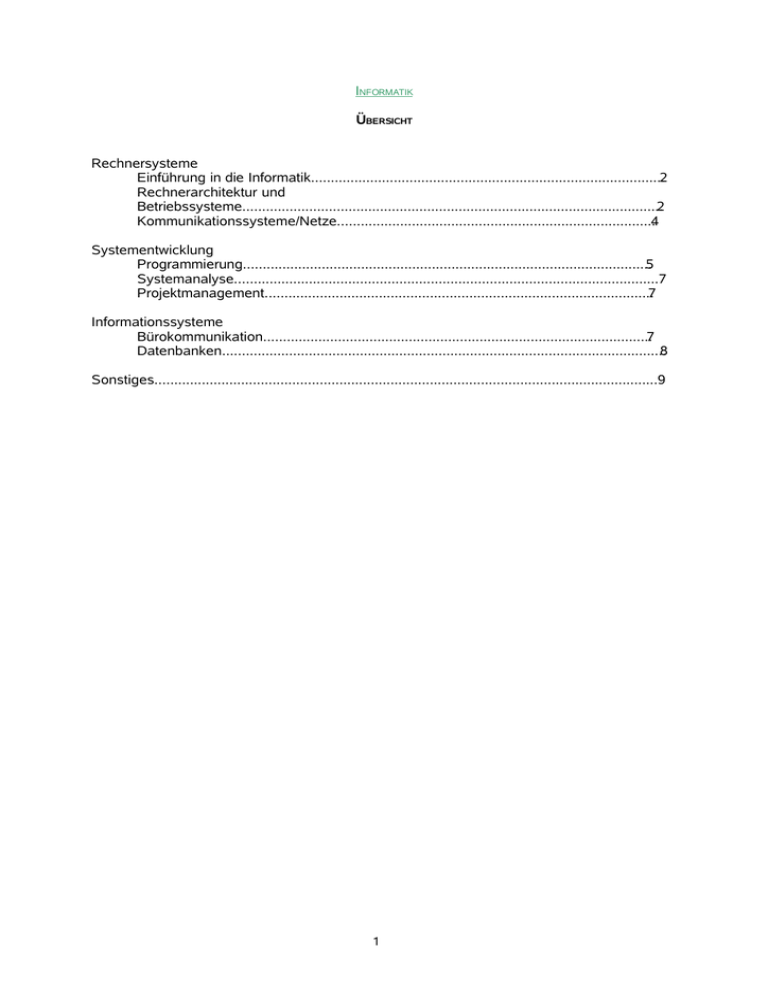

INFORMATIK

ÜBERSICHT

Rechnersysteme

Einführung in die Informatik..........................................................................................2

Rechnerarchitektur und

Betriebssysteme...........................................................................................................2

Kommunikationssysteme/Netze.................................................................................4

Systementwicklung

Programmierung........................................................................................................5

Systemanalyse............................................................................................................7

Projektmanagement...................................................................................................7

Informationssysteme

Bürokommunikation...................................................................................................7

Datenbanken.................................................................................................................8

Sonstiges................................................................................................................................9

1

Rechnersysteme

Einführung in die Informatik

1. Wie erfolgt die Qualitätssicherung bei Software?

Durch Testverfahren für Software

Beim sog. Blackbox Test wird das System als schwarzer Kasten betrachtet,

dessen innere Struktur und Funktionalität dem Tester verborgen bleibt. Es ist deswegen

auch kein Zugriff auf interne Operationen und Zustände von außen

möglich, so dass

sich der Tester auf die Betrachtung des Ein-/Ausgabeverhaltens beschränken muss.

Testfälle können somit nur anhand extern sichtbarer

Schnittstellen und der

Spezifikation des Testobjekts abgeleitet werden.

Beim WhiteBox Testverfahren stehen dem Tester, im Gegensatz zum Black Box

Verfahren, Informationen über den internen Aufbau des Testobjekts zur

Verfügung. In der Regel sind solche Informationen Codedokumente, so dass der

White-Box Test auch als sog. “codebasierter Test” bezeichnet wird.

2. Erläutern Sie die von – Neumann – Architektur!

Folgende drei Eigenschaften kennzeichnen das Modell:

1. Ein (zentralgesteuerter) Rechner besteht aus drei Grundbestandteilen:

o

o

o

Zentraleinheit (Central Processing Unit, kurz CPU)

Speicher

Ein-/Ausgabeeinheit (I/O)

Die Bestandteile sind durch sogenannte Busse verbunden.

2. Die Struktur des Rechners ist unabhängig von einem speziellen zu bearbeitenden

Problem. Für jedes Problem wird ein neues Programm in den Speicher geladen.

Diese Eigenschaft hat zu der Bezeichnung programmgesteuerter Universalrechner

geführt.

3. Programme sowie die Daten, die von den Programmen benötigt werden, sind im

gleichen Speicher abgelegt. Der Speicher besteht aus nummerierten Adressen,

denen jeweils eine bestimmte Anzahl von Bits (Wortlänge) zugeordnet ist.

3. Welche Klassen von Daten sind Ihnen bekannt?

2

Zu ungenau.

In der Programmierung gibt es:

Type

byte

short

int

long

char

float

double

boolean

array

•

•

•

•

•

•

•

•

Größe in

Bit

8

16

32

64

16

32

64

?

4. Welche Aufgaben hat der

Datenschutzbeauftragte eines

Unternehmens?

Die wesentlichen Aufgaben des

Datenschutzbeauftragten werden in § 37

Bundesdatenschutzgesetz

genannt. Zu ihnen zählen insbesondere folgende

Aufgaben:

• Schaffung von Transparenz in der

betrieblichen Datenverarbeitung

• Überwachung der ordnungsgemäßen

Anwendung der Datenverarbeitungsprogramme

Koordinierung und Überwachung der Maßnahmen für Datenschutz und sicherung

Beratung über technische und organisatorische Maßnahmen im Bereich der

Datenverarbeitung

Beratende Mitwirkung bei der Auswahl von Personal, welches im Bereich der

personenbezogenen

Datenverarbeitung tätig wird

Schulung der Mitarbeiter

Erteilung von Auskünften an die Betroffenen in Angelegenheiten des Datenschutzes,

sowie Benachrichtigung des Betroffenen über die Datenerhebung

Vertretung des Unternehmers in datenschutzrechtlichen Fragen

Verfassen eines Tätigkeitsberichts am Ende des Geschäftsjahres

5. Was ist Datenschutz?

Datenschutz - ein Grundrecht

Datenschutz, der Schutz der Privatheit oder "Privacy", ist ein Grundrecht unserer

liberalen Rechts- und Gesellschaftsordnung:

•

Die Europäische Menschenrechtskonvention (Art. 8 EMRK) und die

Bundesverfassung (Art. 13 BV) garantieren das Recht auf Datenschutz.

Die Informations- und Kommunikationstechnologie, die sich seit den sechziger

Jahren

des vergangenen Jahrhunderts entwickelt hat, ist am Ursprung des

Datenschutzes:

•

Datenschutz ist eine Reaktion auf die technologische Entwicklung.

Der Datenschutz hat dieses Grundrecht in der Informations- und

Kommunikationsgesellschaft zu schützen:

•

Das Datenschutzgesetz (DSG) setzt die Rahmenbedingungen für den Umgang mit

Personendaten.

Rechtliche Rahmenbedingungen und organisatorische und technische

Anforderungen

an die Sicherheit sind die Ausgangslage für den Schutz der

Personendaten:

3

•

Mit Recht und Technik wird ein umfassender Datenschutz erreicht.

Die Zunahme der Menge der Daten (Jede Benutzung von Informations- und

Kommunikationstechnologie hinterlässt "Datenspuren") und ihre zunehmende Sensibilität

(Von Finanzinformationen bis zu Geninformationen) ist eine wachsende

Herausforderung für den Schutz der Privatheit.

•

Der Datenschutz nimmt eine aktive Rolle in der Diskussion ein, wie mit diesen Daten

umzugehen ist.

Informationen und Daten werden für das Funktionieren unserer Gesellschaft immer

wichtiger:

•

Der Ausgleich zwischen Zugang zu Informationen und Schutz der persönlichen

Informationen ist ein wichtiger Bestandteil des Datenschutzes.

Mit dem Datenschutz werden Grundanliegen unserer liberalen Rechts- und

Gesellschaftsordnung verwirklicht.

•

Angesichts der rasanten technologischen und gesellschaftlichen Entwicklung muss

die Auseinandersetzung mit dem Datenschutz für jede datenbearbeitende Stelle

einen hohen Stellenwert haben

6. Welche Probleme können beim Outsourcing der EDV Abteilung auftreten?

Zu den Nachteile und Risiken zählen:

• Abhängigkeit von einem IT-Dienstleister

• Risiken in der Kooperation durch Konkurs des Hosting-Anbieters

• Gefahr des Verlustes von unternehmerischem Know-how im Bereich der

lnformationstechnik

• Infrastrukturen des Hosters können nicht gemäß dem Wachstum des Kunden

erweitert werden

• Sicherheitsbedenken

7. Wie erfolgt die Verschlüsselung von Daten?

Zur Verschlüsselung benötigt man eine Verschlüsselungsvorschrift, den Algorithmus.

Diese allgemeine Vorschrift/ Beschreibung wird durch eine für jeden

Verschlüsselungsvorgang einzeln spezifizierte "Arbeitsanweisung" - den Schlüssel ergänzt. Sowohl von der Qualität des Algorithmus, als auch von der Anzahl der

Möglichkeiten (Schlüssellänge) hängt die Güte ("Knackbarkeit") der verschlüsselten

Daten ab.

Mit dem Verschlüsselungsverfahren PGP (Pretty Good Privacy) können

Daten und

Emails verschlüsselt oder signiert (digital unterschrieben)

werden. Das

besondere an

einer mit PGP verschlüsselten email ist, daß Absender und Empfänger

kein gemeinsames Geheimnis, wie eine Code-Tafel, besitzen. Das Programm benutzt

zwei komplementäre

Schlüssel (Keys), ein sog. "Key Pair" bestehend aus

einem "Private Key" und einem "Public Key". Der Private Key ist ausschließlich dem

Benutzer selbst zugänglich und muß streng unter Verschluß gehalten werden. Der

Public Key hingegen wird auf verschiedenen Wegen verbreitet, vorzugsweise über

Keyserver.

Der Absender benutzt nun seinen Private Key zusammen mit einem

Passwort

(das unabhängig vom Zugang zu einem Rechner oder File System gewählt

werden kann) sowie den von einem Keyserver geholten Public Key des

Empfängers

zum Verschlüsseln und/oder

Unterzeichnen. Der Empfänger holt sich den Public

Key des Absenders und kann dann zusammen mit seinem Passwort

und seinem Private

Key die email entschlüsseln und/oder die Signatur prüfen.

4

8. Welche Krypthografieverfahren kennen Sie?

Symmetrische Verschlüsselung

Bei der symmetrischen Kryptographie kennen und benutzen Sender und Empfänger für

die Ver- und Entschlüsselung einer Nachricht den gleichen geheimen Schlüssel: Der

Sender benutzt den geheimen Schlüssel zum Verschlüsseln und der Empfänger benutzt

ihn zum Entschlüsseln. Das Hauptproblem hierbei ist, dass sich Sender und Empfänger

auf den gleichen geheimen Schlüssel einigen, ohne dass ihn ein Dritter erfährt. Jeder,

der den Schlüssel während der Übertragung abfangen oder mithören kann, kann danach

alle verschlüsselten Nachrichten lesen, ändern, fälschen oder unterschreiben, indem er

diesen Schlüssel verwendet. Die Schlüsselerzeugung, -übertragung und -speicherung

wird Schlüsselmanagement genannt; alle Kryptosysteme müssen sich damit befassen.

Da alle Schlüssel eines symmetrischen Kryptosystems geheim bleiben müssen, treten

schwer beherrschbare Sicherheitsprobleme auf, speziell in offenen Umgebungen mit

vielen Nutzern.

Asymmetrische Verschlüsselung

Das Konzept der asymmetrischen Kryptographie wurde 1976 von Whitfield Diffie und

Martin Hellman vorgeschlagen, um das Problem zu lösen, dass bei symmetrischer

Verschlüsselung der geheime Schlüssel zwischen den Kommunikationspartnern

ausgetauscht werden muss und somit auch in falsche Hände geraten kann. In ihrem

Konzept hat jeder Beteiligte zwei Schlüssel, einen öffentlichen und einen privaten. Jeder

öffentliche Schlüssel wird veröffentlicht und der private Schlüssel bleibt geheim. Die

Notwendigkeit eines gemeinsamen Geheimnisses zwischen Sender und Empfänger ist

damit verschwunden: Jede Kommunikation verwendet nur öffentliche Schlüssel, private

Schlüssel werden nie übertragen oder geteilt. Jeder, der eine wichtige Information

versenden will, chiffriert mit dem öffentlichen Schlüssel, das Chiffrat kann jedoch nur mit

dem privaten Schlüssel dechiffriert werden, der sich ausschließlich in der Hand des

Empfängers befindet. Darüber hinaus kann asymmetrische Kryptographie nicht nur zur

Geheimhaltung (Verschlüsselung) sondern auch zur Authentifikation (digitale

Unterschriften) verwendet werden.

Digitale Signatur

Zwei Kommunikationspartner erhalten jeweils ein individuelles Schlüsselpaar:

-

einen öffentlichen Schlüssel (public key)

einen komplementären geheimen Schlüssel (secret key)

Die öffentlichen Schlüssel sind beiden Partnern bekannt, den geheimen Schlüssel kennt

nur der jeweilige Besitzer. Wenn Partner A nun einen Text signiert an Partner B schicken

will, geht er wie folgt vor:

A erstellt einen Klartext. Mit einem Komprimierungsvorgang wird aus dem Text ein HashWert erzeugt. Dieser Hash-Wert ist eine Zeichenkette, die unabhängig von der Länge

des Ausgangstextes immer gleich lang ist. Der Komprimierungsalgorithmus stellt sicher,

dass für jeden beliebigen Text ein eindeutiger Hash-Wert erzeugt wird. Der Hash-Wert

wird nun mit dem geheimen Schlüsüssel von A verschlüsselt. Das Ergebnis ist die

digitale Signatur, die an den Klartext angehängt und mit diesem verschickt wird.

Nachdem Partner B die Nachricht plus Signatur erhalten hat, entschlüsselt er mit dem

öffentlichen Schlüssel von A die Signatur und erhält damit den Hash-Wert des Textes. Er

wendet nun ebenfalls den Komprimierungsalgorithmus auf den Klartext an. Falls die

beiden Hash-Werte übereinstimmen, ist die Signatur echt, das heißt, B kann sicher sein,

dass die Nachricht von A kam (Authentizität). Zudem ist sicher, dass der Text

unverändert übermittelt wurde (Integrität).

Algorithmus

Beschreibung

5

Rivest, Shamir,

Adleman (RSA)

Ein allgemeiner Algorithmus, der digitale Signaturen, verteilte

Authentifizierung, Geheimschlüsselvereinbarung mittels

öffentlicher Schlüssel und die Massendatenverschlüsselung

unterstützt, ohne dass vorher geheime Informationen f

reigegeben wurden.

DSA

Data Encryption

Standard-Cipher

Block Chaining

(DES-CBC)

Algorithmus für digitale Signaturen

Eine zufällige Zahl wird generiert und mit dem Geheimschlüssel

zur Blockweisen Datenverschlüsselung verwendet

9. Nennen Sie die Vor- und Nachteile von Standardsoftware!

Die Einführung von Standardsoftware bringt viele Vorteile mit sich.

Vorweg soll eine Auflistung der erhofften Vorteile aus Verwenderseite gegeben

werden.

1. Bessere Planung, Steuerung und Kontrolle der betrieblichen Geschäftsprozesse

2. Einheitliche und Konsistente Datenbasis

3. Verbesserte Flexibilität im Hinblick auf eine Anpassung von Informationssytem und

Geschäftsprozessen an geänderte Anforderungen

4. Verkürzte Durchlaufzeiten für betriebliche Geschäftsprozesse

5. Qualitative Verbesserung der betrieblichen Geschäftsprozesse

Aus dem von den Anwendern angegebenen erhofften Vorteile lassen sich die

Wettbewerbsvorteile gegenüber ihren Konkurrenten ableiten. Primär erhoffen sich die

Anwender ein verbessertes Geschäftsprozeßmanagement in Verbindung damit eine

verbesserte Planung, Steuerung und Kontrolle, eine höhere Flexibilität sowie kürzere

Durchlaufzeiten.

Es geht also bei der Einführung von Standardsoftware nicht hauptsächlich um

Kosteneinsparungen sondern vielmehr um einen verbesserten

Geschäftsablauf. Ein weiterer indirekter Vorteil einer Standardsoftwareeinführung liegt darin, daß die Einführung zum Anlaß genommen wird, eine

Organisationsumstrukturierung durchzuführen. Es stellt sich hierbei die Frage, ob es

besser ist die neue Software an den Betrieb, oder den Betrieb an die neue Software

anzupassen. Dieses Thema wird in Unterpunkt 5 kurz behandelt.

Als Nachteil kann gesehen werden, daß die Anschaffung eines Datenbanksystems

eine Unternehmung auf längere Zeit bindet. Da die aufgebauten Datenstrukturen in

viele Anwendungsprogramme eingehen ist ein Wechsel des Datenbanksystems oft

nur mit sehr hohen Änderungsaufwand möglich. Auch muß für jedes in der

Unternehmung eingesetzte Datenbanksystem spezielles Know-how aufgebaut

werden, das zu einer wesentlichen Kapazitätsbindung in Personalbereich führt.

Zusammenfassend können folgende Vor-, und Nachteile von Standardsoftware

aufgeführt werden.

Die Vorteile einer Standardsoftware

• Kosteneinsparungen

• Kompatibilität mit anderen Nutzern

• Netzeffekte

• Kurze Implementierungsdauer

• Erfahrung

• Schulung / Erlernbarkeit

• Erfahrung

• Indirekte Nutzeneffekte

• Freiwillige Programm Updates vom Hersteller

• Verschiedene Plattformen

• Innerbetriebliche EDV Ressourcen werden geschont

• Zwischenbetriebliche Integration

Nachteile einer Standardsoftware

• Anforderungen in verschiedenen Bereichen werden nicht erfüllt

6

•

•

•

•

Zu umfangreich, Betriebe nutzen nur einen geringen Anteil an

möglicher Softwarekapazitäten

Unaufgeforderte Änderungen durch den Hersteller

Flächendeckend oder nur für bestimmte Bereiche, wo die Funktionalität am Höchsten

ist

Heterogene betriebliche Informationssyteme können durchaus gewollt sein, denn

eine flächendeckende Standardisierung der Systemelemelemte führt zu einer nicht

optimalen Unterstützung der Systemanwender.

10. Vergleichen Sie Standardsoftware mit Individualsoftware!

Die zweite Grundsatzentscheidung, die vor Projektausführung getroffen werden

muss, betrifft die Frage nach der individuellen Entwicklung oder dem Einsatz einer

Standardsoftware. Auch hierbei gibt es wieder diverse Vor- und Nachteile, die der

Projektleiter kennen und mit seinem Team diskutieren sollte.

Bei der Individualentwicklung wird die Lösung sozusagen aus dem Nichts

geschaffen. Sämtliche Elemente der Lösung, seien es Ein- und Ausgabeseiten, die

Datenbank, die Funktionen und Klassen müssen neu erstellt werden, sofern sie nicht

durch die Programmiersprache oder etwaige Tools bereitgestellt werden.

7

Für die individuelle Entwicklung spricht:

• Die Lösung passt hundertprozentig auf das Unternehmen, die vorhandenen

Systeme, Anwendungen und Schnittstellen.

• Es müssen keine Prozesse innerhalb des Unternehmens umgestellt werden.

• Das Unternehmen begibt sich nicht in eine technologische Abhängigkeit vom

Hersteller, da es volle Kontrolle über den Quellcode und die

Weiterentwicklung besitzt.

• Änderungen und Erweiterungen können binnen kürzester Zeit erfolgen, man

muss nicht auf das nächste Update warten, um auf eine neue Funktion

zugreifen zu können oder einen Fehler zu beseitigen.

• Bei Änderungen und Erweiterungen fallen keine zusätzlichen Lizenzkosten

an.

• Es fallen keine jährlichen Kosten für Softwarepflegeverträge, Updatelieferung

oder Fehlerkorrekturen an.

• Bewährte Nummernschlüssel, Auftragsnummern etc. werden beibehalten.

• Die Software wächst mit dem Unternehmen mit.

• Die Bedienung und der Komfort kann durch das Personal mit beeinflusst

werden.

• Der Schulungsaufwand ist geringer, da die Lösung auf bisherige Prozesse

aufbaut und an die vorhandenen Anwendungen angepasst und intuitiv

gestaltet werden kann. Zudem versperren nicht unzählig viele Funktionen die

Sicht auf die für das Unternehmen wesentlichen Dinge der Anwendung.

• Die Kosten sind als Ausgaben für Dienstleistungen sofort absetzbar und

brauchen nicht aktiviert und abgeschrieben zu werden.

Standard-Softwarepakete sind komplett entwickelte Lösungen, die bereits nach der

Installation einsatzbereit sind. Hierzu zählen Standardprogramme der großen

Hersteller genauso wie Open-Source-Lösungen.

Für Standardanwendungen spricht:

• kürzer Projektzeiten, da schnellere Installation

• geringere Anschaffungskosten, da Lizenzkosten meist billiger

• langfristig kalkulierbarere Kosten und geringeres Planungsrisiko

• Vielfalt an Funktionen zu geringerem Preis

• Keine Abhängigkeit vom Dienstleister, der Rechte auf den Quellcode besitzt

• Die Erweiterung erfolgt vielfach nach Wünschen der Kunden, so dass

Updates die kreative Kraft vieler Kunden enthalten.

• Die Kosten für neue komplexe Funktionen (XML, UMTS etc.) verteilen sich

auf viele Kunden. Diese Funktionen erhält man, ohne das dafür notwendige

Entwickler-Know-how aufzubauen.

11. Was sind die Vorteile wenn man seine Software selbst entwickelt?

Kostenminimierung und Umsatzmaximierung sind die Schlagworte; daneben suchen

die Unternehmen nach Lösungen, um ihr jeweiliges Geschäft zu stabilisieren

beziehungsweise beizubehalten. Alles, was umständlich, zeitraubend oder

kostenintensiv ist, sollte möglichst mit Hilfe von Technologie abgekürzt, vereinfacht

und

preiswerter gestaltet werden.

Die Vorteile dieser maßgeschneiderten Lösungen sind vor allem, dass die Software

genau auf seine Bedürfnisse hin erstellen wird. Support im eigenem Haus.

12. Was versteht man unter einem Prototyp?

Eine ausführbare und evaluierbare Version eines Systems oder Systemteils

(evolutionärer Prototyp) oder eines Werkzeugs, um ausgewählte Merkmale des

späteren, operationellen Systems (explorativer oder experimenteller Prototyp) zu

evaluieren.

Bemerkung:

Für die Erstellung eines Prototyps wird nicht die Erfüllung der Regelungen des V8

Modells gefordert.

Bei der Integration der Prototypen in das operationelle System muss geklärt werden,

welche Nacharbeiten zur Erfüllung der relevanten Anwenderanforderungen

(insbesondere der Qualitätsanforderungen) notwendig sind.

13. Erläutern Sie Computer Viren! Welche Arten von Computerviren kennen Sie?

Definition Computerviren:

Ein Computervirus ist ein Programm, das zu seiner

Weiterverbreitung fremden Code infiziert.Dies können neben Anwender- und

Programmdateien auch Systembereiche aufSpeichermedien sein. Darüber hinaus

besitzt ein Virus meist eine Schadensroutine, die vonstörenden

Bildschirmanimationen bis zum Löschen von Dateien reichen

Computerviren sind – wie der Name vermuten lässt – in ihrer

Funktionsweise den Virenähnlich, die den menschlichen Körper befallen können: Es

handelt sich bei Ihnen zwar um einStück Software (in diesem Kontext wird auch

von "Malware" gesprochen), aber im Grundsatzgehen Computerviren auch so vor,

dass sie einen Wirt befallen, sich dort vermehren, meist denWirt manipulieren

und sich anschliessend auf weitere Wirte verbreiten

Computerviren bestehen denn auch aus den folgenden

Grundbausteinen:

• der Infektionsroutine

• dem Kopiermodul

• der Statusroutine

Generell lassen sich die Gruppe der Computerviren oder eben der Malware

nach verschiedenenKriterien klassifizieren. Die gängigste Einteilung sieht

allerdings die folgenden Gruppen vor:

• Bootviren

• Dateiviren

• MakrovirenAlle

anderen Typen sind entweder Mischformen oder Untergruppen davon

BootvirenBootviren können das Ladeprogramm im Bootsektor oder den

Master-Boot-Record (MBR)von formatierten Datenträgern infizieren. Der Virus

überschreibt entweder einen Teilbereich,ersetzt den gesamten Code oder lagert

weitere Codeteile in andere Bereiche der Festplatte aus.

Dateiviren befallen ausführbare Dateien

wie zum Beispiel Programmdateien mit den Endungen.com oder .exe sowie System(.dll) und Sktriptdateien (.vbs). Dabei kopiert der Virus sich

selbst oder eine Sprunganweisung auf sich an den Anfang der Datei und wird

immer dannausgeführt, wenn die Datei aufgerufen wird.

Makroviren infizieren Dokumente mit Makro-Eigenschaften. Unter anderem

befallen sie Word-Dokumente, Excel-Tabellen und PowerPointpräsentationen.

Mit den Befehlen einer mächtigen Skriptsprache kann einMakro beispielsweise

Dateien und andere Officedokumente manipulieren oder Applikationenfernsteuern.In

der Vorgehensweise unterscheiden sich Makroviren kaum von Dateiviren. Der

Viruscodewird am Anfang beim Laden des Makros ausgeführt, kopiert sich dann auf

andere Dokumenteund erfüllt unter Umständen noch eine einprogrammierte Aufgabe

14. Welche Möglichkeiten gibt es die Lebenszeit eines Softwareproduktes zu

verlängern?

Wartung

Aufgaben

• warten

o Fehler beheben ("corrective")

o anpassen ("adaptive")

9

•

•

•

o verbessern ("perfective")

Ergebnis:

(Fehlerbeschreibungen) software problem report (SPR)

(Veränderungsvorschläge)software change proposals (SCP)

neue Versionen ("release")

15. Erklären Sie das Magische Quadrat der Softwareentwicklung?

16. Rechenen Sie Dualzahl 1101111 in Dezimal bzw. Hexadezimaldarstellung um!

1*2^6+1*2^5+0*2^4+1*2+^3+1*2^2+1*2^1+1*2^0=111

Hexa:

0110|1111

5

F

Dezimal

Hexadezimal

Dual

0

0

0000

1

1

0001

2

2

0010

3

3

0011

4

4

0100

5

5

0101

6

6

0110

7

7

0111

8

8

1000

9

9

1001

10

A

1010

11

B

1011

12

C

1100

13

D

1101

14

E

1110

15

F

1111

17. Was ist ein Byte?

Maßeinheit für Informationseinheiten bei Datenverarbeitungsanlagen, umfasst 9 Bits

(8 Datenbits und ein Prüfbit). Mit jeweils einem Byte wird ein Zeichen aus dem ASCIIZeichensatz oder aus einem vergleichbaren Zeichensatz dargestellt

Ein Byte ist die kleinste adressierbare Speicherstelle. Es besteht aus 8 Bits. Da ein

Bit zwei Zustände einnehmen kann, ermöglicht ein Byte (2 hoch 8) 256 Kombination

und damit die Darstellung von 256 verschiedenen Zuständen oder Zeichen.

18. Softwareergonomie, was versteht man darunter?

Die Software-Ergonomie beruht auf der Basis des Grundverständnisses von

Ergonomie. Das heisst, der Anpassung von technischen Systemen an den Menschen und

nicht umgekehrt! Die Software-Ergonomie beschäftigt sich vor allem mit dem Verhältnis

von Software-Systemen und ihren Benutzern. Dieses Verhältnis (MenschComputerInteraktion) spielt bei der Analyse, Gestaltung und Bewertung interaktiver

Computersysteme eine wichtige Rolle.

19. Sie wollen einen PC zusammenbauen, wie soll dieser PC aufgebaut sein?

10

20. Warum nimmt man keinen Giga Hertz PC?

21. Was sind Kenngrößen?

Anzahl der Gleitpunktoperationen (floating point operations), die im Mittel pro

Sekunde ausgeführt werden. Die Einheit dieser Gleitpunktleistung ist

dementsprechend

flop/s (floating point operations per second) bzw. Mflop/s oder Gflop/s.

Festplatte: Umdrehung/min

CPU: Taktfrequenz, Bustakt, Cache

Arbeitsspeicher: Größe und Bauart

Motherboard: Front Side Bus

22. Was ist ein Bit, Byte, Wort, Langwort?

Bit:

Abkürzung für "Binary Digit" • die kleinste Informationseinheit im binäre

Zahlensystem, die einer Speicherzelle entspricht. Ein Bit kann entweder den Wert 0 oder

1 annehmen. 8 Bit werden zu einem Byte zusammengefasst

Wort:

Ein Word besteht meist 16 Bits (4 Nibbles = 2 Bytes). Ein Word kann die 65536

verschiedene Zustände annehmen. Es kann den Zahlenbereich von 0 bis 65535

repräsentieren. Mit Vorzeichen ist der Bereich -32768 bis 32767 üblich Früher wurde

das Word verwendet um die Breite des Datenbuses von Prozessoren zu

umschreiben. Es wurden auch andere Breiten als 16 Bit eingesetzt.

Langwort:

In Anlehnung an die in den meisten Programmiersprachen übliche Notation

bezeichnet man jedoch als Wort in der Regel eine aus 16 Bit bestehende Dateneinheit und ein aus 32 Bit bestehendes Datum als Langwort.

23. Was ist ein Datenfeld?

kleinste eigenständige Einheit eines Datensatzes und/oder einer Datenbank. Ein

Datenfeld ist gekennzeichnet durch den Feldnamen, den Datentyp (z. B. numerisch

oder alphanumerisch), die Länge des Feldes (in Zeichen oder Byte) sowie den

Feldinhalt. Beispiele für typische Datenfelder sind Name, Geburtsdatum, Postleitzahl und

Kundennummer.

24. Was sind Dateien und welche Arten gibt es?

Musik, filme, komprimierte, Bilder, batch, doc’s, pdf………

25. Was ist ein Parity-Bit?

Prüfbit, das an eine Bitfolge (sieben oder acht Bit) eines Übertragungscodes

angehängt wird, um Übertragungsfehler zu erkennen. Es gibt even-parity und oddparity. Bei even-parity wird die Anzahl der in der Bitfolge auftretenden 1-Bits durch

das

Paritätsbit zu einer geraden Anzahl 1-Bits ergänzt. Bei odd-parity wird entsprechend eine

ungerade Anzahl 1-Bits hergestellt. Mit Hilfe des Parity-Bits kann

der Empfänger

einen Einzelfehler in der Übertragung erkennen. Da nur Einzelfehler

bzw. ungerade

Mehrfachfehler erkannt werden und andererseits die Qualität der

Telefonleitungen

sehr gut ist, wird auf das Paritätsbit bei Modem-Übertragungen heute Vielfach zugunsten

von fehlerkorrigierenden Protokollen (z.B. Zmodem)

verzichtet

26. Was ist das Ziel von Groupware?

?????

Rechnerarchitektur und Betriebssysteme

Rechnerarchitektur

1. Beschreiben Sie die von – Neumann – Architektur!

Siehe Oben

11

2. Welche Rechnerarchitekturen gibt es außer dem von - Neumann - Konzept?

Single instruction stream, single data stream (SISD):

SISD Computer besitzen eine CPU, die eine Anweisung zu einer Zeit verarbeitet

(single instruction stream). Sie schreiben oder laden eine Information zeitgleich aus

dem Speicher (single data stream). Es ist unschwer zu erkennen, dass vonNeumann-Architekturen diesem Computertyp zugeordnet werden können.

Single instruction stream, multiple data stream (SIMD):

Computer dieser Klasse besitzen eine CPU, die genauso arbeitet wie die einer vonNeumann-Maschine (d.h. eine Anweisung zeitgleich), jedoch beinhalten sie mehrere

Verarbeitungseineinheiten, die zeitgleich mit verschiedenen Daten umgehen (mutiple

data streams). Ein Anwendungsbeispiel sind sogenannte Prozessorarrays.

Multiple instruction stream, single data stream (MISD):

Hierbei würden mehrere CPU-Anweisungen auf dieselben Daten ausgeführt. Bisher

gibt es keine realen Umsetzungen dieses Computertyps.

Multiple instruction stream, multiple data stream (MIMD):

Bei Rechnern, die der MIMD-Klasse zugeordnet werden können, handelt es sich in

der Regel um typische Multi\-pro\-zessor-System. Hierbei arbeiten mehrere CPUs

unabhängig voneinander an unterschiedlichen Daten. Es kann also jede CPU ein

anderes Programm ausführen.

3. Erläutern Sie CISC und RISC!

12

RISC und CISC stehen für die Begriffe Reduced Instruction Set Computer bzw.

Complex Instruction Set Computer

Bei dem CISC Modell hat die CPU üblicherweise wenige Register (Speicherplätze in

der CPU), wovon manche auch meist Spezialaufgaben haben. Dazu finden sich viele

Befehle, darunter auch sehr mächtige, die z.B. in einer Schleife gleich mehrere

Register bearbeiten. Die Befehle haben meist ungleiche Befehlslängen. Die am

häufigsten benutzten nur ein Byte, weniger häufige zwei oder drei Bytes. Dadurch

kann der Code kompakt gehalten werden.

RISC geht einen anderen Weg. Man beschränkt sich auf die wirklich notwendigen

Befehle. Als Ausgleich hat mehr erheblich mehr Register (bis zu 256) auf dem Chip,

so das man viel öfters schnelle Register-Register Operationen hat als langsame

Speicher-Register Operationen. Die wenigen Befehle machen das Design einfacher

und man kann den Prozessor billiger herstellen.

4. Erklären Sie die CIS Architektur?

Oben

5. Erläutern Sie das RAID System?

Oben

6. Beschreiben Sie RAID 1 bis RAID 5 und nennen Sie jeweils Vor – und

Nachteile!

RAID=Redundant Arrays of Inexpensive Disks

Bei RAID Level 0 handelt es sich - wie die Null im Namen schon andeutet - um kein

redundantes Speicherverfahren. Es dient lediglich zur Beschleunigung von

Plattenzugriffen. Dazu fasst RAID 0 zwei oder mehr Festplatten zu einem logischen

Laufwerk zusammen. Es verteilt die Daten in aufeinanderfolgenden Blöcken

("Stripes")

gleichmäßig über alle Laufwerke.

Das parallele Lesen respektive Schreiben auf mehreren Laufwerken steigert zwar

die Durchsatzrate, senkt jedoch die Sicherheit der Daten: Fällt eine

Platte des

Verbunds aus, sind alle Daten verloren

Bei RAID Level 0 handelt es sich - wie die Null im Namen schon andeutet - um kein

redundantes Speicherverfahren. Es dient lediglich zur Beschleunigung von

Plattenzugriffen. Dazu fasst RAID 0 zwei oder mehr Festplatten zu einem logischen

Laufwerk zusammen. Es verteilt die Daten in aufeinanderfolgenden Blöcken

("Stripes")

gleichmäßig über alle Laufwerke. Daher bezeichnet man RAID 0 auch als

Striping. Das

parallele Lesen respektive Schreiben auf mehreren Laufwerken steigert

zwar die

Durchsatzrate, senkt jedoch die Sicherheit der Daten: Fällt eine Platte des

Verbunds

aus, sind alle Daten verloren.

RAID Level 1 wird auch als Mirroring oder Spiegelung bezeichnet. Dieser Name

verdeutlicht, wie das Verfahren arbeitet: Alle Schreibzugriffe erfolgen parallel auf zwei

Laufwerke, so dass jede Platte quasi ein Spiegelbild der anderen darstellt. Alle Daten

stehen also doppelt zur Verfügung - sicherer geht es kaum noch. Auch wenn eines

der beiden Laufwerke komplett ausfällt, bleiben alle Nutzdaten erhalten.

Allerdings

steht bei RAID 1 nur die Hälfte der Plattenkapazität für die Speicherung

zur

Verfügung. Die Kosten der Datenhaltung verdoppeln sich also.

Durch eine Kombination von Mirroring und Striping lassen sich

Geschwindigkeitsgewinn und Datensicherheit verbinden: Ein RAID 0 erzielt durch

das

lineare Zusammenschalten mehrerer Festplatten sowohl beim Lesen als auch beim

Schreiben einen Geschwindigkeitsvorteil. Die zusätzliche Spiegelung des

Stripesets

auf weitere Platten sorgt für Datensicherheit. Je nach Hersteller wird

dieses Verfahren

als RAID 0+1, RAID 0/1 oder RAID 10 apostrophiert

13

RAID Level 2 bietet zusätzlichen Schutz gegen Fehler innerhalb der Festplatten,

wird aber aufgrund seiner aufwendigen Implementierung kaum eingesetzt. Es blieb

bis auf wenige Anwendungen auf den Großrechnerbereich beschränkt.

RAID 2 basiert auf einer bitweisen Aufteilung der Nutzdaten. Dabei implementiert es

nicht nur eine Fehlerkorrektur gegen den kompletten Ausfall einer Platte. Alle

anderen RAID-Levels versagen, wenn nicht eine komplette Platte ausfällt, sondern

die

Daten beispielsweise durch einen Schreibfehler inkonsistent sind. Ein Fehler wird

bei

ihnen zwar erkannt. Welche Platte jedoch falsche Daten liefert, ist nicht festzustellen, eine

Korrektur somit unmöglich.

RAID Level 3 setzt auf ein byteweises Striping der Daten. Zur Erkennung von

Schreib-/Lesefehlern setzt es im Gegensatz zu RAID 2 auf die integrierten

Funktionen der Festplatten. Dadurch kommt es mit einem einzelnen, dedizierten

Parity-Laufwerk aus. Um die Generierung der ECC-Daten zu erleichtern

synchronisiert RAID 3 die Kopfpositionen der Laufwerke. Das ermöglicht zwar

Schreibzugriffe ohne Overhead, da sich Parity- und Nutzdaten parallel auf den Laufwerken

speichern lassen. Viele Lesezugriffe auf kleine, verteilte Dateien erfordern dagegen die

synchrone Neupositionierung der Köpfe aller Platten im Verbund und kosten entsprechend

Zeit.

RAID Level 4 arbeitet anders als RAID 3 mit blockweisem Striping der Nutzdaten.

Um die Nachteile von RAID 3 bei der Verarbeitung kleiner Files zu umgehen,

verzichtet es dabei allerdings auf eine Synchronisierung der Kopfbewegungen aller

Laufwerke. Zur Speicherung der Parity-Informationen nutzt es dagegen wie RAID 2

und 3

ein dediziertes Laufwerk. Die Kombination aus blockweisem Striping und

unabhängigem Plattenzugriff ermöglicht RAID 4 das schnelle Lesen auch kleiner

Files.

Je nach Dateigröße kann hier jedes Datenlaufwerk eine unabhängige Leseoperation

vornehmen. Bei Schreiboperationen allerdings erweist sich RAID 4

aufgrund der

fehlenden Synchronisierung RAID 3 unterlegen: Bei jedem ECC Update muss

zunächst die passende Stelle auf dem Parity-Laufwerk gefunden und angesteuert

werden. Damit erweist sich hier das ECC-Drive als Flaschenhals.

RAID Level 5 arbeitet ebenso wie RAID 4 mit einer blockweisen Verteilung der

Nutzdaten. Aber es verzichtet auf ein dediziertes Parity-Laufwerk und verteilt die

ECC -Daten zusammen mit den Nutzdaten gleichmäßig über die Laufwerke. Damit

sinkt die Wahrscheinlichkeit, dass gleichzeitig zwei Schreiboperationen auf dieselbe

Platte erfolgen. Schreibzugriffe lassen sich also weitgehend parallelisieren. Zudem

verteilt sich die mechanische Belastung der Platten gleichmäßig, da keine eine

Sonderstellung als Parity-Laufwerk einnimmt

RAID 6 stellt einen Versuch dar, gegenüber RAID 3 bis 5 die Ausfallsicherheit

nochmals zu erhöhen. Bei diesen Verfahren darf nur eine Platte des Arrays ausfallen,

da sich sonst die Daten nicht mehr per XOR rekonstruieren lassen. RAID 6 umgeht

diese Einschränkung, indem es quasi ein RAID 5 um eine zusätzliches ParityLaufwerk ergänzt. Zwar dürfen nun zwei Platten des Verbunds ausfallen, ohne dass

Datenverluste auftreten. Die zusätzliche Sicherheit muss allerdings mit gegenüber

RAID

3 bis 5 deutlich langsameren Schreibzugriffen erkauft werden.

Auch das proprietäre RAID 7 ist ähnlich wie RAID 5 aufgebaut. Allerdings setzt der

Hersteller Storage Computer im Controller zusätzlich ein lokales

Echtzeitbetriebssystem ein. Schnelle Datenbusse und mehrere große Pufferspeicher

koppeln die Laufwerke vom Bus ab. Dieses asynchrone Verfahren soll Lese- wie

Schreiboperationen gegenüber anderen RAID-Varianten erheblich beschleunigen.

Zudem lässt sich, ähnlich wie bei RAID 6, die Paritätsinformation auch auf

mehrere

Laufwerke speichern.

7. Welche Speicherarten sind Ihnen bekannt?

14

DRAM

Früher wurden die RAM-Bausteine als einzelne Chips auf das Motherboard gesteckt,

wohingegen heute Module verwendet werden, die man auch als SIMMs (Single Inline

Memory Modules) bezeichnet. Zunächst waren dies 30polige SIMMs die inzwischen aber

durch 72polige SIMMs (PS/2-SIMMs) abgelöst wurden. Diese Module sind auf dem

Motherboard in Bänken organisiert, wobei zu beachten ist, daß die einzelnen Bänke immer

vollständig mit Modulen bestückt sind, und diese Module auch vom gleichen Typ sein

müssen. Leider gibt es eine ganze Reihe unterschiedlicher Ausführungen der Module, so

daß hier nur ein kurzer Überblick über die wichtigsten Unterschiede gegeben werden kann.

Bevor ein Rechner im Speicherbereich erweitert werden soll, muß man auf jeden Fall das

Handbuch des Mainboardes zu Rate ziehen, um feststellen zu können welche Module in

welchen Kombinationen verwendet werden können, da manche Bänke parallel geschaltet

sind.

Zugriffszeit, Single sided/Double sided

DRAMs unterscheiden sich zunächst schon einmal durch unterschiedliche Zugriffszeiten.

Typisch sind Zeiten von <70 ns, für Prozessoren mit höheren Taktraten (P100) sind Module

mit Zugriffszeiten von 60ns notwendig. Ein weitere Unterschied ergibt sich durch die

technische Ausführung der Module. So gibt es Single und Double Sided Module, die sich

durch die Anzahl der nach Außen geführten RAS-Leitungen (Row Address Strobe)

unterscheiden (zwei bzw. vier Leitungen). Dies ist von außen ohne weiteres nicht zu

erkennen (!!!), da es nicht darum geht, ob das Modul einseitig oder zweiseitig mit Chips

bestückt ist.

DDR (Double Data Rate)

Als die viel diskutierte und von INTEL unterstützte Rambus-Technik Mitte 1999 Probleme mit

der Marktreife bekam, setzten Chiphersteller wie Hitachi, Hyundai oder IBM wieder auf die

Weiterentwicklung von SDRAM in Form der DDR-Speichertechnik. Während "normale"

SDRAM-Module 1999 bei einem 133 MHz Front-Side-Bus (FSB) einen Datendurchsatz von

1,1 GByte pro Sekunde leisteten, waren DDR-Module doppelt so schnell. Möglich wird dies

durch einen relativ simplen Trick: Die Datenbits werden bei der ab- und aufsteigenden

Flanke des Taktsignals übertragen, statt wie bisher nur bei der aufsteigenden. Erste Boards

und Speicherchips kamen Ende 1999 auf den Markt.

Gegenüber der von INTEL favorisierten Direct-RDRAM-(Rambus)-Lösung hat DDR einige

Vorteile: Die Hersteller benötigen keine neuen Produktionsmaschinen und DDR ist ein

offener Standard, dessen Spezifikationen im Internet offenliegen; Lizenzgebühren an INTEL

oder Rambus werden also nicht fällig.

15

Der DDR-Nachfolger - DDR2 - soll Transferraten von 3,2 GByte pro Sekunde bringen.

DRAM (Dynamic RAM)

Beim dynamischen Schreib-/Lesespeicher (DRAM) müssen die Ladungen zyklisch mit einem

sogenannten Refresh-Impuls immer wieder aufgefrischt werden, um die Daten in den

Speicherzellen zu halten. Der Nachteil: Die Zugriffszeit durch Refresh-Vorgang und

Wartezeiten des Prozessors liegt höher als beim SDRAM. Der Vorteil: DRAM ist

kostengünstig, erwärmt sich weniger und hat durch seine einfachere Struktur eine höhere

Integrationsdichte.

Hochfliegende Pläne hat Samsung: Das Unternehmen will mit 0,13-Mikron-Technik 4-GBitDRAM-Chips fertigen. Die Chips mit 500 MB Speicherkapazität gehen zwar erst in zehn

Jahren in die Massenproduktion. Die Technik läßt sich laut Hersteller jedoch auch bei

bestehenden Produkten - etwa den preisgünstigen 16-MBit-DRAM-Chips einsetzen.

DRDRAM (Direct Rambus Dynamic RAM)

DRDRAM zeichnet sich gegenüber SDRAM dadurch aus, daß der Speichersystembus mit

einer Taktrate von mindestens 400 MHz betrieben werden kann - deutlich schneller als der

100- oder 133-MHz-FSB. Rambus soll laut unternehmensnahen Quellen sogar mit

Systembus-Taktraten von 600, 700 und 800 MHz angeboten werden.

EDO (Extended Data-Out) DRAM

Der EDO DRAM (oder Hyper PageMode DRAM) arbeitet ähnlich wie der FPM-Speicher, ist

aber schneller dank Änderungen des CAS (Column Address Signal) und des verlängerten

Data-Outputs. Diese Chips können Datenwerte noch zum Auslesen bereit halten, während

bereits die nächste Adresse angelegt wird. Das beschleunigt Lesevorgänge.

Im Vergleich mit SDRAM ist EDO-Speicher langsamer.

FC-RAM (Fast Cycle RAM)

Bei der sogenannten Fast Cycle (FC)RAM-Technik wird die interne Leistung des Chips

gesteigert - im Gegensatz zum Direct-Rambus-Verfahren, das die

Schnittstellengeschwindigkeit zwischen Chip und Prozessor erhöht. Die von Fujitsu und

Toshiba initiierten Bausteine sind zwei- bis dreimal schneller als DRAM.

FPM (Fast Page Mode) DRAM

FPM war lange der DRAM-Standard, ist aber mittlerweile veraltet und wird von EDO - noch

mehr von SDRAM - übertroffen. FPM DRAM optimiert den Zugriff auf Daten: Fragt der

Prozessor nach Daten, die in derselben Reihe einer Seite wie die der zuletzt angeforderten

liegen, muß der Speichercontroller nur noch die Spaltenposition adressieren.

MRAM (Speicherchips hoher Packungsdichte auf Magnetbasis)

Bevor das Silizium Einzug in die Speichermedien gehalten hat, basierten diese auf

magnetisierbaren Eisenkernen - mit dem Vorteil, daß auch bei einer Stromunterbrechung

gespeicherte Informationen nicht verlorengingen; das Booten war dadurch überflüssig und

wird durch MRAMs - auch FeRAMs genannt - wieder überflüssig werden, da sich das

gesamte System immer im Hauptspeicher befindet. Außerdem könnten diese Speicherchips

für wesentlich leichtere Notebooks sorgen, denn die heute (2001) verwendeten RAMs

benötigen in bestimmten Abständen energieaufwendige Refresh-Spannungsstöße (siehe

DRAM), um fit zu bleiben; diese entfallen bei den MRAMs.

Bis es soweit ist, wird allerdings noch etwas Zeit vergehen. Prof. Burkhard Hillebrands von

der Uni Kaiserslautern entwickelt diese Chips in Zusammenarbeit mit Siemens. Er glaubt,

dass serienreife MRAMs frühestens im Jahr 2005 auf den Markt kommen werden.

RDRAM (Rambus DRAM)

Rambus soll laut unternehmensnahen Quellen mit Systembus-Taktraten von 600, 700 und

800 MHz angeboten werden.

SDRAM (Synchronous DRAM)

Der Nachfolger von EDO synchronisiert sich mit dem Systemtakt, der den Prozessor

kontrolliert. Das verhindert Zeitverzögerungen beim Zugriff. Eine Datenserie (Burst) wird

16

zügig übertragen.

SDRAM hat eine völlig andere Architektur als klassisches DRAM und ist wesentlich

schneller. Diesen Speichertyp gibt es als 168-polige DIMM-Module für System mit 66MHz

und 100MHz Bustakt.

SLDRAM (Synchronous Link DRAM)

Im September 1998 wollte Mosaid erste Muster seiner Synchronous-Link-DRAM-Chips an

Compaq, Hewlett-Packard und IBM ausliefern. Diese 64-MBit-Chips schaffen laut Hersteller

Datenraten von bis zu 800 MB/s. SLDRAM soll hauptsächlich in High-End-PCs und Servern

eingesetzt werden.

SRAM

SRAMs kommen überall da zum Einsatz, wo es um maximalen Datendurchsatz geht. Dies

ist vor allem beim Second-Level-Cache und bei Grafikkarten der Fall. SRAMs haben kürzere

Zugriffszeiten als DRAMs, und sind deshalb auch teurer als diese. SRAM tritt als SecondLevel-Cache vor allem in drei Formen auf, und zwar onboard in DIL-Bauweise (Dual Inline)

(asynchron), als synchronous Pipliened Burst SRAM in Form eines Coast-Moduls (Cache on

a stick), oder bereits aufgelötet auf dem Mainboard (verringert Kontaktschwierigkeiten). Auch

hier muß unbedingt das Handbuch des Motherboard zu Rate gezogen werden, um

abzuklären welche Art von SRAM zum Einsatz kommt.

Was ist Level-0-Cache?

Entkoppelt den Datenstrom der unterschiedlichen Recheneinheiten innerhalb der CPU.

Seine Größe liegt bei etwa 1 Byte bis 128 Byte.

Was ist Level-1-Cache?

Entkoppelt den Datenstrom innerhalb der CPU von der Außenwelt, Größe von wenigen

Bytes (128) bis zu mehreren kBytes.

Was ist Level 2 Cache?

Entkoppelt den Datenstrom der CPU vom Memory Bus, an dem der Hauptspeicher

angeschlossen ist. Größe von 256 kBytes bis zu mehreren MegaBytes.

Was ist Level 3 Cache?

Entkoppelt ggf. bei Mehrprozessorsystemen den separaten Systembus vom Memory Bus.

Festplatten IDE= Integrated Drive Electronics, SCSI= Small Computer System Interface

CD-ROM, Diskette, Bandlaufwerk

8. Wie groß sind die Speichermedien?

Arbeitsspeicher 1-1024 MB

Festplatte bis 250 Gigabyte

Cache 256 KB-2 MB

9. Welche sequentiellen Datenspeicherungsmodelle kennen Sie?

Magnetbandspulen, -kassetten

10. Was machen sie, wenn sie eine Festplatte eingebaut haben?

Formatieren, BS- Installieren

11. Was muß man denn mit einer jungfräulichen Festplatte machen

Formatieren

12. Wie äußert sich das Geschwindigkeitsverhältnis vom RAM zu Festplatte?

Während Festplatten immer noch eine Zugriffszeit von 8-12 Millisekunden haben,

kommen moderne RAM-Bausteine auf unter 10 Nanosekunden.

13. Erklären Sie RAM und ROM?

RAM: (Random access memory)

17

Das RAM ist ein Schreib-Lese-Speicher, bei dem jede Speicherzelle einzeln

adressierbar und inhaltlich veränderbar ist. RAMs werden als Daten- und als

Programmspeicher eingesetzt. RAMs, die durch Halbleiter realisiert sind, verlieren bei

Stromausfall ihren Inhalt. Um dem vorzubeugen, rüstet man Computer und auch

Taschenrechner mit Schaltungen aus, die bei Stromausfall oder versehentlichem

Ausschalten die RAMs über Akkumulatoren oder Batterien mit Strom versorgen, so

daß

ihr Speicherinhalt erhalten bleibt. ROM: ( Read only memory)

Festwertspeicher; Speicher, dessen Inhalt bereits bei der Herstellung festgelegt wird

und nicht mehr verändert werden kann. ROMs werden vorwiegend als Speicher für

feste Programme (z.B. für Betriebssystemkomponenten) und für unveränderbare

Daten verwendet. Bei speziellen Anfertigungen des Festwertspeichers lassen sich die

Inhalte wieder löschen: EPROM (Erasable Programmable Read Only Memory) durch

Bestrahlung mit UVLicht EEPROM (Electrically Erasable Programmable Read Only

Memory) durch Stromstöße: Kommt bei Chipkarten und Flash-Speichern

(BIOS, etc.) vor

14. Was ist ein Virtueller Speicher?

Physikalisch nicht vorhandener Haupt-Speicher - der durch die vorübergehende

Auslagerung von Daten auf die Festplatte realisiert wird.

15. Was ist ein Halbaddierer ?

Der Halbaddierer ist eine spezifische Gatter-Schaltung (also ein Artefakt), mit welcher

zwei Signale nach folgender Regel in ein Signalpaar übergeführt werden:

0+0=0

0+1=1

1+0=1

1 + 1 = 10

Im letzten Fall wird eine zweite Signalleitung aktiviert.

Der Halbaddierer ist der elementare Bestandteil des Prozessors beispielsweise eines

Computer und erklärt als Konstruktion die Bedeutung von "to compute" oder

Rechnen

im engeren Sinne.Der Informatik-Duden schreibt volks"dümlich":

Der Halbaddierer berechnet aus zwei binären Ziffern ihre Summe.

16. Was ist Microcode?

Der Microcode ist die Summe der Mikroprogramme, die dem Prozessor die

Anweisungen zum Abarbeiten der Befehle übermitteln.

17. Erklären Sie die Begriffe SIMD, und MIMD!

Single instruction stream, multiple data stream (SIMD):

Computer dieser Klasse besitzen eine CPU, die genauso arbeitet wie die einer vonNeumann-Maschine (d.h. eine Anweisung zeitgleich), jedoch beinhalten sie mehrere

Verarbeitungseineinheiten, die zeitgleich mit verschiedenen Daten umgehen (mutiple

data streams). Ein Anwendungsbeispiel sind sogenannte Prozessorarrays.

Multiple instruction stream, multiple data stream (MIMD):

Bei Rechnern, die der MIMD-Klasse zugeordnet werden können, handelt es sich in

der Regel um typische Multi\-pro\-zessor-System. Hierbei arbeiten mehrere CPUs

unabhängig voneinander an unterschiedlichen Daten. Es kann also jede CPU ein

anderes Programm ausführen.

18. Wie ist die Architektur bei SAP?

In SAP R/3 wird eine dreistufige Client-Server-Architektur verwendet, nämlich eine

Trennung in Präsentationsschicht, Anwendungsschicht und Datenbankserver

19. Was ist ATM?

ATM steht für "Asynchronous Transfer Mode". Es handelt sich um ein asynchrones

Datenübertragungsverfahren für Hochgeschwindigkeitsnetze, bei dem die Daten in

winzige Pakete (cells, Zellen) von 53 Byte Länge (davon 48 Bytes Daten) zerhackt

18

werden. Es kann sowohl im WAN- (Wide Area Network) als auch im LAN- (Local

Network) eingesetzt werden. ATM wird im WAN-Bereich als verbindungsorientiertes

Protokoll geplant. Es ist aber auch verbindungsloser Service möglich, was für

bestimmte Anwendungen sehr günstig ist (z.B. Videokonferenzen über Multicasting

statt

vieler Verbindungen von Clients an einen Server). ATM erlaubt sehr hohe

Bandbreiten

- von 25 MBit/s über 155 MBit/s bis zu 622 MBit/s in naher Zukunft (und

möglicherweise auch 2 GBit/s).

Area

20. Welche Registerbreiten haben die jeweiligen Rechner u. welche Auswirkungen

haben sie?

Ein Register in der Computertechnik ist ein Speicherbereich innerhalb einer CPU

(Prozessor), in der ein Datenwort abgelegt wird. Es handelt sich hierbei um den

schnellsten und üblicherweise kleinsten (und manchmal auch einzigen) Speicher, der

direkt auf dem CPU-Chip sitzt. Die Größe der Register spezifiziert die CPU-Klasse (8,

16-, 32- oder 64 Bit-CPU). Eine CPU hat im allgemeinen mehrere Register, mit der

sie Rechenoperationen und Speicheroperationen durchführt. Es gibt aber auch CPUArchitekturen, die anstelle von Registern für Berechnungen einen Stack verwenden.

Die meisten Maschinenbefehle einer CPU nutzen diese Register.

21. Was versteht man unter einem 16 Byte Prozessor?

Bei dem von Intel 1978 vorgestellten 8086 handelt es sich um einen 16 Bit Prozessor

mit einem adressierbaren Arbeitsspeicher von 1 MB. Die logische Adressierung des

Arbeitsspeichers erfolgt dabei immer über ein Registerpaar, das aus Segment- und

Offsetadresse besteht. Bei beiden Adressen handelt es sich um 16 Bit Register.

22. Was ist der Unterschied zwischen Pentium II und Pentium III?

23. Unterscheiden Sie Pentium III und Celeron Prozessor!

24. Welche Modi gibt es beim Pentium III?

25. Warum ist Pentium III besser als Cache?

26. Unterscheiden Sie 386SX,DX und 486SX,DX!

27. Was ist die Superskalare Pipeline beim Pentium?

Prozessoren ab der fünften Generation sind mit mehreren internen Befehlspipelines

ausgestattet. Damit können Prozessoren pro Takt zwei Befehle gleichzeitig

ausführen. Diese Architektur gilt ab der fünften Generation der Prozessoren schon als

Standard. Zwei Pipelines statt nur eine.

28. Was ist der ALPHA-Chip?

Der Prozessor der regelmäßig die Krone in der Geschwindigkeit hält, ist Digital

Equipments Alpha Chip. Der Alpha Prozessor ist ein sehr kompromissloser RISC

Prozessor, es gibt keine Spezialregister, keine 8 oder 16 Bit Operanden. Die

gesamte

Architektur ist auf Erweiterung ausgelegt. So ist der erste (21064) mit nur

einer Integer und Fliesskommaeinheit ausgestattet, während das aktuelle Modell 21264

über 4 Integer, 2 Load/Store und 2 FPU Einheiten verfügt. Gegenüber dem aktuellen

Spitzenmodell von Intel dem Pentium 4 verfügt der Alpha nur über weniger als die

Hälfte der Transistoren (15.2 anstatt 42) und ist trotz nur halb so großen Takt, noch

um 25 % schneller. Der Alpha wurde gezielt entwickelt um bei Digital die alte

Architektur der MIPS und VAX zu ersetzen, und dabei war das Entwicklungsziel eine

Architektur zu schaffen die durch Taktsteigerungen, Superskalare Einheiten und

Multiprozessing um den Faktor 1000 steigerbar ist.

29. Kann ich das AIX von IBM auf einem IntelPC laufen lassen ?

Glaube nicht habe kein gefunden nur das hier:

RISC-Chips, PowerPC und POWER3 laufen mit einem AIX BS von IBM.

19

30. Was ist X.400?

Für den Austausch elektronischer Nachrichten gibt es ebenfalls einen von der ISO

genormten Standard. Dieser wird mit X.400 MHS (X.400 Message Handling System)

bzw. ISO MOTIS (Message Oriented Text Interchange System; ISO 10021)

bezeichnet. Er ist das funktionelle Pendant zum im Internet verwendeten SMTP.

X.400

wurde 1984 als X.400-X.430 Message Handling System von der CCITT

eingeführt

und 1988 deutlich in seiner Funktionalität erweitert. Der Begriff X.400 steht

stellvertretend für eine ganze Gruppe von Protokollen mit unterschiedlichen Aufgaben

31. Was ist ein Superchip?

Der Power4 bietet echtes Multiprozessing durch den Einsatz von zwei Prozessoren

auf einem einzigen 64-Bit-Chip. "Der Power4 ist im Hinblick auf die Taktrate mit

einem Pentium vergleichbar, tatsächlich ist er aber sehr viel leistungsfähiger", sagte

der Chef des Power4-Entwicklungsteams von IBM, Fred Ziebler

32. Was sind Parallele Prozessoren? Welche Vorteile bieten diese, welche

Nachteile?

Nix gefunden aber denke mal System wird schneller Nachteil das bs muss diese

Technologie unterstützen

33. Erläutern Sie die Entwicklung von Prozessoren!

Model

Transistore

n

Takt

Intel

4004

2.300

108 kHz

1973

Intel

8008

3.500

200 kHz

1978

Intel

8086

29.000

4,0-8,0

1989

Intel

80486

1.180.000

16-100

1991

AMD

386 DX

200.000

16-40

1993

AMD

486

930.000

33-100

1996

IBM

PowerPC

604e

5.100.000

166-250

1997

Intel

Pentium II

7.500.000

233-350

1997

AMD

K6

5.500.000

166-300

2000

Intel

Pentium

IIIe

2000

AMD

Duron

2000

Intel

Jahr

Hersteller

1971

28.000.000 700-1000

25.000.000

Pentium 4 42.000.000

600-950

>1400

Bemerkung

Erster Mikroprozessor; 4-Bit Datenbreite. Einsatz in

einigen Taschenrechnern sowie als Steuerbaustein für

elektronische Geräte.

Erste programmierbare CPU. 8-Bit Datenbreite, ist aber noch

nicht für höhere Programmiersprachen (Basic, Fortran, etc.)

geeignet.

Erste 16-Bit-CPU. Definiert die bis heute gültige "-x86"- Linie.

Kann mindestens 330.000 Befehle/ Sekunde abarbeiten.

Weiterentwickelte 80386-CPU mit integriertem

mathematischen Co-Prozessor und 4 mal so vielen

Transistoren wie beim 80386.

Erster AMD-Klon einer Intel-CPU. Trotz geringerer

Transistorenzahl und dank höherer Taktfrequenz dem

Original teilweise überlegen.

AMD-Klon des 80486-Mikro-Prozessors von Intel. Mikrocode

von Intel lizenziert (genehmigt).

Weiterentwickelte CPU der 6. Generation. Vergleichbar mit

dem Pentium Pro. Wird von IBM jedoch nicht in den eigenen

PC´s eingesetzt.

Zweite CPU der 6. Generation. Mit neuem MultimediaBefehlssatz (MMX). Neue Bauform-Platine statt Chip

erfordert neue Motherboards.

AMD-CPU der 6. Generation. Basiert auf dem Nx6x86,

jedoch mit MMX und Pentium-kompatibel. Teilweise

schneller als die Intel-CPU´s.

Zweite Version des P III; 3- fache Transistorenzahl

ermöglicht nahezu Verdoppelung der Taktfrequenz.

Die Sparvariante von AMD soll dem Intel Celeron

Konkurrenz machen. Im Gegensatz zu seinem großem

Bruder, der AMD Athlon, besitzt der Duron lediglich einen

L2-Cache von 64 KB.

Erste CPU der 8. Generation (64- Bit). Trotz neuer Features

kaum besser als der Pentium III. CPU, Mainboard und

Rambus-Speicher extrem teuer.

20

2000

AMD

2000

IBM

2002

AMD

2002

Intel

2002

AMD

2002

Intel

K7

Weiterentwickelte Variante des Athlon. Nun wieder in ChipThunderbir 29.000.000 800-1300 Bauform. Deutlich schneller und wesentlich billiger als der

d

Pentium 4.

IBM-CPU der 7. Generation. Weiterentwickelte IBM-Variante

PowerPC

21.500.000 500-700 der PowerPC 750-CPU. IBM und Motorola haben sich

750 Cx

wieder getrennt.

Weiterentwicklung des Athlon-Chips. Verfügt nun über

erweiterte Multimediafunktionen, unter anderem „SSE“.

Obwohl der Athlon um einiges weniger getaktet ist as ein

Athlon XP 37.500.000 1333-1733 Intel Pentium 4, ist der Athlon XP leistungsstärker. Daher

benennt AMD seine Prozessoren nicht nach der Taktzahl,

sondern nach seiner Leistung. So nennt sich ein Athlon XP

mit 1333 Mhz „AMD Athlon XP 1500+“.

Die Herstellung des Pentium 4 wurde von 0,18 Mikron auf

Pentium 4 55.000.000

>1500 0,13 Mikron reduziert, so dass nun Taktraten bis über 2 Ghz

möglich sind.

Der neue Prozessorkern "Thoroughbred" wird nun mit der

Athlon XP

>1466 0,13 µm-Technologie hergestellt. Dadurch sind höhere

Taktraten bei geringerer Temperatur möglich.

Intel führt die Hyperthreading-Technologie ein, welche ein

Pentium 4

Dual-Prozessor-System simuliert. So sollen Programme, die

>2800

"HT"

zwei Prozessoren unterstützen (z.B. mpeg rippen), einen

enormen Leistungsschub erhalten

Betiebssysteme

34. Was ist ein Betriebssystem?

Die Summe derjenigen Programme, die als residenter Bestandteil einer EDVAnlage für den Betrieb der Anlage und für die Ausführung der

Anwenderprogramme

erforderlich sind. Man unterteilt das Betriebssystem

üblicherweise in:

1. Steuerprogramme, das sind Programme für die

(a) Ausführungsvorbereitung (Job Management)

(b) Prozesskoordination (Task Management)

(c) Datenmanipulation (Daten Management) und für die

(d) Sicherung des Betriebsablaufs.

2. Arbeitsprogramme:

(a) Übersetzungsprogramme für die jeweils benutzte Programmiersprache,

wie

z.B. COBOL, FORTRAN, BASIC

(b) Standardisierte Dienstprogramme, wie z. B. das Sortieren, Mischen und

Laden von Dateien und für die Unterstützung des Testens von Programmen.

35. Welche Aufgaben übernimmt das BS

Ein Betriebssystem ist ein Programmpaket, das als Vermittler zwischen dem

Benutzer/Programmierer und der Hardware eines Computers fungiert. Die wichtigsten

Aufgaben sind:

•

Stellt dem Benutzer eine "Erweiterte Maschine" zur Verfügung, d.h. das BS

vereinfacht das Programmiermodell der Maschine durch Bereitstellung von

Funktionen auf höherem Abstraktionsniveau

•

Verwaltung von Ressourcen, d.h. effiziente Unterstützung von Hardware

36. Welche Betriebssysteme kennen Sie?

Microsoft Windows, Linux (SuSe. Mandrake, RedHat, Slackware), Unix, AIX

(IBM),

MAC(Apple).......

37. Was ist Multitasking?

21

Multitasking ist die Fähigkeit eines Betriebssystems, mehrere Aufgaben scheinbar

gleichzeitig auszuführen. Hierbei gibt es verschiedene Konzepte zur Handhabung

des

Multitasking. Die heutzutage am häufigsten angewendete Methode ist das

präemptive Multitasking, bei

dem der Betriebssystemkern die Abarbeitung der

einzelnen Prozesse steuert und jeden Prozess nach einer bestimmten Abarbeitungszeit zu

Gunsten anderer Prozesse anhält. Eine beliebte Umsetzung des

präemptiven

Multitaskings ist die Verwendung einer Priority Queue in Verbindung mit

der Round

Robin - Scheduling - Strategie.

38. Welche Arten von Betriebssystemen gibt es?

Single-User/Single-Tasking

Beispiel: MS-DOS (Microsoft Disk Operating System)

nur ein Benutzer kann aktiv sein

in einem Moment kann nur eine Anwendung auf dem PC laufen

Single-User/Multi-Tasking

Beispiel: Windows 98, Windows ME

nur ein Benutzer kann aktiv sein

in einem Moment können gleichzeitig mehrere Programm verwendet werden

Multi-User/Multi-Tasking

Beispiel: Linux, Windows 2000, Windows XP

mehrere Benutzer können aktiv sein

in einem Moment können gleichzeitig mehrere Programm verwendet werden

erfordert Zugriffsrechte und andere Schutzmechanismen

Frei Programmierbaren z.B. PC Betriebssystem im Privatenbereich

Keine Programmierbarkeit z.B. Handy

Ein Programmbetrieb(nur ein Programm im Hauptspeicher) z.B. MS-Dos

Mehr Programmbetrieb(mehrere Prgramme im Hauptspeicher) z.B.

Windows,Mac,Linux Unix

39. Wie kann man Betriebssysteme einteilen?

Systemumgebung und ihre Aufgabenstellung

Stapelbetrieb, Interaktiver Betrieb, Echtzeitbetrieb

Benutzerzahl

Einbenuntzerbetrieb, Mehrbenutzerbetrieb(Teilnehmerbertrieb)

Eingriffsmöglichkeiten des Benutzers

Off-Line-Betrieb

On-Line-Betrieb

Programmierbarkeit des Systems durch Benutzer

Frei programmierbar

Nicht programmierbar

Programm-/Speicherorganisation

Einprogrammbetrieb, Mehrprogrammbetrieb, Time-Sharing-Betrieb

40. Was sind proprietäre und offene Betriebssysteme?

Proprietäre Betriebssysteme

Betriebssysteme gelten als proprietär, wenn sie nur auf der Hardware des Herstellers

ablauffähig sind. Programmiersprachen und -systeme gelten als proprietär, wenn der

Befehlsumfang ausschließlich von einem einzigen Hersteller definiert

beziehungsweise weiterentwickelt wird.

Offenes System

In einem offenen System (engl.: open system) sind herstellerunabhängige

Spezifikationen für Schnittstellen, Dienste und unterstützende Formate

implementiert. Auf dieser Basis erstellte Anwendungssoftware gewährleistet

- Portierbarkeit (= Übertragbarkeit) auf verschiedene Systemplattformen,

- Zusammenspiel mit anderen Anwendungen und

- Durchgängigkeit von Benutzerinteraktionen mit konsistenter Benutzeroberfläche.

22

41. Was verbirgt sich hinter den Begriffen kooperatives und preemptives

Multitasking?

Kooperatives Multitasking: War die Bezeichnung für die erste Realisierung von

Multitasking unter Windows. Hierbei wurde das multitasking jedoch nicht vom

Betriebssystem verwaltet, sondern Windows war darauf angewiesen, dass sich die

einzelnen Programme an ganz bestimmt Konventionen halten. Die Programme

konnten selber bestimmen, wie lange sie den Prozessor nutzen wollten. Nach Ablauf

dieser Zeit wurde der Prozessor für andere Programme freigegeben. Der Nachteil war

natürlich, dass, wenn ein solches Programm abstürzte, der ganze Prozessor blockiert war

und Windows keine Möglichkeit hatte, diesen Konflikt zu lösen. Ein Neustart war

die

Folge, mit einem möglichen Datenverlust. Kooperatives Multitasking wird auch als

nonpreemptives Multitasking bezeichnen.

Preemptives Multitasking: Wird inzwischen von den meisten modernen

Betriebssystemen genutzt. Hierbei wird das Multitasking vom Betriebssystem verwaltet.

Das Betriebssystem bestimmt, wann welches Programm wieviel Rechenzeit bekommt. Ist

die zugewiesene Zeit abgelaufen, wird dem Programm der

Zugriff auf den Prozessor

entzogen und das nächste Programm bekommt den Zugriff.

Hierdurch ist völlig

unmöglich, dass die Programme selber bestimmen, wann sie den

Zugriff auf den

Prozessor abgeben. Ein wesentlicher Vorteil ist der, dass ein

abgestürztes Programm

den Prozessor nicht blockiert und damit das ganze System

wesentlich stabiler läuft

und abgestürzte Programme keinen Einfluss mehr auf andere Programme haben.

42. Warum brauche ich ein Betriebssystem?

Um die Hardware ansprechen zu können

43. Teilen Sie die verschiedenen BS nach Rechnerklassen ein!

Großrechner BS = IBM OS/390, Siemens BS2000.

Server BS = Apple Software Mac OS X, Microsoft Windows Server, Novell Netware,

Linux(SuSe, ReadHat, Slackware...), Unix(IBM, HP...)

Workstation, Clinet Rechner= Microsoft Windows, Apple Software Mac OS X,

Linux(SuSe, ReadHat, Slackware...)

44. Vergleichen Sie die beiden Betriebssysteme Windows und Unix!

45. Welche Vorteile bietet das Unix Dateisystem?

Rechtevergabe bei den Dateien oder Ordner. Der der die Datei erstellt hat kann sich

selber das recht nehmen diese auszuführen oder zu löschen. Erhöhte Sicherheit

dadurch das man erst rechte bekommen muss um dateien die einem nicht gehören

änder zu dürfen oder zu löschen.

46. Was ist Office?

Software von Microsoft zur Bearbeitung Büroübliche Arbeit wie z.B. Briefe schreiben,

Presentationen erstellen, Rechnungen in Tabellenschema erstellen usw.

47. Was ist ein Prozess und was ein Programm?

Ein Prozess ist eine durch ein Programm spezifizierte Folge von Aktionen, deren

erste begonnen, deren letzte aber noch nicht abgeschlossen ist. In manchen

Betriebssystemen wird anstelle von Prozess auch der Begriff Task oder Thread

verwendet.

Weitere mögliche Umschreibungen eines Prozesses:

Ein Programm in Ausführung Eine asynchrone Aktivität, Die Belebung einer

Prozedur, Wird manifestiert durch einen Prozess-Steuerblock (pcb),

Einheit der ein Prozessor zugewiesen werden kann, Zu bearbeitende Einheit

(dispatchable unit)

48. Wie werden Prozesse abgearbeitet?

Sobald ein Prozess zuvorderst in der Bereit-Liste steht, und der Prozessor verfügbar

wird, erhält dieser Prozess den Prozessor. Die Zuweisung des Prozessors wird durch

den Bearbeiter (= dispatcher) vorgenommen:

23

den

bearbeite(Prozessname):

bereit/ready

ausführend/running

Damit ein bestimmter Prozess den Prozessor nicht monopolisieren kann, gibt es in

vielen Betriebssystemen einen Timer der periodisch die Prozesse unterbricht, und

dem Betriebssystem (Bearbeiter) den Prozessor zurückgibt:

Timerende(Prozessname):

ausführend

bereit

Falls ein ausführender Prozess eine E/A Operation startet, so gibt dieser Prozess

Prozessor freiwillig frei bis zum Abschluss der E/A Operation:

blocken(Prozessname):

ausführend

blockiert

Sobald die E/A Operation beendet ist, wird der Prozess wieder aufgeweckt:

aufwecken(Prozessname):

blockiert

bereit

Nur der Übergang blocken wird vom Prozess selbst verlangt, alle übrigen Übergänge

werden durch das Betriebssystem gesteuert.

49. Erklären Sie die Phasen eines Prozesses?

Prozesszustände

ausführend (running):

Der Prozess besitzt im Augenblick den Prozessor.

bereit (ready):

Der Prozess könnte den Prozessor gebrauchen, falls dieser verfügbar wäre.

blockiert (blocked):

Der Prozess wartet auf ein bestimmtes Ereignis, bevor er weiterarbeiten kann.

50. Wie erkennt der Rechner welchen Prozess er abarbeiten soll?

Mit dem pcb wird ein Prozess einem Betriebssystem bekanntgemacht. Der pcb ist

eine Datenstruktur die nachstehendes enthält:

• aktueller Zustand des Prozesses

• eindeutige Identifikation des Prozesses

• Prozess Priorität

• Zeiger zum Speicher dieses Prozesses

• Zeiger zu den zugewiesenen Betriebsmitteln

• Bereich zum Retten der Register

Der pcb definiert den Prozess dem Betriebssystem gegenüber. Damit ein

Prozesswechsel schnell stattfinden kann, haben verschiedene Prozessorsysteme

spezielle Register die immer zum aktuellen pcb zeigen, oder Hardware Instruktionen die

einen Prozesswechsel durchführen können.

51. Unterscheiden Sie Batch- und Onlineprozess?

Batch =Abarbeitung am stück ohne weiter Enflußnahme von außen

Online= System ist interaktionsfähig

52. Wann lässt man Batchprozesse ablaufen?

Anwendung bei verarbeitungs- und datenintensiven Aufgaben(über nacht)

53. Wo liegt der Unterschied zwischen Batch-Verarbeitung und DialogVerarbeitung?

Batch-Verarbeitung (DV): Stapelverarbeitung. Sequentielle Abarbeitung eines

normalerweise sortiert auf Datenträgern gespeicherten Stapels von Vorgängen.

(Lochkarten Prinzip)

Dialogverarbeitung (DV): Durch den Bediener interaktiv ausgelöste und kontrollierte

Verarbeitungsprozesse. Normalerweise mit Bedienerführung über Hinweise auf dem

Bildschirm.(Mit Tastatur und Bildschirm, Terminal)

24

Kommunikationssysteme

1. Erläutern Sie das OSI Schichtenmodell?

Open Systems Interconnection. Auch ISO/OSI-Schichtenmodell, da es vom ISO

entwickelt wurde. Das OSI-Modell beschreibt den logischen Aufbau einer NetzwerkVerbindung zwischen zwei Computern, wobei die bei einer Verbindung anfallenden

Aufgaben verschiedenen Protokoll-Schichten zugeteilt werden.

Das OSI-Modell beschreibt einen theoretischen Ideal-Aufbau, so daß eine Zuordnung

in der Praxis, z.B. zum Internet, nicht ohne weiteres möglich ist. Die folgende

Gegenüberstellung ist daher nur ein Versuch.

07. Anwendung

FTP-Programm

06. Darstellung

FTP

05. Kommunikation z.B. FTP, HTTP, SMTP

04. Transport

z.B. TCP oder UDP

03. Vermittlung

IP, X.25, oder X.21

02. Sicherung

z.B. Ethernet oder Tokenring

01. Physikalisch

z.B. Ethernet oder Token-Ring

Die Kommunikation erfolgt immer nur zwischen zwei Schichten der gleichen Ebene.

Z.B. zwischen der Transportschicht von Computer A und Computer B, wobei sich

diese Schichten immer der Dienste der jeweils darunter liegenden Schichten

bedienen müssen, z.B. der Sicherungsschicht und der Physikalischen Schicht.

Für Programmierer hat das den Vorteil, daß ihre Anwendungen z.B. auf der

Transport-Schicht (z.B. dem TCP) aufbauen können. Der Programmierer muß sich

nur

um das Protokoll seiner Anwendung kümmern, den Rest erledigen die Programme der

unteren Schichten.

2. Was ist die Datenübertragungsgeschwindigkeit?

KBytes/s. Kann man sehen wie viele KBytes/s übertragen werden von einem

Rechner zum anderen. Mbits/s gib es auch schon

3. Was sind Datenautobahnen?

Highspeed Internet

4. Erklären Sie FDDI, ATM, Fast Ethernet, ADSL!

FDDI Fiber Distributed Data Interface

Durch ANSI (X3T9.5) genormtes Token-Passing-Glasfaser-Netz mit Doppel-RingTopologie. Zu den wichtigsten Definitionen von FDDI zählen PMD und PHY

(physikalische Ebene) und MAC (data link layer) sowie SMT. Die maximale Anzahl

der

Stationen beträgt 500, die maximale Ausdehnung 100 km. Zwischen zwei

benachbarten Komponenten ist ein maximaler Abstand von 2 km möglich. Es existiert

FDDI-I (Netz für reine Datenübertragung, 100 MBit/s) und FDDI-II, das Daten- und

Sprachübertragung (synchron/isochron) ermöglicht. FDDI-II wird auch als Hybrid Ring

Control (HRC) bezeichnet

Asynchronous Transfer Mode

Eine Technologie für vermittelte, verbindungsorientierte LANs und WANs. Sie

ermöglicht einer theoretisch unbegrenzten Anzahl von Netzbenutzern dedizierte

Hochgeschwindigkeitsfestverbindungen sowohl untereinander als auch mit Servern. Als

Vermittlungstechnik ("Cell-Relay") soll sie im Breitband-ISDN (B-ISDN) oder auch

im

Switched Multimegabit Data Service (SMDS-Netze) eingesetzt werden. Aber auch

im

LAN-Bereich macht ATM mit Hilfe von ATM-LAN-Emulationen mehr und mehr von

sich

reden. ATM basiert auf einem schnellen Zell-Switching (Pakete fester Größe: 48+5 Byte),

das variable Bitraten (je nach Anforderung) ermöglicht. Im

Zusammenhang mit ATM

spricht man nicht von Nachrichtenpaketen, sondern von Nachrichtenblöcken oder

Nachrichtenzellen (s.a. STM, DQDB).

Fast Ethernet

100BaseT wird auch als Fast Ethernet bezeichnet.

Es bezeichnet einen Standard für eine Ethernetverkabelung, die in Anlehnung an

25

10BaseT eine Übertragungsrate von 100 MBit/s ermöglicht. 100BaseT verwendet wie

10BaseT das Zugriffsverfahren CSMA/CD, ist also ein "richtiges" Ethernet.

Asymmetric Digital Subscriber Line

Digitales Übertragungsverfahren, das zu Beginn der 90er Jahre als

Weiterentwicklung von HDSL entwickelt wurde.

ADSL ist aber erst seit kurzer Zeit genormt, so daß es noch wenig verbreitet ist.

Es erlaubt auf den Kupferleitungen des Telefonnetzes relativ hohe

Übertragungsraten und läßt dabei die analoge Telefonübertragung unangetastet, weil es

erst im

Frequenzbereich ab 20 kHz arbeitet.

Während mit HDSL breitbandige Duplexverbindungen möglich sind, ist ADSL

unsymmetrisch ausgelegt.

So stehen upstream (vom Nutzer ins Netz) maximal 768 KBit/s und downstream

maximal 6,144 MBit/s zur Verfügung.

5. Unterschied FDDI/ATM

6. Nennen Sie eine typische Übertragungsgeschwindigkeit im Ethernet!

10Base Thin-Ethernet:

Geschwindigkeit = 10 Megabit/Sekunde

100Base Fast-Ethernet:

Geschwindigkeit = 100 Megabit/Sekunde

1000Base

Gigabit-Ethernet ist die Bezeichnung für die Standards IEEE 802.3z und IEEE

802.3ab, die Ethernet-Varianten mit einer Bandbreite von 1 GBit/s definieren

10GBase ist die Bezeichnung für eine Datenrate von 10 Gigabit/s im Basisband bei

10-Gigabit-Ethernet.

7. In welcher Größenordnung bewegt sich die

Datenübertragungsgeschwindigkeit beim Internet aus der Steckdose?

2,5 MBit/s

8. Welche Internetgremien gibt es damit das Internet funktioniert?

26

9. Wie unterscheiden sich Internet und Intranet?

Internet die ganze Welt im Cyberspace.

Intranet, abgeschottet vom Internet, beschränkt sich auf ein Unternehmen oder

Uni(beschränkte Fläche).Keine Möglichkeit nach außen zugelangen(ins Internet)

wenn kein Verbindungsstück vom Intranet zum Internet besteht.

10. Was ist HTTP, wozu, welche Eigenschaften? Wer hat's erfunden?

Tim Berners - Lee vom Cern in Genf war der Erfinder. 1994 gründete er am MIT das

World Wide Web Consortium (w3c), welchem seither die Entwicklung des WWW

(World Wide Web) obliegt. Das WWW basiert auf dem HTTP, ein Protokoll für die

Kommunikation zwischen einem Webserver und einem Client (Browser):

Der Client schickt dem Server einen Request auf seinen Port 80. Es gibt

verschiedene Typen von Requests (Methoden). Die gängigste Methode ist GET.

Diese

schickt einen URL (Universal Resource Locator), das was Sie im Browser als Adresse

eingeben. Ein URL ist eine eindeutige Adresse zu einer Ressource im Internet und besteht

aus mehreren Teilen:

protokoll://host:port/pfad

Zuerst steht das Protokoll, in unserem Fall http. Es folgt der Domain Name des Host

(oder auch einfach seine ip Adresse). Dann folgt die Portnummer unter welcher die

Applikation (der Dienst) auf dem Host erreichbar ist, in unserem Fall 80. Und zuletzt

wird der Pfad auf dem Host bis zum gewünschten Dokument angegeben. Lassen Sie

Teile des URL weg, setzt der Browser Standardwerte ein, also z.B. 80 bei http. Im

27

Normalfall schickt der Server dem Client als Antwort den Inhalt des gewünschten

Dokumentes zurück.

11. Was sind dynamische Webinhalte?

Es gibt keine html Seiten. Die html Seiten werden erst dann vom Rechner

erzeugt wenn ein Besucher auf diese Seite möchte. Durch ein einfachen

Programmier

Code wie z.B. PHP und mit einem Interpreter wie z.B. Apache lassen sich die Seiten

dynamisch generieren.

12. Was ist www?

World Wide Web= Internet auf der ganzen Welt.

13. Wie funktioniert ein Internetzugang?

Hardware

Das Internet ist ein weltweites Netz von Millionen von Rechnern. Sowohl

Computernetze als auch einzelne Rechner sind mit dem Internet verbunden bzw.

können für die Zeit einer Internet-Sitzung verbunden werden.

Netze und Computer gehören Universitäten, staatlichen Stellen, Institutionen, Firmen,

Privatleuten, Interessengruppen, Parteien u.v.a..

Die weltweite Vernetzung wird über verschiedene Kommunikationswege mit

unterschiedlicher Kapazität erreicht: Glasfaserkabel, Richtfunkstrecken, Telefon-,

ISDN- oder gar Satellitenverbindungen u.a.

Die Leitungen und Übermittlungseinrichtungen gehören in der Regel privaten oder

staatlichen Telekommunikatons-Unternehmen.

Es gibt also keinen, dem das Internet alleine gehört. Das Internet befindet sich