Jubiläums-Dossier 2017

Werbung

Jubiläums-Dossier 2017

30 Seiten gebündeltes Wissen zu

Mobile-/App-Trends, -Development,

-Business & -Design

bastacon

www.basta.net

Inhalt

.NET Framework & C#

Tolle Typen – Wie statisch muss Typisierung sein? Kolumne: Olis bunte Welt der IT

3

von Oliver Sturm

Agile & DevOps

ViewModels test­getrieben entwickeln Test-driven Development (TDD) in MVVM-Apps

7

von Thomas Claudius Huber

VSTS/TFS – ganz nach meinem Geschmack Verschiedene Erweiterungs- und Anpassungsmöglichkeiten

16

von Marc Müller

Web Development

Echtzeitchat mit Node.js und Socket.IO

Nutzung von echtem Server-Push mit dem WebSocket-Protokoll

22

von Manuel Rauber

Mit Azure zur IoT-Infrastruktur

Vom Gerät zum Live-Dashboardl

35

von Thomas Claudius Huber

Data Access & Storage

Entity Framework Core 1.0

Was bringt der Neustart?

42

von Manfred Steyer

HTML5 & JavaScript

Die Alternative für JavaScript-Hasser

TypeScript = JavaScript + x

48

von Dr. Holger Schwichtenberg

Asynchrones TypeScript

TypeScript lernt async/await

58

von Rainer Stropek

User Interface

Das GeBOT der Stunde?

Conversational UIs: Ein erster Blick auf das Microsoft Bot Framework

von Roman Schacherl und Daniel Sklenitzka

64

DOSSIER

.NET Framework & C#

Kolumne: Olis bunte Welt der IT

Tolle Typen –

Wie statisch muss

Typisierung sein?

Wenn es quakt wie eine Ente und schwimmt wie eine Ente, dann ist es eine Ente.

Sie haben diesen Spruch schon einmal gehört – er wird von Verfechtern der dynamischen Programmierung seit Jahren immer wieder vorgetragen. Die Ente ist sinnbildlich ein Objekt, ein Element, mit dem anderer Code arbeitet, und an das dieser

Code Erwartungen hat: quaken soll sie können, und schwimmen, und wenn das

gegeben ist, dann ist alles in bester Ordnung.

von Oliver Sturm

Statische Typisierung – eine Evolution

Im Mainstream der Softwareentwicklung, besonders im

großen Bereich der Businesssoftware, ist man in Hinsicht auf Entenprobleme gern anderer Meinung. Statisch typisierte Sprachen haben in diesem Bereich lange

dominiert, und diese Sprachen mögen eine Ente nur,

wenn sie klar definiert ist. Gefieder- und Schnabelfarbe,

Gewicht und Schwanzlänge müssen sorgsam in einem

Objektmodell abgelegt und notwendige Schnittstellen

wie ISchwimmfähigesTier definiert und implementiert

werden. Irgendwann darf dann auch gequakt und geschwommen werden, aber nur unter penibler Kontrolle

der Compiler- und Laufzeitsysteme.

Viele Programmierer sind der Auffassung, dass diese

statische Typisierung sich aus einem evolutionären

Vorgang entwickelt hat und letztlich grundlegend

„besser“ ist als eine offenere Anschauung der Entenproblematik. In einer bestimmten Gruppe von Sprachen ist diese Ansicht durchaus nachvollziehbar. In

Sprachen wie C und später Pascal gab es zunächst nur

eine trügerische Art von Typsicherheit: Es gab zwar

Typen, aber es war sehr einfach, dem Compiler seinen Irrtum in Hinsicht auf eine bestimmte Typisierung

mit einem simplen Cast verständlich zu machen. Alles

basierte auf Zeigern, und letztlich zählte das Verständnis des Programmierers mehr als das des Compilers.

www.basta.net

3

DOSSIER

Datentypen wie die Unions in C und die varianten Records in Pascal machten sich dies schamlos zunutze,

und große Speichereffizienz und Performance konnte

auf dieser Basis erzielt werden – wenn auch mit beträchtlichem Risiko.

In strikt objektorientierten Sprachen, zunächst in

erster Linie Java, wurde Typen ein ganz neuer Stellenwert eingeräumt. Der Cast wurde vom Befehl zur Anfrage degradiert, und ohne Zustimmung von Compiler

und Runtime konnte der Programmierer nicht mehr

beliebig mit Typen umgehen. Drei Schritte wurden

hier gemacht, um Typsicherheit zu erzwingen. Erstens

musste der Programmierer nun sorgsam spezifische Typen definieren, und seinen Code so strukturieren, dass

Typkonversionen außerhalb des Systems nicht mehr

notwendig waren. Zweitens, und darauf aufbauend,

konnten Compiler und Runtime die korrekte Verwendung dieser Typen erzwingen und so die gewünschte Sicherheit herbeiführen. Drittens war es notwendig, das

Verständnis des Programmierers immer wieder durch

die klare Nennung der Typbezeichnungen im Code zu

versichern – eigentlich ein erheblicher Aufwand, aber

im Vergleich zu komplexen Zeigern in C oder C++ sahen die Typnamen auf den ersten Blick so übersichtlich

aus, dass man damit zunächst ziemlich glücklich war.

In der .NET-Welt wurde die Idee der strikten Typisierung ebenfalls umgesetzt und tief in den Sprachen

der Plattform verankert. C# unterstützt aus Kompatibilitätsgründen mit der Windows-Plattform auch

Strukturen, die ein bestimmtes statisches Speichermapping anwenden. Mit dem var-Schlüsselwort in C#

versuchte man, den Aufwand etwas zu mindern, der

dem Programmierer durch die wiederholte Verwendung der Typnamen entsteht. Typherleitung ist in C#

allerdings sehr rudimentär, und jeder verwendete Typ

muss zumindest einmal beim Namen genannt werden.

Mit einem anderen Schlüsselwort, dynamic, sollte eine

Anbindung an dynamische Welten vereinfacht werden.

Das machte C# zu einer relativ flexiblen statisch typisierten Sprache, schaffte aber auch Verwirrung bei Anwendern, die von der Microsoft-Welt klare Strategien

erwarteten und gewohnt waren.

.NET Framework & C#

Basis von implementiertem Verhalten: Der Compiler

leitet etwa automatisch her, dass Typen, mit denen Addition betrieben wird, zu einer gemeinsamen Typklasse

gehören, die genau diese Fähigkeit verallgemeinert.

Auf der .NET-Plattform bietet F# sehr gute Unterstützung für Typherleitung, die sich allerdings nicht in jedem

Detail in den objektorientierten Bereich erstreckt und,

mangels der entsprechenden Basis in der CLR, auch keine Typklassen kennt. Somit bleibt generell die Tatsache

bestehen, dass statische Sprachen Mehraufwand für den

Programmierer erzeugen, da kontinuierlich sorgfältige

Pflege der Typen und aller Anwendungspunkte betrieben werden muss. Natürlich soll damit nicht gesagt sein,

dass dem kein positiver Wert gegenübersteht, aber die

Arbeit zur Pflege von strikt typisiertem Code kann oft

beträchtlich sein.

Dynamischer entwickeln

Tatsache ist, dass die Welt der Programmierung heutzutage dynamischer ist denn je. Wenn vor einigen

Jahren die Frage gestellt wurde, was für unmittelbare

Vorteile die Verwendung dynamischer Sprachen vorzuweisen habe, dann wurden als Antwort gewöhnlich

bestimmte Anwendungsfälle beschrieben. Ich selbst

habe immer gern ein Szenario einer Tabellenkalkulationssoftware beschrieben, die in Python implementiert

wurde, und ein unglaublich einfach verwendbares API

hatte, basierend auf der Tatsache, dass mittels dynamischer Mechanismen extrem einfache Syntax für

Zelladressierung möglich war. MySheet.K5 liest sich

eben besser als MySheet.Cells[„K5“], um ein simples

Beispiel zu nennen. Auch im Bereich von Object-relational Mapping gab es beeindruckende Beispiele von

ähnlicher Natur. Heute hingegen ist Dynamik ein elementarer Bestandteil von Applikationsarchitekturen

und Entwicklungsmethoden, und ihr muss deshalb eine

wesentlich größere Bedeutung beigemessen werden.

Typen ohne Aufwand

Besuchen Sie auch folgende Session:

Wie wäre es, wenn der Compiler mit Typen arbeiten

und deren korrekte Verwendung garantieren könnte,

ohne dass dem Programmierer dadurch syntaktischer

Aufwand entsteht? Mithilfe extrem leistungsfähiger

Typherleitung ist dies tatsächlich möglich, wie etwa

das Typsystem der Sprache Haskell beweist. Wertzuweisungen müssen in Haskell nur in Konfliktfällen mit

Typannotationen versehen werden, sodass der Code

im Allgemeinen ganz ohne die Erwähnung expliziter

Typen auskommt – der Compiler leitet die Typen her

und prüft sie, aber der Programmierer wird damit nicht

belastet. Was Haskell allerdings zusätzlich besonders

interessant macht, ist die Fähigkeit zur automatischen

Verallgemeinerung. Dies funktioniert sogar auf der

Line-of-Business-Apps mit der Universal Windows Platform entwickeln

www.basta.net

Thomas Claudius Huber

Zum Entwickeln von nativen Windows-Anwendungen stellt die Universal Windows

Platform (UWP) nach der WPF die neuste

Technologie dar. Doch inwiefern lässt sich

die UWP zum Entwickeln von Business-Apps einsetzen? Wie sieht es mit den typischen Anforderungen

aus – Datenbindung und MVVM-Unterstützung, Validierung etc.? In dieser Session erfahren Sie im LiveCoding, was die UWP heute zum Entwickeln einer

klassischen Enterprise-App bietet und wohin die Reise geht.

4

DOSSIER

Dynamische Sprachen im .NET-Umfeld

In verteilten Systemen kommt es immer wieder vor,

dass APIs externalisiert werden, die in der Vergangenheit elementarer Bestandteil des eigenen Systems waren.

Das passiert zum Beispiel, wenn zur Datenablage oder

zu anderen Zwecken Cloud-Dienste verwendet werden

oder ähnliche Integrationen mit Diensten von Drittanbietern stattfinden. REST-Zugriff und Datenübertragung im JSON-Format führen in solchen Fällen leicht

zu sehr dynamischen APIs, die der Programmierer nicht

selbst beeinflussen kann, mit denen der Programmcode

aber möglichst flexibel arbeiten muss, um dauerhaft

stabil zu bleiben.

Die Problematik ist bei der Nutzung von offensichtlich externen Diensten nicht neu. Allerdings bringt die

Idee der Microservices dieselben Umstände direkt ins

eigene Haus. Modularisierung wird bei Anwendung

dieses Schemas zur Disziplin, und eine große Anzahl

eigenständiger Dienste wird unabhängig von mehreren Teams gepflegt und sogar betrieben, um ein

Anwendungssystem aufzubauen. Diese Dienste müssen sich natürlich austauschen, was gewöhnlich mit

ähnlichen Mitteln geschieht wie bei der Einbindung

externer Dienste. Daraus entsteht natürlich eine beeindruckende Konsistenz, aber auch die Notwendigkeit,

dort dynamisch zu denken, wo es um die Schnittstellen zwischen einzelnen Komponenten geht. Auch Systeme zur bidirektionalen Kommunikation oder zum

Message-basierten Austausch von Informationen sind

gewöhnlich in diesem Sinne dynamisch. Letztlich halten dynamische Komponenten sogar im allgemeinen

.NET-Umfeld Einzug, wie etwa in ASP.NET MVC, wo

anonyme Objekte zur Konfiguration und zur Übertragung von Daten zwischen Views und Controllern seitens Microsoft favorisiert werden.

Die Historie dynamischer Sprachen ist ebenso lang

und interessant wie die der statisch typisierten. Lisp,

eine der ältesten Programmiersprachen, ist dynamisch

und bildet die Basis vieler anderer Sprachen. Clojure

ist eine Lisp-basierte Sprache, die im Java-Umfeld sehr

beliebt ist und sich auch auf .NET verbreitet. In Objective-C gibt es Message Passing in der Sprache selbst,

wodurch Dynamik erreicht werden kann. Erlang ist

dynamisch und wird immer wieder aufgrund seiner beeindruckenden Fähigkeiten in der Parallelisierung als

Beispiel herangezogen, und das Schema der Aktoren,

das in Erlang von großer Bedeutung ist, kann mittlerweile auf allen wichtigen Plattformen angewandt

werden. In Python wurden und werden große Anwendungssysteme entwickelt, und dann gibt es natürlich

JavaScript, dessen Bedeutung heute kaum überschätzt

werden kann.

Pflegeleichte Typsicherheit

Der Vorteil dynamischer Sprachen in der beschriebenen

dynamischen Umgebung besteht hauptsächlich darin,

dass der Aufwand zur Pflege bestimmter Elemente einer

Codebasis wesentlich niedriger ist als bei der Anwen-

www.basta.net

.NET Framework & C#

dung statisch typisierter Sprachen. Wenn ein externes

API geändert wird, kann der eigene Code womöglich

ohne Änderungen weiter arbeiten, und wenn Änderungen notwendig werden, müssen sie an weniger Codestellen durchgeführt werden.

Der Programmierer statisch typisierter Sprachen verlässt sich gern darauf, dass Compiler und Runtime einen

Teil der Prüfungen durchführen, die sicherstellen, dass

Programmcode in Hinsicht auf Datentypen korrekt ist.

Daraus entsteht die größte Skepsis in Bezug auf dynamische Sprachen: Wie kann ein stabiles Ergebnis erzielt werden, wenn keine Typsicherheit besteht?

Auf diese Frage gibt es drei wesentliche Antworten. Zunächst gibt es bei dynamischen APIs gewisse

Patterns, die direkt der langfristigen Stabilität von

Anwendungssystemen dienen. APIs können auf diese

Weise versioniert werden, sodass Clients nicht sofort

mit jeder Änderung kompatibel sein müssen. Natürlich wollen solche parallelen Versionen eines API gepflegt werden, und Regeln etabliert, um gleichzeitig

den Anwendern des API Sicherheit zu geben und den

Pflegeaufwand überschaubar zu halten.

Zweitens verwenden auch dynamische Programmierer gern Softwarewerkzeuge, etwa zur statischen Codeanalyse, deren Mechanismen oft ähnliche Resultate

erzielen können wie ein Compiler einer statisch typisierten Sprache. In diesen Bereich fällt auch Microsofts

TypeScript, das mithilfe einer eigenen Syntax und eines

Compilers eine gewisse Typsicherheit für JavaScript

herbeiführt.

Die dritte Antwort, und wohl die wichtigste, besteht

aus der Erzeugung von automatisierten Tests. Aus Statistiken geht hervor, dass die Anzahl von Tests in Projekten auf Basis dynamischer Sprachen oft wesentlich

größer ist als bei statisch typisierten. Im dynamischen

Besuchen Sie auch folgende Session:

Enterprise-Apps mit Xamarin und den

Azure App Services entwickeln

Jörg Neumann

Die Anforderungen an eine Business-App

steigen stetig. Sie soll auf verschiedenen

Plattformen laufen, auch von unterwegs Zugriff auf Unternehmensdaten bieten und natürlich offlinefähig sein. Für solche Aufgaben bieten die Azure

App Services elegante Lösungen. Sie ermöglichen

eine einfache Bereitstellung von Backend-Services,

die Anbindung an unterschiedliche Datenquellen und

eine Integration ins Unternehmensnetz. Zudem werden verschiedene Varianten der Authentifizierung

und der Versand von Push-Benachrichtungen geboten. Jörg Neumann zeigt Ihnen, wie Sie mit Xamarin

und den Azure App Services Enterprise-taugliche

Apps entwickeln und betreiben können.

5

DOSSIER

Umfeld wird die Erzeugung von Tests gewissenhafter

betrieben, und die Abdeckung bestimmter Szenarien ist

größer, um Fehler aufgrund der falschen Verwendung

von Typen auszuschließen.

Gerade dieser letzte Teil wird von manchen Programmierern leider als Problem angesehen. Obwohl

die Erzeugung einer möglichst vollständigen Testbasis

seit Langem eine anerkannte Best Practice ist, hat diese sich in vielen Projekten und Entwicklerteams bisher nicht durchsetzen können. Oft wird als Grund der

Aufwand genannt, der als zu hoch empfunden wird.

Realistisch und korrekt ist dies meiner Erfahrung nach

nicht. Selbst in bestehenden Projekten, die statische Typisierung verwenden, lohnt sich die Einführung einer

guten Testbasis gewöhnlich schnell, da die Stabilität

des Codes steigt, Fehlerbehebung sich vereinfacht und

Regression ausgeschlossen werden kann. In modernen

Anwendungssystemen, die mit der zuvor beschriebenen Dynamik der umgebenden Welt umgehen müssen,

steht dem Aufwand der Testerzeugung außerdem der

Pflegeaufwand statischer Typsysteme gegenüber, der

unter Umständen sehr erheblich sein kann.

Fazit

Statisch und dynamisch typisierte Sprachen haben

Vor- und Nachteile, wie auch jede einzelne Sprache

im Vergleich mit jeder anderen. In der heutigen Zeit

können Sie deutlich Zeit gewinnen und konzeptionell

leistungsfähigere Anwendungen bauen, wenn Sie sich

die Fähigkeiten dynamischer Sprachen zunutze machen

www.basta.net

.NET Framework & C#

und die Ideen der Dynamik akzeptieren. Sie haben die

Wahl, welche Methoden zur Absicherung Sie einsetzen

möchten, aber letztlich hilft vor allem eine Maßgabe,

die in der Softwareentwicklung eine der ältesten ist: testen, testen und nochmal testen!

Besuchen Sie auch folgende Session:

TypeScript für .NET-Entwickler

Christian Wenz

Mit TypeScript macht sich Microsoft daran,

das – für viele Entwickler aus dem eigenen

Kosmos – ungewohnte JavaScript zugänglicher zu machen, indem beispielsweise statisches Typing und bestimmte OOP-Features hinzugefügt werden. Nach einigen Anlaufschwierigkeiten hat

TypeScript inzwischen auch außerhalb der MicrosoftWelt Traktion erhalten. Viel besser noch: Angular

setzt auf TypeScript! Es ist also höchste Zeit, sich

mit der Sprache zu beschäftigen. Diese Session stellt

die Features von TypeScript vor und geht dabei auch

auf die Toolunterstützung seitens Visual Studio und

Co. ein. Damit sind Sie auch für die Entwicklung von

Anwendungen auf Basis von Angular bestens gewappnet.

6

Agile & DevOps

©S&S Media, ©iStockphoto.com/danleap

DOSSIER

Test-driven Development (TDD) in MVVM-Apps

ViewModels test­

getrieben entwickeln

Einer der zentralen Vorteile des Model-View-ViewModel-Patterns (MVVM) ist es, dass

sich ViewModels automatisiert testen lassen. Das ViewModel ist unabhängig vom UI

und enthält nur die UI-Logik; eine Tatsache, die es zu einem idealen Kandidaten für

Unit-Tests macht. Doch um ein testbares ViewModel zu erhalten, muss ein Entwickler

ein paar Punkte beachten, insbesondere beim Laden von Daten oder beim Anzeigen

von Dialogen. Worauf es ankommt und wie ViewModels testgetrieben entwickelt werden, zeigt dieser Artikel. Dabei werden das Unit-Testing-Framework xUnit, die Mocking

Library Moq und das Dependency-Injection-Framework Autofac eingesetzt.

von Thomas Claudius Huber

„Ich habe genug zu tun, da hab‘ ich doch nicht noch Zeit,

um Unit-Tests zu schreiben“. Diese Aussage hört man

nur allzu oft von Entwicklern, insbesondere von jenen,

die noch nie in einem testgetriebenen Projekt mitgearbeitet haben. Von Michael Feathers, Autor des erfolgreichen

Buchs „Working with Legacy Code“, stammt folgendes

Zitat: „Code ohne Tests ist schlechter Code“. Der Grund

www.basta.net

Hinweis

In diesem Artikel wird auf xUnit gesetzt, aber wenn

Sie MSTest oder NUnit nutzen, ist das auch in Ordnung. Wichtig ist allein die Tatsache, dass Sie überhaupt Unit-Tests schreiben, um wartbaren Code zu

erhalten. Welches Unit-Testing-Framework Sie dafür

einsetzen, ist zweitrangig.

7

DOSSIER

Agile & DevOps

Unit-Test entweder rot oder grün sein muss, also keine

manuellen Schritte enthalten darf. Muss der Entwickler

beispielsweise nach dem Test manuell prüfen, ob eine

bestimmte Datei erstellt wurde, dann ist es kein UnitTest mehr, da er sich nicht selbst validiert.

So viel zu den Regeln. Sind die Unit-Tests für den eigenen produktiven Code geschrieben, ergeben sich einige

Vorteile:

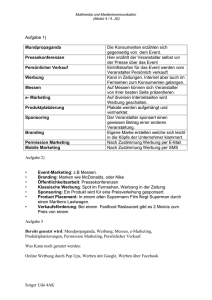

Abb. 1: Test-driven Development

ist folgender: Wenn es Tests gibt, kann ein Entwickler

das Verhalten des Codes sehr schnell und verifizierbar

ändern, da er nach dem Ändern des Codes die Unit-Tests

laufen lässt, um zu sehen, ob er nicht aus Versehen bestehende Logik zerstört hat. Ohne Tests kann der Entwickler nach dem Ändern des Codes niemals wissen, ob der

Code jetzt besser oder schlechter ist.

In diesem Artikel wird nur „guter Code“ geschrieben.

Nach einem Blick auf Unit-Tests, Test-driven Development [1] und das xUnit-Framework zeigt der Artikel,

wie testbare ViewModels geschrieben werden und wie

sie sich testen lassen.

Unit-Tests

Ein Unit-Test ist ein automatisierter Test, der bekanntlich ein Stück produktiven Code testet. Ein Unit-Test

erfüllt dabei verschiedene Eigenschaften, die unter dem

Akronym F.I.R.S.T zusammengefasst sind [2]. UnitTests sind schnell (Fast), unabhängig voneinander

(Isolates), wiederholbar in einer beliebigen Umgebung

(Repeatable), selbstvalidierend (Self-validating) und

werden zeitlich mit oder sogar vor dem produktiven

Code geschrieben (Timely).

Damit diese Eigenschaften eines Unit-Tests erfüllt

sind, muss der produktive Code ein entsprechendes Design erfüllen. Beispielsweise muss es möglich sein, den

Unit-Test in einer beliebigen Umgebung zu wiederholen

(Repeatable): im Zug, zuhause, im Büro oder sogar auf

dem Mond ohne Internet. Das bedeutet, dass beispielsweise ein Datenbankzugriff nicht im produktiven Code

enthalten sein darf; er muss mit einem Interface abstrahiert werden. Dann wird im produktiven Code auf dieses

Interface programmiert und eben nicht auf eine konkrete Implementierung, die auf die Datenbank zugreift. Im

Unit-Test kommt dann eine Testimplementierung des

Interface zum Einsatz, ein so genanntes Mock-Objekt.

Dieses Mock-Objekt hat die Aufgabe, den Datenbankzugriff für den Test zu simulieren. Näheres dazu später

beim Datenzugriff aus einem ViewModel.

Das S im F.I.R.S.T-Akronym sagt, dass ein Unit-Test

auch selbstvalidierend sein muss. Das bedeutet, dass ein

www.basta.net

• Es lassen sich Änderungen durchführen, ohne dass

existierende Logik zerstört wird.

• Gute Tests ergeben auch eine gute Dokumentation.

• Das Schreiben von Unit-Tests kann das Design des

produktiven Codes positiv beeinflussen.

• Das Schreiben von Unit-Tests erfordert, dass man

bereits vor der Implementierung stärker über das

Problem nachdenkt.

Doch läuft die Anwendung fehlerfrei und stabil, wenn

alle Unit-Tests grün sind? Natürlich nicht, es braucht

auch noch Integrationstests.

Unit-Test vs. Integrationstest

Unit-Tests allein sind kein Heilbringer. Viele grüne

Unit-Tests bedeuten noch nicht, dass eine Anwendung

danach keine Fehler mehr hat. Neben Unit-Tests, die

nur ein Stück Code isoliert betrachten, gibt es viele

andere Testarten. Eine sehr wichtige stellen die Integrationstests dar. Beim Integrationstest gibt es keine

Mock-Objekte wie beim Unit-Test. Es wird beispielsweise auf eine Datenbank zugegriffen, es wird der

richtige Web Service aufgerufen etc. Das heißt, beim

Integrationstest geht es darum, wie die einzelnen getesteten Einheiten (Units) dann tatsächlich zusammenspielen.

Zum Schreiben von Integrationstests lässt sich auch

ein Unit-Testing-Framework wie xUnit einsetzen. Dabei

werden im Test dann eben keine Mock-Objekte, sondern die richtigen Objekte verwendet – beispielsweise

für den Datenbankzugriff.

Besuchen Sie auch folgende Session:

Git-Grundlagen für Entwickler

Thomas Claudius Huber

Git hat sich in den letzten Jahren zum Standard für die Sourcecodeverwaltung und

-versionierung entwickelt. Doch immer

noch fehlen Entwicklern die Grundlagen, um Git voll

und ganz zu verstehen. Damit machen wir hier

Schluss. In dieser Session lernen Sie die Basics von

Git, um zu „fetchen“, „pullen“, „pushen“, „committen“ und natürlich auch, um mit Tags und Branches

umzugehen.

8

DOSSIER

Test-driven Development

Test-driven Development (TDD) ist eine Vorgehensweise zum Schreiben von produktivem Code, die sich

Unit-Testing zu Nutze macht. Dabei ist ein zentrales

Prinzip, dass der Unit-Test vor und eben nicht mit oder

nach dem produktiven Code geschrieben wird. Beim

Einsatz von TDD befindet sich der Entwickler in einem

ständigen Kreislauf der drei Phasen Red/Green/Refactor (Abb. 1), die in dieser Reihenfolge immer wieder

durchlaufen werden:

1. Red: Es wird ein Unit-Test geschrieben, der fehlschlägt, da der produktive Code noch nicht implementiert wurde.

2. Green: Der produktive Code wird erstellt/angepasst.

Und zwar lediglich so, damit der Unit-Test grün wird.

3. Refactor: Der produktive Code wird überarbeitet

und strukturiert. Alle Unit-Tests müssen danach

weiterhin grün sein. Ist der Entwickler zufrieden mit

der Struktur, geht es weiter mit Schritt 1, indem der

nächste Unit-Test geschrieben wird.

Test-driven Development hat neben den Vorteilen des

klassischen Unit-Testings weitere Vorteile:

• Da der Test vor dem produktiven Code geschrieben

wird, hat der produktive Code auf jeden Fall ein

testbares Design.

• Das Schreiben des Tests vor dem produktiven Code

erfordert eine genaue Analyse der Anforderungen.

• Die eigene Logik kann bereits fertiggestellt werden,

auch wenn beispielsweise der dazu benötigte Datenbankserver noch nicht läuft.

Insbesondere der letzte Punkt ist spannend: In größeren

Teams können Entwickler ihren Teil bereits fertigstellen, auch wenn andere Teile der Software noch fehlen.

Beispielsweise kann ein fehlender Datenbankzugriff in

einem Unit-Test mit einem Mock-Objekt simuliert werden. Somit kann die Logik isoliert fertiggestellt werden,

auch wenn der Datenbankzugriff noch nicht vorhanden

ist. Es braucht dazu lediglich das entsprechende Interface, das später implementiert wird.

Spikes in TDD

Immer mit einem roten Unit-Test zu starten, ist in manchen Fällen etwas schwierig. Insbesondere, wenn sich

ein Entwickler nicht

sicher ist, ob der eingeschlagene Weg für

Listing 1

ein größeres Feature

public class MainViewModelTests

auch funktionieren

{

wird – dann ist es bei

[Fact]

TDD natürlich unsinpublic void ShouldLoadFriends()

nig, zuerst mit einem

{

Test zu starten. In ei}

nem solchen Fall wird

}

ein so genannter Spike

www.basta.net

Agile & DevOps

erstellt. Ein Spike ist ein Durchstich und ein Experiment;

er stellt sicher, dass der eingeschlagene Weg funktioniert.

Der in einem Spike geschriebene Code sollte nach Sicherstellung der Funktion laut Theorie wieder verworfen

werden. Anschließend sollte es wieder TTD üblich nach

Red/Green/Refactor weitergehen. In der Praxis sieht es

meist so aus, dass erfahrene Entwickler Spikes schreiben,

die danach auch zu 100 Prozent testbar sind, womit sie

manchmal den klassischen TDD-Zyklus umgehen.

Das Testing-Framework xUnit

Es gibt viele interessante Unit-Testing-Frameworks. Mit

Visual Studio wird das von Microsoft bereitgestellte

MSTest installiert. MSTest ist mittlerweile – insbesondere im .NET-Core-Zeitalter – etwas in die Jahre gekommen. Microsoft arbeitet aktuell an einer Version 2

von MSTest, die allerdings noch nicht fertiggestellt ist.

Neben MSTest ist das aus der Java-Welt von JUnit

auf .NET portierte NUnit sehr beliebt. NUnit wurde

mittlerweile komplett neu geschrieben, um die Vorteile

von .NET auszunutzen. Einer der Entwickler von NUnit

hat sich dazu entschlossen, xUnit zu erstellen, da ihm

sowohl NUnit als auch MSTest zu schwergewichtig waren. xUnit ist heute ebenfalls ein sehr beliebtes Framework und derzeit auch die erste Wahl des Autors. Einige

Gründe dafür sind:

Besuchen Sie auch folgende Session:

VS Team Services: Die fertige Teamumgebung von Microsoft in der Cloud

Neno Loje

Visual Studio Team Services ist Microsofts

offene Plattform für Ihre gesamte Softwareentwicklung. Und die ist so vielseitig

wie die Aufgabenstellungen, mit denen es Entwicklungsteams heutzutage zu tu bekommen. So werden

Builds unter Linux und iOS oder Projekte in Java

oder für mobile Plattformen wie Android und iOS

ebenso unterstützt wie das moderne .NET Core. Die

fertige Teamumgebung als Cloud-Lösung wird u. a.

in Westeuropa gehostet und ist für kleine Teams (bis

fünf Benutzer), für Stakeholder sowie MSDN-Abonnenten kostenlos. Der administrative Aufwand ist gering und gibt Ihrem Team Zeit und Raum, sich auf die

eigentliche Arbeit zu fokussieren. In diesem Vortrag

begeben wir uns gemeinsam auf einen Rundgang

durch VS Team Services, klären, welches die Unterschiede zum klassischen Team Foundation Server

(TFS) sind, welche Kosten entstehen und wie eine

Migration vom TFS zu VSTS funktioniert.

Wenn Sie den Aufwand für Ihre Entwicklungsumgebung minimieren wollen, um sich auf die essenziellen

Aufgaben konzentrieren zu können, sind Sie in diesem Vortrag genau richtig.

9

DOSSIER

Agile & DevOps

Abb. 2: Die NuGet-Packages „xUnit“ und „xUnit.runner.visualstudio“ für ein

Testprojekt mit xUnit

• xUnit ist sehr schnell.

• xUnit benötigt im Gegensatz zu MSTest kein spezifisches Testprojekt, stattdessen reicht eine einfache

Klassenbibliothek aus.

• xUnit und die für die Testausführung benötigten

Klassen lassen sich einfach via NuGet installieren.

• xUnit ist sehr leichtgewichtig: Die Testklassen selbst

benötigen keine Attribute, sondern nur die Testmethoden.

• Testmethoden lassen sich einfach parametrisieren.

Ein Testprojekt mit xUnit anlegen

Um mit xUnit ein Testprojekt anzulegen, wird eine Klassenbibliothek erstellt und die beiden NuGet-Packages

„xUnit“ und „xUnit.runner.visualstudio“ hinzugefügt

(Abb. 2).

Wurden die NuGet-Packages hinzugefügt, wird

noch eine Referenz auf das Projekt hinzugefügt, das

die zu testenden Klassen enthält. In diesem Artikel

Listing 2

public class MainViewModel:ViewModelBase

{

public MainViewModel()

{

Friends = new ObservableCollection<Friend>();

}

public void Load()

{

var dataService = new FriendDataService();

var friends = dataService.GetFriends();

foreach (var friend in friends)

{

Friends.Add(friend);

}

}

public ObservableCollection<Friend> Friends { get; private set; }

}

www.basta.net

Abb. 3: Die Testmethode wird im Test-Explorer angezeigt

wird eine Referenz auf ein kleines WPF-Projekt namens FriendStorage.UI hinzugefügt, das eine Main­

ViewModel-Klasse enthält.

Zum Testprojekt wird eine neue Klasse mit dem

Namen MainViewModelTests hinzugefügt, in der die

Testmethoden für diese MainViewModel-Klasse untergebracht werden.

Der erste Fall, der getestet werden soll, ist das Laden

von Friend-Objekten. Somit wird eine ShouldLoad­

Friends-Methode hinzugefügt. Damit diese als Testmethode erkannt wird, wird sie mit dem Fact-Attribut aus

dem Namespace XUnit markiert (Listing 1).

Auch wenn die Methode noch leer ist, lässt sie sich

bereits ausführen. Dazu wird in Visual Studio über das

Hauptmenü Test | Windows | Test Explorer der

Test-Explorer aufgerufen. Nach einem Klick auf Run

all wird die Testmethode ausgeführt und als grün im

Test-Explorer angezeigt (Abb. 3).

Bei einem Blick auf den Test-Explorer fällt auf, dass

der Testmethode der voll qualifizierte Klassenname vorangestellt wird. Das lässt sich anpassen, indem zum

Testprojekt eine Konfigurationsdatei mit dem Namen

xUnit.runner.json hinzugefügt wird. Diese Datei muss

mit ins Ausgabeverzeichnis kopiert werden, um den

Test-Runner von xUnit anzupassen. Mit dem folgenden

Code werden im Test-Explorer die Testmethoden ohne

den voll qualifizierten Klassennamen angezeigt:

{

"methodDisplay": "method"

}

Testbare ViewModels schreiben

Ein eifriger Entwickler hat in der MainViewModel-Klasse bereits etwas Code in der Load-Methode hinzugefügt,

um Friend-Objekte mithilfe einer FriendDataServiceKlasse zu laden und in einer ObservableCollection abzuspeichern (Listing 2).

Genau diese Load-Methode der MainViewModelKlasse soll jetzt in der Testmethode ShouldLoadFriends

getestet werden. Allerdings ist in Listing 2 ein Problem zu erkennen. Die Load-Methode instanziert einen

FriendDataService. Dieser FriendDataService könnte

10

DOSSIER

auf eine Datenbank, auf einen Web Service oder auf

etwas anderes zugreifen. Das bedeutet, dass mit diesem

FriendDataService ein Unit-Test nicht mehr in einer

beliebigen Umgebung wiederholbar und es somit eben

kein Unit-Test wäre. Und damit stellt sich die Frage,

wie sich testbare ViewModels entwickeln lassen. Die

Antwort ist recht banal: ViewModels werden testbar,

indem Abhängigkeiten abstrahiert und ausgelagert

werden. Diese Antwort gilt nicht nur für ViewModels,

sondern auch für jede andere Klasse, die testbar sein

soll. Im Fall des MainViewModels aus Listing 2 stellt

der FriendDataService eine Abhängigkeit dar, die das

Testen der Load-Methode nicht erlaubt. Woher soll

ein Entwickler im Unit-Test wissen, wie viele FriendObjekte dieser FriendDataService zurückgibt? Wie soll

das Ganze in einer beliebigen Umgebung auch ohne

Datenzugriff getestet werden können? Es gibt nur eine

Lösung: Der Datenzugriff muss aus der ViewModelKlasse abstrahiert werden.

Den Datenzugriff abstrahieren

Um den Datenzugriff aus der MainViewModel-Klasse

zu abstrahieren, wird ein IFriendDataProvider-Interface

eingeführt, das eine Methode LoadFriends wie folgt dargestellt definiert:

public interface IFriendDataProvider

{

IEnumerable<Friend> LoadFriends();

}

Agile & DevOps

Das MainViewModel selbst wird angepasst. Im Konstruktor wird ein IFriendDataProvider-Objekt entgegengenommen und in der Instanzvariablen _dataProvider

gespeichert. Anstelle der FriendDataAccess-Klasse wird

in der Load-Methode des MainViewModels das IFriend­

Data­Provider-Objekt verwendet (Listing 3).

Mit dem Verwenden des IFriendDataProvider-Inter­

face ist die Abhängigkeit zur FriendDataAccess-Klasse

aus dem MainViewModel verschwunden. Die Load-Methode lässt sich jetzt einfach testen, indem der IFriend­

DataProvider gemockt wird.

Den Datenzugriff von Hand „mocken“

Um die Load-Methode des MainViewModels zu testen,

wird im Testprojekt eine neue Klasse namens FriendDa­

taProviderMock hinzugefügt, die das Interface IFriend­

DataProvider implementiert (Listing 4).

Mit der FriendDataProviderMock-Klasse lässt sich

in der ShouldLoadFriends-Methode eine neue Main­

ViewModel-Instanz erstellen (Listing 5). Anschließend

wird auf dem MainViewModel die Load-Methode aufgerufen und mit der Assert-Klasse angenommen, dass

die Friends Property des MainViewModels genau zwei

Friend-Instanzen enthält. Das sind die zwei Instanzen,

die vom FriendDataProviderMock-Objekt aus Listing 4

zurückgegeben werden.

Wird der Test ausgeführt, ist er grün. Die händische

Implementierung von IFriendDataProvider für den Test

kann natürlich etwas aufwändig werden, wenn es vie-

Listing 4

Listing 3

public class MainViewModel:ViewModelBase

{

private IFriendDataProvider _dataProvider;

public MainViewModel(IFriendDataProvider dataProvider)

{

_dataProvider = dataProvider;

Friends = new ObservableCollection<Friend>();

}

public void Load()

{

var friends = _dataProvider.LoadFriends();

foreach (var friend in friends)

{

Friends.Add(friend);

}

public class FriendDataProviderMock : IFriendDataProvider

{

public IEnumerable<Friend> LoadFriends()

{

yield return new Friend { Id = 1, FirstName = "Thomas" };

yield return new Friend { Id = 2, FirstName = "Julia" };

}

}

Listing 5

public class MainViewModelTests

{

[Fact]

public void ShouldLoadFriends()

{

var viewModel = new MainViewModel(new FriendDataProviderMock());

viewModel.Load();

}

Assert.Equal(2, viewModel.Friends.Count);

public ObservableCollection<Friend> Friends { get; private set; }

}

www.basta.net

}

}

11

DOSSIER

le Interfaces und viele Tests gibt. In einem solchen Fall

lohnt sich der Einsatz einer Mocking Library wie beispielsweise Moq.

Moq einsetzen

In Listing 4 wurde händisch eine FriendDataProvider­

Mock-Klasse für den Test erstellt. Diese Klasse kann

sich ein Entwickler auch sparen, indem er die Moq

Library einsetzt. Dazu einfach das NuGet-Package

„Moq“ zum Testprojekt hinzufügen und wie in Listing 6 eine Instanz der generischen Mock-Klasse erzeugen. Als generischer Typ-Parameter wird dabei

das Interface IFriendData­Provider angegeben. Auf

der Mock-Instanz wird mit der Setup-Methode die

LoadFriends-Methode des IFriendDataProvider aufgesetzt. Es wird eine Liste mit zwei Friend-Objekten

als Return-Wert festgelegt. Hinter den Kulissen erzeugt die Mock-Klasse einen dynamischen Proxy für

das IFriendDataProvider-Interface. Dieser dynamische

Proxy wird mithilfe des Castle-Frameworks erstellt.

Über die Object Property der Mock-Instanz lässt sich

der dynamische Proxy abgreifen, der in Listing 6 eine

IFriendDataProvider-Instanz darstellt – und diese lässt

sich jetzt wunderbar zum Testen des MainViewModels

verwenden.

Listing 6

Agile & DevOps

Dependency Injection mit Autofac

Nachdem die Load-Methode des MainViewModels

fertiggestellt und getestet ist, wird eine IFriendData­

Pro­vider-Implementierung erstellt, die zur Laufzeit

der Anwendung genutzt wird. Sie greift intern in der

LoadFriends-Methode beispielsweise auf den Friend­

DataService zu, der vorher direkt im MainViewModel

verwendet wurde (Listing 7).

Ist der FriendDataProvider fertig, wird noch der

Konstruktor des MainWindow angepasst, damit dieser

ein MainViewModel entgegennimmt und es im Data­

Context speichert. Findet das Loaded-Event auf dem

MainWindow statt, wird auf dem MainViewModel die

Load-Methode aufgerufen (Listing 8).

Die WPF kann das MainWindow jetzt nicht mehr

selbst instanziieren, da es keinen parameterlosen Konstruktor gibt. Daher wird in der Datei App.xaml die Start­

up­Uri Property entfernt und in der Codebehind-Datei

die OnStartup-Methode überschrieben. Darin wird eine

MainWindow-Instanz erstellt, indem dem Konstruktor

ein MainViewModel übergeben wird. Dem Konstruktor des MainViewModels wiederum wird eine Friend­

Listing 8

public partial class MainWindow : Window

{

private readonly MainViewModel _viewModel;

public void ShouldLoadFriends()

{

var dataProviderMock = new Mock<IFriendDataProvider>();

public MainWindow(MainViewModel viewModel)

{

_viewModel = viewModel;

InitializeComponent();

this.Loaded += MainWindow_Loaded;

DataContext = _viewModel;

}

dataProviderMock.Setup(dp => dp.LoadFriends())

.Returns(new List<Friend>

{

new Friend {Id = 1, FirstName = "Thomas"},

new Friend {Id = 1, FirstName = "Julia"}

});

IFriendDataProvider dataProvider = dataProviderMock.Object;

var viewModel = new MainViewModel(dataProvider);

viewModel.Load();

Assert.Equal(2, viewModel.Friends.Count);

}

Listing 7

public class FriendDataProvider : IFriendDataProvider

{

public IEnumerable<Friend> LoadFriends()

{

var dataService = new FriendDataService();

return dataService.GetFriends();

}

}

www.basta.net

private void MainWindow_Loaded(object sender, RoutedEventArgs e)

{

_viewModel.Load();

}

}

Listing 9

public partial class App : Application

{

protected override void OnStartup(StartupEventArgs e)

{

base.OnStartup(e);

var mainWindow = new MainWindow(

new MainViewModel(

new FriendDataProvider()));

mainWindow.Show();

}

}

12

DOSSIER

DataProvider-Instanz übergeben (Listing 9). Schließlich

wird am Ende die Show-Methode aufgerufen, um das

Fenster anzuzeigen.

Der Code aus Listing 9 hat jetzt ein kleines Problem:

Jedes Mal, wenn sich der Konstruktor des MainWin­

dow, des MainViewModels oder des FriendDataProvi­

ders ändert, muss diese Stelle entsprechend angepasst

werden. Das lässt sich mit einem Dependency-Injection-Framework verhindern. Denn genau das passiert

in Listing 9: In das MainWindow wird eine MainView­

Model-Abhängigkeit injiziert, in das MainViewModel

wird ein IFriendDataProvider injiziert.

Ein Dependency-Injection-Framework kann diese

Injektionen selbst vornehmen, indem ihm mittgeteilt

wird, welche konkreten Typen für welche abstrakten

Typen injiziert werden sollen.

Auf dem Markt gibt es zahlreiche dieser Frameworks, ein sehr beliebtes ist Autofac. Um es einzusetzen, wird im Projekt eine Bootstrapper-Klasse erstellt,

die eine Bootstrap-Methode enthält, die wiederum

einen IContainer zurückgibt. Der IContainer hat die

Informationen über die zu erstellenden Typen. Zum

Erstellen des IContainer kommt bei Autofac die in Listing 10 verwendete ContainerBuilder-Klasse zum Ein-

Listing 10

public class Bootstrapper

{

public IContainer Bootstrap()

{

var builder = new ContainerBuilder();

builder.RegisterType<MainWindow>().AsSelf();

builder.RegisterType<MainViewModel>().AsSelf();

builder.RegisterType<FriendDataProvider>().As<IFriendDataProvider>();

return builder.Build();

}

}

Listing 11

Agile & DevOps

satz. Auf einer ContainerBuilder-Instanz werden mit

RegisterType verschiedene Typen registriert, am Ende

wird mit der Build-Methode ein IContainer erstellt.

Listing 10 zeigt, wie das MainWindow und das Main­

ViewModel mit der Methode AsSelf registriert werden.

Das bedeutet, wo auch immer diese konkreten Typen

benötigt werden, kann Autofac sie erstellen und/oder

injizieren. Der Typ FriendDataProvider wird ebenfalls

registriert. Mit der As-Methode wird festgelegt, dass

eine FriendDataProvider-Instanz immer dann verwendet wird, wenn eine IFriendDataProvider-Instanz benötigt wird.

Der erstellte Bootstrapper ist fertig und kann nun in

der OnStartup-Methode der App-Klasse genutzt werden, um den IContainer zu erstellen und schließlich das

MainWindow zu erzeugen (Listing 11). Was dabei jetzt

auffällt, ist, dass kein Konstruktor mehr aufgerufen

wird, um das MainWindow zu erzeugen. Stattdessen

wird die Resolve-Methode verwendet – eine ExtensionMethode für den IContainer, die im Namespace Autofac untergebracht ist. Mit der Resolve-Methode wird

eine neue MainWindow-Instanz erzeugt; wenn sich

jetzt der Konstruktor ändert, müssen die Abhängigkeiten lediglich im Container registriert werden – was

in der Bootstrapper-Klasse passiert. Eine Anpassung

der OnStartup-Methode ist nicht mehr notwendig, da

das Dependency-Injection-Framework den Rest übernimmt.

Methodenaufrufe testen

Wird das ViewModel erweitert, kommt man schnell

an den Punkt, an dem Methodenaufrufe getestet

Listing 12

public class MainViewModel:ViewModelBase

{

public MainViewModel(IFriendDataProvider dataProvider)

{

...

DeleteCommand = new DelegateCommand(OnDeleteExecute,

OnDeleteCanExecute);

}

public partial class App : Application

{

protected override void OnStartup(StartupEventArgs e)

{

base.OnStartup(e);

public ICommand DeleteCommand { get; }

private void OnDeleteExecute(object obj)

{

var friendToDelete = SelectedFriend;

var bootstrapper = new Bootstrapper();

var container = bootstrapper.Bootstrap();

_dataProvider.DeleteFriend(friendToDelete.Id);

Friends.Remove(friendToDelete);

SelectedFriend = null;

var mainWindow = container.Resolve<MainWindow>();

mainWindow.Show();

}

...

}

}

www.basta.net

}

13

DOSSIER

werden müssen. Beispielsweise zeigt Listing 12 ein

DeleteCommand im MainViewModel. In der OnDe­

lete­Exe­cute-Methode wird der selektierte Freund verwendet und dessen ID an die DeleteFriend-Methode

des DataProviders übergeben. Anschließend wird das

Friend-Objekt aus der Friends Collection entfernt und

Listing 13

[Fact]

public void

ShouldDeleteAndRemoveFriendWhenDeleteCommandIsExecuted()

{

var dataProviderMock = new Mock<IFriendDataProvider>();

dataProviderMock.Setup(dp => dp.LoadFriends())

.Returns(new List<Friend>

{

new Friend {Id = 1, FirstName = "Thomas"},

new Friend {Id = 1, FirstName = "Julia"}

});

IFriendDataProvider dataProvider = dataProviderMock.Object;

var viewModel = new MainViewModel(dataProvider);

viewModel.Load();

var friendToDelete = viewModel.Friends.First();

viewModel.SelectedFriend = friendToDelete;

viewModel.DeleteCommand.Execute(null);

dataProviderMock.Verify(dp => dp.DeleteFriend(friendToDelete.Id),Times.

Once);

Assert.False(viewModel.Friends.Contains(friendToDelete));

Assert.Null(viewModel.SelectedFriend);

}

Listing 14

private void OnDeleteExecute(object obj)

{

var result = MessageBox.Show(

"Möchten Sie den Freund wirklich löschen?",

"Löschen",

MessageBoxButton.OKCancel);

if (result == MessageBoxResult.OK)

{

var friendToDelete = SelectedFriend;

Agile & DevOps

die SelectedFriend Property auf null gesetzt. Doch wie

lässt sich all das testen?

Listing 13 zeigt eine Testmethode, die genau den

Inhalt der OnDeleteExecute-Methode aus Listing 12

testet. Interessant sind dabei die letzten drei Anweisungen, nachdem das DeleteCommand mit der Exe­

cute-Methode ausgeführt wurde. Zuerst wird auf der

in der Variablen dataProviderMock gespeicherten

Mock-Instanz mithilfe der Verify-Methode geprüft, ob

die DeleteFriend-Methode genau einmal aufgerufen

wurde – und zwar genau mit der ID des zu löschenden Freundes (friendToDelete). Anschließend wird

geprüft, ob der zu löschende Freund aus der Friends

Collection entfernt und die SelectedFriend Property

wieder auf null gesetzt wurde.

Dialoge anzeigen

Was beim Laden der Daten galt, um das ViewModel

testbar zu gestalten, gilt auch für das Anzeigen von

Dialogen: Abhängigkeiten müssen abstrahiert und

aus dem ViewModel entfernt werden. Ein typischer

Fall ist das Anzeigen einer Ok Cancel MessageBox

beim Löschen eines Freundes. In Listing 12 wurde die

OnDeleteExe­cute-Methode gezeigt. In diese Methode

lässt sich eine MessageBox wie in Listing 14 integrieren; die Anwendung wird wunderbar funktionieren.

Das Problem ist nur, dass die MessageBox auch in jedem Unit-Test angezeigt wird, in dem das DeleteCom­

mand ausgeführt wird; beispielsweise in dem Unit-Test

aus Listing 13. Der Unit-Test ist somit blockiert – Visual Studio zeigt beim Ausführen des Unit-Tests die

Listing 15

public class MainViewModel:ViewModelBase

{

private readonly IMessageBoxService _messageBoxService;

...

public MainViewModel(IFriendDataProvider dataProvider,

IMessageBoxService messageBoxService)

{

_messageBoxService = messageBoxService;

...

}

private void OnDeleteExecute(object obj)

{

var result = _messageBoxService.Show(

"Möchten Sie den Freund wirklich löschen?",

"Löschen",

MessageBoxButton.OKCancel);

_dataProvider.DeleteFriend(friendToDelete.Id);

Friends.Remove(friendToDelete);

SelectedFriend = null;

}

}

www.basta.net

if (result == MessageBoxResult.OK)

{

...

}

}

14

DOSSIER

MessageBox an. Ein Build-Server, der die Unit-Tests

ausführt, wird einfach blockiert sein. Somit gilt auch

an dieser Stelle: Die MessageBox muss aus dem ViewModel abstrahiert werden.

Um die MessageBox zu abstrahieren, wird das Interface IMessageBoxService eingeführt:

public interface IMessageBoxService

{

MessageBoxResult Show(string message, string title, MessageBoxButton

buttons);

}

Das MainViewModel wird erweitert, ein neuer Konstruktorparameter vom Typ IMessageBoxService kommt

hinzu. Die erhaltene Instanz wird in einer Instanzvariablen gespeichert und in der OnDeleteExecute-Methode

verwendet, was in Listing 15 zu sehen ist.

Mit der Abstraktion der MessageBox in einen IMes­

sageBoxService lässt sich dieser IMessageBoxService

im Unit-Test jetzt wunderbar „mocken“. Beispielsweise zeigt das folgende Codebeispiel, wie das MainView­

Model mit einem IMessageBoxService erstellt wird.

Dabei wird die Methode Show des IMessageBoxSer­

vice aufgesetzt:

var messageBoxServiceMock = new Mock<IMessageBoxService>();

messageBoxServiceMock.Setup(m => m.Show(It.IsAny<string>(),

It.IsAny<string>(),

MessageBoxButton.OKCancel))

.Returns(MessageBoxResult.OK);

var viewModel = new MainViewModel(dataProvider, messageBoxServiceMock.

Object);

Zu beachten ist der Einsatz der Klasse It, die auch zur

Moq Library gehört. Mit der generischen It.IsAnyMethode wird festgelegt, dass dieses Set-up der IMes­

sageBoxService.Show-Methode für einen beliebigen

String als ersten Parameter und einen beliebigen String

als zweiten Parameter gilt. Als dritter Parameter muss

MessageBoxButton.OKCancel angegeben werden,

Listing 16

public IContainer Bootstrap()

{

var builder = new ContainerBuilder();

Agile & DevOps

und dann wird das Ergebnis MessageBoxResult.OK

zurückgegeben.

Mit diesem Code wird im Unit-Test jetzt keine Mes­

sageBox mehr angezeigt. Für den produktiven Code ist

noch eine Implementierung von ImessageBoxService

notwendig. Das kann einfach wie folgt aussehen:

public class MessageBoxService : IMessageBoxService

{

public MessageBoxResult Show(string message, string title,

MessageBoxButton buttons)

{

return MessageBox.Show(message, title, buttons);

}

}

Damit die Anwendung läuft, ist der MessageBoxSer­

vice lediglich noch im Container von Autofac zu registrieren, damit dieser als IMessageBoxService in das

MainViewModel injiziert wird. Dazu wird in der Boots­

trap-Methode des Bootstrappers RegisterType auf dem

ContainerBuilder aufgerufen (Listing 16).

Einfach F5 drücken, und die Anwendung startet und

läuft ohne weitere Anpassungen mit dem neuen Mes­

sageBoxService.

Fazit

Dieser Artikel hat gezeigt, wie sich testbare ViewModels erstellen lassen. Dabei ist das Prinzip ganz einfach: Abhängigkeiten werden mithilfe von Interfaces

abstrahiert und als Konstruktorparameter definiert.

Dadurch lassen sich ViewModels mit 100 Prozent

Test-Coverage entwickeln. Allerdings sollte man dazu

sagen, dass sich Entwickler auf die komplexen Teile

konzentrieren sollten. Das Laden von Freunden und

das Anzeigen einer Mes­sage­Box wurde in diesem Artikel beispielhaft aufgeführt. In der Praxis empfehlen

sich immer diese Stellen für Unit-Tests, an denen man

als Entwickler darüber nachdenkt, doch den einen oder

anderen Kommentar zu schreiben. Das Offensichtliche

zu testen, ist nicht immer lohnenswert, aber das Herzstück zu testen, ist sehr zu empfehlen.

Thomas Claudius Huber arbeitet als Principal Consultant in Basel

bei der Trivadis AG. Er ist Microsoft MVP für Windows Development

und Autor zahlreicher Bücher, Artikel und Pluralsight-Videos. Er

spricht regelmäßig auf großen Entwicklerkonferenzen wie der

BASTA! und freut sich immer über Feedback.

www.thomasclaudiushuber.com

builder.RegisterType<MessageBoxService>().As<IMessageBoxService>();

builder.RegisterType<MainWindow>().AsSelf();

builder.RegisterType<MainViewModel>().AsSelf();

builder.RegisterType<FriendDataProvider>().As<IFriendDataProvider>();

return builder.Build();

}

www.basta.net

Links & Literatur

[1] TDD: https://de.wikipedia.org/wiki/Testgetriebene_Entwicklung

[2] F.I.R.S.T.: http://agileinaflash.blogspot.de/2009/02/first.html

[3] TDD und MVVM: https://www.pluralsight.com/courses/wpf-mvvm-testdriven-development-viewmodels

15

Agile & DevOps

©iStockphoto.com/stask

DOSSIER

Verschiedene Erweiterungs- und Anpassungsmöglichkeiten

VSTS/TFS – ganz

nach meinem

Geschmack

Visual Studio Team Services bzw. der Team Foundation Server sind mittlerweile sehr

offene und interoperable Application-Lifecycle-Management-Produkte aus dem Haus

Microsoft. Seit der anfänglichen Anpassbarkeit von Work-Item-Typen wurde der Funktionsumfang in Sachen Integration und Erweiterbarkeit stark vergrößert. Seit Kurzem

kann auch die Web­oberfläche nach Belieben erweitert werden. Mit Update 3 können

nun auch für den Team Foundation Server 2015 eigene Dashboard-Widgets erstellt

werden. Es ist also an der Zeit, einen Blick auf die neuen Möglichkeiten zu werfen.

von Marc Müller

Ein anpassbares und erweiterbares ALM-Tool zu haben,

ist heutzutage für den Erfolg von wesentlicher Bedeutung. Die Möglichkeiten, Work-Item-Typen zu erweitern

oder gar neue Entitäten zu erstellen, kennt vermutlich

jeder. Dieser Artikel legt den Fokus auf die Anpassung

der Weboberfläche sowie auf die Integration von eigenen

Services in Visual Studio Team Services (VSTS) und Team

Foundation Server (TFS). Abbildung 1 zeigt, welche Integrationspunkte zur Verfügung stehen.

www.basta.net

Wie oft hatte man sich in der Vergangenheit gewünscht, an einer bestimmten Stelle einen zusätzlichen

Button hinzuzufügen oder gar eigene Views einzublenden. Diese Möglichkeit ist mit der aktuellen Version nun

gegeben. Die Erweiterungen in der Oberfläche enthalten

Code in Form von JavaScript zur Interaktion mit dem

System, die Visualisierung wird mittels HTML implementiert. Eigene Backend-Services können damit aber

nicht integriert werden. Sobald Servicelogik erforderlich

ist, kann dies nur als externer Service implementiert werden, also z. B. als eigenständige Webapplikation.

16

DOSSIER

Diese Applikationen können über

die REST-Schnittstelle mit dem VSTS

bzw. TFS interagieren. Zur Benachrichtigung der externen Applikation

stehen so genannte WebHooks zur

Verfügung. Zu guter Letzt können

dem TFS bzw. VSTS noch eigene

Build-Tasks über die ExtensibilitySchnittstelle zur Verfügung gestellt

werden. Weitere Details zu den einzelnen Erweiterungspunkten sind

auf der Extensibility-Webseite von

VSTS [1] zu finden. Neben einer

detaillierten Auflistung werden entsprechende Beispiele [2] zur Verfügung gestellt.

Agile & DevOps

Abb. 1: Übersicht über die Integrationspunkte von Extension in VSTS/TFS

Eigenes Dashboard-Widget

erstellen

In diesem Artikel wird die Extensibility-Schnittstelle anhand eines eigenen Dashboard-Widgets erklärt. Um die

Komplexität klein zu halten, wollen wir ein einfaches

Widget in Form einer Build-Ampel erstellen (Abb. 2).

Die Ampel kommuniziert mit dem Build-System über ein

REST-API, um den aktuellen Status periodisch zu erfragen. Da wir für verschiedene Build-Definitionen verschiedene Ampeln auf dem Dashboard positionieren möchten,

benötigen wir ebenfalls eine Konfigurationsmöglichkeit

für den Nutzer, in der er die Größe des Widgets sowie die

gewünschte Build-Definition auswählen kann.

UI-Extensions bestehen primär aus HTML und JavaScript und den üblichen Webartefakten wie Bildern und

CSS-Dateien. Damit VSTS respektive TFS weiß, was wie

und wo intergiert werden muss, beinhaltet jede Extension

ein Manifest. Das Manifest, das als JSON-Datei definiert

wird, beinhaltet alle Informationen, Dateispezifikationen

sowie Integrationspunkte. Dazu kommt die Definition

der Scopes, also die Definition der Zugriffsrechte der Erweiterung. Vor der Installation wird der Nutzer darüber

informiert, auf was die Erweiterung Zugriff wünscht, und

Abb. 2: Build-Traffic-Lights-Widget als Beispiel für diesen Artikel

muss dies entsprechend bestätigen. Ist eine Erweiterung

einmal ausgerollt, kann der Scope nicht mehr verändert

werden. So wird verhindert, dass durch ein Update plötzlich mehr Berechtigungen als einmal bestätigt eingefordert werden können.

Generell wird die Sicherheit großgeschrieben. Eine

UI-Erweiterung läuft immer „sandboxed“ in einem dedizierten iFrame und erhält über ein SDK Zugriff auf den

Listing 1: Auszug aus dem Manifest

{

"manifestVersion": 1,

"id": "BuildTrafficLights",

"version": "0.1.16",

"name": "Build Traffic Lights",

"scopes": [ "vso.build_execute" ],

...

"contributions": [

{

"id": "BuildTrafficLightsWidget",

"type": "ms.vss-dashboards-web.

widget",

"targets": [

"ms.vss-dashboards-web.widget-

www.basta.net

catalog",

"4tecture.BuildTrafficLights.

BuildTrafficLightsWidget.Configuration"

],

"properties": {

"name": "Build Traffic Lights Widgets",

"uri": "TrafficLightsWidget.html",

...

"supportedScopes": [

"project_team"

]}},

{

"id": "BuildTrafficLightsWidget.

Configuration",

"type": "ms.vss-dashboards-web.widgetconfiguration",

"targets": [ "ms.vss-dashboards-web.

widget-configuration" ],

"properties": {

"name": "Build Traffic Lights Widget

Configuration",

"description": "Configures Build Traffic

Lights Widget",

"uri": "TrafficLightsWidgetConfiguration.

html"

}}]}

17

DOSSIER

VSTS/TFS – samt Services und Events. Sorgen wegen der

Authentifizierung muss man sich bei der Verwendung des

SDK keine machen, da der aktuelle Nutzerkontext übernommen wird. Jeder API-Call wird gegenüber den definierten und durch den Nutzer bestätigten Scopes geprüft

und bei einem Fehlverhalten blockiert. Damit alle Artefakte sowie das Manifest ausgeliefert und installiert werden können, erstellen wir als Artefakt ein Paket in Form

einer VSIX-Datei. Diese kann manuell auf den TFS geladen oder über den VSTS Marketplace vertrieben werden.

Listing 2: „TrafficLightsWidget.html“

<body>

<script type="text/javascript">

// Initialize the VSS sdk

VSS.init({

explicitNotifyLoaded: true,

setupModuleLoader: true,

moduleLoaderConfig: {

paths: {

"Scripts": "scripts"

}

},

usePlatformScripts: true,

usePlatformStyles: true

});

// Wait for the SDK to be initialized

VSS.ready(function () {

require(["Scripts/TrafficLightsWidget"], function (tlwidget) {

});

});

</script>

<div class="widget" >

<h2 class="title" id="buildDefinitionTitle"></h2>

<div class="content" id="content">

</div>

</div>

</body>

Agile & DevOps

Grundsätzlich können wir die Erweiterung mit jedem

Texteditor erstellen, jedoch wollen wir auch in diesem

kleinen Beispiel den Entwicklungsprozess gleich sauber

aufgleisen und verwenden hierzu Visual Studio. Für die

Libraries und Zusatztools verwenden wir den Node Package Manager (npm). Damit wir die Paketerstellung automatisieren können, kommt Grunt als Task-Runner zum

Einsatz. Wer das alles nicht von Hand aufbauen möchte,

kann die Visual-Studio-Erweiterung VSTS Extension

Project Templates [3] installieren. Hiermit verfügt Vi­

sual Studio über einen neuen Projekttyp, der das Erweiterungsprojekt mit allen Abhängigkeiten und Tools korrekt

aufsetzt. Zudem möchten wir in unserem Beispiel nicht

direkt JavaScript-Code schreiben, sondern TypeScript

Listing 4: „TrafficLightsCollection.ts“

/// <reference path='../node_modules/vss-web-extension-sdk/typings/

/// VSS.d.ts' />

import Contracts = require("TFS/Build/Contracts");

import BuildRestClient = require("TFS/Build/RestClient");

export class TrafficLightsCollection {

...

constructor(projectname: string, builddefinition: number,

numberofbuilds: number, element: HTMLElement) {

...

}

public updateBuildState() {

var buildClient = BuildRestClient.getClient();

buildClient.getBuilds(this.projectname, [this.buildDefinitionId, ...,

this.numberOfBuilds).then((buildResults: Contracts.Build[]) => {

this.builds = buildResults;

this.renderLights();

});

}, err => { this.renderLights(); });

}

}

Listing 3: „TrafficLightsWidget.ts“

/// <reference path='../node_modules/vss-web-extension-sdk/typings/

/// VSS.d.ts' />

/// <reference path="trafficlightscollection.ts" />

import TrafficLights = require("scripts/TrafficLightsCollection");

function GetSettings(widgetSettings) {...}

function RenderTrafficLights(WidgetHelpers, widgetSettings) {

var numberOfBuilds = <number>widgetSettings.size.columnSpan;

var config = GetSettings(widgetSettings);

if (config != null) {

var trafficLights = new TrafficLights.TrafficLightsCollection(

VSS.getWebContext().project.name, config.buildDefinition,

numberOfBuilds, document.getElementById("content"));

}

else {...}

www.basta.net

}

VSS.require("TFS/Dashboards/WidgetHelpers", function (WidgetHelpers) {

WidgetHelpers.IncludeWidgetStyles();

VSS.register("BuildTrafficLightsWidget", function () {

return {

load: function (widgetSettings) {

RenderTrafficLights(WidgetHelpers, widgetSettings);

return WidgetHelpers.WidgetStatusHelper.Success();

},

reload: function (widgetSettings) {...}

};

});

VSS.notifyLoadSucceeded();

});

18

DOSSIER

Abb. 3: Projektstruktur des Build-Traffic-Lights-Widgets

zur Implementierung verwenden. Abbildung 3 zeigt die

Projektstruktur in Visual Studio für unsere Erweiterung.

Unsere Manifestdatei befüllen wir mit den üblichen

Informationen zum Autor sowie der Beschreibung der

Erweiterung. Von entscheidender Bedeutung sind der

Scope für die Berechtigungen sowie die Contribution

Points, in denen die eigentliche Integration beschrieben

wird. Da wir auf Build-Informationen lesend zugreifen

möchten, wählen wir den Scope vso.build_execute. Als

Contribution Points definieren wir zwei UI-Elemente:

ein Widget-UI sowie ein Konfigurations-UI. In Listing 1

sind die entsprechenden Stellen fett hervorgehoben.

Aufgrund des Manifests wird unsere Erweiterung

richtig im Widgetkatalog aufgeführt, und aufgrund der

Contribution Points werden die richtigen HTML-Dateien für die UI-Erweiterungen angezogen. Die Implementierung der Views ist nichts anderes als klassische

Webentwicklung. Jedoch ist die Integration der Komponente über das zur Verfügung gestellte SDK von entscheidender Bedeutung.

Das SDK liegt uns in Form einer JavaScript-Datei

(VSS.SDK.js) in unserem Projekt vor. Da wir mit TypeScript arbeiten, laden wir ebenso die dazugehörigen

Typinformationen. Nach der Referenzierung der Skriptdatei in unserer HTML-Datei können wir nun über das

VSS-Objekt die Erweiterung registrieren. Zudem geben

wir VSTS/TFS bekannt, wie die Runtime unsere JavaScript-Module finden und laden kann. In unserem Fall

ist der gesamte Code in TypeScript implementiert und

wird als AMD-Modul zur Verfügung gestellt. Da wir

unsere Build-Ampel dynamisch in unserem TypeScript-

www.basta.net

Agile & DevOps

Code aufbauen werden, enthält die HTML-Datei nur

das Grundgerüst des Widgets (Listing 2).

Damit unser Widget und seine Controls nicht vom

Look and Feel von VSTS/FS abweichen, gibt uns das

SDK die Möglichkeit, über WidgetHelpers.Include­

WidgetStyles() die Styles von VSTS/TFS zu laden und in

unserem Widget zu verwenden. Das erspart uns einiges

an Designarbeit. Listing 3 zeigt zudem das Auslesen der

Konfiguration sowie der Instanziierung unseres AmpelRenderers TrafficLightsCollection.

Um nun mit dem REST-API von VSTS/TFS zu kommunizieren, können wir über das SDK einen entsprechenden

Client instanziieren. Der Vorteil dieser Vorgehensweise

liegt darin, dass wir uns nicht über die Authentifizierung

kümmern müssen. Die REST-Aufrufe erfolgen automatisch im Sicherheitskontext des aktuellen Nutzers. In Listing 4 ist der entsprechende Auszug zu sehen.

Was jetzt noch fehlt, ist die Möglichkeit, unser Widget zu konfigurieren (Listing 5). Jedes Ampel-Widget

benötigt eine entsprechende Konfiguration, in der die

gewünschte Build-Definition ausgewählt und gespeichert

wird. Die Grunddefinition der Konfigurationsansicht

(HTML-Datei) verhält sich genauso wie die beim Widget.

Im Code für die Konfigurationsansicht müssen zwei Lifecycle-Events überschrieben werden: load und onSave().

Hier können wir über das SDK unsere spezifischen Einstellungswerte als JSON-Definition laden und speichern.

Damit die Livepreview im Konfigurationsmodus funktioniert, müssen entsprechende Änderungsevents publiziert

werden. Die aktuellen Konfigurationswerte werden mittels TypeScript mit den UI-Controls synchron gehalten.

Ein komplettes Code-Listing wäre für diesen Artikel zu

umfangreich. Entsprechend steht der gesamte Code dieser

Beispiel-Extension auf GitHub [4] zur Verfügung.

Besuchen Sie auch folgende Session:

TFS/VSTS mit Extensions an die eigenen Bedürfnisse anpassen

Marc Müller

Seit der anfänglichen Anpassbarkeit von

Work-Item-Typen wurde der Funktionsumfang in Sachen Integration und Erweiterbarkeit für TFS und VSTS stark vergrößert. TFS bzw.

VSTS können über Extension in den Bereichen Web

UI, Dashboard Widgets und Build Tasks einfach erweitert werden. Nebst den Extensions bieten RESTAPI und Service Hooks ideale Möglichkeiten, um

Drittkomponenten einfach in das ALM-Tool zu integrieren. In unserem Vortrag zeigen wir Ihnen, wie eigene Extensions erstellt werden und was der TFS in

Sachen Erweiterbarkeit und Integration zu bieten

hat.

19

DOSSIER

Abb. 4: Grunt-Task zur Erstellung des Pakets

Entwicklungsworkflow von Extensions

Wer Extensions entwickelt, setzt sich primär mit klassischen Webentwicklungstechnologien auseinander.

Doch wie bekommen wir nun die Extension in den

TFS oder VSTS, und wie können wir debuggen? Als

Erstes benötigen wir ein Extension Package in Form

einer VSIX-2.0-Datei. Diese können wir anhand des

Manifests und dem Kommandozeilentool tfx-cli erstellen. Das CLI wird als npm-Paket angeboten und

entsprechend in unserem Projekt geladen. Wie bereits

weiter oben erwähnt, möchten wir diesen Schritt als

Grunt-Task in den Visual Studio Build integrieren.

Wie in Abbildung 4 zu sehen ist, verknüpfen wir den

Agile & DevOps

Grunt-Task mit dem After-Build-Event von Visual

Studio. Somit erhalten wir nach jedem Build das entsprechende Package.

Der nächste Schritt ist das Publizieren in TFS oder

VSTS. Im Fall von TFS wird die VSIX-Datei über den

Extension-Manager hochgeladen und in der gewünschten Team Project Collection installiert. Soll die Extension in VSTS getestet werden, ist das Publizieren im

Marketplace notwendig. Keine Angst, auch hier können die Extensions zuerst getestet werden, bevor sie der

Allgemeinheit zugänglich gemacht werden. Extensions

können außerdem als private Erweiterungen markiert

werden. Somit stehen sie nur ausgewählten VSTS-Accounts zur Verfügung.

Nun ist die Extension verfügbar und kann getestet

werden. Hierzu wenden wir die Entwicklertools der

gängigen Browser an. Die Extension läuft in einem

­iFrame; entsprechend kann die JavaScript-Konsole auf

den gewünschten iFrame gefiltert, Elemente inspiziert

und der TypeScript- bzw. JavaScript-Code mit dem Debugger analysiert werden.

Einbindung von externen Services mit REST-API

und WebHooks

Die aktuelle Erweiterungsschnittstelle von VSTS/TFS

erlaubt nur Frontend-Erweiterungen. Eigene Services

oder Backend-Logik können nicht integriert werden.

Entsprechend muss diese Art von Erweiterung extern

als Windows-Service oder Webapplikation betrieben bzw. gehostet werden. VSTS und TFS stellen ein

Listing 5: Widget-Konfiguration

if (config.buildDefinition != null) {

this.selectBuildDefinition.value = config.buildDefinition;

}

import BuildRestClient = require("TFS/Build/RestClient");

import Contracts = require("TFS/Build/Contracts");

}

export class TrafficLightsWidgetConfiguration {

...

constructor(public WidgetHelpers) { }

public load(widgetSettings, widgetConfigurationContext) {

this.widgetConfigurationContext = widgetConfigurationContext;

this.initializeOptions(widgetSettings);

this.selectBuildDefinition.addEventListener(

"change", () => { this.widgetConfigurationContext

.notify(this.WidgetHelpers.WidgetEvent.ConfigurationChange,

this.WidgetHelpers.WidgetEvent.Args(this.getCustomSettings()));

});

...

return this.WidgetHelpers.WidgetStatusHelper.Success();

}

public initializeOptions(widgetSettings) {

...

var config = JSON.parse(widgetSettings.customSettings.data);

if (config != null) {

www.basta.net

}

public onSave() {

var customSettings = this.getCustomSettings();

return this.WidgetHelpers.WidgetConfigurationSave

.Valid(customSettings);

}

}

VSS.require(["TFS/Dashboards/WidgetHelpers"], (WidgetHelpers) => {

WidgetHelpers.IncludeWidgetConfigurationStyles();

VSS.register("BuildTrafficLightsWidget.Configuration", () => {

var configuration =

new TrafficLightsWidgetConfiguration(WidgetHelpers);

return configuration;

})

VSS.notifyLoadSucceeded();

});

20

DOSSIER

Abb. 5: Registrierung des WebHook-Receivers in VSTS

REST-API [5] zur Verfügung, mit dem fast alle Aktionen getätigt werden können. Entwickelt man mit

.NET, so stehen entsprechende NuGet-Pakete zur Verfügung.

Oft bedingen eigene Logikerweiterungen aber, dass

man auf Ereignisse in VSTS/TFS reagieren kann. Ein

Polling über das API wäre ein schlechter Ansatz. Entsprechend wurde in VSTS/TFS das Konzept von WebHooks implementiert. Über die Einstellungen unter

Service Hooks können eigene WebHook-Empfänger

registriert werden. Jede WebHook-Registrierung ist an

ein bestimmtes Event in VSTS/TFS gebunden und wird

bei dessen Eintreten ausgelöst.

Der WebHook-Empfänger ist an und für sich relativ einfach zu implementieren. VSTS/TFS führt einen

POST-Request an den definierten Empfänger durch,

und der Body beinhaltet alle Eventdaten, wie zum Beispiel die Work-Item-Daten des geänderten Work Items

bei einem Work-Item-Update-Event. Einen POST-Request abzuarbeiten, ist nicht weiter schwierig, jedoch

ist es mit einem gewissen Zeitaufwand verbunden, die

Routen zu konfigurieren und den Payload richtig zu

parsen. Zum Glück greift uns Microsoft ein wenig

Agile & DevOps

unter die Arme. Für ASP.NET gibt es ein WebHookFramework [6], das eine Basisimplementierung für das

Senden und Empfangen von WebHooks bereitstellt.

Zudem ist ebenfalls eine Implementierung für VSTSWebHook-Events verfügbar, was einem das gesamte

Parsen des Payloads abnimmt. Nach dem Erstellen eines Web-API-Projekts muss lediglich das NuGet-Paket

Microsoft.AspNet.WebHooks.Receivers.VSTS [7]

hinzugefügt werden. Zu beachten ist hierbei, dass das

Framework sowie die Pakete noch im RC-Status sind

und entsprechend über NuGet als Pre-Release geladen

werden müssen.

Um auf VSTS/TFS-Events reagieren zu können, muss

von der entsprechende Basisklasse abgeleitet und die gewünschte Methode überschrieben werden (Listing 6).

Das WebHooks-Framework generiert über die Konfiguration entsprechende Web-API-Routen. Damit nicht

jeder einen Post auf den WebHook-Receiver absetzen

kann, wird ein Sender anhand einer ID Identifiziert, die

in der Web.config-Datei hinterlegt wird (Abb. 5). Der

entsprechende URL muss dann noch im VSTS/TFS hinterlegt werden.

Fazit

Die hier gezeigte UI-Integration bietet weitere Möglichkeiten, den eigenen Prozess bis in das Standard-Tooling

zu integrieren. Somit sind nahezu grenzenlose Möglichkeiten für eine optimale Usability und Unterstützung

der Nutzer gegeben. Wer sich mit HTML, CSS und JavaScript/TypeScript auskennt, dem dürfte das Erstellen

eigener Extensions nicht allzu schwer fallen. Für Nutzer

können die neuen Funktionen nur Vorteile haben, zumal

die Werbefläche von VSTS/TFS fast nicht mehr verlassen

werden muss.

Marc Müller arbeitet als Principal Consultant für Microsoft ALM

sowie .NET-/Windows-Azure-Lösungen bei der 4tecture GmbH

und wurde von Microsoft als Most Valuable Professional (MVP) für

Visual Studio ALM ausgezeichnet. Sein ALM-Fachwissen sowie

Know-how für Enterprise-Architekturen und komponentenbasierte verteilte Systeme konnte er in den letzten Jahren in viele Projekte einbringen. Als Trainer und Referent zählen die Ausbildung und das Coaching von

ALM- und .NET-Projektteams zu seinen Schwerpunkten.

Listing 6

public class VstsWebHookHandler : VstsWebHookHandlerBase

{

public override Task ExecuteAsync(WebHookHandlerContext context,

WorkItemUpdatedPayload payload)

{ // sample check

if (payload.Resource.Fields.SystemState.OldValue == "New" &&

payload.Resource.Fields.SystemState.NewValue == "Approved")

{

// your logic goes here...

}

return Task.FromResult(true);

}

}

www.basta.net

Links & Literatur

[1]https://www.visualstudio.com/en-us/docs/integrate/extensions/

overview

[2]https://github.com/Microsoft/vsts-extension-samples

[3]https://visualstudiogallery.msdn.microsoft.com/a00f6cfc-4dbb-4b9aa1b8-4d24bf46770b?SRC=VSIDE

[4]https://github.com/4tecture/BuildTrafficLights

[5]https://www.visualstudio.com/en-us/docs/integrate/api/overview

[6]https://github.com/aspnet/WebHooks

[7]https://www.nuget.org/packages/Microsoft.AspNet.WebHooks.

Receivers.VSTS

21

DOSSIER

Web Development

Nutzung von echtem Server-Push mit dem WebSocket-Protokoll

Echtzeitchat mit

Node.js und Socket.IO

© S&S Media

Was wäre heute eine Anwendung ohne die bekannten In-App Notifications? Neue

Chatnachricht, neuer Artikel oder im Allgemeinen eine neue Benachrichtigung – oft

symbolisiert durch ein kleines Icon mit einer Zahl zur Anzeige, wie viele neue Nachrichten uns erwarten. Kaum mehr wegzudenken und ständig verfügbar, auch ohne

dass man eine Seite neu laden muss. Und das Ganze natürlich in Echtzeit. Wie das

geht? WebSocket für Echtzeitkommunikation lautet das Zauberwort.

von Manuel Rauber

In der heutigen Zeit haben wir alle sicher schon mal ein

Real-Time-Collaboration-Tool genutzt, ein Werkzeug,

um in Echtzeit gemeinsamen mit anderen Personen

ein Dokument zu editieren. Als Paradebeispiel sei hier

Google Docs genannt, aber mittlerweile auch OfficeWeb-Apps wie Word Online. Je mehr Leute dabei sind,

umso mehr bunte Marker springen munter in einem Dokument herum, fügen neue Texte ein oder ändern bestehende. Das alles passiert in Echtzeit.

www.basta.net

Prinzipiell gibt es verschiedene Möglichkeiten, das gemeinsame Editieren von Dokumenten zu ermöglichen.

Die erste Möglichkeit ist ein typisches Intervallpolling,

also das Senden einer Anfrage mit der Bitte um Aktualisierung zum Server in einem bestimmten Intervall.

Das heißt, dass wir beispielsweise alle 10 Sekunden eine

HTTP-­Anfrage zum Server schicken und als Antwort

die Änderungen oder das komplette Dokument bekommen. Wirklich Echtzeit ist dies aber nicht, da wir bis

zu 10 Sekunden (plus die Zeit zum Verbindungsaufbau

und Übertragen der Daten) warten müssen, um neue

22

DOSSIER

Video-Link:

Chris Heilmann im Interview

zum Edge-Browser auf der

BASTA! Spring

Web Development

es sich allerdings nicht um HTTP-Anfragen, d. h. bei

der Übermittlung der Daten müssen keine zusätzlichen

Header mitgesendet werden. Die Datenpakete sind

daher deutlich kleiner und beinhalten genau das, was

gesendet wird, also genau unsere Änderungen im gemeinsamen Dokument.

Darf ich Ihnen die Hand geben?

Änderungen zu erhalten. Das Chaos, das hier in einem

gemeinsamen Dokument entstehen würde, kann man

sich sicherlich denken. Spaß sieht anders aus.

Die zweite Möglichkeit ist die Nutzung von HTTP

Long Polling. Hier schickt der Client eine Anfrage zum

Server. Der Server hält die Verbindung so lange offen,