¨Ubungsblatt 1

Werbung

Übungsblatt 1

zur Vorlesung Lineare Algebra und Analytische Geometrie II im Sommersemester 2008

Christoph Schweigert

Erstellt am 09.04.2008, 08:11 Uhr für Matrikelnummer CHECKING ALL VARIANTS. Abgabezeitpunkt ist

07.04.2008, 08:00 Uhr.

Dieses Blatt ist das erste Übungsblatt zur Vorlesung Lineare Algebra II. Es ist in der ersten Übungsgruppe im

Sommersemester 2008 abzugeben.

1

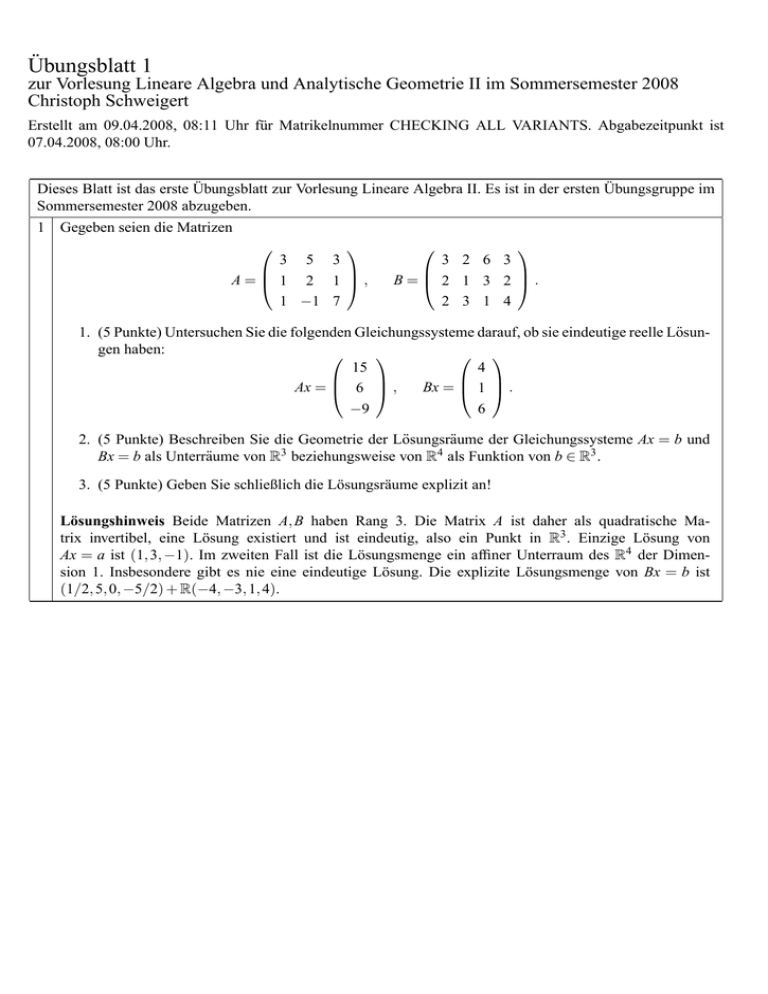

Gegeben seien die Matrizen

3 5 3

A= 1 2 1 ,

1 −1 7

3 2 6 3

B= 2 1 3 2 .

2 3 1 4

1. (5 Punkte) Untersuchen Sie die folgenden Gleichungssysteme darauf, ob sie eindeutige reelle Lösungen haben:

15

4

Ax = 6 ,

Bx = 1 .

−9

6

2. (5 Punkte) Beschreiben Sie die Geometrie der Lösungsräume der Gleichungssysteme Ax = b und

Bx = b als Unterräume von R3 beziehungsweise von R4 als Funktion von b ∈ R3 .

3. (5 Punkte) Geben Sie schließlich die Lösungsräume explizit an!

Lösungshinweis Beide Matrizen A, B haben Rang 3. Die Matrix A ist daher als quadratische Matrix invertibel, eine Lösung existiert und ist eindeutig, also ein Punkt in R3 . Einzige Lösung von

Ax = a ist (1, 3, −1). Im zweiten Fall ist die Lösungsmenge ein affiner Unterraum des R4 der Dimension 1. Insbesondere gibt es nie eine eindeutige Lösung. Die explizite Lösungsmenge von Bx = b ist

(1/2, 5, 0, −5/2) + R(−4, −3, 1, 4).

2

Im R2 seien die Basen

A=

−1

1

!

,

2

3

!!

,

1

2

B=

!

,

0

1

!!

gegeben.

1. (5 Punkte) Berechnen Sie die Transformationsmatrix TBA .

2. (5 Punkte) Bestimmen Sie mit Hilfe der Transformationsmatrix die Koordinaten des Vektors

!

!

−1

2

v=2

+9

1

3

bezüglich der Basis B .

Lösungshinweis

Aus a j = ∑i Ti j bi finden wir mit

a1 = −b1 + 3b2

a2 = 2b1 − b2

die Matrix

T=

−1

2

3 −1

!

.

Es folgt T (2, 9) = (16, −3), also v = 16b1 − 3b2 .

3

(5 Punkte) Sei K ein beliebiger Körper und seien Q der Körper der rationalen Zahlen und R der Körper

der reellen Zahlen. Sind die folgenden Teilmengen Unterrringe der angegebenen Matrizenringe?

!

a 0

∈ M(2 × 2, R) | a ∈ Q, b, c ∈ R} ⊂ M(2 × 2, R)

1. {

b c

!

a 0

2. {

∈ M(2 × 2, K) | a, b ∈ K} ⊂ M(2 × 2, K)

b 0

Lösungshinweis

Durch Nachrechnen sehen wir, dass beide Teilmengen unter Addition und Multiplikation abgeschlossen

sind. Also sind beide Teilmengen Unterringe der gegebenen Matrizenringe.

4

(10 Punkte) Sei K ein Körper und seien X,Y ∈ M(m×n, K) Matrizen. Zeigen Sie: die beiden Matrizen sind

genau dann äquivalent, wenn sie dieselbe lineare Abbildung bezüglich verschiedener Basen beschreiben.

Das heißt: Es gibt einen n-dimensionalen K-Vektorraum V mit zwei geordneten Basen A , A 0 und einen mdimensionalen K-Vektorraum W mit zwei geordneten Basen B , B 0 und eine lineare Abbildung Φ : V → W ,

so dass gilt

0

X = MBA (Φ) und Y = MBA0 (Φ) .

Lösungshinweis

“⇐” folgt sofort aus Satz 2.7.4.

“⇒” Seien X,Y äquivalente m × n Matrizen:

Y = SXT −1

mit S ∈ GL(m, K) und T ∈ GL(n, K). Sei A = (v1 , . . . , vn ) eine beliebige geordnete Basis von V und

B = (w1 , . . . , wm ) eine beliebige geordnete Basis von W . Betrachte die durch

Φ(vi ) =

m

∑ X jiw j

j=1

definierte lineare Abbildung. Finde nun die geordnete Basis A 0 von V mit Elementen v0i , die durch

n

v j = ∑ Ti j v0i

i=1

definiert ist; analog finde eine geordnete Basis B 0 von W mit

m

w j = ∑ Si j w0i

i=1

und rechne

Φ(v0i ) = Φ(∑ j T ji−1 v j ) = ∑ j T ji−1 Φ(v j )

= ∑ j,k Xk j T ji−1 wk = ∑ jkl Slk Xk j T ji−1 w0l = ∑l Yli w0l

5

(15 Punkte) Sei K ein Körper, V ein K-Vektorraum, U ⊂ V ein Untervektorraum und π : V → V /U die

kanonische Surjektion.

(i) Zeigen Sie:

Dann existiert für jeden K-Vektorraum X und jede lineare Abbildung f : V → X mit f|U = 0 eine eindeutig

bestimmte lineare Abbildung f˜ : V /U → X mit f = f˜ ◦ π.

Sei Q ein K-Vektorraum und π̂ : V → Q eine lineare Abbildung mit π̂|U = 0, so dass für jede lineare

Abbildung f : V → X mit f|U = 0 eine eindeutig bestimmte lineare Abbildung fˆ : Q → X mit f = fˆ ◦ π̂

existiert.

(ii) Zeigen Sie:

Dann gibt es einen eindeutig bestimmten Isomorphismus fˆQ : Q → V /U, so dass π = fˆQ ◦ π̂ gilt.

Lösungshinweis

(i) Sei v ∈ V . Für jede solche Abbildung f˜ muss gelten:

f˜([v]) = f˜ ◦ π(v) = f (v) ,

so dass f˜ eindeutig festgelegt ist. Dies ist wegen f (v+u) = f (v)+ f (u) = f (v) für alle u ∈ U wohldefiniert,

d.h. unabhängig vom Repräsentanten v von [v]. Aus der Linearität von f folgt wieder leicht die Linearität

von f˜.

(ii) Wenden wir (i) auf die lineare Abbildung π̂ : V → Q an, so finden wir eine eindeutige lineare Abbildung

f˜Q : V /U → Q mit π̂ = f˜Q ◦ π. Zum zweiten wenden wir die für Q geforderte Eigenschaft auf die lineare

Abbildung π : V → V /U an und finden fˆQ : Q → V /U mit π = fˆQ ◦ π̂. Es folgt

f˜Q ◦ fˆQ ◦ π̂ = f˜Q ◦ π = π̂ .

Natürlich gilt auch idQ ◦ π̂ = π̂. Aber die definierende Eigenschaft von Q, angewandt auf π̂ : V → Q

selbst, sagt, dass eine solche Abbildung eindeutig ist, also gilt f˜Q ◦ fˆQ = idQ . Analog zeigt man auch

fˆQ ◦ f˜Q = idV /U .

6

(15 Punkte) Sei V ein K–Vektorraum und U,W Untervektorräume von V , so dass V = U ⊕W gilt, d.h. V

sei innere direkte Summe von U und W . Zeigen Sie: Dann ist V zusammen mit den Inklusionen

iU : U → V

iW : W → V

isomorph zur äußeren direkten Summe von U und W .

Lösungshinweis:

Wir müssen nur die universelle Eigenschaft der äußeren direkten Summe nachweisen. Nach Lemma 1.5.4

lässt sich jedes v ∈ V eindeutig als v = u + w mit u ∈ U und w ∈ W schreiben. Sei Z ein beliebiger weiterer

K-Vektorraum; gegeben zwei lineare Abbildungen

gU : U → Z

und

gW : W → Z

Dann muss jedes g : V → Z, das den Forderungen der universellen Eigenschaft genügt, erfüllen

g(v) = g(u + w) = g ◦ iU (u) + g ◦ iW (w) = gU (u) + gW (w) ,

ist also eindeutig. Die so definierte lineare Abbildung g : V → Z leistet umgekehrt auch alles Geforderte.

Innere und äußere direkte Summe sind also nach Satz 2.4.8 kanonisch isomorph.

7

(15 Punkte) Sei V ein endlich dimensionaler Vektorraum und Φ ∈ End(V ). Zeigen Sie, dass die folgenden

Bedingungen äquivalent sind.

(i) V = ker(Φ) ⊕ im(Φ)

(ii) im(Φ2 ) = im(Φ) .

Lösungshinweis

(i) ⇒ (ii). Die Inklusion im(Φ2 ) ⊂ im(Φ) gilt ohnehin für jeden Endomorphismus. Sei v ∈ im(Φ), also

v = Φ(x). Schreibe x = x1 + x2 mit x1 ∈ ker(Φ) und x2 ∈ im(Φ). Dann ist Φ(x) = Φ(x2 ). Daher können

wir x ∈ im(Φ) annehmen, also folgt mit x = Φ(x0 ) die Gleichung, v = Φ2 (x0 ) ∈ im(Φ2 ).

(ii) ⇒ (i). Betrachte die Einschränkung Ψ von Φ auf imΦ. Wegen (ii) ist diese Abbildung surjektiv, also

wegen der endlichen Dimension von V auch injektiv. Sie hat also trivialen Kern, somit kerΦ ∩ imΦ = {0}.

Es gilt v = (v − Ψ−1 Φ(v)) + Ψ−1 Φ(v). Man rechnet nun leicht nach, dass v − Ψ−1 Φ(v) für jedes v ∈ V im

Kern von Φ liegt. Offenbar ist Ψ−1 Φ(v) ∈ im(Φ). Also ist V auch Summe von Kern und Bild von Φ.

Abgabe in der ersten Übungsgruppe im Sommersemester 2008. Das Blatt geht in die Wertung ein.

Übungsblatt 2

zur Vorlesung Lineare Algebra und Analytische Geometrie II im Sommersemester 2008

Christoph Schweigert

Erstellt am 14.04.2008, 15:25 Uhr für Matrikelnummer CHECKING ALL VARIANTS. Abgabezeitpunkt ist

14.04.2008, 08:00 Uhr.

1

1

2

3

Es sei K ein Körper und M, N ∈ M(n × n, K) für ein n ∈ N. Die Einträge der Matrix M seien mit mi, j für

(1 ≤ i, j ≤ n) bezeichnet. Sind die folgenden Aussagen über Determinanten richtig?

Ist M eine untere Dreiecksmatrix, dann ist die Determinante von M gleich dem Ja / Nein

Produkt der Diagonalelemente.

Ist ein Diagonalelement von M gleich 0, dann ist die Determinante von M auch Ja / Nein

gleich 0.

Es gilt (det M) · (det N) = det(M · N).

Ja / Nein

Es gilt (det M) + (det N) = det(M + N).

Ja / Nein

Ist mi, j = 0 für i + j > n + 1, dann ist det M = ∏ni=1 mi,n+1−i .

Ist mi, j = 0 für i + j ≤ n, dann ist det M

4

5

= ∏ni=1 mi,n+1−i .

Ja / Nein

Ja / Nein

Enthält M nur die Zahlen 0 und 1, dann ist die Determinante von M auch entweder 0 oder 1.

Enthält M nur die Zahlen 0 und 1, dann ist die Determinante von M in der Menge

{0, 1, −1}.

Ja / Nein

Sind zwei Zeilen von N gleich, so ist det N = 0.

Ist eine Zeile von N das Negative einer anderen Zeile von N, dann ist det N = 0.

Ja / Nein

Ja / Nein

Ja / Nein

2

Alle vorkommenden Matrizen haben Einträge in einem Körper K. Sind die folgenden Aussagen wahr?

1

Der Zeilenrang einer Matrix ist gleich ihrem Spaltenrang.

Ja / Nein

Eine n × n-Matrix mit vollem Rang läßt sich durch elementare Zeilen- und Spaltenumformungen in die Einheitsmatrix überführen.

Ja / Nein

2

3

4

5

6

Der Zeilenrang einer Matrix ist gleich der Dimension des Raums, der von den Ja / Nein

Spaltenvektoren aufgespannt wird.

Der Spaltenrang einer Matrix ist gleich der Dimension des Raums, der von den Ja / Nein

Zeilenvektoren aufgespannt wird.

Die Dimension des Lösungsraums eines homogenen linearen Gleichungssy- Ja / Nein

stems Ax = 0 ist gleich der Differenz der Anzahl der Unbekannten und dem

Rang der Matrix A.

Es sei A eine quadratische Matrix. Dann hat das lineare Gleichungssystem Ax = Ja / Nein

0 genau dann eine eindeutige Lösung, wenn die Matrix A invertierbar ist.

7

Für 0 6= c ∈ K und eine Matrix A haben A und c · A den gleichen Rang.

Ja / Nein

8

Eine invertierbare n × n-Matrix hat den Rang n.

Ja / Nein

3

Berechnen Sie die Determinanten der folgenden Matrizen:

1

0

1

1

1

1

1

0

1

1

1

1

1

0

1

1

1

1

1

0

1

1

1

1

1

0

Lösung:

Man kann von der zweiten bis fünften Zeile die erste Zeile abziehen, ohne den

Wert der Determinante zu verändern, und erhält die Matrix:

0 1

1

1

1

1 −1 0

0

0

1 0

−1 0

0

0

−1 0

1 0

1 0

0

0

−1

Nun addiert man zur ersten Zeile die Summe der letzten vier Zeilen, wiederum

ohne den Wert der Determinante zu ändern, und erhält die Matrix

4 0

0

0

0

1 −1 0

0

0

1 0

−1

0

0

0

−1 0

1 0

1 0

0

0

−1

deren Determinante offensichtlich gleich 4 ist, wie man durch Entwicklung nach

der ersten Zeile sieht.

0

2

2

2

2

2

0

2

2

2

2

2

0

2

2

2

2

2

0

2

2

2

2

2

0

Lösung:

Man kann von der zweiten bis fünften Zeile die erste Zeile abziehen, ohne den

Wert der Determinante zu verändern und erhält die Matrix:

0 2

2

2

2

2 −2 0

0

0

2 0

−2

0

0

2

0

0

−2

0

2 0

0

0

−2

Nun addiert man zur ersten Zeile die Summe der letzten vier Zeilen, wiederum

ohne den Wert der Determinante zu ändern, und erhält die Matrix

8 0

0

0

0

2 −2 0

0

0

2 0

−2 0

0

0

−2 0

2 0

2 0

0

0

−2

deren Determinante offensichtlich gleich 128 ist, wie man durch Entwicklung

nach der ersten Zeile sieht.

2

1 2 3

2 5 1

2 7 9

7 2 9

2 1 3

5 2 1

3

x 1 1

1 x 1

1 1 x

(a) x3 + 3x − 2

(b) (x − 1)2 (x + 2)

(c) x3 − x

(a) / (b) / (c)

1 1 x

1 x 1

x 1 1

(a) / (b) / (c)

(a) −x3 − 3x + 2

(b) −(x − 1)2 (x + 2)

(c) x3 − x

4

1 x 1

1 1 x

x 1 1

(a) / (b) / (c)

(a) −x3 + 3x + 1

(b) x3 − 3x + 2

(c) x3 + x2 − 2

1 x 1

x 1 1

1 1 x

4

1

2

3

4

5

5

(a) / (b) / (c)

(a) x3 − 3x − 1

(b) −x3 + 3x − 2

(c) x3 + x2 − 2

Es sei K ein Körper, A ∈ M(m × n, K) mit m, n ∈ N und b ∈ K m . Sind die folgenden Aussagen über das

lineare Gleichungssystem Ax = b richtig?

Wenn es ein c ∈ K m gibt, so dass Ax = c eine eindeutige Lösung hat, dann hat Ja / Nein

Ax = b auch eine eindeutige Lösung.

Falls m = n ist und es ein c ∈ K m gibt, so dass Ax = c eine eindeutige Lösung Ja / Nein

hat, dann hat Ax = b auch eine eindeutige Lösung.

Ax = b ist genau dann unlösbar, wenn rang(A) + 1 = rang(A, b) ist.

Ja / Nein

Ax = b ist genau dann unlösbar, wenn rang(A) = rang(A, b) − 1 ist.

Ja / Nein

c ∈ Km

Für jedes

gibt es eine Bijektion zwischen der Lösungsmenge von Ax = b

und der von Ax = c.

Für jedes 0 6= c ∈ K m gibt es eine Bijektion zwischen der Lösungsmenge von

Ax = b und der von Ax = c.

Falls m = n ist und A nicht invertierbar ist, dann gibt es c ∈ K m , so dass Ax = c

unlösbar ist.

Falls m = n ist und A nicht invertierbar ist, dann ist Ax = c für alle c ∈ K m

unlösbar.

Für c = 0 und n > m hat Ax = c mindestens n − m Lösungen.

Für c = 0 hat Ax = c mindestens |n − m| (Absolutbetrag) Lösungen.

Berechnen Sie im R3 :

Ja / Nein

Ja / Nein

Ja / Nein

Ja / Nein

Ja / Nein

Ja / Nein

1

1

2

2 × 0

1

3

Geben sie den zweiten Eintrag des Ergebnisses an.

2

3

Berechnen Sie den Flächeninhalt des von den folgenden Vektoren im R3 aufgespannten Parallelogramms

8

−4

15 , 5

6

−3

Lösung: Der Flächeninhalt ist die Norm des Vektorprodukts der beiden Vektoren.

Berechnen Sie das Volumen des von den folgenden Vektoren im R3 aufgespannten Spates

4

1

−2

5 , 2 , −3

−7

6

2

Lösung: Das Volumen des Spates ist die Determinante der Matrix mit den drei

Vektoren als Spalten.

Die folgenden Aufgaben sind schriftlich zu bearbeiten.

6

(15 Punkte) Im R3 seien die beiden geordneten Basen

−1

1

−1

A =

−4 , −5 , −7 ,

4

−4

−8

1

−2

−3

B =

1 , −2 , 0

2

2

6

gegeben.

1. Berechnen Sie die Transformationsmatrix TBA .

2. Bestimmen Sie mit Hilfe dieser Transformationsmatrix die Koordinaten des Vektors

−1

1

−1

v = 3 −4 + 2 −5 − 2 −7

4

−4

−8

bezüglich der geordneten Basis B .

Lösung:

Wegen TBA = MBA (id) folgt aus

(−1, −4, 4)

= 2(1, 1, 2)

+3(−2, −2, 2) −1(−3, 0, 6)

(1, −5, −4)

= 1(1, 1, 2)

+3(−2, −2, 2) −2(−3, 0, 6)

(−1, −7, −8) = −1(1, 1, 2) +3(−2, −2, 2) −2(−3, 0, 6)

dass

und somit

2

1

−1

TBA = 3

3

3

−1 −2 −2

TBA (3, 2, −2) = (10, 9, −3)

Zur Probe rechnet man nach, dass

3(−1, −4, 4) + 2(1, −5, −4) − 2(−1, −7, −8) = (1, −8, 20) = 10(1, 1, 2) + 9(−2, −2, 2) − 3(−3, 0, 6)

gilt.

7

1. (5 Punkte)

Zeigen Sie für x, y, z ∈ R3 die Grassmann-Identität

x × (y × z) = hx, ziy − hx, yiz .

2. (10 Punkte)

Seien x, y, z ∈ R3 . Ist die folgende Aussage korrekt?

x, y, z sind linear abhängig ⇔ x × y, y × z, z × x sind linear abhängig .

Geben Sie ein Gegenbeispiel mit Rechnung oder einen Beweis!

8

(15 Punkte) Sei K ein Körper. Sind die folgenden Teilmengen Unterringe der angegebenen Matrizenringe?

Begründen Sie Ihre Antwort!

1. (ai j ) ∈ M(n × n, K) | ai j = 0 für i ≥ j ⊂ M(n × n, K)

2. (ai j ) ∈ M(n × n, K) | ai j = 0 für i ≥ j + k oder j ≥ i + k ⊂ M(n × n, K), wobei k ∈ N

3. (ai j ) ∈ M(n × n, K) | ai j = 0 für i 6= j oder i ≥ k ⊂ M(n × n, K), wobei k ∈ N

Lösung:

Es handelt sich bei 1 um die Matrizen, die nur oberhalb der Hauptdiagonale nicht-verschwindende

Einträge haben, und bei 3 um die Matrizen, bei denen nur die ersten k − 1 Einträge auf der Diagonale

ungleich Null sind. Beides sind Unterringe.

Dagegen ist 2 kein Unterring: betrachte n = 3 und k = 2 und

2 2 1

1 1 0

1 1 0

1 1 1 1 1 1 = 2 3 2

1 2 2

0 1 1

0 1 1

9

Sei K ein Körper und sei A ∈ M(2 × 2, K). Die Kommutante A0 von A ist der Untervektorraum von M(2 ×

2, K), der aus den Matrizen besteht, die mit der Matrix A kommutieren:

A0 := {B ∈ M(2 × 2, K) | A · B − B · A = 0} .

1. (5 Punkte) Zeigen Sie, dass die Kommutante eines Vielfachen der Einheitsmatrix λE2 mit λ ∈ K die

Dimension 4 hat.

2. (5 Punkte) Zeigen Sie, dass die Kommutante einer Matrix A, die kein Vielfaches der Einheitsmatrix

ist, mindestens die Dimension 2 hat.

3. (5 Punkte) Zeigen Sie, dass die Kommutante einer Matrix A, die kein Vielfaches der Einheitsmatrix

ist, höchstens die Dimension 3 hat.

4. (Zusatzaufgabe ohne Wertung) Zeigen Sie, dass die Kommutante einer Matrix A, die kein Vielfaches

der Einheitsmatrix ist, genau die Dimension 2 hat.

Lösung:

Ist A ein Vielfaches der Einheitsmatrix E2 , so ist offenbar A0 = M(2 × 2, K), also dimK A0 = 4.

Ist A kein Vielfaches der Einheitsmatrix, so kommutiert A mit E2 und mit A selbst. E2 und A sind linear

unabhängig, also ist dimK A0 ≥ 2.

Schreibt man

!

a b

A=

c d

so sieht man, dass nur Vielfache der Einheitsmatrix eine Kommutante der Dimension 4 haben: Vertauschen

mit der Matrixeinheit E11 liefert die Bedingung b = c = 0, Vertauschen mit der Matrixeinheit E12 liefert

die Bedingung a = d.

Zur Zusatzaufgabe:

Wäre dimK A0 = 3, so wäre der Schnitt mit dem zwei-dimensionalen Unterraum spanK (E11 , E12 ) nicht der

Nullvektorraum. Aus dem Gleichsetzen von

!

!

!

α β

aα βa

a b

=

c d

0 0

cα βc

und

α β

0 0

!

a b

c d

!

αa + βc αb + βd

0

0

=

!

folgt, da man das Element in der Kommutante so wählen kann, dass nicht α und β gleich Null sind,

c = 0. Ein analoges Argument mit dem Untervektorraum spanK (E21 , E22 ) zeigt, dass auch b = 0 gelten

muss. Also ist A eine Diagonalmatrix. Die beiden Diagonalelemente sind verschieden, da andernfalls die

Kommutante Dimension 4 hätte.

Die explizite Rechnung

!

!

!

a 0

α β

aα aβ

=

0 d

γ δ

dγ dδ

und

α β

γ δ

!

a 0

0 d

!

=

aα dβ

aγ dδ

!

zeigt durch den Vergleich der Außerdiagonalelemente, dass für Matrizen in der Kommutante von Diagonalmatrizen β = γ = 0 gelten muss, diese Kommutante also zwei-dimensional ist.

Den Abgabeschluß der multiple choice Aufgaben sehen Sie oben auf dem Blatt. Die schriftlichen Aufgaben

werden in der Übungsgruppe am Freitag, dem 14. April, abgegeben.

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

1,

1,

1,

1,

1,

1,

1,

1,

1,

1,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

4,

4,

5,

5,

Var

Var

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

1:

2:

1:

2:

[’Ja’]

[’Nein’]

[’Ja’]

[’Nein’]

[’Nein’]

[’Nein’]

[’Nein’]

[’Nein’]

[’Ja’]

[’Ja’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

2,

2,

2,

2,

2,

2,

2,

2,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

2,

3,

4,

5,

6,

7,

8,

Var

Var

Var

Var

Var

Var

Var

Var

1:

1:

1:

1:

1:

1:

1:

1:

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

3,

3,

3,

3,

3,

3,

3,

3,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

4,

4,

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

1:

2:

[’4’]

[’128’]

[’18’]

[’-18’]

[’(b)’]

[’(b)’]

[’(b)’]

[’(b)’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

4,

4,

4,

4,

4,

4,

4,

4,

4,

4,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

4,

4,

5,

5,

Var

Var

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

1:

2:

1:

2:

[’Nein’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Nein’]

[’Nein’]

[’Ja’]

[’Nein’]

[’Ja’]

[’Nein’]

Ex 5, Qu 1, Var 1: [’-1’]

Ex 5, Qu 2, Var 1: [’125’]

Ex 5, Qu 3, Var 1: [’11’]

Übungsblatt 3

zur Vorlesung Lineare Algebra und Analytische Geometrie II im Sommersemester 2008

Christoph Schweigert

Erstellt am 21.04.2008, 16:04 Uhr für Matrikelnummer CHECKING ALL VARIANTS. Abgabezeitpunkt ist

21.04.2008, 08:30 Uhr.

1

1

Es sei K ein Körper. Weiter sei A = (ai, j ) ∈ M(n × n, K) und s ∈ K. Entscheiden Sie, ob die folgenden

Aussagen allgemein richtig sind.

Es ist det(sA) = s · det A.

Es ist

2

3

4

Ja / Nein

det(sA) = sn · det A.

Ja / Nein

Ist K = Q und det(A3 ) = 1, so ist det A = 1.

Dann muss auch (det A)3 = 1 gelten, was über Q nur die Lösung det A = 1 hat.

Ja / Nein

Ist K = Q und det(A5 ) = 1, so ist det A = 1.

Dann muss auch (det A)5 = 1 gelten, was über Q nur die Lösung det A = 1 hat.

Ja / Nein

Ist K = Q und det A = 2, so gibt es kein B ∈ M(n × n, Q) mit B2 = A.

Es gilt dann (det B)2 = 2 und det B ∈ Q, was keine Lösung hat.

Ja / Nein

Das Gleichungssystem über Z7

Ja / Nein

1x1 + 4x2 + 2x3 = 1

4x1 + 1x2 + 6x3 = 2

2x1 + 1x2 + 2x3 = 3

2

1

hat eine eindeutige Lösung (x1 , x2 , x3 ) in Z37 .

Man berechnet die Determinante der Koeffizientenmatrix über Z zu 16, also über

Z7 zu 2.

Es seien A, B,C, D ∈ M(n × n, Q). Entscheiden Sie, ob die folgenden Aussagen wahr sind.

!

A B

= (det A) · (det D) − (det B) · (detC).

Es gilt stets det

wahr / falsch

C D

Lösung:

Betrachte als Gegenbeispiel

1

0

0

0

0

0

0

1

0

0

1

0

0

1

0

0

Diese Matrix hat Determinante −1, die falsche Regel würde aber 0 liefern.

2

Genau dann gilt für alle A, B,C, D ∈ M(n × n, Q), dass

!

A B

det

= (det A) · (det D) − (det B) · (detC)

C D

wahr / falsch

ist, wenn n = 1 ist.

Lösung:

Betrachte als Gegenbeispiel

3

1

0

0

0

0

0

0

1

0

0

1

0

0

1

0

0

Diese Matrix hat Determinante −1, die falsche Regel würde aber 0 liefern.

!

0 B

Es gilt stets det

= (det B) · (detC).

C 0

wahr / falsch

Lösung:

Falsch, schon für n = 1 gilt

! das nicht.

Es gilt stets det

4

A B

C 0

= (det B) · (detC).

Lösung:

Falsch, schon für n = 1 gilt das nicht.

!

0 B

Genau dann gilt det

= (det B) · (detC) für alle B,C ∈ M(n × n, Q),

C 0

wenn n gerade ist.

Lösung:

Man sieht dies, indem man die ersten n und die letzten n Spalten vertauscht.

Hierzu sind n2 Vertauschungen vonnöten, was nur für gerades n gerade ist und

so das Vorzeichen der Determinante nicht ändert.

wahr / falsch

wahr / falsch

5

Es gilt stets det

A 0

B C

!

= (det A) · (detC).

Lösung: Wahr, denn wir können schreiben

!

!

A 0

A 0

det

= det

· det

B C

B En

wahr / falsch

En 0

0 C

!

.

Durch n-malige Entwicklung nach der jeweils letzten Spalte findet man

!

A 0

det

= det A .

B En

Analog ergibt sich durch n-malige Entwicklung nach der jeweils ersten Spalte

!

En 0

det

= detC .

0 C

Es gilt stets det

A B

0 C

!

= (det A) · (detC).

Lösung: Wahr, denn wir können schreiben

!

!

En 0

A B

= det

· det

det

0 C

0 C

wahr / falsch

A B

0 En

!

.

Durch n-malige Entwicklung nach der jeweils letzten Spalte findet man

!

A B

det

= det A .

0 En

Analog ergibt sich durch n-malige Entwicklung nach der jeweils ersten Spalte

!

En 0

= detC .

det

0 C

6

Es gilt stets det(A · B) = det(B · A).

wahr / falsch

Lösung:

det(A · B) = det(A)det(B) = det(B)det(A) = det(B · A)

3

Es seien V , W und U Vektorräume über einem Körper K und ϕ : V → W und ψ : W → U lineare Abbildungen. Sind die folgenden Aussagen richtig?

1

Sind v1 6= v2 Elemente von V und gilt ϕ(v1 ) = ϕ(v2 ) 6= 0, dann ist (v1 , v2 ) in V

linear unabhängig.

Ja / Nein

Lösung:

Wäre die Familie (v1 , v2 ) linear abhängig, so gälte v1 = λv2 mit λ 6= 1, da beide

Elemente ungleich null sein müssen. Wegen λϕ(v2 ) = ϕ(v1 ) = ϕ(v2 ) 6= 0 ist dies

aber nicht möglich.

Sind v1 6= v2 Elemente von V und gilt ϕ(v1 ) = ϕ(v2 ) 6= 0, dann ist (v1 , v2 ) in V Ja / Nein

linear abhängig.

Lösung:

Wäre die Familie (v1 , v2 ) linear abhängig, so gälte v1 = λv2 mit λ 6= 1, da beide

Elemente ungleich null sein müssen. Wegen λϕ(v2 ) = ϕ(v1 ) = ϕ(v2 ) 6= 0 ist dies

aber nicht möglich.

2

Sind v1 6= v2 Elemente von V und gilt ϕ(v1 ) = ϕ(v2 ), dann ist (v1 , v2 ) in V linear Ja / Nein

unabhängig.

Lösung:

Wähle als Gegenbeispiel v1 = 0 und v2 6= 0 im Kern von ϕ.

Sind v1 6= v2 Elemente von V und gilt ϕ(v1 ) = ϕ(v2 ), dann ist (v1 , v2 ) in V linear Ja / Nein

abhängig.

Lösung:

Wähle als Gegenbeispiel v1 , v2 linear unabhängig im Kern von ϕ.

3

Sind v1 6= v2 Elemente von V und gilt ψ(ϕ(v1 )) = ψ(ϕ(v2 )) 6= 0, dann ist

(ϕ(v1 ), ϕ(v2 )) in W linear unabhängig.

Ja / Nein

Lösung:

Wähle ein Beispiel, bei dem ϕ(v1 ) = ϕ(v2 ) mit v1 6= v2 gilt.

Sind v1 6= v2 Elemente von V und gilt ψ(ϕ(v1 )) = ψ(ϕ(v2 )) 6= 0, dann ist

(ϕ(v1 ), ϕ(v2 )) in W linear abhängig.

Ja / Nein

Lösung:

Wähle als Gegenbeispiel V = W und ϕ = id, v1 und v2 linear unabhängig, aber

v1 − v2 ∈ Kerψ.

4

Sind v1 6= v2 Elemente von V und gilt ϕ(v1 ) = ϕ(v2 ) und ψ(ϕ(v1 )) 6= 0, dann ist

(v1 , v2 ) in V linear unabhängig.

Ja / Nein

Lösung:

Wären Sie linear abhängig, so wäre v1 = λv2 mit λ 6= 1, woraus folgt ϕ(v1 ) =

λϕ(v2 ). Zusammen mit der Bedingung ϕ(v1 ) = ϕ(v2 ) folgt ϕ(v1 ) = 0, was im

Widerspruch zu ψ(ϕ(v1 )) 6= 0 ist.

Sind v1 6= v2 Elemente von V und gilt ϕ(v1 ) = ϕ(v2 ) und ψ(ϕ(v1 )) 6= 0, dann ist

(v1 , v2 ) in V linear abhängig.

Lösung:

Wären Sie linear abhängig, so wäre v1 = λv2 mit λ 6= 1, woraus folgt ϕ(v1 ) =

λϕ(v2 ). Zusammen mit der Bedingung ϕ(v1 ) = ϕ(v2 ) folgt ϕ(v1 ) = 0, was im

Widerspruch zu ψ(ϕ(v1 )) 6= 0 ist.

Ja / Nein

5

Sind v1 und v2 Elemente von V mit v1 = v2 und gilt ψ(ϕ(v1 )) = ψ(ϕ(v2 )) 6= 0, Ja / Nein

dann ist (ϕ(v1 ), ϕ(v2 )) in W linear abhängig.

Lösung:

Es gilt sogar ϕ(v1 ) = ϕ(v2 ), also ist die Familie linear abhängig.

Sind v1 und v2 Elemente von V mit v1 = v2 und gilt ψ(ϕ(v1 )) = ψ(ϕ(v2 )) = 0, Ja / Nein

dann ist (ϕ(v1 ), ϕ(v2 )) in W linear unabhängig.

Lösung:

Es gilt sogar ϕ(v1 ) = ϕ(v2 ), also ist die Familie linear abhängig.

Die folgenden Aufgaben sind schriftlich zu bearbeiten.

4

(10 Punkte) Sei K ein Körper und A = (ai j ) ∈ M(n × n, K). Zeigen Sie, dass dann gilt

det(ai j ) = det((−1)i+ j ai j ) .

Hinweis: Weisen Sie nach, dass die Abbildung

M(n × n, K) → K

A 7→ det((−1)i+ j ai j )

eine Determinantenabbildung ist.

Lösung:

Wir zeigen, dass die genannte Abbildung eine Determinantenabbildung ist. Die Behauptung folgt dann

aus der Eindeutigkeit der Determinantenabbildung.

(D1) Die zeilenweise Linearität ist offensichtlich.

(D2) Stimmen die k-te und l-te Zeile von A überein, so unterscheiden sich die k-te und l-te Zeile der Matrix mit Einträgen (−1)i+ j ai j um ein Vorzeichen (−1)l−k . Die Determinante der Matrix (−1)i+ j ai j

verschwindet daher auch.

(D3) Offensichtlich gilt für die Einheitsmatrix:

det((−1)i+ j δi j ) = det(δi j ) = 1 .

5

(15 Punkte) Sei K ein Körper und V ein n-dimensionaler K-Vektorraum. Eine Hyperebene H in V ist ein

(n − 1)-dimensionaler affiner Unterraum von V .

(i) Zeigen Sie: Eine Teilmenge A ⊂ K n ist eine Hyperebene genau dann, wenn es einen von Null verschiedenen Vektor φ im Vektorraum HomK (V, K) und ein c ∈ K gibt, so dass

A = {x ∈ K n | φ(x) = c}

gilt.

(ii) Betrachten Sie nun den Fall K = R und V = Rn , versehen mit dem Standard-Skalarprodukt

n

hv, wi = ∑ vi wi .

i=1

Zeigen Sie, dass die Abbildung

Rn → HomR (Rn , R)

v

7→ ϕv

mit ϕv (w) = hv, wi ein Isomorphismus von reellen Vektorräumen ist.

(iii) Schließen Sie nun, dass sich jede Hyperebene in Rn in der Form

A = {x ∈ Rn | hv, xi = c}

mit geeignetem c ∈ R und v ∈ Rn , v 6= 0 schreiben lässt. (Dies ist die sogenannte Hessesche Normalform einer Hyperebene im R3 .)

Lösung:

(i) Die Lösungsmenge von φ(x) = c ist nach Bemerkung 2.3.7 der Vorlesung entweder leer oder

ein affiner Unterraum der Dimension dimK Kerφ. Offenbar rgφ = 1, also nach der Gradformel

dimK Kerφ = n − rgφ = n − 1. Die Menge ist nie leer: da φ nicht null ist, gibt es wenigstens einen

Vektor ei in der Standardbasis, so dass φ(ei ) = ci 6= 0. Somit ist φ( cci ei ) = c und cci ei ∈ A.

Sei nun umgekehrt A = p + U ein n − 1-dimensionaler affiner Unterraum. Dann ergänzen wir eine

Basis {w1 , . . . , wn−1 } von U zu einer Basis {w1 , . . . , wn } von V . Setze φ(wi ) = 0 für i ≤ n − 1 und

φ(wn ) = 1. Setze c := φ(p).

Dann ist φ−1 (c) = A, denn wegen

φ(p + u) = φ(p) + φ(u) = c + 0 = c

für u ∈ U ist A ⊆ φ−1 (c) und beide Räume haben Dimension n − 1.

(ii) Wegen der Bilinearität des Skalarprodukts ist die Abbildung linear. Sie ist injektiv, denn aus hv, wi =

0 für alle w ∈ V folgt v = 0. Da beide Vektorräume die gleiche Dimension haben, ist die Abbildung

auch surjektiv, also ein Isomorphismus.

(iii) Es folgt aus (ii) sofort, dass es ein v ∈ Rn gibt, so dass φ(·) = hv, ·i gilt.

6

(15 Punkte) Sei φ der Endomorphismus des Q-Vektorraumes M(n × n, Q), der durch die Transposition

gegeben ist,

φ(M) = Mt .

Berechnen Sie die Determinante von φ.

Lösung:

Man kann leicht eine Basis von M(n × n, Q) finden in der φ diagonal ist.

Für j ≥ i sei Ei+j die Matrix, die überall den Eintrag 0 hat, ausser in der i-ten Zeile und der j-ten Spalte,

sowie in der j-ten Zeile und der i-ten Spalte. Diese beiden Einträge seien gleich 1.

Analog, für j > i sei Ei−j die Matrix, die überall den Eintrag 0 hat, ausser in der i-ten Zeile und der j-ten

Spalte, hier habe sie den Wert +1, sowie in der j-ten Zeile und i-ten Spalte, hier habe sie den Wert −1.

Es ist klar, dass man aus Linearkombinationen von Ei+j und Ei−j alle Matrizen in M(n × n, Q) gewinnen

kann. (Überlegen Sie sich, wie die Basismatrizen Ei j durch die Matrizen Ei+j und Ei−j ausgedrückt werden

können.)

Man kann sich leicht überzeugen, dass es n(n + 1)/2 Matrizen vom Typ Ei+j und n(n − 1)/2 Matrizen vom

Typ Ei−j gibt.

Es ist φ(Ei+j ) = Ei+j und φ(Ei−j ) = −Ei−j , also hat φ in dieser Basis Diagonalgestalt. Auf der Diagonalen findet sich n(n + 1)/2-mal der Eintrag +1 und n(n − 1)/2-mal der Eintrag −1. Also ist det φ = (−1)n(n−1)/2 .

7

(10 Punkte) Es sei K ein Körper und a0 , a1 , . . . , an ∈ K. Zeigen Sie:

1 1 ··· 1

a0 a1 · · · an

2 2

2

a

a

·

·

·

a

det

n

0

1

= ∏ (a j − ai )

.. 0≤i< j≤n

.. .. . .

.

. .

.

an0 an1 · · · ann

Lösung:

Beweis durch vollständige Induktion nach n. Der Induktionsanfang n = 1 ist trivial.

Induktionsschritt:

Wir addieren das (−an )-fache der k-ten Zeile zur k + 1-ten Zeile, ohne den Wert der Determinante zu

ändern:

1

1 ···

1 1

a0 − an

a1 − an · · ·

an−1 − an 0

a

(a

−

a

)

a

(a

−

a

)

·

·

·

a

(a

−

a

)

0

det

n

n

n

0

0

1

1

n−1

n−1

..

.. . .

..

.

.

.

.

n−1

n−1

an−1

0 (a0 − an ) a1 (a1 − an ) · · · an−1 (an−1 − an ) 0

Wir entwickeln nach der letzten Spalte und erhalten nur eine einzige Determinante. Bei dieser ziehen wir

nun aus der ersten Spalte einen Faktor (a0 − an ), aus der zweiten (a1 − an ) etc. Wir erhalten so

n−1

(−1)n+2 ∏ (ai − an )Vn−1

i=0

wobei Vn−1 ein Ausdruck der obigen Form in den Variablen a0 , . . . , an−1 mit einer Zeile und Spalte weniger

ist.

Man nennt die Determinante einer Matrix dieser Gestalt auch Vandermonde-Determinante.

8

(15 Punkte):

Es sei I eine Indexmenge und Ai mit i ∈ I eine Familie von Mengen. (Sie dürfen I = N wählen, wenn

Ihnen das hilft.) Wir definieren das kartesische Produkt ∏i∈I Ai als Menge aller Abbildungen f : I → ∪Ai

mit f (i) ∈ Ai . Auf dem kartesischen Produkt betrachten wir für jedes i ∈ I die kanonischen Projektionen

pi : ∏ j∈I A j −→ Ai

f 7→ f (i) .

(i) Beweisen Sie die folgende universelle Eigenschaft des kartesischen Produktes: Sei eine Menge Q

gegeben und sei für jedes i ∈ I eine Abbildung

fi : Q −→ Ai

gegeben. Dann gibt es eine eindeutige Abbildung

f : Q −→ ∏ Ai

i∈I

so dass

f i = pi ◦ f

gilt.

Zeichnen Sie auch die relevanten kommutierenden Diagramme. Vergleichen Sie mit dem in der Vorlesung

eingeführten Produkt von Vektorräumen.

Die folgende Definition ist das Analogon zur direkten Summe von Vektorräumen. Gegeben sei wieder

eine Familie (Ai )i∈I von Mengen. Eine Menge P zusammen mit einer Familie von Injektionen ιi : Ai → P

heißt Koprodukt, wenn es für jede Menge B und jede Familie von Abbildungen fi : Ai → B genau eine

Abbildung f : P → B gibt, so dass für alle i ∈ I gilt fi = f ◦ ιi .

(ii) Zeigen Sie: alle Mengen P mit dieser Eigenschaft, wenn überhaupt eine solche Menge existiert, sind

isomorph.

(iii) Eine solche Menge existiert: Geben Sie eine mögliche Wahl für P an und weisen Sie nach, dass diese

die genannte Eigenschaft erfüllt.

Lösung:

(i) Sei q ∈ Q. Angenommen eine solche Abbildung f : Q → ∏i∈I Ai existiert. Wir schreiben fq := f (q) :

I → ∪Ai . Dann muss wegen der universellen Eigenschaft gelten

fq (i) = pi ( fq ) = pi ( f (q)) = (pi ◦ f )(q) = fi (q)

Dadurch ist fq für jedes q eindeutig bestimmt und f somit eindeutig festgelegt. Umgekehrt erfüllt die

durch fq (i) = fi (q) definierte Abbildung die geforderte Eigenschaft.

(ii) Sei P0 eine weitere Menge, die diese Eigenschaft mit Abbildungen ι0i : Ai → P0 erfüllt. Diese Eigenschaft auf die Abbildungen ιi angewandt liefert eine eindeutig bestimmte Abbildung f : P0 → P mit

ιi = f ◦ ι0i . Die Eigenschaft von P angewandt auf die Abbildungen ι0i liefert eine eindeutig bestimmte Abbildung g : P → P0 , so dass ι0i = g ◦ ιi . Damit ist ι0i = g ◦ f ◦ ι0i . Die Eigenschaft von P0 auf ι0i angewandt

liefert eine eindeutige Abbildung h : P0 → P0 mit ι0i = h ◦ ι0i . Da dies mit h = idP0 erfüllt ist, folgt g ◦ f = idP0 .

Genauso zeigt man f ◦ g = idP .

(iii) Eine mögliche Wahl für P ist die disjunkte Vereinigung der Mengen Ai . Diese ist definiert als

ti∈I Ai := ∪i∈I {i} × Ai .

Die Abbildungen ι j sind die Inklusionen:

ι j : A j → ti∈I Ai

a 7→ ( j, a)

Den Abgabeschluß der multiple choice Aufgaben sehen Sie oben auf dem Blatt. Die schriftlichen Aufgaben

werden in der Übungsgruppe am Montag, dem 21. April, abgegeben.

Ex

Ex

Ex

Ex

Ex

Ex

1,

1,

1,

1,

1,

1,

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

4,

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

1:

[’Nein’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

2,

2,

2,

2,

2,

2,

2,

2,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

2,

3,

3,

4,

5,

5,

6,

Var

Var

Var

Var

Var

Var

Var

Var

1:

1:

1:

2:

1:

1:

2:

1:

[’falsch’]

[’wahr’]

[’falsch’]

[’falsch’]

[’wahr’]

[’wahr’]

[’wahr’]

[’wahr’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

3,

3,

3,

3,

3,

3,

3,

3,

3,

3,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

4,

4,

5,

5,

Var

Var

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

1:

2:

1:

2:

[’Ja’]

[’Nein’]

[’Nein’]

[’Nein’]

[’Nein’]

[’Nein’]

[’Ja’]

[’Nein’]

[’Ja’]

[’Nein’]

Übungsblatt 4

zur Vorlesung Lineare Algebra und Analytische Geometrie II im Sommersemester 2008

Christoph Schweigert

Erstellt am 28.04.2008, 16:32 Uhr für Matrikelnummer CHECKING ALL VARIANTS. Abgabezeitpunkt ist

28.04.2008, 08:00 Uhr.

1

1

Man berechne den Rang der Matrix A = (ai, j ) ∈ M(n × n, Q) mit n ≥ 2 und . . .

ai, j = i + j.

Lösung:

Es gilt für festes i und alle j

ai j = (2 − i)a1 j + (i − 1)a2 j .

Also lassen sich alle Zeilen als Linearkombination der ersten und zweiten Zeile

schreiben. Der Rang ist also höchsten gleich zwei. Da die ersten beiden Zeilen

linear unabhängig sind, ist der Rang genau gleich zwei.

ai, j = i + j + 1.

Lösung:

Es gilt für festes i und alle j

ai j = (2 − i)a1 j + (i − 1)a2 j .

Also lassen sich alle Zeilen als Linearkombination der ersten und zweiten Zeile

schreiben. Der Rang ist also höchsten gleich zwei. Da die ersten beiden Zeilen

linear unabhängig sind, ist der Rang genau gleich zwei.

2

ai, j = i − j.

Lösung:

Es gilt für festes i und alle j

ai j = (2 − i)a1 j + (i − 1)a2 j .

Also lassen sich alle Zeilen als Linearkombination der ersten und zweiten Zeile

schreiben. Der Rang ist also höchsten gleich zwei. Da die ersten beiden Zeilen

linear unabhängig sind, ist der Rang genau gleich zwei.

ai, j = i − j + 1.

Lösung:

Es gilt für festes i und alle j

ai j = (2 − i)a1 j + (i − 1)a2 j .

Also lassen sich alle Zeilen als Linearkombination der ersten und zweiten Zeile

schreiben. Der Rang ist also höchsten gleich zwei. Da die ersten beiden Zeilen

linear unabhängig sind, ist der Rang genau gleich zwei.

3

ai, j = i · j.

Lösung:

Die i-te Zeile ist das i-fache der ersten Zeile, also ist der Rang maximal gleich

eins. Da die erste Zeile linear unabhängig ist, ist der Rang genau gleich eins.

ai, j = 2 · i · j.

Lösung:

Die i-te Zeile ist das 2i-fache der ersten Zeile, also ist der Rang maximal gleich

Eins. Da die erste Zeile linear unabhängig ist, ist der Rang genau gleich eins.

4

ai, j = ji .

Lösung: Dies ist eine Matrix von der Form wie sie in Aufgabe 7 auf dem dritten

Übungsblatt behandelt wurde (Vandermonde Determinante). Dort war allgemeiner ai, j = (r j )i , für gegebene Konstanten r j . Im hier gegebenen Fall ist r j = j

Die Determinante dieser Matrix ist allgemein ∏ (r j − ri ), in unserem Fall

0≤i< j≤n

∏

also

( j − i). Alle Faktoren in diesem Produkt sind positiv, daher ist das

0≤i< j≤n

gesamte Produkt positiv. Insbesondere ist also die Determinante unserer Matrix

nichtverschwindend. Daher hat sie vollen Rang.

ai, j = ji+1 .

Lösung: Wir können aus jeder Zeile dieser Matrix einen Faktor herausziehen,

und zwar aus der iten Zeile den Faktor j. Die verbleibende Matrix hat offenbar

noch immer den selben Rang wie die ursprüngliche Matrix.

Die verbleibende Matrix ist ai, j = ji . Dies ist eine Matrix von der Form wie

sie in Aufgabe 7 auf dem dritten Übungsblatt behandelt wurde (Vandermonde

Determinante). Dort war allgemeiner ai, j = (r j )i , für gegebene Konstanten r· .

Im hier gegebenen Fall ist r j = j

Die Determinante dieser Matrix ist allgemein ∏ (r j − ri ), in unserem Fall

also

∏

0≤i< j≤n

( j − i). Alle Faktoren in diesem Produkt sind positiv, daher ist das

0≤i< j≤n

5

gesamte Produkt positiv. Insbesondere ist also die Determinante unserer Matrix

nichtverschwindend. Daher hat sie vollen Rang.

(

i für i ≥ j

.

ai, j =

0 sonst

Lösung:

Es liegt eine obere Dreiecksmatrix mit nicht verschwindenden Einträgen auf der

Diagonale

( vor, die also invertibel ist, also maximalen Rang hat.

ai, j =

j für i < j

.

0 sonst

Lösung:

Wie bei einer oberen Dreicksmatrix zeigt man, dass die n − 1 nicht verschwindenden Zeilen linear unabhängig sind. Also ist der Rang gleich n − 1.

2

Seien A, B ∈ M(n × n, R) quadratische Matrizen mit reellen Einträgen.

1

Ist

det

A iB

iB A

Ja / Nein

!

reell?

Lösung:

Durch Umformungen sieht man:

!

!

A iB

A + iB A + iB

det

= det

= det

iB A

iB

A

Ist

det

iA −B

−B iA

A + iB 0

iB

A − iB

!

= | det(A+iB)|2

Ja / Nein

!

reell?

Lösung:

Durch Umformungen sieht man:

!

!

iA −B

iA − B iA − B

det

= det

= det

−B iA

−B

iA

2

Ist

det

A

iB

−iB A

iA − B 0

−B

iA + B

!

= −| det(B+iA)|2

Ja / Nein

!

reell?

Lösung:

Durch Umformungen sieht man:

!

!

A

iB

A

iB

det

= det

= det

−iB A

i(A − B) A − B

Ist

det

iA −B

B iA

A + B iB

0

A−B

!

= det(A+B) det(A−B)

Ja / Nein

!

reell?

Lösung:

Durch Umformungen sieht man:

!

!

iA −B

iA

−B

det

= det

= det

B iA

−A + B iA − iB

iA + iB −B

0

iA − iB

!

= − det(A−B) det(A+B)

3

Ist

det

A

B

−B A

Ja / Nein

!

stets nicht-negativ?

Lösung:

Wir rechnen:

det

A

B

−B A

!

= det

A − iB B + iA

−B

A

!

= det

Ist

det

A B

B −A

A − iB 0

−B

A + iB

!

= | det(A+iB)|2

Ja / Nein

!

stets nicht-negativ?

Lösung:

det

3

1

2

3

4

5

4

1

2

A B

B −A

!

= det

A + iB B − iA

B

−A

!

= det

A + iB 0

B

−A + iB

!

= −| det(A+iB)|2

Es sei K ein Körper, n ∈ N, n ≥ 2 und A ∈ M(n × n, K). Sind die folgenden Aussagen richtig?

Sei (Ã)i j = (−1)i+ j det Astr

ji ist die zu A komplementäre Matrix. Ist die Matrix A

ist genau dann invertierbar, wenn A · Ã 6= 0 ist?.

Ja / Nein

Die Abbildung det : GLn (K) → K ∗ = K \ {0} ist ein surjektiver Gruppenhomomorphismus.

Die Abbildung det : GLn (K) → K ∗ = K \ {0} ist ein injektiver Gruppenhomomorphismus.

Ja / Nein

Sind zwei Zeilen von A linear abhängig, dann ist det(A) = 0.

Ja / Nein

Sind zwei Spalten von A linear abhängig, dann ist det(A) = 0.

Ja / Nein

Ja / Nein

Ist A eine invertierbare obere Dreiecksmatrix, dann ist auch A−1 eine obere Drei- Ja / Nein

ecksmatrix.

Ist A eine invertierbare untere Dreiecksmatrix, dann ist auch A−1 eine untere Ja / Nein

Dreiecksmatrix.

Es sei K = R und A = (ai j ) ∈ M(n × n, R). Ist ai j ∈

/ Q für ein Paar (i, j), dann ist Ja / Nein

auch det(A) ∈

/ Q.

Es sei n ∈ N mit n ≥ 2. Sind die folgenden Aussagen richtig?

A ∈ M(n × n, Z) ist genau dann invertierbar in M(n × n, Z), wenn det(A) ∈ Ja / Nein

{1, −1} ist.

A ∈ M(n × n, Z) ist genau dann invertierbar in M(n × n, Z), wenn det(A) = 1 ist.

Ja / Nein

Es sei K ein beliebiger Körper, A ∈ M(n × n, K) invertierbar und At = A−1 . Dann

ist det(A) = 1.

Ja / Nein

Es sei K ein Körper, A ∈ M(n × n, K) invertierbar und At = A−1 . Dann ist Ja / Nein

det(A) ∈ {1, −1}.

3

−1

Es sei

A = (ai j ) ∈ M(n × n, R) invertierbar. Sind alle ai j ∈ Z, dann gilt: A = Ja / Nein

bi j

bi j

ci j mit gewissen bi j , ci j ∈ Z und ci j | det(A) wenn ci j ein gekürzter Bruch ist.

Lösung:

Dies ist eine gekürzte Darstellung der inversen Matrix nach Satz 3.2.14 der Vorlesung

4

5

Gilt für A ∈ M(n × n, Z), dass in jeder Zeile und in jeder Spalte genau eine 1 und

sonst lauter Nullen stehen, dann ist A ∈ M(n × n, Z) invertierbar.

Ja / Nein

Gilt für A ∈ M(n × n, Z), dass in jeder Zeile und in jeder Spalte genau eine 1 und

sonst lauter Nullen stehen, dann ist det(A) = 1.

Ja / Nein

Gilt für A ∈ M(n × n, Z), dass in jeder Zeile genau eine 1 und sonst lauter Nullen Ja / Nein

stehen, dann ist det(A) ∈ {1, −1}.

Gilt für A ∈ M(n × n, Z), dass in jeder Zeile genau eine 1 und sonst lauter Nullen Ja / Nein

stehen, dann ist det(A) ∈ {1, 0, −1}.

Die folgenden Aufgaben sind schriftlich zu bearbeiten.

5

Sei K ein Körper und seien A, B ∈ M(n × n, K).

1. (5 Punkte) Zeigen Sie, dass die Abbildungsvorschrift

φ(M) = AMB

einen Endomorphismus des K-Vektorraumes M(n × n, K) definiert.

2. (5 Punkte) Berechnen Sie die Wirkung von φ auf die Basismatrizen (Das sind solche Matrizen deren

Einträge alle verschwinden, bis auf einen einzigen Eintrag mit dem Wert 1.)

3. (10 Punkte) Bestimmen Sie nun die Determinante von φ als Funktion von det(A) und det(B).

Lösung:

Wir berechnen φ auf den Basismatrizen Ei j :

φ(Ei j ) = AEi j B = (∑ akl Ekl Ei j )B = (∑ aki Ek j )(∑ blm Elm ) = ∑ aki b jm Ekm

k,l

k

l,m

k,m

Wir definieren zwei Endomorphismen ψ1 , ψ2 von M(n × n, K) durch

ψ1 (M) := AM

ψ2 (M) := MB

Dann ist φ = ψ1 ◦ ψ2 . Wir rechnen mit Basismatrizen:

ψ1 (Ei j ) = A · Ei j = ∑ aki Ek j

k

Betrachtet man den Unterraum von M(n × n, K), der von den Basismatrizen Ei j mit gleichem j aufgespannt wird, so wird ψ auf jedem dieser n Unterräume durch die Matrix A dargestellt. So erhält

man n Matrixblöcke mit A, also det ψ1 = (det A)n . Ähnlich folgt det ψ2 = (det B)n . Zusammen also

det φ = det ψ1 det ψ2 = det(AB)n .

6

Schreiben Sie die folgenden invertierbaren Matrizen als Produkte von Elementarmatrizen in M(n × n, Q):

(a) (5 Punkte)

!

−5

4

A=

4 −3

(b) (10 Punkte)

−1 −1 4

B= 2

1 4

−4 −2 8

Bemerkung:

Man kann zeigen, dass für jeden Körper K die Elementarmatrizen in M(n × n, K) die Gruppe GL(n, K)

erzeugen, d.h. dass sich jede invertierbare n×n Matrix als Produkt von (endlich vielen) Elementarmatrizen

schreiben lässt. Jedoch ist diese Darstellung als Produkt nicht eindeutig!

Lösung:

Wir bestimmen die inversen Matrizen mit dem üblichen Verfahren. Die dabei gemachten Zeilenumformungen schreiben wir mit den zugehörigen Elementarmatrizen. Diese Elementarmatrizen invertieren wir

wieder u nd erhalten so beispielsweise (zur Erinnerung: Diese Darstellung ist nicht eindeutig!)

(a) Es ist z.B.

!

!

!

!

1 −1

1 0

−1 0

1 −1

·

·

·

A=

0

1

−4 1

0 1

0

1

(b) Es ist z.B.

1

0 0

1 0 0

1 0 0

1 0 0

1 0 0

1 0 12

B = 0 1 0 · 0

1 0 · 0 1 0 · 2 1 0 · 0 1 1 · 0 1 0

0 −2 1

0 0 2

0 0 1

0 0 1

0 0 4

0 0 1

7

(10 Punkte) Es sei K ein Körper und es seien a1 , . . . an ∈ K für n ∈ N. Sei

a1

1

0

1

0

−1 a2

0 −1 a3 1

dn (a1 , . . . an ) = det

.

−1 . .

..

. 1

0

−1 an

Zeigen Sie:

Für n ≥ 3 ist

dn−1 (a2 , . . . , an )

=

dn (a1 , . . . , an )

a1 + a

1

1

2+

1

a3 +

..

1

.+

1

an−1 + a1n

Lösung:

Mit Induktion. Induktionsanfang n = 3:

Es ist d3 (a1 , a2 , a3 ) = a1 a2 a3 + a1 + a3 und d2 (a2 , a3 ) = a2 a3 + 1. Wir rechnen

1

a1 +

1

a2 + a1

=

1

a1 +

a3

a2 a3 +1

=

a2 a3 + 1

a1 a2 a3 + a1 + a3

3

durch Erweitern der Brüche.

Induktionsschritt:

Wir berechnen dn (a1 , . . . an ) durch Entwicklung nach der ersten Spalte:

dn (a1 , . . . an ) = a1 dn−1 (a2 , . . . , an ) + dn−2 (a3 , . . . , an )

Jetzt teilen wir dn−1 (a2 , . . . , an ) durch beide Seiten dieser Gleichung:

dn−1 (a2 , . . . , an )

1

dn−1 (a2 , . . . , an )

=

=

d

dn (a1 , . . . an )

a1 dn−1 (a2 , . . . , an ) + dn−2 (a3 , . . . , an ) a1 + n−2 (a3 ,...,an )

dn−1 (a2 ,...,an )

wobei wir auf der rechten Seite mit dn−1 (a2 , . . . , an ) gekürzt haben. Nach Induktionsvoraussetzung ist

dn−2 (a3 ,...,an )

dn−1 (a2 ,...,an ) ein Kettenbruch.

8

Die folgende Aufgabe soll Ihnen zeigen, wie man die Determinante eines Endomorphismus definieren

kann, ohne dass man vorher Determinanten von Matrizen einführt.

Sei K ein Körper, in dem 1 + 1 6= 0 gilt, und Vi , 1 ≤ i ≤ r endlich-dimensionale K-Vektorräume. Eine

Abbildung

ϕ : V1 × . . .Vr → K

heißt r-Linearform, wenn sie in jedem Argument K-linear ist.

(i) (5 Punkte) Zeigen Sie, dass die Menge aller r-Linearformen ein K-Vektorraum ist, und bestimmen Sie

seine Dimension als Funktion der Dimensionen der Vektorräume Vi .

Seien nun alle Vektorräume gleich, also V1 = V2 = . . .Vr = V . Eine K-Linearform ϕ : V r → K heißt alternierend, wenn für jedes r-Tupel von Vektoren vi ∈ V gilt, dass ϕ(v1 , v2 , . . . , vr ) = 0, sobald zwei vi gleich

sind.

(ii) (10 Punkte) Sei nun r = dimK V . Zeigen Sie, dass der Raum aller alternierenden dimK V -Linearformen

eindimensional ist.

(iii) (5 Punkte) Schließen Sie aus Teil (ii), dass es für jeden Endomorphismus A von V genau einen Skalar

d(A) ∈ K gibt, so dass für jede alternierende r-Linearform ϕ und alle vi ∈ V die Beziehung

ϕ(Av1 , Av2 , . . . , Avr ) = d(A)ϕ(v1 , v2 , . . . , vr )

erfüllt ist.

Wählen Sie nun eine Basis B von V und erhalten Sie einen Isomorphismus

MBB : End(V ) → M(r × r, K)

(iv) (5 Punkte) Zeigen Sie: die Abbildung

M(r × r, K) → K

M

7→ d((MBB )−1 M)

ist eine Determinantenabbildung.

Freiwillige Zusatzaufgaben:

(a) Schließen Sie direkt aus der Definition, dass für zwei Endomorphismen A1 , A2 von V gilt d(A1 ◦ A2 ) =

d(A1 ) · d(A2 ).

(b) Ein Endomorphismus A ist genau dann bijektiv, wenn d(A) 6= 0 gilt.

9

(Lösung zur vorigen Aufgabe)

(i)

Die Vektorraumeigenschaft ist klar: Die Summe zweier r-Linearformen ist sicher wieder in jedem Argument K-linear, ebenso das Produkt jeder Multilinearform mit einem Element aus K.

Per Definition ist jede Multilinearform (wie gewöhnliche Linearformen auch) durch ihre Werte auf Basisvektoren der Vi festgelegt. Nachdem wir in jedem Vi eine Basis gewaehlt haben gibt es offensichtlich

Dr = (dimK V1 )(dimK V2 ) · · · (dimK Vr ) verschiedene r-Tupel von Basisvektoren der einzelnen Vi . Also ist

die Dimension des Raumes der r-Linearformen gleich Dr .

(ii)

Halten wir zuallererst fest, dass ϕ das Vorzeichen wechseln muss, wenn zwei seiner Argumente vertauscht

werden. Dies folgt mit der gleichen Argumentation wie bei der Determinante.

Sei nun B := {ei }ri=1 eine geordnete Basis von V . Sei

ϕB := ϕ(e1 , e2 , . . . , er ) ∈ K .

Man sieht nun, dass die alternierende Linearform ϕ schon durch das ϕB ∈ K eindeutig festgelegt ist. Denn

um ϕ(v, w, . . .) zu berechnen entwickeln wir alle Argumente in der Basis B , ziehen mittels Multilinearität alle Entwicklungskoeffizienten aus ϕ(. . .) heraus. Alle Terme in denen mindestens ein Basisvektor

doppelt vorkommt verschwinden; wir ordnen ordnen die verbleibenden Basisvektoren (mittels der alternierenden Eigenschaft) in aufsteigender Reihenfolge. Also sind alle verbleibenden Terme proportional zu

ϕB . (Dieses Argument sollte mit dem Beweis von Satz 3.3.6 der Vorlesung verglichen werden!)

Zu jeder Wahl von ϕB ∈ K gibt es also genau eine alternierende dimK V -Linearform. Diese bilden daher

einen eindimensionalen Vektorraum.

(iii)

Man prüft leicht, dass die linke Seite der Gleichung, als Funktion der vi , selbst eine alternierende dimK V Linearform ist.

Die Aussage folgt dann aus der Tatsache, dass der Raum dieser Formen eindimensional ist.

(iv) Aus der definierenden Gleichung ϕ(Av1 , Av2 , . . . , Avr ) = d(A)ϕ(v1 , v2 , . . . , vr ), sowie aus den definierenden Eigenschaften von ϕ folgen direkt die drei Axiome der Determinantenabbildung: die Spaltenlinearität (D1) folgt aus der Multilinearität von ϕ, (D2) folgt, da ϕ alternierend sein soll, und die Normierung

(D3) ist offensichtlich.

Lösungen zu den Zusatzaufgaben

(a) Wir wenden die definierende Gleichung

ϕ(Av1 , Av2 , . . . , Avr ) = d(A)ϕ(v1 , v2 , . . . , vr )

zweimal hintereinander an.

(b) Sei A bijektiv; dann existiert ein Endomorphismus A−1 mit A◦A−1 = idV . Aus der ersten Zusatzaufgabe

folgt d(A) · d(A−1 ) = 1, so dass d(A) 6= 0 gelten muss.

Ist A nicht bijektiv, so ist A auch nicht injektiv. Also existiert v1 ∈ V, v1 6= 0 mit Av1 = 0. Ergänze v1

zu einer Basis {v1 , . . . vn } von V . Es folgt für eine nicht-verschwindende alternierende Multilinearform

ϕ(v1 , v2 , . . . , vr ) 6= 0, aber ϕ(Av1 , Av2 , . . . , Avr ) = 0 auf Grund der Linearität im ersten Argument. Somit

muss d(A) = 0 gelten.

Den Abgabeschluß der multiple choice Aufgaben sehen Sie oben auf dem Blatt. Die schriftlichen Aufgaben

werden in der Übungsgruppe am Montag, dem 28. April, abgegeben.

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

1,

1,

1,

1,

1,

1,

1,

1,

1,

1,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

4,

4,

5,

5,

Var

Var

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

1:

2:

1:

2:

[’2’]

[’2’]

[’2’]

[’2’]

[’1’]

[’1’]

[’n’]

[’n’]

[’n’]

[’n-1’]

Ex

Ex

Ex

Ex

Ex

Ex

2,

2,

2,

2,

2,

2,

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Nein’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

3,

3,

3,

3,

3,

3,

3,

3,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

2,

2,

3,

3,

4,

4,

5,

Var

Var

Var

Var

Var

Var

Var

Var

1:

1:

2:

1:

2:

1:

2:

1:

[’Ja’]

[’Ja’]

[’Nein’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Nein’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

4,

4,

4,

4,

4,

4,

4,

4,

4,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

4,

4,

5,

5,

Var

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

1:

2:

1:

2:

[’Ja’]

[’Nein’]

[’Nein’]

[’Ja’]

[’Ja’]

[’Ja’]

[’Nein’]

[’Nein’]

[’Ja’]

Übungsblatt 5

zur Vorlesung Lineare Algebra und Analytische Geometrie II im Sommersemester 2008

Christoph Schweigert

Erstellt am 05.05.2008, 16:28 Uhr für Matrikelnummer CHECKING ALL VARIANTS. Abgabezeitpunkt ist

05.05.2008, 08:00 Uhr.

1

Berechnen Sie das Signum der folgenden Permutationen.

Lösung: Wir führen die obere Zeile in die untere durch eine Folge von Vertauschungen benachbarter

Einträge aus. Jede solche Vertauschung traegt einen Faktor (−1) bei. Das Signum ist das Produkt all dieser

Faktoren, also +1 wenn wir insgesamt eine gerade Anzahl an Paarvertauschungen ausführen müssen, −1

bei einer ungeraden Zahl.

Sei zum Beispiel die Permutation

!

1 2 3 4 5 6 7 8 9 10 11 12

5 7 10 2 3 11 12 8 6 4 9 1

betrachtet.

Im diesem Fall bewegen wir z.B. zuerst die 1 an die letzte Stelle. Dazu müssen wir an der 2, der 3, der

4, usw., bis schließlich an der 12 vorbei. Das sind insgesamt 11 Vertauschungen, liefert also einen Faktor

−1.

Als nächstes müssen wir die 9 an the vorletzte Stelle bringen. Dazu müssen wir an 10, 11 und 12 vorbei.

Es gibt also wieder einen Faktor -1.

Auf diese Weise fährt man fort.

Für zyklische Permutationen ist allgemein das Signum von

!

1 ... n−1 n

2 ...

n

1

1

2

3

4

gegeben durch (−1)n .

!

1 2 3

2 3 1

!

1 2 3

3 1 2

!

1 2 3 4

2 3 4 1

!

1 2 3 4

4 1 2 3

!

1 2 3 4 5

2 3 4 5 1

!

1 2 3 4 5

5 1 2 3 4

1 2 3 4 5 6 7 8 9 10 11 12

5 4 6 3 11 9 1 10 8 2 12 7

+1 / -1

+1 / -1

+1 / -1

+1 / -1

+1 / -1

+1 / -1

!

+1 / -1

2

!

1 2 3 4 5 6 7 8 9 10 11 12

+1 / -1

4 2 10 3 12 1 5 8 7 9 6 11

sin(2θ)

cos(θ) − sin(θ)

Es sei Sθ = cos(2θ)

eine

Spiegelungsmatrix

und

D

=

eine Drehmatrix. Wir

θ

sin(2θ) − cos(2θ)

sin(θ) cos(θ)

können diese Matrizen entweder als Elemente in M(2 × 2, R) oder in M(2 × 2, C) auffassen. Prüfen Sie

die folgenden Aussagen für allgemeines θ.

Lösung:

Das charakteristische Polynom von Sθ ist

(λ − cos(2θ))(λ + cos(2θ)) − (sin(2θ))2 = λ2 − 1 = (λ − 1)(λ + 1) .

Die Eigenwerte sind also λ = 1und λ = −1. Man prüft leicht,

dass die dazugehörigen Eigenräume die

cos θ

sin θ

Form Eig(Sθ , 1) = spanR ( sin θ ) und Eig(Sθ , −1) = spanR ( −cos

θ ) haben.

Das charakteristische Polynom von Dθ ist

(λ − cos θ)2 + (sin θ)2 = λ2 − 2 cos(θ)λ + 1 = (λ − cos θ + i sin θ)(λ − cos θ − i sin θ) .

Für allgemeine θ gibt es also nur über C Eigenwerte, nicht über R. Über C sind die Eigenwerte λ1,2 =

cos θ ± i sin θ. Dazu gehören die Eigenräume

1

Eig(Dθ , λ1,2 ) = spanC

.

∓i

1

2

3

4

5

3

1

Aufgefasst als Element von M(2 × 2, R) hat Sθ die Eigenwerte λ1 = +1, λ2 = Wahr / Falsch

−1.

Aufgefasst als Element von M(2 × 2, R) hat Sθ die Eigenwerte λ1 = cos(θ), Wahr / Falsch

λ2 = sin(θ).

Aufgefasst als Element von M(2 × 2, C) hat Dθ rein reelle Eigenwerte.

Wahr / Falsch

Aufgefasst als Element von M(2 × 2, C) hat Dθ rein imaginäre Eigenwerte.

Wahr / Falsch

Aufgefasst als Element von M(2 × 2, C) hat Dθ die Eigenwerte λ1 = cos(θ),

λ2 = sin(θ)

Wahr / Falsch

Aufgefasst als Element von M(2 × 2, C) hat Dθ die Eigenwerte λ1,2 = cos(θ) ±

i sin(θ).

cos(θ)

spanR sin(θ) ist ein Eigenraum von Sθ ∈ M(2 × 2, R).

sin(θ)

spanR cos(θ)

ist ein Eigenraum von Sθ ∈ M(2 × 2, R).

spanC 1i ist ein Eigenraum von Dθ ∈ M(2 × 2, C).

spanC 1i ist ein Eigenraum von Dθ ∈ M(2 × 2, C).

Wahr / Falsch

Wahr / Falsch

Wahr / Falsch

Wahr / Falsch

Wahr / Falsch

Es sei K ein Körper, V ein n-dimensionaler K-Vektorraum (1 ≤ n < ∞) und ϕ ∈ End V .

Ist 1 einziger Eigenwert von ϕ, so ist ϕ = idV .

Lösung:

Gegenbeispiel:

!

1 1

.

0 1

Ja / Nein

2

3

4

5

4

Ist 0 einziger Eigenwert von ϕ, so ist ϕ = 0.

Lösung:

Gegenbeispiel:

!

0 1

.

0 0

Ja / Nein

Es gibt a ∈ K, das nicht Eigenwert irgendeines Endomorphismus von V ist.

Lösung:

Nein, a ist Eigenwert von a · Id.

Es gibt einen Vektor v ∈ V ungleich Null, der für keinen Endomorphismus von

V ein Eigenvektor ist.

Lösung:

Nein, jedes v ungleich Null ist Eigenvektor der Identitätsabbildung.

Ja / Nein

ϕ hat mindestens einen Eigenwert.

Lösung:

Gegenbeispiel: allgemeine Drehmatrix im R2 .

Ist ϕ nicht invertierbar, so hat ϕ mindestens einen Eigenwert.

Lösung:

Wenn der Kern nicht verschwindet, gibt es Eigenvektoren zum Eigenwert 0.

Ist ϕ nicht invertierbar, so hat ϕ nur einen Eigenwert.

Lösung:

Gegenbeispiel:

1 0 0

0 2 0 .

0 0 0

Ja / Nein

Die Summe von zwei Eigenvektoren von ϕ ist stets auch ein Eigenvektor von ϕ.

Lösung:

Nur wenn die Eigenwerte übereinstimmen.

Die Summe von zwei Eigenvektoren zu verschiedenen Eigenwerten ist kein Eigenvektor von ϕ.

Lösung:

Klar.

Ist ϕ2 = ϕ und ϕ 6= idV , so hat ϕ genau zwei Eigenwerte.

Lösung:

Gegenbeispiel: die Nullabbildung.

Ist ϕ3 = ϕ und ϕ 6= idV , so hat ϕ genau drei Eigenwerte.

Lösung:

Gegenbeispiel: die Nullabbildung.

Ja / Nein

Ja / Nein

Ja / Nein

Ja / Nein

Ja / Nein

Ja / Nein

Ja / Nein

Es sei K ein Körper, V ein endlich-dimensionaler Vektorraum und ϕ : V → V ein Endomorphismus von V .

Sind die folgenden Aussagen über Eigenvektoren richtig?

1

2

3

4

Wenn die Dimension von V gleich n ≥ 2 ist und ein linear unabhängiges (n − 1)- Ja / Nein

Tupel (v1 , . . . , vn−1 ) von Eigenvektoren von ϕ existiert, dann gibt es auch ein

linear unabhängiges n-Tupel (v1 , . . . , vn ) von Eigenvektoren von ϕ.

Lösung:

Gegenbeispiel

!

1 1

0 1

Wenn die Dimension von V mindestens 2 ist und ϕ einen Eigenvektor besitzt,

dann hat ϕ mindestens 2 linear unabhängige Eigenvektoren.

Lösung:

Gegenbeispiel

!

1 1

0 1

Ja / Nein

Der Endomorphismus ϕ hat mindestens einen Eigenvektor.

Lösung:

Gegenbeispiel: nichttriviale 2 × 2 Drehmatrix über R.

Es gibt einen Endomorphismus ϕ, der keinen Eigenvektor besitzt.

Lösung:

Beispiel: nichttriviale 2 × 2 Drehmatrix über R.

Ja / Nein

Ja / Nein

Die Summe zweier Eigenvektoren von ϕ zu verschiedenen Eigenwerten ist ein Ja / Nein

Eigenvektor von ϕ.

Die Differenz zweier Eigenvektoren von ϕ zu verschiedenen Eigenwerten ist ein Ja / Nein

Eigenvektor von ϕ.

Jede nichtverschwindende Linearkombination von zwei Eigenvektoren von ϕ Ja / Nein

zum gleichen Eigenwert ist ein Eigenvektor.

Die Summe zweier Eigenvektoren von ϕ zum gleichen Eigenwert ist entweder Ja / Nein

der Nullvektor oder ein Eigenvektor.

Die folgenden Aufgaben sind schriftlich zu bearbeiten.

5

(5 Punkte) Sei K ein nicht notwendigerweise kommutativer Ring mit Eins. Sei darüber hinaus die Abbildung

M(2 × 2, K) −→ K

!

a b

7→ ad − bc

c d

eine Determinantenabbildung. Zeigen Sie, dass aus der Existenz der Determinantenabbildung folgt, dass

K kommutativ ist.

Lösung:

Seien a, b ∈ K beliebig. Unter Verwendung der definierenden Eigenschaften von Determinantenabbildungen können wir die folgenden Umformungen vornehmen:

!

!

!

!

!

1 0

1 0

a 0

a 0

1 0

ab = ab det

= a det

= det

= b det

= ba det

= ba .

0 1

0 b

0 b

0 1

0 1

6

Die Fibonacci-Folge (an )n∈N ist definiert durch die zwei Anfangswerte

a0 = 0

a1 = 1

und die Rekursionsformel

an+2 = an+1 + an .

Da die Rekursionsvorschrift linear ist, kann man Vektoren

vn :=

an+1

an

!

einführen und die Rekursionsvorschrift durch eine Matrix A beschreiben:

vk+1 = A · vk .

1. (5 Punkte) Bestimmen Sie die Matrix A und finden Sie deren Eigenwerte und Eigenvektoren.

2. (10 Punkte) Diagonalisieren Sie die Matrix A. Betrachten Sie mit Hilfe der diagonalisierten Matrix

die zweite Komponente von vn und geben Sie eine explizite Formel für ak als Funktion von k an.

Lösung:

Offenbar ist

A=

1 1

1 0

!

.

Das gesuchte Element ak ist die zweite Komponente des Vektors vk = Ak · v0 = Ak ·

1

0

!

, also der

Eintrag (Ak )21 der Matrix Ak .

Das charakteristische Polynom von A lautet χA (λ) = λ2 − λ − 1. Dessen Nullstellen, und damit die Ei!

√

√

1

genwerte von A, sind λ1 = 1+2 5 und λ2 = 1−2 5 zu den Eigenräumen Eig(A, λ1 ) = spanR

λ1 − 1

!

1

und Eig(A, λ2 ) = spanR

. Eine Transformationsmatrix auf eine Eigenbasis ist also S−1 =

λ2 − 1

!

!

1

1

λ

−

1

−1

2

1

. Deren Inverse berechnet sich zu S = λ2 −λ

. Es gilt

1

λ1 − 1 λ2 − 1

1 − λ1 1

Ak = S−1

λk1

0

0

λk2

!

S.

Den linken unteren Eintrag dieser Matrix berechnet man leicht zu

ak =

λk1 − λk2

√

.

5

7

Sei K ein Körper. Wir betrachten die Menge Abb(N0 , K) der Abbildungen von N0 nach K. Für f , g ∈

Abb(N0 , K) und a ∈ K definieren wir:

f + g : N0 −→ K, n 7→ f (n) + g(n)

a · f : N0 −→ K, n →

7 a f (n)

Wir bezeichnen mit Abb0 (N0 , K) die Teilmenge der Abbildungen f ∈ Abb(N0 , K), für die es nur endlich

viele n ∈ N0 mit f (n) 6= 0 gibt.

Schließlich definieren wir für f , g ∈ Abb(N0 , K) die Verknüpfung f ◦ g ∈ Abb(N0 , K), so dass für n ∈ N0

gilt ( f ◦ g)(n) = ∑a,b∈N0 ,a+b=n f (a)g(b).

(i) (5 Punkte) Zeigen Sie, dass Abb(N0 , K) mit der oben angegebenen Addition und Skalarmultiplikation ein K-Vektorraum ist.

(ii) (5 Punkte) Zeigen Sie, dass Abb0 (N0 , K) ein Untervektorraum von Abb(N0 , K) ist, der nicht von

endlich vielen Elementen erzeugt wird.

(iii) (5 Punkte) Zeigen Sie, dass ◦ ein assoziatives Produkt auf Abb(N0 , K) definiert. Für welches Element, das wir mit X 0 bezeichnen wollen, gilt X 0 ◦ f = f für alle f ∈ Abb(N0 , K)?

(iv) (5 Punkte) Sei X : N0 −→ K die Abbildung mit 1 7→ 1 und n 7→ 0 für n 6= 1. Wir definieren X i ∈

Abb(N0 , K) rekursiv als X i−1 ◦ X für i > 0. Zeigen Sie, dass jedes f ∈ Abb0 (N0 , K) eine eindeutige

Linearkombination von (X 0 , X 1 , . . . , X n ) für ein geeignetes n ∈ N0 ist, wobei X 0 das Element aus

Teil (iii) ist.

(v) (5 Punkte) Zeigen Sie, dass Abb0 (N0 , K) ein kommutativer Ring mit Eins ist.

(vi) (5 Punkte) Zeigen Sie, dass dieser Ring ein Polynomring über K in der Unbestimmten X aus Teilaufgabe (iv) ist.

8

Sei K ein Körper und V ein K-Vektorraum und seien φ, ψ ∈ End(V ). Zeigen Sie:

(a) (5 Punkte) Ist v ∈ V Eigenvektor von φ ◦ ψ zum Eigenwert λ, und ist ψ(v) 6= 0, so ist ψ(v) Eigenvektor

von ψ ◦ φ zum Eigenwert λ.

(b) (5 Punkte) Ist V endlich-dimensional, so haben φ ◦ ψ und ψ ◦ φ die gleichen Eigenwerte.

(c) (5 Punkte) Haben φ ◦ ψ und ψ ◦ φ auch die gleichen Eigenvektoren? Geben Sie einen Beweis oder ein

Gegenbeispiel.

Lösung:

(a) Wir rechnen unter Benutzung von Assoziativität der Komposition von Abbildungen:

ψ ◦ φ(ψ(v)) = ψ((φ ◦ ψ)(v)) = ψ(λv) = λψ(v)

Also ist ψ(v) Eigenvektor zum Eigenwert λ.

(b) Wir zeigen, dass alle Eigenwerte von φ ◦ ψ auch Eigenwerte von ψ ◦ φ sind. Die Aussage folgt dann

daraus, dass die betrachtete Situation symmetrisch ist.

Sei λ ein Eigenwert von φ ◦ ψ mit Eigenvektor v. Ist ψ(v) 6= 0, so folgt mit (a), dass λ auch Eigenwert von

ψ ◦ φ ist. Sei nun ψ(v) = 0, also v ∈ ker ψ. Dann ist auch λ = 0. Wir müssen also nur zeigen, dass ψ ◦ φ

nichttrivialen Kern hat. Da 0 ein Eigenwert von φ ◦ φ ist, ist

0 = det(φ ◦ ψ) = det φ det ψ = det ψ det φ = det(ψ ◦ φ)

Also hat auch ψ ◦ φ nichtverschwindenden Kern.

(c) Gegenbeispiel: Betrachten Sie R2 und die Matrizen

!

1 1

,

B=

A=

0 0

1

1

0 −1

!

Dann haben AB und BA verschiedene Eigenvektoren.

Den Abgabeschluß der multiple choice Aufgaben sehen Sie oben auf dem Blatt. Die schriftlichen Aufgaben

werden in der Übungsgruppe am Montag, dem 5. Mai, abgegeben.

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

1,

1,

1,

1,

1,

1,

1,

1,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

4,

4,

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

1:

2:

[’+1’]

[’+1’]

[’-1’]

[’-1’]

[’+1’]

[’+1’]

[’+1’]

[’-1’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

2,

2,

2,

2,

2,

2,

2,

2,

2,

2,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

4,

4,

5,

5,

Var

Var

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

1:

2:

1:

2:

[’Wahr’]

[’Falsch’]

[’Falsch’]

[’Falsch’]

[’Falsch’]

[’Wahr’]

[’Wahr’]

[’Falsch’]

[’Wahr’]

[’Wahr’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

3,

3,

3,

3,

3,

3,

3,

3,

3,

3,

3,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

3,

4,

4,

5,

5,

Var

Var

Var

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

3:

1:

2:

1:

2:

[’Nein’]

[’Nein’]

[’Nein’]

[’Nein’]

[’Nein’]

[’Ja’]

[’Nein’]

[’Nein’]

[’Ja’]

[’Nein’]

[’Nein’]

Ex

Ex

Ex

Ex

Ex

Ex

Ex

Ex

4,

4,

4,

4,

4,

4,

4,

4,

Qu

Qu

Qu

Qu

Qu

Qu

Qu

Qu

1,

1,

2,

2,

3,

3,

4,

4,

Var

Var

Var

Var

Var

Var

Var

Var

1:

2:

1:

2:

1:

2:

1:

2:

[’Nein’]

[’Nein’]

[’Nein’]

[’Ja’]

[’Nein’]

[’Nein’]

[’Ja’]

[’Ja’]

Übungsblatt 6

zur Vorlesung Lineare Algebra und Analytische Geometrie II im Sommersemester 2008

Christoph Schweigert

Erstellt am 29.05.2008, 13:42 Uhr für Matrikelnummer CHECKING ALL VARIANTS. Abgabezeitpunkt ist

26.05.2008, 08:00 Uhr.

1

1

Seien K ein Körper und V ein K-Vektorraum, ϕ ∈ End V und 1 ≤ dim V = n < ∞. Sind die folgenden

Aussagen wahr?

Für jedes a ∈ K gibt es einen Endomorphismus von V mit Eigenwert a.

Ja / Nein

Lösung: Ja. Z.B. das a-fache der Identität.

Es gibt ein Element a ∈ K, das nicht Eigenwert eines Endomorphismus von V

ist.

Ja / Nein

Lösung: Nein. Der Eigenwert des a-fachen der Identität ist a.

2

ϕ hat höchstens n verschiedene Eigenwerte.

Ja / Nein

Lösung: Ja. Eigenvektoren zu unterschiedlichen Eigenwerten sind linear unabhängig. Es gibt aber höchstens n linear unabhängige Vektoren in einem Vektorraum der Dimension n.

ϕ hat stets n verschiedene Eigenwerte.

Ja / Nein

Lösung: Nein. Gegenbeispiel: die Identitätsabbildung.

3

Die Summe der geometrischen Vielfachheiten aller Eigenwerte von ϕ ist stets n. Ja / Nein

!

0 1

Lösung: Nein. Gegenbeispiel:

.

0 0

Die Summe der geometrischen Vielfachheiten aller Eigenwerte von ϕ ist stets Ja / Nein

von Null verschieden.

Lösung: Nein. Gegenbeispiel: Die allgemeine Drehmatrix hat gar keine (rellen)

Eigenwerte.

4

Falls K = R und n = 5 ist, so hat ϕ einen Eigenwert.

Lösung: Ja. Das folgt aus dem Zwischenwertsatz der Analysis. Relle polynomiale Funktionen von ungeradem Grad nehmen notwendigerweise sowohl positive als auch negative Werte an. Daher müssen Sie auch den Wert Null annehmen. Insbesondere hat das charakteristische Polynom von ϕ also eine Nullstelle.

Aus dem Fundamentalsatz der Algebra folgt genauer, dass reelle Polynome vom

Grad 5 genau eine, drei oder aber fünf reelle Nullstellen haben. Der Satz besagt, dass jedes Polynom in C[X], damit auch das charakteristische Polynom, in