Big-Data-Technologien machen das Notwendige möglich

Werbung

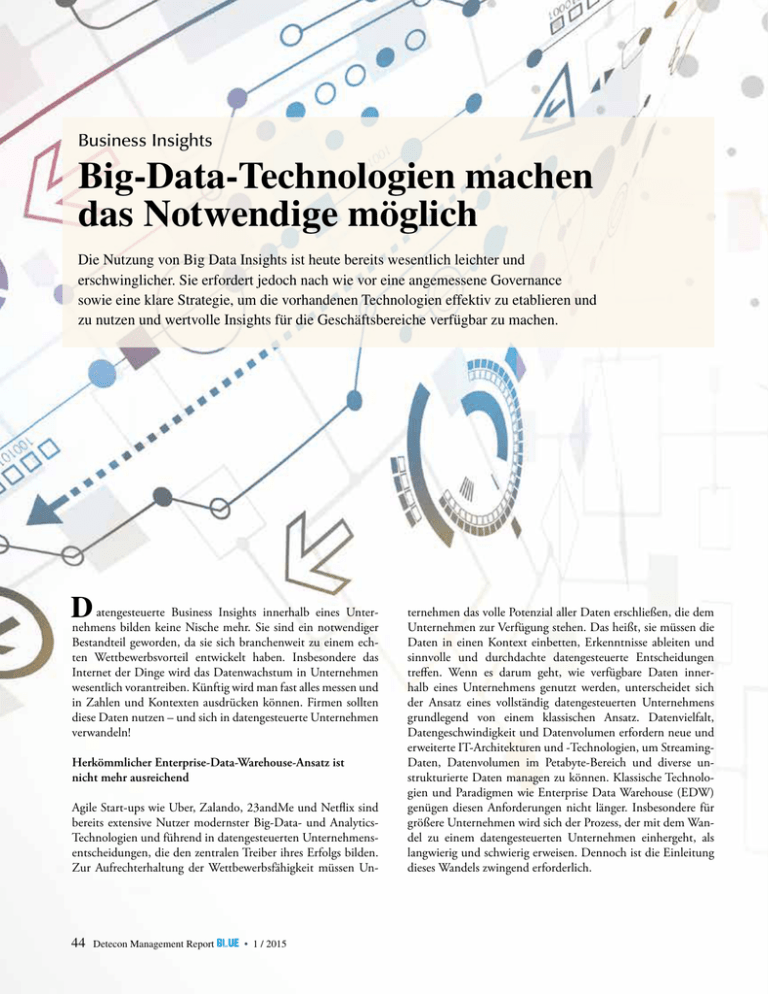

Business Insights Big-Data-Technologien machen das Notwendige möglich Die Nutzung von Big Data Insights ist heute bereits wesentlich leichter und ­erschwinglicher. Sie erfordert jedoch nach wie vor eine angemessene Governa­nce ­sowie eine klare Strategie, um die vorhandenen Technologien effektiv zu etablieren und zu nutzen und wertvolle Insights für die Geschäftsbereiche verfügbar zu machen. atengesteuerte Business Insights innerhalb eines UnterD nehmens bilden keine Nische mehr. Sie sind ein notwendiger ­ estandteil geworden, da sie sich branchenweit zu einem echB ten Wettbewerbsvorteil entwickelt haben. Insbesondere das Internet der Dinge wird das Datenwachstum in Unternehmen ­wesentlich vorantreiben. Künftig wird man fast alles messen und in Zahlen und Kontexten ausdrücken können. Firmen sollten diese Daten nutzen – und sich in datengesteuerte Unternehmen verwandeln! Herkömmlicher Enterprise-Data-Warehouse-Ansatz ist nicht mehr ausreichend Agile Start-ups wie Uber, Zalando, 23andMe und Netflix sind bereits extensive Nutzer modernster Big-Data- und AnalyticsTechnologien und führend in datengesteuerten Unternehmens­ entscheidungen, die den zentralen Treiber ihres Erfolgs bilden. Zur Aufrechterhaltung der Wettbewerbsfähigkeit müssen Un- 44 Detecon Management Report blue • 1 / 2015 ternehmen das volle Potenzial aller Daten erschließen, die dem Unternehmen zur Verfügung stehen. Das heißt, sie m ­ üssen die Daten in einen Kontext einbetten, Erkenntnisse ableiten und sinnvolle und durchdachte datengesteuerte Entscheidungen treffen. Wenn es darum geht, wie verfügbare Daten innerhalb eines Unternehmens genutzt werden, unterscheidet sich der Ansatz eines vollständig datengesteuerten Unternehmens grundlegend von einem klassischen Ansatz. Datenvielfalt, ­Datengeschwindigkeit und Datenvolumen erfordern neue und erweiterte IT-Architekturen und -Technologien, um StreamingDaten, Datenvolumen im Petabyte-Bereich und diverse unstrukturierte Daten managen zu können. Klassische Technologien und Paradigmen wie Enterprise Data Warehouse (EDW) genügen diesen Anforderungen nicht länger. Insbesondere für größere Unternehmen wird sich der Prozess, der mit dem Wandel zu einem datengesteuerten Unternehmen einhergeht, als langwierig und schwierig erweisen. Dennoch ist die Einleitung dieses Wandels zwingend erforderlich. Seit Jahrzehnten errichten Unternehmen Reporting-Architekturen auf klassische Weise, und zwar unter Verwendung von zwei Arten von Datenquellen: Betriebsdaten aus ­ Systemen wie Enterprise Resource Planning (ERP) und Customer ­Relationship Management (CRM) sowie aus dem zentralen Enterprise Data Warehouse (EDW). Sämtliche Daten sind in herkömmlichen relationalen Datenbanken strukturiert, Analytics sind primär als vordefiniertes Reporting konfiguriert. Adhoc-Analysen können nur mit den vom Data Warehouse – oder Data Marts und Analytics Cubes – gelieferten Daten durchgeführt werden. Weiterhin ist die Durchführung von Advanced ­Analytics mit den zur Verfügung stehenden Datenstrukturen und Softwareprogrammen kaum möglich. Unternehmen nutzen spezielle Infrastrukturkomponenten, die im Hinblick auf künftige Bedürfnisse kaum skalierbar sind. Die Kosten für diese Art Infrastruktur sind hoch, denn aufgrund teurer Lizenzen und spezieller Infrastrukturkomponenten werden die Kosten für die Errichtung eines Enterprise Data Warehouse gewöhnlich mit mindestens einer Million US-Dollar veranschlagt. Tatsächlich wird dabei nur ein Bruchteil der erzeugten Unternehmensdaten für das Treffen durchdachter Entscheidungen genutzt. Und dennoch hat sich die klassische Data-Warehouse-Architektur nicht überlebt – sie muss mit weiterentwickelten Technologien ergänzt werden, um die Anforderungen der Zukunft erfüllen zu können. Big-Data-Architektur erhöht Gesamtkomplexität Unter dem Dach von Big Data haben sich in den vergangenen zehn Jahren mehrere neue Technologien herausgebildet. Diese Technologien ermöglichen Unternehmen eine verteilte Datenhaltung und Datenanalyse sowie die Identifizierung von Mustern, Trends und sonstigen Insights. Zusätzlich zu herkömmlichen vordefinierten Reports und ­Ad-hoc-Analytics, Statistical und Predictive Analytics wurden maschinelles Lernen, Graph Analytics und operative Intelligenz möglich. Dies wiederum erlaubte den Unternehmen nicht nur die Durchführung von historischen Analysen und rückwärtsgerichtetem Reporting, sondern auch den Blick nach vorn und damit die Vorhersage von Business Insights – eine aktive Unterstützung für künftige Entscheidungen! Die Big-Data-Technologien lassen sich in die sechs unterschiedlichen Schwerpunktbereiche Datenspeicherung, Datenintegration, Analytical Processing, Visualisierung und Daten-­ Governance gruppieren, in denen spezielle Technologien genutzt werden (siehe Abbildung). Die neue Big-Data-Architektur ergänzt die traditionellen Systeme, erhöht aber gleichzeitig die Gesamtkomplexität. Es sind Abbildung: Vereinfachter Big Data Stack Datenintegration Visualisierung EchtzeitIntelligenz Erweiterte Visualisierung Dashboard Datenkonnektivität Datensicherheit und Daten-Governace Identitätsmanagement Analytical Processing Data Ingestion Video Audio Georäumlich Web Textsemantik Datenverschlüsselung Prädiktiv Data Mining Maschinelles Lernen Reporting Mandantenfähigkeit (Multitenancy) Governance Datenzugriff BatchVerarbeitung Streaming und Verarbeitung Suchen und Finden Anfrage Datenspeicherung Hadoop HDFS NoSQL Datenbanken In-Memory Datenbanken Analytische Datenbanken Transaktionsdatenbanken Quelle: Detecon 45 Detecon Management Report blue • 1 / 2015 diverse spezielle Systeme erforderlich, um die unterschiedlichen Anforderungen und Methoden handhaben zu können. Insbesondere für das Internet der Dinge, M2M und Sensordaten ist die Anwendung von In-Memory- und Streaming-Datenbanken unverzichtbar, da die für die Daten erforderliche Echtzeitverarbeitung und Analyse mittels herkömmlicher Systeme nicht geleistet werden kann. Hadoop wird als zentrale Technologie für Big Data oft falsch verstanden Hadoop hat einen regelrechten Hype erfahren. Das bedeutet jedoch nicht, dass Hadoop wirklich von jedem Unternehmen verstanden wird. Bei Hadoop handelt es sich nicht um eine einzige Technologie, sondern um ein ganzes Framework, das aus vielen unterschiedlichen Technologien fast den gesamten Big Data Stack zusammenfasst. Die Hadoop-Technologien sind Open Source Software unter der Apache-Lizenz und w ­ urden in ihrem Kern zuerst als Teil eines von Yahoo gestarteten Forschungsprojekts entwickelt. Die wichtigsten Bestandteile von Hadoop sind Hadoop Common (Shared Library), Hadoop HDFS (verteilte Datenhaltung), Hadoop MapReduce (­ Datenverarbeitung), Pig (Datenmanipulation), Hive (Data Warehouse) und HBase (Bigtable NoSQL-Datenbank). Das Hadoop Distributed File System (HDFS) löste eines der Hauptprobleme traditioneller relationaler Enterprise Data Warehouses: Es kann unstrukturierte Daten aus unterschiedlichsten Quellen speichern und die Gesamtheit der gespeicherten Daten über verteilte Standardsysteme – zum Beispiel x86-Architekturen – auf Tausenden von kostengünstigen Servern verteilen. Die Nutzung von HDFS ermöglicht eine kostengünstige Speicherung von ­Datenvolumen im Terabyte-Bereich und ist in der Regel etwa 20 Mal preiswerter als spezialisierte BI-Systeme. Darüber ­hinaus ist HDFS hoch skalierbar, sodass neue Server der verteilten Infrastruktur einfach hinzugefügt werden können und historische Daten nicht mehr ausgelagert werden müssen, wie es bei EDW-Systemen häufig der Fall ist. Die Hadoop-Komponente MapReduce wird zur Koordinierung und Programmierung von Batch-Verarbeitungsjobs verwendet, um Daten zu laden, zu verarbeiten und zu analysieren. MapReduce basiert nicht auf der Datenbanksprache SQL (Structured Query Language), sondern nutzt im Vergleich zu der weit verbreiteten SQL ein komplexeres Programmiermodell und Paradigma. Um die Datenabfragen und Datenverarbeitung zu erleichtern, versuchen viele Anbieter, zusätzliche SQL-Layer auf MapReduce aufzusetzen. Für Unternehmen, die gewaltige Datenvolumen, Datenvielfalt 46 Detecon Management Report blue • 1 / 2015 und Datengeschwindigkeit handhaben müssen, kann Hadoop als zugrunde liegender Enabler für Big Data Insights betrachtet werden. Hadoop ist jedoch keine Lösung für alle Big-DataHerausforderungen, und Unternehmen, insbesondere, wenn es sich um kleine Unternehmen handelt, sollten sorgfältig prüfen, ob ihnen nicht gegebenenfalls bestehende traditionelle Ansätze dabei helfen können, ihren Bedarf an Daten-Insights zu befriedigen. Kommerzielle Hadoop-Anbieter haben bis Mitte 2014 eine Risikokapitalfinanzierung in Höhe von mehr als anderthalb Milliarden US-Dollar erhalten, wodurch das enorme Wachstum der Hadoop-basierten Technologielösungen gefördert wurde. Innerhalb des Hadoop-Marktes haben sich dabei vier große Anbieter als deutliche Marktführer positioniert: Hortonworks, MapR Technologies, Cloudera und IBM. Diese Unternehmen haben es geschafft, das Open Source Framework mit zusätzlichen Services und klaren Geschäftsmodellen anzureichern. Sie bieten zum Beispiel professionelle Services für Implementierungs-Support, Enterprise-Grade-Support und Release-Zyklen sowie weitere (Analytics) Funktionen. Analytics-Lösungen und industriespezifische Anwendungen Hadoop und NoSQL-Datenbanken fördern die unternehmensweite Nutzung unterschiedlicher Datenquellen und ermög­ lichen daher eine einzige Schnittstelle für Business Analytics für vielfach strukturierte Daten. In erster Linie geht es hier jedoch nicht um die Technologie, sondern um den geschäftlichen Nutzen und die Nutzung der Insights für Entscheidungsprozesse in Unternehmen. Relevante Analytics und deren Anwendung innerhalb der Geschäftsbereiche sind ausschlaggebend, nicht die technologischen Lösungen. Vorausschauende AnalyticsModelle werden von vielen Branchenteilnehmern genutzt, um Angebot und Nachfrage angemessen abschätzen zu können. Branchen wie Telekommunikation, Finanzdienstleistungen und Einzelhandel agieren bei der Nutzung der Daten stärker vorausschauend. Visualisierung ist für Unternehmen wichtig, die ­ regelmäßig massive Datenvolumen erzeugen. Moderne ­Visualisierungstools sind zur Identifizierung von Mustern unverzichtbar und bewirken stärker durchdachte Entscheidungen. Insbesondere im Bereich der Visualisierung haben diverse innovative Unternehmen in den letzten Jahren neue Lösungen auf den Markt gebracht. Tableau und Quid sind Beispiele für die erfolgreiche Positionierung neuer Visualisierungslösungen, um Muster und Verbindungen zu identifizieren, Insights zu veranschaulichen oder ganze Marktlandschaften abzubilden. Die Verbesserung der Rechenleistung für Analytics und die Ge- schwindigkeit von Datenströmen führen dazu, dass die Bedeutung von Echtzeit-Analytics zunimmt. Unternehmen wollen bei neuen Ereignissen mit der Analyse auf dem Laufenden bleiben, um so die Durchführung ihrer Geschäftsprozesse optimieren zu können. SAP investiert seit einiger Zeit mit großem Aufwand in seine HANA-Lösungen für In-Memory-Datenverarbeitung mit der Zielsetzung, hiermit zentrale Enabler für Data Analytics in Echtzeit zu ermöglichen. Die steigende Komplexität der ITLandschaft erzeugt eine Menge an Log- und Maschinendaten, die es zu analysieren gilt. Unternehmen wie Splunk oder Sumo Logic haben sich diesen Bereich mit operativen Data Analytics erschlossen, die Insights über Ausfälle und IT-Probleme liefern und diese zeitweise sogar automatisch lösen können. Neuere Bereiche wie Text Analytics und Web & Social Analytics gewinnen ebenfalls an Bedeutung, da Unternehmen ihre Onlinepräsenz erweitern und Soziale Medien zunehmend an Akzeptanz gewinnen. Generische Analytics-Produkte ohne spezifische Branchenausrichtung sind der von Big-Data-Analytics-Anbietern am häufigsten genutzte Ansatz. Sie liefern den Unternehmen die ­passenden Tools, um Analytics-Lösungen an ihre Anforderungen anzupassen und somit ihre speziellen organisatorischen oder branchenspezifischen Herausforderungen meistern zu können. Für manche Industrien, zum Beispiel die Finanz­ industrie, ­haben Anbieter aufgrund sich wiederholender Probleme spezielle Lösungen entwickelt, um etwa Credit Scores innerhalb ­einer Sekunde zu analysieren oder Betrugsmuster zu identifizieren und Risiken zu vermeiden. Der Schwerpunkt der Lösungen für Retailer und E ­ -Commerce liegt auf prädiktiver und operativer­­Analytics, um Kundenverhalten vorhersagen zu können, sowie auf der Analyse operativer Daten, um effektiver agieren zu können. Telekommunikationsunternehmen stehen ebenfalls im Mittelpunkt, wenn es um die industriespezifische Nutzung geht. Prädiktive und operative Analytics werden insbesondere eingesetzt, um Kundenabwanderungen vorherzusagen, Zeitreihendaten und gewaltige Kundendatenmengen wie CDRs zu analysieren, operative Effizienz und Marketing-Insights zu erzielen oder gar Mobilfunkinfrastruktur auf Basis von Nutzerdaten oder durchschnittlicher Bandbreite zu planen. Weiterhin sind die visuelle Datenentdeckung (Data Discovery) und Mustererkennung für das Gesundheitswesen von großer Bedeutung. Stärker als andere Branchen setzt die Hightech- und Media-Branche ebenfalls auf Web und Social Analytics. Neue Delivery-Modelle bilden sich im Big-Data-Ecosystem heraus Um mit spezialisierten und innovativen Start-ups Schritt halten zu können, nehmen etablierte Hersteller wie Microsoft, IBM und Oracle Anpassungen an ihren Produktangeboten und -strategien vor. Diese setzen verstärkt auf M&A-Maßnahmen, um ihre Portfolios entsprechend der neu generierten Nachfrage zu ergänzen. Flexible Lizenzmodelle und Open-Source-Produkte wirken sich dabei ebenfalls auf die Einkaufsmuster von Unternehmen aus. Stark beeinflusst wird dies durch die zunehmende Nutzung der SaaS-Delivery-Modelle für Big-Data-Lösungen. Um einfache und schnelle Lösungen liefern zu können, offerieren viele Anbieter Out-of-the-Box-Lösungen ihrer Produkte, die Hosting, Datenverarbeitung und auch die Software selbst beinhalten können. Dieser Ansatz ist nicht ganz problemlos, kann Unternehmen jedoch dabei helfen, Analytics-Lösungen kostengünstiger, schneller und flexibler einzusetzen. Self-Service-Analytics-Lösungen für nicht technische Nutzer sind ­dabei ein zentraler Enabler für geschäftliche Nutzer, um Daten-Insights entsprechend ihren eigenen Bedürfnissen zu entdecken, zu analysieren und zu visualisieren. Hierbei sind insbesondere Advanced-Analytics-Lösungen sind von schwerfälligen, komplexen und umständlich zu nutzenden Tools hin zu Use-Casebasierten und intuitiven „Dashboards“ gereift. Die Nutzung von Big-Data-Insights stellt nach wie vor eine technologische und organisatorische Herausforderung dar Analytics-Lösungen und die zugrunde liegenden Technologien haben sich weiterentwickelt und sind während der vergangenen Jahre extrem gereift. Die effektive Nutzung von Big Data ist aber immer noch keine einfache Standard-Aufgabe. Anwendungsfälle und Business-Anforderungen müssen von den Unternehmensbereichen nach dem Top-down-Prinzip definiert werden. Bis heute erfordern die zugrunde liegenden Datenbanktechnologien ein hohes Maß an Anpassung und Implementierungsaufwand, damit diese Lösungen angemessen in die bestehenden IT-Architekturen integriert werden können. Lars Bodenheimer ist Senior Consultant und Experte für Strategie, Planung und Rollout neuer ICT-Produkte und Technologien sowie für eine Vielzahl von Themen im Bereich ICT-Migration. Er arbeitet mit Festnetz- und ­Mobilfunkbetreibern in Nord- und Südamerika und anderen Regionen weltweit. Kolja Schluetter arbeitet als Consultant bei Detecon Inc., USA, und ­unterstützt Klienten weltweit dabei, neue Technologien einzuführen und die Transformation in die digitale Geschäftswelt zu meistern. 47 Detecon Management Report blue • 1 / 2015