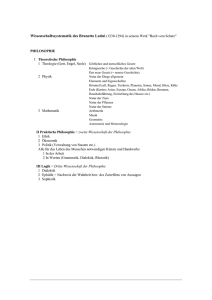

Buch: Wissenschaftliche Philosophie - Das Computer

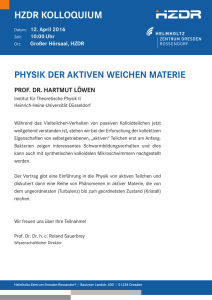

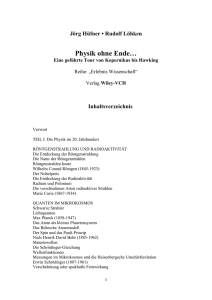

Werbung