Stochastik - Alexander Stoffel

Werbung

Materialien zur Vorlesung

Stochastik

Einführung in die Wahrscheinlichkeitsrechnung und Statistik

Alexander Stoffel

Institut für Nachrichtentechnik

Fakultät für Informations-, Medien- und Elektrotechnik

Fachhochschule Köln

4. Februar 2012

1

2

Einleitung

Dieses Skript ist nur für die Teilnehmer meiner Lehrveranstaltung konzipiert. Hierfür gilt

analog, was in der Einleitung zum Analysis-Skript gesagt wurde, das braucht also nicht

wiederholt zu werden. Für Hinweise auf Tippfehler und andere Unstimmigkeiten sowie

für Verbesserungsvorschläge bin ich sehr dankbar.

Noch eine Anmerkung zum Namen: Stochastik kommt vom griechischen Wort στ óχoς,

Vermutung, Kunst des Mutmaßens. Es bezeichnet das Gebiet der Wahrscheinlichkeitstheorie und der mathematischen Statistik. Diese Bezeichnungsweise ist aber eine Besonderheit des deutschen Sprachraums. Ein entsprechendes englisches Substantiv scheint zumindest außerordentlich wenig gebräuchlich zu sein, das Adjektiv stochastic wird vor allem

im Zusammenhang mit den speziellen Fachausdrücken stochastic process, stochastischer

Prozess und stochastic differential equation, stochastische Differentialgleichung, benutzt.

Beide dieser Fachausdrücke bezeichnen aber sehr spezielle Teilgebiete der (deutschen)

Stochastik. Das Thema dieses Skriptes und der zugehörigen Lehrveranstaltung wäre im

englischen probability and statistics“, was dem oben angegebenen Untertitel entspricht.

”

3

Hier die Literaturempfehlungen:

Literatur

[1] Dimitri P. Bertsekas and John N. Tsitsiklis. Introduction to Probability. Athena

Scientific, Belmont, Massachusetts, second edition edition, 2008.

[2] Karl Bosch. Elementare Einführung in die Wahrscheinlichkeitsrechnung. Vieweg,

Braunschweig, 5. Auflage, 1986.

[3] Karl Bosch. Elementare Einführung in die angewandte Statistik. Vieweg, Braunschweig, 4. Auflage, 1987.

[4] Norbert Henze. Stochastik für Einsteiger. Vieweg, Braunschweig/Wiesbaden, 1997.

[5] Alberto Leon-Garcia. Probability and Random Processes for Electrical Engineering.

Addison-Wesley, Reading, Massachusetts, second edition, 1994.

[6] Lothar Papula. Mathematik für Ingenieure und Naturwissenschaftler, Band 3, Vektoranalysis, Wahrscheinlichkeitsrechnung, Mathematische Statistik, Fehler- und Ausgleichsrechnung. Vieweg, Braunschweig/Wiesbaden, 1994.

[7] Sheldon M. Ross. Introduction to Probality and Statistics for Engineers and Scientists.

Elsevier Academic Press, Amsterdam, third edition, 2004.

[8] Volker Schmidt.

Wahrscheinlichkeitsrechnung.

Skript, Universität

Ulm,

Institut

für

Stochastik,

http://www.mathematik.uniulm.de/stochastik/lehre/ws06 07/wr/skript.pdf, 2006.

[9] Hubert Weber. Einführung in die Wahrscheinlichkeitsrechnung und Statistik für Ingenieure. Teubner, Stuttgart, 1992.

4

Inhaltsverzeichnis

1 Grundbegriffe

1.1 Beispiele, Zufallsexperimente, Ereignisse, Ergebnisraum

1.2 Wahrscheinlichkeitsmaß, Wahrscheinlichkeitsraum . . .

1.3 Laplace-Modelle, Kombinatorik . . . . . . . . . . . . .

1.4 Rechenregeln für Wahrscheinlichkeiten . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6

6

7

11

15

2 Bedingte Wahrscheinlichkeit und Unabhängigkeit

16

2.1 Definitionen und wichtige Folgerungen . . . . . . . . . . . . . . . . . . . . 16

2.2 Produktwahrscheinlichkeitsmaß . . . . . . . . . . . . . . . . . . . . . . . . 18

2.3 Anwendungen von bedingten Wahrscheinlichkeiten . . . . . . . . . . . . . . 20

3 Zufallsvariable

3.1 Beispiele, Verteilungsfunktion, Dichtefunktion . . . . . . . . . . . . . . . .

3.2 Erwartungswert und Varianz . . . . . . . . . . . . . . . . . . . . . . . . . .

3.3 Quantil und Median . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

24

24

36

42

4 Spezielle Verteilungen

4.1 Binomialverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2 Poissonverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3 Normalverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

44

46

47

5 Mehrere Zufallsvariable mit demselben Grundraum

51

5.1 Zwei Zufallsvariable mit demselben Grundraum . . . . . . . . . . . . . . . 51

5.2 Mehr als zwei Zufallsvariable auf demselben Grundraum . . . . . . . . . . 66

5.3 Summen von Zufallsvariablen, Grenzwertsatz . . . . . . . . . . . . . . . . . 70

6 Grundbegriffe der Statistik

6.1 Histogramm, Mittelwert, Stichprobenvarianz . . . . . .

6.2 Parameterschätzungen . . . . . . . . . . . . . . . . . .

6.3 Allgemeine Prinzipien zur Gewinnung von Schätzungen

6.4 Lineare Regression . . . . . . . . . . . . . . . . . . . .

6.5 Intervallschätzungen, Konfidenzintervalle . . . . . . . .

6.6 Tests von Hypothesen . . . . . . . . . . . . . . . . . .

7 Zufallszahlen, Simulation von Zufallsexperimenten

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

75

75

77

81

84

91

94

100

A Anhang: Mehrfachintegrale

103

A.1 Funktionen von 2 Variablen: Zweifachintegrale . . . . . . . . . . . . . . . . 103

A.2 Funktionen von 3 und mehr Variablen . . . . . . . . . . . . . . . . . . . . 112

5

1

Grundbegriffe

1.1

Beispiele, Zufallsexperimente, Ereignisse, Ergebnisraum

Beispiele für Zufallsexperimente:

• Werfen einer Münze

• Würfeln

• Ziehen der Lottozahlen

• Lebensdauer einer Glühbirne messen

• Übertragen eines Bits über eine unzuverlässige Übertragungsstrecke

Ein Zufallsexperiment ist durch folgende Eigenschaften gekennzeichnet:

• Die Bedingungen sind genau festgelegt (Ziehen der Lottozahlen!).

• Das Experiment ist vom Prinzip her beliebig oft wiederholbar.

• Es gibt mehrere unterscheidbare Elemente der Menge der Ergebnisse des Zufallsexperiments

• Die Ergebnisse sind nicht vorhersagbar.

Beachten Sie, dass hier gedanklich Annahmen gemacht und Näherungen vorgenommen

werden, die in der Praxis in voller Strenge nicht realisiert sind!

Definition 1.1.1 Die Menge der Ergebnisse eines Zufallsexperiments heißt Ergebnismenge, Ergebnisraum, Ereignisraum oder Grundraum und wird hier mit Ω bezeichnet.

Beispiele: Für den Würfel ist Ω = {1, 2, 3, 4, 5, 6}, für das Werfen einer Münze ist Ω =

{W, Z} (oder Ω = {0, 1}). Für die Lebensdauer einer Glühbirne ist Ω = R+ . Als Ereignis

möchte man zulassen, dass beispielsweise eine Zahl größer als 3 gewürfelt wurde. Man

definiert also

Definition 1.1.2 Ereignisse sind Teilmengen von Ω. Sie werden hier meist mit A, B,

C oder D bezeichnet. A = Ω ist das sichere Ereignis, ∅ ist das unmögliche Ereignis.

Elementarereignisse sind Ereignisse mit nur einem Element A = {ω} mit ω ∈ Ω.

Das Ereignis, eine Zahl größer als 3 zu würfeln, ist also A = {4, 5, 6}.

Zur Erinnerung:

A ∪ B := {ω ∈ Ω | ω ∈ A oder ω ∈ B}

A ∩ B := {ω ∈ Ω | ω ∈ A und ω ∈ B}

A \ B := {ω ∈ Ω | ω ∈ A und ω 6∈ B}

Beachten Sie, dass das oder“ bei der Bildung der Vereinigung im nicht ausschließlichen

”

Sinn gemeint ist. Also, wenn ω ∈ A und ω ∈ B, dann ist auch ω ∈ A ∪ B.

6

Definition 1.1.3 Zwei Ereignisse A und B heißen disjunkt, wenn A∩B = ∅. In diesem

Fall wird A+B := A∪B geschrieben. Die Ereignisse A1 , A2 , A3 , . . . An heißen paarweise

disjunkt, wenn Ai ∩ Ak = ∅ für alle i 6= k mit 1 ≤ i, k ≤ n gilt. In diesem Fall schreibt

man

n

X

k=1

Ak = A1 + A2 + A3 + · · · + An := A1 ∪ A2 ∪ A3 ∪ · · · ∪ An =

n

[

Ak

k=1

A := Ω \ A heißt Komplementärereignis, Gegenereignis oder Komplement von A. Es

wird auch Ac := A geschrieben.

Weitere Beispiele:

(a) Werfen von zwei Würfeln. Ω = {1, 2, 3, . . . 6} × {1, 2, 3, . . . 6}. Beachten Sie, dass

beim kartesischen Produkt die Elemente (i, k) und (k, i) zu unterscheiden sind, wenn

i 6= k. Das Ereignis, dass eine Eins und eine Fünf gewürfelt wurde (ohne zu unterscheiden, welcher Würfel ein Auge zeigt), ist also die Teilmenge A = {(1, 5), (5, 1)}.

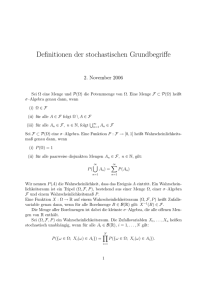

Abbildung 1: Zum Nadelexperiment von Buffon

(b) Nadelexperiment von Buffon. Eine Nadel der Länge l = 1 wird auf eine Ebene

geworfen, die ein Gitter von Parallelen im Abstand d = 1 enthält. Die Lage der

Nadel soll durch den Abstand a des Mittelpunkts zur nächsten unteren Parallelen

und den Winkel ϕ mit der Senkrechten zur Parallelen gekennzeichnet sein. Wir

haben also 0 ≤ a < 1 und − π2 < ϕ ≤ π2 (siehe auch die Abb. 1). Der Ereignisraum

ist also

π π

Ω = [0, 1[ × ] − , + ]

2

2

Das Ereignis Die Nadel trifft keine Parallele“ ist also die Teilmenge

”

A = {(a, ϕ) ∈ Ω | a > 12 cos(ϕ) und (1 − a) > 12 cos(ϕ)}

1.2

Wahrscheinlichkeitsmaß, Wahrscheinlichkeitsraum

Betrachten wir als Beispiel das Ereignis A, bei einem Würfel eine Sechs zu würfeln. Wir

wiederholen das Experiment sehr häufig und als nA bezeichnen wir die Zahl der Würfe

mit ω ∈ A und die Gesamtzahl der Würfe nennen wir N . Dann erwarten wir im Limes

7

N → ∞, dass nNA → 16 . Wir werden als Bewertung des nicht exakt vorhersagbaren Ereignisses A sagen, dass die Wahrscheinlichkeit P (A) = 61 . Wir wollen allgemeiner mit

der Wahrscheinlichkeit nicht exakt vorhersagbare Ereignisse bewerten. Es hat sich als

nicht sinnvoll herausgestellt, für die Definition des Begriffes der Wahrscheinlichkeit den

Grenzwert für N → ∞ zu benutzen, wobei N die Gesamtzahl der Wiederholungen des

Zufallsexperiments ist. Man faßt daher den Begriff allgemeiner und sieht als die Wahrscheinlichkeit eine zahlenmäßige Bewertung der nicht exakt vorhersehbaren Ereignisse an,

die bestimmten Grundregeln (Axiomen) genügt.

Vorher ist eine kleine technische Schwierigkeit zu klären. Bei Grundräumen, die unendlich viele Elemente enthalten und die deren Elemente auch nicht durchnumeriert werden

können (beispielsweise bei Ω = R+ ), kann nicht jede Teilmenge als Ereignis zugelassen

werden, das wir mit einer bestimmten Wahrscheinlichkeit bewerten. In solchen Fällen

können wir nur vernünftige“ Teilmengen als Ereignis zulassen. Wir müssen daher die

”

ursprüngliche Definition 1.1.2 des Begriffs Ereignis“ geauer formulieren.

”

Definition 1.2.1 Ereignisse sind Teilmengen des Grundraums Ω. In den Fällen, in denen nicht jede Teilmenge von Ω als Ereignis zugelassen ist, werden folgende Regeln vorausgesetzt:

(a) Ω ist ein Ereignis

(b) A ist ein Ereignis =⇒ A = Ω \ A ist ein Ereignis

(c) Für jede Folge A1 , A2 , A3 , A4 . . . von Ereignissen ist

A1 ∪ A2 ∪ A3 ∪ A4 ∪ . . . =

∞

[

Ak

k=1

ebenfalls ein Ereignis.

Hinweise:

(a) Für endlich viele Ereignisse A1 , A2 , A3 . . . An ist

A1 ∪ A2 ∪ A3 · · · An =

n

[

Ak

k=1

für alle n ∈ N ein Ereignis. Dies folgt aus (c), wenn man Ak = ∅ für k > n setzt.

(b) Weil für alle Ereignisse A, B ⊂ Ω gilt

A ∩ B = (Ac ∪ B c )c

ist auch A ∩ B ein Ereignis. Entsprechendes gilt für endlich viele Ereignisse und

auch für Folgen Ak von Ereignissen: Der Durchschnitt

!c

∞

∞

\

[

A1 ∩ A2 ∩ A3 ∩ A4 ∩ . . . =

Ak =

Ack

k=1

ebenfalls ein Ereignis.

8

k=1

Damit können wir die Grundregeln (Axiome) für die Wahrscheinlichkeit formulieren.

Definition 1.2.2 Gegeben sei ein Grundraum Ω und als Ereignisse zugelassene Teilmengen von Ω, die die Bedingungen der Definition 1.2.1 erfüllen. Dann heißt eine Zuordnungsvorschrift, die jedem Ereignis A die reelle Zahl P (A) zuordnet, Wahrscheinlichkeitsmaß auf Ω und P (A) heißt Wahrscheinlichkeit von A, wenn folgende Grundregeln

(Axiome) erfüllt sind:

(a) P (A) ∈ [0, 1] ( Positivität“)

”

(b) P (Ω) = 1 ( Normierung“)

”

(c) Für alle Folgen A1 , A2 , A3 , A4 , . . . von paarweise disjunkten Ereignissen gilt

!

∞

∞

[

X

P

Ak =

P (Ak )

( Additivität“)

”

k=1

k=1

Dann wird Ω mit den zugelassenen Ereignissen und dem Wahrscheinlichkeitsmaß ein

Wahrscheinlichkeitsraum genannt.

Hinweis: Aus der Grundregel (c) folgt, dass für paarweise disjunkte Ereignisse A1 , A2 ,

A3 , . . . An (also endlich viele Ereignisse) gilt

!

n

n

[

X

P

Ak =

P (Ak )

k=1

k=1

(Um dies einzusehen, braucht man nur in (c) Ak = ∅ für k > n zu setzen.)

Beispiele:

(a) Würfel, Ω = {1, 2, 3, . . . 6}, P ({k}) = 61 für alle k = 1, 2, . . . 6, es werden alle Teilmengen von Ω als Ereignisse zugelassen und wir haben

P (A) =

Zahl der Elemente in A

6

(b) Triviales Beispiel: Ω = {1, 2, 3, . . . 6}, alle Teilmengen sind als Ereignisse zugelassen.

1 falls 6 ∈ A

P (A) :=

0 falls 6 6∈ A

ist ein Wahrscheinlichkeitsmaß auf Ω.

(c) Ω = {g, e} Bei der Übertragung eines Bits steht g“ dafür, dass es richtig übertragen

”

wird, e“ dafür, dass es umgekehrt wird (aus 1 wird 0 und aus 0 wird 1). Alle

”

Teilmengen, also ∅, {g}, {e}, Ω sind als Ereignis zugelassen. Für jede Zahl p mit

0 < p < 1 ist

0

falls A = ∅

p

falls A = {g}

P (A) :=

1 − p falls A = {e}

1

falls A = Ω

ein Wahrscheinlichkeitsmaß. Man hofft, dass p nahe an 1 (z.B. p = 0, 999) ein gutes

Modell für die Übertragung ist.

9

(d) Glücksrad. Hier ist eine Möglichkeit für den Grundraum Ω = ] − π, +π] (die Winkelpositionen, die das Glücksrad nach Stillstand einnehmen kann). Es stellt sich hier

heraus, dass es nicht möglich ist, alle Teilmengen dieses Intervalls als Ereignisse zuzulassen. Eine Möglichkeit ist, als Ereignisse links offene und rechts abgeschlossene

Intervalle der Form ]a, b] mit −π ≤ a < b ≤ +π sowie die leere Menge, Vereinigungen von Folgen derartiger Mengen sowie die Komplementmengen derartiger Mengen

zuzulassen. Beachten Sie, dass man damit auch offene und abgeschlossene Intervalle

als Ereignisse bekommt mit

∞

\

1

[a, b] =

]a − ε, b],

k

k=1

]a, b[=

∞

[

1

]a, b − ε]

k

k=1

und einem geeignet gewählten ε > 0. Es ist ein plausibles Modell, dass die Wahrscheinlichkeit dafür, dass das Glücksrad in der Winkelposition ϕ mit ϕ ∈ ]a, b] stehen

bleibt, proportional zur Länge des Intervalls, also zu b − a ist. Aus der Normierungsbedingung ergibt sich sofort

b−a

P (]a, b]) =

2π

Beachten Sie, dass die Wahrscheinlichkeit, dass das Glücksrad in einer genau festgelegten Winkelposition stehen bleibt, verschwindet, also beispielsweise P ({ π6 }) = 0.

(e) Nadelexperiment von Buffon. Hier war schon früher als Grundraum

Ω = [0, 1[×] −

π π

,+ ]

2

2

angegeben worden (siehe auch Abb. 1). Auch hier hat man die technische Schwierigkeit, dass man nicht alle Teilmengen als Ereignisse zulassen kann. Man kann jedoch

Rechtecken analog zu den Intervallen beim Glücksrad und Vereinigungen von Folgen

derartiger Mengen als Ereignisse zulassen und so alle vernünftigen“ Teilmengen von

”

Ω erhalten. Eine sinnvolle Wahrscheinlichkeit einer Teilmenge von Ω sollte proportional zur Fläche dieser Teilmenge sein. Wir bezeichnen mit F (A) die Fläche einer

Teilmenge von Ω. Aus der Normierungsbedingung und der Gesamtfläche F (Ω) = π

ergibt sich die Wahrscheinlichkeit

P (A) =

F (A)

π

Wir hatten schon früher das Ereignis Die Nadel trifft keine Parallele“ als die Teil”

menge

A = {(a, ϕ) ∈ Ω | a > 12 cos(ϕ) und (1 − a) > 12 cos(ϕ)}

charakterisiert. Eine kleine Aufgabe zum Knobeln: Wie groß ist die Wahrscheinlichkeit P (A) dieses Ereignisses? Hierzu empiehlt es sich, eine Zeichnung anzufertigen

und die Randkurven der Fläche, die sich aus den beiden Bedingungen in der Definition von A ergeben, einzuzeichnen. Mit Hilfe von Symmetrieüberlegungen sieht

man, dass sich die Menge A aus vier kleineren Teilmengen derselben Fläche zusammensetzen lässt. Die Fläche dieser kleineren Teilmenge ergibt sich durch eine

einfache Integration, und als Ergebnis erhält man

P (A) = 1 −

10

2

π

(f) Zufallszahlen aus dem Computer. In vielen Programmen ist es möglich, Zufallszahlen x zu berechnen mit x ∈ ]0, 1[. In Scilab erhält man nach Initialisierung durch den

Aufruf rand(’u’) bei jedem Aufruf der Form x=rand() eine Zahl in ]0, 1[. Dies ist

strenggenommen kein Zufallsexperiment. Wenn man den Algorithmus kennt, so lässt

sich jede so erzeugte Zufallszahl exakt vorhersagen (es genügt, das Quellprogramm

zu kennen!). Aber für viele Zwecke kann man mit diesen Zufallszahlen Zufallsexperimente simulieren, bei denen die Wahrscheinlichkeit für das Ereignis x ∈ ]a, b[

durch

P (]a, b[) = b − a

für 0 ≤ a < b ≤ 1

ist. Beachten Sie, dass auch hier die Wahrscheinlichkeit, dass die Zufallszahl einen

genau festgelegten Wert annimmt, verschwindet, also beispielsweise P ({ 21 }) = 0.

1.3

Laplace-Modelle, Kombinatorik

Für viele Ergebnisräume Ω mit endlich vielen Elementen ist das folgende Wahrscheinlichkeitsmaß ein sinnvolles Modell

P (A) =

|A|

Zahl der Elemente in A

=

Zahl der Elemente in Ω

|Ω|

P heißt dann diskrete Gleichverteilung oder Laplace-Verteilung, das zugehörige Experiment Laplace-Experiment, das zugehörige Modell Laplace-Modell. Man hat jedoch sorgfältig zu überprüfen, ob die darin ausgedrückte völlige Gleichberechtigung aller Elemente

des Grundraums wirklich berechtigt ist, wie das erste Beispiel zeigt.

Beispiele:

(a) Werfen von zwei Münzen (oder zweimaliges Werfen einer Münze). Wir bezeichnen

die Ergebnismenge für eine Münze mit Ω = {W, Z} (für Wappen oder Zahl). Wir haben zwei verschiedene Varianten, das Zufallsexperiment durchzuführen, also streng

genommen zwei verschiedene Zufallsexperimente mit zwei Münzen:

(a) ohne Unterscheidung der beiden Münzen oder der Reihenfolge:

ΩA = {(W, W )A , (W, Z)A , (Z, Z)A }

(nach dem Mathematiker d’Alembert)

(b) mit Unterscheidung der Münzen oder der Reihenfolge

ΩL = {(W, W ), (W, Z), (Z, W ), (Z, Z)}

(nach dem Mathematiker Laplace)

Wenn man ohne Überlegung auf ΩA ein Laplace-Modell anwendet, dann erhält man

für die Wahrscheinlichkeit, dass Wappen und Zahl geworfen wird, die falsche Wahrscheinlichkeit 31 . Die Ereignisse A = {(W, Z)A } und B = {(W, W )A } sind jedoch

nicht gleichberechtigt, denn man erhält beim Vergleich der beiden Beschreibungen

A = {(W, Z)A } = {(W, Z), (Z, W )},

11

B = {(W, W )}A = {(W, W )}

Also das eine Ereignis ist ein Elementarereignis bei der Beschreibung nach Laplace,

das andere hat nach Laplace zwei Elemente! Die richtige Wahrscheinlichkeit, dass

Wappen und Zahl geworfen wird, ist also

P (A) =

1

2

Dies ist sinnvoll, weil es zwei Möglichkeiten für Wappen und Zahl gibt (erste Münze

Wappen, zweite Münze Zahl und umgekehrt) dagegen nur eine Möglichkeit dafür,

dass zweimal Wappen auftritt. Wenn man immer noch zweifelt, dann kann man in

Gedanken das Experiment von zwei verschiedenen Beobachtern durchführen lassen,

von denen der eine die beiden Münzen unterscheiden kann, (beispielsweise durch eine

Spezialbrille) und der andere sie nicht unterscheiden kann. Der Ausgang des Zufallsexperiments sollte nicht von der Anwesenheit des Beobachters mit der Spezialbrille

abhängen. Auf dem Grundraum ΩL ist also die Beschreibung durch ein LaplaceModell sinnvoll, auf dem Grundraum ΩA ist das sinnvolle Wahrscheinlichkeitsmaß

durch

1

1

1

P {(W, W )A }) = , P {(W, Z)A }) = , P {(Z, Z)A }) =

4

2

4

gegeben. Die Beschreibung nach Laplace mit ΩL ist jedoch einfacher!

(b) Würfeln mit drei Würfeln (oder dreimaliges Würfeln). Für einen Würfel haben wir

den Grundraum

Ω0 = {1, 2, 3, 4, 5, 6}

und damit für drei Würfel

Ω = Ω0 × Ω0 × Ω0 = {(i, k, l) | i, k, l ∈ Ω0 }

Beachten Sie, dass wir das kartesische Produkt von Mengen so definiert haben, dass

Tripel mit denselben Elementen und unterschiedlicher Reihenfolge als unterschiedliche Elemente anzusehen sind. Also ist hier (3, 2, 1) 6= (2, 3, 1) und unser Grundraum

hat insgesamt 63 = 216 Elemente. Nach Laplace erhält jedes Elementarereignis die

Wahrscheinlichkeit

1

P ({(i, k, l)}) =

216

1

Die Wahrscheinlichkeit, dreimal eine Sechs zu würfeln, ist also 216

. Das Ereignis,

dass die Augenzahl 1, 2, 3 ohne Berücksichtigung der Reihenfolge gewürfelt wird, ist

also die Teilmenge

A = {(1, 2, 3), (1, 3, 2), (3, 1, 2), (2, 1, 3)(2, 3, 1)(3, 2, 1)}

mit 6 Elementen und der Wahrscheinlichkeit P (A) =

6

216

=

(1)

1

.

36

Das letzte Beispiel gibt Anlass zur Definition

Definition 1.3.1 Eine Umordnung der Zahlen (1, 2, 3, 4, . . . n) (alle Zahlen verschieden!)

in eine andere Reihenfolge heißt Permutation, genauer n-Permutation ohne Wiederholung. Mathematisch ist eine Umordnung“eine bijektive Abbildung von

”

{1, 2, 3, 4, . . . n} → {1, 2, 3, 4, . . . n}

Auch eine Umordnung von n verschiedenen Elementen einer Menge (z.B. n verschiedenen

Buchstaben eines Alphabets) heißt Permutation.

12

Das letzte Beispiel legt die Frage nahe, wieviel Permutationen es gibt (in Abhängigkeit

von n). In (1) sind alle 6 = 3 · 2 Permutationen für n = 3 aufgeführt. Aus einer beliebigen

Permutation (i, k, l) für n = 3 erhält man für n = 4 die Permutationen

(4, i, k, l), (i, 4, k, l), (i, k, 4, l), (i, k, l, 4)

und man kann sich überzeugen, dass man aus allen Permutationen für n = 3 auf diese

Weise alle 4 · 6 = 24 Permutationen für n = 4 erhält. Entsprechend erhält man aus einer

beliebigen Permutation (i, k, l, m) für n = 4 die Permutationen für n = 5

(5, i, k, l, m), (i, 5, k, l, m), (i, k, 5, l, m), (i, k, l, 5, m), (i, k, l, m, 5)

und man erhält auf diese Weise alle 5 · 4 · 3 · 2 = 5! = 120 Permutationen für n = 5. Wir

erhalten so das Ergebnis (genauer Beweis durch vollständige Induktion):

Satz 1.3.1 Für beliebiges n ∈ N existieren genau n! verschiedene Permutationen der

Zahlen (1, 2, 3, 4. . . . n).

weiteres Beispiel:

(c) Lotto 6 aus 49. Die Lottozahlen werden nach dem Ziehen sortiert, die Reihenfolge

beim Ziehen wird also nicht berücksichtigt. Der Grundraum ist hier

Ω = {(k1 , k2 , k3 , k4 , k5 , k6 ) | 1 ≤ kl ≤ 49}

und dem Ereignis A, dass die Lottozahlen (i1 < i2 < i3 < i4 < i5 < i6 ) betragen,

entspricht also die Menge

A = {(k1 , k2 , . . . k6 ) | (k1 , k2 , . . . k6 ) ist Permutation von (i1 < i2 < · · · < i6 )}

mit 6! = 720 verschiedenen Elementen. 720 verschiedene Ziehungen führen also zu

denselben Lottozahlen. Für die Ziehung der ersten Zahl k1 gibt es 49 Möglichkeiten,

für die Ziehung von k2 gibt es 48 Möglichkeiten, für k3 47 Möglichkeiten. Für die

Ziehung von (k1 , k2 , k3 , k4 , k5 , k5 , k6 ) in der angegebenen Reihenfolge gibt es also

insgesamt

NR = 49 · (49 − 1) · (49 − 2) · (49 − 3) · (49 − 4) · (49 − 5)

Möglichkeiten. Legt man ein Laplace-Modell zugrunde, so ist die Wahrscheinlichkeit

für die Ziehung von (k1 , k2 , k3 , k4 , k5 , k5 , k6 ) in der angegebenen Reihenfolge N1R . Das

Ereignis A besteht aber aus 6! derartigen Elementen. Für das Ereignis Lottozahlen

”

(i1 < i2 < i3 < i4 < i5 < i6 )“ erhalten wir also die Wahrscheinlichkeit

P (A) =

6!

1

=

49 · (49 − 1) · (49 − 2) · (49 − 3) · · · (49 − 5)

13 983 816

Dies ist die Wahrscheinlichkeit, 6 Richtige im Lotto zu haben!

13

Zur Erinnerung:

Die Binomialkoeffizienten

n

k

sind durch

(

1

falls k = 0

n

:=

n!

falls 1 ≤ k ≤ n

k

k!(n − k)!

definiert. Sie haben die Eigenschaften

n

n

n

n

n

= 1,

=

= n,

=

,

n

1

n−1

k

n−k

n

n

n+1

+

=

k−1

k

k

Sie stehen in der n. Zeile des Pascal-Dreiecks an der k. Position von links, wenn man

jeweils mit 0 anfängt zu zählen. Kürzen in der Definition liefert für k ≥ 1

n

1 · 2 · 3 · · · (n − k) · (n − k + 1) · · · n

(n − k + 1) · (n − k + 2) · · · (n − 1) · n

=

=

k

k! · 1 · 2 · 3 · · · (n − k)

k!

n · (n − 1) · (n − 2) · · · (n − k + 1)

=

k!

Wir erhalten also für die Wahrscheinlichkeit 6 Richtige beim Lotto“

”

1

P (A) = 49

6

und allgemeiner für die Wahrscheinlichkeit, bei der zufälligen Auswahl von k Zahlen aus

den Zahlen {1, 2, 3, . . . n} eine vorgegebene Menge A von k Zahlen zu erhalten

P (A) =

1

n

k

allgemeinere Permutationen:

Definition 1.3.2 M sei eine Menge mit n Elementen, beispielsweise M = {1, 2, 3, . . . n}

und k ∈ N.

Eine k-Permutation aus M mit Wiederholung ist ein k-Tupel (a1 , a2 , a3 , . . . ak ) mit ak ∈

M . Die Menge Ω der k-Permutationen aus M mit Wiederholung ist also

Ω = Mk = M

{z × · · · × M}

| ×M ×M

k mal

d.h. das k-fache kartesische Produkt von M .

Wenn k ≤ n, dann ist eine k-Permutation aus M ohne Wiederholung ein k-Tupel

(a1 , a2 , a3 , . . . ak ) mit ak ∈ M und ai 6= ak für i 6= k

Hinweise:

(a) Beachten Sie, dass es bei k-Tupeln grundsätzlich auf die Reihenfolge der Elemente

ankommt.

(b) Es gibt nk k-Permutationen mit Wiederholung (das k-fache kartesische Produkt

einer Menge mit n Elementen hat nk Elemente).

14

(c) Die Zahl der möglichen k-Permutationen ohne Wiederholung ist

n · (n − 1) · (n − 2) · · · (n − k + 1)

Für k = n spricht man von einer n-Permutation in Übereinstimmung mit Definition

1.3.1 und Satz 1.3.1.

(d) Beim Ausmultiplizieren von

(a + b)n = (a + b) · (a + b) · (a + b) · · · (a + b)

{z

}

|

n Faktoren

entspricht die Zahl der Summanden an−k bk der Zahl der Möglichkeiten der Zie”

hung“ von k Faktoren b aus den Klammern der gedachten Nummern 1, 2, . . . n ohne

Berücksichtigung der Reihenfolge der Ziehung“. Dies erklärt das Auftauchen der

”

Binomialkoeffizienten bei Problemen der Art der Ziehung von Lottozahlen.

1.4

Rechenregeln für Wahrscheinlichkeiten

Aus den Grundregeln für die Wahrscheinlichkeit ergeben sich folgende enfache Rechenregeln:

Satz 1.4.1 P sei ein Wahrscheinlichkeitsmaß über dem Grundraum Ω und A, B seien

ein Ereignisse. Dann gilt

(a) P (∅) = 0

(b) P (A) = 1 − P (A)

(c) B ⊂ A =⇒ P (A \ B) = P (A) − P (B) und P (B) ≤ P (A)

(d) P (A ∪ B) = P (A) + P (B) − P (A ∩ B) ≤ P (A) + P (B)

Beweis: (a) ergibt sich aus Ω = Ω ∪ ∅. Anwendung der Grundregeln ergibt 1 = P (Ω) =

P (Ω) + P (∅) = 1 + P (∅) und daraus folgt P (∅) = 0.

(b) ergibt sich aus Ω = A ∪ A = A ∪ (Ω \ A). Anwendung der Grundregeln ergibt

1 = P (A) + P (Ω \ A) und damit P (Ω \ A) = P (A) = 1 − P (A)

(c): Wenn B ⊂ A dann ist A = (A \ B) ∪ B. Die Mengen A \ B und B sind disjunkt,

also hat man nach Grundregel (c) P (A) = P (A \ B) + P (B) und daraus ergibt sich

P (A \ B) = P (A) − P (B) und P (A) ≥ P (B).

(d): Hierfür benutzen wir die Identität

A ∪ B = (A \ (A ∩ B)) ∪ (B \ (A ∩ B)) ∪ (A ∩ B)

die man sich leicht an einem Venn-Diagramm klarmachen kann. Die drei Mengen auf

der rechten Seite sind disjunkt (sie sind gerade so konstruiert). Aus (A ∩ B) ⊂ A folgt

nach (c) P (A \ (A ∩ B)) = P (A) − P ((A ∩ B), analog folgt aus (A ∩ B) ⊂ B, dass

P (B \ (A ∩ B)) = P (B) − P ((A ∩ B). Damit erhalten wir aus der obigen Mengenidentität

P (A ∪ B) = P (A \ (A ∩ B)) + P (B \ (A ∩ B)) + P (A ∩ B)

= P (A) − P (A ∩ B) + P (B) − P (A ∩ B) + P (A ∩ B)

= P (A) + P (B) − P (A ∩ B)

15

Satz 1.4.2

(a) Wenn Ω aus endlich vielen Elementen besteht, also Ω = {ω1 , ω2 , ω3 , . . . ωn }, dann

ist das Wahrscheinlichkeitsmaß durch die Wahrscheinlichkeiten der Elementarereignisse gegeben mit

pk = P ({ωk }),

0 ≤ pk ≤ 1

und

n

X

pk = 1

(2)

k=1

erfüllen. Umgekehrt definieren beliebige Zahlen p1 , p2 , p3 , . . . pn , die (2) erfüllen,

ein Wahrscheinlichkeitsmaß auf Ω. Die Wahrscheinlichkeit beliebiger Ereignisse ist

durch

k

X

P ({ωi1 , ωi2 , ωi3 . . . ωik }) =

p il

mit 1 ≤ k ≤ n

l=1

gegeben.

(b) Wenn Ω = {ω1 , ω2 , ω3 , . . .} aus einer Folge unendlich vieler Elemente besteht (also

die Elemente von Ω durchnummeriert werden können), dann ist das Wahrscheinlichkeitsmaß analog durch pk = P ({ωk }) gegeben mit

0 ≤ pk ≤ 1

und

∞

X

pk = 1

k=1

und umgekehrt definiert jede Folge pk , die diesen Bedingungen genügt, ein Wahrscheinlichkeitsmaß auf Ω.

Hinweise:

(a) Der Beweis ist leicht mit Hilfe der Grundregeln zu führen.

(b) Man kann nachweisen, dass die reellen Zahlen und nichtleere Intervalle nicht die

Eigenschaft haben, dass man ihre Elemente durchnummerieren kann!

Definition 1.4.1 Wenn Ω die Voraussetzungen einer der beiden Teilaussagen des Satzes 1.4.2 erfüllt, dann heißt P diskretes Wahrscheinlichkeitsmaß und Ω heißt diskreter

Wahrscheinlichkeitsraum. Wenn eine Menge unendlich viele Elemente hat und man die

Elemente einer Menge durchnummerieren kann, dann sagt man, sie habe abzählbar (unendlich) viele Elemente.

2

2.1

Bedingte Wahrscheinlichkeit und Unabhängigkeit

Definitionen und wichtige Folgerungen

Beispiel: In einem Nachbarraum wird mit 2 Würfeln gewürfelt und es soll erraten werden,

ob das Ereignis A eingetreten ist, dass mindestens eine 6 gewürfelt wurde. Um dieses etwas

zu erleichtern, wird mitgeteilt, ob das Ereignis B eingetreten ist, dass die Augensumme

mindestens 8 ist, oder ob dieses nicht der Fall ist. Wir haben also eine Wahrscheinlichkeit

16

Abbildung 2: Zwei Würfel, Ereignis A: Mindestens eine 6“ grau unterlegt, Ereignis B:

”

Augensumme mindestens 8“ eingerahmt

”

für das Ereignis A anzugeben, unter der Zusatzinformation, dass das Ereignis B eingetreten ist. Dabei ist der ursprüngliche Grundraum Ω = Ω0 × Ω0 mit Ω0 = {1, 2, 3 . . . 6}

und

A = {(i, k) ∈ Ω | i = 6 oder k = 6}, B = {(i, k) ∈ Ω | i + k ≥ 8}

Die Idee ist, dass wir aufgrund der Zusatzinformation, das Ereignis B ist eingetreten, den

Grundraum verkleinern und als neuen Grundraum B wählen können. Dieser ist in Abb. 2

eingerahmt. Das Ereignis A ist in der Abb. 2 grau unterlegt. Um die Wahrscheinlichkeit

des Ereignisses A unter der Bedingung B zu bestimmen, brauchen wir jetzt nur alle

Elemente aus B abzuzählen, die zu A gehören (in der Abb. alle eingerahmten und grau

unterlegten Elemente, also 9) und diese durch die Gesamtzahl aller Elemente von B (aller

eingerahmten, also 15) zu dividieren. Einfaches Abzählen ergibt also als die gesuchte

9

= 35 .

bedingte Wahrscheinlichkeit 15

Allgemein möchten wir, dass die bedingte Wahrscheinlichkeit von A unter der Bedingung B proportional zur ursprünglichen Wahrscheinlichkeit sein soll, wenn man sie

auf B als neuem Grundraum einschränkt. Also haben wir als Ansatz für diese bedingte Wahrscheinlichkeit c · P (A ∩ B). Sie soll auf B ein Wahrscheinlichkeitsmaß sein. Die

1

. Dies motiviert die

Normierungsbedingung ergibt dann sofort c · P (B) = 1, also c = P (B)

folgende Definition:

Definition 2.1.1 Sei P ein Wahrscheinlichkeitsmaß auf dem Grundraum Ω und B ⊂ Ω

ein Ereignis mit P (B) 6= 0. Dann ist die bedingte Wahrscheinlichkeit von A unter der

Bedingung B durch

P (A ∩ B)

P (A|B) :=

P (B)

definiert.

Hinweise:

(a) Für Elementarereignisse A = {ω} erhalten wir aus der Definition

(

0

falls ω 6∈ B

P ({ω}|B) =

P ({ω})

falls ω ∈ B

P (B)

17

Die bedingte Wahrscheinlichkeit ist in diesem Fall dann größer als die ursprüngliche,

wenn P (B) < 1 und P ({ω}) > 0.

(b) Trivialerweise erhalten wir P (Ω|B) = 1.

Aus der Definition ergibt sich sofort der Multiplikationssatz:

Satz 2.1.1 Sei P ein Wahrscheinlichkeitsmaß auf dem Grundraum Ω und seien A ⊂ Ω

und B ⊂ Ω Ereignisse mit P (A) 6= 0 und P (B) =

6 0. Dann gilt

P (A ∩ B) = P (A|B) · P (B) = P (B|A) · P (A)

Definition 2.1.2 Zwei Ereignisse A und B heißen (stochastisch) unabhängig, wenn

P (A ∩ B) = P (A) · P (B)

Drei Ereignisse A, B, C heißen (stochastisch) unabhängig, wenn

P (A ∩ B) = P (A) · P (B), P (A ∩ C) = P (A) · P (C),

P (A ∩ B ∩ C) = P (A) · P (B) · P (C)

P (B ∩ C) = P (B) · P (C)

Die Ereignisse A1 , A2 , A3 . . . An heißen (stochastisch) unabhängig, wenn für alle Nummern i1 < i2 < i3 < · · · < ik mit k ≤ n gilt

P (Ai1 ∩ Ai2 ∩ Ai3 ∩ . . . ∩ Aik ) = P (Ai1 ) · P (Ai2 ) · P (Ai3 ) · · · P (Aik )

Hinweis: Wenn A und B unabhängig sind, dann ist P (A|B) = P (A), falls P (B) 6= 0,

und P (B|A) = P (B) falls P (A) 6= 0, die bedingten Wahrscheinlichkeiten stimmen dann

mit den ursprünglichen überein.

Beispiel: Würfeln mit zwei Würfeln. A sei das Ereignis, dass die Augensumme ungerade

ist und B sei das Ereignis, dass die Augenzahl beim 1. Würfel gerade ist. Eine einfache

Überlegung oder Abzählen der Elemente in Abb. 2 ergibt

1

P (A) = ,

2

1

P (B) = ,

2

P (A ∩ B) =

1

4

Die beiden Ereignisse sind also unabhängig, obwohl anschaulich ein Zusammenhang“ des

”

einen Ereignisses mit dem andern besteht.

2.2

Produktwahrscheinlichkeitsmaß

Führt man zwei einzelne Zufallsexperimente mit den Grundräumen Ω1 und Ω2 und den

Wahrscheinlichkeitsmaßen P1 und P2 , die sich nicht gegenseitig beeinflussen, gleichzeitig

oder zeitlich nacheinander durch, so kann man dies auch als ein einziges Experiment

beschreiben mit dem Grundraum

Ω = Ω1 × Ω2

Beispielsweise wählen wir für das gleichzeitige Werfen einer Münze und eines Würfels den

Grundraum

Ω = {W, Z} × {1, 2, . . . 6}

Als Ereignisse lässt man Teilmengen der Form

A = A1 × A2

18

sowie Vereinigungen von Folgen derartiger Ereignisse sowie Komplementmengen derartiger Ereignisse zu, wobei mit A1 zugelassene Ereignisse in Ω1 und mit A2 zugelassene

Ereignisse in Ω2 bezeichnet sind. Durch

P (A) = P1 (A1 ) · P2 (A2 )

erhält man aus den Wahrscheinlichkeitsmaßen in Ω1 und Ω2 ein Wahrscheinlichkeitsmaß

auf Ω, das man Produktwahrscheinlichkeitsmaß nennt. Im angegebenen Beispiel ist

die Wahrscheinlichkeit, Wappen“ und 6 Augen“ zu erhalten

”

”

1

1 1

P ({W } × {6}) = P1 ({W }) · P2 ({6}) = · =

2 6

12

Bei dieser Beschreibung entspricht dem Ereignis: In Experiment 1 tritt A1 auf“ ohne

”

Berücksichtigung von Experiment 2 die Teilmente

A = A1 × Ω2

und entsprechend gehört zum Ereignis In Experiment 2 tritt Ereignis A2 auf“ ohne

”

Berücksichtigung von Experiment 1 die Teilmenge

B = Ω1 × A2

Derartige Ereignisse sind in der Tat unabhängig in Bezug auf das Produktwahrscheinlichkeitsmaß, denn

P (A1 × A2 ) = P (A1 × Ω2 ) ∩ (Ω1 × A2 ) = P1 (A1 ) · P2 (A2 )

= P1 (A1 ) · P2 (Ω2 ) · P1 (Ω1 ) · P2 (A2 )

Für n nacheinander oder gleichzeitig durchgeführte unabhängige Zufallsexperimente wird

analog vorgegangen.

Beispiel: Bereits früher wurde das Zufallsexperiment Übertragen eines Bits über einen

”

unzuverlässigen Kanal“ erwähnt (siehe Beispiel (c) in Abschnitt 1.2) mit Ω = {g, e}und

g“ für korrekte Übertragung, e“ für Übertragungsfehler und 21 < P0 ({g}) < 1 für eine

”

”

akzeptable Übertragung. In der Praxis überträgt man nicht 1 Bit sondern n Bits. Man

wiederholt dieses Experiment also n mal. Ein entsprechendes Einzelexperiment (mit 2

möglichen Ausgängen) heißt Bernoulli-Experiment. Die n-fache Wiederholung eines

Bernoulli-Experiments wird also durch das Produktwahrscheinlichkeitsmaß beschrieben

mit

Ω = {g, e}n

und P (A1 × A2 × A3 × · · · × An ) = P0 (A1 ) · P0 (A2 ) · P0 (A3 ) · · · P0 (An )

Beispielsweise wird das Ereignis, dass nur beim 3. und 5. Bit ein Übertragungsfehler

auftritt, durch

A = (g, g, e, g, e, g, g, g . . . g)

beschrieben, seine Wahrscheinlichkeit ist

P (A) = p · p · (1 − p) · p · (1 − p) · p · p · p · · · p = pn−2 · (1 − p)2

Wenn bei einem derartigen Elementarereignis k Bits korrekt übertragen werden und bei

(n − k) Bits ein Fehler auftritt, dann ist seine Wahrscheinlichkeit pk · (1 − p)n−k . In der

19

Praxis interessiert man sich meist nicht, bei welchen Bits die Fehler auftreten. Die Frage,

wieviele derartige Elementarereignisse es gibt, also wieviele Möglichkeiten es gibt, k Bits

aus insgesamt n Bits auszusuchen ohne Berücksichtigung

der Reihenfolge des Aussuchens

entspricht demselben Problem beim Lotto: Es sind nk Möglichkeiten. Wir haben also

das für die Praxis wichtige Ergebnis: Die Wahrscheinlichkeit, k von n Bits fehlerfrei zu

übertragen, ist

n k

n

n−k

PB (n, k) =

p (1 − p)

=

pk (1 − p)n−k

k

n−k

Als Zahlenwerte erhält man für p = 0, 99 und n = 1024 die Wahrscheinlichkeit für 5

Fehler 0,0331, für 10 Fehler 0,125, für 15 Fehler 0,0388. Wir werden uns später genauer

mit diesem Ergebnis befassen.

2.3

Anwendungen von bedingten Wahrscheinlichkeiten

Bei der Einführung der bedingten Wahrscheinlichkeit P (A|B) war diese in einem Beispiel

berechnet worden, in dem die Wahrscheinlichkeiten P (Ak ) bekannt waren. In der Praxis

ist es häufig umgekehr: Man kennt bedingte Wahrscheinlichkeiten und möchte daraus die

Wahrscheinlichkeiten berechnen. Hierzu benutzt man eine Zerlegung des Grundraums in

disjunkte Ereignisse und den folgenden Satz:

Satz 2.3.1 Seien A1 , A2 , A3 . . . An Ereignisse mit

Ω=

n

[

Ak

k=1

mit P (Ak ) 6= 0 und

Dann gilt für alle Ereignisse B

n

P

P (Ak ) · P (B|Ak )

(a) P (B) =

k=1

Ai ∩ Ak = ∅ für alle 1 ≤ i, k ≤ n mit i 6= k

( Formel von der totalen Wahrscheinlichkeit“)

”

(b) Wenn P (B) 6= 0, dann gilt für alle k = 1, 2, 3, . . . n die Formel von Bayes“

”

P (Ak ) · P (B|Ak )

P (Ak |B) = P

n

P (Al ) · P (B|Al )

l=1

Beweis:

(a) Die Regel

(C ∪ D) ∩ E = (C ∩ E) ∪ (D ∩ E)

kann man sich leicht an einem Venn-Diagramm klarmachen und durch eine Wahrheitstafel beweisen (siehe das 1. und 2. Übungsblatt zur Mathematik 1, Analysis).

Man kann sie (Beweis durch vollständige Induktion) auf den Fall der Vereinigung

von n Mengen verallgemeinern. Wir wenden sie hier an:

n

n

X

n

S

S

P (B) = P (Ω ∩ B) = P

Ak ∩ B = P

(Ak ∩ B) =

P (Ak ∩ B)

k=1

=

n

X

k=1

k=1

P (Ak ) · P (B|Ak )

Dabei wurde am Schluß Satz 2.1.1 benutzt.

20

k=1

(b) Nach Satz 2.1.1 gilt

P (B) · P (Ak |B) = P (B|Ak ) · P (Ak )

und damit

P (Ak |B) =

P (B|Ak ) · P (Ak )

P (B)

Ersetzt man den Nenner nach der Formel von der totalen Wahrscheinlichkeit durch

die rechte Seite dieser Formel, dann erhält man die behauptete Formel von Bayes.

Anwendungsbeispiele:

Abbildung 3: Baumdiagramm zum Beispiel zur Formel von Bayes aus der Medizin

(a) Bei vielen Krankheiten, die im Frühstadium ohne Symptome verlaufen, gibt es einen

Früherkennungstest, meist durch eine Blutuntersuchung. Das hier angeführte Beispiel stammt von

http://de.wikipedia.org/wiki/Bayes-Theorem

Gehen wir davon aus, dass die Wahrscheinlichkeit, dass eine zufällig ausgesuchte

Testperson an der Krankheit leidet, P (A) = 0, 0002 ist. B bezeichne das Ereignis,

dass der Test für diese Person positiv verläuft. Der Hersteller des Tests versichert,

dass die Wahrscheinlichkeit, dass der Test falsch positiv ist

P (B|A) = 0, 01

beträgt und die Wahrscheinlichkeit, dass die Krankheit erkannt wird

P (B|A) = 0, 99

Wie groß ist die Wahrscheinlichkeit P (B), dass der Test positiv verläuft? Wie groß

ist die Wahrscheinlichkeit, dass die Testperson erkrankt ist, wenn der Test positiv

verläuft? P (B) erhält man aus der Formel von der totalen Wahrscheinlichkeit, wenn

man die Zerlegung

Ω = A ∪ A = A ∪ (Ω \ A)

21

benutzt:

P (B) = P (A) · P (B|A) + P (A) · P (B|A) ≈ 0, 0102

Aus der Formel von Bayes erhält man

P (A|B) =

P (A) · P (B|A)

≈ 0, 0194193

P (A) · P (B|A) + P (A) · P (B|A)

Die Wahrscheinlichkeit, bei positivem Test tatsächlich erkrankt zu sein, ist recht

klein. Man kann sich den entsprechenden Sachverhalt auch graphisch klarmachen

mit Hilfe eines Baumdiagramms oder Ereignisbaumes wie in Abb. 3. Wir erhalten

zunächst

P (B) = P (positiv getestet) = P (krank) · P (positiv getestet | krank)

+P (gesund) · P (positiv getestet | gesund)

was mit der Anwendung der Formel von der totalen Wahrscheinlichkeit identisch

ist. Aus der Definition bedingter Wahrscheinlichkeiten erhält man dann

P (krank ∩ positiv getestet)

P (positiv getestet)

0, 0002 · 0, 99

=

≈ 0, 0194193

0, 0002 · 0, 99 + 0, 9998 · 0, 01

P (krank|positiv getestet) =

In der medizinischen Praxis sollte ein entsprechender Test viel besser sein! So liefert

P (B|A) = 0, 0001 und P (B|A) = 0, 9999 bei gleichem P (A) den eher akzeptablen

Wert P (A|B) ≈ 0, 667.

Abbildung 4: Baumdiagramm für die Übertragung über einen unsicheren Kanal

(b) Übertragung über einen unsicheren Kanal, genaueres Modell (siehe auch Abb. 4).

Wir haben für das Senden ΩS = {0, 1} und für das Empfangen ΩE = {0, 1}, für

beides also Ω = Ωs × ΩE . Das Ereignis, dass Null gesendet wird, ist also

A0 = {0} × ΩE

mit

P (A0 ) = r0

und das Ereignis, dass Eins gesendet wird, ist

A1 = {1} × ΩE

mit

22

P (A1 ) = r1 = 1 − r0

denn A0 ∩ A1 = ∅ und Ω = A0 ∪ A1 . Als bekannt werden vorausgesetzt

p0 = P (1 empfangen|0 gesendet) = P (ΩS × {1}|{0} × ΩE )

p1 = P (0 empfangen|1 gesendet) = P (ΩS × {0}|{1} × ΩE )

Weil

(ΩS × {0}) ∩ (ΩS × {1}) = ∅

und

Ω = (ΩS × {0}) ∪ (ΩS × {1})

haben wir

1 − p0 = P (0 empfangen|0 gesendet) = P (ΩS × {0}|{0} × ΩE )

und analog

1 − p1 = P (1 empfangen|1 gesendet) = P (ΩS × {1}|{1} × ΩE )

Das Ereignis, dass ein Übermittlungsfehler auftritt, sei

B = (0, 1), (1, 0) = ({0} × {1}) ∪ ({1} × {0})

Wir erwarten anschaulich

P (B|A0 ) = P (Fehler|0 gesendet) = P (1 empfangen|0 gesendet) = p0

Dies ist in der Tat richtig, denn

P (Fehler|0 gesendet) = P ({(0, 1), (1, 0)}|{0} × ΩE )

P {(0, 1), (1, 0)} ∩ ({0} × ΩE )

P ({(0, 1)}

=

=

P ({0} × ΩE )

P ({0} × ΩE )

und

P (1 empfangen|0 gesendet) = P (ΩS × {1}|{0} × ΩE )

P (ΩS × {1}) ∩ ({0} × ΩE )

P ({(0, 1)}

=

=

P ({0} × ΩE )

P ({0} × ΩE )

Analog erhält man

P (B|A1 ) = P (Fehler|1 gesendet) = P (0 empfangen|1 gesendet) = p1

Nach der Formel für die totale Wahrscheinlichkeit erhalten wir somit

P (B) = P (A0 ) · P (B|A0 ) + P (A1 )P (B|A1 ) = r0 · p0 + r1 · p1

Wir bezeichnen nun mit C0 das Ereignis, dass wir 0 empfangen, also

C0 = Ωs × {0}

Nach der Formel von Bayes erhält man für P (1 gesendet|0 empfangen)

P (A1 ) · P (C0 |A1 )

P (A0 ) · P (C0 |A0 ) + P (A1 )P (C0 |A1 )

r1 p1

=

r0 (1 − p0 ) + r1 p1

P (A1 |C0 ) =

23

und für P (0 gesendet|0 empfangen)

P (A0 ) · P (C0 |A0 )

P (A0 ) · P (C0 |A0 ) + P (A1 )P (C0 |A1 )

r0 (1 − p0 )

=

r0 (1 − p0 ) + r1 p1

P (A0 |C0 ) =

Man kann die Formel von der totalen Wahrscheinlichkeit auch durch die folgende Regel

über die Baumdiagramme ausdrücken, die man sich leicht anhand der Beispiele plausibel

machen kann:

Die totale Wahrscheinlichkeit eines Ereignisses erhält man aus dem Baumdiagramm, indem man über die Wahrscheinlichkeiten aller zu dem Ereignis

führenden Pfade summiert. Die entlang der Pfade auftretenden Wahrscheinlichkeiten sind dabei zu multiplizieren.

Die Formel von Bayes kann man entsprechend durch die Regel ausdrücken:

Die bedingte Wahrscheinlichkeit P (Ak |B) erhält man aus dem Baumdiagramm,

indem man die Wahrscheinlichkeit längs des Pfades über Ak nach B bestimmt

(durch Multiplikation der entsprechenden Wahrscheinlichkeiten) und diese

dann durch die Wahrscheinlichkeit dividiert, die sich nach der Formel für die

totale Wahrscheinlichkeit für P (B) nach der entsprechenden Diagrammregel

ergibt.

3

3.1

Zufallsvariable

Beispiele, Verteilungsfunktion, Dichtefunktion

Häufig interessiert man sich nicht für das ursprüngliche Zufallsexperiment, sondern für

eine Funktion, die aus dem Ergebnis des Experiments berechnet wird. Beim Würfeln mit

zwei Würfeln könnte dies die Augensumme beider Würfel sein. Man hat in diesem Fall

den Grundraum Ω = Ω0 × Ω0 mit Ω0 = {1, 2, 3, . . . 6} und die Funktion

X : Ω → R,

(ω1 , ω2 ) 7→ ω1 + ω2

Man kann dann nach der Wahrscheinlichkeit fragen, dass die Augensumme kleiner oder

gleich 6 ist, also das Ereignis

A = {ω ∈ Ω | X(ω) ≤ 6}

betrachten (dieses Beispiel wird in den Übungen näher untersucht). Dies motiviert die

folgende Definition:

Definition 3.1.1 Gegeben sei ein Grundraum Ω und als Ereignisse zugelassene Teilmengen von Ω, die die Bedingungen der Definition 1.2.1 erfüllen. Dann heißt eine Funktion

X : Ω → R,

ω 7→ X(ω)

Zufallsvariable oder Zufallsgröße, wenn für alle Intervalle I die Menge

{ω ∈ Ω | X(ω) ∈ I}

24

ein zugelassenes Ereignis ist. Man benutzt dann die folgenden Kurzschreibweisen

{X = a} := {ω ∈ Ω | X(ω) = a}

{X < a} := {ω ∈ Ω | X(ω) < a}

und analoge Kurzschreibweisen für ≤, > und ≥.

Hinweise:

(a) Zuweilen werden allgemeinere Abbildungen mit der Definitionsmenge Ω und einer

von R verschiedenen Menge als Zielmenge Zufallsvariable genannt und der Name

Zufallsgröße bleibt den Abbildungen mit der Zielmenge R vorbehalten. Wir werden

uns zunächst nicht mit solchen allgemeineren Abbildungen beschäftigen.

(b) Um zu überprüfen, ob eine auf Ω definierte Funktion eine Zufallsvariable ist, genügt

es festzustellen, dass {X ≤ b} für alle b ∈ R ein zugelassenes Ereignis ist. Denn wir

können beispielsweise

{a < X ≤ b} = {X ≤ a}c ∩ {X ≤ b}

schreiben und durch die Vereinigung von Folgen von Intervallen mit einem Randpunkt erhält man Intervalle ohne den Randpunkt und umgekehrt erhält man durch

den Durchschnitt von Intervallen ohne den Randpunkt Intervalle mit dem Randpunkt, wie das am Beispiel der Ereignisse für das Glücksrad erklärt wurde.

Definition 3.1.2 Wenn wir R als Ereignisraum für ein Wahrscheinlichkeitsmaß ansehen, dann vereinbaren wir, dass zunächst alle Intervalle und dann alle Teilmengen, die

aus bereits zugelassenen Ereignissen mit den in Definition 1.2.1 aufgeführten Operationen

konstruiert werden können, als Ereignisse zugelassen sind. Also alle Teilmengen, die sich

— wie in Definition 1.2.1 angegeben — mit Vereinigungen von Folgen von Teilmengen und

Bildung des Komplements aus Intervallen konstruieren lassen, sind in R als Ereignisse

zugelassen.

Für in Ω definierte Zufallsvariable X und als Ereignisse zugelassene Teilmengen A ⊂ R

vereinbaren wir die allgemeine Schreibabkürzung

{X ∈ A} := {ω ∈ Ω | X(ω) ∈ A}

Hinweis: Weil {a} = [a − 1, a] ∩ [a, a + 1], sind damit auch Teilmengen mit nur einem

Element zugelassen; solche Ereignisse sind die Elementarereignisse in R.

Die Definitionen 3.1.1 und 3.1.2 erlauben es nun, mit jeder Zufallsvariable ein Wahrscheinlichkeitsmaß in R einzuführen:

Satz 3.1.1 Sei Ω ein Grundraum mit einem Wahrscheinlichkeitsmaß P und einer in Ω

definierten Zufallsvariable X. Dann wird durch

PX (A) := P {ω ∈ Ω | X(ω) ∈ A} = P {X ∈ A}

für beliebige als Ereignisse zugelassenen Teilmengen A von R ein Wahrscheinlichkeitsmaß

in R definiert. Dieses Wahrscheinlichkeitsmaß wird auch Verteilung oder Wahrscheinlichkeitsverteilung von X genannt.

25

Hinweise:

(a) Beachten Sie, dass speziell für Intervalle A =]a, b] gilt

PX ]a, b]) = P ({a < X ≤ b} = P {ω ∈ Ω | a < X(ω) ≤ b}

(b) Der Beweis ist leicht aufgrund der Definitionen zu führen, wenn man beachtet, dass

für beliebige Ereignisse A, B ⊂ R gilt

{X ∈ Ac } = {X ∈ A}c

{X ∈ A ∪ B} = {X ∈ A} ∪ {X ∈ B}

und

Beispiele

(a) Für einen Würfel mit dem Grundraum Ω = {1, 2, 3 . . . 6} haben wir die triviale

Zufallsvariable Ω → R, ω 7→ ω. Wir erhalten das Wahrscheinlichkeitsmaß in R, das

PX (A) =

1

· |A ∩ Ω|

6

für alle als Ereignis zugelassene Mengen A ⊂ R erfüllt. Dabei bezeichnet |A ∩ Ω| die

Zahl der in A ∩ Ω enthaltenen Elemente.

(b) Für das Würfeln mit zwei Würfeln und die Augensumme“ als Zufallsvariable X

”

erhalten wir das Wahrscheinlichkeitsmaß

1

PX (A) = |{(ω1 , ω2 ) | ω1 + ω2 ∈ A}|

36

wobei auch hier |M | die Zahl der Elemente der Menge M bezeichnet. Weitere Einzelheiten dieses Beispiels werden in einer Übungsaufgabe behandelt.

(c) Für das Glücksrad haben wir die triviale Zufallsvariable

X : Ω = ] − π, +π] → R,

ω 7→ ω

und das Wahrscheinlichkeitsmaß

PX (I) =

1

· l I∩ ] − π, +π]

2π

für alle Intervalle I ⊂ R, wobei l(K) die Länge des Intervalls K bezeichnet. Ein

Wahrscheinlichkeitsmaß auf R ist bereits dadurch gegeben, dass wir den Wert für

Intervalle kennen, denn für Ereignisse, die aus Intervallen konstruiert sind, können

wir die Wahrscheinlichkeit nach den Rechenregeln aus Definition 1.2.2 und Satz

1.4.1 berechnen.

(d) Übertragung von n Bits über einen unzuverlässigen Kanal. Hier ist Ω = {g, e}n

und wir betrachten bei festgehaltenem n die Gesamtzahl der Einzelereignisse g der

fehlerfreien Übertragung in ω als Zufallsvariable X(Ω), also

X(ω) = |{1 ≤ k ≤ n | ωk = g}|

Wir haben bereits früher die Wahrscheinlichkeit (bei festgehaltenem n)

n k

n

n−k

p (1 − p)

=

pk (1 − p)n−k

P {X = k} =

k

n−k

berechnet. Wir werden uns später genauer mit diesem Beispiel beschäftigen.

26

(3)

Für die Behandlung von Zufallsvariablen ist die folgende Definition von entscheidender

Bedeutung:

Definition 3.1.3 Sei X eine auf dem Grundraum Ω definierte Zufallsvariable. Dann

heißt die Funktion FX : R → R, die durch

FX (t) := P {X ≤ t} = P {ω ∈ Ω | X(ω) ≤ t}

definiert ist, Verteilungsfunktion von X.

Beispiele:

Abbildung 5: Verteilungsfunktion für einen Würfel

(a) Für die triviale Zufallsvariable bei einem Würfel erhalten wir die Verteilungsfunktion

0 falls t < 1

1

falls 1 ≤ t < 2

6

2

falls 2 ≤ t < 3

FX (t) =

6

..

..

.

.

5

falls 5 ≤ t < 6

16 falls 6 ≤ t

Diese Verteilungsfunktion ist in Abb. 5 grafisch dargestellt.

(b) Für das Glücksrad erhalten wir die Verteilungsfunktion

0

falls t < −π

1

(t

+

π)

falls

−π ≤ t < π

FX (t) =

2π

1

falls t ≥ π

Diese ist in Abb. 6 gezeigt.

27

Abbildung 6: Verteilungsfunktion für das Glücksrad

Folgende allgemeine Eigenschaften von Verteilungsfunktionen sind wichtig:

Satz 3.1.2 Sei X eine Zufallsvariable und FX ihre Verteilungsfunktion. Dann gilt

(a) FX ist monoton wachsend.

(b) lim FX (t) = 0, lim FX (t) = 1.

t→−∞

t→+∞

(c) lim FX (t) = FX (a) für alle a ∈ R (also FX ist rechtsseitig stetig).

t→a+

(d) Für alle a < b gilt

P {a < X ≤ b} = P {ω ∈ Ω | a < X(ω) ≤ b} = FX (b) − FX (a)

(e) Für alle a ∈ R gilt

P {X = a} = P {ω ∈ Ω | X(ω) = a} = FX (a) − lim FX (t)

t→a−

Hinweise zum Beweis:

• (a) und (b) folgen unmittelbar aus der Definition, für den Beweis von (c) und (e)

muß man die Grundregel der Additivität für Folgen von disjunkten Ereignissen

ausnutzen.

• (d) ergibt sich aus

{X ≤ b} = {X ≤ a} ∪ {a < X ≤ b} und {X ≤ a} ∩ {a < X ≤ b} = ∅

28

also

P {X ≤ b} = P {X ≤ a} + P {a < X ≤ b}

wegen der Grundregel der Additivität. Damit hat man

FX (b) = FX (a) + P {a < X ≤ b}

Das durch die Zufallsvariable X definierte Wahrscheinlichkeitsmaß ist durch die Verteilungsfunktion FX eindeutig bestimmt. Dies folgt unmittelbar aus Teilaussage (d). Wir

haben sogar den Satz:

Satz 3.1.3 Sei F : R → R eine Funktion, die die folgenden Bedingungen erfüllt:

(a) F ist monoton wachsend

(b) lim F (t) = 0, lim F (t) = 1

t→−∞

t→+∞

(c) lim F (t) = F (a) für alle a ∈ R

t→a+

Dann gilt: Durch

P (]a, b]) := F (b) − F (a)

wird ein Wahrscheinlichkeitsmaß auf Ω = R definiert, das

P {a} = FX (a) − lim FX (t)

t→a−

für alle a ∈ R erfüllt.

Der Beweis ist elementar, man hat für kompliziertere Ereignisse A ⊂ R die Wahrscheinlichkeit P (A) gemäß den Rechenregeln aus Definition 1.2.2 und Satz 1.4.1 zu definieren.

Abbildung 7: Verteilungsfunktion für die Lebensdauer eines elektronischen Bauelements

Beispiel: Für die Lebensdauer eines elektronischen Bauteils erhalten wir mit einer vom

Bauteil abhängigen Zeitkonstante τ > 0 ein sinnvolles Wahrscheinlichkeitsmaß durch die

Verteilungsfunktion

0

falls t < 0

FT (t) =

− τt

1−e

falls t ≥ 0

Diese ist in Abb. 7 gezeigt. Die Wahrscheinlichkeit, dass die Lebensdauer T (die wir als

Zufallsvariable auffassen können) im Intervall [a, b] liegt, ist also

a

b

P {T ∈ [a, b]} = F (b) − F (a) = e− τ − e− τ

29

Da F stetig ist, haben wir hier P {T ∈ [a, b]} = P {T ∈]a, b]} = P {T ∈]a, b[} für

alle a < b und P {T = a} = 0 für alle a ∈ R.

Für Zufallsvariable, die auf diskreten Wahrscheinlichkeitsräumen definiert sind, die

den Voraussetzungen einer der beiden Teilaussagen von Satz 1.4.2 genügen, haben wir

das Ergebnis:

Satz 3.1.4

(a) Sei Ω = {ω1 , ω2 , ω3 , . . . ωn }, und das Wahrscheinlichkeitsmaß sei durch

pk = P ({ωk }),

mit

0 ≤ pk ≤ 1

und

n

X

pk = 1

k=1

gegeben und X sei eine auf Ω definierte Zufallsvariable. Dann erfüllt die Verteilungsfunktion

X

FX (t) =

pk

k = 1, . . . n

X(ωk ) ≤ t

Sie besitzt an den Funktionswerten von X, also für t = X(ωk ) Sprungstellen und

ist dort rechtsseitig stetig; die Differenz zwischen dem rechts- und dem linksseitigen

Grenzwert ist pk . Zwischen diesen Sprungstellen ist FX (t) konstant.

(b) Sei Ω = {ω1 , ω2 , ω3 , . . .} (also eine Folge unendlich vieler Elemente) und sei das

Wahrscheinlichkeitsmaß durch pk = P ({ωk }) gegeben mit

0 ≤ pk ≤ 1

und

∞

X

pk = 1

k=1

und sei X eine auf Ω definierte Zufallsvariable. Dann erfüllt die Verteilungsfunktion

X

FX (t) =

pk

k∈N

X(ωk ) ≤ t

und sie hat dieselben Eigenschaften wie in Teilaussage (a) mit dem Unterschied,

dass hier eine Folge unendlich vieler Sprungstellen in t = X(ωk ) vorliegt.

Definition 3.1.4 Wir nennen eine Zufallsvariable X eine diskrete Zufallsvariable, wenn

die Menge der möglichen Werte {X(ω) | ω ∈ Ω} nur aus endlich vielen Elementen besteht oder durchnummeriert werden kann (aus einer Folge von Elementen besteht, also

abzählbar unendlich viele Elemente hat).

Hinweise:

(a) Beachten Sie, dass die Elemente eines reellen Intervalls [a, b] mit a < b nicht durchnummeriert werden können!

(b) Wenn X eine diskrete Zufallsvariable ist, dann wissen wir nicht, ob der Grundraum Ω

endlich viele oder abzählbar unendlich viele Elemente besitzt. Wir haben dennoch

eine Situation, die analog zu der des Satzes 1.4.2 ist. Wir können die Menge der

30

möglichen Funktionswerte durchnummerieren und bezeichnen diese mit xk (k läuft

von 1 bis n oder durchläuft ganz N). Wir definieren dann die Zahlen

pk := P {X = xk } = P {ω ∈ Ω | X(ω) = xk } = PX (xk )

Weil Ω =

∞

S

{ω ∈ Ω | X(ω) = xk }, haben wir

k=1

1 = P (Ω) = P

∞

[

{ω ∈ Ω | X(ω) = xk } =

k=1

∞

X

k=1

P {ω ∈ Ω | X(ω) = xk } =

∞

X

pk

k=1

Weiterhin gilt für alle Ereignisse A ⊂ R

P (X ∈ A) = 0 wenn xk 6∈ A für alle k

und insbesondere

P {x} = 0 für alle x 6= xk

und allgemeiner

P (X ∈ A) =

X

pk

k∈N

xk ∈ A

Die Verteilungsfunktion ist dann gegeben durch

FX (t) = P {X ≤ t} =

X

pk

k∈N

xk ≤ t

Wenn die Menge der möglichen Werte {X(ω) | ω ∈ Ω} nur aus endlich vielen

Elementen besteht, dann hat die Verteilungsfunktion die Gestalt einer Treppen”

funktion“ ähnlich wie beim Würfel (siehe Abb. 5); zwischen den Werten xk ist sie

konstant, bei jedem xk macht sie einen Sprung um pk (sie ist dabei rechtsseitig

stetig). Statt FX (t) kann man auch die Zahlen pk grafisch darstellen, dies erfolgt

häufig als Balken- oder Stabdiagramm. Ein Beispiel für eine diskrete Zufallsvariable

wurde als Beispiel (d) nach Satz 3.1.1 (Übertragung von n Bits über einen unzuverlässigen Kanal) angegeben. Diese Zufallsvariable X kann die Werte 0, 1, 2, . . . n

annehmen, ist also eine diskrete Zufallsvariable (wir haben hier n + 1 mögliche Werte und müssen berücksichtigen,

dass die Numerierung bei 0 anfängt). Die Zahlen

pk = P {X = k} sind in Gleichung (3) angegeben. Aus dem binomischen Lehrsatz

n

P

ergibt sich sofort, dass tatsächlich

pk = 1.

k=0

(c) Wenn die Verteilungsfunktion FX (t) in Gestalt einer Treppenfunktion“ vorliegt,

”

dann sind die möglichen Werte {X(ω) | ω ∈ Ω} die Sprungstellen xk von FX (t) und

die zugehörigen Wahrscheinlichkeiten ergeben sich aus der Höhe des Sprungs in xk :

pk = P {X = xk } = FX (xk ) − lim FX (t)

t→xk −

31

FX(t)

p3 = 1 −

p2 =

p1 =

p0 =

3

5

−

1

2

=

3

5

=

2

5

1

10

1

4

1

4

t

Abbildung 8: Zur Bestimmung der Wahrscheinlichkeiten pk aus der Höhe der Sprünge“

”

der Verteilungsfunktion

Beispiel:

FX (t) =

0

1

4

1

2

3

5

1

falls

falls

falls

falls

falls

führt auf x0 = 0, p0 = 14 , x1 = 1, p1 =

p3 = 1 − 53 = 25 (siehe auch die Abb. 8).

1

,

4

t<0

0≤t<1

1≤t<2

2≤t<3

3≤t

x2 = 2, p2 =

3

5

−

1

2

=

1

,

10

x3 = 3,

(d) Wenn eine diskrete

Zufallsvariable X die Werte x1 , x2 , x3 . . . xn annimmt und pk =

P {X = xk } , dann heißt das n-tupel p1 , p2 , p3 . . . pn Verteilung von X.

Die meisten Zufallsvariablen, die in der Praxis vorkommen, sind diskret oder erfüllen die

in der folgenden Definition genannte Bedingung:

Definition 3.1.5 Wenn eine Verteilungsfunktion einer Zufallsvariablen X die Eigenschaft hat, dass

Zt

FX (t) =

f (u)du

für alle t ∈ R

(4)

−∞

wobei die Funktion f stückweise stetig ist sowie

f (t) ≥ 0 für alle t ∈ R

und

Z+∞

f (t)dt = 1

(5)

−∞

erfüllt, dann heißt f (t) Wahrscheinlichkeitsdichte, Dichtefunktion oder Dichte. Wir werden dann sagen, die Zufallsvariable X besitzt eine Dichtefunktion.

32

Hinweise:

(a) Wenn FX durch (4) gegeben ist und f (t) in einem Intervall ]a, b[ stetig ist, dann gilt

zusätzlich nach dem Hauptsatz der Differential- und Integralrechnung

FX0 (t) = f (t)

für alle t ∈]a, b[

(b) Eine Verteilungsfunktion, die mit einer Dichte gemäß (4) gegeben ist, ist stetig. Das

zugehörige Wahrscheinlichkeitsmaß erfüllt damit

P {X = a} = 0

für alle a ∈ R

(c) Wenn FX durch (4) gegeben ist, dann gilt

P (a ≤ X ≤ b} =

Zb

f (x)dx

a

Dies folgt aus Satz 3.1.2 sowie Hinweis b).

(d) Betrachten wir ein Intervall ]a, b[, in dem die Dichtefunktion stetig ist (wir haben

vorausgesetzt, dass sie stückweise stetig ist). Nach Hinweis c) haben wir für die

Wahrscheinlichkeit, dass X(ω) zwischen x0 und x0 + ∆x liegt

P (x0 ≤ X ≤ x0 + ∆x} =

x0Z+∆x

f (x)dx

x0

und falls a < x0 < x0 + ∆x < b haben wir für kleine Werte von ∆x die Näherung

P (x0 ≤ X ≤ x0 + ∆x} ≈ f (x0 )∆x

Diese Wahrscheinlichkeit ist also für genügend kleine ∆x näherungsweise proportional zur Länge des Intervalls ∆x mit einem Proportionalitätsfaktor f (x0 ). Dies

begründet den Namen Dichte“.

”

(e) Jede stückweise stetige und in ganz R definierte Funktion f (t), die die beiden Bedingungen

Z+∞

f (t) ≥ 0 für alle t ∈ R

und

f (t)dt = 1

−∞

erfüllt, definiert durch

Zt

FX (t) :=

f (u)du

für alle t ∈ R

−∞

die Verteilungsfunktion einer Zufallsvariablen X. Wenn nur die Verteilungsfunktion

FX (t) gegeben ist, dann kann man stets als Grundraum Ω = R wählen und durch

P ]a, b] := FX (b) − FX (a)

ein Wahrscheinlichkeitsmaß auf R definieren (siehe Satz 3.1.3).

33

(f) Zahlreiche Wahrscheinlichkeitsmaße der Praxis werden durch ihre Wahrscheinlichkeitsdichte charakterisiert.

(g) Wenn umgekehrt eine Zufallsvariable X die Eigenschaft

P {X = a} = 0

für alle a ∈ R

hat, dann ist ihre Verteilungsfunktion FX (t) stetig (wegen Teilaussage (e) von Satz

3.1.2). Dies bedeutet jedoch nicht, dass notwendigerweise eine stückweise stetige

(oder etwas allgemeinere vernünftige“) Dichtefunktion existiert, die die Vertei”

lungsfunktion nach Gleichung (4) liefert. Allerdings scheinen derartige exotische

Zufallsvariable, die zwar eine stetige Verteilungsfunktion FX (t) haben, aber keine

Wahrscheinlichkeitsdichte besitzen, in praktischen Anwendungen recht selten vorzukommen.

FX (t)

!"ω#

t

ω

Abbildung 9: Beispiel mit {X(ω) | ω ∈ Ω} = [0, 23 ] (links), zugehörige Verteilungsfunktion

FX (t) (rechts)

(h) Man könnte meinen, dass eine Zufallsvariable, bei der die Menge der möglichen

Werte ein nichtleeres Intervall enthält, also bei der

[a, b] ⊂ {X(ω) | ω ∈ Ω} mit a < b

eine stetige Verteilungsfunktion oder gar eine Dichtefunktion besitzt. Dies ist nicht

der Fall, wie das folgende Gegenbeispiel zeigt: Wir nehmen als Grundraum Ω = [0, 1]

mit dem durch P (]a, b]) = b − a gegebenen Wahrscheinlichkeitsmaß. Als Zufallsvariable nehmen wir

falls ω ∈ [0, 13 [

ω

1

falls ω ∈ [ 13 , 23 [

X(ω) =

3

ω − 31 falls ω ∈ [ 32 , 1]

Diese Zufallsvariable ist in Abb. 9 (links) grafisch dargestellt. Offensichtlich ist

2

{X(ω) | ω ∈ Ω} = [0, ]

3

1

1 2

1

aber P {X = 3 } = P ([ 3 , 3 ]) = 3 und die Verteilungsfunktion FX (t) hat einen

Sprung in t = 31 . Man kann sie explizit angeben (siehe auch Abb. 9 rechts):

0

falls t < 0

t

falls t ∈ [0, 13 [

FX (t) =

t + 13 falls t ∈ [ 13 , 32 [

1

falls t ≥ 23

34

Beispiele:

(a) Beim Glücksrad haben wir die Wahrscheinlichkeitsdichte

0 falls t ≤ −π oder t > π

f (t) =

1

falls −π < t ≤ +π

2π

Die konstante Dichte drückt aus, dass die Wahrscheinlichkeit über den Winkelbereich ] − π, π] gleichverteilt ist. Verteilungsfunktion FX (t) und Dichtefunktion f (t)

sind in Abb. 10 gezeigt. Beachten Sie, dass f (t) nur unter dem Integral von Bedeutung ist. Damit kann der Funktionswert f (t) ohne irgendwelche Änderungen

bei der Verteilungsfunktion FX (t) an einzelnen Punkten abgeändert werden. Man

kann die Dichte beim Glücksrad also beispielsweise in t = −π abändern, indem man

1

setzt. An den Sprungstellen von f (t) in t = ±π ist FX (t) nicht

f (−π) = 2π

differenzierbar, außerhalb der Sprungstellen, d.h. für t 6= ±π gilt FX0 (t) = f (t).

Abbildung 10: Verteilungsfunktion FX (t) und zugehörige Wahrscheinlichkeitsdichte f (t)

für das Glücksrad

(b) Bei der Lebensdauer von elektronischen Bauelementen haben wir die Dichte

0

falls t ≤ 0

f (t) =

1

− τt

·e

falls t > 0

τ

(6)

Diese Dichte drückt aus, dass die Wahrscheinlichkeit für große Lebensdauern exponentiell abnimmt. Auch hier können wir ohne Auswirkung auf die Verteilungsfunktion FT (t) die Dichtefunktion abändern durch f (0) = τ1 . An der Sprungstelle

t = 0 von f (t) ist FT (t) nicht differenzierbar, für t 6= 0 gilt FT0 (t) = f (t) (siehe auch

Abb. 11).

35

T

t

Abbildung 11: Verteilungsfunktion FT (t) und zugehörige Wahrscheinlichkeitsdichte f (t)

für die Lebensdauer von elektronischen Bauelementen (Zahlenwert τ = 5)

3.2

Erwartungswert und Varianz

Definition 3.2.1 (a) Wenn X eine diskrete Zufallsvariable mit endlich vielen Werten

xk ist, dann ist ihr Erwartungswert durch

n

n

X

X

E(X) :=

P {X = xk } · xk =

p k · xk

(7)

k=1

k=1

definiert.

(b) Wenn X eine diskrete Zufallsvariable mit abzählbar unendlich vielen Werten xk ist,

dann ist ihr Erwartungswert durch

∞

∞

X

X

p k · xk

(8)

E(X) :=

P {X = xk } · xk =

k=1

k=1

definiert, wenn diese Reihe absolut konvergent ist, d.h.

!

n

X

lim

pk · |xk |

n→∞

k=1

existiert.

(c) Wenn X eine Zufallsvariable mit stückweise stetiger Wahrscheinlichkeitsdichte f (x)

ist, dann ist ihr Erwartungswert durch

Z+∞

E(X) :=

f (x) · x dx

(9)

−∞

definiert, wenn dieses uneigentliche Integral absolut konvergent ist, d.h.

Z+∞

f (x) · |x| dx < ∞

−∞

36

Hinweise:

(a) Der Erwartungswert wird hier nur für die in den Anwendungen fast ausschließlich vorkommenden Sonderfälle definiert. Eine allgemeinere Definition für beliebige

Zufallsvariablen ist möglich, aber ihre Formulierung würde erheblichen Platz und

erhebliche Zeit beanspruchen

(b) Aus der absoluten Konvergenz einer Reihe folgt die Konvergenz der Reihe, aber umgekehrt gibt es konvergente Reihen, die konvergieren, aber nicht absolut konvergent

∞

P

sind, z.B. die alternierende harmonische Reihe

(−1)k+1 · k1 . Entsprechend folgt

k=1

aus der absoluten Konvergenz eines uneigentlichen Integrals, dass das uneigentliche

Integral selbst existiert (auch dabei ist die Umkehrung falsch). Es ist üblich und

hat technische Vorteile, hier etwas mehr zu fordern, als für die bloße Existenz der

in der Definition auftretenden unendlichen Reihe bzw. des uneigentlichen Integrals

notwendig wäre.

(c) Es gibt Zufallsvariable, für die der Erwartungswert nicht existiert (Beispiele in den

Übungen und am Schluss dieses Unterabschnitts). Sie kommen in der Praxis jedoch

recht selten vor.

(d) Hier werden nicht immer die Gleichungen für den Fall endlich vieler Werte xk und

abzählbar unendlich vieler xk getrennt aufgeschrieben, sondern es wird in vielen

Fällen nur die allgemeinere Form (8) angeben. Wenn notwendig, erhält man daraus

die Form (7), indem man pk = 0 für k > n setzt.

Beispiele:

(a) Bei einem Würfel ist Ω = {1, 2, . . . 6}, X(ω) = ω und P {X = k} = pk =

alle k = 1, 2, . . . 6. Wir erhalten

E(X) =

6

X

k=1

pk · k =

6

X

1

k=1

6

·k =

1

6

für

6

1 X

21

7

·

k=

= = 3, 5

6 k=1

6

2

Der Erwartungswert ist hier also einfach der Mittelwert. Man kann (7) auch als

gewichteten Mittelwert ansehen. Eine andere Zufallsvariable führt hier zum selben

Erwartungswert: X2 (1) = X2 (2) = X2 (3) = 3, X2(4) = X2 (5) = X2 (6) = 4 nimmt

die Werte x1 = 3 und x2 = 4 mit p1 = P {X2 = 3} = 12 und p2 = P {X2 = 4} = 12

an und wir erhalten denselben Erwartungswert

1

1

7

E(X2 ) = P {X2 = 3} · 3 + P {X2 = 4} · 4 = · 3 + · 4 =

2

2

2

(b) Für das Glücksrad mit der auf ] − π, +π] konstanten Dichte haben wir

Z+∞

Z+π

1

E(X) =

f (x) · x dx =

· x dx = 0

2π

−π

−∞

und wir haben tatsächlich den Mittelwert der möglichen Winkel erhalten.

37

(c) Bei der Lebensdauer eines elektronischen Bauelements haben wir die Dichtefunktion

in (6) angegeben. Für den Erwartungswert erhalten wir hier

Z∞

E(T ) =

x ∞

1 −x

e τ x dx = −e− τ 0 −

τ

0

Z∞

x ∞

x

(−e− τ )dx = −τ e− τ 0 = τ

0

Die Zeitkonstante τ hat hier also die Rolle des Erwartungswertes der Lebensdauer.

Bei zwei reellwertigen Funktionen können wir deren Summe dadurch definieren, dass wir

die Funktionswerte addieren, entsprechendes gilt für das Vielfache einer Funktion. Dies

ist für Zufallsvariable genauso möglich:

Definition 3.2.2 Sei X eine Zufallsvariable, die im Ereignisraum Ω definiert ist und sei

c ∈ R und sei g : R → R eine stückweise stetige Funktion. Dann wird definiert:

c · X : Ω → R,

|X| : Ω → R,

g(X) : Ω → R,

ω→

7 c · X(ω)

ω→

7 |X(ω)|

ω→

7 g X(ω)

Insbesondere für jede in ganz R definierte stetige Funktion g wird mit dieser Definition für

jede Zufallsvariable X eine neue Zufallsvariable g(X) erklärt. Für deren Erwartungswert

gilt der folgende

Satz 3.2.1 Sei g : R → R stetig, X : Ω → R, ω 7→ X(ω) eine diskrete Zufallsvariable

oder eine Zufallsvariable mit stückweise stetiger Dichtefunktion fX (t). Die Zufallsvariable

Y sei durch Y = g(X) definiert und es sei

∞

X

k=0

|g(xk )| ·

pX

k

<∞

Z+∞

|g(u)|fX (u)du < ∞

bzw.

−∞

Dann gilt für den Erwartungswert

∞

X

g(xk ) · pX

E(Y ) = E g(X) =

k

k=1

wenn X eine diskrete Zufallsvariable mit pX

k = P {X = xk } ist bzw.

Z+∞

E(Y ) = E g(X) = g(u)fX (u)du

−∞

wenn fX (u) die Dichtefunktion von X ist.

Beweisskizze: (nur für den Fall einer diskreten Zufallsvariablen X) Wenn X diskret ist,

dann ist auch Y = g(X) diskret. Wir bezeichnen die möglichen Werte von Y mit yl und

definieren die Mengen

Il := {k ∈ N | g(Xk ) = yl }

38

Falls g injektiv ist, enthält jede solche Menge genau ein Element, ansonsten kann sie

mehrere, auch unendlich viele Elemente enthalten. Wir haben für alle vorkommenden l

X

X X

P {Y = yl } = P {g(X) = yl } =

P {X = xk } =

pk

k∈Il

k∈Il

Für den Erwartungswert gilt damit

∞

X

E(Y ) = E g(X) =

yl P {Y = yl }

l=1

=

∞

X

l=1

yl

X

k∈Il

pX

k

=

∞ X

X

l=1 k∈Il

g(xk )pX

k

=

∞

X

g(xk )pX

k

k=1

Satz 3.2.2 Sei X eine diskrete Zufallsvariable oder eine Zufallsvariable mit stückweise

stetiger Dichtefunktion, deren Erwartungswert E(X) existiert.

Dann existiert der Erwartungswert der Zufallsvariablen aX + b und |X| und es gilt

und

E(aX + b) = aE(X) + b

E(|X|) ≥ E(X)

Der Beweis ist elementar und mit Hilfe der Rechenregeln für Summen, Reihen und Integrale leicht zu führen. E(|X|) existiert, weil bei der Definition des Erwartungswertes die

absolute Konvergenz der Reihe bzw. des Integrals vorausgesetzt wurde.

Der Erwartungswert gibt nur eine sehr eingeschränkte Information über X. So besagt

E(X) = 0 nur, dass die Ereignisse X = x oder X ∈ [x, x+∆x] mit ihrer Wahrscheinlichkeit

gewichtet, symmetrisch zum Ursprung liegen. Es ist aber auch von Interesse, wie sehr sie

streuen:

Definition 3.2.3 Sei X eine Zufallsvariable und sei µ := E(X), µ ∈ R (die Existenz des

Erwartungswertes wird also vorausgesetzt). Dann wird die Varianz von X definiert als

Var(X) := E (X − µ)2

wenn dieser Erwartungswert existiert. In diesem Fall wird die Streuung oder Standardabweichung von X als

p

σ(X) := Var(X)

definiert.

Hinweise:

(a) Aufgrund der Definition ist klar, dass für alle Zufallsvariable, für die die Varianz

existiert, Var(X) ≥ 0 gilt.

(b) Für jede Zufallsvariable mit einer stückweise stetigen Wahrscheinlichkeitsdichte f (x)

ist

Z+∞

Var(X) =

f (x)(x − µ)2 > 0

−∞

39

wenn die Varianz existiert. Für eine diskrete Zufallsvariable ist

∞

X

Var(X) =

pk (xk − µ)2

k=1

und der Fall Var(X) = 0 kann nur auftreten, wenn für ein k die Wahrscheinlichkeit

pk = P {X = µ} = 1

ist, das Wahrscheinlichkeitsmaß PX also trivial ist.

(c) In den Anwendungen wird meist die Standardabweichung angegeben, da die Maßeinheit von X (Länge, Spannung, Stromstärke) und von σ(X) übereinstimmen.

Satz 3.2.3 Sei X eine Zufallsvariable, für die Var(X) existiert, und seien a, b ∈ R.

Dann existiert auch der Erwartungswert E(X 2 ) und es gilt:

2

Var(aX + b) = a2 Var(X)

und

Var(X) = E(X 2 ) − E(X)

Beweisskizze: Sei µ := E(X). Wir haben (X − µ)2 = X 2 − 2µX + µ2 und damit

muss

2

2

aufgrund von Satz 3.2.1 und Satz 3.2.2 auch E(X ) existieren, wenn E (X −µ) existiert.

Aufgrund von Satz 3.2.2 gilt

E(aX + b) = aE(X) + b = aµ + b

2 Var(aX + b) = E aX + b − E(aX + b)

= E (aX + b − aµ − b)2

= E a2 (X − µ)2 = a2 E (X − µ)2 ) = a2 Var(X)

Var(X) = E(X 2 − 2µX + µ2 ) = E(X 2 ) − 2µE(X) + µ2

2

= E(X 2 ) − 2µ2 + µ2 = E(X 2 ) − µ2 = E(X 2 ) − E(X)

Beispiele:

(a) Bei einem Würfel war µ =

Varianz erhält man

Var(X) =

7

2

= E(X) = E(X2 ) (siehe das frühere Beispiel). Für die

6

X

k=1

6

pk (k − µ)2 =

1

7

(3 − )2 +

2

2

Die beiden Zufallsvariablen haben also

unterschiedliche Varianz.

Var(X2 ) =

1X

7

35

(k − )2 =

6 k=1

2

12

1

7

1 1 1 1

1

(4 − ) = · + · =

2

2

2 4 2 4

4

denselben Erwartungswert, aber eine sehr

(b) Beim Glücksrad haben wir

1

Var(X) =

2π

Z+π

1 1 3 +π π 2

x2 dx =

x

=

2π 3 −π

3

−π

(c) Bei der Lebensdauer eines elektronischen Bauelements haben wir

Z∞

t

1

Var(T ) =

(t − τ )2 e− τ dt = τ 2

τ

0

Also erhält man hier σ(T ) = τ (der Erwartungswert war ebenfalls E(T ) = τ ).

40

Anmerkungen:

(a) Es gibt Zufallsvariable, für die kein Erwartungswert existiert. Wir betrachten als

Beispiel die durch die Dichtefunktion

(

0

falls x < 1

f (x) = 1

falls x ≥ 1

x2

gegebene Verteilung. Der zugehörige Erwartungswert existiert nicht, weil das uneiR∞

nicht existiert.

gentliche Integral dx

x

1

(b) Wenn wir das gerade angegebene Beispiel etwas abändern, erhalten wir eine Verteilung, für die zwar E(X) existiert, aber E(X 2 ) nicht existiert. Wir betrachten die

Dichtefunktion

(

0

falls x < 1

f (x) = 2

falls x ≥ 1

x3