1.6 Wichtige Verteilungsmodelle

Werbung

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

1.6 Wichtige Verteilungsmodelle

Wir behandeln hier nur Binomial-, Poisson- und Normalverteilung. Einige weitere Verteilungsmodelle

werden direkt dort eingeführt, wo sie benötigt werden.

1.6.1 Binomialverteilung

Konstruktionsprinzip:

• Ein Zufallsexperiment wird n mal unabhängig durchgeführt.

• Wir interessieren uns jeweils nur, ob ein bestimmtes Ereignis A eintritt oder nicht.

• X = Häufigkeit, mit der Ereignis A bei n unabhängigen Versuchen eintritt“.

”

• Träger von X : X = {0, 1, 2, . . . , n}.

1 Wahrscheinlichkeitsrechnung

155

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Herleitung der Wahrscheinlichkeitsfunktion:

• Bezeichne π = P (A) die Wahrscheinlichkeit für A in einem Experiment.

• Das Ereignis {X = x} tritt z.B. auf, wenn in den ersten x Versuchen A eintritt und anschließend

nicht mehr. Die Wahrscheinlichkeit dafür ist

P (A1 ∩ . . . ∩ Ax ∩ Āx+1 ∩ . . . ∩ Ān)

• Insgesamt gibt es

Damit gilt:

1 Wahrscheinlichkeitsrechnung

n

x

=

π

. . · π} (1 − π) · . . . · (1 − π)

| · .{z

|

{z

}

x mal

n−x mal

=

π (1 − π)

x

n−x

.

Möglichkeiten für die Verteilung der x Erfolge (Auftreten von A) auf n Plätze.

n

x

n−x

P (X = x) =

π (1 − π)

.

x

156

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Definition 1.57.

Eine Zufallsvariable heißt binomialverteilt mit den Parametern n und π , kurz X ∼ B(n, π), wenn sie

die Wahrscheinlichkeitsfunktion

n

x

n−x

π (1 − π)

, x = 0, 1, . . . , n

x

f (x) =

0,

sonst

besitzt.

Die B(1, π)-Verteilung heißt auch Bernoulliverteilung.

1 Wahrscheinlichkeitsrechnung

157

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

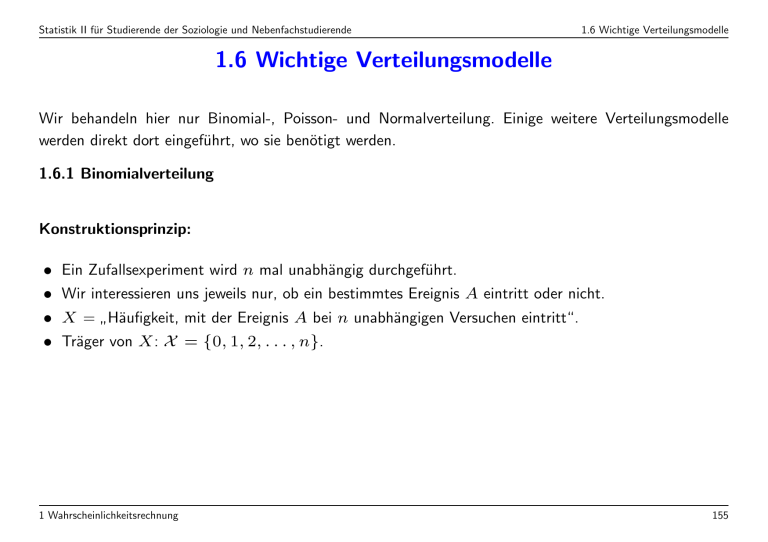

Wahrscheinlichkeitshistogramme von Binomialverteilungen mit n = 10

π = 0.1

π = 0.25

0.4

0.4

0.3 0.3 0.2

0.2

0.1

0.1

0

0

1

2

3

4

5

6

7

8

0

π = 0.5

0.4

0.3 0.3 0.2

0.2

0.1

0.1

0

1

2

1

2

3

4

5

7 8

9 10

6

7 8

9 10

π = 0.75

0.4

0

6

0

9 10

3

4

5

1 Wahrscheinlichkeitsrechnung

6

7 8

0

9 10

0

1

2

3

4

5

158

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Erwartungswert und Varianz:

• Zur Berechnung von Erwartungswert und Varianz der Binomialverteilung ist folgende Darstellung

hilfreich:

X = X1 + . . . + Xn

mit den binären Variablen

1 falls A beim i-ten Versuch eintritt,

Xi =

0 falls Ā beim i-ten Versuch eintritt.

• Die Xi sind stochastisch unabhängig mit

E(Xi)

=

0 · P ({Xi = 0}) + 1 · P ({Xi = 1}) = π

Var(Xi)

=

E(Xi ) − (E(Xi)) = 1 · P ({Xi = 1}) − π = π − π = π(1 − π).

1 Wahrscheinlichkeitsrechnung

2

2

2

2

159

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

• Erwartungswert der Binomialverteilung:

E(X) = E(X1 + . . . + Xn) = E(X1) + . . . + E(Xn) = nπ

Die direkte Berechnung über

n

n

X

i

n−i

π (1 − π)

= . . . = nπ

E(X) =

i

i

i=1

ist deutlich komplizierter!

• Varianz der Binomialverteilung:

Var(X) = Var(X1 + . . . + Xn) = Var(X1) + . . . + Var(Xn) = nπ(1 − π)

1 Wahrscheinlichkeitsrechnung

160

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Bsp. 1.58.

Risikobereite Slalomfahrer stürzen mit W’keit 10%, vorsichtigere mit 2%.

a) Wie groß sind jeweils die Wahrscheinlichkeiten, dass von 20 Fahrern mindestens einer stürzt?

b) Vergleichen Sie die durchschnittlich zu erwartende Anzahl von Stürzen von je 100 Rennläufern!

Beschreibung der Situation durch ein Binomialmodell

• Xr Anzahl der Stürze der risikobereiten Fahrer

Xv Anzahl der Stürze der vorsichtigen Fahrer

• Trefferwskten πr , πv

• n Anzahl der Rennläufer der jeweiligen Kategorie.

• Unabhängigkeit der Versuche nicht ganz unproblematisch, aber hier vorausgesetzt.

a) n = 20, gesucht: P ({Xr ≥ 1}), P ({Xv ≥ 1}), wobei:

n

k

n−k

P ({Xr = k}) =

· π · (1 − π)

k

Dann gilt

P ({Xr ≥ 1}) = P ({Xr = 1}) + P ({Xr = 2}) + . . . + P ({Xr = 20})

1 Wahrscheinlichkeitsrechnung

161

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Zur Berechnung einfacher:

P ({Xr ≥ 1})

1 − P ({Xr = 0})

n

0

n−0

1−

· πr · (1 − π)

0

20

0

20

1−

· (0.1) · (1 − 0.1)

0

20!

20

· 1 · (0.9)

1−

0!20!

=

=

=

=

≈

1 − 0.1216 ≈ 0.8784

Analog:

P ({Xv ≥ 1})

=

=

=

≈

1 Wahrscheinlichkeitsrechnung

1 − P ({Xv = 0})

n

0

n−0

1−

· πv · (1 − πv )

0

20

0

20

1−

· (0.02) · (0.98)

0

1 − 0.6676 ≈ 0.332

162

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

b) Durchschnittlich erwartete Anzahl =

ˆ Erwartungswert

E(Xr ) = n · πr

und

E(Xv ) = n · πv

E(Xr ) = 100 · 0.1 = 10

und

E(Xv ) = 100 · 0.02 = 2.

also

Für den Vergleich ergibt sich damit

E(Xr )

10

=

= 5.

E(Xv )

2

Es gilt allgemein (für zwei binomialverteilte ZV):

n · πr

πr

E(Xr )

=

=

.

E(Xv )

n · πv

πv

1 Wahrscheinlichkeitsrechnung

163

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Exkurs: Zur Problematik der Argumentation mittels natürlicher Häufigkeiten“.

”

Man würde demgemäß die Wahrscheinlichkeit πr = 0.1 kommunizieren als von 100 stürzen 10

”

Rennläufer“.

Diese Interpretation läuft Gefahr, die beträchtliche Variabilität zufälliger Prozesse zu verschleiern. In der

Tat ist hier die Wahrscheinlichkeit, dass genau 10 von 100 Läufern stürzen,

100

10

90

· 0.1 · 0.9 = 0.13,

P (X = 10) =

10

also lediglich etwa 13%. Natürliche Häufigkeiten“ müssen also unbedingt als Durchschnittswerte bzw.

”

Erwartungswerte begriffen werden.

1 Wahrscheinlichkeitsrechnung

164

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Eigenschaften der Binomialverteilung:

• Symmetrieeigenschaft (vertausche Rolle von A und Ā):

Sei X ∼ B(n, π) und Y = n − X . Dann gilt Y ∼ B(n, 1 − π).

• Summeneigenschaft: Seien X ∼ B(n, π) und Y ∼ B(m, π). Sind X und Y unabhängig, so gilt

X + Y ∼ B(n + m, π)

Entscheidend: Gleiches π !

1 Wahrscheinlichkeitsrechnung

165

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

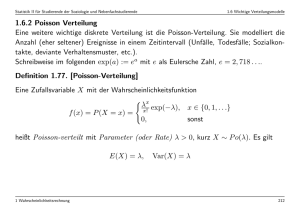

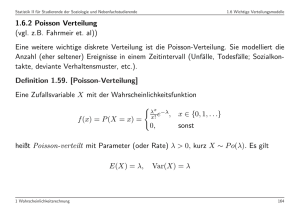

1.6.2 Poisson Verteilung

(vgl. z.B. Fahrmeir et. al))

Eine weitere wichtige diskrete Verteilung ist die Poisson-Verteilung. Sie modelliert die Anzahl (eher

seltener) Ereignisse in einem Zeitintervall (Unfälle, Todesfälle; Sozialkontakte, deviante Verhaltensmuster,

etc.).

Definition 1.59. [Poisson-Verteilung]

Eine Zufallsvariable X mit der Wahrscheinlichkeitsfunktion

λx e−λ, x ∈ {0, 1, . . .}

x!

f (x) = P ({X = x}) =

0,

sonst

heißt Poisson-verteilt mit Parameter (oder Rate) λ > 0, kurz X ∼ P o(λ). Es gilt

E(X) = λ,

1 Wahrscheinlichkeitsrechnung

Var(X) = λ

166

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Die Poisson-Verteilung kann auch als Näherungsmodell für eine Binomialverteilung gesehen werden, wenn

die Anzahl der Versuchswiederholungen n groß und die Trefferwahrscheinlichkeit“ π sehr klein ist (seltene

”

Ereignisse!).

Der Erwartungswert λ ist dann gleich n · π.

Es gilt also abgekürzt geschrieben

X ∼ B(n, π) =⇒ X u P o(n · π)

n groß

π klein

Hat man mehrere unabhängige Poisson-Prozesse“, also dynamische Simulationen, bei denen die Ereig”

nisanzahl Poisson-verteilt ist, also z.B. verschiedene deviante Verhaltensmuster, so ist die Gesamtanzahl

der einzelnen Ereignisanzahlen wieder Poisson-verteilt: genauer gilt

1 Wahrscheinlichkeitsrechnung

167

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Satz 1.60. [Addition von Poisson-verteilten Zufallsvariablen]

Sind X ∼ P o(λX ), Y ∼ P o(λY ) voneinander unabhängig, so gilt

X + Y ∼ P o(λX + λY ).

Beachte, die Unabhängigkeit (genauer die Unkorreliertheit, siehe später) ist wesentlich. Hat man als

Extremfall, z.B. zwei Ereignisse bei denen das eine das andere voraussetzt (Scheidungen, Scheidungen

mit Streit um das Sorgerecht für Kinder), so ist die Gesamtzahl nicht mehr Poisson-verteilt.

Es muss gelten, wenn X + Y Poisson-verteilt wäre:

Var(X + Y ) = E(X + Y ) = E(X) + E(Y ) = Var(X) + Var(Y ),

was aber bei abhängigen (korrelierten) X und Y verletzt ist.

1 Wahrscheinlichkeitsrechnung

168

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Bsp. 1.61.

Max geht gerne auf Open-Air Festivals. Im Durchschnitt trifft er dort 6 weibliche Bekannte und 3

männliche Bekannte.

a) Wie groß ist die Wahrscheinlichkeit, dass er genau 6 weibliche Bekannte trifft?

b) Wie groß ist die Wahrscheinlichkeit, dass er mindestens einen männlichen Bekannten trifft?

c) Berechnen Sie die Wahrscheinlichkeit, das er weder einen männlichen noch eine weibliche Bekannte

trifft, auf 2 verschiedene Arten. Diskutieren Sie eventuell zu treffende Zusatzannahmen.

a) Sei X die Anzahl der getroffenen weiblichen Bekannten und Y die Anzahl der getroffenen

männlichen Bekannten.

Es gilt (bzw. es gelte)

X

∼

P o(6),

λX = 6

Y

∼

P o(3),

λY = 3

λxX −λX

66 −6

P (X = x) =

e

⇒ P (X = 6) = e = 0.1606

x!

6!

b) P ({Y ≥ 1}) = 1 − P ({Y = 0}). Also: P (Y ≥ 1) = 1 −

1 Wahrscheinlichkeitsrechnung

30 −3

0! e

= 1 − 0.0498 = 0.9502

169

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

c) Unter Unabhängigkeit von X und Y gilt:

Z = X + Y ∼ P o(λX + λY ),

also

(6 + 3)0 −(6+3)

P ({Z = 0}) =

e

= 0.0001

0!

Alternative Berechnung:

keinen Bekannten“ bedeutet {X = 0} ∩ {Y = 0}

”

P ({X = 0} ∩ {Y = 0})

unabh.

=

P ({X = 0}) · P ({Y = 0}) =

=

λ0X −λX λ0Y −λY

·

=

e

e

0!

0!

=

(λX + λY )0 −(λX +λY )

e

= ...

0!

Die Unabhängigkeitsannahme ist zentral, in dem Beispiel ist das Treffen eines männlichen und einer

weiblichen Bekannten nicht unabhängig, wenn man viele Pärchen kennt (und Pärchen gemeinsam

auf Open-Air Festivals gehen)

1 Wahrscheinlichkeitsrechnung

170

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

1.6.3 Normalverteilung

Die Normalverteilung ist wohl das wichtigste Verteilungsmodell der Statistik, denn

• viele Zufallsvariablen sind (nach Transformation) (ungefähr) normalverteilt.

• beim Zusammenwirken vieler zufälliger Einflüsse ist der geeignet aggregierte Gesamteffekt oft approximativ normalverteilt (Zentraler Grenzwertsatz, Kap. 1.7).

• die asymptotische Grenzverteilung, also die Verteilung bei unendlich großem Stichprobenumfang,

typischer statistischer Größen ist die Normalverteilung.

1 Wahrscheinlichkeitsrechnung

171

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Definition 1.62.

Eine stetige Zufallsvariable X heißt normalverteilt mit den Parametern µ und σ 2, in Zeichen X ∼

N (µ, σ 2), wenn für ihre Dichte gilt:

1

f (x) = √

exp

2π · σ

1

2

− 2 (x − µ)

2σ

, x∈R

(1.2)

und standardnormalverteilt, in Zeichen X ∼ N (0; 1), falls µ = 0 und σ 2 = 1 gilt (π ist hier die

Kreiszahl π = 3.14 . . .).

1 Wahrscheinlichkeitsrechnung

172

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Grundlegende Eigenschaften:

a) Die Dichte der Standardnormalverteilung wird oft mit ϕ(x) bezeichnet, also

1

ϕ(x) = √

exp

2π

1 2

− x

2

und die zugehörige Verteilungsfunktion mit

x

Z

Φ(x) =

ϕ(u)du

−∞

b) Φ(x) lässt sich nicht in geschlossener Form durch bekannte Funktionen beschreiben =⇒ numerische

Berechnung, Tabellierung.

c) µ und σ 2 sind genau der Erwartungswert und die Varianz, also, wenn X ∼ N (µ, σ 2), dann

E(X) = µ

und

2

Var(X) = σ .

d) Die Dichte ist symmetrisch um µ, d.h.

f (µ − x)

1 Wahrscheinlichkeitsrechnung

=

f (µ + x) .

173

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Grundlegendes zum Rechnen mit Normalverteilungen:

• Es gilt:

Φ(−x) = 1 − Φ(x)

(folgt aus der Symmetrie der Dichte).

• Gilt X ∼ N (µ, σ 2), so ist die zugehörige standardisierte Zufallsvariable

Z=

•

•

•

•

X−µ

σ

standardnormalverteilt. Einfach zu zeigen: E(Z) = 0, Var(Z) = 1.

Andersherum: Ist Z ∼ N (0, 1), dann ist σZ + µ ∼ N (µ, σ 2)

Entscheidende Eigenschaft für die Tabellierung: Es reicht die Standardnormalverteilung zu tabellieren.

Normalverteilte Zufallsvariablen mit Erwartungswert µ und Varianz σ 2 muss man, wie unten erläutert,

zuerst standardisieren, dann kann man aber auch die Standardnormalverteilungstabelle verwenden.

Tabelliert sind die Werte der Verteilungsfunktion Φ(z) = P ({Z ≤ z}) für z ≥ 0.

Ablesebeispiel: Φ(1.75) = 0.9599

Funktionswerte für negative Argumente: Φ(−z) = 1 − Φ(z)

Die z -Quantile ergeben sich über die Umkehrfunktion.

Beispielsweise ist z0.9599 = 1.75 und z0.9750 = 1.96.

1 Wahrscheinlichkeitsrechnung

174

Statistik II für Studierende der Soziologie und Nebenfachstudierende

0.0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1.0

1.1

1.2

1.3

1.4

1.5

1.6

1.7

0.00

0.5000

0.5398

0.5793

0.6179

0.6554

0.6915

0.7257

0.7580

0.7881

0.8159

0.8413

0.8643

0.8849

0.9032

0.9192

0.9332

0.9452

0.9554

0.01

0.5040

0.5438

0.5832

0.6217

0.6591

0.6950

0.7291

0.7611

0.7910

0.8186

0.8438

0.8665

0.8869

0.9049

0.9207

0.9345

0.9463

0.9564

1 Wahrscheinlichkeitsrechnung

0.02

0.5080

0.5478

0.5871

0.6255

0.6628

0.6985

0.7324

0.7642

0.7939

0.8212

0.8461

0.8686

0.8888

0.9066

0.9222

0.9357

0.9474

0.9573

0.03

0.5120

0.5517

0.5910

0.6293

0.6664

0.7019

0.7357

0.7673

0.7967

0.8238

0.8485

0.8708

0.8907

0.9082

0.9236

0.9370

0.9484

0.9582

1.6 Wichtige Verteilungsmodelle

0.04

0.5160

0.5557

0.5948

0.6331

0.6700

0.7054

0.7389

0.7704

0.7995

0.8264

0.8508

0.8729

0.8925

0.9099

0.9251

0.9382

0.9495

0.9591

0.05

0.5199

0.5596

0.5987

0.6368

0.6736

0.7088

0.7422

0.7734

0.8023

0.8289

0.8531

0.8749

0.8944

0.9115

0.9265

0.9394

0.9505

0.9599

0.06

0.5239

0.5636

0.6026

0.6406

0.6772

0.7123

0.7454

0.7764

0.8051

0.8315

0.8554

0.8770

0.8962

0.9131

0.9279

0.9406

0.9515

0.9608

0.07

0.5279

0.5675

0.6064

0.6443

0.6808

0.7157

0.7486

0.7794

0.8078

0.8340

0.8577

0.8790

0.8980

0.9147

0.9292

0.9418

0.9525

0.9616

0.08

0.5319

0.5714

0.6103

0.6480

0.6844

0.7190

0.7517

0.7823

0.8106

0.8365

0.8599

0.8810

0.8997

0.9162

0.9306

0.9429

0.9535

0.9625

0.09

0.5359

0.5753

0.6141

0.6517

0.6879

0.7224

0.7549

0.7852

0.8133

0.8389

0.8621

0.8830

0.9015

0.9177

0.9319

0.9441

0.9545

0.9633

175

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Berechnung bei allgemeiner Normalverteilung: Wie bestimmt man bei X ∼ N (µ, σ 2) die Wahrscheinlichkeiten P ({X ≤ a}) aus der Tabelle der Standardnormalverteilung?

• Zentrale Idee: X zu standardnormalverteilter Zufallsvariable umformen, d.h. standardisieren.

• Dabei muss die rechte Seite analog mit transformiert werden:

{X ≤ a}

⇔

⇔

{X − µ ≤ a − µ}

a−µ

X−µ

≤

σ

σ

das heißt

P ({X ≤ a}) = P

X−µ

a−µ

≤

σ

σ

.

Wegen

X−µ

∼ N (0, 1)

σ

gilt dann

P

1 Wahrscheinlichkeitsrechnung

X−µ

a−µ

≤

σ

σ

=Φ

a−µ

σ

,

176

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

so dass sich der folgende Zusammenhang ergibt:

P ({X ≤ a}) = Φ

a−µ

σ

.

Ist a < µ, also a − µ < 0, so muss man vor dem Benutzen der Tabelle noch folgendes ausnutzen:

a−µ

a−µ

µ−a

Φ

=1−Φ −

=1−Φ

σ

σ

σ

1 Wahrscheinlichkeitsrechnung

177

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Abgeschlossenheit gegenüber Linearkombinationen: Seien X1 und X2 unabhängig und Xi ∼

N (µi, σi2), i = 1, 2. Ferner seien b, a1, a2 feste reelle Zahlen. Dann gilt

2

2

Y1

:=

a1X1 + b ∼ N (a1µ1 + b; a1σ1 )

Y2

:=

a1X1 + a2X2 ∼ N (a1µ1 + a2µ2; a1σ1 + a2σ2 ).

2

2

2

2

Das Ergebnis lässt sich auf mehrere Summanden verallgemeinern.

1 Wahrscheinlichkeitsrechnung

178

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Bsp. 1.63. [aus Fahrmeir et al.]

•

Schultischhöhe:

Stuhlhöhe:

Y

X

∼

∼

N (µY , σY2 ) ,

2

N (µX , σX

),

µY = 113 ,

µX = 83 ,

σY2 = 16

2

σX

= 25

• optimale Sitzposition: Tisch zwischen 27 und 29 cm höher als Stuhl.

• Wie groß ist die Wahrscheinlichkeit, dass ein zufällig ausgewähltes Paar zueinander gut passt?

Differenz: Y − X soll zwischen [27, 29] sein.

Definiere also

V := Y − X = Y + (−X)

Wegen −X ∼ N (−83, 25) gilt dann

V ∼ N (113 − 83, 16 + 25) = N (30, 41).

Außerdem ergibt sich durch Standardisieren:

27 ≤ V ≤ 29

1 Wahrscheinlichkeitsrechnung

⇔

27 − 30 ≤ V − 30 ≤ 29 − 30

⇔

27 − 30

V − 30

29 − 30

≤ √

≤ √

√

41

41

41

179

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.6 Wichtige Verteilungsmodelle

Damit lässt sich die gesuchte Wahrscheinlichkeit bestimmen:

P (27 ≤ V ≤ 29)

1 Wahrscheinlichkeitsrechnung

V − 30

≤ −0.156) =

√

41

=

P (−0.469 ≤

=

Φ(−0.156) − Φ(−0.469) =

=

(1 − Φ(0.156)) − (1 − Φ(0.469)) =

=

−0.5636 + 0.6808 = 0.1172

180

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

1.7 Grenzwertsätze und Approximationen

Gerade in der Soziologie beobachtet man häufig große Stichprobenumfänge.

• Was ist das Besondere daran?

• Vereinfacht sich etwas und wenn ja was?

• Kann man Wahrscheinlichkeitsgesetzmäßigkeiten“ durch Betrachten vielfacher Wiederholungen er”

kennen?

1 Wahrscheinlichkeitsrechnung

181

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

1.7.1 Das i.i.d.-Modell

Betrachtet werden diskrete oder stetige Zufallsvariablen X1, . . . , Xn, die i.i.d. (independently, identically

distributed) sind, d.h. die

1) unabhängig sind und

2) die gleiche Verteilung besitzen.

Ferner sollen der Erwartungswert µ und die Varianz σ 2 existieren. Die Verteilungsfunktion werde mit F

bezeichnet.

Dies bildet insbesondere die Situation ab in der X1, . . . , Xn eine Stichprobe eines Merkmals X̃ bei

reiner Zufallsauswahl sind.

1 Wahrscheinlichkeitsrechnung

182

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Jede Funktion von X1, . . . , Xn ist wieder eine Zufallsvariable, z.B. das arithmetische Mittel oder die

Stichprobenvarianz

n

n

1X

1X

2

2

Xi

S̃ =

(Xi − X̄)

n i=1

n i=1

Vor dem Ziehen der Stichprobe: Wahrscheinlichkeitsaussagen möglich =⇒ Wahrscheinlichkeitsrechnung

anwenden

• Gerade bei diesen Zufallsgrößen ist die Abhängigkeit von n oft wichtig, man schreibt dann X̄n, S̃n2

• Sind X1, . . . , Xn jeweils {0, 1}-Variablen, so ist X̄n gerade die empirische relative Häufigkeit von

Einsen in der Stichprobe vom Umfang n. Notation: Hn

1 Wahrscheinlichkeitsrechnung

183

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

später:

Induktionsschluss

Durchführen eines Zufallsexperiments // Ziehen einer Stichprobe

?

IMMER Wahrheit “

”

?

S−planung

→

VORHER

Wahre Urliste

x

f

g

1 , ..., x

N

Zufallsvariablen

X1 , . . . , Xn

eines Merkmals

(z.B. Xi Einkommen der i-ten Person)

¯

x

e

arithmetisches Mittel

in der Grundgesamtheit

f

s2

e

X

Varianz in

der Grundgesamtheit

F (x)

empirische Verteilungsfunktion

in der Grundgesamtheit

1

arithmetisches Mittel

der Stichprobe

1 Pn X

X = n

i=1 i

NACHHER

W sktsrechn.

−→

S−ziehung

←→

Realisationen

x , . . . , xn

}

| 1 {z

neue Urliste

⇓

Auswertung, z.B.

arithmetisches Mittel

der Stichprobe

1 Pn x

x̄ = n

i=1 i

Stichprobenvarianz

2

1 Pn (X − X)2

e

S = n

i=1 i

←→

empirische Varianz1

1 Pn (x − x̄)2

s̃2 = n

i=1 i

empirische Verteilungsfunktion als

Zufallsvariable in jedem Punkt x

X1 ,...,Xn

1 |{i : X ≤ x}|

Fn

(x) = n

i

←→

empirische Verteilungsfunktion

X ,...,Xn

1 |{i : x ≤ x}|

Fn 1

(x) = n

i

Gehört nicht zur Grundgesamtheit; hier e“ für empirische Version

”

1 Wahrscheinlichkeitsrechnung

184

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

1.7.2 Das schwache Gesetz der großen Zahlen

Betrachte für wachsenden Stichprobenumfang n:

• X1, . . . , Xn i.i.d.

• Xi ∈ {0, 1} binäre Variablen mit π = P (Xi = 1)

• Hn = die relative Häufigkeit der Einsen in den ersten n Versuchen.

1 Wahrscheinlichkeitsrechnung

185

svariable!

Figur

beschreiben:

fallsvariable!

Figur

beschreiben:

500 1000

10001500

0.7

0.7

0.6

0.7

0.7

1 Wahrscheinlichkeitsrechnung

0.4

0.5

s[1:i]

0.3

1:i

500

1000

1500

0.7

s[1:i]

0.4

0.4

0.3

0.3

0.4

1500

4000

2000

6000

4000

500

1000

1500

8000

6000

10000

8000

10000

0.3

2000

0

1:i

0

0.5

0.6

0.6

0.5

s[1:i]

s[1:i]

s[1:i]

0

3500

10001500

1:i

1500

0.7

0.7

0.3

0.6

0.6

0.4

0.3

0

0.6

0.7

0.7

0.6

0.5

s[1:i]

0.5

s[1:i]

1:i

1000 1500

1:i

0.4

500 1000

1:i

500 1000

1:i

1:i

0 500

1:i

0.7

0.7

0.7

0.3

0.5

0.6

0.3

0.4

1500

0.7

1:i

500

0.3

10001500

1000 500

1500 1000

2000 1500

2500 2000

3000 2500

3500 3000

0

0

1500

0.4

0.5

s[1:i]

s[1:i]

0.4

0.5

s[1:i]

0.6

0.6

0.7

0.7

0.60.7

0.50.6

s[1:i]

0.7

0.6

500

0.3

0

0

1:i

2000

2500

3000

3500

1:i

0.7

1:i

0.6

0.5

s[1:i]

s[1:i]

0.4

0.3

0.4

0.3

1500

0.5

0.4

0.6

s[1:i]

0.3

1000

1:i

0 500

0.40.5

s[1:i]

0.30.4

0.7

0.7

0.5

0.6

s[1:i]

s[1:i]

0.4

0.5

500

500 1000

1:i

0.3

0.4

0.3

0

0

1500

1:i

0 500

1:i

0.6

0.7

0.7

0.6

0.5

0.4

s[1:i]

0

1500

1:i

1000 1500

0.5

0.6

10001500

500 1000

0.3

500 1000

1:i

0

0 500

1:i

0 500

1500

0

0.4

0.5

1500

0.5

0

1000

0.3

0.3

500

1.7 Grenzwertsätze und Approximationen

0.7

0.7

0.6

0.4

0.3

0.3

0.4

0

0.3

1500

0.5

s[1:i]

0.5

0.6

s[1:i]

s[1:i]

0.4

0.5

0.5

0.4

s[1:i]

0.6

0.6

0.7

0.7

0.7

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1:i

186

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Beobachtungen:

1. Am Anfang sehr unterschiedlicher, unregelmäßiger Verlauf der Pfade.

2. Mit wachsendem n pendeln sich die Pfade immer stärker um π herum ein, d.h. mit wachsendem Stichprobenumfang konvergiert die relative Häufigkeiten eines Ereignisses gegen seine

Wahrscheinlichkeit.

3. Formalisierung von 2.: Legt man sehr kleine Korridore/Intervalle um π , so ist bei sehr großem n der

Wert von Hn fast sicher in diesem Korridor.

Das Ereignis Die relative Häufigkeit Hn liegt im Intervall der Breite 2 um π lässt sich schreiben

”

”

als:

π−ε≤

−ε ≤

1 Wahrscheinlichkeitsrechnung

Hn

≤π+ε

Hn − π

≤ε

|Hn − π|

≤ε

187

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Theorem 1.64. [Theorem von Bernoulli]

Seien X1, . . . , Xn, i.i.d. mit Xi ∈ {0, 1} und P (Xi = 1) = π . Dann gilt für

n

1X

Hn =

Xi

n i=1

(relative Häufigkeit der Einsen“) und beliebig kleines > 0

”

lim P (|Hn − π| ≤ ) = 1

n→∞

Anschauliche Interpretation: Die relative Häufigkeit eines Ereignisses nähert sich praktisch sicher mit

wachsender Versuchszahl an die Wahrscheinlichkeit des Ereignisses an.

1 Wahrscheinlichkeitsrechnung

188

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Zwei wichtige Konsequenzen:

1) Häufigkeitsinterpretation von Wahrscheinlichkeiten:

P (A), die Wahrscheinlichkeit eines Ereignisses A, kann man sich vorstellen als Grenzwert der relativen

Häufigkeit des Eintretens von A in einer unendlichen Versuchsreihe identischer Wiederholungen eines

Zufallsexperiments.

2) Induktion: Man kann dieses Ergebnis nutzen, um Information über eine unbekannte Wahrscheinlichkeit

(π =

ˆ Anteil in einer Grundgesamtheit) zu erhalten.

Sei z.B. π der (unbekannte) Anteil der SPD Wähler, so ist die relative Häufigkeit in der Stichprobe

eine gute Schätzung für π“. Je größer die Stichprobe ist, umso größer ist die Wahrscheinlichkeit,

”

dass die relative Häufigkeit sehr nahe beim wahren Anteil π ist.

1 Wahrscheinlichkeitsrechnung

189

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Das Ergebnis lässt sich verallgemeinern auf Mittelwerte beliebiger Zufallsvariablen:

Schwaches Gesetz der großen Zahl: Gegeben seien X1, . . . , Xn i.i.d. Zufallsvariablen mit (existierendem) Erwartungswert µ und (existierender) Varianz σ 2. Dann gilt für

n

1X

X̄n :=

Xi

n i=1

und beliebiges > 0:

lim P (|X̄n − µ| ≤ ) = 1

n→∞

Schreibweise:

P

X̄n −→ µ

( Stochastische Konvergenz“, Xn konvergiert in Wahrscheinlichkeit gegen µ“.)

”

”

Schwaches Gesetz“: Kommt daher, dass es auch ein starkes Gesetz“ gibt. Dort wird eine stärkere

”

”

Form der Konvergenz betrachtet, welche im Prinzip fordert, dass die Folge nicht nur fast sicher in den

Intervallen liegt, sonder praktisch sicher einen entsprechenden Tunnel nie mehr verlässt.

Konsequenz für die Interpretation des Erwartungswerts:

µ kann in der Tat interpretiert werden als Durchschnittswert in einer unendlichen Folge von

Wiederholungen des Zufallsexperiments.

1 Wahrscheinlichkeitsrechnung

190

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

1.7.3 Der Hauptsatz der Statistik

Jetzt betrachten wir die empirische Verteilungsfunktion: In jedem Punkt x ist Fn(x) vor der Stichprobe

eine Zufallsvariable, also ist Fn eine zufällige Funktion

Bsp.: Realisation von Fn(4) bei n = 3

bei Realisation der Stichprobe 1, 3, 7:

1

⇒

F3(4) =

3

2

3

1 Wahrscheinlichkeitsrechnung

4

bei Realisation der Stichprobe 5, 6, 8:

4

7

⇒

5

6

8

F3(4) = 0

191

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Jetzt vergleiche die empirische Verteilungsfunktion Fn(x) und die wahre Verteilungsfunktion F (x):

Für jeden einzelnen Punkt x0 gilt nach dem schwachen Gesetz der großen Zahl

n

1X

P

Fn(x0) =

1(Xi ≤ x0) −→ P (X ≤ x0) = F (x0).

n i=1

Jetzt globale“ Sicht: Was passiert wenn man die ganze Funktion auf einmal betrachtet?

”

d

4

5

6

8

Wie vergleicht man die zufällige Funktion Fn(x) mit der Funktion F (x)? Der Abstand hängt ja von

dem Punkt x ab, in dem gemessen wird!

1 Wahrscheinlichkeitsrechnung

192

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Idee: Maximaler Abstand

X1 ,...,Xn

(x)

max |Fn

x ∈R

− F (x)|

Existiert nicht immer; formal muss man das sogenannte Supremum betrachten. Trotzdem so merken:

Wenn maximaler Abstand klein, dann Abstand überall klein!

Satz 1.65. [Hauptsatz der Statistik]

Seien X1, . . . , Xn i.i.d. mit Verteilungsfunktion F und sei Fn(x) die empirische Verteilungsfunktion

der ersten n Beobachtungen. Mit

Dn := sup |Fn(x) − F (x)|,

x

gilt für jedes c > 0

lim P (Dn > c) = 0.

n→∞

1 Wahrscheinlichkeitsrechnung

193

4

−4

−2

0

sort(x)

1 Wahrscheinlichkeitsrechnung

2

4

−4

0.6

−4 −2

−2 0

sort(x)

0 2

sort(x)

2 4

4

−3

0.4

0.6

0.8

1.0

4

0.2

sort(x)

function(x) pnorm(x, 0, 1) (x)

1.0

sort(x)

42

0.8

20

0.6

sort(x)

−2

0

0.4

1.0

−4

−2

0.2

0.8

−4

0.0

0.0

0.4

1.0

4

function(x) pnorm(x, 0, 1) (x)

0.2

0.8

1.0

24

(1:lx)/lx

0.8

sort(x)

02

0.6

(1:lx)/lx

0.6

−20

0.4

0.4

−4−2

0.0

0.2

0.2

−4

0.0

0.0

(1:lx)/lx

0.0

0.0

0.0

0.0

0.0

0.2

0.2

0.2

0.2

0.2

0.6

0.6

0.6

(1:lx)/lx

0.4

(1:lx)/lx

0.6

(1:lx)/lx

0.4

0.4

(1:lx)/lx

0.6

(1:lx)/lx

0.4

0.4

(1:lx)/lx

0.8

0.8

0.8

0.8

0.8

1.0

1.0

1.0

1.0

1.0

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Interpretation:

−4

−2

−2 −3

0

−1 −2

0 −1

x

2

1

0

2

4

sort(x)

Normal CDF

Normal CDF

1

3

2

3

x

194

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

1.7.4 Der zentrale Grenzwertsatz

• Gibt es für große Stichprobenumfänge Regelmäßigkeiten im Verteilungstyp?

• Gibt es eine Standardverteilung, mit der man oft bei großen empirischen Untersuchungen rechnen

kann?

Damit kann man dann insbesondere Fehlermengen einheitlich behandeln.

1 Wahrscheinlichkeitsrechnung

195

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Satz 1.66. [Zentraler Grenzwertsatz]

Seien X1, . . . , Xn i.i.d. mit E(Xi) = µ und Var(Xi) = σ 2 > 0 sowie

n

1 X

Zn = √

n i=1

Xi − µ

σ

.

a

Dann gilt: Zn ist asymptotisch standardnormalverteilt, in Zeichen: Zn ∼ N (0; 1), d.h. es gilt für jedes

z

lim P ({Zn ≤ z}) = Φ(z).

n→∞

Für die Eingangsfragen gilt also:

• Ja, wenn man die Variablen geeignet mittelt und standardisiert, dann kann man bei großem n

näherungsweise mit der Normalverteilung rechnen. Dabei ist für festes n die Approximation umso

besser, je symmetrischer“ die ursprüngliche Verteilung ist.

”

1 Wahrscheinlichkeitsrechnung

196

4

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Histogram of res

Histogram of res

3

1

2

1 Wahrscheinlichkeitsrechnung

0.4

0.4

2

2

4

0.3

0.1

0.0

−4

4

2

4

−2

res

0.4

0.4

0.3

Density

0.1

0.0

−2 0

res

02

res

2

4

Histogram of res

Histogram of res

0.1

−4 −2

0

res

0.0

−4

24

4

0.2

Density

0.1

0.0

0

0.2

Density

0.0

res

0

0.3

0.4

Density

0.1

0.2

0.3

0.4

0.3

0.2

0

0.2

Density

−2

Histogram of res

Histogram of res

0.1

Density

−2

res

0.0

−2

−4

res

Histogram of res

−4

0.3

0.4

0.3

0.1

0.0

−4

3

0.4

2

0.3

0

0.2

res

1

0.1

0

−1

0.0

−1

−2

Density

−2

−3

0.2

−3

−4

Histogram of res

0.2

0.2

0.1

0.0

0.1

0.0

0.0

−4

Density

Density

0.3

0.3

0.2

Density

0.2

0.1

Density

0.3

0.4

Histogram of res

Histogram of res

−4

−2−4

0−2

20

res

4 2

6 4

6

res

197

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Anwendung des zentralen Grenzwertsatz auf X̄ :

Gemäß dem Gesetz der großen Zahlen weiß man: X̄n −→ µ

Für die Praxis ist es aber zudem wichtig, die konkreten Abweichungen bei großem aber endlichem n zu

quantifizieren, etwa zur Beantwortung folgender Fragen:

• Gegeben eine Fehlermarge ε und Stichprobenumfang n: Wie groß ist die Wahrscheinlichkeit, dass X̄

höchstens um ε von µ abweicht?

• Gegeben eine Fehlermarge ε und eine Sicherheitswahrscheinlichkeit“ γ : Wie groß muss man n

”

mindestens wählen, damit mit mindestens Wahrscheinlichkeit γ das Stichprobenmittel höchstens um

ε von µ abweicht (Stichprobenplanung)?

Aus dem zentralen Grenzwertsatz folgt:

n 1 X Xi − µ

√

n i=1

σ

Pn

=

=

1 Wahrscheinlichkeitsrechnung

Xi − nµ

√

n·σ

i=1

nX̄n − nµ

X̄n − µ a

=

√

√ ∼ N (0, 1)

n·σ

σ/ n

198

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Wichtige Anwendung: Approximation der Binomialverteilung

Sei X ∼ B(n, π). Kann man die Verteilung von X approximieren?

Hier hat man zunächst nur ein X . Der zentrale Grenzwertsatz gilt aber für eine Summe vieler Glieder.

Idee: Schreibe X als Summe von binären Zufallsvariablen.

X ist die Anzahl der Treffer in einer i.i.d. Folge Y1, . . . , Yn von Einzelversuchen, wobei

1 Treffer

Yi =

0 kein Treffer

Die Yi sind i.i.d. Zufallsvariablen mit Yi ∼ B(1, π) und es gilt

X =

n

X

Yi ,

E(Yi) = π,

Var(Yi) = π · (1 − π).

i=1

1 Wahrscheinlichkeitsrechnung

199

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Damit lässt sich der zentrale Grenzwertsatz anwenden:

!

P

n

1 X

Yi − π

1

Yi − n · π

= √ p

p

√

n i=1

n

π(1 − π)

π(1 − π)

P

Yi − n · π a

= p

∼ N (0, 1)

n · π(1 − π)

und damit

X − E(X) a

∼ N (0, 1)

p

Var(X)

so dass

P (X ≤ x) ≈ Φ

x−n·π

p

!

n · π(1 − π)

falls n groß genug.

Es gibt verschiedene Faustregeln, ab wann diese Approximation gut ist, z.B.

n · π ≥ 5 und n · (1 − π) ≥ 5

n · π(1 − π) ≥ 9

1 Wahrscheinlichkeitsrechnung

200

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Fiktives Beispiel: Ein Politiker ist von einer gewissen umstrittenen Maßnahme überzeugt und überlegt,

ob es taktisch geschickt ist, zur Unterstützung der Argumentation eine Mitgliederbefragung zu dem

Thema durchzuführen. Er wählt dazu 200 Mitglieder zufällig aus und beschließt, eine Mitgliederbefragung

zu riskieren“, falls er in der Stichprobe mindestens 52% Zustimmung erhält.

”

Wie groß ist die Wahrscheinlichkeit, in der Stichprobe mindestens 52% Zustimmung zu erhalten, obwohl

der wahre Anteil nur 48% beträgt?

• X Anzahl der Ja-Stimmen

• X ja/nein ⇒ Binomialmodell

• X ∼ B(n, π) mit n = 200 und π = 48%

• n · π = 96 und n · (1 − π) = 104: Faustregel erfüllt, die Normalapproximation darf also angewendet

werden.

1 Wahrscheinlichkeitsrechnung

201

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.7 Grenzwertsätze und Approximationen

Gesucht: W’keit dass mind. 52%, also 104 Mitglieder, zustimmen, d.h.

P (X ≥ 104)

1 Wahrscheinlichkeitsrechnung

=

1 − P (X < 104)

=

1 − Φ( p

=

1 − Φ(1.13)

=

1 − 0.871241 = 12.87%

104 − 200 · 0.48

200 · 0.48(1 − 0.48)

)

202

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.8 Mehrdimensionale Zufallsvariablen

1.8 Mehrdimensionale Zufallsvariablen

Im Folgenden Beschränkung auf den diskreten Fall und zweidimensionale Zufallsvariablen.

Vorstellung: Auswerten eines mehrdimensionalen Merkmals

X X :Ω→

Y

Y

Das Hauptinteresse gilt (entsprechend der Kontingenztafel in Statistik I) der gemeinsamen Verteilung

P ({X = xi} ∩ {Y = yj })

1 Wahrscheinlichkeitsrechnung

203

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.8 Mehrdimensionale Zufallsvariablen

Definition 1.67.

Betrachtet werden zwei eindimensionale diskrete Zufallselemente X und Y (zu demselben Zufallsexperiment). Die Wahrscheinlichkeit

P (X = xi, Y = yj ) := P ({X = xi} ∩ {Y = yj })

in Abhängigkeit von xi und yj heißt gemeinsame Verteilung der mehrdimensionalen Zufallsvariable

bzw. der Variablen X und Y .

X

Y

Randwahrscheinlichkeiten:

pi•

=

P (X = xi) =

m

X

P (X = xi, Y = yj )

j=1

p•j

=

P (Y = yj ) =

k

X

P (X = xi, Y = yj )

i=1

1 Wahrscheinlichkeitsrechnung

204

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.8 Mehrdimensionale Zufallsvariablen

Bedingte Verteilungen:

P (X = xi|Y = yj )

=

P (X = xi, Y = yj )

P (Y = yj )

P (Y = yj |X = xi)

=

P (X = xi, Y = yj )

P (X = xi)

Stetiger Fall (nicht klausurrelevant): Zufallsvariable mit zweidimensionaler Dichtefunktion f (x, y):

b

Z

P (a ≤ X ≤ b, c ≤ Y ≤ d) =

f (x, y)dy

a

1 Wahrscheinlichkeitsrechnung

!

d

Z

dx

c

205

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.8 Mehrdimensionale Zufallsvariablen

Definition 1.68.

Seien X und Y zwei Zufallsvariablen. Dann heißt

σX,Y := Cov(X, Y ) = E((X − E(X))(Y − E(Y )))

Kovarianz von X und Y .

Rechenregeln:

•

•

•

•

Cov(X, X) = Var(X)

Cov(X, Y ) = E(XY ) − E(X) · E(Y )

Cov(X, Y ) = Cov(Y, X)

Mit X̃ = aX X + bX und Ỹ = aY Y + bY ist

Cov(X̃, Ỹ ) = aX · aY · Cov(X, Y )

• Var(X + Y ) = Var(X) + Var(Y ) + 2 · Cov(X, Y )

Definition 1.69.

Zwei Zufallsvariablen X und Y mit Cov(X, Y ) = 0 heißen unkorreliert.

1 Wahrscheinlichkeitsrechnung

206

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.8 Mehrdimensionale Zufallsvariablen

Satz 1.70.

Stochastisch unabhängige Zufallsvariablen sind unkorreliert. Die Umkehrung gilt jedoch im allgemeinen

nicht.

Vergleiche Statistik I: Kovarianz misst nur lineare Zusammenhänge.

Definition 1.71.

Gegeben seien zwei Zufallsvariablen X und Y . Dann heißt

ρ(X, Y ) = p

Cov(X, Y )

p

Var(X) Var(Y )

Korrelationskoeffizient von X und Y .

1 Wahrscheinlichkeitsrechnung

207

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.8 Mehrdimensionale Zufallsvariablen

Eigenschaften des Korrelationskoeffizienten:

• Mit X̃ = aX X + bX und Ỹ = aY Y + bY ist

|ρ(X̃, Ỹ )| = |ρ(X, Y )|.

• −1 ≤ ρ(X, Y ) ≤ 1.

• |ρ(X, Y )| = 1 ⇐⇒ Y = aX + b

• Sind Var(X) > 0 und Var(Y ) > 0, so gilt ρ(X, Y ) = 0 genau dann, wenn Cov(X, Y ) = 0.

1 Wahrscheinlichkeitsrechnung

208

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.8 Mehrdimensionale Zufallsvariablen

Bsp. 1.72. [Chuckk-a-Luck:]

X1 Gewinn, wenn beim ersten Wurf ein Einsatz auf 1 gesetzt wird.

X6 Gewinn, wenn beim ersten Wurf ein Einsatz auf 6 gesetzt wird.

Kovarianz zwischen X1 und X6:

1 Wahrscheinlichkeitsrechnung

209

Statistik II für Studierende der Soziologie und Nebenfachstudierende

1.8 Mehrdimensionale Zufallsvariablen

(x1, x6)

P (X1 = x1, X6 = x6)

(x1, x6)

P (X1 = x1, X6 = x6)

(−1, −1)

64

216

(−1, 3)

1

216

(−1, 1)

48

216

(3, −1)

1

216

(1, −1)

48

216

(1, 1)

24

216

(−1, 2)

12

216

(1, 2)

3

216

(2, −1)

12

216

(2, 1)

3

216

⇒

E(X1 · X6)

=

−50/216 = −0.23148

Cov(X1, X6)

=

−0.23148 − (−0.0787) · (−0.0787) = −0.23768

1 Wahrscheinlichkeitsrechnung

210

![1.5.4 Quantile und Modi Bem. 1.73. [Quantil, Modus] Analog zu](http://s1.studylibde.com/store/data/012393489_1-9a0b092e56e19fe178962849ae51d0ae-300x300.png)