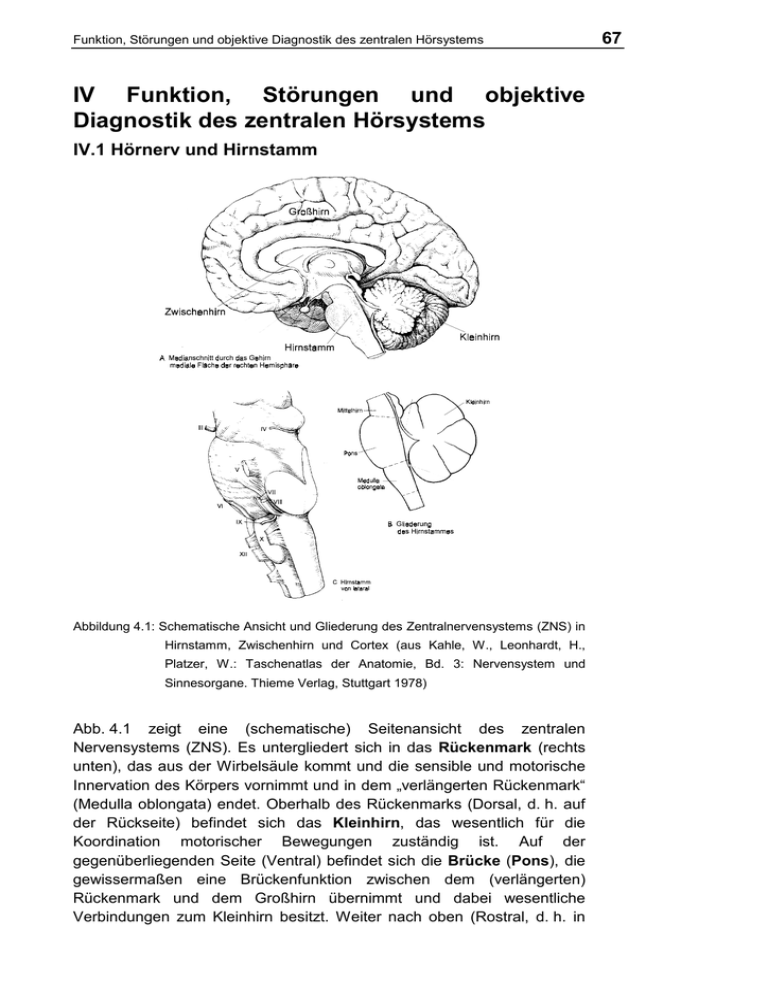

IV Funktion, Störungen und objektive Diagnostik des zentralen

Werbung