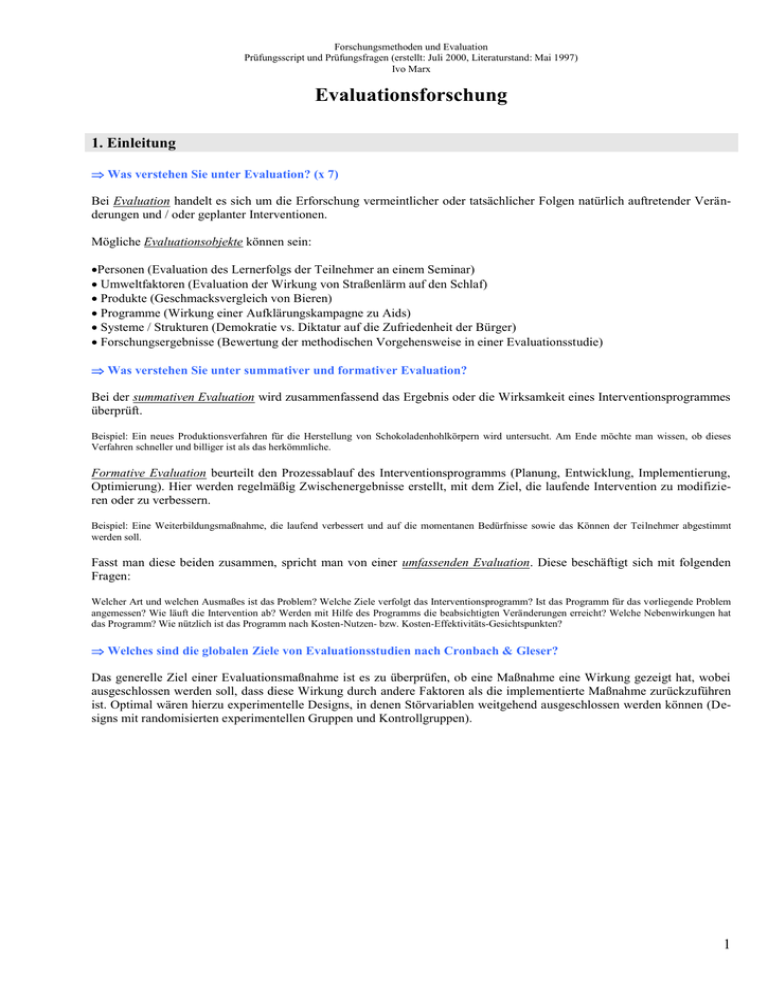

Evaluationsforschung - Universität Bielefeld

Werbung