Quasi-experimentelle Designs - Fachschaft Psychologie Freiburg

Werbung

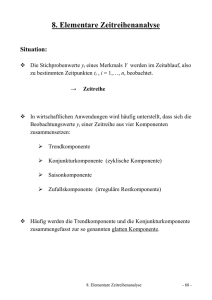

5. Quasi-experimentelle Designs mit Kontrollgruppe und Prä-Messung Einleitendes Beispiel: Homemaker – Programm 6 Wochen Training, danach ABM-Maßnahme als Haushaltshilfe AV = Einkünfte danach 3 Kontrollgruppen o Bewerber, die ausstiegen vor Eignungstest o Bewerber, die ungeeignet waren o Akzeptierte Bewerber, die aber nicht teilnahmen Prätest: Einkünfte vor Maßnahme Zugewinn durch Training gegenüber allen 3 KG o Größe unterschiedlich je nach KG o Prätestunterschiede nicht Posttest unterschiede verantwortlich Vorteile durch Prätests: Anfänglich Differenzen einschätzen ist wichtig für die Bewertungen der Bedrohung der internen Validität Insbesondere partielle Bewertung von Selektionbias o Prätests sind in der Regel am stärksten mit Posttest korreliert, daher sind anfängliche Unterschiede darin besonders bedeutsam Ferner: Partielle Bewertung von selektiven Dropout o Unterscheiden sich Abbrecher im Prätest von denen, die durchhalten o Gibt es dabei unterschiede zwischen EG und KG? Erhöht die statistische Trennschärfe der statistischen Analyse: Validität der statistischen Schlussfolgerungen erhöht! Quasi-experimentelle Designs mit Prä- Post-Messung und nicht äquivalenter KG NR O1 X O2 ------------------------------------NR O1 O2 Nicht-äquivalente KG: Selektionsbias wird von vorneherein in Kauf genommen (eingeräumt) Prätest soll Größe und Richtung des Selektionsbias einschätzen helfen Aber: Abwesenheit von Prätestunterschieden garantiert nicht Abwesenheit von Selektionsbias! Potentielle Probleme: Selektion-Reifung o Unterschiedliche spontane Veränderungsraten Selektion-Instrumentation (z.B. gleiches Instrument für hoch- und niedrigbegabte) o Skalen, Deckeneffekte Selektion-Geschichte o Lokale Geschichte Selektion Regression 35 Designs mit Prä-Post-Messung und Kontrollgruppe NR O1 X O2 -----------------------NR O1 O2 Statistisches Vorgehen: Auswertung der Daten über eine zweifaktorielle Varianzanalyse mit Messwiederholung auf einem Faktor Wichtig: Bei der Interpretation der Ergebnisse muss primär der Interaktionseffekt betrachtet werden, da über diesen der Effekt der Intervention erhoben werden kann. Vergleich der beiden Mittelwerte bei der Beobachtung O1 soll zeigen, dass die Gruppen vor der Durchführung des Treatments sich nicht statistisch signifikant unterscheiden (was in den meisten Designs so gewünscht ist, später mehr zu alternativen Designs). Vergleich der Mittelwertsdifferenzen der beiden Messzeitpunkte (Beobachtungen) O1 und O2 soll die Wirksamkeit des Treatments in der Experimentalgruppe belegen, sowie die „NichtWirksamkeit“ des Nicht-Treatments in der Kontrollgruppe. Hierdurch kann eine Vielzahl von Validitätsgefährdungen ausgeschlossen werden. Auch bei Designs mit Prä-Post-Messung und Kontrollgruppe gilt: o Alternative Erklärungen (Validitätsgefährdungen) müssen so weit wie irgend möglich ausgeschlossen werden. Wichtig sind aber in der Diskussion der Ergebnisse die plausiblen (und somit relevanten) Gefährdungen der Validität und nicht die möglichen Gefährdungen, welche aber eventuell sehr unwahrscheinlich sind, bzw. im Alltag nicht auftreten. Die Plausibilität hängt auch vom Ergebnismuster ab, wie im Folgenden illustriert Im Folgenden die Diskussion einiger Beispiele. 36 Fall 1: fächerförmige Ventilatorverteilung Varianzerweiterung zum Postzeitpunkt: Beide Gruppen verändern sich in Gleiche Richtung aber unterschiedlich schnell! Erklärungsansätze: Behandlungseffekte Selektion-Reifung (Personen mit hoher Leistung hoher Motivation sind in der EG und sind wegen höherer intrinsischer Lernrate, Leistungssteigerung zu t2 besser Mögliche Hinweise für das vorliegen einer „Ventilator“ –Verteilung Treatment wirksam? Kann man nicht genau sagen, da KG auch ansteigt. Nicht nur die Differenz der Mittelwerte zu t2 wird größer, sondern auch die Varianz bei den Messwerten zum Messzeitpunkt t2 Die eingetragenen Streuungen werden größer wie die länge der Gitter bei einem Ventilator Somit ergibt sich über die Zeit eine Varianzerweiterung Häufig in pädagogischer und A&O und Klinische Psychologie beobachtet könnte Verteilung auch so aussehen? kann b. Unterschied in t1 sein, wenn t0 nicht erhoben wurde Unterschied schon vor treatment 37 Lösungsansätze im Fall 1: Überprüfung der unterschiedlichen Reifungsprozesse in den Gruppen: - Testung der Reifungshypothese innerhalb der Gruppen (Ventialtor-Muster auch innerhalb der Gruppen) - Regression der Prä-Werte auf weitere Variablen, welche die Reifung beschreiben (z.B. Alter, Jahre der Berufserfahrung) getrennt für Kontrollgruppe und Behandlungsgruppe, falls unterschiedliche Regressionslinien in beiden Gruppen sind unterschiedliche Wachstumsraten wahrscheinlich Kritiker der Studie müssen erklären warum sich der Messwert in der EG spontan erhöht und warum KG nicht? Dennoch muss überprüft werden, ob Unterschiede zwischen EG zu KG zu einer plausiblen Erklärung herangezogen werden kann z.B. Mitglieder der KG älter und spontan weniger änderungsbereit Plausible Gefährdungen der Validität sollten ausgeschlossen werde keine Veränderung in KG Veränderung in EG kann auf Treatment zurückgeführt werden! Unterschiede zwischen den beiden Gruppen in den Prä-Werten werden durch das Treatment eliminiert Bsp. Selbstvertrauen von Grundschülern, die später aufs Gymnasium kommen (EG), im Vergleich zu späteren Realschülern (KG). Prätest in Grundschule, Posttest nach Trennung. Selektion-Reifung nicht plausibel, aber: Selektion Regression, Selektion-History und Selektion-Instrumentierung z.B. Förderprogramme soz. Benachteiligung oder soz. Kompetenz. 38 Ich führe EG an KG heran. Kann auftreten wenn z.B. die Treatmentgruppe (EG) aus SozialBenachteiligten besteht, welche eine besondere Förderung erhalten. Nach der Förderung unterscheiden sie sich nicht mehr von der Kontrollgruppe (Normalbevölkerung) Fall 4 ist eigentlich analog zu Fall 3 zu sehen, nur dass hier die Polung der Werte unterschiedlich ist (Fall 3: niedrige Werte = positiv, Fall 4: hohe Werte = positiv) Besonders gut kausal zu interpretierendes Ergebnismuster Selektion-Instrumentierung p hierfür gering Selektion-Regression können das Muster alleine nicht erklären Selektion-Reifung unwahrscheinlich, insofern als Ventilatormuster typischer und mit Fall fünf nicht vereinbar Hier findet man weniger Kritik Treatment wirkt Verbesserungsmöglichkeiten Das grundlegende Design kann durch folgende Ergänzungen verbessert werden: a) zweifache (mehrfache) Prä-Messung b) verzögertes Treatment c) umgekehrtes Treatment d) Erhebung der Validitätsgefährdungen a) zweifache (mehrfache) Prä-Messung NR O1 O2 X O3 -----------------------------------------------NR O1 O2 O3 Selektion – Reifung: - Unterschiede in Reifungsraten einschätzbar - Annahme das die Raten stabil in KG prüfbar - Aber: Instrumentierung kann zu unterschiedlichen Raten von O1bis O3führen Selektion – Regression: Falls O2 verschieden von O1 im Sinne von Regression zur Mitte. Korrelation von O1 und O2 kann geschätzt werden Verbesserung der statistischen Validität 39 Warum wird dieses Design nicht häufiger eingesetzt? - Kostengründe - Durchführbarkeit - Ermüdung der Probanden - Einfluss der Messungen (Testing) - Post-Messzeitpunkte sind von größerem Interesse b) verzögertes Treatment NR O1 X O2 O3 --------------------------------------NR O1 O2 X O3 Zweite Gruppe wird zu Beginn als KG eingesetzt und erhält später das Treatment (Wartekontrollgruppe). z.B. bei Schulungsmaßnahmen oder bei zu wenigen vorhandenen Therapieplätzen etc. Mögliches Problem: Zweiter Teil der Untersuchung ist keine Wiederholung des ersten Teils mit vertauschten „Rollen“, da eventuell vom ersten Treatment in der ersten Gruppe etwas „zurückbleibt“. es in der Wartekontrollgruppe einen Einfluss des „Wartenmüssens“ gibt (Unzufriedenheit wegen der „Zurückstufung“, aber auch Suche nach alternativen Hilfen). Eventuell kann es hierbei zu schwer interpretierbaren Verläufen kommen siehe nächste Folien Aber: im günstigen Fall: Interne und externe Validität sehr hoch Endpunkte Unterschiede, wirkt Treatment wirklich? Schwierige Interpretation c) Umgekehrtes Treatment NR O1 X+ O2 -------------------------NR O1 X- O2 Nur möglich, wenn X+ und X- klar definierbar. Gegenbeispiel: Nicht möglich bei der Überprüfung der Wirkung einer Schulungsmaßnahme. Wie müsste eine „negative“ Schulungsmaßnahme aussehen? 40 Bsp. A&O-Bereich: job enrichment Erweiterung des Tätigkeitsbereiches X+ erhöht die Arbeitszufriedenheit und Produktivität. Kritik bei Standardkontrollgruppe ohne zusätzliches Treatment: Anregung durch den Neuigkeitswert der Veränderung (Hawthorne - Studie). Kritik kann widerlegt werden durch die Implementierung eines X--Treatments: Reduktion des Tätigkeitsbereiches müsste zu Arbeitsunzufriedenheit und sinkender Produktivität führen. (Jobimpoverishment, Verarmung). d) Erhebung der Validitätsgefährdungen Bei den vorgestellten Designs sollten jegliche Veränderungen in beiden Gruppen erhoben werden. Möglicherweise erfolgen neben dem Treatment weitere Veränderungen. Besonders wenn diese Veränderungen nur in einer der beiden Gruppen implementiert werden (KG oder EG), ist die Validität gefährdet. Z.B. im A&O-Bereich: In der KG wird zwar nicht das eigentliche Treatment (Flexibilisierung der Arbeitszeiten) eingeführt, aber es wird das Entlohnungssystem (nur dort) verändert. Aber auch wenn es zu Veränderungen in beiden Gruppen kommt, kann eine mögliche Interaktion aus beiden Treatments in der EG die Interpretation der Effekte erschweren. Kohortenstudien Definition: Eine Gruppe von Personen, die im gleichen Zeitabschnitt geboren sind. Die Geburtszeit definiert somit die Kohortenzugehörigkeit (primär) Bsp.: Personen die im gleichen Monat, Jahr, Jahrzehnt geboren sind Breite der Kohorte ist abhängig von der Veränderungsgeschwindigkeit der im Fokus der Untersuchung stehenden Variablen Z.B. nur langsam veränderndes Merkmal: (Kohorte = Jahrzehnte); schnell: (Kohorte = Monate) Allgemeiner: Bei Institutionen / Einrichtungen mit sukzessiven Durchlauf von Personen / Gruppen mit ähnlichen Bedingungen, ist eine Kohorte die Personengruppe eines Durchlaufs (z.B Schule, Ausbildungsbetrieben, Universität) Typische Untersuchungsgruppen: Schuljahrgänge/Studienjahrgänge in einem Jahrzehnt geborene (Vergleich. Geb. in den 30er J. vs. in den 50er Jahren) Geschwister innerhalb von Familien Generell: Geringere Selektionbiases plausibel als im Design mit nicht-äquivalenter KG Hauptproblem: History 41 Formale Notation: Kohortenstudie durch gepunktete Linie symbolisiert NR O1 …………..……………….. NR X O2 Bsp: Untersuchung im Kindergarten nach Einführung der Sesamstrasse Ältere Geschwister könnten als KG verwendet werden (gute Vergleichbarkeit, identische Familien) Aber: Verwendung älterer Geschwister als KG intern valide? - Möglicherweise hat die Reihung der Geschwister einen Einfluss: - Confluence hypothesis (Zajonc, 1975): erstgeborene wurden von den Eltern anders behandelt, Ressourcen - Andere Ereignisse als das Treatment haben eventuell einen Einfluss (History) - nicht-äquivalente abhängige Variable (trainiert vs. nicht-trainierte Buchstaben) Verbesserung des Designs durch Einfügung von Prä-Messungen NR O1 O2 …………..………………………. NR O3 X O4 Bsp.: In der KG werden Daten zum Beginn und zum Ende des Studienjahres erhoben, analog hierzu ein Jahr später in der EG: o Überprüfung von Selektionsbias o Regression und Reifung problematisch bleibt: history Zusammenfassung: Designelemente 1. Zuweisung 2. Messung 3. Vergleichsgruppen 4. Behandlungen zur Verbesserung der Validität: Zuweisung: Vermeide Selbstzuweisung o Vielfältige Evidenz, dass dies Resultate verzerrt Matching und Stratifizieren o Erhöht Ähnlichkeit der Gruppen Blindversuch (Versuchsleiter, Hilfskräfte, Teilnehmer) o Reaktivität von Versuchleiterund Teilnehmer o Rosenthaleffekte Messung: Nicht-äquivalente abhängige Variable o Erschwert Erklärung durch History oder Reifung Multiple inhaltliche Posttests o Muster wird vorhergesagt Prätest o Selektionbias und selektiver Dropout 42 Multiple Prätests o Regressionsartefakte, Reifungstrends, Testeffekte, Instrumentierungsprobleme Retrospektive Prätest (Gedächtnis, Archiv) Vergleichsgruppen Multiple nicht-äquivalente Kontrollgruppen Kohorten Kontrollgruppe Weniger wünschenswert: o Extrapolation durch Regression vom Prätest auf den Posttest o Normierungsgruppe als KG o Vergleich mit Gruppen aus anderen Studien Behandlung Design mit verzögerter Behandlung o Am besten mit multiplen Gruppen und Behandlung zu unterschiedlichen Zeiten Umgekehrte Behandlung (negatives Treatment) Entfernte Behandlung Wiederholte Behandlung (ABAB) Matching und Stratifizierung Beim Matching werden die Probanden der KG und der EG zu Paaren zusammengestellt, die auf einer oder mehreren Matchingvariablen möglichst ähnlich sind Beim Stratifizieren werden Probanden der KG und EG in Gruppen mit ähnlichen Werten (Strata) auf einer oder mehrerer Matchingvariablen zusammengestellt Analog für mehr Gruppen Matching und statistische Validität: Matching Variablen sollten mit abhängiger Variablen zusammenhängen, z.B. Prätest Varianz die auf die Matchingvariable zurückgeht, kann aus der Fehlervarianz eliminiert werdenTrennschärfe erhöht (Validität der statistischen Schlussfolgerungen) Aber Einbuße durch Verlust von Freiheitsgraden Sinnvoll, daher nur, wenn substantielle Varianz auf Matchingvariable zurückgeht Hauptgrund warum Matching manchmal in randomisierten Gruppen eingesetzt wird Matching und interne Validität: Selektionsbias verringern durch Matching hinsichtlich wichtiger Bedrohungen der internen Validität Matching-Variable soll hoch-reliabel sein; mehrere / viele Hintergrundvariablen (siehe letztes Kapitel) Matching: Voraussetzung für ein effektives Matching 43 o Die vorhandene oder potentielle KG sollte um ein vielfaches größer sein als die Experimentalgruppe o Bei ähnlicher Gruppengröße ist ein vollständiges Matching meist nicht möglich Matching mit Hilfe binär logistischer Regression Bei vorliegender Experimentalgruppe und weit größerer Kontrollgruppe, können über die binär logistische Regression aus der Kontrollgruppe die passenden Elemente ausgewählt werden Das Matching erfolgt über die aufgrund der Matchingvariable vorhergesagte Wahrscheinlichkeit der Zugehörigkeit zur EG So werden aus der größeren KG die Elemente ausgewählt, welche von den Ausprägungen in den Matching-Variablen den Elementen der EG ähnlich sind Probleme dieser Vorgehensweise: Große N (Stichproben) notwendig damit es gut funktioniert Überlappungsbereich in der Zugehörigkeitswahrscheinlichkeit zwischen den Gruppen sollte groß sein (sonst nur wenige Strata, statistische Zwillinge) Methode verlangt komplette Daten auf allen benützten Matchingvariablen Starke Annahme: Es gibt keine weiteren konfundierten Variablen, die a) die Zugehörigkeitswahrscheinlichkeiten vorhersagen und b mit der abhängigen Variablen korrelieren Matching über Clusteranalysen: Bei Clusteranalysen wird das erhobene Kollektiv in Gruppen mit ähnlicher Merkmalsträgern aufgeteilt Hierbei können Personen und Variablen in Clustern geordnet werden. Beim Matching sind nur Gruppen von ähnlichen Personen von Interesse Schrittweise werden diese Cluster über ein hierarchisches Verfahren gesucht Im Folgenden wird nur eine Form der Clusteranalyse besprochen 44 Voraussetzung: intervallskalierte, multivariat normalverteilte Variablen oder nominalskalierte Variablen Bildhafte Beschreibung: Mit Hilfe eines Distanzmaßes wird die Ähnlichkeit bzw. die Unähnlichkeit zweier Objekte beschrieben Die zwei ähnlichsten Objekte werden zu einem Cluster zusammengefügt Anschließend wird: o Zu diesem Cluster eine weiteres Objekt hinzugefügt o Oder zwei weitere Objekte (Bsp. Personen) bilden ein neues Cluster Abalufschema, einzelne Schritte und wichtige Begriffe: Es gibt eine Vielzahl von Distanz- oder Ähnlichkeitsmaßen (Proximitätsmaße) und Fusionierungsalgorithmen o Hier nur die häufigsten: Es muss entschieden werden nach welchem Fusionierungsalgorithmus die Cluster/ Gruppen zusammengefügt werden, eine Auswahl an Algorithmen wären: Single Linkage Complete Linkage Average Linkage Centroid Median Ward Single Linkage: o Das Paar mit der kleinsten Distanz bildet die erste Gruppe und wird zusammengeführt o Die alten Distanzen bleiben erhalten o Anschließend erfolgt bei der normalen Clusteranalyse die nächste Fusionierung nach der nächsten kleineren Distanz o Nearest-Neighbour-Verfahren Gebräulichste Proximitätsmaße 45 Intervallskalierte Proximitätsmaße Q-Korreltionskoeffizient: Analoge Berechnung zum Korrelationskoeffizeint, wobei hier nicht über die Person sondern über die Variablen aufsummiert wird 46 Anmerkungen zum Matching über hierarchische Clusteranalysen: Beim Matching über Clusteranalysen werden eine Vielzahl von Optionen angeboten, welche aus inhaltlichen Vorüberlegungen gewählt werden sollten Diese Form des Matching ist aufwendiger, erlaubt aber bei einer Vielzahl MatchingVariablen eine optimale Passung von Mitgliedern der Eperimental- und der Kontrollgruppe Je größer das Verhältnis von NKontrollgruppe / NExperimentalgruppe ist, desto leichter ist es geeignete Paare zu bilden Die Zeitreihenanalyse ist die Disziplin, die sich mit der mathematisch-statistischen Analyse von Zeitreihen und der Vorhersage (Trends) ihrer künftigen Entwicklung beschäftigt. Sie ist eine Spezialform der Regressionsanalyse *Der gleitende Mittelwert (moving-average)wird auch gleitender Durchschnitt genannt. Gleitende Mittelwerte verringern die in einer Datenreihe vorhandene Variation. Daher werden sie oft verwendet, um Zeitreihen zu glätten Thema 6: Zeitreihen Lehrziele: Grundlegendes Verständnis von Zeitreihenanalysen als Vorbereitung für das Thema: „Unterbrochene Zeitreihendesigns“ Anwendungsgebiete von Zeitreihenanalysen ARIMA- Modell als ein Verfahren für Zeitreihenanalysen Zeitreihenanalysen – Ziele Analyse einer Vielzahl von Messzeitpunkten (mindestens 50 bis 100, aber auch viele tausend Messzeitpunkte sind möglich) Analyse mit primär zwei Zielen: a) Ermittlung von zyklischem Phänomenen (z.B. Effekte vom Wochenende, saisonale Effekte von Jahreszeiten, Semester etc.) b) Vorhersage von zukünftigen Ereignissen / Verläufen (z.B. Vorhersage von Börsenkursen (nicht gut möglich), Therapieverläufen etc.) Beispiele: • • Verkaufszahlen im Einzelhandel steigen über die Jahre hinweg (im Jahresdurchschnitt, aber auch pro Monat) - Allerdings gibt es innerhalb der einzelnen Jahre zyklische Bewegungen z.B. 25% des Umsatzes im Dezember und nur 4% im August Kosten für Kraftstoff / Heizöl - Höhere Preise für Kraftstoff in den Urlaubszeiten oder zu den Feiertagen (Weihnachten / Ostern etc.) - Höhere Preise für Heizöl im Spätherbst / Winter - Steigende Kraftstoffpreise über die Jahre hinweg Ausführliches Beispiel: • Verlauf der Anzahl der Flugreisen im Laufe der Jahre (klassischer Datensatz nach Serie G nach Box und Jenkins, 1976) 1. Datensatz aller Zeiten 47 • • Anzahl der internationalen Flugreisen (Fluggäste) in den Jahren 1949 bis 1960 in 1000 Monatliche Messung: o Höhere Anzahl von Flugreisen in den Urlaubszeiten (Sommer) oder zu den Feiertagen (Weihnachten, Ostern etc.) Saisonalität im Jahreszyklus o Steigende Flugzahlen über die Jahre hinweg Deutlicher linearer Trend belegt ein ständiges Anwachsen der Anzahl der Fluggäste vier mal so viele Passagiere 1960 im Vergleich zu 1949 Fragestellung: Vorhersage für zukünftige Jahre möglich? Abhängigkeit (saisonale): Autokorrelation • • • • • Ermittlung der Abhängigkeit durch eine Korrelation der Ordnung k zwischen dem i-ten Element der Serie und dem (i-k)-ten Element Autokorrelation: Korrelationen zwischen Messzeitpunkten mit Abstand k (Variable mit sich selbst korreliert über Zeit hinweg = Autokorrelation) Der Abstand k wird als lag bezeichnet Bei einer geeigneten Messung kann saisonale Abhängigkeit identifiziert werden als ein Muster, welches alle k Elemente auftritt. Im Beispiel: Hohe Abhängigkeit zwischen den Monaten. Peaks im Sommerurlaub Analysen von Zeitreihen Beschreibung der Zeitreihe durch ein ARIMA-Modell d.h. autoregressive integrated moving average model ARIMA ist eine von mehreren Möglichkeiten der Modellierung Ziel: Vorhersage von Zeitreihenwerten Überprüfung von Trends Überprüfung der Abhängigkeit der Messzeitpunkte 48 ARIMA (p, d, q)-Modelle ARIMA (p, d, q)-Modelle versuchen, die Systematik einer Zeitreihe anhand von 3 Parametern zu beschreiben: p: Anzahl der autoregressiven Anteile (AR-Anteile) der Zeitreihe d: Anzahl der notwendigen Differenzierungen, um eine Zeitreihe stationär zu machen q: Anzahl der moving-average-Komponenten der Zeitreihe* *Der gleitende Mittelwert (moving-average)wird auch gleitender Durchschnitt genannt. Gleitende Mittelwerte verringern die in einer Datenreihe vorhandene Variation. Daher werden sie oft verwendet, um Zeitreihen zu glätten ARIMA-Modelle: Parameter d (Anzahl der notwendigen Differenzierungen, um eine Zeitreihe stationär zu machen) - Viele Verfahren der Zeitreihenanalysen (z.B. ARIMA, AR- und MA-Modelle, Fourieranalysen) basieren auf der Annahme der Stationarität des Merkmals. - Eine Zeitreihe wird als stationär bezeichnet, falls die Verteilungsmerkmale von Stichproben aus der Zeitreihe nicht vom absoluten Zeitpunkt ihrer Ziehung abhängt (Mittelwert, Varianz,Schiefe, Exzess). kein Trend Wir schaffen es, Trend in Zeitreihe festzustellen und herauszurechnen, ich möchte vergleichbare Mittelwerte haben. Ändert sich der Mittelwert von Stichproben aus der Zeitreihe systematisch, liegt ein Trend vor. Häufig ist eine Zeitreihe wegen eines vorhandenen Trends nicht stationär. Dies tritt primär bei ökonomischen Daten auf. Dann muss diese Zeitreihe durch Differenzierung (einmalige oder mehrfache Differenzbildung) stationär gemacht werden. 49 Anmerkung: Durch die Differenzbildung kann nur ein möglichst „gerader“ (stationärer) Verlauf der Zeitreihe erreicht werden. Einen vollständige „Verflachung“ der Zeitreihe ist: meist nicht möglich und inhaltlich nicht sinnvoll, da saisonale Effekte ermittelt werden sollten. Beispiel Fluggäste: Differenzierung Stationarität streng stationär: wenn die Verteilungskennwerte in allen möglichen Teilsstichproben identisch sindKennwerte sind unabhängig von der Zeit Schwach stationär: Stationarität zweiter Ordnung Mittelwert und Kovarianzen innerhalb der Stichproben sollten unabhängig von der Zeit sein ARIMA-Modelle: Parameter p Ist die Zeitreihe nach der Differenzierung stationär, so kann die Autokorrelationsstruktur der Zeitreihe untersucht werden. ARIMA = autoregressive integrated moving average model 50 integrated = stationär nach Differenzbildung Autokorrelationen sind Korrelationen, die durch zeitliche Versetzung („time lags“) der Messwerte einer Zeitreihe berechnet wurden. (Auto: weil Werte mit sich selbst korrelieren) Das lag kann beliebig erweitert werden. - r = .93 bei lag 12 (1Jahr) Vorteil: Je mehr lags zur Vorhersage verwendet werden, desto präziser kann diese Prädiktion werden. Nachteil: Sehr viele lags erfordern komplexe Gleichungen zur Vorhersage des nächsten Messzeitpunkt und komplexe Modelle. Korrelation deshalb so hoch, weil i. Bsp. Flugdaten: Vorhersage für Juni, guter Prädiktor ist Juni im Vorjahr. Bei lag 12 12 Prädiktoren/MZP (werden aufgenommen, obwohl sie nicht so gut sind) in ARIMA-Modellen wird die Autokorrelationsstruktur der Zeitreihe durch Autoregressionen beschrieben Besteht lediglich eine Abhängigkeit zwischen benachbarten Messungen, so kann der Messwert xt zum Zeitpunkt t allein durch den vorhergehenden Messwert xt-1 vorhergesagt werden. Besteht ein Abhängigkeit zwischen Messungen mit einem lag von 2 so kann der Messwert xt zum Zeitpunkt t durch die vorhergehenden Messwert xt-1 und xt-2 vorhergesagt werden. Es handelt sich hierbei jeweils um ein Autoregressionsmodell. „Autoregressionsmodell“ mit lag 1 „Autoregressionsmodell“ mit lag 2 51 ARIMA (p,d,q)-Modelle Erinnerung Diese Modelle versuchen, die Systematik einer Zeitreihe anhand von 3 Parametern zu beschreiben p: Anzahl der Autoregressiven Anteile (AR-Anteile) der Zeitreihe d: Anzahl der notwendigen Differenzierungen, um eine Zeitreihe stationär zu machen q: Anzahl der moving-average-Komponenten der Zeitreihe ARIMA-Modelle: Parameter q Die durch das Autoregressive Modell (AR-Modell) vorhergesagten Messwerte sind immer noch mit einem Vorhersagefehler behaftet. Der zum Zeitpunkt t beobachtet Messwert xt kann von den vorhergehenden Messfehler abhängen („error propagation“). Eine solche Abhängigkeit kann durch ein moving average-Modell ermittelt werden Während bei Autoregressiven Modellen von einem Zusammenhang zwischen den vorhergesagten Messwerten ausgegangen wird, ergibt sich kein Zusammenhang zwischen den Messfehlern. Jede Beobachtung wird von einem zufälligen Fehler (random shock) und einer Linearkombination von vorhergehenden zufälligen Fehlern beeinflusst. Über den Parameter q wird somit bestimmt, wie viele vorhergehende zufällige Fehler in der Modellierung berücksichtigt werden. Beispiel: ARIMA (12,1,0)-Modelle p: Anzahl der autoregressiven Anteile (AR-Anteile) der Zeitreihe d: Anzahl der notwendigen Differenzierungen, um eine Zeitreihe stationär zu machen q: Anzahl der moving-average- Komponenten der Zeitreihe 52 regelmäßiges „Strickmuster“ von Daten abhängig neue Daten müssen eingegeben werden („System füttern“) um Prognose besser zu machen ARIMA-Modelle: Anwendungen Vorhersage Ist die Systematik der Zeitreihe durch ein geeignetes ARIMA-Modell erfasst, so lassen sich zukünftige Messpunkte vorhersagen. Je länger und stabiler die Zeitreihe ist (mindestens 50 Messpunkte, besser 100), desto besser ist die Vorhersage. Je weiter die Vorhersage in die Zukunft reichen soll, desto schlechter wird sie. Beispiel: Prognose von Entwicklungsverläufen 53 Thema 7: Unterbrochene Zeitreihen-Designs Lehrziele: Analyse von unterbrochenen Zeitreihendesigns Anwendungsgebiete Analysemöglichkeiten Probleme Zeitreihe und Intervention Wird in einer Untersuchung mit vielen Messzeitpunkten eine Intervention durchgeführt, so muss ein erfolgreiches Treatment einen Einfluss auf die Zeitreihe haben. O1 O2 O3 O4 O5 X O6 O7 O8 O9 O10 Zeitreihe T Zeitreihe reatment Beispiel: Theoretischer Einschub: Mögliche Veränderungen im Verlauf der Zeitreihe Eine Intervention kann unterschiedliche Effekte haben: - Der Trend verändert sich. (Veränderungen in der Steigung der Zeitreihe) 54 - Das Niveau verändert sich. (Veränderungen in der mittleren Anzahl) - Die Varianz verändert sich - Der Effekt zeigt sich unmittelbar oder verzögert (z.B. Geburtenkontrolle; Maßnahmen erst nach neun Monaten sichtbar) - Der Effekt ist dauerhaft temporär 55 56 Verzögerter Effekt, da noch alte Flaschen im Handel. Saisonalität muss berücksichtigt werden Gefahr bei verzögerten Effekten mit unklarem zeitlichen Verlauf Capitalization of chance?? Mögliche Validitätsgefährdungen - Mögliche Reifung und Regression durch viele Prätests einschätzbar Wichtigste Bedrohung = History Instrumentierung: Definition der Kategorien ändert sich z.B. Arbeitslosenstatistik; Boden – Deckeneffekte (wenn es nicht höher oder tiefer gehen kann, kann Intervention auch nicht helfen) Selektion: Wenn Intervention Zusammensetzung der Gruppe ändert Statistische Schlussfolgerung Es muss auch hier immer überprüft werden, ob nicht möglicherweise andere Ursachen den Effekt begründen können. z.B. Kampagne gegen Alkoholkonsum während der Schwangerschaft Nicht das Trinkverhalten der Frauen ändert sich, sondern nur die Angaben zum Trinkverhalten (da dieses nicht mehr sozial akzeptiert ist). Verbesserung durch nicht-äquivalente Kontrollgruppe ohne Treatment O1 O2 O3 O4 O5 X O6 O7 O8 O9 O10 -------------------------------------------------O1 O2 O3 O4 O5 O6 O7 O8 O9 O10 Bsp: Einführung der Helmpflicht für Mofas Vergleichsgruppe: Motorradfahrer (hier bestand schon zuvor Helmpflicht) 57 Verbesserung durch nicht-äquivalente Kontrollgruppe ohne X: History – unwahrscheinlich; es sei denn, es gibt plausible lokale History, die genau zu dem Zeitpunkt der Intervention genau die beobachtete Veränderung bewirkt Instrumentierung ist für beide Gruppen gleich Reifung ähnlich in beiden Gruppen Intervention nicht unmittelbar nach extremer Messung Regression unwahrscheinlich Erhebung einer nicht-äquivalenten abhängigen Variablen OA1 OA2 OA3 OA4 OA5 X OA6 OA7 OA8 -------------------------------------------------OB1 OB2 OB3 OB4 OB5 X OB6 OB7 OB8 Beide Variablen A und B müssen aber konzeptuell zusammenhängen. Beispiel: Anwendungen von Alkoholteströhrchen, bei Kontrollen auf die Anzahl der Verkehrsunfälle in Großbritannien: Gemessen wurde die Anzahl der Unfälle jeweils zu den Öffnungszeiten der Pubs am Wochenenden und zu geschlossenen Zeiten als Vergleichsgruppe die meisten Bedrohungen der internen Validität durch history sollten Unfälle unabhängig von der Tageszeit beeinflussen (z.B. Wetter, Gurtpflicht, sichere Autos, strengere Strafen) Ausschluss der Gefährdungen der Konstruktvalidität durch weitere Daten: Effekt zeigt sich auch auf Anzahl tödliche Unfälle pro gefahrene Kilometer nicht hervorgerufen durch generelle Reduktion der Fahrten Kein Effekt auf den Verkauf von alkoholhaltigen Getränken nicht hervorgerufen durch weniger trinken Nach Intervention berichten Pubbesucher, zu Fuß nach Hause gegangen zu sein. Nach der Intervention sank die Zahl der Todesopfer mit Alkohl im Blut vermutliche Ursache insgesamt: Weniger Fahrten stark alkoholisierter Personen 58 Entfernen eines Treatments O1 O2 O3 X O4 O5 O6 O7 X O8 O9 O10 Nach der Einführung eines Treatments sollte eine Veränderung in der Zeitreihe auftreten (Niveauunterschied). Dieser Unterschied sollte nach der Entfernung des Treatments wieder zurück gehen, vorausgesetzt die Treatmentwirkung ist temporär. Beispiel: Einrichtung eines mobilen psychiatrischen Kriseninterventionsteams zur Behandlung von psychischen Problemen. Das Angebot des Beratungsteams wird nach einer bestimmten zeitlichen Periode wieder entfernt Ergebnis: Anzahl der Einweisungen in eine staatliche Psychiatrie hat sich Signifikant verändert Analyse mit einem ARIMA (0,1,1)- Modell Probleme: Saisonalität ? History: unwahrscheinlich, da doppelter Effekt aber: Demoralisierung beim Entfernen Instrumentierung unwahrscheinlich Weiteres Designfeature: Kontrollzeitreihe in privatem psychiatrischen Krankenhaus Multiple Treatments (scheinbar fast so gut wie randomisierte Experimente) O1 O2 X O3 O4 X O5 O6 X O7 O8 X O9 O10 Anwendung: Klinische Psychologie, Medizin z.B: Tierversuch Allgemeine Psychologie History ist unwahrscheinlich Wünschenswert: Zeitpunkte zufällig gewählt, dann auch Saisonalität ausgeschlossen Verzögertes Treatment O1 O2 O3 X O4 O5 O6 O7 O8 O9 O10 ---------------------------------------------------------O1 O2 O3 O4 O5 O6 O7 O8 X O9 O10 Kaum alternative Erklärungen möglich Externe Validität ist erhöht, da Effekt in zwei Populationen zu zwei Zeitpunkten (Generalisierbarkeit) Besonders hilfreich bei verzögerten Effekten un unbekanntem delay. Vernichtet capitalization of chance Probleme von unterbrochenen Zeitreihendesigns Langsame und graduelle Implementierung (Einführung): Diffusion z.B. Flaschenaufschrift Alkohol und Schwangerschaft 59 Unbekanntes Intervall zwischen Ursache und Effekt Möglicherweise von Population zu Population verschieden Kurze Zeitreihen (N<100) Beschränkung von Archivdaten (diese sind vom aktuellen Zeitgeschehen beeinflusst und so mit Vorsicht zu genießen) Langsame Diffusion des Treatments Viele Interventionen können nur schrittweise eingeführt werden. Nur in seltenen Fällen wird eine Intervention übergreifend eingeführt. Neues Wissen gelangt nur langsam und schrittweise zur Interventionsgruppe. o z.B. - Aids-Aufklärungsmaßnahmen – o Schulungsprogramme (klinisches Personal kann nicht zu identischem Zeitpunkt komplett geschult werden) Falls Diffusionsrate bekannt, kann der Effekt entsprechend modelliert werden: o Gradueller Anstieg anstelle von Schrittfunktion Unbekanntes Intervall zwischen Ursache und Wirkung Erwartete Effekte treten erst mit langer, zeitlicher Verzögerung auf. Erfolge sind nur schleichend bemerkbar. o Änderung der Essgewohnheiten o Lungenkrebs durch Rauchen Problem: Der Effekt einer Intervention kann durch große zeitliche Differenz zwischen Intervention und Erfolg wieder verwässert werden o Vorsätze im neuen Jahr o Änderung im Ernährungsverhalten oder bei der sportlichen Aktivität Capitalization on chance Zeitreihen mit versetztem Treatment Probleme von unterbrochenen Zeitreihen Designs Problem 1: Das Kriterium Tote und schwere Verkehrsunfälle ist nicht exakt definiert (schwerer Busunfall wird als Ereignis gewertet oder geht dieser Unfall mit einer Vielzahl von Toten in die Statistik ein Problem 2: Die relative geringe Anzahl von Messungen nach der Intervention (Gurtpflicht) erlaubt keine statistisch absicherbaren Angaben zum weiteren Verlauf. Offene Frage: Ist der weitere Trend eher gleich bleibend oder steigt die Anzahl der Todesfälle wieder auf das vorherige Niveau an? Hat die Intervention nur einen relativ kurzfristigen Effekt? 60 Zu kurze Zeitreihen - Für die statistische Anwendung: Mindestens 100 Beobachtungen (O) bei stärkeren Annahmen über die Autokorrelationsstruktur auch weniger! Bei unterbrochenen Zeitreihen sollte mindesten 50 Messungen vor und mindestens 50 Messungen nach dem Ereignis erfolgt sein Je größer der Abstand (lag) bei Abhängigkeiten, der saisonale Trend, desto relevanter ist die Anzahl der Messzeitpunkte Dennoch erlauben auch kurze Zeitreihen vielfach Bewertung von Reifung und Regression Weitere Probleme: Die Datenqualität bei Zeitreihen ist oft nur sehr schwer zu bewerten. Wie valide ist die Messung durch Erhebung? o z.B. Anzahl der Unfälle unter Alkoholeinfluss. Wie viele Unfälle werden nicht von der Polizei erfasst? Bei wie vielen Unfällen wird von der Polizei der Alkoholge-nuss nicht bemerkt? Daten oft nicht vorhanden oder von zweifelhafter Qualität o z.B. Anzahl der Unfälle unter Alkoholeinfluss am Arbeitsplatz. Offen ist, ob dies immer vom Arbeitgeber korrekt gemeldet wird, da dies schwerwiegende Konsequenzen haben kann (Frühberentung, Kostenübernahme) Auch ist der Grad der Datenaggregation oft so hoch, dass Analysen nicht in dem gewünschten Zeitfenster stattfinden können o z.B. Sind aus den Archiven nur Verkehrsunfälle pro Jahr und nicht pro Monat oder Tag bekannt. So kann der Einfluss des Wochenendes auf die Frequenz der Verkehrsunfälle nicht erfasst werden. Eventuell besteht auch Verfälschungsgefahr durch Veränderung des Konstruktes über die Zeit. o z.B. Bei der Diagnose verschiedener psychischer Krankheitsbilder haben sich fundamentale Veränderungen ergeben. Neurosen gibt es heute nicht mehr im klinischen Sprachgebrauch, während die Diagnose Borderline- Persönlichkeitsstörung erst in den letzen Jahrzehnten aufkam. Oder die Definitionskriterien ändern sich im Laufe der Zeit 61 8. Diskontinuierliche Regressionsdesigns Lehrziele: o o o Diskontinuierliche Regressionsdesigns Typische Designs- Einsatzgebiete Vor-und Nachteile dieses Designs Cut-off- Variable Auswahl Möglichkeiten für den cut-off-Wert Anforderungen an den cut-off-Wert RD-Analysen mit randomsierter Zuweisung • Bei den bisher vorgestellten quasi-experimentellen Designs: - Kontroll- und Experimentalgruppe sollten vor dem Treatment in der Experimentalgruppe identisch (oder zumindest vergleichbar / ähnlich) sein - Falls doch Unterschiede zwischen KG und EG vor dem Treatment vorliegen, wird mit verschiedenen versuchsplanerischen und statistischen Mittel versucht, diese auszugleichen • Bei diskontinuierlichen Regressionsdesigns hingegen: - Mit Hilfe eines cut-off-Wertes (= bestimmter festgelegter Wert, anhand dessen ich Gruppen einteile) bei einer Zuordnungsvariablen (Prä-Messung) werden Probanden den Gruppen zugeteilt oder unterschiedliche Zusammenhänge zu Post-Werten vorhergesagt Einführendes Beispiel: - Untersuchung zur Resozialisierung von Strafgefangenen Frage: Kann die Rückfallquote nach der Entlassung durch eine finanzielle Starthilfe erleichtert (VERRINGERN WAHRSCHEINLICH) werden? - Hypothese: Rückfallquote geringer nach Maßnahme - Finanzielle Hilfe wird nur gewährt wenn der Gefangene 652 Stunden im Gefängnis gearbeitet hatte Ergebnisse: - Die Anzahl der Personen mit erneuter Straffälligkeit war in der EG um 13% geringer als in der KG - EG und KG über cut-off mit 652 Stunden Arbeitsleistung definiert Basis-Design Es gibt für diskontinuierliche Regressionsdesigns (RD) verschiedene Subdesigns zur Auswahl. Im Folgenden soll das Basisdesign besprochen werden. OA C X O2 OA C O2 OA Messung der Zuordnungsvariablen C Zuordnung nach dem cut-off-Wert Beispiel: - Zuordnung zu einer bestimmten Form der Depressionsbehandlung aufgrund der PräWerte - Ab einem BDI-Wert von 28 (Becks-Depressions-Inventar) erhalten die Patienten mit hohen Werten (stärkere Depression) eine Zusatzbehandlung 62 - Gemessen werden die Prä- und die Post-Werte in der EG und KG Zwei mögliche Ergebnisse sollten im Folgendem diskutiert werden Kein Treatmenteffekt: o Die Steigung der Regressionsgerade ist in beiden Gruppen identische o Es gibt einen übergangslosen Verlauf zwischen der Kontrollgruppe und der EG somit kann davon ausgegangen werden das dieses Treatment keinen Einfluss hat 63 Treatment hat einen Effekt: Deutlicher Sprung beim cut-off-Wert beim Vergleich beider Gruppen sichtbar o Sprung = Diskontinuität Dieser „Sprung“, beziehungsweise die differierende Konstante in der Regressionsgleichung belegt die Wirkung des Treatments Statistische Analyse: Dummy-Kodiertes Treatment. DR-Designs: - Einsatzgebiet: Studien, welche Gruppen nach Leistung oder Bedarf unterteilen, z.B.: - Förderung bestimmter Gruppen (nach Bedarf oder Verdienst) - Durchführung einer Rehabilitation oder einer Therapie, wobei der Bedarf beispielsweise anhand von Befindlichkeitswerten nach einem Klinikaufenthalt ermittelt wurde Wichtig: cut-off-Wert sollte relativ nahe dem Median sein - Nachteile dieses Designs: o Hoher Stichprobenbedarf (höher als bei randomisierten Designs) o Suche nach dem optimalen cut-off-Wert oft nicht leicht (statistische (z.B. Median) vs. praktische / klinische Entscheidung) 64 - o Md kann ich erst nehmen, wenn ich alle Vp´s schon erhoben habe. Wo ist die Grenze? Ab wie viel kg/KG cut off? Vorteile: o Bei erfüllten Voraussetzungen fast so gute interne Validität wie randomisierte Experimente (Wieso ist Selektion hier kein Problem?) o Große Flexibilität bei Auswahl der Zuweisungsvariablen o Bedürftigkeit/ Verdienst kann berücksichtigt werden und erhöht oftmals die Akzeptanz und Durchsetzbarkeit des Designs Zuweisungsvariable und cut-off- Werte • Zuweisungsvariable kann der Prä-Wert der aV sein oder eine beliebige andere intervallskalierte Variable (z.B. Geburtsjahr). - z.B. Rechtsschreibleistung vor einem Treatment Wichtig: - Die Zuweisungsvariable sollte mindestens intervallskaliert sein und eine möglichst große Streuung haben. - Keine dichotome Zuweisungsvariable (2geteilt, z.B. Geschlecht) (Regressionsgeraden dann nicht schätzbar) - Eine Korrelation mit der abhängigen Variable ist nicht wichtig; im Gegenteil die statistische Trennschärfe steigt, wenn keine Korrelation vorliegt. cut-off-point • kann nach verschiedenen Kriterien gewählt werden - Z.B. praktischen Festlegungen, BMI > 30 - Oder statistisch gewählt, z.B. über einen Median- Split (allerdings nur möglich, wenn die Stichprobe relativ „schnell“ gewonnen wird, da der cut-off-Wert in der Erhebungsphase schon als Zuordnungskriterium verwendet wird). - Auch dürfen bei einem kontinuierlichen Merkmal nicht nur die Maximalwerte (z.B. 99.9Prozentrang) als cut-off-Wert gewählt werden, da sonst keine Regressionsgeraden schätzbar Beispiel: 65 Variationen des Standardvorgehens Statt eines Treatment-Kontrollgruppen- Vergleichs können auch zwei Treatmentgruppen verglichen werden. Mehr als zwei Gruppen können verglichen werden (Standardbehandlung, neue Behandlungsform, Kontrollgruppe). Das Treatment kann in Abhängigkeit von der Zuweisungsvariablen in verschiedenen Dosierungen zugefügt werden. 66 Randomisierte Experimente und diskontinuierliche Regressionsdesigns Bei allen Teilnehmenden wird eine Prä-Messung erhoben. Randomisierte Zuweisung zur Experimental- und zur Kontrollgruppe unabhängig vom PräWert der Probanden. Bei zufälliger Zuordnung sollten die Mittelwerte und Streuungen der Prä-Werte in beiden Gruppen ähnlich sein. Anhand des Scatterplots und der statistischen Analyse kann dann beurteilt werden, ob das Treatment einen Effekt hat. Kein Treatmenteffekt: Für Kontroll und Experimental-gruppe ergibt sich eine identische Regressionsgleichung Der Zusammenhang zwischen Prä- u. Post-Werten und die jeweiligen Mittelwerte sind gleich (zumindest unterscheiden sie sich nicht statistisch bedeutsam) RD-Designs mit Randomisierung 67 Was passiert bei randomisierten Experiment wenn ein cut-off-Wert bei 28 eingeführt wird und dann: o In der KG nur Werte kleiner dem cut-off-Wert und o In der EG nur Werte größer dem cut-off-Wert zugelassen werden? Voraussetzung Linearität (=Nachteil, da nicht alles linear verteilt ist) Vorsicht Bei diskontinuierlichen Regressionsdesigns, wird zunächst von linearen Zusammenhängen ausgegangen. D.h. zur Vorhersage wird eine Regressionsgerade herangezogen. Aber sind die Zusammenhänge zwischen Prädiktor und Kriterium immer linear? o Es sollte und kann überprüft werden ob ein nicht-lineares Modell (z.B. quadratisch, kubisch oder exponentiell) nicht eine bessere Modellpassung (Vorhersage) erreicht Vorausgesetzt wird das die funktionelle Form der Abhängigkeit von Zuweisungsvariable und Ergebnisvariable korrekt modelliert wird. 68 Weitere Voraussetzungen: Die Zuweisungsvariable darf nicht durch das Treatment beeinflusst werden Beispielsweise Prätest (zeitlich vor treatment) Zeitlich stabile Variable (Geburtstag) Die Versuchspersonen müssen aus einer gemeinsamen Population kommen; praktisch: Teilnehmer hätten prinzipiell das treatment bekommen können, wenn der cut-off anders gewählt worden wäre, so dass sie in die EG fielen Erweiterung der Ergebnisinterpretation Bisher: Bei vorliegendem Treatmenteffekt zwei parallele Regressionsgeraden Differenz der Konstanten in beiden Regressionsgeraden = Treatmenteffekt Frage: Müssen beide Regressionsgeraden parallel verlaufen (bzw. ist dies immer der Fall?) 69 Probleme bei der Interpretation von nicht-linearen Zusammenhängen oder Interaktionseffekten • Allgemein: Interpretation ohne Diskontinuität ist schwierig. Z.B. Quadratischer Zusammenhang zwischen Zuweisungsvariable und abhängiger Variable ohne Treatmenteffekt Generell sollte bei zu erwartenden Interaktionseffekten zur Verbesserung des Designs eine randomisierte Zuweisung erfolgen. Methoden zur Verbesserung der Power eines RD-Designs Als cut-off-Wert den Mittelwert der Zuordnungsvariable wählen (ähnlich große Gruppen). Nach Möglichkeit eine intervallskalierte Zuordnungsvariable wählen (oder wenigstens eine ordinalskalierte Variable mit vielen Kategorien). Je mehr Varianz in der Zuordnungsvariable, desto besser. Die Zuordnungsvariable sollte so wenig wie möglich mit dem Treatment korrelieren. o z.B. indem die Personen in einem mittleren Intervall der Zuweisung einer Gruppe, die Personen außerhalb des Intervalls der anderen Gruppe zugeordnet werden Kombiniere mit randomisierten Experimenten im mittleren Intervall Nach Möglichkeit nicht mit zu vielen Interaktions- und nicht-linearen Termen ein unnötigerweise komplexes Regressionsmodell erstellen (eventuell unnötiger Verlust an Freiheitsgraden). Mittleres cut-off-Intervall einer Bedingung A zuordnen, äußere Intervalle einer zweiten Bedingung B Kombination von RD mit einer randomisierten Zuordnung, beziehungsweise Verwendung eines möglichst großen Intervalls mit randomisierter Zuordnung. Praktische Durchführung einer RD-Analyse Die Regressionskoeffizienten in den verschiedenen Gruppen sind nie identisch, aber bei fehlendem Treatmenteffekt ähnlich. Überprüft werden muss, ob eine Gleichsetzung der Koeffizienten (Gewinn an Freiheitsgraden) eine signifikante Reduktion der Modellpassung bewirkt. • Wenn nicht! -> kein Effekt! • Wenn doch! -> Treatmenteffekt! Interne Validität Alternativerklärung: Wieso Diskontinuität am Cut-off? History kann bedeutsam sein o Bedürftige Gruppe auch für weitere Programme berechtigt Selection ist lückenlos kontrolliert und vollständig berücksichtigt (bei erfüllten Voraussetzungen dito: Regression Testing unplausibel (EG und KG erhalten gleiche Tests) Instrumentation, maturation kann zu Verletzung der Linearität: o Komplexere Modellierung erfordert (z.B. polynomiale Terme) o Aber dann ist die interne Validität nicht weiter gefährdet Problem: genaues Einhalten von Zuordnungsvorschriften, insbesondere bei Grenzfällen. 70