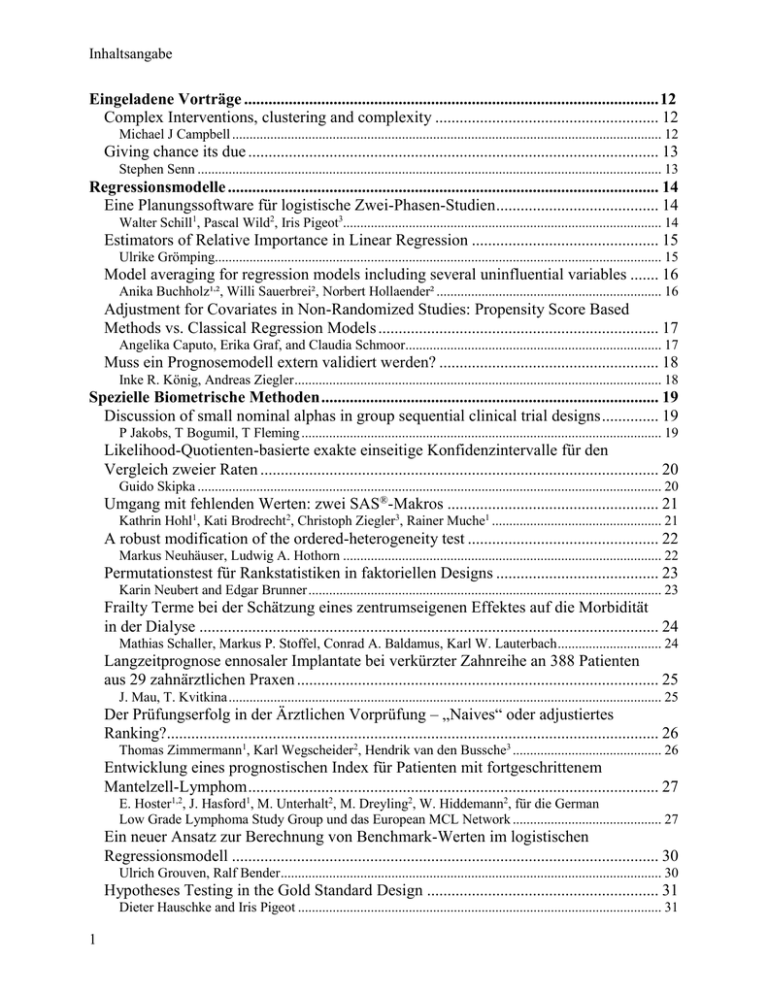

Abstractband downloaden - Deutsche Region der Internationalen

Werbung