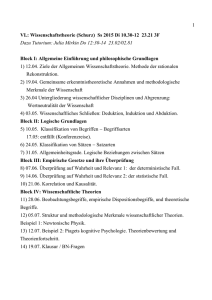

PRÜFUNGSFRAGEN der VO „Philosophische

Werbung