Word - Das IICM - Graz University of Technology

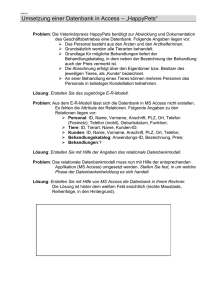

Werbung

Wissensauffindung in verteilten Systemen

Lokale Suchmaschine und Informationsaufbereitung für externe

Suchdienste

Diplomarbeit

an der

Technischen Universität Graz

vorgelegt von

Bernhard Knögler

Institut für Informationsverarbeitung und computergestützte neue Medien IICM

Technische Universität Graz

A-8010 Graz

Österreich

September 1999

© Copyright 1999, Bernhard Knögler

Begutachter: o.Univ.-Prof. Dr. Dr.h.c. Hermann Maurer

Betreuer: Dipl.-Ing. Christian Gütl

Kurzfassung

Das Internet repräsentiert heute, seit der Entwicklung einfach zu bedienender Zugriffswerkzeuge, die weltweit größte und am schnellsten wachsende unstrukturierte Wissensund Informationsdatenbank. Gerade diese Eigenschaften erschweren das Auffinden von

relevanten Informationen und verhindern die effiziente Nutzung des World Wide Web.

Aus der Notwendigkeit heraus, den Benutzern des Web die Möglichkeit zu geben,

Informationen zu einem bestimmten Thema zu finden, entstanden in den letzten Jahren

mehrere Suchdienste, die jeder für sich mehr oder weniger große Teile des World Wide

Web indizieren und eine Suche ermöglichen.

Mit den gegenwärtigen Methoden der Informationssammlung dieser Suchdienste und

der steigenden Anzahl von Dokumenten und aktiven Suchmaschinen wird die dadurch

verursachte Netz- und Serverbelastung künftig andere Anwendungen weitgehend

beeinträchtigen. In der vorliegenden Arbeit werden daher neue Forschungsansätze wie

lokale Indizes und hierarchische Suchdienste näher untersucht. Dabei werden gegenwärtige

Konzepte lokaler Informationssammlung und Konzepte zur Bereitstellung bereits

gesammelter Daten für externe, übergeordnete Suchdienste behandelt.

Die Ergebnisse des Untersuchungsbereiches führen in weiterer Folge zur Entwicklung

eines leicht portierbaren lokalen Suchdienstes, der die Bereitstellung von Informationen –

Inhalte sowie Metadaten – für externe Suchdienste ermöglicht. Zusätzlich werden die

Informationen über ein Web-Suchinterface zur Verfügung gestellt, wobei ein Index mit

einem Ranking- und Relevanzsystem und automatischer Schlüsselwortbildung aus den

Dokumenten aufgebaut wird. Die lokale Suchmaschine sowie die Schnittstellen werden

detailliert dokumentiert und zukünftige Erweiterungsmöglichkeiten aufgezeigt.

Abstract

Today, since the development of simple-to-use access tools, the Internet represents the

world's largest and fastest growing unstructured knowledge and information database.

However, exactly this very characteristic makes the discovery of relevant information

difficult and prevents efficient use of the World Wide Web. In recent years search engines

have been developed to give users the possibility to search and find certain information on

the Web. All these search services gather independently information from more or less

large parts of the Internet.

Present day methods of information collection and the ever-growing quantity of

documents and active search engines will increasingly affect future internet applications

because of repeated net- and server-load caused by information gathering. In this thesis

new approaches such as local gathering and hierarchical search services will be analysed.

Furthermore, current concepts of local search engines and concepts of providing already

gathered information for external, hierarchically higher levels of search services are

discussed.

The results of this analysis lead to the development of an easily portable local search

engine which enables providing information – contents as well as meta information – for

external search services. Additionally, the gathered information will be made available

through a Web search interface. An index with a ranking and relevance system and

automatic keyword extraction from the documents will be created. The local search engine

and the interfaces are documented in detail and future ways of extending the engine will be

discussed.

Danksagung

An dieser Stelle möchte ich mich bei all jenen Bedanken, die mir beim Erstellen dieser

Arbeit mit Trost und Hilfe zur Seite standen.

Allen voran o.Univ.-Prof. Dr. Dr. h.c. Hermann Maurer, Leiter des Instituts für

Informationsverarbeitung und computergestützte neue Medien (IICM) und Begutachter

dieser Arbeit sowie meinem Betreuer Dipl.-Ing. Christian Gütl, der mir durch wiederholte

Besprechungen und oftmaliges Korrekturlesen geholfen hat.

Ganz besonderer Dank gilt meinen Eltern Gerda und Kurt Knögler, die mein Studium

erst ermöglichten, mich all die Jahre hinweg unterstützten und mit tatkräftiger Hilfe immer

schnell bei der Stelle waren.

Ich versichere hiermit, diese Arbeit selbständig verfaßt, andere als die angegebenen

Quellen und Hilfsmittel nicht benutzt und mich auch sonst keiner unerlaubten Hilfsmittel

bedient zu haben.

Inhaltsverzeichnis

Kapitel 1

1.1

1.2

Motivation............................................................................................................................ 1

Strukturierung der Arbeit ..................................................................................................... 3

Teil I

Kapitel 2

2.1

2.2

2.3

2.4

3.3

3.4

3.5

Suchdienste ................................................................................................. 6

Lokale und verteilte Aufbereitung ......................................................... 19

Grundlagen ........................................................................................................................ 19

Vorteile der verteilten Informationsaufbereitung .............................................................. 20

3.2.1 Vollständigkeit und Aktualität ..............................................................................20

3.2.2 Netz- und Serverbelastung ....................................................................................20

3.2.3 Gliederung des Informationsraumes .....................................................................21

3.2.4 Zusatzinformationen .............................................................................................21

Nachteile der verteilten Informationsaufbereitung ............................................................ 22

Lokale Informationsaufbereitung und Suchdienste ........................................................... 22

3.4.1 Harvest ..................................................................................................................23

3.4.2 Hyperwave ............................................................................................................24

Zusammenfassung ............................................................................................................. 26

Kapitel 4

4.1

Untersuchungsbereich................................................................5

Grundlagen .......................................................................................................................... 6

2.1.1 Informationsauffindung und Aufbereitung .............................................................7

2.1.2 Bereitstellen der Informationen ..............................................................................9

Einteilung der Suchdienste ................................................................................................ 11

Schwachpunkte gängiger Suchdienste ............................................................................... 12

2.3.1 Vollständigkeit, Aktualität und Linkkonsistenz....................................................12

2.3.2 Netz- und Serverbelastung ....................................................................................13

2.3.3 Qualität und Zuverlässigkeit .................................................................................14

2.3.4 Zusatzinformationen .............................................................................................16

2.3.5 Relevanz der Informationen ..................................................................................17

Zusammenfassung ............................................................................................................. 18

Kapitel 3

3.1

3.2

Einleitung ................................................................................................... 1

Formate und Metadaten ......................................................................... 27

HTML – Hypertext Markup Language .............................................................................. 28

4.1.1 Kurzbeschreibung der Syntax ...............................................................................29

4.1.2 Meta-Tags in HTML-Dokumenten .......................................................................31

4.2

4.3

4.4

4.5

Standardisierte Metadaten.................................................................................................. 39

4.2.1 DC - Dublin Core Metadata Element Set..............................................................39

4.2.2 LOM – Learning Object Metadata ........................................................................43

4.2.3 PICS – Platform for Internet Content Selection....................................................44

Metadatenformate zum Datenaustausch ............................................................................ 46

4.3.1 SOIF – Harvest Summary Object Interchange Format ........................................46

4.3.2 XML – Extensible Markup Language ..................................................................49

4.3.3 MCF – Meta Content Framework .........................................................................55

4.3.4 RDF – Resource Description Framework .............................................................56

Ausblick ............................................................................................................................. 63

Zusammenfassung ............................................................................................................. 64

Teil II

Kapitel 5

5.1

5.2

6.4

6.5

6.6

6.7

6.8

7.2

7.3

7.4

7.5

7.6

7.7

Der Gatherer ............................................................................................ 71

Funktionsbeschreibung ...................................................................................................... 72

Beschreibung des Gathervorganges ................................................................................... 74

Konfiguration des Gatherers .............................................................................................. 75

6.3.1 Sektion Config ......................................................................................................76

6.3.2 Sektion Gather ......................................................................................................78

6.3.3 Sektion Info...........................................................................................................82

6.3.4 Sektion Disallow ...................................................................................................82

Zusatzinformationen .......................................................................................................... 83

Meta-Tag Robots ............................................................................................................... 83

Virtuelle Hosts ................................................................................................................... 85

Beispiel einer Konfigurationsdatei .................................................................................... 85

Zusammenfassung ............................................................................................................. 87

Kapitel 7

7.1

Softwaredokumentation .......................................................................... 66

Gesamtkonzept .................................................................................................................. 66

Zusammenfassung ............................................................................................................. 70

Kapitel 6

6.1

6.2

6.3

Gestaltungsbereich....................................................................65

Fehlertoleranter HTML-Konverter ....................................................... 88

Konfiguration des Konverters ............................................................................................ 89

7.1.1 Sektion ConvertTab ..............................................................................................89

7.1.2 Sektion Separator ..................................................................................................93

7.1.3 Weitere Konfiguration ..........................................................................................94

Detailaspekte des Konverters............................................................................................. 94

Performance ..................................................................................................................... 100

Unterschiede Windows/UNIX ......................................................................................... 101

Erweiterungsmöglichkeiten ............................................................................................. 101

Vollständige Konfigurationsdatei .................................................................................... 102

Zusammenfassung ........................................................................................................... 104

Kapitel 8

Das Gatherer-Collector-Interface ........................................................ 105

8.1

8.2

8.3

8.4

8.5

Funktionsbeschreibung .................................................................................................... 106

Protokollbeschreibung ..................................................................................................... 108

8.2.1 Die Willkommens-Meldung ...............................................................................108

8.2.2 Das HELLO Kommando ....................................................................................109

8.2.3 SEND-UPDATE und SEND-INFO-UPDATE ...................................................109

8.2.4 Das SET Kommando ..........................................................................................110

8.2.5 Das SEND-OBJECT Kommando .......................................................................111

8.2.6 Das INFO Kommando ........................................................................................111

8.2.7 Das HELP Kommando .......................................................................................111

8.2.8 QUIT, EXIT und BYE ........................................................................................111

Antworten und Fehlermeldungen des Interfaces ............................................................. 112

Beispiel für einen Datenaustausch ................................................................................... 114

Zusammenfassung ........................................................................................................... 115

Kapitel 9

9.1

9.2

9.3

9.4

9.5

Der Suchdienst ....................................................................................... 116

Suchabfrage ..................................................................................................................... 117

9.1.1 Suchbereich .........................................................................................................118

9.1.2 Relevanz..............................................................................................................119

9.1.3 Ausgabemöglichkeiten ........................................................................................119

9.1.4 Stoppwörter .........................................................................................................120

Konfiguration des Suchservlets ....................................................................................... 121

Implementierung .............................................................................................................. 122

Einbindung des Servlets am Beispiel des Webservers Jigsaw ......................................... 126

Zusammenfassung ........................................................................................................... 129

Kapitel 10

Datenbank – Anbindung und Aufbau ................................................. 130

10.1 Zielsetzung ....................................................................................................................... 130

10.2 Datenbankdesign.............................................................................................................. 132

10.2.1 Theorie relationaler Datenbanken .......................................................................132

10.2.2 Relationen der Dokumentenverwaltung..............................................................133

10.2.3 Dokument- und Informationsspeicherung ..........................................................136

10.3 Arbeitsweise .................................................................................................................... 137

10.3.1 Einfügen ..............................................................................................................137

10.3.2 Löschen ...............................................................................................................138

10.4 Suchabfragen ................................................................................................................... 139

10.4.1 Suchabfrage mit einem Wort ..............................................................................140

10.4.2 Boolesche Operatoren .........................................................................................141

10.4.3 Eingeschränkte Suche .........................................................................................143

10.4.4 Gewichtung gefundener Dokumente ..................................................................144

10.5 Erweiterung der Datenbank um neue Attribute ............................................................... 146

10.6 Konfiguration der Datenbank .......................................................................................... 147

10.6.1 Sektion Config ....................................................................................................147

10.6.2 WordFilter ...........................................................................................................150

10.6.3 Rating ..................................................................................................................150

10.6.4 Stoppwörter .........................................................................................................151

10.6.5 Vollständige Konfigurationsdatei .......................................................................152

10.7 Implementierung .............................................................................................................. 153

10.8 Zusammenfassung ........................................................................................................... 156

Kapitel 11

Zusätzliche Module................................................................................ 157

11.1 ConfigReader ................................................................................................................... 157

11.1.1 Implementierung .................................................................................................158

11.1.2 Programmierbeispiel ...........................................................................................159

11.2 Log und LogListener ....................................................................................................... 160

11.2.1 Konfiguration ......................................................................................................160

11.2.2 Implementierung .................................................................................................161

11.2.3 Programmierbeispiel ...........................................................................................162

11.3 StringFilter ....................................................................................................................... 163

11.4 StrTokenizer .................................................................................................................... 165

11.5 MD5 und MD5Builder..................................................................................................... 166

11.6 ListenPort......................................................................................................................... 167

11.7 SendPassword .................................................................................................................. 168

11.8 TimeDiff .......................................................................................................................... 169

11.9 Common .......................................................................................................................... 170

11.10 AVTable .......................................................................................................................... 171

11.10.1 Konfiguration ......................................................................................................171

11.10.2 Implementierung .................................................................................................173

11.11 AVTableFilter .................................................................................................................. 174

11.12 AVTableAnalyzer ............................................................................................................ 178

11.12.1 Konfiguration ......................................................................................................178

11.12.2 Implementierung .................................................................................................179

11.13 AVTableConverter .......................................................................................................... 181

11.14 Zusammenfassung ........................................................................................................... 182

Kapitel 12

Ausblick .................................................................................................. 183

Kapitel 13

Zusammenfassung ................................................................................. 185

Anhang 1...................................................................................................187

Anhang 2...................................................................................................201

Kapitel 1

Einleitung

1.1 Motivation

Seit der Entwicklung einfach zu bedienender Zugriffswerkzeuge wie Mosaic, Netscape

Navigator oder dem Internet Explorer hat sich das World Wide Web nahezu explosionsartig verbreitet. Das Informationsangebot ist in kürzester Zeit unüberschaubar gewachsen,

so daß die Suche in diesem Informationsraum die heute beinahe wichtigste, aber auch die

problematischste Anwendung des Internet geworden ist. Um dies zu Unterstreichen soll

hier die Studie von SQRiBE Technologies Corp., Kalifornien, erwähnt werden. Durch

ineffiziente Suche in Datennetzen verliert Europas Wirtschaft jährlich mehrere Milliarden

Schilling, was die Notwendigkeit der Entwicklung effizienterer Suchwerkzeuge

hervorhebt. [Hor1998]

Im folgenden wird eine kurze Einführung über die Entstehung des Internet und

insbesondere des World Wide Web gegeben, um damit die enorme Geschwindigkeit der

Entwicklung zu verdeutlichen, welche im weiteren zur Entwicklung von Suchdiensten

führte.

Das Internet

Als die Advanced Research Projects Agency1 1969 ein Projekt aus der Taufe hob, das

ein experimentelles paketvermitteltes Netzwerk implementieren sollte, da ahnte noch

niemand, daß genau dieses ARPANET das erste kleine Stückchen Straße für den erst

Jahrzehnte später entstehenden "Information Superhighway" war. Das Projekt war

hauptsächlich dafür ausgelegt, wichtige militärische Daten besser schützen zu können,

indem man die gleichen Daten auf mehreren, weit entfernten Rechnern ablegt und bei

neuen oder geänderten Daten allen angeschlossenen Rechner binnen kürzester Zeit den

aktuellen Datenstand über mehrere unabhängige Wege zukommen lassen zu können.

[EH1996]

Das Prinzip der vernetzten Rechner war aber nicht nur für militärische Zwecke

interessant. Man erkannte schnell, daß auch der akademische Betrieb vom ARPANET

1

heute Defense Advanced Research Projects Agency, DARPA, http://www.arpa.mil

KAPITEL 1 - EINLEITUNG

2

profitieren würde. Der Anschluß der akademischen Welt ans Netz erforderte eine

Trennung zwischen dem militärischen und dem zivilen Teil. So kam es, daß Anfang der

80er Jahre ein neues militärisches Datennetz, das Milnet, vom ARPANET abgekoppelt

wurde. Das ARPANET selbst wurde dem wissenschaftlichen Betrieb überlassen.

[Münz1998]

Im zivilen Teil des Netzes nahm die Anzahl der angeschlossenen Rechner im Laufe der

80er Jahre sprunghaft zu. Eine wichtige Rolle spielte dabei die amerikanische National

Science Foundation2. Diese Organisation schaffte ein Leitungs-Verbundsystem, das alle

bedeutenden wissenschaftlichen Rechenzentren des Landes miteinander verband. Einzelne

Universitätsrechner oder kleinere Rechnernetze konnten sich mit einem Rechenzentrum

verbinden und darüber in andere Netze gelangen. So entstand buchstäblich ein Netz der

Netze. Alsbald bürgerte sich auch der Name "Internet" dafür ein. Ein weiterer wichtiger

Schritt war auch die Vereinheitlichung des Datenübertragungsprotokolls. Ab 1983 wurde

ausschließlich TCP/IP3 als Übertragungsprotokoll verwendet. [Münz1998]

Doch erst mit der Entwicklung eines neuen Dienstes, des World Wide Web, hat sich das

Interesse am Internet von der wissenschaftlichen und militärischen Nutzung hin zu einer

zunehmenden Kommerzialisierung gewandelt und die Öffentlichkeit begann, auf das neue

Medium aufmerksam zu werden. [Münz1998]

Das World Wide Web

Die Geschichte des World Wide Web (WWW oder auch W3) begann um 1990 in Genf.

Tim Berners-Lee, britischer Informatiker am Genfer Hochenergieforschungszentrum

CERN4, startete zusammen mit einigen Kollegen eine Initiative, um das Internet für einen

neuartigen Informationsaustausch zwischen Wissenschaftern zu nutzen. Es ging darum,

wissenschaftliche Dokumente online sichtbar zu machen, wobei einfache Textformatierung

und das Einbinden von Grafik möglich sein sollte. Genau diese Technik ist die Grundlage

für das gesamte heutige World Wide Web mit seiner unüberschaubaren Anzahl an

Dokumenten. Das Internet repräsentiert heute, seit der Entwicklung einfach zu bedienender

Zugriffswerkzeuge, die weltweit größte und am schnellsten wachsende unstrukturierte

Wissens- und Informationsdatenbank. Die effektive Nutzung dieser Informationen erwies

sich im Laufe der Zeit als beinahe unmöglich und führte in weiterer Folge zur Entwicklung

von Suchdiensten, also Werkzeugen zum Auffinden von Dokumenten anhand bestimmter

Begriffe. [BCL+1994]

Suchdienste

Als die ersten Suchdienste 1994/95 aufgebaut wurden [SoMa1998], reagierten sie auf

folgendes offensichtliches Problem: die Anzahl der im Netz verfügbaren Informationen

und Texte hatte in exponentiellem Wachstum zugenommen (zur Zeit wird die Anzahl der

öffentlich indizierbaren Server auf 3 Millionen und die Anzahl der Dokumente auf diesen

Servern auf etwa 800 Millionen geschätzt [LG1999]) und es war in wenigen Jahren eine

riesige, den Globus umspannende Bibliothek entstanden; eine Bibliothek allerdings – man

denke sich dergleichen außerhalb der virtuellen Sphäre – ohne Katalog und ohne zentrale

2

National Science Foundation, NSF, http://www.nsf.gov

3

Transmission Control Protocol / Internet Protocol

4

Conseil Europénne pour la Recherche Nucléaire (dt. Europäische Organisation für

Kernforschung)

KAPITEL 1 - EINLEITUNG

3

Beschaffung, mit willkürlich gewählten Signaturen und ohne jede Möglichkeit, beim

Auskunftspersonal Hilfe zu finden.

Heute verfügbare Suchverfahren und die Aufbereitung der Informationen durchsuchter

Dokumente stellen in Teilbereichen hilfreiche Werkzeuge zur Verfügung. Doch mit den

gegenwärtigen Methoden und der Zunahme von Dokumenten und Suchmaschinen wird

allerdings die dadurch verursachte Netz- und Serverbelastung künftig andere Anwendungen weitgehend beeinträchtigen. Ein weiteres Problem ergibt sich durch das Wachstum

und die enorme Dynamik des Web, so daß auch größere Suchdienste immer nur einen

Bruchteil aller Dokumente erfassen können. Die Dynamik äußert sich durch einen

kontinuierlichen Wandel der Dokumente und ihrer Inhalte, durchschnittlich soll sich ein

Dokument alle 75 Tage ändern. [Bra1997]

1.2 Strukturierung der Arbeit

Aus den in Abschnitt 1.1 genannten Gründen es notwendig, neue Wege in der Auffindung und Bereitstellung von Informationen zu entwickeln und auf ihre Verwendungsmöglichkeiten hin zu untersuchen. In dieser Arbeit wird im Untersuchungsbereich (siehe

Teil I) nach einer einführenden Begriffsbestimmung und einem Überblick über gängige

Suchdienste und Systeme zur Informationsauffindung vor allem auf die Schwachpunkte

dieser Suchdienste näher eingegangen (siehe auch Kapitel 2).

Die Untersuchungen in Kapitel 3 zeigen, daß sich die meisten dieser Schwachpunkte

durch das Konzept lokaler und verteilter Informationsaufbereitung und die Eingliederung

von lokalen Modulen in hierarchische Suchstrukturen vermeiden bzw. verbessern lassen.

Vor- und Nachteile gegenüber herkömmlichen Suchmaschinen werden hier näher erläutert.

Metainformationen, also Informationen über Dokumente oder andere Objekte, werden

für Suchdienste immer wichtiger, um relevante Ergebnisse liefern zu können. Oft wird es

erst dadurch möglich, den korrekten Inhalt und Themenbezug eines Dokumentes ermitteln

zu können. Die Einbettung von Metainformationen in HTML-Dokumente wird im

Abschnitt 4.1 genauer erläutert, damit die im Gestaltungsbereich entwickelten Module für

die Extraktion und Verwendung von Metainformationen konfiguriert werden können.

Es gibt mehrere Initiativen, die Vorschläge für Metainformationen über beliebige

Objekte beschreiben, wobei heute vor allem Dublin Core oder auch LOM (siehe Abschnitt

4.2) verwendet werden. Zur Weitergabe von Daten über Dokumente beispielsweise von

Suchdienst zu Suchdienst ist es notwendig, diese in einheitlichen Formaten zu übertragen.

Dabei gibt es bereits etablierte Standardformate wie z.B. SOIF. Auf diese und auf sich

gerade in Entwicklung befindliche Formate geht Abschnitt 4.3 näher ein. Es bietet eine

Zusammenfassung von Formaten zur Weitergabe von Metainformationen wie XML, MCF

und RDF.

Die Erkenntnisse des Untersuchungsbereiches führen im Gestaltungsbereich (Teil II) zur

Entwicklung eines leicht portierbaren lokalen Suchdienstes, wobei Kapitel 5 eine

Übersicht der implementierten Module gibt. Der Informationssammler5 (siehe auch Kapitel

6) trägt Informationen – Inhalten sowie Metadaten – über Dokumente zusammen, die dann

mit einem Interface für weitere externe Suchdienste bereit gestellt werden (siehe auch

5

hier im weiteren engl. Gatherer genannt

KAPITEL 1 - EINLEITUNG

4

Kapitel 8). Die notwendigen Informationen werden von einem fehlertoleranten und

konfigurierbaren HTML-Konverter extrahiert (siehe auch Kapitel 7), wobei die

Erweiterbarkeit anhand eines Moduls zur automatischen Generation von Zusammenfassungen demonstriert wird. Zusätzlich werden die extrahierten Informationen über ein WebSuchinterface zur Verfügung gestellt (siehe auch Kapitel 9), die Indizierung erfolgt mit

variablem Ranking- und Relevanzsystem und automatischer Schlüsselwortbildung aus den

Dokumenten. Die indizierten Begriffe werden in einer relationalen Datenbank gespeichert

(siehe Kapitel 10). Im Kapitel 11 werden weitere Module, die für diese Arbeit implementiert wurden, beschrieben.

Im Ausblick werden schließlich weiterführende Ergänzungen und Einsatzmöglichkeiten

des Systems erörtert. So läßt sich zum Beispiel eine Modul zur Erkennung der in einem

Dokument verwendeten Sprache in den HTML-Konverter integrieren.

Teil I

Untersuchungsbereich

Kapitel 2

Suchdienste

Eine effektive Nutzung des World Wide Web wäre wegen der enormen Anzahl an

Dokumenten und deren kontinuierlicher Veränderung und Erweiterung ohne die Hilfe von

Suchdiensten nicht mehr möglich. Im folgenden wird versucht, einen Überblick über

gängige Ansätze und Systeme zur Wissensauffindung zu geben. Danach werden

Schwachpunkte gängiger Verfahren untersucht.

2.1 Grundlagen

Die Aufgabe der Suchdienste ist es, aus den hunderten Millionen Web-Dokumenten und

Newsgroup-Beiträgen Verweise zu den gewünschten Themen bereitzustellen. Das Internet

stellt sich als ein dynamischer Informationsraum dar, der durch ständige Änderungen bzw.

durch exponentielles Anwachsen des Informationsinhalts1 und durch eine völlige

unstrukturierte Form gekennzeichnet ist. Dabei müssen sich die Suchdienste der

Anforderung stellen, die jeweiligen Veränderungen von bestehenden Dokumenten zu

erfassen und neue Dokumente in ihren Suchindex aufzunehmen. Eine vollständige und

möglichst aktuelle Erfassung von Dokumenten wird immer nur auf einen Teilbereich des

Internet beschränkt bleiben können.

Weiters ist eine geeignete Datenaufbereitung der durchforsteten Dokumente und die

Bereitstellung eines Userinterfaces notwendig, damit die angebotenen Informationen von

den Benutzern auch gefunden werden können. Die notwendigen Komponenten eines

Suchdienstes lassen sich in drei Funktionseinheiten – Informationsauffindung (also

Durchforsten der Dokumentenstrukturen), Aufbereitung und Bereitstellung – unterteilen,

die im nachfolgenden beschrieben werden.

1

Bis 1998 verdoppelte sich die Anzahl der Dokumente alle 8 Monate [Alx1998], wobei

sich dieser Trend weiter fortsetzt. Anfang 1998 betrug die Anzahl der Dokumente im

Web 320 Millionen [LG1998] und stieg bis Juni 1999 auf über 800 Millionen an

[LG1999].

KAPITEL 2 - SUCHDIENSTE

2.1.1

7

Informationsauffindung und Aufbereitung

Bevor der Anwender die Möglichkeit der Suche hat, müssen Informationen über die

Dokumente erst gesammelt werden. Es gibt verschiedene Möglichkeiten, wie Dokumente

im World Wide Web lokalisiert werden, wobei die Grenzen durchaus fließend ineinander

übergehen und Kombinationen möglich sind. Eine Sonderstellung nehmen Informationssysteme ein, die ein integriertes Suchsystem besitzen. Ein Beispiel dafür ist das

Hyperwave-System (siehe auch Kapitel 3.4.2). Hierbei werden die Dokumente bereits

beim Einfügen indiziert, so daß die Suchinformationen immer auf dem aktuellsten Stand

sind.

Vollautomatische Auffindung

Bei dieser Methode der Informationssammlung verfolgt ein Programm ähnlich wie ein

Benutzer Hyperlinks auf Web-Seiten bzw. Verzeichnisstrukturen auf FTP-Servern. Diese

sogenannten Robots oder Spider verarbeiten vollautomatisch alle gefundenen Dokumente

und versuchen, relevante Informationen wie etwa Namen von Autoren, Titel und

Schlüsselwörter zu extrahieren. [WRD1998a]

Bei diesen Spidern handelt es sich um Programme, die das Internet kontinuierlich

durchforsten. Sie starten auf der Homepage eines bestimmten Servers, verfolgen

nacheinander alle Links und sammeln Informationen über besuchte Objekte. Auf diese

Weise bewegen sich Spider seitenweise über den Server. Trifft ein Spider auf eine neue

oder geänderte Seite, wird aus dieser eine Liste mit Schlüsselwörtern generiert und die

Datenbank der jeweiligen Suchmaschine entsprechend aktualisiert. Datensätze werden

entfernt falls die Seiten mittlerweile gelöscht wurden. Die einzige Aktion, die vom

Betreiber des Servers manuell vorgenommen werden muß, ist die einmalige Anmeldung

der Domäne. [WRD1998a]

Es gibt verschiedene Ansätze, wie relevante Informationen aus den Dokumenten

extrahiert werden. Schlüsselwörter können etwa durch einen Algorithmus festgelegt

werden, der sich an der relativen Häufigkeitsverteilung orientiert, wobei Wörter mit

geringer relativer Häufigkeit das Dokument beschreiben könnten. Wörter mit gewissen

Formatierungen (beispielsweise Überschriften oder Fettdruck) bieten ebenfalls

Ansatzpunkte, relevante Beschreibungen zu extrahieren. Auch die Verarbeitung von

sogenannten Meta-Tags im Dokument kann zusätzliche Informationen bringen (siehe auch

Kapitel 4.1.2 – Meta-Tags). Eine weitere Möglichkeit besteht darin, die gesamte VolltextInformation zu verarbeiten. In der vorliegenden Diplomarbeit ist die Extraktion von

Wörtern bzw. Dokumentteilen, die durch bestimmte Formatierungen gekennzeichnet sind,

implementiert. Zusätzlich können alle Metainformationen miteinbezogen werden.

Die durch Spider gewonnenen Informationen der jeweiligen Dokumente benötigen eine

Nachbearbeitung, vor allem um die Größe des Index zu reduzieren und so die Suche

effizienter durchführen zu können. Das Ergebnis der Reduktionen wird in einer Datenbank

indiziert und steht dann für eine Suchanfrage zur Verfügung. Einige Möglichkeiten der

Reduktion sind [Sul1999b]:

Entfernen von zu kurzen oder zu langen Wörtern und Löschen von Duplikaten.

Umwandeln aller Wörter in Kleinschreibung.

KAPITEL 2 - SUCHDIENSTE

8

Reduzieren erkannter Wörter auf ihren Wortstamm. Bei dieser Methode, genannt

Stemming, werden die Endungen von Wörtern entfernt, Einzahl bzw. Mehrzahl

angepaßt und oft auch der Tempus korrigiert, wodurch eine Normalisierung der

Begriffe erreicht wird. Stemming2 funktioniert vor allem mit der englischen Sprache

und es wird sichergestellt, daß etwa bei einer Suche nach 'walk' Wörter wie 'walking',

'walked' und 'walks' gefunden werden. Damit die Suche funktioniert, wird Stemming

auch auf Wörter der Suchabfrage angewandt und dann mit der Datenbankabfrage

begonnen.

Bedeutungssubstitution von Wörtern mit gleicher oder ähnlicher Bedeutung. Durch

Substitution bekannter Wörter auf ein Grundwort läßt sich nicht nur die Indexgröße

reduzieren, sondern auch die Erfolgsquote einer Suche erhöhen. So ist sichergestellt,

daß bei einer Suche nach 'Fell' auch Dokumente mit 'Pelz' oder 'Balg' gefunden werden.

Diese Umwandlung erfordert allerdings umfangreiches Sprachwissen des Suchdienstes,

wobei auch auf die Bedeutung der Wörter im Satzzusammenhang Rücksicht genommen

werden muß. Wie bei dem Stemming wird auch die Substitution zuerst auf die Wörter

der Suchabfrage angewendet. Diesen Mechanismus, der im Kapitel 2.3.3 noch kurz

erläutert wird, verwenden beispielsweise Excite3 oder Verity4.

Entfernen bestimmter Wörter wie Artikel oder unerwünschter Wörter mittels einer

Stoppliste. Die Stoppliste bietet dadurch auch die Möglichkeit einer eingeschränkten

Zensur.

Aktives Anmelden einzelner Seiten

Einige wenige Suchmaschinen setzen überhaupt keine Spider ein. Hier melden die

Benutzer Dokumente beim Suchsystem an, wobei auch zusätzliche Informationen wie

beispielsweise Beschreibungen, Schlüsselwörter und vor allem die zugehörigen Kategorien

angegeben werden können. Die Dokumente werden von Expertenteams beurteilt und in die

Kategorien aufgenommen. Meist wird auch der Inhalt der Dokumente extrahiert und

indiziert. [Koch1996]

Bei diesen Systemen ist der Seitenbestand entsprechend kleiner, das Angebot aber besser

kategorisiert. Einige Suchmaschinen, zum Beispiel Infoseek, erfassen die Daten zwar per

Spider, bieten aber ein zusätzliches, redaktionell betreutes Verzeichnis an.

Redaktionelle Recherche

Die Ergebnisse von meist automatischer Auffindung werden redaktionell bearbeitet und

bieten die Möglichkeit, gute Zusammenfassungen zur Suche anzubieten. Zusätzlich

werden manuelle Suchen zu bestimmten Themenkreisen durchgeführt oder vorangemeldete Dokumente geprüft und in den Suchdienst aufgenommen. Diese Art der Informationsaufbereitung nimmt vor allem im kommerziellen Bereich einen gewissen Stellenwert ein,

da für die so gefundenen Dokumente von den Redaktionsteams meist auch eine Bewertung

vorgenommen worden ist oder unzulängliche Dokumente erst gar nicht in den Suchdienst

übernommen werden. [Koch1996]

2

Stemming ist sprachabhängig, es gibt für jede Sprache Regeln, um ein Wort auf seinen

Stamm zu reduzieren.

3

Excite, http://www.excite.com

4

Verity, http://www.verity.com

KAPITEL 2 - SUCHDIENSTE

9

Die Anbieter von sogenannten "Added-value" Diensten mit Qualitätswertungen bzw.

Reviews und manuell erstellten Inhaltsbeschreibungen werden ständig zahlreicher

(Magellan5, Excite, OCLC's NetFirst6). Es ist allerdings meist schwer, sich einen

generellen Eindruck von der Qualität und Korrektheit dieser Angaben zu machen und sie

mit den automatischen Methoden auf der Grundlage der Originaldokumente zu

vergleichen.

2.1.2 Bereitstellen der Informationen

Neben dem intelligenten Durchforsten, Sammeln und Extrahieren von relevanten

Informationen ist die Schnittstelle zum Anwender eine weitere wichtige Komponente, da

erst so eine Suche im Datenbestand ermöglicht wird. Die zwei wichtigsten Vertreter

werden im folgenden kurz beschrieben.

2.1.2.1

Suchkataloge

Die Suche in Katalogen basiert auf der Navigation in hierarchisch nach Sachgebieten

gegliederten Themen. Auf der obersten Ebene werden beispielsweise Themen wie

Gesundheit, Finanz oder Computer angeboten, die bei einer Suche gewählt werden. Das

Thema wird jetzt stufenweise verfeinert bis letztendlich eine Übersicht der zu diesem

Thema gesuchten Dokumente angezeigt wird. Da mit steigender Anzahl an Kategorien die

Navigation im Katalog erschwert wird, bieten diese Suchdienste meist auch eine Suche

nach Stichworten an. [Koch1996]

Den menschlichen Aufwand, der beim Erstellen eines Kataloges nötig ist, kann man

anhand des Katalogsuchdienstes Open Directory7 (Netscape Communications) abschätzen.

Weltweit sind etwa 13.000 Angestellte und vor allem Freiwillige damit beschäftigt, den

Katalog ständig zu erweitern, wobei die Dokumente anhand von über 100.000 Kategorien

wie Wirtschaft, Wissenschaft und Sport klassifiziert werden. [Gug1999]

2.1.2.2

Suchindizes

Diese Dienste nutzen eine Datenbank, die im Hintergrund die extrahierten Informationen

der einzelnen Dokumente bereit hält. Dies können Schlüsselwörter, Autor, Erstelldatum

aber auch der gesamte Volltext sein (siehe auch Kapitel 2.1.1 – vollautomatische Suche)

[Bag1996]. Der Benutzer des Suchdienstes kann durch Eingabe eines oder mehrerer

Suchbegriffe nach den gewünschten Informationen suchen. Die meisten Dienste sind

mittlerweile dazu übergegangen, dem Benutzer nur ein einfaches Eingabefenster

anzubieten, oft sogar ohne weitere Hilfsinformation auf der gleichen Seite. Erweiterte

Suchfunktionen (wie boolesche Verknüpfungen) oder auch Anzeigealternativen werden

meist auf anderen Seiten angeboten und sind in ihrer Vielfalt eher reduziert. [Koch1996]

5

Magellan, http://www.mckinley.com

6

Online Computer Library Center, OCLC, http://www.oclc.org

7

Open Directory Project, ODP, http://dmoz.org

KAPITEL 2 - SUCHDIENSTE

10

Die grundlegenden Suchfunktionen, die von der Mehrzahl der im World Wide Web zur

Verfügung stehenden Dienste angeboten werden, sind [Sul1999c]:

Boolesche Operatoren

Wörter können mit den Operatoren AND, OR bzw. AND NOT verknüpft werden. So kann

man mit einfachen Befehlen angeben, daß nur Dokumente gesucht werden sollen, die etwa

die Wörter 'Restaurant' AND 'Graz' enthalten. Wichtig ist auch der Operator AND NOT,

mit dem eine Suche eingeschränkt werden kann, indem man bestimmte Wörter angibt, die

nicht in den Dokumenten vorkommen sollen.

Phrasen

Manchmal ist es nötig, nach bestimmten zusammengehörigen Wörtern zu suchen. Ein

Beispiel dafür sind Filmtitel (z.B. "the next generation").

Nähe

Bei manchen Suchmaschinen kann man mit dem Operator NEAR angeben, daß ein

bestimmtes Wort in einem Dokumente in der Nähe eines anderen Wortes vorkommen soll

(z.B. Resetarits NEAR Kabarett).

Wildcards

Mit bestimmten Platzhaltern kann man nach Variationen von Wörtern suchen, wobei

manche Suchdienste automatisch mit Wildcard suchen ('sing*' findet etwa 'singen' oder

'singapur').

Feldindizierung8

Eine weitere Möglichkeit ist es, die Suche auf bestimmte Attribute wie Titel oder

Überschrift einzuschränken.

Eine etwas andere Art der Eingabe für die Suche wird zusätzlich bei AltaVista9

angeboten. Die Technologie ist von Ask Jeeves10 lizensiert und nennt sich Ask AltaVista.

Hier kann der Benutzer Fragen in Umgangssprache stellen, die mit 7 Millionen

Grundfragen (Ende 1998) in einer Datenbank verglichen werden. Als Ergebnis erhält man

wie bei Katalogdiensten von Redakteuren geprüfte Ergebnisse. [Sul1999d]

Das Suchergebnis stellt sich meist als eine nach Relevanzgrad sortierte Trefferliste dar,

zum Teil ergänzt um Bereiche des Originaldokuments oder einer automatisch generierten

Zusammenfassung. Relevanz kann sich dabei beispielsweise auf die Häufigkeit des

Vorkommens der gesuchten Wörter, auf die Position der Wörter oder auf das Vorkommen

in bestimmten Attributen wie Titel, Überschriften oder Schlüsselwörtern im Dokument

beziehen. [Kar1999a]

8

Ort des Vorkommens

9

Altavista, http://www.altavista.com

10

Ask Jeeves for Kids, http://www.ajkids.com

KAPITEL 2 - SUCHDIENSTE

11

2.2 Einteilung der Suchdienste

Die nachfolgende Einteilung orientiert sich an der Arbeit von Koch [Koch1996] und

bietet eine beispielhafte Auswahl aktueller Suchdienste:

Generelle Suchdienste für alle Arten von Web-Ressourcen

Singuläre Suchdienste

Indexsuchdienste mit Auffindung durch Spider

Volltextindex bzw. reduzierter Volltextindex

AltaVista

http://www.altavista.com

Hotbot

http://www.hotbot.com

Excite

http://www.excite.com

Fast

http://www.alltheweb.com

InfoSeek

http://www.infoseek.com

Harvest

http://harvest.austria.eu.net/Server-in-AT/

Schlüsselwörter und Metadaten

Magellan

http://www.mckinley.com

WWW Worm

http://www.goto.com

Katalogsuchdienste durch aktives Anmelden und Redaktionsteams

Yahoo

http://www.yahoo.com

Open Directory

http://directory.mozilla.org

Dino-Online

http://www.dino-online.de

Web.de

http://web.de

Henkel

http://www.henkel.at/service/ha_www.htm

Metasuchdienste und kombinierte Suchdienste

Metasuchdienst durch simultane Nutzung mehrerer Suchdienste

MetaCrawler

http://www.metacrawler.com

InfoMarket

http://www.infomarket.com

Inference Find

http://www.infind.com

Zusammenfassung mehrerer Katalogsuchdienste

Metaindex Europa http://www.hj.se/hs/bibl/miewww/

Kombination von Index- und Katalogsuchdiensten

Lycos

http://www.lycos.com

Intelligent Agents

Verity

http://www.verity.com

Indizes für bestimmte Arten von Web-Ressourcen und bzw. oder Protokollen

Files, Software (FTP)

Filez

http://www.filez.com

FTP Search

http://ftpsearch.ntnu.no

FTP Search

http://ftp.sunet.se:8000/ftpsearch

OPAC

Online Public Access Catalog, Informationssuche in Bibliotheken

Gopher Informationssystem mit menüartiger Struktur

WAIS

Wide Area Information Servers, Verteilte Informationssuche

Z39.50

ANSI Standard für offene, verteilte Informationssysteme

KAPITEL 2 - SUCHDIENSTE

12

Die hier getroffene Einteilung soll die unterschiedlichen Möglichkeiten beim Aufbau

eines Suchsystems aufzeigen. Jedes Konzept bietet dem Anwender in Teilbereichen

Vorteile, die mehr oder weniger ausgeprägten Schwachstellen gegenüber stehen (siehe

auch Kapitel 2.3).

Die Unterschiede in der Gruppe der singulären Suchdienste sind in vielerlei Hinsicht

erheblich. Zu den Vorteilen der Katalogsuchdienste (siehe auch Abschnitt 2.1.2.1) zählt

vor allem die Auswahl der Dokumente. Autoren, Lektoren oder Benutzer des Systems

entscheiden, ob und in welchem Maß Informationsobjekte relevant sind, ob sie in den

Katalog aufgenommen und welcher Kategorie sie zugeordnet werden. Der Vorteil von

Indexsuchdiensten hingegen liegt in ihrem vergleichsweise hohen Grad an Aktualität und

Vollständigkeit (siehe auch Abschnitt 2.1.2.2). Innerhalb dieser Gruppe exisitieren

Unterschiede auf dem Gebiet der Indizierung (Volltext, Schlüsselwörter, Metadaten) und

dem thematischen und geographischen Deckungsbereich.

Ein spezielle Art der Suchdienste sind die in der Aufstellung erwähnten Metasuchdienste. Diese nutzen bei einer Suchabfrage verschiedene andere Suchdienste und

generieren von deren Ergebnissen Zusammenfassungen, die dann dem Anwender

präsentiert werden. Da die einzelnen Suchdienste oft verschiedene Teile des World Wide

Web absuchen, läßt sich so die Vollständigkeit der Abfrage verbessern. [LG1999]

2.3 Schwachpunkte gängiger Suchdienste

Heutige Suchmaschinen haben bestimmte Nachteile, auf die in diesem Abschnitt näher

eingegangen wird. Dabei wird vor allem die Vollständigkeit und Linkkonsistenz und

anschließend die bei der Indizierung auftretende Server- und Netzbelastung untersucht.

2.3.1 Vollständigkeit, Aktualität und Linkkonsistenz

Für den Benutzer des Wissensspeichers Internet ist es wichtig, daß der Suchdienst die

Dokumente vollständig und aktuell – zumindest in einem geographischen oder

thematischen Teilbereich – zur Verfügung stellt.

Suchdienste streben zumindest teilweise Vollständigkeit an. Da aber selbst die größten

Suchdienste mit einem enormen technischen Aufwand nicht ständig alle neuen Dokumente

erfassen können und die Einstiegspunkte für die weitere Linkverfolgung eine zusätzliche

Rolle spielen, läßt sich folgern, daß Vollständigkeit an zentraler Stelle niemals erreicht

werden kann. Die selben Überlegungen betreffen die Aktualität von bereits indizierten

Dokumenten, deren Inhalte sich verändert haben. Das World Wide Web ändert sich viel zu

schnell, als daß neue Informationen unmittelbar berücksichtigt werden könnten. Frühere

Suchdienste arbeiteten oft mit einem festen Turnus von mehreren Tagen bis Wochen – so

bestand kaum eine Chance, einen eben erschienenen Artikel zu finden. Infoseek und

AltaVista versuchen das Problem zu entschärfen, indem sie ohne feste Intervalle ihre

Spider zur Informationsauffindung starten. Statt dessen werden Seiten, die in der

Vergangenheit bereits häufiger aktualisiert wurden, in kürzeren Intervallen untersucht, also

die Geschwindigkeit der Informationsaktualisierung dynamisch angepaßt. [GAM1998]

[Kar1999b]

KAPITEL 2 - SUCHDIENSTE

13

Ein weiteres Problem sind nicht mehr existierende Dokumente, wobei dann die

Verweise der Suchergebnisse oftmals keine gültige Referenz mehr angeben und die

Linkkonsistenz nicht mehr garantiert ist. Die Anzahl der ungültigen Verweise ist vom

Suchdienst abhängig, und beträgt zwischen 3 und 14%. [LG1999]

Eine vollständige und möglichst aktuelle Erfassung von Dokumenten wird immer auf

einen Teilbereich des Informationsraumes im Internet beschränkt bleiben. Als Ansatz zur

Lösung dieses Problems bietet sich an, die Informationserfassung kleinerer Bereiche, etwa

auf einzelne Webserver zu beschränken. Der Server selbst könnte bereits beim Einfügen

von Dokumenten Änderungen erkennen, so wie es der Hyperwave Information Server11

ermöglicht (siehe auch Kapitel 3.4.2), und die Indizes seiner Suchdatenbanken anpassen.

Eine andere Möglichkeit bieten lokale Gatherer, Programme die am Server lokal ständig

im Hintergrund laufen und periodisch die Dokumente durchforsten. Wie aktuell und

vollständig die gesammelten Informationen sind, hängt davon ab, wie oft der Datenbestand

abgesucht wird. Diese Informationen können über geeignete Schnittstellen für übergeordnete Suchdienste bereit gehalten werden. Dieser Ansatz führt zur Entwicklung hierarchischer Topologien, an deren unterster Ebene lokale Suchdienste stehen [GAM1998].

Darüber liegende Suchmaschinen fassen die Informationen mehrerer Server entweder

geographisch oder thematisch zu größeren Suchinformationen zusammen [DGK+1998].

Dieses Grundprinzip der verteilten Datenauffindung und Aufbereitung sowie Bereitstellen

der Informationen für andere Suchdienste findet man beim Harvest-System (siehe auch

Kapitel 3.4.1) und ist auch in der vorliegenden Diplomarbeit realisiert.

Katalogsuchdienste sind nicht in der Lage, Vollständigkeit zu bieten, da die Suchinformationen von aktiver Anmeldung der Dokumente von den jeweiligen Autoren bzw. den

Recherchen von Redaktionsteams abhängen [GAM1998]. Auch ergeben sich die gleichen

Probleme wie etwa Linkinkonsistenzen oder falsche Inhalte, wenn Dokumente geändert

oder entfernt werden.

2.3.2 Netz- und Serverbelastung

Das Hauptproblem heutiger Suchdienste ist das vielfache Durchforsten des World Wide

Web von vielen Suchrobotern – auch Spider genannt – in unkoordinierter Weise. Spider

sind Programme, die entlang von WWW-Hypertext-Strukturen Dokumente automatisch

über das Web laden, verarbeiten und Referenzen auf andere Dokumente weiterverfolgen.

Sie sammeln periodisch Informationen, die dann von den Suchdiensten bereitgestellt

werden. Jeder dieser Spider holt über das Web immer wieder die Dokumente bestimmter

Server. Dabei müssen auch schon einmal geprüfte Dokumente bzw., falls der Webserver

dies unterstützt, der HTTP-Header geholt werden, um überhaupt feststellen zu können, ob

diese geändert wurden. [WRD1998a]

Eine genaue Auslastung der Netzkapazität und der Webserver durch Spider ist nicht

bekannt, doch aus verschiedenen Untersuchungen kann man zumindest auf die

Netzbelastung durch die größeren Suchdienste schließen. Tabelle 2.1 zeigt eine Auswahl

aktueller Suchdienste. Die Größe der Suchdienste, also Anzahl der indizierten Seiten,

wurde aus [Sul1999a] (Stand 1. Juli 1999), die Updaterate und die Anzahl der abgesuchten

Seiten pro Tag sind aus [Car1999] (Stand 13. Jänner 1999) entnommen.

11

Hyperwave, http://www.hyperwave.com

14

KAPITEL 2 - SUCHDIENSTE

Search

Engine

Größe in

Millionen

Seiten

Fast

Northern

Light

Alta

Vista

HotBot/

Inktomi

Infoseek

Excite

Lycos

200

160

150

110

75

55

50

Abgesuchte

Seiten pro

Tag

unbekannt

Updaterate12

unbekannt

3 Millionen 10 Millionen 10 Millionen unbekannt

2 bis 4

Wochen

1 Tag bis

1 Monat

1 Tag bis

2 Wochen

1 Tag bis

2 Monate

3 Millionen 6 Millionen

1 bis 3

Wochen

2 bis 3

Wochen

Tabelle 2.1: Vergleich aktueller Suchdienste

Eine Liste aktiver Spider, auch Web Robots genannt, ist bei Martijn Koster zu finden

und zählt zur Zeit der Erstellung dieser Diplomarbeit über 200 Einträge [WRD1998b].

Was ein Spider genau durchsucht, läßt sich beeinflussen. Der "Robots Exclusion Standard"

beschreibt, wie mittels der Datei "robots.txt" im Root-Verzeichnis eines Webservers

Robots der Zutritt zu bestimmten Verzeichnissen im Web-Angebot verwehrt wird, wobei

diese allerdings nicht von allen Such-Robots berücksichtigt wird. Für weitere Informationen über die Funktionsweise sei auf die Robots-Pages von WebCrawler. [WRD1998a]

Ein Weg, um der hohen Netz- und Serverbelastung entgegen zu steuern, ist der in dieser

Diplomarbeit vorgestellte lokale Suchdienst, der in Verbindung mit hierarchisch

zusammenarbeitenden Suchdiensten Dokumenteninformationen eines Servers in effizienter

Weise weitergeben kann. Außerdem können mehrere Suchdienste von den so aufbereiteten

Daten Gebrauch machen, ohne daß der Server zusätzlich belastet wird. Auf die Vorteile

von hierarchischen Suchverfahren wird im Kapitel 3 genauer eingegangen.

2.3.3 Qualität und Zuverlässigkeit

Für den Benutzer eines Suchdienstes wäre es wichtig, Kenntnisse über die Qualität und

Zuverlässigkeit der einzelnen Informationen zu erhalten. Recherchiert etwa ein

Kulturreiseveranstalter nach den Öffnungszeiten und Führungsmöglichkeiten des Grazer

Zeughauses, so muß sich dieser auf die Information verlassen können. Derzeit bieten nur

Suchkataloge mit recherchierten Einträgen rudimentäre Ansätze für Bewertungen, da man

davon ausgehen kann, daß die aufgenommenen Webseiten zumindest einmal von den

Redakteuren überprüft worden sind. [Dys1997]

Die Angaben über Qualität und Zuverlässigkeit werden mit der raschen Zunahme an

Dokumenten im Internet immer wichtiger. Die Bewertung von Web-Information wird

menschlichen Bearbeitern eines Suchdienstes unter Mitwirkung der Web-Site-Betreiber

12

Die Updaterate ist meist von der "Wichtigkeit" der Seiten abhängig, also wie oft

andere Dokumente darauf verweisen, oder wird aus der durchschnittlichen

Änderungsrate der Dokumente abgeleitet.

KAPITEL 2 - SUCHDIENSTE

15

vorbehalten sein13. Neben der kostenlosen Bereitstellung von Suchergebnissen könnte sich

die Bewertung von Informationen zu einem kommerziellen Geschäftsfeld in Form einer

zusätzlichen Dienstleistung entwickeln. Durch die Entwicklung eines Maßstabes für

Qualität und Zuverlässigkeit und der Zuordnung einer Kennziffer zu jedem abgesuchten

Dokument (wie z.B. PICS14) könnte dem Benutzer eine Information bereitgestellt werden,

die darüber Auskunft gibt, wie sehr man sich auf die Information verlassen kann.

[Dys1997]

Eine andere Problematik, die zu unbefriedigenden Suchergebnissen führen kann, ist der

meist triviale Mechanismus, mit dem Suchmaschinen die Stichwörter festlegen. Dabei

werden in der Regel alle Wörter zu Stichwörtern, auch wenn sie in einem irrelevanten

Zusammenhang auftauchen; lediglich "Allerweltswörter”, zum Beispiel Artikel und

Pronomen, werden ausgefiltert. Nur wenige Suchmaschinen besitzen in dieser Beziehung

eine gewisse Intelligenz. Excite15 oder Verity16 berücksichtigt immerhin auch synonyme

Wörter. So werden beim Suchbegriff "Senioren” auch Seiten gefunden, die den Text

"ältere Menschen” enthalten. Eingesetzt wird bei Excite die patentierte Technologie

Intelligent Concept Extraction17, die die zugrundeliegenden Synonymtabellen selbsttätig

generiert. [ICE1996]

Ein weiterer Schwachpunkt läßt sich bei der Verwendung automatischer Indizierung

mittels Spider aufzeigen. Durch Wiederholen bestimmter oft im World Wide Web

gesuchter Schlüsselwörter im Dokument scheinen diese Dokumente fälschlicherweise im

Suchergebnis auf, obwohl der eigentliche Inhalt womöglich gar nichts mit der wirklichen

Abfrage zu tun hat. Diese Art der Beeinträchtigung wird Keyword-Spamming genannt.

[AtAs1998]

13

Bewertungsdienste, die gleichzeitig auch Programme zum Filtern von Internetinhalten

anbieten, sind z.B.:

Microsystems (Cyper Patrol), http://www.cyberpatrol.com

Net Nanny, http://www.netnanny.com

Net Shepherd, http://www.netshepherd.com

SafeSurf, http://www.safesurf.com

Solid Oak (CYBERsitter), http://www.cybersitter.com

SurfWatch, http://www.surfwatch.com

RSACi (Recreation Software Advisory Council Internet), http://www.rsac.org

14

Platform for Internet Content Selection, PICS, http://www.w3.org/PICS/

15

Excite, http://www.excite.com

16

Verity, http://www.verity.com

17

Intelligent Concept Exctraction, ICE, http://excite.com/ice/tech.html

KAPITEL 2 - SUCHDIENSTE

16

2.3.4 Zusatzinformationen

Zusätzliche Informationen (Metainformationen) über das Dokument, wie z.B. Autor,

Erstelldatum, Empfangskreis (Benutzerkreis, Ausbildungsniveau, etc.) und Zusammenfassung sind für den Benutzer ebenfalls hilfreich. Die Kenntnisse über Verwendung

bestimmter Multimedia-Anwendungen (z.B. Real Audio) als zusätzliches Suchkriterium

oder Script-Sprachen (ActiveX) als Sicherheitskriterium werden immer größere Bedeutung

erlangen. Derzeit gibt es noch keine normierten Richtlinien für Metainformationen in

Dokumenten, aber im Laufe der Zeit haben sich einige oft verwendete Methoden

entwickelt. Leider nehmen viele aktuelle Suchdienste wie Excite, Lycos oder Northern

Light keine Notiz von diesen Informationen. [Sul1999b]

Es sind Bestrebungen im Gange, einen Standard zu schaffen, wie man diese zusätzlichen

Informationen in den Web-Seiten integrieren kann. Mehrere Arbeitsgruppen des World

Wide Web Consortium18 sind zu Zeit der Erstellung der Arbeit dabei, unter Einbeziehung

existierender Vorschläge wie PICS19, LOM20 und Dublin Core21 einen allgemeingültigen

Standard für diese Metadaten zu erarbeiten, das sogenannte Resource Description

Framework22. Zur Zeit der Erstellung dieser Diplomarbeit liegt RDF als Recommendation

vor. Eine genauere Beschreibung der hier erwähnten Standards findet sich im Kapitel 4 –

Formate und Metadaten.

Der Grundgedanke von PICS liegt in der Selektion von Informationen, die bestimmten

ausgewählten Kriterien entsprechen (z.B. Gewaltfreiheit), um damit nur bestimmte WebDokumente zugänglich zu machen. Die Information für das Rating sind in Metainformationen der HTML-Dokumente enthalten oder verweisen auf sogenannte Rating-Server, wo

die Kategorisierung der jeweiligen Seiten getroffen wird. Es wäre denkbar, bestehende

Rating-Informationen ebenfalls in den Daten-Index von Suchdiensten aufzunehmen und so

dem Benutzer mehr Informationen zur Verfügung stellen zu können. Heutige Suchdienste

verwenden allerdings nur die Meta-Angaben für Description und Keywords. Eine

Ausnahme ist der Suchdienst Fireball23, der auch Angaben wie Author, Publisher oder

Page-Type berücksichtigt. [Sul1999b] [Kar1999b]

Eine interessante Entwicklung, die man im Rahmen der Meta-Tags ausnützen kann,

stellt der Hyperwave Information Server24 zur Verfügung. Jedes Objekt in einem

Hyperwave Server hat eine Reihe von Attributen (z.B. Schlüsselwörter oder Autor), die in

der lokalen Suchmaschine indiziert und damit rasch suchbar sind. Diese Attribute können

dem jeweiligen Dokument in Form von Meta-Tags automatisch hinzugefügt werden, die

18

World Wide Web Consortium, W3C, http://www.w3.org

19

Platform for Internet Content Selection, PICS, http://www.w3.org/PICS/

20

Learning Object Metadata, LOM, siehe IEEE Learning Technology Standards

Committee, http://ltsc.ieee.org/wg12/index.html

21

Dublin Core Metadata Initiative, http://purl.org/dc/

22

Resource Description Framework, RDF, http://www.w3.org/RDF/

23

Fireball, http://www.fireball.de

24

Hyperwave, http://www.hyperwave.com

KAPITEL 2 - SUCHDIENSTE

17

damit für Spider externer Suchdienste die notwendigen Zusatzinformationen bereitstellen

(siehe auch Kapitel 3.4.2 – Hyperwave).

Ein weitere Möglichkeit, zusätzliche Informationen zu nutzen, bieten sogenannte

Recommender Systems. Die Grundidee dabei ist, bei anderen Menschen mit entsprechend

ähnlichen Interessensgebieten, wie dem Anwender, Empfehlungen einzuholen. Diese

Systeme bilden die programmtechnische Umgebung, die es ermöglicht, Dokumente mit

bestimmtem Inhalt bzw. Qualität für Benutzer mit bestimmten Interessen und Ansprüchen

zugänglich zu machen. Dabei lassen sich zwei Kategorien unterscheiden. Die Content

based Recommender Systems vergleichen dabei die tatsächlichen Inhalte oder Kurzfassungen von Dokumenten mit dem Benutzerprofil, beispielsweise einer Sammlung gewichteter

Wörter, und versuchen für den Benutzer interessante Dokumente zu finden. Die

Collaborative based Recommender Systems versuchen, Benutzer mit ähnlichen Interessen

zu finden und schlagen dann Dokumente vor, die von diesen als interessant klassifiziert

wurden. Unter anderem sind dies PHOAKS25, Referral Web26, GroupLens27, Siteseer28,

Fab29, Alexa30 und das auf Hyperwave31 aufbauende Personalised Recommender System.

Das Personalised Recommender System ist ein Collaborative System, daß es Benutzern

ermöglicht, Dokumente zu kategorisieren und zu bewerten32. Die Bewertungen werden auf

einem Hyperwave Server verwaltet, was den Vorteil mit sich bringt, die bereits

vorhandenen Such- und Sortierfunktionen von Hyperwave benutzen zu können. Um

Empfehlungen betrachten zu können, stehen einerseits das Server Interface und

andererseits ein eigenes Recommendation-Modul zur Verfügung. Das System erlaubt auch,

die Empfehlungen bestimmter anderer Benutzer besonders zu gewichten. [Hor1999]

[Leg1999]

2.3.5 Relevanz der Informationen

Relevanz kann als Grad der Übereinstimmung von nachgefragten und angebotenen

Informationen definiert werden, also wie gut das Suchergebnis mit der Abfrage

übereinstimmt. Suchdienste berechnen den Relevanzgrad mittels statistischer Verfahren

unter Nutzung der Worthäufigkeit und der Wortabstände. [Bek1996]

Die einzelnen Wörter in den jeweiligen Dokumenten sind in ihrer Wichtigkeit bzw.

Relevanz unterschiedlich. Ein automatisiertes Verfahren könnte die Wichtigkeit der

Begriffe ermitteln und für eine Zusammenfassung bzw. Schlüsselwortgenerierung sowie

für eine Sortierreihenfolge bei Suchergebnissen verwenden. Ein Ansatzpunkt ist durch die

25

PHOAKS, http://www.phoaks.com

26

Referral Web, http://www.research.att.com/~kautz/referralweb/index.html

27

GroupLens, http://www.cs.umn.edu/Research/GroupLens

28

Siteseer, http://www.imana.com/WebObjects/Siteseer

29

Fab, http://www-diglib.stanford.edu/diglib/pub/projects.shtml

30

Alexa, http://www.alexa.com

31

Hyperwave, http://www.hyperwave.com

32

Jeder Benutzer ist Mitglied einer oder mehrerer Gruppen, wobei jede Gruppe eine

Menge von Kategorien enthält, die von einem Administrator verwaltet werden; jedes

Dokument ist einer Kategorie zugeordnet.

KAPITEL 2 - SUCHDIENSTE

18

Bewertung der örtlichen Stelle des Wortes innerhalb des Dokuments gegeben [Bag1996].

Naheliegend dabei ist, daß beispielsweise Wörter in der Überschrift oder fett geschriebene

eine größere Bedeutung haben werden als im normalen Fließtext (siehe auch Abschnitt

4.1.1 – HTML). Die daraus gewonnene Maßzahl könnte als zusätzliche Information in den

Suchindex eingehen. Dieser Ansatz wurde auch in der vorliegenden Diplomarbeit gewählt,

wobei die Wörter je nach Ort des Vorkommens bewertet werden können. Dem Benutzer

wird durch automatisch erstellte Zusammenfassung bzw. die Bildung von relevanten

Schlüsselwörtern ermöglicht, aus einer großen Anzahl von Suchergebnissen eine geeignete

Auswahl zu entnehmen.

Ein weiterer Forschungsansatz ist die Zusammenfassung von Dokumenten mit ähnlichen

Indizierungsprofilen zu Dokumentenclustern. Unter der Annahme, daß Dokumente mit

ähnlichen bzw. einer großen Anzahl an gleichen Wörtern auch ähnliche Inhalte haben

werden, lassen sich entsprechende Algorithmen entwickeln. Andere Ansätze befassen sich

mit der Gruppierung von Dokumenten anhand Titeln und Beschreibungen. [ZE1998]

2.4 Zusammenfassung

Aufgrund der unüberschaubaren Anzahl an Dokumenten im World Wide Web und deren

kontinuierlicher Veränderung ist es ohne die Hilfe von Suchdiensten, also die Bereitstellung von Verweisen zu gewünschten Themen, praktisch nicht mehr möglich, relevante

Informationen zu erhalten. Die Basis dieser Suchdienste sind verschiedene Methoden der

Lokalisierung von Dokumenten und der Aufbereitung deren Inhalts. Durch aktives

Anmelden können Autoren ihre Dokumente in einen Suchdienst aufnehmen lassen. Bei der

redaktionellen Recherche verfolgen Lektoren die Hypertext-Strukturen und nehmen

passende Dokumente in ihren Suchdienst auf. Robots bzw. Spider navigieren mit Hilfe von

Hyperlinks, Menüs und Verzeichnisstrukturen im Informationsraum und verarbeiten die

aufgefundenen Dokumente automatisch.

Die Bereitstellung der Information wird durch thematische Kataloge, durch einen

Suchindex oder durch Mischformen aus beiden realisiert. Während sich der Benutzer bei

Verwendung eines Kataloges schrittweise der gewünschten Dokumentenmenge "nähert",

muß er beim Suchindex durch Angaben von Suchwörtern seine Suche formulieren. Die

Suchanfrage kann dabei mit Hilfe von booleschen Operatoren oder Wildcards modifiziert

werden. Einige Suchdienste bieten auch Unterstützung für die Suche nach Phrasen oder

beziehen die Nähe von Suchwörtern untereinander in die Auswertung mit ein (siehe

Abschnitt 2.1.2).

Gängige Suchdienste arbeiten meist unabhängig von einander und laden Daten vom

Informationsserver über das Netz, um den Inhalt zu verarbeiten und bereitzustellen. Diese

unkoordinierte, zentrale Vorgangsweise führt zu enormer Netz- und Serverlast. Weitere

Probleme liegen zum Beispiel auf dem Gebiet der Aktualität und der Qualität der

angebotenen Information. (siehe Abschnitt 2.3).

Viele der in diesem Kapitel aufgezählten Nachteile lassen sich durch die im folgenden

Kapitel vorgestellte verteilte bzw. lokale Informationssammlung, -aufbereitung und -auffindung verhindern.

Kapitel 3

Lokale und verteilte Aufbereitung

Heutige Methoden und Technologien zur Informationsauffindung im World Wide Web

kommen mit der exponentiell anwachsenden Informationsmenge von Dokumenten und

Newsgroup-Beiträgen nur mehr in Teilbereichen zurecht. Die unter anderem im letzten

Kapitel aufgezeigten Schwachstellen (siehe Abschnitt 2.3) lassen es notwendig erscheinen,

neue Forschungsansätze und innovative Verbesserungen gegenwärtiger Suchdienste zur

Wissenserfassung zu untersuchen. In diesem Kapitel wird auf die Konzepte verteilter

Datenaufbereitung und hierarchischer Suchdienste näher eingegangen und nach einer

Bewertung der Vor- und Nachteile ein Überblick über heute existierende Systeme gegeben.

3.1 Grundlagen

Im Gegensatz zu herkömmlichen Methoden (siehe auch 2.1.1), also dem Sammeln und

Aufbereiten von Informationen über Dokumente im World Wide Web von zentralen

Stellen aus (siehe Abbildung 3.1a), verfolgt die verteilte Auffindung einen anderen Ansatz.

Suchdienst

Suchdienst

Gatherer

Gatherer

InformationsServer

InformationsServer

InformationsServer

Teil a: Topologie mit unabhängigen

zentralen Gatherern

Suchdienst

Suchdienst

Gatherer

Server

Suchdienst

Gatherer

Server

Gatherer

Server

Teil b: Hierarchische Topologie mit

lokalen Gatherern

Abbildung 3.1: Herkömmliche und hierarchische Topologie von Suchdiensten

KAPITEL 3 - LOKALE UND VERTEILTE AUFBEREITUNG

20

Bei verteilten Systemen (siehe Abbildung 3.1b) sind mehrere voneinander unabhängige

Module1 für das Auffinden und die Aufbereitung der Daten zuständig. Ein oder mehrere

übergeordnete Systeme, die Suchdienste, bedienen sich der Daten und stellen sie über ein

Suchinterface zur Verfügung. [BDH+1995] [HSW1996] [GAM1998]

3.2 Vorteile der verteilten

Informationsaufbereitung

Durch die mögliche hierarchische Anordnung von Suchdiensten und die Nähe der

Gatherer – also der Programme die die Informationen sammeln – zu den aufzubereitenden

Daten ergeben sich einige Vorteile, die in diesem Abschnitt diskutiert werden.

3.2.1 Vollständigkeit und Aktualität

Die Vollständigkeit beschränkt sich beim System der verteilten Aufbereitung auf

Teilbereiche, die durch die lokalen Gatherer abgedeckt werden. Aufgrund des Wissens

über den Serverinhalt kann der Administrator lokale Gatherer individuell an die Dynamik

des Dokumentenangebotes anpassen. So können Informationsserver mit oftmaligen

Änderungen der Dokumente wesentlich häufiger durchforstet werden, was zu einem guten

Maß an Aktualität innerhalb des abgesuchten Bereiches führt. Bei geändernden

Dokumenten stimmen sonst die Suchergebnisse nicht mehr mit den tatsächlich

vorhandenen Seiten überein. [Bek1996]

Durch Weitergabe der gesammelten Informationen an übergeordnete Suchprogramme

verbessert sich die Vollständigkeit auf die Summe der durchforsteten Teilbereiche. Wenn

auch die unterschiedlichen Sammelraten an übergeordnete Suchprogramme weitergegeben

werden und diese dementsprechend ihre eigenen Datenbestände erneuern, bleibt die

Aktualität der Teilbereiche möglichst gut erhalten. Bei dem im Rahmen dieser Diplomarbeit entwickelten Suchprogramm kann die Informationssammelrate und die Zeit, die

Dokumente nach dem letzten erfolgreichen Zugriff in der Suchdatenbank verbleiben,

individuell eingestellt werden.

3.2.2 Netz- und Serverbelastung

Wie in Abschnitt 2.3.2 erläutert, durchforsten herkömmliche Suchdienste bzw. deren

Spider unabhängig voneinander das World Wide Web und fordern Dokumente so

mehrfach über das Netz an. Auch um Dokumente auf Änderungen zu überprüfen muß

zumindest ein HTTP-Header ebenfalls zu jedem Suchdienst übertragen werden. Durch das

System der verteilten Sammlung und Aufbereitung ergeben sich mehrere Möglichkeiten,

die Belastung von Internet und Webservern zu verringern. Lokale Gatherer können sich die

zu untersuchenden Dokumente über das Dateisystem holen und vermeiden so, Dokumente

mittels HTTP-Protokoll zu übertragen und den Webserver zusätzlich zu belasten.

1

hier engl. Gatherer genannt

KAPITEL 3 - LOKALE UND VERTEILTE AUFBEREITUNG

21

Eine weitere Optimierung ergibt sich durch die gesammelte Übertragung der Dokumenteninformationen an übergeordnete Suchprogramme anstatt der üblichen Einzelübertragungen. Durch zusätzliche Komprimierung kann die Datenmenge auf unter dreißig Prozent

reduziert werden. Eine weitere Reduktion erreicht man, wenn statt der Volltextinformation

Inhaltszusammenfassungen (Abstracts) erzeugt und übertragen werden. Der größte Vorteil

ist, daß das lokale Suchprogramm nur Daten über diejenigen Dokumente weitergeben muß,

die sich seit der letzten Übertragung geändert haben. Durch diese inkrementelle

Informationsweitergabe wird die Netzbelastung wesentlich verringert. [BDH+1995]

[HSW1996]

Alle erwähnten Vorteile sind in der vorliegenden Arbeit implementiert. Die Sammlung

der Informationen erfolgt über das Dateisystem, wobei automatisch Inhaltszusammenfassungen generiert werden können. Die Schnittstelle zu übergeordneten Suchsystemen

unterstützt inkrementelle Datenübertragung und die Daten können auf Anfrage zusätzlich

komprimiert werden (siehe auch Kapitel 8).

3.2.3 Gliederung des Informationsraumes

Aufgrund der Kenntnis des Administrators über die unterschiedlichen Themen, die in

verschiedenen Verzeichnissen eines Informationsservers behandelt werden, kann dieser

Gatherer für unterschiedliche Wissensgebiete einrichten. Bei der Informationssammlung

durch übergeordnete Module, die also Dokumenteninformationen von lokalen Gatherern

übernehmen, können dann entweder themenspezifisch oder nach den geographischen

Gegebenheiten Daten übernommen werden. Eine Voraussetzung dafür ist allerdings das

Wissen um den Inhalt der durchforsteten Daten eines lokalen Gatherers (siehe auch Kapitel

3.3 –Nachteile der verteilten Informationsaufbereitung).