Hand-Out

Werbung

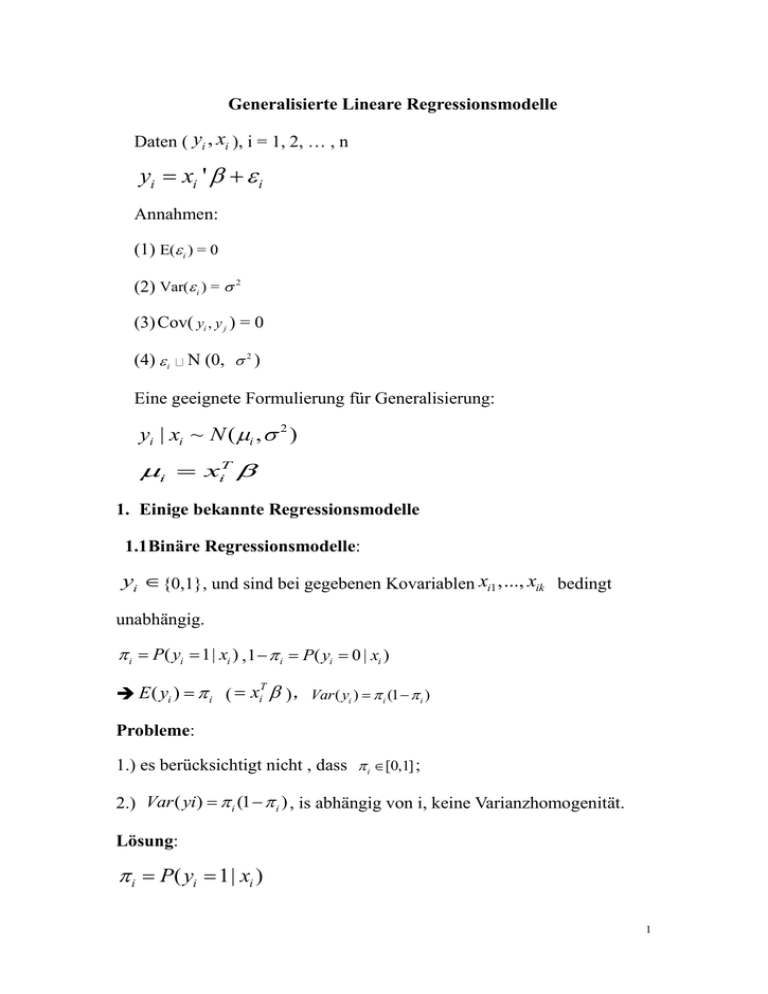

Generalisierte Lineare Regressionsmodelle

Daten ( yi , xi ), i = 1, 2, … , n

yi xi ' i

Annahmen:

(1) E( i ) = 0

(2) Var( i ) = 2

(3) Cov( yi , y j ) = 0

(4) i N (0, 2 )

Eine geeignete Formulierung für Generalisierung:

yi | xi ~ N ( i , 2 )

i xiT

1. Einige bekannte Regressionsmodelle

1.1Binäre Regressionsmodelle:

yi {0,1}, und sind bei gegebenen Kovariablen xi1 ,..., xik bedingt

unabhängig.

i P( yi 1| xi ) , 1 i P( yi 0 | xi )

T

E ( yi ) i ( xi ), Var ( yi ) i (1 i )

Probleme:

1.) es berücksichtigt nicht , dass i [0,1] ;

2.) Var ( yi) i (1 i ) , is abhängig von i, keine Varianzhomogenität.

Lösung:

i P( yi 1| xi )

1

i 0 1 xi1 ...k xik xi ' <= der lineare Prädiktor

i h(i ) <= Responsefunktion, h( ) [0,1]

i g ( i )

1

<= Linkfunktion, g h

1.1.1) Logit-Modell:

h( )

exp( )

1 exp( )

P( yi 1| xi )

exp( 0 ) exp( 1 xi1 ) ... exp( k xik )

P( yi 0 | xi )

i

P ( yi 1| xi )

<= die Chance (odds)

1 i P ( yi 0 | xi )

1.1.2) Probit-Modell:

h( ) ( ) F ( xi ' )

<= Verteilungsfunktion von N(0,1)

g ( ) 1 ( )

1.1.3) Log-log-Modell:

h( ) 1 exp( exp( ))

g ( ) log( log(1 ))

1.1.4) Gruppierte Daten:

( yi , xi ) ( yij , xij ) , i = 1,...,G; j = 1,...ni ; ni n

z.B. yi

B(1, ) , yij

B (1, i )

1 ni

Betrachte: yi yij

n j 1

=> ni yi

B(ni , i )

E(ni yi ) ni i

2

Var (ni yi ) ni i (1 i )

Es gilt dann:

E( yi ) i

i (1 i )

Var ( yi )

ni

Problem:

Überdispersion, die empirische Varianz oft größer als die geschätzte

Varianz

i (1 i )

ni

ist. (Lösung in 3.Quasi-likelihood-Modelle)

1.2 Regression für Zähldaten:

i E ( yi | xi ,)<= die Rate von Zähldaten

1.2.1 Log-lineares Poisson-Modell:

i xi ' 0 1 xi1 ... k xik ,

i exp(i ) exp(0 1 xi1 ... k xik )

=> log(i ) i xi ' 0 1 xi1 ... k xik

1.2.2 lineares Poisson-Modell:

i i xi '

2.Generalisierte Lineare RegressionsModelle:

2.1 Allgemeine Modelldefinition:

Grundkonzept: yi | xi , i = 1, 2, …, n, unabhängig

(1) Zufallskomponente:

yi | xi folgt einfacher Exponentialfamilie

3

f ( y | ) exp(

y b( )

w c( y, , w)) <= Dichtefunktion

: natürlicher/kanonischer Parameter

b( ) : zweimal stetig differenzierbare Funktion

: Dispersionsparameter,unabhängig von i

w : Gewicht

c(.) : eine Funktion,unabhängig von

Es gilt:

E ( y ) b '( ) & Var ( y ) b ''( ) / w

Beispiele:

1.) Bernoulliverteilung: y∈﹛0,1﹜

E (Y ) P(Y 1) ; Var (Y ) (1 )

f ( y | ) P(Y y ) y (1 )1 y

b '( )

b ''( )

exp( )

E ( y)

1 exp( )

exp( )

(1 ) Var ( y )

(1 exp( )) 2

2.) Poissonverteilung: y = 0, 1, 2, …

f ( y | ) P(Y y)

y exp( )

y!

b '( ) b ''( )

Also: E ( y ) Var ( y )

3.) Normalverteilung: y R

4

f ( y | ) (2 )

( y )2

exp(

)

2 2

2 1 / 2

b'

(

) E (y )

b ''( ) 1 => Var ( y ) b ''( ) 2

(2) Systematische Komponente:

i h( yi ) h( xiT )

T

g: g ( i ) xi

2.2 Likelihood-Inferenz

Beobachtung ( yi , xi )

E ( yi | xi ) i , Var ( yi | xi ) i2

i h(i ) h( xi ' ) , i g ( i )

li ( ) log( f ( yi | ))

yii b(i )

wi

=> l ( ) li ( )

Die Score-Funktion :

s( )

l ( ) ( i ) h(i ) i

l ( )

i i

s ( ) xi

dh(i ) yi i

di

i2 ;

Der ML-Schätzer :

s( ) 0

s( ) xi

dh(i ) yi i

0

di

i2

Die Fisher-Matrix:

5

2l ( )

2l ( )

Fobs ( )

(

)ij

'

i j

F ( ) E ( Fobs ( )) cov( s( )) , wenn E ( s ( )) 0 .

In Matrix-Darstellung:

s( ) X ' D 1 ( y )

F ( ) X 'WX

y ( y1 ,..., yn ) '

wobei

( 1 ,..., n ) '

X ( x1' ,..., xn' ) ' , rg(X) = p

D diag (

dh(i )

)

di

diag ( i2 ) ,

W diag ((

dh(i ) 2

) / i2 )

d

2.3 Asymptotische Eigenschaften des ML-Schätzers

n : der ML-Schätzer zum Stichprobenumfang n

=> F

1/ 2

d

( )( n )

N (0, I )

n

N ( , F 1 ( ))

a

bzw. :

2.4 Schätzung vom Dispersionsparameter

(bei gruppierten Daten)

G

( yi i ) 2

1

G p i 1 v ( i ) / ni ,

p = Anzahl der Regressionsparameter

6

i

: geschätzte Erwartungswert

v( i ) : geschätzte Varianzfunktion

3. Quasi Likelihood Modelle

Problem:

die empirische Varianz der Daten ≠ die geschätzten Varianz

Lösung: Quasi-likelihood-Modelle

Annahmen:

i h( xi ' )

i2 Var ( yi ) V ( i )

die generalisierte Schätzfunktion:

s ( ) xi

dh(i ) yi i

di

i2

Es gilt:

E ( s ( )) xi

dh(i ) E ( yi | xi ) i

0

di

i2

2 ( ) Var ( y ) V ( ) <= Quasi-Varianzfunktion/Arbeitsvarianz

2

z.B. in Binomial-Modellen: i ( i )

i (1 i )

ni

2

in Poisson-Modellen: i (i ) i

2

falls: ( ) v( ; )

Ein wichtiger Fall : v( ; )

Q

<=

Quasi-ML-Schaetzer,

(

Lösung

von

generalisierten

Schätzgleichung (GEE))

7

sQ ( ) 0

n

FQ ( ) xi xi ' wi <= quasi-Fisher-Information

i 1

wi (

dh(i ) 2 2

) /i

d

i2 : die Arbeitsvarianzen

oi2

V ( ) xi xi ' wi 2

i

i 1

n

oi2 : die wahre Varianzen

wenn i = oi => F ( ) V ( )

2

2

4. Bayesianische generalisierter lineare Modelle

ggb.:

y ( y1 ,..., yn ) ' , ist bedingt unabhängig mit Kovariablen

x ( x1 ,..., xn ) .

p( | y )

L( | y ) p ( )

L( | y ) p ( ) d

L( | y ) p ( )

n

L( | y ) f i ( yi | )

i 1

E ( | y ) p ( )d <= Der Posteriori-Erwartungswert

Cov( | y ) ( E ( | y ))( E ( | y )) ' p( | y ) d <= die

Posteriori-Kovarianzmatrix

Problem: die Integrationen, die schwer zu berechnen sind.

4.1 Posteriori-Modus-Schätzer

8

p <= Posteriori-Modus-Schätzer

l p ( | y ) l ( ) log p( ) <= Log-Posteriori-likelihood

l ( ) : die betrachtete log-likelihood

Fall 1:

1

2

N (m, M ) => l p ( | y ) l ( ) ( m) ' M 1 ( m)

M 1 0 von p( )

const => p

Fall 2: m = 0 und M r 2 I ,

1

=>

2r 2

( ' ) ( 02 12 ... k2 )

p

N ( , Fp 1 ( p )) ,

n

4.2 Volle Bayes-Inferenz

Fall 1:

N (m, M ) und M 1 0 von p( )

=> p ( | y )

exp(l ( )

const

1

( m) ' M 1 ( m))

2

*

(t )

-> MCMC-Techniken; q( | ) : Vorschlagsdichte

-> MH-Algorithmus mit IWLS-Vorschlagsdichte

Fall 2: für m = 0 und M r 2 I von p( )

*

const

N ( (t ) , ( X 'W (t ) X ) 1 )

F ( t ) X 'W ( t ) X

L( * ) q ( ( t ) | * )

( | ) min{

} : Akzeptanzwahrscheinlichkeit

L( ( t ) ) q ( * | ( t ) )

*

(t )

9