Skript Computergestützte Datenanalyse

Werbung

Skript Computergestützte Datenanalyse

SS 2014

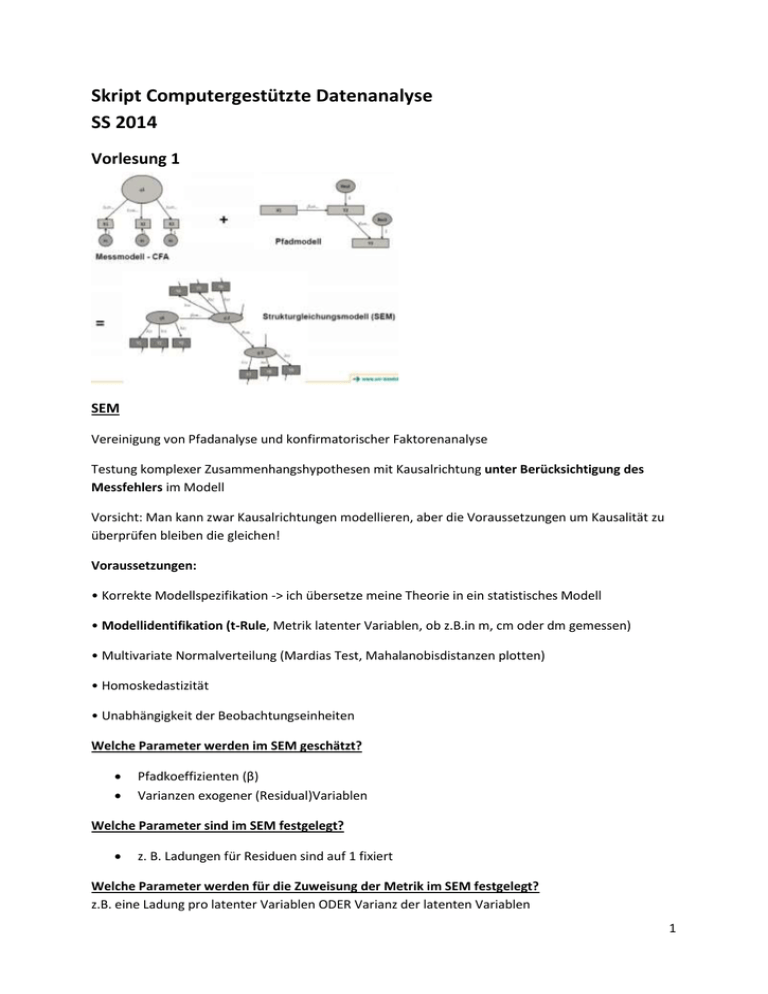

Vorlesung 1

SEM

Vereinigung von Pfadanalyse und konfirmatorischer Faktorenanalyse

Testung komplexer Zusammenhangshypothesen mit Kausalrichtung unter Berücksichtigung des

Messfehlers im Modell

Vorsicht: Man kann zwar Kausalrichtungen modellieren, aber die Voraussetzungen um Kausalität zu

überprüfen bleiben die gleichen!

Voraussetzungen:

• Korrekte Modellspezifikation -> ich übersetze meine Theorie in ein statistisches Modell

• Modellidentifikation (t-Rule, Metrik latenter Variablen, ob z.B.in m, cm oder dm gemessen)

• Multivariate Normalverteilung (Mardias Test, Mahalanobisdistanzen plotten)

• Homoskedastizität

• Unabhängigkeit der Beobachtungseinheiten

Welche Parameter werden im SEM geschätzt?

Pfadkoeffizienten (β)

Varianzen exogener (Residual)Variablen

Welche Parameter sind im SEM festgelegt?

z. B. Ladungen für Residuen sind auf 1 fixiert

Welche Parameter werden für die Zuweisung der Metrik im SEM festgelegt?

z.B. eine Ladung pro latenter Variablen ODER Varianz der latenten Variablen

1

t-rule anwenden können

Modellidentifikation: t-Rule

1. ☺ Anzahl Informationen* > Anzahl zu schätzender Parameter

Modell ist überidentifiziert. (Modellfit interpretierbar)

2. Anzahl Informationen* < Anzahl zu schätzender Parameter

Modell ist unteridentifiziert. (Modell kann nicht geschätzt werden)

Man kann zu Modellrestriktionen greifen, z.B. könnte man Ladungen gleichsetzen

oder fixieren. Dies sollte jedoch inhaltlich begründbar sein.

3. Anzahl Informationen* = Anzahl zu schätzender Parameter

Modell ist exakt identifiziert (saturiertes Modell), Modell passt immer perfekt auf die

Daten.

Dies ist aber eine rein mathematische Eigenschaft, ohne inhaltliche Bedeutung. Folge: Der

Modellfit kann nicht beurteilt werden. Hat man guten Grund anzunehmen, dass die

Modellspezifikation gültig ist, können dennoch einzelne Koeffizienten interpretiert werden.

*Anzahl an Informationen = Anzahl einzigartiger Varianzen und Kovarianzen. Kann berechnet werden

durch p*(p+1)/2, wobei p = Anzahl manifester Variablen

wenn df (Freiheitsgrade) positiv, dann ist die T-Regel erfüllt

wenn df= 0-> saturiertes Modell

CFA

- Reflexives Messmodell

- Statt β schreiben wir λ

- Die stand. λ sind die Faktorladungen

- Die R²te zu X1, X2, Xk … sind die Kommunalitäten

- Die Varianz der Residuen beschreibt den Messfehleranteil beim zugehörigen Indikator

Identifikation:

- Nicht jedes Messmodell ist identifiziert. Für die CFA gilt genauso wie für das Pfadmodell die t-Rule

- Zusätzlich muss jedoch der latenten Variable eine Metrik (Maßeinheit, in der sie gemessen wird)

zugewiesen werden

geschieht über Modelleinschränkungen (Parameter werden fixiert)

2

2 Arten einer latenten Variable eine Metrik zuzuweisen können

1. Ladung eines Referenzindikators auf 1 setzen, „marker variable“

2. Varianz der latenten Variable auf 1 setzen, „fixed factor“

t-rule hier:

p=3

Freie Parameter = 6

6 < p*(p+1)/2

6 < 3*2

6 = 6 -> Modell ist exakt identifiziert… Wir sollten den Modellfit nicht interpretieren.

Nach welchem Kriterium werden Pfadmodelle, CFA und SEM geschätzt?

Schätzmethode

Die Parameter sollen so geschätzt werden, dass modellimplizierte Kovarianzmatrix die empirische

Kovarianzmatrix wiedergibt

Abweichung der modellimplizierten Matrix von der empirischen Matrix: χ2-Wert

großes χ2= schlechtes Modell

Dies geschieht über eine Diskriminanzfunktion, die minimiert werden soll.

Typischerweise mittels Maximum Liklihood-Schätzung.

Modellfit überprüfen: Chi-Quadrat-Wert sollte klein und nicht signifikant sein

3

Koeffizienten R2, β, λ interpretieren können

Pfadanalyse:

Kausalpfeile: implizieren eine angenommene Kausalrichtung

Ein sign. Gewicht bedeutet nicht, dass die Kausalrichtung stimmt!

Ebenso bedeutet ein guter Modellfit nicht, dass die Kausalrichtung stimmt!

Hier: Die Ausprägung der direkt beobachteten Variable „AV“ wird verursacht durch die direkt

beobachtete Variable „UV“. Das stand. β1 zeigt wie stark der Zusammenhang ist in SD. Das

unstandardisierte β1 beschreibt den Zusammenhang in der Metrik der beiden Variablen „Wenn UV

um eine Einheit hoch geht, dann geht AV um β1 Einheiten…. hoch/runter“. Die Vorhersage ist aber

nicht perfekt, die Werte in „AV“ werden außerdem noch durch einen nicht beobachteten Faktor

beeinflusst (dem Vorhersagefehler=Residuum).

CFA:

Statt β schreiben wir λ

- Die stand. λ sind die Faktorladungen

- Die R²te zu X1, X2, Xk … sind die Kommunalitäten

Modell aus einer Textaufgabe heraus als SEM aufmalen können

Können Unterschiede zwischen Menschen hinsichtlich ihres wahrgenommenen Stress (AV) durch

folgende Variablen erklärt werden?

1. Wahrgenommene Kontrolle über internale States (PCOISS)

2. Wahrgenommene Selbstwirksamkeit? (mast)

Für jede der drei Variablen liegen je 3 Indikatoren sogenannte Parcells vor (z.B. Parc_pstress1,

Parc_pstress2, Parc_pstress3) .

4

66%= sehr guter Wert!

r2 von der Variable angucken, die erklärt werden soll:

Wie gut kann ich die Varianz von pstress aufklären?

Vorzeichen angucken!

wenn man mastery um 1 erhöht, sinkt stress um .55 SD

5

Vorlesung 2

Parcels

aggregierte Items, typischerweise ein Summen- oder Mittelwert

Warum bildet man Parcels?

um SEM übersichtlicher zu machen

einzelne Items sind oft nicht normalverteilt, Parcels oft -> Verteilungsannahmen werden nicht so oft

verletzt

Modellfit wird besser

Werden nach folgenden Kriterien gebildet:

randomisiert, nach Statistik geleitet

gleichmäßig anhand von Ladungen

inhaltliche Zuweisung

Fit-Indices

Unterschied zwischen den 3 Arten von Fit-Indices konzeptuell verstanden haben

Konkrete Werte für TLI, CFI und RSEA bewerten können, bzw. bei Vergleich von zwei

Modellen mittels AIC/BIC sagen können, welches das bessere ist

beschreiben, wie gut unser Modell die empirische Kovarianzmatrix reproduzieren kann

χ²-Test -> Wie schlecht passt das Modell?

Inkrementelle Fit-Indices

folgen derselben Logik wie R²

sollen über .90 liegen; sehr gut, wenn über .95

NFI:

Obsolet, da besser, je komplexer das Modell, widerspricht dem Parsimonitätsprinzip

benutzt man nicht mehr

TLI wie NFI, aber die x²-Werte werden noch durch die Freiheitsgrade des jeweiligen Modells geteilt

CFI wie NFI, aber es werden von den x²-Werten immer die Freiheitsgrade des spezifizierten Modells

abgezogen

-> bei TLI und CFI werden die Modelle bestraft, je komplexer sie werden

Absolut Fit-Indices

fragen, wie weit bin ich von bestmöglichen Modell entfernt?

badness-Faktor

hohe Werte = schlechtes Modell

RMSEA

.01 excellent, .05 good, .08 mittelmäßig

es kann ein Konfidenzintervall gebildet werden

PCLOSE soll > .05 sein, also nicht signifikant, dann gut!

hier signifikant, kein Close-Fit

6

Comparative Fit-Indices

vergleichen zwei Modelle miteinander und sind auch nur im direkten Vergleich interpretierbar

AIC

k*(k+1)-2df ist immer das doppelte der Anzahl freier Parameter

bestraft Modell mit 2 x²- Punkten pro freiem Parameter

nicht so konservativ

wenn ich komplexes Modell habe, diesen nehmen

k = Anzahl der Variablen im Modell

BIC

2 „Strafpunkte“ werden noch mit dem natürlichen Logarithmus der Stichprobengröße gewichtet

konservativer

bevorzugt eher sparsame Modelle

Können nicht direkt interpretiert werden, sondern es können nur AIC&BIC von Modellen verglichen

werden. Je kleiner der Index, desto besser das Modell.

Je komplexer Modell ist, desto besser wird x²-Wert (ganz automatisch). Aus diesem Grund werden

hier die komplexeren Modelle „bestraft“.

am besten beide Indizes berichten

Ursachen schlechter Fit-Indices

- Modell passt nicht

- wichtige Kovariaten wurden nicht berücksichtigt

- Je besser das Nullmodell auf die Daten passt, desto schlechter fallen inkrementelle Fit-Indices aus

- Viele Indikatoren in den Messmodellen

- Verletzung von Voraussetzungen kennen und wissen, was man tun kann, wenn sie gebrochen

sind:

1. Korrekte Modellspezifikation

2. Modellidentifikation (mehr Infos haben, als wir schätzen müssen: t-rule, latente Variablen

brauchen Metrik)

3. Multivariate Normalverteilung

- Mardias Test (sehr konservativ)

- Mahalanobisdistanzen in SPSS ausgeben lassen und mit pp-Plot / qq-Polt auswerten

- Wenn gebrochen: Robuster Schätzer oder Bootstrap

4. Homoskedastizität (siehe Regression), Daten sollen gleichmäßig um Vorhersagegerade verteilt

sein

5. Unabhängigkeit der Beobachtungseinheiten bzw. wenn diese nicht gegeben ist: „Multilevel

SEM“

7

Longitudinale Modelle

= Längsschnittdaten

Longitudinale Daten sind spezielle Repeated Measures Daten, bei denen die Zielgröße(n) für die

Subjekte mehrfach in zeitlicher Abfolge gemessen wurde(n)

→ z.B. mehrfache Blutdruckmessungen an mehreren Patienten im Zeitraum eines Jahres

Klassisches Nullmodell nicht plausibel (Annahme: Variable korreliert über die Zeit nicht mit sich

selbst)

kann hier nicht stimmen, da Werte von derselben Person oft miteinander korrelieren

-> anderes Nullmodell zur Berechnung inkrementeller Fit-Indices

Welche Art Fit-Indices sollte ich immer nur mit Vorsicht bei längsschnittlichen Daten

betrachten?

ausschließlich Betrachtung von RMSEA und Modellverbesserungen durch x²-Test -> keine

Interpretation von inkrementellen Fit-Indices

Logik der Modellvergleiche verstanden haben (vom uneingeschränkten Modell zum

eingeschränkten) beginnend bei den Messmodellen, erst dann bei dem Strukturmodell

Zeitpunkte

Im Ausgangsmodell werden zunächst Annahmen über die Messmodelle getestet.

Wir beginnen mit dem uneingeschränkten Modell

und führen nach und nach Modelleinschränkungen in den Messmodellen ein

und zwar so lange wie sich das Modell dadurch nicht sign. verschlechtert.

1. Messinvarianz

2. Homogenität der Testhälften

Erst danach beginnen wir mit der Modellierung des Strukturmodells. Auch hier fangen wir beim

allgemeinsten an und tasten uns in Richtung eingeschränktere Modelle vor.

8

Messinvarianz

Sind die Indikatoren über die Zeit gleich mit der latenten Variable verknüpft?

3 Arten von Invarianz über Zeit:

- Schwach (Metrik und Ladungen sollen sich nicht ändern)

- Stark (s.o. + der Intercept der Indikatoren soll sich nicht ändern/MW sollen gleich sein)

- Strikt (Residuen sollen gleich sein, behandeln wir nicht)

Schwache Messinvarianz

Starke Messinvarianz

p-Wert=.638 -> ist mein eingeschränktes Modell schlechter als

vorher? Nein, wird nicht signifikant schlechter.

p>.05-> wir dürfen schwaches Messniveau annehmen

CMIN = χ2 Wert

Restriktionen: L1=L2=L3=L4,

m11=m21=m31=m41

m12=m22=m32=m42

Hoher χ2-Wert, p<.05 -> Modell ist schlechter als

Ausgangsmodell, wenn MW gleich

Hoher χ2-Wert, p<.05 -> Modell ist schlechter als Modell mit

schwacher Messinvarianz, wenn MW gleich

9

Homogenität der Testhälften

Sind die Testhälften innerhalb der Testzeitpunkte gleich?

Folgen die Daten nur einem kongenerischen (uneingeschränkt), essentiell-tauäquivalenten

(Ladungen der Testhälften sind gleich) oder sogar tau-äquivalenten Messmodell (Ladungen und

Mittelwerte der Testhälften sind gleich)?

Beide Testhälften sind innerhalb eines Zeitpunktes gleich

Mehr Freiheitsgrade -> brauche weniger Informationen -> t-rule->

aber modellfit wird schlechter

Nachdem wir die Messmodelle geklärt haben, können wir nun die Messmodelle so lassen wie sie

sind.

Bisher waren Korrelationen zwischen allen Faktoren erlaubt. Das nächsteingeschränktere Modell

wäre ein Latentes Autoregressives Modell zweiter Ordnung.

T1 hat auf T4 keine Auswirkungen

Restriktionen wie vorher

10

Vorlesung 3

Was ist der Unterschied zwischen einem rein autoregressiven Modell, einem Latent-StateTrait und einem Latent-State-Trait mit autoregressiver Struktur?

Latent-State-Trait

Trait: kommt dazu zu allen Zeitpunkten, z.B. versch. Level an

Lebenszufriedenheit pro Person oder Persönlichkeitseigenschaften wie

Extraversion

State

Grundidee Latent-State-Trait-Modell

Modell der Veränderungsmessung

In ihm wird ein beobachteter Wert in einen latenten Traitfaktorwert, einen latenten

messgelegenheitsspezifischen Abweichungswert und einen Fehlerwert zerlegt

Die latenten Traitvariablen kennzeichnen zeitstabile Bedingungen beobachtbarer

Unterscheide, wohingegen die latenten messgelegenheitsspezifischen Variablen

Bedingungen beobachtbarer Unterschiede repräsentieren, die weder auf den Messfehler

noch auf die zeitstabilen Bedingungen zurückgeführt werden können

Autoregressiv:

Zeitlich relativ stabile States, in dem Sinne, dass die aktuelle Stimmung immer die kommende

beeinflusst. Bei Second Order sogar über 2 Zeitpunkte hinaus.

Bei starker Messinvarianz sind sogar die Mittelwerte stabil. In unserem Beispiel nicht, also die

Intercepts/ Mittelwerte verändern sich über die Zeit.

Latent-State-Trait (ohne AR1):

States zeitlich relativ stabil, da Personen ein ähnlich hohes Level an Stimmungen halten. Manche sind

halt tendenziell immer etwas glücklicher als andere und umgekehrt.

Abweichungen zu einem Zeitpunkt von diesem „Stimmungslevel“ sind rein zufällig.

11

Latent-State-Trait (mit AR1):

States relativ stabil, weil jede Person für sich ein ähnlich hohes Level an Stimmungen hält. Manche

sind halt tendenziell immer etwas glücklicher als andere und umgekehrt.

Personen schwanken aber systematisch um ihr mittleres Stimmungslevel in der Weise, dass die

aktuelle Stimmung die des Folgetages beeinflusst.

Was versteht man unter einem autoregressiven Effekt?

regressiver Effekt, den ein Merkmal, das zu einem früheren Messzeitpunkt gemessen wurde,

auf das selbe Merkmale hat, das zu einem späteren Messzeitpunkt erneut gemessen wurde

Was gibt die Ordnung eines autoregressiven Modells an?

In einem autoregressiven Modell k-ter Ordnung wirken sich alle Messungen bis zu dem k-ten

Messzeitpunkt vor der Messung in direkter Weise auf Merkmalsunterschiede aus.

Latent Change

Wann brauche ich ein latent change-Modell?

Einem einfachen Latent Change Modell liegt i.d.R. dieselbe Forschungsfrage zu Grunde wie

bei einem T-Test für abhängige Stichproben (T1-T2 Hat sich Mittelwert verändert?)

Es geht also um Mittelwertsveränderung, aber auf latenter Ebene. (In den vorigen Modellen

ging es um Stabilitäten)

Messfehler ist nicht mit drin

Nehmen wir an: a1=5, a2=10, L1=1

Karl hat einen Wert von 5 auf T1. Für Test1_T1 würden wir einen Wert

von 10 vorhersagen, für Test2_T1 einen von 15.

Für T2 würden zunächst auch einen Wert von 4 vorhersagen (ohne Change

zu berücksichtigen). Folglich würden wir für Test1_T2 einen Wert von 10 und

für Test2_T2 einen Wert von 15 vorhersagen. (Also keine Veränderung auf

den Indikatoren)

T2=1xT1&1xChange

Jetzt hat Karl aber einen Wert von 15 auf Test 1 und 20 auf Test 2 zu T2. Wir

haben seine Werte jeweils um 5 Punkte unterschätzt. Damit die Gleichung

wieder passt sollte Karl auf Change einen Wert von 5 haben (Für Test 1 wäre

dann die Vorhersage 10+5=19 und für Test 2 15+5=20).

In Change stecken also die Veränderungen. Hohe Varianz bedeutet: Viel

Veränderung. Ist der Mittelwert von 0 verschieden dann bedeutet das, dass

im Mittel die Werte steigen (positiver MW) oder sinken (negativer MW).

12

Steigt positiv um 9.5, Veränderung signifikant

Vorlesung 4

Beispiel Strukturgleichungsmodell aus Hypothesen aufmalen

a) Ein niedriges Fähig.Selbstkonzept bzgl. Mathe und/oder PCs/SPSS macht, dass man mehr Angst vor

Statistik hat.

b) Angst vor Statistik reduziert die Motivation etwas aus der Veranstaltung dauerhaft mitnehmen zu

wollen

c) Die Selbstkonzepte haben neben ihrem indirekten Effekt über die Angst vor Statistik auch noch

einen direkten Effekt auf die Motivation

Nicht vergessen, alle Residuen einzuzeichnen und die Metrik zuzuweisen (Ladungen der Residuen

sowie Variablen auf Parcels) auf 1

Mathe & PC haben keinen eigenen Fehler

13

deuten der Ergebnisse:

FSK Mathe & PC sind in der falschen Richtung -> hohe Werte= schlechtes Selbstkonzept

in Mathe schlecht -> hohe Motivation -> direkter Effekt kurios

PC könnte man rausnehmen, weil Ladungen niedrig sind

r2 soll zwischen 0 und 1 sein -> würde hier 219% Varianzaufklärung bedeuten -> Heywoodcase ->

Varianz auf 1 setzen

Modellgüte bewerten

chi-square nicht signifikant-> Modell ist nicht schlechter als das saturierte Modell

TLI & CFI gut

RMSEA zwischen gut und mittel, gut wäre bis .05

14

Welches Modell ist am besten?

gucken, welches Modell den kleinsten Wert hat

lassen wir den direkten Effekt weg, ist unser Modell nicht sign. schlechter

CMIN: so viele Punkte weicht es ab von default model

>.05 nicht signifikant schlechter

<.05 signifikant schlechter, nicht nehmen

nach Sparsamkeitsprinzip nimmt man das Modell, das weniger hat -> eingeschränkteres Modell

je mehr Freiheitsgrade, desto eingeschränkter -> sparsameres Modell

Noch ein Beispiel, Längsschnittdaten

Robin erforscht emotionales Erleben während Teamtrainings im Kletterpark und den Effekt auf das

Feedback der Schüler. Er sammelt von 200 Trainings Daten. Er misst immer den Begeisterungsfaktor

der Schüler (mit dem AwE) zu jeder Trainingseinheit (insgesamt gibt es vier) und kopiert sich den

Feedbackbogen des Lehrers.

Robin glaubt, dass die erste Übung entscheidend ist. Löst die erste Übung viel Begeisterung aus, dann

bleibt dieser Effekt relativ stabil.

Und zwar in der Weise, dass die aktuelle Begeisterung die Begeisterung bei der kommenden

bestimmt.

Robin glaubt aber auch, dass das Feedback vor allem von dem Begeisterungsfaktor bei der ersten

Übung als auch dem der Letzten abhängt. Die dazwischen spielen keinerlei Rolle.

Robin glaubt, dass der Begeisterungsfaktor beim ersten Training vor allem von der Fähigkeit des

Trainers abhängt.

Modell:

15

Ergebnisse:

Wie gut können Unterschiede im Feedback erklärt werden durch dieses Modell? 83%

Varianzaufklärung

Modellgüte bewerten

chi-square nicht signifikant-> Modell ist nicht schlechter als das saturierte Modell

TLI & CFI gut

RMSEA zwischen gut und mittel, gut wäre bis .05

16

Vorlesung 5

Loglineare Modelle

Zusammenhang von mehreren kategorialen Variablen gleichzeitig untersuchen (vorher

waren nur Unterschiede zwischen 2 möglich)

-> loglineare Modelle zur Analyse mehrdimensionaler Kontingenztabellen

3 mögliche Notationen:

multiplikatives Modell

additives Modell

Modell mit Referenzkategorie

Beispiel für 3dimensionale Kontingenztabelle:

Odds-Ratio

Odds = Chance

(Beispiel: Die Chance, dass man als Mann Karottenhosen präferiert ist 2:28 (30-2 Hosen, die sie

tragen) bzw. 1:14. Achtung: Die Wahrscheinlichkeit wäre dagegen 2/30)

Odds-Ratio = Chancenverhältnis

(Beispiel: Die Chance, dass man als Mann Karottenhosen präferiert ist 1:14. Bei Frauen 8:62, gekürzt

4:31. Das Odds Ratio wäre (1:14)/(4:31)≈0,55 (Die Chance, dass Karottenhosen bevorzugt werden, ist

bei Männern grob halb so groß wie bei Frauen bzw. bei Frauen etwa grob doppelt so hoch

(4:31)/(1:14) ≈1,8; Man kann statt dessen auch einfach den Kehrwert nehmen: 1/0,55 ≈ 1,8)

17

Wie berechnet sich grob der χ2-Wert? Bzw. was repräsentiert er?

χ²-Anpassungstest

Die Teststatistik: Über alle Zellen aufsummieren: (Abweichung²/erwartete Häufigkeit)

Beispieldaten, erstmal zweidimensional:

Multiplikatives Modell

Ziel:

mehr als 2 Dimensionen werden modelliert

man kriegt Koeffizienten im Randbereich

kann Effektgrößen vergleichen

Berechnung geometrisches Mittel über alle Zellen:

Für jede Faktorstufe:

18

Haupteffekte:

Bei nur 2 Stufen ergibt sich immer der Kehrwert der anderen Stufe.

Werte > 1 zeigen, dass hier die Häufigkeiten größer sind als bei einer

angenommen Gleichverteilung innerhalb eines Faktors.

Werte < 1, dass sie kleiner sind als bei einer angenommen Gleichverteilung.

Herrchen/Frauchen entscheiden sich also öfter für affektive Belohnung

(1,68). Ungefähr gleich viele Tiere können tanzen, wie Tiere nicht tanzen

können (halbe:halbe) mit leichter Tendenz, dass es ein paar mehr können

(1.06).

Interaktion:

Drückt die Abweichung des beobachteten Wertes in Zelle 1,1 aus, von der Erwartung, wenn wir

annehmen würden, dass sich die beiden Haupteffekte einfach addieren. Nehmen wir den Wert hoch

dem Produkt der Anzahl der Stufen der beteiligten Faktoren erhalten wir das passende Odds-Ratio

(+Rundungsfehler): 0,764 = 0,33

Man liest es immer so: das was oben steht und das was als erstes steht -> darauf bezieht sich das

ausgerechnete OR

Die Chance, dass ein Tier nicht tanzen kann, wenn man es mit Futter belohnt hat, ist also ungefähr

ein Drittel (0,33) gegenüber den Tieren, die mit affektiven Reaktionen belohnt wurden.

Andersrum ausgedrückt: Die Chance, dass ein Tier tanzen kann, ist 3 mal so hoch, wenn man es mit

Futter belohnt hat, als wenn man es mit affektiven Reaktionen belohnt hat.

Additives Modell

einfach logarithmieren

Vorteile Interpretation:

Koeffizienten sind einfacher zu interpretieren

hier bedeutet 0 kein Effekt, „+“ positiver Effekt, „-“ negativer Effekt

Interaktion:

Um wie viel weicht die beobachtete logarithmierte Häufigkeit von der erwarteten logarithmierten

Häufigkeit ab, wenn man annimmt, dass ein rein additiver Effekt der Haupteffekte vorliegt?

19

Additives Modell mit Referenzkategorie

SPSS wählt für jeden Faktor eine Referenzkategorie und zwar immer die höchste Stufe

(dass, was auf 1 kodiert ist)!

Referenzzelle ist dann die, wo sich alles kreuzt

Statt der Abweichungen von der mittleren Häufigkeit werden nun die Abweichungen von der

Referenzkategorie oder Referenzzelle berechnet.

Interaktion

Constant: logarithmierte Häufigkeit von Zelle 2,2. Der p-Wert zeigt lediglich, dass der Wert sign. von

Null abweicht.

[Training = 0]: Es wählen sign. weniger Frauchen/Herrchen Essen als Belohnung, verglichen mit der

Referenzkategorie (innerhalb der Gruppe der Tiere, die tanzen können).

20

[Dance = 0]: Es gibt sign. mehr Tiere, die nicht tanzen, als es Tiere gibt, die tanzen - innerhalb der

Gruppe der Tiere, die affektiv belohnt wurden.

[Training=0]*[Dance=0]: Gibt man Tieren Essen als Belohnung, können sign. weniger Tiere nicht

tanzen als man es durch die rein additiven Effekte erwarten würde.

Vorlesung 6

Loglinear-Modellvergleiche

Einzelne Effekte können auf 0 gesetzt werden. Bedeutet: dieser Effekt existiert nicht.

1. Behält man einen Effekt im Modell, dann müssen auch alle anderen Effekte niedrigerer Ordnung

erhalten bleiben.

2. Ist ein Modell ein Spezialfall eines vorherigen Modells, dann handelt es sich um hierarchische

Modelle. Diese können mit x²-Differenztest oder Logliklihood- Quotiententest verglichen werden.

auf 0

A*B*C = 3. Ordnung

A*B usw. = 2. Ordnung

A = 1. Ordnung

auf 0

C fehlt, sollte aber drin sein,

weil es oben drin ist

geht nicht,

weil A*B

wieder

auftaucht

Wie bei Strukturgleichungsmodell:

x² (Modellvergleich) = x² (eingeschränktes Modell) – x² (weniger eingeschränktes Modell)

df (Modellvergleich) = df (eingeschränktes Modell) – df( weniger eingeschränktes Modell)

Benutze ich Pearson x² für einen Modellvergleich, sprechen manche von einem x²-Differenztest.

Benutze ich liklihood-ratio, dann sprechen manche von dem Liklihoodquotiententest. SPSS benutzt

intern letzteren.

Erhebungsschema

Multinomial: Das N wird vor der Untersuchung festgelegt.

Beispiel: Wir sammeln ab jetzt so lange VPs bis wir 200 haben!

Multinomial-Produkt: Das N und die Verteilung eines Faktors wird festgelegt.

Beispiel: Wir sammeln jetzt 200 VPs, 100 Frauen und 100 Männer! Nicht in SPSS

implementiert, nicht prüfungsrelevant

21

Poisson: Weder N noch irgendeine Randverteilung wird festgelegt.

Beispiel: Okay, wir starten morgen früh um 8:00 mit dem VP sammeln und schauen wie viele

VPs wir bis 20:00 zusammenbekommen.

Constant= Referenzzelle

Animal

0=Katzen

1=Hunde

Training

0=Essen

1=affektiv

Dance

0=no

1=yes

[Animal=0]

Katzen sind häufiger als Hunde (innerhalb Training=1 und Dance=1)

[Training=0]

Es wird seltener mit Essen belohnt (n.s.) (innerhalb Animal=1 und Dance=1)

[Dance=0]

Nur der kleinere Teil der Tiere tanzt nicht (innerhalb Training=1 und Animal=1)

[Animal=0]*[Training=0] Verglichen mit Hunden, werden Katzen seltener mit Essen belohnt (n.s.)

(innerhalb Dance=1)

[Training=0]*[Dance=0] Tiere, die mit Essen belohnt werden, können öfter nicht tanzen (n.s.)

(innerhalb Animal=1)

[Animal=0]*[Dance=0]

Training=1)

Verglichen mit Hunden, können Katzen öfter nicht tanzen (innerhalb

[Animal=0]*[Training=0]*[Dance=0] Verglichen mit Hunden, können Katzen seltener nicht tanzen,

wenn man ihnen essen als Belohnung gibt

Beobachtete und erwartete Häufigkeiten sind gleich, da saturiertes Modell

Dog, Affection as reward & Yes = Referenzkategorie, weil alles mit 1 kodiert

22

3fach-Interaktion sichtbar, moderiert durch Katze/Hund

Katzen sollte man eher mit Essen belohnen, Hunde eher mit Affekt

23

Anderes Beispiel

Psychotherapie (0=ja, 1=nein), Schlafstörungen (0=ja, 1=nein)

Konstante: logarithmierte Häufigkeit der Referenzzelle (1) keine Psychotherapie und (1) keine

Schlafstörungen ist signifikant von 0 verschieden.

PsyTh: (in der Kategorie (1) keine Schlafstörungen): in der Kategorie (0) Psychotherapie gibt es

signifikant weniger Personen als in der Kategorie (1) keine Psychotherapie.

Schlafst: (in der Kategorie (1) keine Psychotherapie): in der Kategorie (0) Schlafstörungen gibt es

signifikant weniger Personen als in der Kategorie (1) keine Schlafstörungen.

PsyTh*Schlafst: In der Zelle (0) Psychotherapie und (0) Schlafstörungen gibt es signifikant mehr

Personen als man durch die rein additiven Effekte erwarten würde!

In der Kategorie keine Schlafstörungen gibt es signifikant weniger Personen mit Psychotherapie,

OR = -2.434, in der Kategorie keine Psychotherapie gibt es signifikant weniger Personen mit

Schlafstörungen, OR = -.865, und es gibt signifikant mehr Personen mit Psychotherapie und mit

Schlafstörungen als man es durch die rein additiven Effekte erwarten würde, OR = 1.895.

2x2x2-Design

K=1+: Alle Haupteffekte + Zweifachinteraktionen + dreifach sind zusammen statistisch bedeutsam

K=2+: Betrachtet man alle Interaktionen gemeinsam, so sind diese immer noch bedeutsam.

K=3+: Betrachtet man nur die Dreifachinteraktionen, dann sind diese (gibt ja nur eine) nicht

bedeutsam (p=.058).

24

K=1 Die Haupteffekte sind zusammen statistisch nicht bedeutsam

K=2 Die Zweifachinteraktionen sind zusammen bedeutsam

K=3 Die Dreifachinteraktionen sind zusammen (wieder gibt nur eine) nicht bedeutsam

Step 0: Entferne ich die Dreifachinteraktion, dann ist das neue Modell nicht sign. schlechter als das

saturierte Modell. -> Wir schließen eine Dreifachinteraktion aus und gehen weiter:

Step 1: Prüfen, welche zweifache Interaktion ausgeschlossen werden kann:

Raucher*Rentenbegehren hat den kleinen x²-Wert und ist nicht sign. Fliegt also raus…

Step2: Wir prüfen die anderen beiden zweifachen Interaktionen nochmals, aber ohne das

Raucher*Rentenbegehren noch im Modell sind. Keine der beiden Interaktionen kann ausgeschlossen

werden und verbleiben im Modell

Step 3: Unser finales Modell weicht 5,739 x²-Werte (bestimmt über Logliklihood) vom saturierten

Modell ab.

Dieser Unterschied ist nicht sign.

Kleines Fazit loglinearer Modelle

Mit loglinearen Modellen lassen sich mehrdimensionale Kontingenztabellen analysieren

Die Notation mit Referenzkategorie macht es jedoch schwer die Ergebnisse alleine anhand

der Koeffizienten zu interpretieren. Eine begleitende graphische Analyse wird daher

empfohlen

25

Vorlesung 7

Logistische Regression

äquivalent einer linearen Regression bei dichotomer AV (intervallskaliert oder dummykodiert =

lineare/ multiple Regression)

Ansatz kann aber auch auf mehrkategoriale AVs erweitert werden

Beispiel: hat die Körpergröße was damit zu tun, wie viele Basketballkörbe ich werfe?

Bedeutung von b0 (bei b1≠0)

Formel wie Regressionsgleichung:

b0= Konstante

Bedeutung von b0 (bei b1=0)

es ist egal, wie groß-> immer gleiche Chance

26

Bedeutung von b1

je höher Prädiktor, desto wahrscheinlicher, dass ich 1 erreiche (negativer Zshg.)

Vorzeichen von den Regressionsgewichten kann ich genauso interpretieren wie bei der linearen

Regression

allerdings sagt die Vorhersagegleichung jetzt nur die Logits vorher, die kann man nicht gut

interpretieren

Ich kann sie aber durch exp so umformen, dass sich Odd`s Ratios ergeben

Bedeutung von eb0 und eb1

oben Wahrscheinlichkeit

unten Gegenwahrscheinlichkeit

Sind die Odds bzw. Chancen zur Kategorie 1 der abhängigen Variable zu gehören

27

Odd`s Ratios für intervallskalierte Variablen interpretiere ich so:

„Pro Einheit im Prädiktor steigt die Chance, zur Kategorie 1 der abhängigen Variable zu gehören auf

das x-fache“

Wenn z.B. x=2, dann verdoppelt sich die Chance

wenn x=0,5, dann halbiert sich die Chance

Koeffizienten im Output

ist der Wert von 1

verschieden? Ja

bei 1 kein Effekt

Wald Test: hat der Prädiktor einen signifikanten Einfluss

auf die abhängige Variable?

e b1

pro Trainingsstd. halbiert

sich die WSK sich zu

verletzen

e b0 = Basis-WSK, 200 mal höher

Chance, sich bei Kampfsport zu verletzen bei 0

Trainingsstd. 200mal höher

bei 1= 50/50

Anderes Beispiel

Eine Krankenkasse möchte die Wirksamkeit einer Suchttherapie evaluieren: Dafür erfasst sie bei

Personen, ob in den vergangenen Jahren eine Therapie gemacht wurde (0 = nein, 1 = ja), ob noch

immer eine Suchterkrankung vorliegt, d.h. die Person geheilt ist oder nicht (0 = nicht geheilt, 1=

geheilt) und ob es im vergangenen Jahr einen Rückfall gab (0 = ja, 1 = nein). Außerdem wurde die

Motivation keinen Alkohol mehr zu trinken, die kognitive Fähigkeit und die generelle Ängstlichkeit

erfasst, sowie die Anzahl ebenfalls suchtkranker Freunde.

Spielt für einen Rückfall das Ausmaß kognitiver Fähigkeiten, Motivation und Anzahl der Freunde mit

einer Suchterkrankung eine Rolle?

28

Eine binäre logistische Regression mit kognitiven Fähigkeiten, Motivation keinen Alkohol mehr zu

trinken und Anzahl suchtkranker Freunde als metrischen Prädiktoren und Rückfall (ja vs. nein) als

abhängiger Variablen zeigte einen signifikanten Effekt der kognitiven Fähigkeiten, b = -.22, Wald =

6.97, p < .01, und der Anzahl suchtkranker Freunde, b = .07, Wald = 8.64, p < .01, aber keinen

signifikanten Effekt der Motivation, b = -.42, Wald = 1.65, ns, d .h.

je mehr kognitive Fähigkeiten, desto geringer die Chance eines Rückfalls (Odds Ratio = .80:

für jeden Punkt mehr auf der Skala kognitive Fähigkeiten, steigt die Chance um das 0.80fache, sie sinkt also!) und

je mehr suchtkranke Freunde, desto höher die Chance eines Rückfalls (Odds Ratio = 1.07:

für jeden suchtkranken Freund mehr, steigt die Chance um das 1.07-fache).

Spielt es für die Heilung eine Rolle, ob eine Therapie gemacht wurde und die Höhe der Motivation

keinen Alkohol mehr zu trinken?

Eine binäre logistische Regression mit Therapie als dichotomen und Motivation keinen Alkohol mehr

zu trinken als metrischem Prädiktor und Heilung (ja vs. nein) als abhängiger Variablen zeigte einen

signifikanten Effekt der Therapie, b = 1.23, Wald = 8.85, p < .01, aber keinen signifikanten Effekt der

Motivation, b = -.01, Wald = .002, ns, d .h. die Chance nach 5 Jahren geheilt zu sein ist nach einer

Therapie ca. dreieinhalb mal so groß wie ohne Therapie (Odds Ratio = 3.43), unabhängig von der

Motivation.

29

Vorlesung 8

Anderes Beispiel logistische Regression

Suizidrisiko (dichotom)

Je älter, desto größer Chance sich zu suizidieren (0.71)

emotionales Ventil verringert Suizidwsk. (-0.34)

R = first-order Korrelationen (phi oder Produkt Moment)

B = unsere Regressionsgewichte:

(+) Risiko nimmt durch Erhöhung des Prädiktors zu

(-) Risiko nimmt durch Erhöhung des Prädiktors ab

Odd`s Ratio aus B: exponieren, damit man sie besser deuten kann

Interpretationen von Koeffizienten bei Dummykodierung

Für getrennte oder geschiedene Frauen (Dummy 1) ist die Chance als suizidal eingestuft zu

werden um den Faktor 1,2 höher als in der Referenzkategorie (also in Partnerschaft lebende

Frauen) – Dieser Effekt ist nicht signifikant (p=.786)

30

Für in Partnerschaft lebende Frauen (Dummy 1) ist die Chance als suizidal eingestuft zu werden 1,747

mal so hoch wie in der Referenzgruppe (Singles). Der Effekt ist nicht sign. (p=.588) .

Für getrennte oder geschiedene ist die Chance 2 mal so hoch wie in der Referenzkategorie (Singles) –

Der Effekt ist nicht signifikant (p=.535).

Interpretation von Koeffizienten bei intervallskalierten Prädiktoren

Pro Altersjahr verdoppelt sich die Chance suizidal eingestuft zu werden. Dieser Effekt ist sign.

(p=.032) .

Vorsicht: Hier wird ein linearer Effekt auf die Logits angenommen… Das ist hier okay, da nur

die Jahre 14 bis 18 untersucht werden und man für diesen Zeitraum auch Linearität

annehmen kann. Wir wissen jedoch, dass das Selbstmordrisiko auch irgendwann wieder

abflacht. (quadratische Logit-Funktion).

31

Odd`s Ratio, Probleme Interpretation

Negative Odds gibt es nicht

zwischen 0 und 1 negativer Effekt

positiver Effekt kann bis ins unendliche gehen

negative mit positiven vergleichen: Kehrwert des negativen-> vergleichen

OR kleiner 1 und größer 1 lassen sich nicht direkt vergleichen.

Man kann jedoch immer den Kehrwert nehmen, um die Größe des Effektes zu vergleichen.

Kehrwerte bilden

,001= 1/1000 -> 1000

,01= 1/100 -> 100

,05 = 5/100 -> 100/5-> 20

,1 = 1/10 -> 10

,2 = 2/10 -> 5

,25 =25/10 -> 0,4

,5 = 5/10 -> 2

1 -> 1

1,5 = 15/10 -> 10/15-> 2/3

2 -> 1/2

4 ->1/4

5 ->1/5

10 ->1/10

20 -> 1/20

100 -> 1/100

1000 -> 1/1000

Relative Bedeutung von Prädiktoren vergleichen

kategoriale Prädiktoren

„marital status“ hat ein Odds Ratio von 1,2. Ist man getrennt/geschieden, ist die Chance als

suizidal (Y=1) eingestuft zu werden also 1,2 mal so groß wie in der Referenzgruppe (in

Beziehung).

Nehmen wir an, wir wollen „marital status“ mit einem anderen (fiktiven) kategorialen

Prädiktor vergleichen, z.B. „Intervention“ mit der Referenzkategorie „keine Intervention“.

Nehmen wir an „Intervention“ hat ein Odds-Ratio von 0,5. Dann ist die Chance als suizidal

(Y=1) eingestuft zu werden nur halb so groß, wenn man in der Interventionsgruppe ist.

Wollen wir die Odds vergleichen, sollten wir den Kehrwert bilden. Die Interpretation kehrt

32

sich dann jedoch um: Ist man in der Interventionsgruppe, dann ist die Chance 2 mal so groß

nicht-suizidal (Y=0) eingestuft zu werden.

Odds-Ratio sind also gut geeignet, um kategoriale Prädiktoren miteinander zu vergleichen.

- intervallskalierte Prädiktoren

„Alter“ hatte ein Odds-Ratio von ungefähr 2, „vicarious listening“ von 0,710.

Pro Jahr Alter verdoppelt sich also die Chance als suizidal (Y=1) eingestuft zu werden.

Um es mit „vicarious listening“ vergleichen zu können, sollten wir wieder den Kehrwert

nehmen, die Interpretation dreht sich damit aber auch um: Pro Punkt auf der „vicarious

listening“ Skala steigt die Chance mal 1,41 als nicht suizidal (Y=0) eingestuft zu werden.

Ein Problem bleibt aber: Wir vergleichen den Effekt von einem Jahr mit dem Effekt von

einem Punkt auf der „vicarious“ Skala. Während Alter nur von 14,5 bis 18,5 streut (mit

sd=.95), streut „vicarious listening“ von 2 bis 8 (sd=1,82).

Odds-Ratios sind also nur bedingt geeignet, um den Einfluss von intervallskalierten

Prädiktoren mit anderen Prädiktoren zu vergleichen:

a) Bei gleicher Skalierung direkt vergleichbar

b) Bei ungleicher Skalierung in der Interpretation berücksichtigen

c) Oder Skalierung mittels Transformation anpassen.

Nullmodell, Modellschätzung und Modellfit

Reihenfolge der Berechnung

1. Berechnung des Nullmodells (keine Prädiktoren, schlechtmöglichst)

2. Berechnung der -2*Loglikelihood vom Nullmodell

(wie schlecht passt das Nullmodell)

3. Schätzung des spezifizierten Modells (unser Modell)

(Parameter werden so geschätzt, dass das Modell bestmöglich auf die Daten passt.

Loglikelihood soll möglichst klein werden)

4.Vergleich der Loglikelihood und die Berechnung daraus resultierender Fit-Indices

Nullmodell

Der Output teilt sich in Blöcke:

Block 0: Wird das Nullmodell ausführlich berechnet.

(Modell ohne Prädiktoren, aber Verteilung der AV ist bekannt)

fast immer irrelevant für uns

Block 1: Unser Modell mit Prädiktoren

(weitere Blöcke kommen nur bei Modellvergleichen oder schrittweisen Verfahren zum

Einsatz)

33

Log-likelihood von Nullmodell (Schritt 2)

und spezifizierten Modell (Schritt 3)

Hier die -2LL von unserem Nullmodell!

Hier die -2LL von unserem

spezifizierten Modell. Die

Parameter in diesem Modell

wurden so geschätzt, dass die -2LL

möglichst klein wird.

(Parameter werden also so

geschätzt, dass das Modell best

möglichst auf die Daten passt)

log-likelihood-Statistik -2LL: wie schlecht passt unser Modell auf die Daten? -> sollte also

möglichst klein sein, um bestmöglich auf die Daten zu passen

gibt uns aber alleine keine interpretierbaren Informationen

34

Modellvergleich und Modellfit (Schritt 4)

χ²-Test

So lange keine automatisierte Modellauswahl

eingestellt ist, steht hier in jeder Zeile dasselbe,

nämlich der Modellvergleich: Unser

spezifiziertes Modell vs. Nullmodell

Was bedeutet hier der sign. x²-Test?

Unser Modell mit Prädiktoren ist sign. besser als das Baselinemodell (also ein Modell ohne

Prädiktoren!)

x2 = -2LL (Nullmodell) – (-2LL(spezifizierten Modell))

= 2[LL(spezifizierten Modell) – LL(Nullmodell)

Df = df(spezifiziertes Modell) – df(Nullmodell)

Beispielrechnung hier:

x2 = 135, 533 - 85,116

df = 13 – 1

(df= Anzahl Prädiktoren + 1; (1 für die Konstante)

Dieser Test sagt uns lediglich: Unser spezifiziertes Modell ist sign. besser als ein Modell ohne

Prädiktoren.

Pseudo R²te

Bei dichotomer AV kann man keine echte Varianz

berechnen.

Daher kann man auch kein R² (Varianzaufklärung)

berechnen. Die Pseudo R²te versuchen aber

dennoch ein ähnliches Maß

darzustellen (hier Erklärungskraft gemessen in

Anteilen eines perfekten Modells).

1. Cox n Snell

konservativer Ersatz für R²

34,1% der Varianz kann erklärt werden durch das Modell

das ist allgemein als gut bis sehr gut zu werten

kann nie 1 werden -> blöd, weil Modelle dann nie passen würde -> deshalb Korrektur

2. Nagelkerke

progressiver Ersatz für R2

hat standardisierte Form entwickelt

je schlechter Nullmodell, desto größer R²

hier .506 als gut bis sehr gut zu werten

Zwischen 34,1 und 50,6% der Varianz können durch das spezifizierte Modell erklärt

werden

35

Fazit

Pseudo R² können ähnlich interpretiert werden wie R² aus der linearen Regression.

SPSS gibt uns nur Cox n Snell und Nagelkerke (immer etwas größer als Cox n Snell) aus. In

unserem Beispiel können zwischen 34,1% und 50,6% der Variabilität im Kriterium durch

unser Modell erklärt werden.

Mit dem χ2-Test kann das spezifizierte Modell gegen das Nullmodell, aber auch gegen jedes

andere genestete Modell getestet werden.

Wichtigste Schritte bei der Interpretation

1. Modellfit (x2-Test, Pseudo-R2te + evtl. Kennwerte aus der Klassifikation)

2. Koeffizienten (was wirkt wie stark und in welche Richtung und ist es sign.?)

Für manche Fragestellungen kann es wichtig sein, die Klassifikationstabellen anzuschauen.

Z.B. kann es sein, dass mich gar nicht der „Overall-fit“ so sehr interessiert, sondern es geht

mir vor allem darum eine sehr sensitive Testbatterie zu haben.

Klassifikationstabellen

Block 0: Nullmodell (Modell, wo dieselbe WSK für jd. Person hat; zieht Infos aus Grundgesamtheit,

75,2% werden richtig einsortiert)

Block 1: unser Modell (11 Personen mehr werden richtig klassifiziert)

36

Sensitivität, Spezifität und pos. Prädiktionswert eines Modells bestimmen

RP=17

FN=13

RN=85

FP=6

Sensitivität (Wie viel wird erkannt?): 56,7% (nicht gut für Screening, zu gering)

Spezifität (Gegenteil: Wie gut werfe ich faule Eier raus?): 93,4%

Pos. Prädiktionswert: (17/23)*100 ≈ 73,9%

Das heißt, wir können Sensitivität und Spezifität auch für ein ganzes Modell ermitteln. Hebt

man den Trennwert (Cut-Off) an, dann gewinnt man Spezifität. Senkt man den Trennwert

(Cut-Off), dann gewinnt man Sensitivität. – Immer aber zum Preis, dass die

Overall-korrekten-Klassifikationen sinken.

Vorlesung 9

Überlebenszeitanalysen

Was sind Eventdaten? Wie sind sie strukturiert?

oder Event-occurrence-Analysen

fragen danach: „Tritt ein bestimmtes Event auf, und wenn ja, wann?“

„Gibt es individuelle Faktoren, die das Risiko, dass ein Event eintritt, reduzieren

oder erhöhen?“

Was ist jetzt unter dem Event zu verstehen? – Klassische Anwendungen haben

darunter meistens den Tod oder eine bestimmte Todesursache verstanden

Events-Occurrence, die für Psychologen relevant sein können:

- Rückfall nach einer Entwöhnungsbehandlung oder rezidivierender Depression

- Erstes delinquentes Verhalten bei Jugendlichen

- Erstes Auftreten von Symptomen bei Personen von Hochrisikogruppen

- Wie schnell schlägt eine Therapie an?

37

Beispiel:

Eine Pandemie bricht aus, und wir haben 18 frisch infizierte Freiwillige, die wir 30 Monate

begleiten. Wir schauen, „ob und falls ja, wann“ sie innerhalb der 30 Monate durch einen

Suizid sterben, um herauszufinden, ob Supertoxoplasmose wirklich das Suizidrisiko steigert.

In einem zweiten Schritt wollen wir schauen, ob sich die Sterberaten von einer

Kontrollgruppe unterscheiden.

„whether and when Rule“ von Singer&Willet:

Wann immer „ob“ und „wann“ in meiner Fragestellung auftauchen, sollte ich

darüber nachdenken, ob ich es nicht mit Event- /Überlebensdaten zu tun habe bzw.

meine Konstrukte so operationalisieren sollte, dass ich Event-/Überlebensdaten

erhalte.

deutsche Publikationen: fast immer der Satz „Wie lange dauert es, bis…“

Wichtigste Fragen bzgl. der Erhebung von Eventdaten:

- Welches konkrete Event untersuchen wir?

(in unserem Datenbeispiel: Suizid. Besonderheit: Stirbt eine Person aus anderen

Gründen, können wir leider nicht mehr rausfinden, ob und wann das Event eingetreten

wäre.)

- Was ist der Zeitpunkt Null?

(in unserem Datenbeispiel: direkt ab der Diagnose – wünschenswert wäre ab der

Infektion, aber das ist in vielen Fällen schwierig zu erreichen und führt zu zusätzlicher

Unsicherheit in den Daten. Nehmen wir aber an, dass aufgrund der Pandemie

Testungen täglich durchgeführt werden sollen, sollte dies hier kein Problem darstellen)

- In welcher Metrik messen wir die Zeit?

(in unserem simulierten Beispiel kommt von jedem Infizierten ein Wochenbericht rein)

Einfachste Art von Eventdaten – Eigenschaften

- Alle VPs starten zum Zeitpunkt Null

- Zeit wird diskret (Zeitpunkte/-intervalle) gemessen

- Jeder VP ist ein Zeitpunkt zugeordnet, wann etwas passiert ist

- Passieren kann, dass das Event eintritt oder die VPs aus irgendeinem anderen Grund nicht

mehr weiterbeobachtet wird (z.B. der Untersuchungszeitraum ist vorbei)

man unterscheidet Fälle, bei denen das Event eintritt i.d.R. von

zensierten Fällen

- entsprechen im Prinzip „Missings“ aus anderen Verfahren, besitzen aber für die

Überlebensanalysen immer noch mehr Informationen

- rechtszensierten Daten: wir wissen zwar nicht, wann das Ereignis eingetreten wäre, aber

dass es später als die letzte Beobachtung sein muss

- intervallzensierten Daten: Daten aus einem oder mehreren Zeitintervallen fehlen

In unserem Beispiel ist das nicht weiter schlimm, da wir davon ausgehen können, dass das

Ereignis Suizid nicht in dem Zeitraum eingetreten sein kann. (Person lebt ja später noch)

- Linkszensierte Daten: Startpunkt unbekannt

In psychologischen Untersuchungen ist dies fast immer durch das Design vermeidbar.

Probleme können aber z.B. bei der Bestimmung des Startpunktes einer Depression o.ä.

entstehen.

38

zensierte Fälle werden in noninformative und informative unterteilt

Grundannahme, davon gehen wir aus:

noninformative entspricht in etwa MCAR: Mechanismus, der dafür sorgt, dass Fälle

zensiert werden ist rein zufällig

informative (entspricht in etwas MNAR): Mechanismus, der dafür sorgt, dass Fälle

zensiert werden und die Auftretenswahrscheinlichkeit des Events sind konfundiert.

Beispiel: Wir warten darauf, dass Alkoholabstinente rückfällig werden. Dummerweise

neigen Rückfällige dazu, sich nicht mehr zu melden, bevor man feststellen kann, dass

sie rückfällig geworden sind und werden als zensiert geführt.

rechtszensierter Fall (Zensur vor Ende der Untersuchung)

rechtszensierter Fall (Zensur nach Ende der Untersuchung)

Intervallzensierter Fall

wo ein ? steht -> drop-out -> wir wissen nichts

Klassische Ansätze bei Zeiteinteilung

- Sterbetafeln bzw. Versicherungsmathematische Methode

unterteilt Zeit in gleichgroße, vor der Analyse definierte Zeitintervalle

- Kaplan-Meier-Methode

unterteilt Zeit in unterschiedlich große Intervalle

Zeitintervall beginnt, wenn gerade ein Ereignis eingetreten ist und endet, wenn ein neues

auftritt.

39

Survival und Hazard-Rates interpretieren können

Survivor-Rates/-function

Wie viel Personen leben noch zu einem bestimmten Zeitpunkt?

Wie schnell sterben VP? Wie schnell treten Ereignisse ein?

rein deskriptiv, nicht parametrisches Verfahren

fällt immer

Hazard-Rates/-function

Ausfallrate (relatives Risiko zu einem Zeitpunkt)

kumulierte Hazardrate:

steigt

40

nicht kumulierte Hazardrate:

Zeiten, in denen besonders viel Risiko herrscht, können besser/ schneller erkannt werden als

bei der kumulierten

Risiko zu Beginn recht hoch

dann sinkt sie und irgendwo ab Woche 9 steigt sie schnell wieder nach oben

Beispiele

links: Hazard

rechts: survival

ML: median-lifetime

Kokain: je länger man es geschafft hat, desto geringer das Risiko nach 7 ½ Wochen Rückfall

zu bekommen

Erste Mal: je älter, desto wahrscheinlicher, ab der 10. Klasse die Hälfte

Während Pubertät größte WSK, mit 14 hat jeder 2. schonmal daran gedacht

41

7

Sinkt erstmal, aber nach 6 Jahren Legislaturp. steigt es wieder, Hälfte bleibt etwa 3,5 im Amt

Medium-life-time allein anzuschauen ist schwierig

hier in beiden Beispielen ML=5, aber die Hazards sehen total unterschiedlich aus

Fazit zum rein Deskriptiven

immer Hazard-und Survivor- function anschauen

Median-Lifetime kann spannende Information sein, alleine recht informationsarm

42

Zwei Gruppen nach Kaplan-Meier verglichen bewerten können, ob die sich sign.

unterschieden!

Wie kann man nun 2 Gruppenverläufe vergleichen?

wenn sich die beiden Gruppenverläufe grafisch kreuzen, ist kein Vergleich möglich!!!

Gruppe {0=nicht infiziert ; 1=infiziert}

Mittlere geschätzte Zeit bis Event eintritt

Geschätzter Median bis Event eintritt, bei Gruppe 0 kein Wert, weil Wert nie auf <50% fällt,

keine medium-life-time

Die sign. zu unseren drei Tests: Die Gruppen unterscheiden sich nicht sign.

Wären die p-Werte signifikant, würden sich die Gruppen unterscheiden!

Cox-Regression

Überlebenszeitanalyse mit intervallskalierten Kovariaten

ähnlich wie Regression

Modellgleichung:

Hazard zu einem Zeitpunkt h(t) ergibt sich aus einer Art „Grundhazard“ h0(t), wie er für jede

Person zu diesem Zeitpunkt wäre, wenn diese Person auf allen Kovariaten den Wert 0 hat

mal einem Wert der sich als Linearkombination aus Prädiktorwerten und Gewichten (QuasiRegressionsgewichte) ergibt

Wenn Gewicht b1 1,031: Personen mit Toxoplasmose haben eine höhere Chance, dass das

Event innerhalb eines Zeitintervalls eintritt

Nehmen wir davon exp()=Odds, erhalten wir das Risikoverhältnis: Risiko für eine Person mit

Toxoplasmose ist 2,804 mal so hoch ist wie bei einer Person ohne! Der Effekt ist signifikant!

43

Interaktion:

Effekt von Katzenbegegnungen wird dadurch moderiert, ob man mit Supertoxoplasmose

infiziert ist oder nicht

Ist man es (Supertoxoplasmose =1), dann beträgt das b für Anzahl Katzen ca. 0,064

(= (- ,693) + 0,757) bzw. als exp(b) beträgt es ca. 1,07 (2.131x0.5)

Pro Katze, die einem Menschen mit Supertoxoplasmose begegnet, steigt das Risiko mal 1,07.

Für Menschen ohne Supertoxoplasmose stellen Katzen hingegen sogar einen Schutzfaktor

dar. Für jede Katze, die einem Menschen ohne Supertoxoplasmose begegnet, wird das Risiko

mal 0,5 genommen.

exp der Interaktion ist nicht direkt interpretierbar, umrechnen (siehe oben)

Output Cox-Regression mit maximal 2 Variablen und einer Moderation (auf jeden Fall wird

der Moderator dichotom sein) auf Sign. des Gesamtmodells überprüfen & Koeffizienten

interpretieren

44

Coxregression – Fazit

Event-Daten/Überlebensdaten analysieren und dabei auch mehrere

intervallskalierte oder dichotome Kovariaten aufzunehmen

auch möglich Interaktionen/Moderationen mit ins Modell aufzunehmen

Schätzung der Gewichte erfolgt mittels Maximum-Liklihood

Modelltest erfolgt durch einen Vergleich der Loglikelihood des Nullmodells und des

spezifizierten Modells

nimmt an, dass die Stärke des Einflusses einer Kovariate über die Zeit konstant ist

Hab ich 1 Pkt. mehr auf einem Risikofaktor und beim Exp(b) wurde dafür mit 2

geschätzt, dann ist man Risiko zu jedem Zeitpunkt doppelt so hoch wie für jemanden

der 0 Pkt. auf dem Risikofaktor hat!

Modelle mit dieser Annahme gehören zur Klasse der „proportionalhazards models“

kann schwanken wie sie will, da sie kein Verteilungsannahmen bzgl. des Hazards

hat

Kurven dürfen sich auch kreuzen, was sie bei Kaplan-Meier nicht dürfen

wird häufig zu den semiparametrischen Verfahren gezählt, da die h0(t) jede Form

annehmen kann, die Kovariaten aber immer als Linearkombination ins Modell

einfließen. Die Cox-Regression verliert dadurch etwas an Genauigkeit, gewinnt aber

an Robustheit gegenüber voll-parametrischen Verfahren!

Vorlesung 10

LCA – Latent-Class-Analyse

probabilistisches latentes Klassenmodell

querschnittliches Verfahren

Ziele der LCA/ Fragen, die LCA beantworten sollte:

• Aufdeckung von latenten Typen: Wie viele Klassen gibt es?

• Bestimmung typischer Antwortmuster (Patterns)

• Klassifikation von Personen: Welche Person gehört zu welcher Klasse? Wie groß sind die

Klassen?

• Bestimmung der Wahrscheinlichkeit einer bestimmten Antwort: Wie groß ist die

Lösungswahrscheinlichkeit für ein Item (bei bekannter Klassenzugehörigkeit)?

LCA vs. Faktorenanalyse

45

Was sind Patterns?

Antwortmuster

z.B. Gibt es unterschiedliche Persönlichkeitstypen?

Kennzeichnung der Persönlichkeitstypen über ihr Antwortmuster (Pattern)

Etwa: Choleriker sollen möglichst den ersten beiden Items zustimmen, und die anderen

möglichst ablehnen

Es gibt aber auch immer Personen, die nicht in diese typischen Klassifizierungen passen ->

Modell, das mit Wahrscheinlichkeiten arbeitet (probabilistisches Modell)

z.B. Choleriker haben hohe Wahrscheinlichkeiten, den ersten beiden Items zuzustimmen und

geringe Wahrscheinlichkeiten, den anderen Items zuzustimmen

Was sind die 4 Annahmen der LCA? anwenden können

1. Die Lösungswahrscheinlichkeit eines Items ist konstant für alle Mitglieder einer Klasse

2. Jede Person gehört genau einer Klasse an, d.h. alle Personen werden klassifiziert

(exhaustiv) und dabei nur einer einzigen Klasse zugeordnet (disjunkt)

3. Alle Items messen dieselbe typologische Eigenschaft

messe also nur Choleriker, Phlegmatiker und nicht noch was anderes

4. Lokale stochastische Unabhängigkeit (alle Gemeinsamkeiten der Items sind durch die

Klassenvariable aufgeklärt)

Was für Daten muss ich vorliegen haben, damit ich eine LCA rechnen kann, was muss ich

bei der Analyse selber vorgeben?

dichotome Variablen/Items

auch mehrkategoriale Items oder ordinale Restriktionen annehmen

Für Items, die den Prinzipien einer Likertskala genügen, gibt es nochmal eigene

Restriktionen.

Vorgeben muss ich die Anzahl der latenten Klassen.

Wie finde ich die Anzahl an latenten Klassen in meinen Daten heraus?

muss vorgegeben werden:

entweder theoriegeleitet oder es werden verschiedene Lösungen ausprobiert

Die einzelnen WSK sollen so geschätzt werden, dass die beobachteten Patterns

bestmöglich erklärt werden. Dies kann i.d.R. nur iterativ gelöst werden

Wie interpretiere ich meine Klassenlösung?

WSK angucken

46

Modellvergleich

Modelle, die sich in der Klassenzahl unterscheiden, werden in Bezug auf AIC oder BIC

Verglichen

-> Kleinerer Wert zeigt bessere Modellanpassung an

Welches Modell nehme ich jetzt?

- Nach AIC / BIC schauen, welches am besten auf die Daten passt.

- Inhaltlich schauen, welche Klassenlösungen am plausibelsten erscheinen.

- Mischung aus beidem: Grob Modelle nach AIC/BIC vergleichen, bei kleinen Unterschieden

schauen, welche Lösung inhaltlich plausibler ist.

47