2 = i - Lectures

Werbung

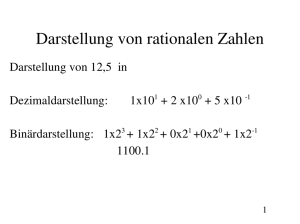

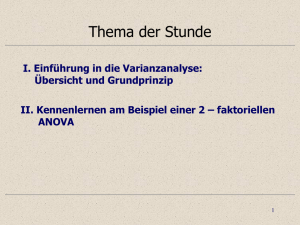

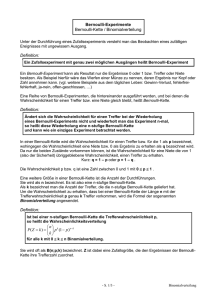

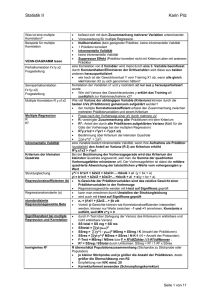

Vorlesung: ANOVA I 11.11.2003 ANOVA = Analysis of Variances • ANOVA ist eine statistische Analysemethode, um Haupteffekte und Interaktionseffekte zwischen kategorisch unabhängigen Variablen bzgl. einer abhängigen Variablen aufzudecken • Haupteffekt: Messvariable • Interaktionseffekt: gemeinsame Effekte von 2 oder mehr Variablen auf eine abhängige Variable (die Messvariable) • Messung: Cholesterin • bekannt: Rauchen (Ja,Nein); Gewicht/Größe (dick,dünn); Alter (alt,jung) • Fragen: Welche der bekannten Variablen haben einen Einfluß ? • Ist der Einfluß signifikant ? • Ist ev. die Interaktion von zwei Variablen signifikant ? Array 1 Patient: Kontrolle: Array 2 Grün Rot Patient: Kontrolle: ARRAY 1 oder 2 ? Variety: Patient oder Kontrolle ? Intensität: 14527 Farbstoff: Grün oder Rot ? Welches Gen ? Rot Grün Variety Array Dye= Farbstoff Gen Array-Variety Array-Gen Array-Dye Variety-Gen Variety-Dye Dye-Gen Varianten der ANOVA (1) ANCOVA (Analysis of Covariances) Kontinuierliche Variablen statt diskrete; diese werden “Covariates” genannt. (2) MANOVA (Multiple Analysis of Variances) Mehrere abhängige Variablen: zB: Auswirkung der Benutzung verschiedener Lehrbücher auf die Klausurergebnisse in Mathematik UND Physik (3) MANCOVA (Multiple Analysis of Covariances) Mehrere abhängige Variablen, aber die Covarianten sind kontinuierlich ANOVA Statistik F Test für Differenzen der Gruppen Mittelwerte. Test, ob der Mittelwert der Gruppen, die durch die Werte der unabhängigen Variablen oder deren Kombinationen unterschiedlich genug sind, um nicht durch Zufall aufgetreten zu sein. Der ANOVA F Test ist eine Funktion der Varianz einer Gruppe von Mittelwerten, Gesamtmittelwert aller Beobachtungen und der Varianzen der Beobachtungen in jeder Gruppe gewichtet bzgl. einer Gruppenmengengröße. Falls der Gruppenmittelwert sich nicht signifikant unterscheidet, dann heißt dies, daß die unabhängige Variable(n) keine Effekt auf die abhängige hat/haben. Wenn der F Test eine Abhängigkeit mit der abhängigen Variablen anzeigt, dann wird ein multipler Vergleichstest auf Signifikanz angewendet, um zu sehen, welche Gruppen den größten Einfluß auf die Beziehung haben. Was hat das Testen auf Mittelwertdifferenzen mit Varianzen zu tun ? Im Mittelpunkt der ANOVA steht die Tatsache, daß man Varianzen partitionieren kann. Die Varianz ist die Summe der quadrierten Abweichungen vom Mittelwert dividiert durch die Anzahl der Proben minus 1. 1 n 2 (Xi X ) n 1 i 1 Damit ist die Varianz eine Funktion der Summe der quadrierten Standardabweichungen (SQ). Wie werden nun die Varianzen zerlegt ? Beispiel: Angenommen, wir haben folgenden Datensatz Beobachtungen: • Die Mittelwerte der beiden Gruppen sind sehr unterschiedlich • Die Summe der Quadrate ist in beiden Gruppen = 4 Gruppe1 Gruppe2 Beob.1 2 6 Beob.2 3 7 Beob.3 1 5 Mittelwert 2 6 SQ 4 4 Gesamtmittel 4 GesamtSQ 28 • Insgesamt ist die Summe der Quadrate (unter Vernachlässigung der Gruppenzugehörigkeiten) = 28 • Die Varianzen innerhalb der Gruppen ist wesentlich kleiner als die Gesamtvariabilität. • Der Grund hierfür liegt darin, daß die Mittelwerte sehr unterschiedlich sind. Gruppe1 Gruppe2 Beob.1 2 6 Beob.2 3 7 Beob.3 1 5 Gesamtvariabilität - Gruppenvariabilität Mittelwert 2 6 = = SQ 4 4 28 20 SQ Effekt - (4+4) Gesamtmittel 4 GesamtSQ 28 Unter der Nullhypothese sollte die Varianz innerhalb der Gruppen ungefähr so groß sein wie die zwischen den Gruppen. Wir können diese Schätzer der Varianz mittels F Test vergleichen. Dieser Test überprüft, ob der Quotient der beiden Varianz Schätzer signifikant größer als 1 ist. Hier F=20 => signifikant, p<0.05 (Ausgabe in R: p=0.04761905) dh. wir können schließen, dass die zwei Gruppen signifikant unterschiedlich sind. Wie kommen wir nun zu dieser Statistik ? F Statistik Definitionen und Grundbegriffe: • Gamma Funktion •Verteilungsfunktion, Dichte • Erwartungswert, Standardabweichung und Varianz • stochastische Unabhängigkeit • F Verteilung •p Wert Gamma Funktion Definition Zunächst gilt: (n)=(n-1)! Dies gilt aber nur für natürliche Zahlen. ( x) t x 1et dt 0 x (0, ) Insbesondere gilt ( x 1) x( x) Gaußsche Definition und n !n ( x) lim ( x 1)...( (n x1) nx!, n) , nx Z x x - Verteilungsfunktion, Dichte Diskrete Zufallsvariable Bei diskreten Zufallsvariablen läßt sich jedem möglichen Ereignis genau eine bestimmte Eintrittswahrscheinlichkeit zuordnen. Beispiel: Eine Münze wird dreimal geworfen. Wie groß ist die Wahrscheinlichkeit dafür, daß xi-mal das Wappen oben liegt? Summe: 1.Wurf Ja Nein Die Zuordnung der Wahrscheinlichkeiten P(xi) zu den möglichen Ereignissen xi erfolgt über die sogenannte Wahrscheinlichkeitsfunktion fX. 2.Wurf P(xi)= fX(xi) 3.Wurf 3xJa 0.53 = 0.125 P(x1)+P(x2)+P(x3)+P(x4) = 0.125+0.375+0.375+0.125 =1 Es gilt: 2xJa,1xNein 3*0.53 = 0.375 2xNein,1xJa 3*0.53 = 0.375 3xNein 0.53 = 0.125 0 fX(xi) 1 und fX(xi) =1 Verteilungsfunktion, Dichte Stetige Zufallsvariable Eine stetige Zufallsvariable weißt ein völlig anderes Verhalten auf. Da es unendlich viele mögliche Ausprägungen gibt, ist die Wahrscheinlichkeit dafür, daß genau ein bestimmtes Ereignis eintritt, gleich Null. Dies bedeutet aber nicht, daß dieses Ereignis unmöglich wäre. Anstelle von Wahrscheinlichkeiten werden bei stetigen Zufallsvariablen Dichten angegeben und zwar in Form der sogenannten Dichtefunktion fX. • Die Dichte kann nicht negativ werden; kann aber Werte >1 annehmen. fX(x) >= 0 • Das bestimmte Integral von – bis + beträgt Eins. + fX(x) dx = 1 – Verteilungsfunktion, Dichte Für viele Fragestellungen ist es von Relevanz, wie groß die Wahrscheinlichkeit dafür ist, daß eine Zufallsvariable X einen bestimmten Wert x nicht überschreitet. Gesucht ist also: P(X x) bzw P(– <X x) Eine Funktion, die diese Wahrscheinlichkeit für jeden Wert x in R angibt, wird Verteilungsfunktion genannt und mit FX(x) bezeichnet. Diskreter Fall FX(x) = xi x fX(xi) • FX ist monoton steigend Stetiger Fall FX(x) = –x fX(t)dt • FX ist monoton steigend • FX ist stetig • lim x-> – FX (x) = 0 • lim x-> + FX (x) = 1 Funktion, die von – kommend bei 0 beginnt und treppenförmig bis 1 ansteigt und dort bis + bleibt • lim x-> – FX (x) = 0 • lim x-> + FX (x) = 1 Es gilt: P(a<x<b)= ab fX(x)dx = FX(b)- FX(a) Erwartungswert, Standardabweichung und Varianz Der Erwartungswert einer Wahrscheinlichkeitsverteilung entspricht dem arithmetischen Mittel in der deskriptiven Statistik. Diskreter Fall: E(X) = i xi fX(xi) Stetiger Fall: + E(X) = xfX(x) dx – Die Varianz bzw. die Standardabweichung ist folgendermaßen definiert: Diskreter Fall: Varianz(X) = Var(X) = 2 = i (xi-E(X))2 fX(xi) = i (xi2 fX(xi) ) – (E(X))2 Stetiger Fall: Varianz(X) = Var(X) = 2 = + + (x-E(X))2 fX(x) dx = x2 fX(x) dx –(E(X))2 – – Sowohl für den diskreten wie stetigen Fall gilt: Die Standardabweichung ist definiert durch: X = +Var(X) Stochastische Unabhängigkeit Bedingte Wahrscheinlichkeit für zwei Ereignisse A und B PB(A) := P(A|B):= P(A B) /P(B) Multiplikationssatz P(A B) = P(A|B)P(B) = P(B|A)P(A) Stochastische Unabhängigkeit Zwei Ereignisse A, B mit der Eigenschaft P(A B) = P(A)P(B) heißen stochastisch unabhängig. Wie groß ist die Wahrscheinlichkeit, daß A eintreten wird, vorausgesetzt, daß B bereits eingetreten ist? F-Verteilung (1) Ist X eine standard-normalverteilte Variable (N(0,1)), so wird die Verteilung der Variable X2 ChiQuadrat Verteilung mit einem Freiheitsgrad genannt. (2) Sind X1, ... ,Xn unabhängige ChiQuadrat verteilte Variablen mit 1 Freiheitsgrad, so wird die Verteilung von Y = i Xi 2 Verteilung mit n Freiheitsgraden genannt: 2 n Die Dichte ist gegeben durch: f(y) = 1/ [2n/2 (n/2)] * y n/2-1 exp(-y/2) y>=0 E(Y) = n Var(Y) = 2n F-Verteilung (3) Sind X, Y zwei unabhängige ChiQuadrat verteilte Variablen mit m und n Freiheitsgraden, so wird die Verteilung von Z = X/m / Y/n F Verteilung mit m,n Freiheitsgraden genannt: F m,n Die Dichte ist gegeben durch: f(z) = [(m+n)/2 ]/ [(m/2) (n/2)] * m/n m/2 z m/2-1 (1+m/n z) -(m+n)/2 E(Z) = n/(n-2) z>=0 n>=2 Var(Z) = 2n2(m+n-2)/[m(n-2)2(m-4)] n>=5 SATZ: Sind X,Y zwei unabhängige normalverteilte Variablen, so ist Var(X)/Var(Y) F-verteilt. P-Wert Die Wahrscheinlichkeitswert (probability value, p-value) eines statistischen Hypothesentests gibt die Wahrscheinlichkeit an, aus der Teststatistik zufällig einen Wert zu erhalten, der mindestens so extrem ist wie der beobachtete unter der Voraussetzung, daß die Nullhypothese H0 wahr ist. Er gibt die Wahrscheinlichkeit an, fälschlicherweise die Nullhypothese abzulehnen, obwohl sie eigentlich richtig ist. Der p-Wert wird mit dem Signifikanzlevel verglichen (meist 0.05). Ist er kleiner, erhalten wir ein signifikantes Ergebnis. Das heißt, falls die Nullhypothese mit einem Signifikanzlevel von 5% abgelehnt wird, so gilt: p<0,05. Beispiel: ANOVA Experiment: Wir messen die Konzentration eines Proteins nach Behandlung von Zellen mit vier verschiedenen Lösungen Messung 1 2 3 4 5 6 7 8 Behandlung A 62 60 63 59 nd nd nd nd B 63 67 71 64 65 66 nd nd C 68 66 71 67 68 68 nd nd D 56 62 60 61 63 64 63 59 Beispiel: ANOVA A B C D Min: 59.0000 63.0000 66.0000 56.0000 1st Qu.: 59.7500 64.2500 67.2500 59.7500 Mean: 61.0000 66.0000 68.0000 61.0000 Median: 61.0000 65.5000 68.0000 61.5000 3rd Qu.: 62.2500 66.7500 68.0000 63.0000 Max: 63.0000 71.0000 71.0000 64.0000 Total N: 8.0000 8.0000 8.0000 8.0000 NA's : 4.0000 2.0000 2.0000 0.0000 Variance: 3.3333 8.0000 2.8000 6.8571 Std Dev.: 1.8257 2.8284 1.6733 2.6186 Sum: 244.0000 396.0000 408.0000 488.0000 Sind die Differenzen in den Mittelwerten/Medianen der Meßwerte der unterschiedlichen Behandlungsmethoden signifikant oder sind sie zufällig? Beispiel: ANOVA V= 62 60 63 59 63 67 71 64 65 66 68 66 71 67 68 68 56 62 60 61 63 64 Summe/Anzahl 64 + 63 59 -2 -4 -1 -5 -1 3 7 0 1 2 4 2 7 3 4 4 -8 -2 -4 -3 -1 0 -1 Können wir dies in eine Behandlungsspezifischen und Residuen-Effekt zerlegen? -5 Beispiel: ANOVA V = Gesamtmittelwert + [ Behandlungsmittelwert-Gesamtmittelwert ] + [ Datenpunkt-Behandlungsmittelwert ] + 64 yi – y + yij – yi 61 66 68 61 Beispiel: ANOVA V = 64 + -3 -3 -3 -3 2 2 2 2 2 2 4 4 4 4 4 4 -3 -3 -3 -3 -3 -3 + -3 -3 1 -1 2 -2 -3 1 5 -2 -1 0 0 -2 3 -1 0 0 -5 1 -1 0 2 3 2 -2 ANOVA Zunächst soll die Varianzanalyse und der F-Test im Falle von: I Proben je der Länge J dargestellt werden, d.h. ein Experiment mit I Behandlungen, jede J mal gemessen. Den Fall, den wir eben betrachtet haben, bei dem unterschiedlich häufig gemessen wurde, betrachten wir danach. Messung 1 Behandlung 1 2 3 ... I 2 … 3 ... J ANOVA Das zugrundeliegende Modell ist das folgende: Yij = j-te Beobachtung in der i-ten Behandlung Jede einzelne Beobachtung wird gestört durch einen möglichen zufälligen Fehler. Außerdem nimmt man an, daß der Fehler der einen Beobachtung unabhängig von demjenigen einer anderen Beobachtung. Yij = + i + ij Zufälliger Fehler in der j-ten Beobachtung und i-ten Behandlung Gesamtmittelwert „differentieller Effekt“ in der i-ten Behandlung Die Fehler werden als unabhängig angenommen und sind normalverteilt mit Erwartungswert 0 und Varianz 2 Außerdem sind die i normalisiert, d.h.: i i = 0 Der Erwartungswert der i-ten Behandlung und j-ten Messung beträgt: E(Yij) = + i ANOVA Die Varianzanalyse basiert auf der folgenden Identität: i j (Yij – Y..)2 = i j (Yij – Yi.)2 + J i (Yi – Y..)2 wobei Yi. = 1/J j Yij das Mittel der Beobachtungen in der i-ten Behandlung beschreibt und Y.. = 1/IJ i,j Yij das Gesamtmittel. Summe der Quadrate SQgesamt SQinnerhalb SQzwischen ANOVA Lemma: Seien X1,...,Xn unabhängige Zufallsvariablen mit Erwartungswerten E(Xi) = i und Varianz Var(Xi) = 2. Dann gilt: E(Xi – X)2 = (i –1/n i i )2 + (n-1)/n 2 Mittels dieses Lemmas läßt sich folgender Satz zeigen: Satz1: E(SQinnerhalb) = i j E(Yij – Yi.)2 = i j J-1/J 2 = I(J-1) 2 E(SQzwischen) = J j E(Yi. – Y..)2 = J j [i2 + (I-1)/IJ 2 ] = J j [i2 + (I-1) 2 ] Ein Schätzer für die Varianz ist gegeben durch: SQinnerhalb/I(J-1) ANOVA Satz2: Wenn alle Fehler unabhängig normalverteilt sind mit Erwartungswert 0 und Varianz 2, dann gilt: SQinnerhalb/2 folgt einer 2 Verteilung mit I/(J-1) Freiheitsgraden. Sind außerdem alle i Null, dann folgt auch SQzwischen/2 einer 2 Verteilung mit (I-1) Freiheitsgraden und ist unabhängig von SQinnerhalb. Die Statistik F = SQzwischen/(I-1) / SQinnerhalb/[I(J-1)] wird benutzt, um die Nullhypothese: H0: 1 = 2 = 3 =... = i =0 zu testen. Wenn die Nullhypothese richtig ist, so sollte die F-Statistik nahe bei 1 liegen. Ist sie hingegen falsch, sollte die Statistik zu Werten größer 1 tendieren, da die Erwartung des Zählers anwächst. ANOVA Nun zu dem Problem, daß nicht jede Meßreihe gleich lang sein muß, d.h. es könnte sein – wie in unserem Eingangsbeispiel – daß für jede Behandlung unterschiedlich viele Messungen durchgeführt wurden. Das bedeutet: J hängt von der i-ten Behandlung ab: Ji Dann gilt: i j(i) (Yij – Y..)2 = i j(i) (Yij – Yi.)2 + J(i) i (Yi – Y..)2 E(SQinnerhalb) = 2 j J(i)-1 E(SQinnerhalb) = I(J-1) 2 E(SQzwischen) = (I-1) 2 + j J(i) i2 E(SQzwischen) = J j [i2 + (I-1) 2 ] Die Freiheitsgrade für die Quadratsummen betragen: i J(i)-I und I-1 Zurück zu unserem Beispiel: Messung 1 2 3 4 5 6 7 8 Behandlung A 62 60 63 59 nd nd nd nd B 63 67 71 64 65 66 nd nd C 68 66 71 67 68 68 nd nd D 56 62 60 61 63 64 63 59 Zurück zu unserem Beispiel: i j(i) (Yij – Y..)2 = i j(i) (Yij – Yi.)2 + i J(i) (Yi – Y..)2 SQinnerhalb Summe der Quadrate SQgesamt SQzwischen F = SQzwischen/(I-1) / SQinnerhalb/ i J(i)-I Zurück zu unserem Beispiel: Mittel=64 J(i)=[4 6 6 8] Yi. =[61 66 68 61] SQinnerhalb=112 SQzwischen=228 Freiheitsgrade: 3; 20 Variationsquelle SQ Freiheitsgrade Zwischen 228 3 Behandlung innerhalb F 76/56=13.6 112 20 SQ Total 340 n-1 23 Zurück zu unserem Beispiel: Falls H0 (alle Mittel in allen Behandlungen sind gleich) richtig sein sollte, müßte F einer F 3;20 Verteilung folgen. Andernfalls, müßte F größer sein, also lehnen wir H0 bei hinreichend großem F ab. Also müssen wir testen: P(F 3;20 > F beobachtet) = P(F 3;20 > 13.6) In R: > pf(13.6,3,20,lower.tail=F) [1] 4.654599e-5