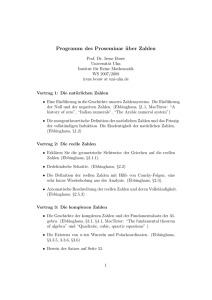

Vortrag Gedächtnis - Allgemeine Psychologie I - Christian

Werbung

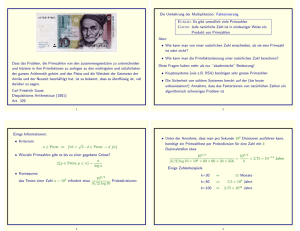

Memory is a mud trap Über den Verlauf des Vergessens Christian Kaernbach Christian-AlbrechtsUniversität zu Kiel Wie zerfallen Gedächtnisinhalte? • Zerfall oder Interferenz? – Untrennbar miteinander verbunden: Es gibt keine Retentionsdauer, in der keine Interferenz stattfände, und sei es durch interne Zustände. – Ob man Zerfall oder Interferenz mißt, hängt von der eingesetzten Methode ab. – Im folgenden wird nur betrachtet der Zerfall als Funktion der Zeit. Wie zerfällt Uran? • Radioaktiver Zerfall ... Ausschwingen einer Gitarrensaite Bremsvorgänge in Flüssigkeit oder Gas allgemein: Relaxation in linearen Systemen ... verläuft exponentiell x(t ) x0e t • generiert durch „negative Verzinsung“ d – Pro Zeiteinheit zerfällt x(t ) x(t ) ein gleicher Prozentsatz. dt Ebbinghaus 60 Ersparnis [%] 50 40 30 20 10 0 0 5 10 15 20 25 Retentionsintervall [Tage] Ebbinghaus, H. (1885). Über das Gedächtnis. Untersuchungen zur experimentellen Psychologie. Leipzig: Duncker & Humblot. 30 100 k x(t ) (log 10 t ) c k Ebbinghaus 60 Woodworth & Schlosberg (1954): Ersparnis [%] 50 40 x(t ) d a log t 30 20 Anderson (1983): 10 x(t ) x0t 0 0 5 10 15 20 25 Retentionsintervall [Tage] Ebbinghaus, H. (1885). Über das Gedächtnis. Untersuchungen zur experimentellen Psychologie. Leipzig: Duncker & Humblot. 30 100 k x(t ) (log 10 t ) c k Ebbinghaus 100 log10 (Ersparnis [%]) Woodworth & Schlosberg (1954): x(t ) d a log t Anderson (1983): x(t ) x0t 10 10 100 1000 10000 log10 (Retentionsintervall [Minuten]) Ebbinghaus, H. (1885). Über das Gedächtnis. Untersuchungen zur experimentellen Psychologie. Leipzig: Duncker & Humblot. 100000 100 k x(t ) (log 10 t ) c k Ebbinghaus 100 log10 (Ersparnis [%]) Woodworth & Schlosberg (1954): x(t ) d a log t Anderson (1983): x(t ) x0t 10 10 100 1000 10000 log10 (Retentionsintervall [Minuten]) Ebbinghaus, H. (1885). Über das Gedächtnis. Untersuchungen zur experimentellen Psychologie. Leipzig: Duncker & Humblot. 100000 100 k x(t ) (log 10 t ) c k Ebbinghaus 100 log10 (Ersparnis [%]) Woodworth & Schlosberg (1954): x(t ) d a log t Anderson (1983): x(t ) x0t 10 10 100 1000 10000 log10 (Retentionsintervall [Minuten]) Ebbinghaus, H. (1885). Über das Gedächtnis. Untersuchungen zur experimentellen Psychologie. Leipzig: Duncker & Humblot. 100000 Kurvenanpassung • Rubin, D.C. & Wenzel, A.E. (1996) One hundred years of forgetting: a quantitative description of retention. Psychol. Rev. 103, 734-760. – 210 Datensätze – 105 zweiparametrige Formeln (theoriefrei) – kein Sieger Gültigkeit des „Potenzgesetzes“ • Material – Sinnlose Silben, Wörter – Alltagswissen – Fertigkeiten • Explizites und implizites Gedächtnis • Lernen und Vergessen • Zeitbereiche – Wixted & Ebbesen (1991): 2.5-40 s – Squire (1989): 1 - 15 Jahre • Spezies – Menschen – Hunde, Ratten, Katzen, ... – Bienen Gültigkeit des „Potenzgesetzes“ • Material – Sinnlose Silben, Wörter – Alltagswissen – Fertigkeiten • Explizites und implizites Gedächtnis • Lernen und Vergessen • Zeitbereiche Baddeley, A. (1997) – Wixted & Ebbesen (1991): 2.5-40 s – Squire (1989): 1 - 15 Jahre • Spezies – Menschen – Hunde, Ratten, Katzen, ... – Bienen Human memory: Theory and practice. Hove: Psychology Press. “We know surprisingly little about this most fundamental aspect of human memory.” Gedächtnismodelle • Jede Spur ist ein getrennter Knoten im Netzwerk. – Suche unter parallel aktivierten Spuren • SAM (Raaijmakers & Shiffrin, 1980) – Aktivierungsausbreitung zwischen den Spuren • ACT (Anderson, 1983) • Die Spur ist auf alle beteiligten Knoten verteilt. Parallel Distributed Processing (Rumelhart McClelland 1986) – Hopfield Netz (Hopfield & Tank, 1986) Das Hopfield-Netz • N Neurone, symmetrisch all-to-all verbunden. cj wij Zustand des Neurons j Gewicht der Synapse zwischen Neuron j und Neuron i • internes Potential = Summe der Aktivität Synapsengewichte. N Vi (t ) wij c j (t 1) j 1 1 p(ci feuert ) 1 e Vi / kT k 1 p(Feuern) • Feuern probabilistisch. internes Potential Hebbsches Lernen • wij wird vergrößert, „wenn es mit den Geschehnissen kompatibel ist“. cj(t1) = +1, ci(t) = +1, oder cj(t1) = –1, ci(t) = –1. • wij wird verkleinert, „wenn es mit den Geschehnissen inkompatibel ist“. cj(t1) = +1, ci(t) = –1, oder cj(t1) = –1, ci(t) = +1. • Größe der Veränderung: Lernrate h wii 0 wij 1 Vergessen im Hopfield-Netz • Start mit Idealgewichten für zu erinnerndes Muster. • Hebbsches Lernen bei hoher Temperatur bewirkt allmähliches Vergessen. x(t ) x0e t ln x(t ) ln x0 t Diffusion mit Hindernissen x E d x x dt e E / kT x(t ) x0e t Systematisch durchvariieren: Neuronenzahl N = 8, 16, 32, 64 Temperatur T = 0.1...0.5 Lernrate h = 0.1...0.4 Mit steigendem h sinkt E: E 0.58 h0.6 ln x(t ) ln x0 t E kT ln Diffusion mit Hindernissen x d x x dt E e E / kT x(t ) x0e t Nicht-exponentielle Diffusion E Häufigkeit E x d x x dt 0,1 x(t ) x0 ML ((t ) ) Mittag-Leffler-Funktion • Beispiel für = 0.5: Spur log (Spur) Anwendbarkeit in der Gedächtnispsychologie? Zeit ? log (Zeit) • ML-Funktionen passen zu den Gedächtnis-Daten. • ML-Funktionen haben keine Singularität bei t = 0. • Es gibt eine erzeugende Differentialgleichung, die von einem mikromechanischen Modell motiviert ist. Fallen verschiedener Tiefe • Einwand: Im Hopfieldnetz liegen bei konstantem h Fallen gleicher Tiefe vor. • Bei einer Exponentialverteilung der Fallentiefe ergibt sich eine Wartezeitverteilung mit nicht-finitem Mittelwert: t : W (t ) 1 t 1 , 0,1 E Dynamische Fallen • In der Neuroinformatik üblich: T oder h mit der Zeit verkleinern. – simulated annealing: T nimmt ab. – Kohonen-Karten: h nimmt ab. • äquivalent: E vergrößern. – setzt globalen Effektor voraus (Hormon?) – festes Zeitschema • inadäquat für kontinuierlichen Input E E e Et1 / kT e Et / kT Dynamische Fallen • In der Neuroinformatik üblich: T oder h mit der Zeit verkleinern. Wartezeitverteilung mit nicht-finitem Mittelwert: W (t ) 1 t 1 mud trap – simulated annealing: T nimmt ab. – Kohonen-Karten: h nimmt ab. • äquivalent: E vergrößern. – setzt globalen Effektor voraus (Hormon?) – festes Zeitschema • inadäquat für kontinuierlichen Input • alternativer Ansatz: „adaptive Fallen“ Je länger ein item in einer Falle ist, desto tiefer wird sie. E Hopfield mit dynamischen Fallen • Bei unverändertem Muster sinkt die Temperatur: e1/ Tt 1 e1/ Tt • Wenn sich das Muster ändert, wird die Temperatur wieder hochgesetzt. Hopfield mit dynamischen Fallen 0.6 0.6 • Bei unverändertem Muster sinkt die Lernrate: eh t1 eh t • Wenn sich das Muster ändert, wird die Lernrate wieder hochgesetzt. Steuerung pro Neuron • Bei unverändertem Einzelverhalten des Neurons sinkt dessen Temperatur. • Wenn sich das Einzelverhalten ändert, wird die Temperatur wieder hochgesetzt. Lernen im Hopfield-Netz • • Start mit zufälligen Gewichten. Hebbsches Lernen bei verrauschtem Muster. Bei unverändertem Muster sinkt die Lernrate. Wenn sich das Muster ändert, wird sie wieder hochgesetzt. set effect „Potenzgesetz“ des Lernens Bringt die mudtrap einen Vorteil? • Hebbsches Lernen bei verrauschtem Muster bewirkt allmähliches Lernen. • Ab Zeitschritt 1000 wird unkorreliertes Rauschen eingesetzt: Vergessen. mit mudtrap ohne mudtrap Das Jostsche Gesetz • Sind zwei Spuren jetzt unter einer bestimmten Operationalisierung gleich stark, dann wird später diejenige stärker sein, die früher gesetzt wurde. Jost, A. (1897). Die Assoziationsfestigkeit in ihrer Abhängigkeit von der Verteilung der Wiederholungen. Zeitschrift für Psychologie und Physiologie der Sinnesorgane, 14, 436-472. Das Netzwerk Igor Sokolov Sverker Sikström Sokolov, I., Klafter, J., Blumen, A. (2002). Fractional Kinetics. Physics Today 55, 48-54. – fraktale Kinetik Sikström, S. (2002). Forgetting curves: implications for connectionist models. Cognitive Psychology 45, 95–152. – verteilte Lerngeschwindigkeiten – primacy, recency-Effekte Fazit learn and Memory is the thing you forget with. Alexander Chase, Perspectives (1966) • Das Lernen und Vergessen in einem Hopfield-Netz mit verteilten oder adaptiven Fallen wird durch eine fraktale Differentialgleichung beschrieben und verläuft wie eine Mittag-Leffler-Funktion. – Wichtig ist nicht die genaue Implementierung. • Wird menschliches Lernen/Vergessen durch eine fraktale DG beschrieben? Es könnte schon so sein... – Die Daten werden zwar nicht besser beschrieben, aber der Verlauf wird zum ersten Mal von theoretischen Modellvorstellungen abgeleitet. – „Potenzgesetz“ zum x-ten Mal bestätigen: wenig hilfreich – Abweichungen vom „Potenzgesetz“ finden Vorhersage: für kleine t (Wixted & Ebbesen, 1991: 2.5 - 40 s) Test: sensorisches Gedächtnis log (Spur) • Experimentelle Überprüfung log (Zeit) Ausblick • Lebensdauer des auditiv sensorischen Gedächtnisses Inhalt 1. Intervall 2. Intervall log (Spur) SOA Inhalt log (Zeit)