Seminar Quantitatives Risikomanagement

Werbung

Seminar Quantitatives

Risikomanagement

Multivariate Modelle II

Toni Bastgen

Mathematisches Institut

der

Universität zu Köln

Sommersemester 2008

Betreuung: Prof. Schmidli, J. Eisenberg

Inhaltsverzeichnis

3

4

Sphärische und Elliptische Verteilungen . . . . . . . . . . . .

2

3.1

Sphärische Verteilungen . . . . . . . . . . . . . . . . .

2

3.2

Elliptische Verteilungen . . . . . . . . . . . . . . . . .

4

3.3

Eigenschaften elliptischer Verteilungen . . . . . . . . .

6

3.4

Verteilungs- und Korrelationsschätzer . . . . . . . . .

7

3.5

Testen Elliptischer Symmetrie . . . . . . . . . . . . . .

8

Dimensionsreduzierungstechniken . . . . . . . . . . . . . . . .

10

4.1

Faktor-Modelle . . . . . . . . . . . . . . . . . . . . . .

10

4.2

Regressionsanalyse von Faktormodellen . . . . . . . .

11

1

2

3.3

3.3.1

Sphärische und Elliptische Verteilungen

Sphärische Verteilungen

Definition 3.18

Ein Zufallsvektor X = (X1 , . . . , Xd )T hat eine sphärische Verteilung wenn

für jede orthogonale Abbildung U ∈ Rd×d

d

UX = X .

Somit sind sphärische Verteilungen drehinvariant.

Auch die folgenden Eigenschaften sind als Def. üblich.

Theorem 3.19

Es sind äquivalent:

(1) X ist sphärisch

(2) Es gibt eine Funktion ψ mit einer skalaren Variablen, so dass für alle

t ∈ Rd gilt:

TX

φX (t) = E(eit

(3) ∀ a ∈ Rd :

) = ψ(tT × t) = ψ(t21 + . . . + t2d )

d

aT X = kakX1 .

Proof. (1) ⇒ (2): Ist X sphärisch, so gilt für jede orthogonale Matrix U

T UX

φX (t) = φU X (t) = E(eit

) = φX (U T t).

Also hängt φX (t) nur von der Länge von t ab ⇒ (2).

(2) ⇒ (3): Es gilt φX1 (t) = E(eitX1 ) = φX (te1 ) = ψ(t2 ).

Nun folgt für jedes a ∈ Rd

φaT X (t) = φX (ta) = ψ(t2 aT a) = ψ(t2 kak2 ) = φX1 (tkak) = φkakX1 (t).

(3) ⇒ (1): Für bel. orthogonale Matrix U gilt

φU X (t) = E(ei(U

T t)T X

) = E(eikU

T tkX

1

TX

) = E(eiktkX1 ) = E(eit

) = φX (t).

3

ψ heißt charakteristischer Generator und beschreibt einen sphärisch verteilten Zufallsvektor eindeutig.

Notation: X ∼ Sd (ψ)

Beispiel 3.20 (Multivariate Normalverteilung)

Ein Zufallsvektor X mit der Standardnormalverteilung Nd (0, Ia ) ist sphärisch.

1

) = exp(− tT t).

2

1

Es folgt X ∼ Sd (ψ) mit ψ(t) = exp(− 2 t)

TX

φX (t) = E(eit

Beispiel 3.21 (Mischverteilung)

Zufallsvektor X mit X ∼ Md (0, Id , Ĥ) (standardisierte, unkorrelierte Normal-

Varianz-Mischverteilung) ist sphärisch.

Tµ

φX (t) = eit

1

1

Ĥ( tT Σt) = Ĥ( tT t)

2

2

Also ist ψ(t) = Ĥ( 12 t), es gilt

1

X ∼ Md (0, Id , Ĥ(×)) ⇔ X ∼ Sd (Ĥ( ×)).

2

Theorem 3.22

X hat genau dann eine sphärische Verteilung, wenn es die stochastische Repräsentation

d

X = RS

hat. Dabei ist S gleichverteilt auf der Einheitssphäre S d−1 = {s ∈ Rd :

sT s = 1}, R ≥ 0 ist eine radiale Zufallsvariable, unabhängig von S.

Es bezeichne Sd+ (ψ) die Unterklasse der sphärischen Zufallsvektoren X mit

P (X = 0) = 0.

Korollar 3.23

d

Sei X = RS ∼ Sd+ (ψ), dann gilt

X d

= (R, S).

kXk,

kXk

4

Proof.

kXk,

RS X = kRSk,

= (R, S)

kXk

kRSk

Beispiel 3.24

X ∼ Nd (0, Id ). Wegen X T X ∼ χ2d ist auch R2 ∼ χ2d .

Nun wird E(S), Cov(S) berechnet:

0 = E(X) = E(R)E(S) ⇒ E(S) = 0

Id = Cov(X) = E(R)2 Cov(S) ⇒ Cov(S) =

Id

d

wegen E(R2 ) = d (weil R2 ∼ Xd2 ).

Hat nun X eine sphärische Normal-Varianz-Mischverteilung X ∼ Md (0, Id , Ĥ),

d

so können wir die Verteilung von R2 = X T X wie folgt kalkulieren: Wegen

d

d √

e2

X = W Y , mit Y ∼ Nd (0, Id ) und W unabhängig von Y , folgt R2 = W R

e2 ∼ χ2 und W und R

e unabhängig. Nun können wir die Verteilung von

mit R

d

e2 kalkulieren und erhalten somit R2 .

WR

3.3.2

Elliptische Verteilungen

Definition 3.26

X hat eine elliptische Verteilung wenn

d

X = µ + AY,

wobei Y ∼ Sk (ψ) und A ∈ Rd×k und µ ∈ Rd sind eine Matrix und ein Vektor

mit konstanten Einträgen.

Elliptische Verteilungen sind also affine Transformationen von sphärischen

Verteilungen.

TX

φX (t) = E(eit

T (µ+AY

) = E(eit

)

Tµ

) = eit

E(ei(A

T t)T Y

Tµ

) = eit

ψ(tT Σt),

5

wobei Σ = AAT .

Notation: X ∼ Ed (µ, Σ, ψ) mit µ als Ortsvektor, Σ als Verteilungsmatrix

und ψ als charakteristischem Generator.

Bemerkung 3.27

Die Kenntnis von X und µ lässt nicht eindeutig auf die elliptische Verteilung

Ed (µ, Σ, ψ) schließen, sondern Σ und ψ hängen von einer positiven Konstanten ab. Zum Beispiel kann die multivariate Normalverteilung als Ed (µ, Σ, ψ)

oder Ed (µ, cΣ, ψ(·/c)) beschrieben werden mit ψ(u) = exp(− 12 ) und c > 0

bel.

Aus Def. 3.26 und Theorem 3.22 folgt

Satz 3.28

X ∼ Ed (µ, Σ, ψ) genau dann, wenn es S, R, A gibt, so dass

d

X = µ + RAS

wobei

(i) S auf der Einheitssphäre S k×1 = {s ∈ Rk : sT s = 1}

gleichverteilt ist,

(ii) R ≥ 0, eine radiale Zufallsvariable, unabhängig von S,

(iii) A ∈ Rd×k mit AAT = Σ.

Ist Σ positiv definit, so gilt:

1

X ∼ Ed (µ, Σ, ψ) ⇔ Σ− 2 (X − µ) ∼ Sd (ψ).

Hat nun der sphärische Vektor Y die Dichtefunktion g, dann hat X = µ +

1

Σ 2 Y die Dichte

f (x) =

1

T −1

g

(x

−

µ)

Σ

(x

−

µ)

.

1

|Σ| 2

6

Außerdem ergibt sich für eine nicht singuläre elliptische Verteilung

! q

− 12

Σ

(X

−

µ)

d

T

−1

= R, S

(X − µ) Σ (X − µ) p

(X − µ)T Σ−1 (X − µ)

mit S gleichverteilt auf S d−1 und R als unabhängige skalare Zufallsvariable.

Satz 3.29

Sei X ∼ Ed (µ, Σ, ψ), Σ sei positiv definit und Cov(X) endlich. Dann gilt für

jedes c ≥ 0 mit P (X − µ)T Σ−1 (X − µ) ≥ c > 0:

ρ X|(X − µ)T Σ−1 (X − µ) ≥ c = ρ(X)

1

d

d p

Proof. X|(X−µ)T Σ−1 (X−µ) ≥ c = µ+RΣ 2 S|R2 ≥ c mit R = (X − µ)T Σ−1 (X − µ)

und S unabhängig von R, verteilt auf S d−1 . So gilt

d

e 12 S,

X|(X − µ)T Σ−1 (X − µ) ≥ c = µ + RΣ

e = R|R2 ≥ c. Also bleibt die Verteilung elliptisch mit Verteilungsmamit R

trix Σ (nach Satz. 3.28)

3.3.3

Eigenschaften elliptischer Verteilungen

• Linearkombinationen

Sei X ∼ Ed (µ, Σ, ψ), B ∈ Rk×d und b ∈ Rd bel., so gilt:

BX + b ∼ Ek (Bµ + b, BΣB T , ψ)

• Quadratische Formen

Sei X ∼ Ed (µ, Σψ), Σ nicht singulär, so ist Q÷ = (X − µ)T Σ−1 (X −

d

µ) = R2 , wobei R die radiale Zufallsvariable der stoch. Repräsentation

ist. Ist nun X ∼ Nd (µ, Σ), so ist R2 ∼ χ2d .

• Faltungen

Seien X, Y unabhängig mit X ∼ Ed (µ, Σ, ψ), Y ∼ Ed (µ̃, Σ, ψ̃), dann

ist

X + Y ∼ Ed (µ + µ̃, Σ, ψ)

mit ψ̃(u) = ψ(u)ψ̃(u). Das funktioniert nur, solange die Verteilungsmatrizen bis auf einen konstanten Faktor gleich sind.

7

3.3.4

Verteilungs- und Korrelationsschätzer

µ, Σ und die Korrelationsmatrix P sollen geschätzt werden. Bisher wurden

X und S als Schätzer für Erwartungswert und Kovarianzmatrix betrachtet,

nun werden effektivere Schätzer gesucht.

• M-Schätzer

Maronnas M -Schätzer schätzen Ort (µ̂) und Verteilung (σ̂). Für jede

Beobachtung Xi wird Di2 = (Xi − µ̂)T Σ̂−1 (Xi − µ̂) kalkuliert. Um ver-

besserte Schätzungen zu erlangen, werden monoton fallende Gewichtsfunktionen Wj : R+ 7→ R, j = 1, 2 benutzt, um Beobachtungen mit

großen D-Werten zu entkräften.

M -Schätzer für Ort und Verteilung

(1) Startschätzer: µ̂[1] = X, Σ̂[1] = S

(Standard Schätzer); Iterationszähler: k = 1

T

−1

(2) Für i = 1, . . . , n setze Di2 = Xi − µ

b[k]

Σ[k]

Xi − µ̂[k]

(3) Setze

µ̂[k+1] =

Σni=1 ω1 (D1 )Xi

Σni=1 ω1 (Di )

mit ω1 als Gewichtsfunktion.

(4) Setze

Σ̂[k+1] =

T

1 n

Σi=1 ω2 Di2 Xi − µ̂[k] Xi − µ̂[k]

n

wie Gewichtsfunktionen.

(5) Setze k = k +1 und wiederhole die Schritte (2)−(4) bis die Schätzer konvergieren.

Für ω1 und ω2 waehlt man häufig ω1 (X) = (d + ν)/(X 2 + ν) =

ω2 (X 2 ) für positive Konstanten ν. Benutzt man diese ω1 , ω2 so

führt der Algorithmus zu einer multivariaten td (ν, µ, Σ) Verteilung

mit bekannten Freiheitsgraden.

8

• Korrelationsschätzer nach Kendall’s tau.

Diese Methode zur Schätzung der Korrelation basiert auf Kendall’s

Rang-Korrelations-Koeffizient: ρτ (X1 , X2 ) mit Zufallsvariablen X1 , X2

(formale Def. in 5.2)

Wenn (X1 , X2 ) ∼ E2 (µ, Σ, ψ), dann

ρτ (X1 , X2 ) =

2

arcsin(ρ)

π

(Prop.5.37)

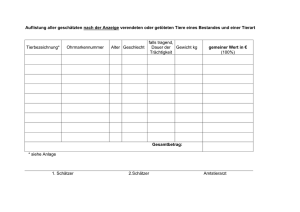

Beispiel 3.31 (Effektive Korrelationsschätzung für stark abweichende Daten.)

Korrelation einer Risikofaktoränderung bestimmter Daten über 90 Tage.

Bei identischer Verteilung sollte diese Zeitspanne ausreichen, um die “wahre“Korrelation zu schätzen.

Bild 3.5: Ergebnisse eines Simulationsexperiments, dass 3000 bivariate Proben t-verteilter Daten mit 3 Freiheitsgraden und Korrelation ρ = 0, 5 (sich

stark auseinanderziehende elliptische Verteilung)

oben: Werte des Pearson-Korrelationskoeffizienten weichen zum Teil stark

ab.

unten: Kendall’s tau Methode bringt Schätzer hervor, die nah am Wert 0, 5

liegen.

3.3.5

Testen Elliptischer Symmetrie

Wie findet man heraus ob identisch verteilte Datenvektoren X1 , . . . , Xn Ed (µ, Σ, ψ)verteilt sind? Für alle Methoden werden Schätzer µ̂ und Σ̂ benötigt (siehe

33.4 um µ̂ und Σ̂ zu berechnen). Allgemein kann nicht von unabhängigen

identisch verteilten Zufallsvektoren ausgegangen werden. Aber wir nehmen

an, dass die Zufallsvektoren zumindest identisch verteilt sind. Selbst wenn

die Daten unabhängig wären, würde die Abhängigkeit schon dadurch entstehen, dass Schätzer für µ und Σ durch die ganze Datenmenge beeinflusst

werden.

• Stabiler Korrelationsschaetzer: eine Erforschungsmethode (basiert auf

Prop. 3.29)

9

Wir versuchen

h(x) = (x − µ̂)T Σ̂−1 (x − µ̂)

ρ(X|h(X) > c),

für verschiedene Werte c ≥ 0 zu schätzen. Für elliptisch verteilte Da-

ten erwarten wir nun, dass die Schätzer über einer Reihe verschiedener

c-Werte stabil bleiben. Für µ̂ und Σ̂ soll dabei wieder ein effizienterer

Schätzer als der Standard-Korrelationsschätzer gewählt werden.

• QQplots

Diese Methode beruht auf dem Zusammenhang zwischen nicht-singulären

elliptischen und sphärischen Verteilungen. Seien µ und Σ bekannt, so

testen wir X auf elliptische Symmetrie, indem wir die Daten

o

n 1

Σ− 2 (Xi − µ) : i = 1, . . . , n auf spährische Symmetrie testen. Wir

o

n

1

prüfen ob die Daten Yi = Σ̂− 2 (Xi − µ̂) : i = 1, . . . , n mit einer sphärischen Verteilung uebereinstimmen, während wir Schätzungsfehler vernachlässigen. Setzen wir nun Ri = kYi k und Si = Yi /kYi k, dann ist zu

prüfen, ob die Si -Daten auf der Einheitsphäre S d−1 gleichverteilt sind

und die Paare (Ri , Si ) unabhängig sind.

Lemma 3.32

Sei T (Y ) eine Statistik, s.d.

T (aY ) = T (Y )

∀ a > 0,

dann hat T (Y ) dieselbe Verteilung für alle spärischen Vektoren Y ∼ Sd+ (ψ).

Proof. Nach Theorem 3.22 gilt T (Y )d = T (RS); T (RS) = T (S) gilt nach

Voraussetzung. Weil die Verteilung T (Y ) nur von S und nicht von R abhängt,

muß sie für alle Y ∼ Sd+ (ψ) dieselbe sein.

Dieses Resultat wird genutzt für Statistiken T (Y ) mit T (Y ) = T (aY ) für

alle a > 0, deren Verteilung bekannt ist wenn Y ∼ Nd (0, Id ). Zwei Beispiele

sind

d

1

T1 (Y ) = s

d2 Y

(1/d − 1)

d

P

i=1

,

(Yi − Y )2

Y =

1X

Yi

d

i=1

10

T2 (Y ) =

K

P

i=1

d

P

i=1

Für Y ∼ Nd (0, Id ) und somit Y ∼

Beta 12 k, 21 (d − k) .

3.4

Yi2

Yi2

Sd+ (ψ)

ist T1 (Y ) ∼ td−1 und T2 (Y ) ∼

Dimensionsreduzierungstechniken

Diese sind in der multivariaten statistischen Analysis ein zentrales Thema

und werden für Ökonomische Modelle gebraucht.

3.4.1

Faktor-Modelle

Durch solche werden d-dimensionale Zufallsvektoren X durch eine kleinere

Reihe von “allgemeinen Faktoren“beschrieben.

Definition 3.33 (Linearfaktormodelle)

Der Zufallsvektor X folgt einem p-Faktormodell, wenn er zersetzt werden

kann als

X = a + BF + ǫ

wobei

(i) F = (F1 , . . . , Fp )T allgemeine Faktoren mit p < d, mit positiv definiter

Kovarianzmatrix;

(ii) ǫ = (ǫ1 , . . . , ǫd )T Zufallsvektor spezieller Fehlerterme, die unkorreliert

sind mit Erwartungswert 0;

(iii) B ∈ Rd×p ist eine Matrix konstanter Ladefaktoren und a ∈ Rd ein

Vektor mit Konstanten;

(iv) Cov(F, ǫ) = E (F − E(F ))ǫT = 0.

Punkte (ii), (iv) sind wichtig, es wird keine Unabhängigkeit, sondern nur

Unkorreliertheit verlangt. Ist X multivariat normalverteilt und genügt dem

Faktormodell, dann ist es möglich eine Version des Faktormodells zu finden,

11

bei der F und ǫ Gauss-verteilt sind. Wobei die Fehler voneinander unabhängig angenommen werden dürfen.

Faktormodelle implizieren eine besondere Struktur für die Kovarianzmatrix

Σ von X:

Σ = Cov(X) = BΩB T + γ,

wobei Ω die Kovarianzmatrix von F und γ die von ǫ darstellt, welche diagonal

ist.

Gilt das Faktormodell, so können die allgeimeinen Faktoren trnasformiert

werden, s.d. sie orthogonal sind mit Erwartungswert 0. Setzt man F ∗ =

Ω−1/2 (F − E(F )) und B ∗ = BΩ1/2 , so lautet das Faktormodell: X = µ +

B ∗ F ∗ + ǫ mit µ = E(X), Σ = B ∗ (B ∗ )T + γ.

3.4.2

Regressionsanalyse von Faktormodellen

Sei

Xt = a + BF + ǫt ,

t = 1, ..., n

ein Modell, bei dem a, B zur Zeit t geschätzt werden sollen. Es gibt zwei

Möglichkeiten der Regression

• Univariate Regression

Xt,j sei die Beobachtung des Instruments j zur Zeit t:

Xt,j = aj + bTj Ft + ǫt,j

t = 1, ..., n.

Nun wird eine lineare Regression durchgeführt.

• Multivariate Regression

Setze

X1T

.

.

X=

. ,

XnT

| {z }

n×d

1 F1T

.

..

..

F =

.

,

1 FnT

{z

}

|

n×(p+1)

B2 =

aT

!

,

BT

| {z }

(p+1)×d

ǫT1

.

.

E=

. .

ǫTn

| {z }

n×d

Es gilt: X = F B2 + E, wobei B2 die Matrix der zu schätzenden Para-

meter ist.

![ELLIPTISCHE FUNKTIONEN ([1], S. 14–18) In Ihrem Vortrag sollen](http://s1.studylibde.com/store/data/020877042_1-b38df3c880287a445de9369f2b0df6ec-300x300.png)