1 Beispiel 1 (Einiges zum Zusammenhang der Verteilungen) Die

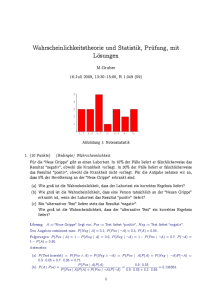

Werbung

1 Beispiel 1 (Einiges zum Zusammenhang der Verteilungen) Die Multinomialverteilung als Obermenge für Binomialverteilung und BernoulliVerteilung Für den Zusammenhang von Multinomialverteilung, Binomialverteilung und Bernoulli-Verteilung gelten: M(n, p1, p2, …, pr) → M(n, p1, p2) = B(n,p1) → B(1,p 1) = Bernoulli(p1) r=2 n=1 (NB: p2 = 1 - p1) Die beiden ersten Momente der Multinomialverteilung Für das Auftreten der einzelnen Merkmale (Kategorien) folgen die Mittelwerte, Varianz und Kovarianz: E[Xi ] = npi ; var[X i ] = npi (1-pi ); Cov[Xi ,Xj] = Cov(i,j) = -npi pj Illustration r = 3 (Kovarianzmatrix V) p1⋅ (1–p1) –p1⋅ p 2 –p 1⋅ p3 V=n –p 2⋅ p1 p 2⋅ (1–p 2) –p 2⋅ p3 –p 3⋅ p1 –p 3⋅ p 2 p3⋅ (1–p3) var1 Cov(1,2) Cov(1,3) = Cov(2,1) var 2 Cov(2,3) Cov(3,1) Cov(3,2) var3 Der Beweis für die Momente folgt aus dem Modus des Ziehens, der mit Multinomialverteilung verbunden ist: eine Urne mit r Kategorien von Kugeln, der "mit Zurücklegen" - eine unveränderte Zusammensetzung - gezogen wird. jedem Zug wird eine einzige Eins von r möglichen angetroffen (Xi = 1 oder Xi = 0 der jeweiligen Wahrscheinlichkeit (0<pi <1 oder 0<1-pi <1), d.h. jeweils der 0 0 Einheitsvektor oder der Nullvektor, graphisch: ei = 1. 2. der aus Bei mit i-te 0 0 0 (i – 1). 0 , bzw. 0 = ∈Rr 1 ← i. 0 0 (i +1). 0 0 r. 0 Das ist für die Zufallsvariable Xi , die i-te Komponente von X, (i=1, 2, …, r) eine Bernoulli-Situation mit E[Xi ] = p i ; var[Xi ] = p i (1-pi ), bzw für n unabhängige Züge für die Zahl der Einsen des Typs i insgesamt (die Wiederholung von n Bernoulli's gibt eine Binomialverteilung: E[Yi ] = npi ; var[Y i ] = npi (1-pi ) 2 Für die Kovarianz zweier dieser Zufallsvariablen Xi und Xj, i≠j eines Zuges, Cov[Xi ,Xj], gilt nicht Unabhängigkeit. Eine Darstellung der gemeinsamen Wahrscheinlichkeit wie Xi \ X j P[Xj = 1] = pj P[Xj = 0] = 1-pj P[Xi = 1] = pi P[Xi =1; Xj=1]=pi . pj P[Xi =1; Xj=0]=pi . (1-pj) P[Xi =0; Xj=1]=(1-pi ) . pj P[Xi = 0] = 1-pi P[Xi =0; Xj=0]=(1-pi ) . (1-pj) ist daher falsch. Hier wäre die Kovarianz aufgrund der Unabhängigkeitsvoraussetzung null. Zur Bestimmung der Kovarianz wird von der allgemeinen Formel Cov[Xi ,Xj] = E[Xi . Xj] - E[Xi ] . E[Xj] ausgegangen. Für das Produkt Xi . Xj gibt es vier Fälle: Xi \ X j Xj = 1 Xj = 0 Xi = 1 Xi .Xj= 1 Xi .Xj= 0 Xi = 0 Xi .Xj= 0 Xi .Xj= 0 Drei Produkte davon sind ohnehin null, das übrigbleibende Produkt "Xi .Xj= 1" kann nicht auftreten, da in jedem Zug nur eine Eins dabei ist. Damit gilt für die Kovarianz: Cov[Xi ,Xj] = - E[Xi ] . E[Xj] = - pi . pj Bei n Zügen gilt dann Cov[Yi ,Yj] = - n . pi . pj. Ein Beweis ist induktiv (Illustration hier z.B. für n= 2 Züge. Der Zug wird durch den Superskript angezeigt). Die Summe der Einsen in Kategorie i sei Yi = X1i + X2i , E[Yi ] = E[ X1i + X2i ] =2pi var[Y i ] = E[(Yi - 2pi )(Yi - 2pi )] = E[ ( X1i - pi ) + ( X2i - pi )) .(( X1i - pi ) + ( X2i - pi ))] = = var[ X1i ] + Cov[ X1i , X2i ] + var[ X2i ] + Cov[ X1i , X2i ] = 2 var[Xi ] = 2pi (1-pi ) (aufgrund der identisch verteilten Grundgesamtheit sowie der Unabhängigkeit über die Zeit) Cov[Yi , Yj] = E[(Yi - 2pi )(Yj - 2pj)] = E[ ( X1 - pi ) + ( X2 - pi )) .(( X1 - pj) + ( X2 - pj))] = i = E[ ( X1i - pi )( Xj1 - pj) ]+E[ ( X1i - pi )( Xj2 - pj)]+E[ ( X2i - i 1 pi )( Xj - j 2 pj)]+E[( Xi j - pi )( Xj2 - pj)] = Cov[Xi , Xj] + 0 + 0 + Cov[X i , Xj] = - 2 . pi . pj denn Cov[ X1i , Xj1 ] =Cov[ X2i , Xj2 ] = Cov[Xi , Xj] = - pi . pj (gleiche Verteilung in jedem Zug) E[ ( X1i - pi )( Xj2 - pj) ] = E[ ( X2i - pi )( Xj1 - pj) ] = 0 (Unabhängigkeit) ■