19 Brownsche Bewegungen als Gaußsche Prozesse

Werbung

65

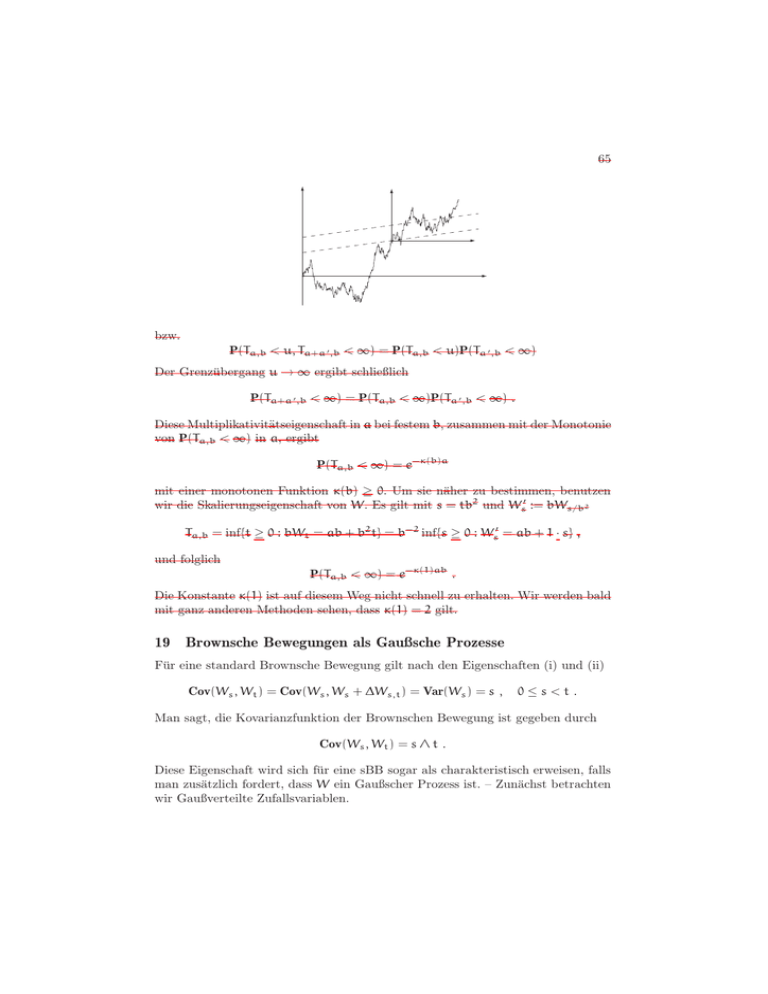

bzw.

P(Ta,b < u, Ta+a ′ ,b < ∞) = P(Ta,b < u)P(Ta ′ ,b < ∞)

Der Grenzübergang u → ∞ ergibt schließlich

P(Ta+a ′ ,b < ∞) = P(Ta,b < ∞)P(Ta ′ ,b < ∞) .

Diese Multiplikativitätseigenschaft in a bei festem b, zusammen mit der Monotonie

von P(Ta,b < ∞) in a, ergibt

P(Ta,b < ∞) = e−κ(b)a

mit einer monotonen Funktion κ(b) ≥ 0. Um sie näher zu bestimmen, benutzen

wir die Skalierungseigenschaft von W. Es gilt mit s = tb2 und Ws′ := bWs/b2

Ta,b = inf{t ≥ 0 : bWt = ab + b2 t} = b−2 inf{s ≥ 0 : Ws′ = ab + 1 · s} ,

und folglich

P(Ta,b < ∞) = e−κ(1)ab .

Die Konstante κ(1) ist auf diesem Weg nicht schnell zu erhalten. Wir werden bald

mit ganz anderen Methoden sehen, dass κ(1) = 2 gilt.

19 Brownsche Bewegungen als Gaußsche Prozesse

Für eine standard Brownsche Bewegung gilt nach den Eigenschaften (i) und (ii)

Cov(Ws , Wt ) = Cov(Ws , Ws + ∆Ws,t ) = Var(Ws ) = s ,

0≤s<t.

Man sagt, die Kovarianzfunktion der Brownschen Bewegung ist gegeben durch

Cov(Ws , Wt ) = s ∧ t .

Diese Eigenschaft wird sich für eine sBB sogar als charakteristisch erweisen, falls

man zusätzlich fordert, dass W ein Gaußscher Prozess ist. – Zunächst betrachten

wir Gaußverteilte Zufallsvariablen.

66

Kapitel III. Die Brownsche Bewegung

Definition. Eine Rn -wertige Zufallsvariable X = (X1 , . . . , Xn ) heißt Gaußverteilt

(oder multivariat normalverteilt), wenn jede Linearkombination c1 X1 + · · · + cn Xn

(mit reellen Zahlen c1 , . . . , cn ) normalverteilt ist.

Die wichtigen Kenngrößen sind der Mittelwertvektor

µX = µ = (µ1 , . . . , µn )

mit µi := E[Xi ]

und die Kovarianzmatrix

ΣX = Σ = (σij )1≤i,j≤n

mit σij := Cov(Xi , Xj ) .

Offenbar ist Σ symmetrisch, zudem nichtnegativ definit, d.h. für alle c1 , . . . , cn ∈ R

gilt

n X

n

X

ci σij cj ≥ 0 .

i=1 j=1

Denn

P

j ci σij cj = Var[ i ci Xi ].

P P

i

Lemma III.6. Zwei Gaußverteilte Zufallsvariablen mit gleichem Mittelwertvektor

µ und gleicher Kovarianzmatrix Σ haben dieselbe Verteilung.

Beweis. Wie sich mit Werkzeugen der Maß- und Integrationstheorie ergibt (Stichwort: charakteristische Funktionen), haben zwei Rn -wertige Zufallsvariablen X

und Y dieselbe Verteilung, falls für alle reellen c1 , . . . , cn die beiden reellwertigen Zufallsvariablen c1 X1 + · · · + cn Xn und c1 Y1 + · · · + cn Yn identisch verteilt

sind. Für Gaußverteilte Zufallsvariablen sind dies normalverteilte

P Zufallsvariablen,

deren

Mittelwert

und

Varianz

nach

Voraussetzung

gleich

i ci µi und Varianz

P P

i

j ci σij cj sind. Dies ergibt die Behauptung.

Gaußverteilte Zufallsvariable haben eine wichtige, exklusive Eigenschaft.

Lemma III.7. Seien 1 ≤ k < n natürliche Zahlen.Verschwinden für eine Gaußverteilte Zufallsvariable X = (X1 , . . . , Xn ) für alle i ≤ k < j die Kovarianzen

Cov(Xi , Xj ), so sind (X1 , . . . , Xk ) und (Xk+1 , . . . , Xn ) unabhängig.

Beweis. Es bezeichne X ′ eine unabhängige Kopie von X. Mit X ist offenbar auch

′

(X1 , . . . , Xk ) Gaußverteilt, und mit X ′ auch (Xk+1

, . . . , Xn′ ). Da Summen von unabhängigen, normalverteilten Zufallsvariablen wieder normalverteilt sind, ist auch

′

Y = (X1 , . . . , Xk , Xk+1

, . . . , Xn′ ) Gaußverteilt. Außerdem haben X und Y gleichen

Mittelwertvektor und gleiche Kovarianzmatrix, daher sind sie nach dem vorigen

Lemma identisch verteilt. Y erfüllt die behauptete Unabhängigkeit, deswegen gilt

sie auch für X.

Wir kehren nun zu stochastischen Prozessen zurück. Ein reellwertiger stochastischer Prozess X = (Xt )t≥0 heißt Gaußsch, falls für alle 0 ≤ t1 < · · · < tk die

Zufallsvariable (Xt1 , . . . , Xtk ) Gaußverteilt ist, und

γ(s, t) := Cov(Xs , Xt )

67

heißt die Kovarianzfunktion von X. Nach dem Lemma bestimmt sie also zusammen

mit den Mittelwerten die endlichdimensionalen Verteilungen von X.

Satz III.8. Ein stochastischer Prozess W mit f.s. stetigen Pfaden ist genau dann

eine sBB, wenn er ein zentrierter Gaußscher Prozess mit Kovarianzfunktion

γ(s, t) = s ∧ t ist.

Beweis. Für 0 = t0 < t1 < · · · < tk ist X = (Wt1 , . . . , Wtk ) genau dann Gaußverteilt, wenn dies für Y = (∆Wt0 ,t1 , . . . , ∆Wtk−1 ,tk ) gilt. Diese Zufallsvektoren

gehen nämlich durch Linearkombination auseinander hervor. Aus diesem Grund

sind auch die Beziehungen ΣX = (ti ∧ tj ) und ΣY = ((ti − ti−1 )δij ) äquivalent (δij

bezeichnet das Kroneckersymbol). Die Behauptung ergibt sich deswegen aus dem

vorigen Lemma.

Der Satz hat wichtige Anwendungen.

Beispiele.

1. Für 0 ≤ t ≤ 1 gilt Cov(Wt − tW1 , W1 ) = t − t = 0. Daher wird eine sBB W

durch

Wt = Bt + tW1 , 0 ≤ t ≤ 1 , mit Bt := Wt − tW1

in zwei unabhängige Bestandteile zerlegt. Der Prozess B = (Bt )0≤t≤1 heißt

Brownsche Brücke. – Übrigens ist aufgrund der Unabhängigkeit B in Verteilung nichts anderes als die Brownsche Bewegung W, bedingt auf das Ereignis

{W1 = 0}.

1

2. Setze W̃t := tW1/t für t > 0 sowie W̃0 = 0. Mit W ist dann auch W̃ ein

Gaußscher Prozess. Weiter gilt Cov(W̃s , W̃t ) = st min(s−1 , t−1 ) = min(s, t).

Auch für s = 0 oder t = 0 stimmt die Formel, daher haben W und W̃ dieselbe

Kovarianzfunktion. Nach Satz ?? besitzt W̃ eine f.s. stetige Version. Da nun

W̃ die Eigenschaft, f.s. für alle t > 0 stetig zu sein, von W erbt, stimmt W̃

bereits f.s. mit seiner stetigen Version überein. Es ist also bereits W̃ eine

sBB.

68

Kapitel III. Die Brownsche Bewegung

3. Durch Xt := e−t We2t , t ∈ R, ist ein Gaußscher Prozess gegeben, dessen Zeitparameter t die gesamte reelle Achse durchläuft. Für s < t ist

Cov(Xs , Xt ) = e−s e−t e2s = es−t , die Kovarianzfunktion ist also

γ(s, t) = e−|s−t| .

Dies bedeutet, dass die Verteilung von (Xt1 +h , . . . , Xtk +h ) von dem Translationsparameter h unabhängig ist. Man sagt, X ist ein stationärer Prozess. X

heißt Ornstein-Uhlenbeck Prozess.

20 Martingale bei Brownschen Bewegungen

Eine Brownschen Bewegung W gibt Anlass für die Betrachtung und Konstruktion einer Anzahl von Martingalen. Dazu betrachten wir wieder die zugehörige

natürliche Filtration“ F = (Ft )t≥0 , gegeben durch

”

Ft := σ(Ws , s ≤ t) .

Eine Familie (Xt )t≥0 von integrierbaren Zufallsvariablen heißt ein F-Martingal,

falls für alle 0 ≤ s < t

E[Xt | Fs ] = Xs f.s.

gilt.

Beispiele. Nach Satz III.5 (angewandt auf die Stoppzeit T = s) ist ∆Ws,t unabhängig von Fs , andererseits ist Ws eine Fs -messbare Zufallsvariable. Damit

ergeben sich aus der Zerlegung Wt = Ws + ∆Ws,t verschiedene Martingale.

1. W selbst ist ein Martingal, denn für s < t gilt

E[Wt | Fs ] = Ws + E[∆Ws,t ] = Ws f.s.

2. Auch (Wt2 − t)t≥0 ist ein Martingal, denn für s ≤ t gilt

2

E[Wt2 | Fs ] = E[Ws2 + 2Ws ∆Ws,t + ∆Ws,t

| Fs ] = Ws2 + (t − s) f.s.

1

2

3. Für alle λ ∈ R ist (eλWt − 2 λ t )t≥0 ein Martingal, denn

1

2

E[eλWt | Fs ] = eλWs E[eλ∆Ws,t ] = eλWs e 2 λ

(t−s)

f.s.

In der letzten Zeile haben wir die Identität

2

E[eλWt ] = eλ

t/2

verwendet, die man durch einfache Rechnung erhält:

Z

Z

(x−λt)2

2

2

1

1

x2

e−λ t/2 E[eλWt ] = e−λ t/2 √

eλx− 2t dx = √

e− 2t dx = 1.

2πt

2πt

(0.4)