Document

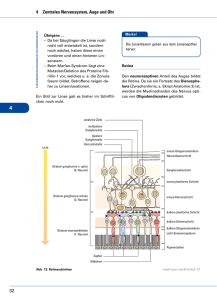

Werbung

Neuronale Netze und Gedächtnis pdf-File (farbig): http://www.cns.unibe.ch/~wsenn/#teaching 1. Physiologische Grundlagen 2. Affen-Experiment 3. Binäre Klassifikation 4. Hopfield-Modell Walter Senn, 2003 Die 7 Schichten des Neokortex Frontaler kortex I II Primärer visueller Kortex (V1) III IV V VI Ramon y Cajal, 1898 Kortikales Netzwerk von Nervenzellen Dendriten Aktionspotential (binär) Synapse post-synaptisches Potential (analog) Soma Axon 100 mV 10 ms Die Synapse als elektrochemisches Bindeglied Aktionspotential Mg2+ Glutamat K+ (Neurotransmittor) + Na NMDARezeptor Exitatorisches postsynaptisches Potential (EPSP) ~100 EPSPs Æ 1 Aktionspotential Gleichzeitige prä- und postsynaptische Aktivierung: Æ Einbau weiterer Kanäle („LangzeitPotenzierung der Synapsen“) Æ grösserers EPSP (grösserer „synaptisches Gewicht“) Prinzip der assoziativen synaptischen Plastizität nach Paarung auf Rosenduft (Stim. Koll. B) auf Zwiebelduft (Stim. Koll. C) Antworten des CA1 Neurons.... Verstärkung Bild oder Duft aktivieren CA1Neuron („Rosenneuron“) auf Bild der Rose (Stim. Koll. A) vor Paarung Zeit Ort der Hebb‘schen Plastizität (Schaffer Kollateral Æ CA1 Neuron; Hippocampus) Paarung: gleichzeitige visuelle und olfaktorische Stimulation mit Rose (bzw. elektr. Stim. von Kollateral A und B) Baer-Connors-Paradiso, Neuroscience, 2001 Gedächtnis: Vernetzung verschiedener Inhalte • Wann? 31. August 1997 Æ Fakten • Wo war ich? Æ Ereignisse • Schuldige? Æ Emotionen • Wie hätte ich als Fahrer reagiert? Æ Skills/Reflexe (Qualitative) Klassifikation von Gedächtnis Deklarativ (explizit) Fakten Ereignisse Nicht-deklarativ (implizit) Priming, Habituation (perzeptives Lernen) prozedural (Fertigkeiten) Konditionierung („assoziatives Lernen“) emotional medialer Temporallappen + Neocortex Neokortex Basalganglien Motorik Amygdala Kleinhirn Kandel-Schwartz-Jessel, Principles of Neuroscience, 2001 Repräsentation der verschiedenen Gedächtnisarten im Gehirn prozedural: basothalamo-cortical Angst-Konditionierung, Emotionen: Amygdala deklarativ (Fakten + Ereignisse): cortico-hippokampal Priming: sensorische Areale Motor-Konditionierung: Kleinhirn Zeitliche Klassifikation von Gedächtnis Sensorische Eingänge < 1s Sensorisches Gedächtnis: verblassende Neuronen-Aktivität, unbewusst, vorwiegend primäre sensorische Areale Bsp: optische Nachbilder beim Lesen SekMin Kurzzeitgedächtnis: selbsterhaltende („kreisende“) Netzwerk-Aktivität, willentlich, vorwiegend höhere Areale Bsp: Telefonnummern wiederholen Abruf TageJahre Langzeitgedächtnis: Lang-ZeitPotenzierung/Depression synaptischer Verbindungen; Neocortex, Hippocampus, Basalganglien, Amygdala, Kleinhirn, etc. Das Affenexperiment: Entstehung von Lang- und Kurzzeitgedächtnis (deklarativ) V. Yakovlev, S. Fusi, E. Berman, E. Zohary. Inter-trial neuronal activity in infero-temporal cortex: a putative vehicle to generate long term associations. Nature Neuroscience, 1, No. 4, 310-317 (1998) Das delayed match-to-sample Experiment Sample-Stimulus in Kurzzeitgedächtnis Extrazelluläre Ableitungen in IT Inferotemporaler Kortex IT Ableitungen Selektive Delay-Aktivität Keine Delay-Aktivität: Stimulus unbekannt (Ænicht genügend LTP) oder Neuron nicht selektiv für Stim 24. Delay-Aktivität: Neuron selektiv für Sim 14 und Stimulus genügend oft gezeigt (ÆLangzeitgedächtnis) Verschiedene Stimuli aktivieren verschiedene Netzwerke Lernen der Stimuli: Hebb‘s Postulat Gleichzeitige Aktivität von Neuronen stärkt ihre synaptische Verbindung: "When an axon of cell A is near enough to excite B and repeatedly or persistently takes part in firing it, some growth process or metabolic change takes place in one or both cells such that A's efficiency, as one of the cells firing B, is increased." (Donald O. Hebb, 1949) Verbindung zwischen aktiven Neuronen verstärkt Nach synaptischer Potenzierung: Delay-Aktivität als selbsterhaltende Netzwerk-Aktivität Ist Delay-Aktivität wirklich ein Attraktor? 0 1 Computererzeugter Stimulus, nicht verrauscht, hundertfach gezeigt. Degradation Level 2 3 Verrauschte Varianten, nicht gelernt. 4 Attraktor! ...da kein kontinuierlicher Übergang in den DelayAktivitäten mit zunehmendem Degradationsgrad. Binäre Klassifikation: Arbeitsweise eines neuronalen Attraktor-Netzwerkes Das schwarz-weiss Klassifikationsproblem Lösung: - Seriell, durch Auszählen der schwarzen und weissen Pixels. - Parallel, als emergente Funktion eines interagierenden Systems einfacher Recheneinheiten. 61/100 (black/total) 52/100 (black/total) 179/400 (black/total) 220/400 (black/total) 5381/10’000 (black/total) 4459/10’000 (black/total) Antwortzeit Pop-out versus serielles Auszählen l l e ri e s Pop-out (Relaxation) Bildgrösse Antwortzeiten des Hirns Aktivitätsdifferenz zwischen `go´ und `no-go´ Fällen (schwarz/weiss bzw. Tier/kein Tier). Motorische Antwort nach 400ms. Aktivitätsprofil der 7 frontalen Elektroden. Signifikanter Unterschied nach 150ms. S Thorpe, F Fize & C Marlot. Speed of processing in the human visual system. Nature, 1996 Dynamik des neuronalen Netzwerkes Aktivität von Neuron i: si=±1, je nach dem ob Pixel i schwarz (-1) oder weiss (+1) ist. Verbindung von Neuron j zu Neuron i mit synaptischem Gewicht Jij. Interaktion zwischen Neuronen: Neuron j trägt proportional zum synaptischen Gewicht Jij zum Potential hi von Neuron i bei. si (t + 1) = sign (hi (t ) ) , s1 J11 Σ sN J1N hi (t ) = ∑ Jij s j (t ) j 1 if J 1s = ∑ J1 j s j ≥ 0 j s1 = − 1 if ∑ J1 j s j < 0 j Lösung des schwarz-weiss Problems Identische synaptische Gewichte Jij=1. si (t + 1) = sign ∑ s j (t ) , j Majoritätsregel! Schneeballeffekt Æ alles wird entweder schwarz oder weiss Allgemeiner Konvergenzbeweis Annahme: symmetrische Verbindungen, Jij= Jji (“Integrabilitätsbedingung“) Energie: E (t ) = − ∑ si (t )hi (t ) = − ∑ si (t )∑ Jij s j (t ) = − ∑ Jij si s j i j ≠i i i,j Behauptung: Energie wird höchstens kleiner! Æ Gradientenabstieg Beweis: Nimm an, höchstens Neuron (Pixel) 1 werde zur Zeit t verändert. E = E ( t ), E' = E( t + 1) , s = s( t ) , s' = s( t + 1) , s' j = s j fuer j≠1 und s '1 = −s1 E ' = − ∑ Jij si ' s j ' = −J11s1' s1'− ∑ J1 j s1' s j − ∑ Ji 1si s1 = − J11 − 2∑ J1 j s1' s j j ≠1 i,j i ≠1 s’j=sj fuer j≠1 j ≠1 Jij=Jji E = − ∑ Jij si s j = −J11 − 2∑ J1 j s1s j j ≠1 i,j ⇒ E '−E = −2∑ J1 j s1' s j + 2∑ J1 j s1s j = 4∑ J1 j s1s j = 4s1 ∑ J1 j s j = 4s1h1 < 0 . j ≠1 j ≠1 j ≠1 j ≠1 s’1=-s1 s1' = sign(h1) = sign ∑ Jij s j = −s1 ⇒ s1h1 < 0 . j Somit: s(t) konvergiert gegen lokales Minimum der Energie! Landschafts - Metapher Klassifikation schwarz/weiss: E(s1,…,sN) grauer Hügel N E (s1,..., sN ; t ) = − ∑ si (t )hi (t ) i =1 schwarzes Tal weisses Tal Das Hopfield-Modell Attraktor-Netzwerk als assoziativer Speicher Literatur: J Hertz, A Krogh, RG Palmer. Introduction to the theory of neural computation, 1991 R. Rojas. Theorie der neuronalen Netze, 1993 Platzierung eines beliebigen Tales - Wähle beliebiges Muster (Talsohle), z.B. ξ=(1,-1,-1,1,...,-1). - Transformiere si Æ s’i= ξisi ⇒ Falls si=ξi wird s‘=(1,1,...,1), d.h. S liegt im weissen Tal. - Schwarz/weiss-Dynamik: s 'i (t + 1) = sign ∑ s ' j (t ) j oder ξ i si (t + 1) = sign ∑ξ j s j (t ) j ⇒ si (t + 1) = ξ i sign ∑ ξ j s j (t ) = sign ∑ ξ iξ j s j (t ) = sign ∑ Jij s j (t ) j j j Jij Setze Jij=ξiξj , um Muster ξ zum lokalen Energieminimum zu machen. Platzierung mehrerer Täler (Hopfield-Modell) - Talsohlen bei den p Mustern ξ1=(ξ11,..., ξ1Ν), ..., ξp . p - Synaptische Gewichte: Jij = ∑ξ i ξ j . In Matrix-Form: µ µ µ =1 p J = ∑ξ ξ µ µ µ =1 - Dynamik wie vorher: si (t + 1) = sign(hi (t ) ) , hi (t ) = ∑ Jij s j (t ) j In Matrix-Form: s (t + 1) = sign (J s (t ) ) - Neue Landschaft: Klassifikation von Muster in p Klassen N E(s1,…,sN) E (s1,..., sN ; t ) = − ∑ si (t )hi (t ) i =1 U-Tal L-Tal C-Tal “spurious state” Æ erhöhe “Temperatur”Æ spontanes Entweichen Sind die Muster wirklich stabil? Setze s(t)=ξ1 =(ξ11,..., ξ1Ν). Gilt s(t+1)= s(t)=ξ1 ? ? ( ) ξ = sign Jξ 1 1 p µ µ 1 µ µ = sign ∑ξ ξ ξ = sign Nξ 1 + ∑ξ ξ ξ 1 µ ≠1 µ =1 C „Crosstalk“ µ ν Fall 1: Orthogonale Muster, d.h. ξ ξ = 0 fuer µ ≠ ν . µ ⇒ ξ ξ 1 = 0 fuer ( ) µ ≠ 1, und damit C = 0. ( ) ⇒ sign Jξ 1 = sign Nξ 1 = ξ 1 Muster ξ1 ist Fixpunkt. Stabil aufgrund der bewiesenen Attraktoreigenschaft. Stabilität für gelernte zufällige Muster Fall 2: Zufällig gewählte Komponenten ξµi = ±1 ? ( ) ξ = sign Jξ 1 1 p µ µ 1 µ µ = sign ∑ξ ξ ξ = sign Nξ 1 + ∑ξ ξ ξ 1 µ ≠1 µ =1 C „Crosstalk“ µ µ 1 Ci = ∑ξ ξ ξ = ∑∑ ξ iµξ jµξ 1j = Summe von (p-1)N zuffällig gewählten ±1. µ ≠1 i µ ≠1 j ±1 ⇒ Erwartungswert: Ci = 0 2 Varianz: Ci = ( p − 1)N (zentraler Grenzwertsatz) ⇒ hi1 = Nξ i1 + η pN , mit η gaussverteilt um 0 mit Varianz 1 (p≈p-1). 1 ⇒ ξ1 ist Fixpunkt: s (t ) = ξ ( ) ( ) ⇒ si (t + 1) = sign Jξ 1 i = sign Nξ i1 + η pN = ξ i1 = si (t ) , falls p nicht zu gross. Die gelernten zufälligen Muster sind Attraktoren Talsohlen (ξµ) sind auch Attraktoren: Starte mit s(t)= ξ1 und invertiere m Pixel. m nicht zu gross: m p pN ( ) ( ) ⇒ si (t + 1) = sign Jξ 1 i = sign (N − 2m)ξ i1 + η pN = ξ i1 = si (t ) Bereits beim nächsten Zeitschritt sind alle m Pixel wieder zurückgedreht. Das Muster wird korrekt ergänzt („erkannt“). Beispiel 1 Zahlen 0,..,9 abgespeichert in 10x10 Netzwerk 100 si ( t + 1) = sign ∑ Jijs j ( t ) , j=1 9 Jij = ∑ξi µξ jµ µ =0 Korrekte Ergänzung Original Falsche Ergänzung Präsentation t=5 t=10 t=15 t=20 t=25 t=30 t=35 Original Präsentation t=7 t=14 t=21 t=28 t=35 t=42 t=47 Beispiel 2 Vervollständigung von gelernten Bildern Aus: J Hertz, A Krogh, RG Palmer, Introduction to the theory of neural computation, 1991 Landschafts-Metapher im Affenexperiment 1. Zustand vor Präsentation des visuellen Stimulus: Netzwerk im „schwarzen“ (vollständig inaktiven) Tal. Neuron X und Y beide nicht aktiv, s(t1)=(-1,-1). Landschafts-Metapher im Affenexperiment 2. Zustand während Präsentation des visuellen Stimulus ξ=(1,-1): Netzwerk wird im „Hang“ des „ ξ-Tales“ festgehalten. Neuron X ist (stark) aktiv, Neuron Y ist nicht aktiv, s(t2)=(1,-1). Landschafts-Metapher im Affenexperiment 3. Zustand nach Präsentation des visuellen Stimulus ξ =(1,-1): Netzwerk rutscht in „ξ-Tal“. Neuron X bleibt aktiv, Neuron Y bleibt inaktiv, s(t3)=(1,-1). Speicherkapazität des Hopfield-Netzwerkes Wieviele Muster können mit N Neuronen gespeichert werden? Intuition: 1 zusätzliches Neuron Æ N zusätzliche Synapsen Æ N zusätzliche Freiheitsgrade Æ 1 zusätzliches Muster mit N Pixel. ⇒ Speicherkapazität ∝N. Methode: Abschätzung des Crosstalks C. pN µ µ 1 µ µ 1 Ci = ∑ ξ ξ ξ = ∑∑ ξi ξ j ξ j = ∑ ζ k , mit ζ k = ±1 (50%). k =1 µ ≠1 i µ ≠1 j σ Perror = N Ci 1 2πσ ∫ ∞ N e −x 2 2σ dx = ( ( 1 1 − erf N 2 ) 2σ2 = P(p,N) < 0.01 σ = pN Resultat: Perror = P(p,N) < 0.01 falls p < 0.185·N. ⇒ Speicherkapazität≈0.18·N d.h. mit N=1000 Neuronen können p=185 zufällige Muster mit einer Fehlerwahrscheinlichkeit <1% pro Pixel gespeichert werden. Appendix: Summe Sn von n Zufallszahlen ±1 n → ∞ (n=pN) Binomialverteilung → Normalverteilung Summe S 1 1 1 −1 1 1 3 2 1 6 3 1 4 4 Wahrsch‘keit von Sn=S 50% Sn 50% σ n Pn (S) = Stirling‘sche Formel n 1 2n (S + n) → 2 2 1 e −S 2 n 2πn Varianz : σ2 = n 1 1 S + 1 , 50% Sn+1 = n Sn − 1 , 50% n gross (für Binomial- und Normalverteilung) 2 ⇒ Sn+1 ⇒ Sn 2 = 1 (Sn + 1)2 + 1 (Sn − 1)2 2 2 = n, ⇒ σ = n (n=pN) 2 = Sn + 1 = Sn 2 +1