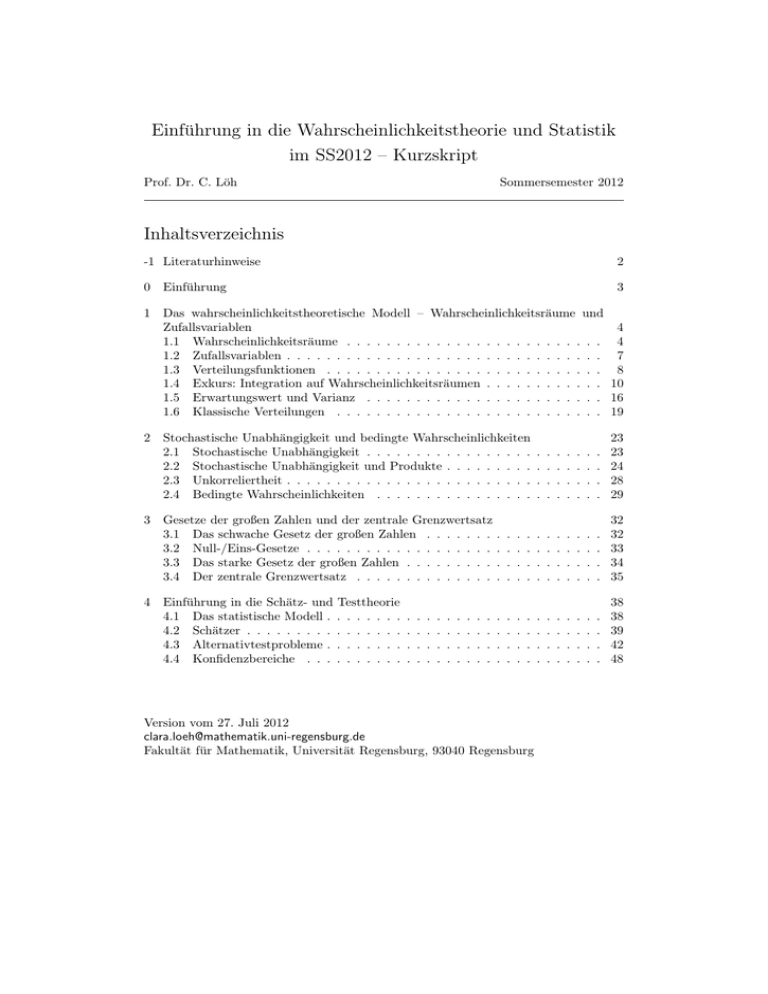

Einführung in die Wahrscheinlichkeitstheorie und Statistik im

Werbung