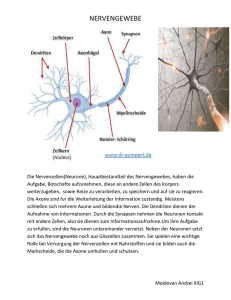

NEURAL NETWORKS

Werbung

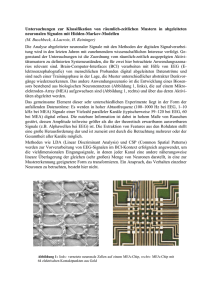

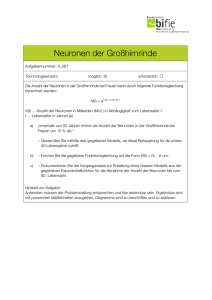

NEURAL NETWORKS IVO PEKEC . 2010 . IAM ARCHITECTURE OF THE HUMAN MIND - Neuronale Netzwerke bilden Struktur und Informationsarchitektur des Gehirns - menschliches Hirn 300-500 Milliarden Neuronen 100.000km Nervenverbindungen - Funktionsweise Vielzahl identer, einfacher Elemente die immer dieselbe Grundoperation wiederholen - Summierung / Gewichtung einkommender Impulse bis ein Schwellenwert erreicht wird, dann Sendung eingener Impulse an weitere Neuronen - parallele Informationsverarbeitung - erlaubt Erlernung von komplexen , nichtlinearen Funktionen 3 DEFINIERENDE FAKTOREN ART DER NEURONEN McCullloch Pitts-Zellen TOPOLOGIE LERNVERFAHREN TOPOLOGIE STRUKTUR DES NETZES FEED-FORWARD-NETZE REKURRENTE NETZE LERNVERFAHREN - Algorithmisches Lernverhalten - dienen dazu für bestimmte Eingabemuster bestimmte Ausgabemuster zu erzeugen 4 Möglichkeiten : - Entwicklung neuer Verbindungen - Änderung der Gewichtung - Anpassung der Schwellenwerte - Hinzufügen / Löschen von Neuronen - bewachte / unüberwachte Lernprozesse - verschiedene Varianten mit eigener Definition der Regeln für Neuverbindungen ANWENDUNG - bei Aufgaben wo wenig explizites Wissen über das zu lösende Problem vorhanden ist - hohe Fehlerbeständigkeit - Texterkennung, Bilderkennung, Gesichtserkennung - KI, Robotik, virtuelle Agentensysteme - Data-Mining , Mustererkennung - Frühwarnsysteme NEURON CONNECTIONS - RAT BRAIN HUMAN NEOCORTEX - IBM PERCEPTRON - PROCESSING SCRIPT NEURON CONNECTIONS - RAT BRAIN NEURAL NETWORKS Biologisches Vorbild Lernregeln Neuronale Netzwerke bilden die Struktur und Informationsarchitektur des Gehirns von Säugetieren. Statt eines einzigen komplexen, zentralen Prozessors der schrittweise bestimmte besitzt das Gehirn einfache Rechenelemente, die Neuronen (über Axons verbunden), aber diese in extrem großer großer Zahl. Das menschliche Gehirn hat schätzungsweise mehrere 100 Milliarden Neuronen. Diese sind über Nervenfasern verbunden, jedes mit bis zu 10.000 weiteren Neuronen, was eine Nervenlänge von 100.00 km ergibt. Dies ergibt ein extrem Komplexes Netzwerk. Den auschlaggebenden Punkt bei NN bilden die algoritmischen Lernverfahren, welche dazu dienen, ein neuronales Netz dazu zu bringen, für bestimmte Eingangsmuster zugehörige Ausgabemuster zu erzeugen. Grunsätzlich gibt es 4 Möglichkeiten die Netze zu lernen: -Entwicklung neuer Verbindungen - Änderung der Gewichtung - Anpassen der Schwellenwerte - Hinzufügen / Löschen von Neuronen (nur virtuell, in Echt genetisch fix vorgegeben) Die Funktionsweise ist simpel, prinzipiell wird immer dieselbe, einfache Grundoperation wiederholt. Es werden von anderen Nerven einkommende Nervenimpulse/Aktionspotentiale solange summiert bis ein gewisser Schwellenwert erreicht wird und selber ein Impuls abgefeuert wird. Dies erfolgt auf Basis eines bestimmten Eingangsreizes. Dies geschieht im Vergleich zu Computern die Daten nach einer bestimmten Anweisungskette abarbeiten parrallel. ERlaubt Erlernung von Komplexen nicht linearen Funktionen Künstliche Neuronale Netzwerke Für uns interessant sind künstliche neuronale Netze. Diese funktionieren prinzipiell ähnlich. 3 Faktoren sind ausschlaggebend für die Funktion und Anwendungen. Erstens die Art der Neuronen, meistens kommen McCulloch-Pitts Zellen zum Einsatz. Diese kann nur binär unterscheiden und hat eine bestimmte Zahl als Schwellenwert. Wie in Echt Nehmen diese nur die Funkion einkommende Signale zu summieren und zu gewichten bis ein Schwellenwert erreicht wird und das nächste Signal abgefeuert wird, das wiederum von anderen Neuronen gewichtet/summiert wird. Ausschlaggebend ist die Verbindugsstärke/Gewichtung zwischen den Neuronen (in Echt durch Synapsen chemisch bestimmt). TOPOLOGIE: Bezeichnet in Künstlichen neuronalen Netzwerken bezeichnet die Struktur des Netzes. Damit ist u.a. gemeint wie viele künstliche Neuronen sich auf wievielen Layern/Schichten befinden, auch wieviele Sogenannte Hidden-Layers es gibt und wie diese untereinander verbunden sind. Es gibt z.b. reine Feed-Forward-Netze wo eine Schicht immer nur mit der Nächsthöheren Verbunden ist. Darüber hinaus gibt es auch etwa rekurrente Netzwerke in denen Rückgekoppelte Verbindungen in beide Richtungen Möglich sind. Weitere Varianten sind Perceptrons, Kohoennetze, Neocognitrons, GNG-Netze. Je nach Funktion zu wählen, nachdem wie diese künstlichen Neuronen miteinander verbunden sind bilden sie bestimmte Netzwerkklassen mit ganz speziellen Eigenschaften und Anwendungsmöglichkeiten. Dies geschieht wieder auf verschiedenen Wegen, die wichtigste bilden aber bewachte und unüberwachte Lernprozesse, die jeweils eigenen ganz bestimmten Regeln und Prozessen folgen die definieren wie die Neuverbindungen vonstatten gehen. Beispiele für bewachte wären die Backpropagation(Fehlerrückführung) oder die Deltaregel, bei unbewachten. Überwachte Lernregeln: Beim Überwachten Lernen wird dem KNN ein Eingangsmuster gegeben und die Ausgabe, die das Neuronale Netz in seinem aktuellen Zustand produziert, mit dem Wert verglichen, den es eigentlich ausgeben soll. Durch Vergleich von Soll- und Istausgabe kann auf die vorzunehmenden Änderungen der Netzkonfiguration geschlossen werden. (Lernen aus Fehlern) Das Unüberwachte Lernen erfolgt ausschließlich durch Eingabe der zu lernenden Muster. Das Neuronale Netz verändert sich entsprechend den Eingabemustern von selbst, also durch Selbstorganisation. Es gibt auch hier noch weitere Varianten etwa den LMSAlgorithmus (Gradientverfahren) Aufgabengebiete Seine Besonderen Eigenschaften machen das KNN bei allen Anwendungen interessant , wo man wenig explizites Wissen über das zu lösende Problem verfügt. Sehr fehlerbeständig. Texterkennung, Bilderkennung, Gesichtserkennung || Künstliche Intelligenz , Virtuelle Agenten , Robotik || Data-Mining || Frühwarnsysteme (Tornados)