Grundlagen der Wahrscheinlichkeitsrechnung Die erwartete Höhe

Werbung

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Endlicher Wahrscheinlichkeitsraum

Grundlagen der Wahrscheinlichkeitsrechnung

Die erwartete Höhe eines Treaps

Sei

Pr [!]

P

!2⌦

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Zufallsexperiment

Ereignisse

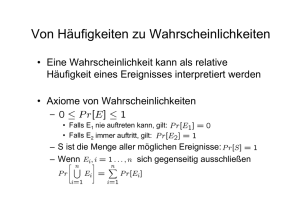

Endlicher Wahrscheinlichkeitsraum

Sei

0 für alle ! 2 ⌦

Pr [!] = 1

Pr [!]

P

!2⌦

0 für alle ! 2 ⌦

Pr [!] = 1

Definition

Zufallsexperiment

Ereignisse

Endlicher Wahrscheinlichkeitsraum

GW

Treaps

Pr [!]

P

0 für alle ! 2 ⌦

Pr [!] = 1

(⌦, Pr) ist ein endlicher Wahrscheinlichkeitsraum.

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Zufallsexperiment

Ereignisse

Wahrscheinlichkeitsraum - roter und blauer Würfel

Mögliche Würfelergebnisse:

⌦ eine endliche Menge;

Pr : ⌦ ! R eine Funktion, die jedem Element ! 2 ⌦ eine

Wahrscheinlichkeit zuordnet.

Pr [!]

P

!2⌦

(⌦, Pr) ist ein endlicher Wahrscheinlichkeitsraum.

⌦ eine endliche Menge;

Pr : ⌦ ! R eine Funktion, die jedem Element ! 2 ⌦ eine

Wahrscheinlichkeit zuordnet.

Treaps

Sei

⌦ eine endliche Menge;

Pr : ⌦ ! R eine Funktion, die jedem Element ! 2 ⌦ eine

Wahrscheinlichkeit zuordnet.

Endlicher Wahrscheinlichkeitsraum

!2⌦

(⌦, Pr) ist ein endlicher Wahrscheinlichkeitsraum.

11. Dezember 2012

Definition

Zufallsexperiment

Ereignisse

Sei

⌦ eine endliche Menge;

Pr : ⌦ ! R eine Funktion, die jedem Element ! 2 ⌦ eine

Wahrscheinlichkeit zuordnet.

B. Gärtner, E. Welzl

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Zufallsexperiment

Ereignisse

0 für alle ! 2 ⌦

Pr [!] = 1

⌦ = {(i, j) : 1 i, j 6}.

(i: roter Würfel, j: blauer Würfel)

Wahrscheinlichkeiten:

(⌦, Pr) ist ein endlicher Wahrscheinlichkeitsraum.

Pr [(i, j)] =

GW

Treaps

GW

1

,

36

1 i, j 6.

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Zufallsexperiment

Ereignisse

Wahrscheinlichkeitsraum - roter und blauer Würfel

Mögliche Würfelergebnisse:

⌦ = {(i, j) : 1 i, j 6}.

(i: roter Würfel, j: blauer Würfel)

Wahrscheinlichkeiten:

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Zufallsexperiment

Ereignisse

Zufallsexperiment

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

1

,

36

Definition

Zufallsexperiment

Ereignisse

Zufallsexperiment

Definition

Ein Zufallsexperiment über (⌦, Pr) ist eine Prozedur, die beliebig

oft wiederholt werden kann und jedes Mal ein Ergebnis (Element

! 2 ⌦) produziert.

Die Wahrscheinlichkeit für das Ergebnis ! ist dabei Pr [!].

Pr [(i, j)] =

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Ein Zufallsexperiment über (⌦, Pr) ist eine Prozedur, die beliebig

oft wiederholt werden kann und jedes Mal ein Ergebnis (Element

! 2 ⌦) produziert.

Die Wahrscheinlichkeit für das Ergebnis ! ist dabei Pr [!].

1 i, j 6.

Treaps

Definition

Zufallsexperiment

Ereignisse

Zufallsexperiment

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Zufallsexperiment

Ereignisse

Zufallsexperiment - roter und blauer Würfel

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Zufallsexperiment

Ereignisse

Zufallsexperiment - roter und blauer Würfel

Definition

Ein Zufallsexperiment über (⌦, Pr) ist eine Prozedur, die beliebig

oft wiederholt werden kann und jedes Mal ein Ergebnis (Element

! 2 ⌦) produziert.

Die Wahrscheinlichkeit für das Ergebnis ! ist dabei Pr [!].

Vorstellung: Das Ergebnis wird aus einer Schale mit Kugeln

gezogen; der Anteil der Kugeln mit Beschriftung ! ist Pr [!].

GW

Treaps

Zufallsexperiment wird ausgeführt durch...

Würfeln!

Zufallsexperiment wird ausgeführt durch...

Würfeln!

GW

Treaps

GW

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Zufallsexperiment

Ereignisse

Ereignisse

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Zufallsexperiment

Ereignisse

Ereignisse

Definition

Ein Ereignis ist eine Teilmenge A ✓ ⌦ des

Wahrscheinlichkeitsraums.

Die Wahrscheinlichkeit von A ist Pr [A] :=

P

Pr [!].

Für ! 2 ⌦ ist {!} ein Elementarereignis und wird auch

einfach als ! geschrieben.

) Wenn B1 , . . . , Bk disjunkte Ereignisse sind, so gilt

" k

#

k

[

X

Pr

Bi =

Pr [Bi ].

i=1

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Die Wahrscheinlichkeit von A ist Pr [A] :=

P

i=1

i=1

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Zufallsexperiment

Ereignisse

Ereignisse

P

Definition

Zufallsexperiment

Ereignisse

Das Ereignis “Pasch” ist

!2A

) Wenn B1 , . . . , Bk disjunkte Ereignisse sind, so gilt

" k

#

k

[

X

Pr

Bi =

Pr [Bi ].

i=1

i=1

GW

Treaps

A = {(i, i) : 1 i 6}

und hat Wahrscheinlichkeit

Pr [A] = 6 ·

Das Ereignis

Die Wahrscheinlichkeit von A ist Pr [A] :=

P

!2A

Pr [!].

Für ! 2 ⌦ ist {!} ein Elementarereignis und wird auch

einfach als ! geschrieben.

) Wenn B1 , . . . , Bk disjunkte Ereignisse sind, so gilt

" k

#

k

[

X

Pr

Bi =

Pr [Bi ].

i=1

i=1

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Zufallsexperiment

Ereignisse

Ereignisse - roter und blauer Würfel

Sei Bi das Ereignis “roter Würfel zeigt i”, i = 1, 2, . . . , 6.

Pr [!].

Für ! 2 ⌦ ist {!} ein Elementarereignis und wird auch

einfach als ! geschrieben.

Pr [!].

Treaps

Ereignisse - roter und blauer Würfel

Die Wahrscheinlichkeit von A ist Pr [A] :=

!2A

Für ! 2 ⌦ ist {!} ein Elementarereignis und wird auch

einfach als ! geschrieben.

Treaps

Definition

Ein Ereignis ist eine Teilmenge A ✓ ⌦ des

Wahrscheinlichkeitsraums.

Definition

Ein Ereignis ist eine Teilmenge A ✓ ⌦ des

Wahrscheinlichkeitsraums.

) Wenn B1 , . . . , Bk disjunkte Ereignisse sind, so gilt

" k

#

k

[

X

Pr

Bi =

Pr [Bi ].

i=1

GW

Ereignisse

Definition

Ein Ereignis ist eine Teilmenge A ✓ ⌦ des

Wahrscheinlichkeitsraums.

!2A

Definition

Zufallsexperiment

Ereignisse

1

1

= .

36

6

Die Ereignissse Bi sind disjunkt, also gilt zum Beispiel

Pr [B1 [ B2 ] =

=

Pr [roter Würfel zeigt 1 oder 2]

1 1

1

Pr [B1 ] + Pr [B2 ] = + = .

6 6

3

ist ein Elementarereignis.

GW

Treaps

GW

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Zufallsexperiment

Ereignisse

Ereignisse - roter und blauer Würfel

Sei Bi das Ereignis “roter Würfel zeigt i”, i = 1, 2, . . . , 6.

Die Ereignissse Bi sind disjunkt, also gilt zum Beispiel

Pr [B1 [ B2 ] =

=

Pr [roter Würfel zeigt 1 oder 2]

1 1

1

Pr [B1 ] + Pr [B2 ] = + = .

6 6

3

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Zufallsvariablen - roter und blauer Würfel

Sei X (i, j) = i + j die Summe beider Würfelaugen.

Das Ereignis {X = 7} ist

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Zufallsvariablen

Definition

Sei S = (⌦, Pr) ein endlicher Wahrscheinlichkeitsraum. Eine

Funktion X : ⌦ ! R heisst Zufallsvariable über S.

Für eine reelle Zahl r 2 R definieren wir das Ereignis

Definition

Sei S = (⌦, Pr) ein endlicher Wahrscheinlichkeitsraum. Eine

Funktion X : ⌦ ! R heisst Zufallsvariable über S.

Für eine reelle Zahl r 2 R definieren wir das Ereignis

{X = r } := {! 2 ⌦ : X (!) = r },

{X = r } := {! 2 ⌦ : X (!) = r },

wobei wir die geschweiften Klammern in Ausdrücken oft weglassen,

z.B. in Pr [X = r ].

wobei wir die geschweiften Klammern in Ausdrücken oft weglassen,

z.B. in Pr [X = r ].

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Zufallsvariablen - roter und blauer Würfel

Sei X (i, j) = i + j die Summe beider Würfelaugen.

{X = 7} = {(1, 6), (2, 5), (3, 4), (4, 3), (5, 2), (6, 1)}.

GW

Es hat Wahrscheinlichkeit

Pr [X = 7] =

GW

6

1

= .

36

6

Treaps

GW

6

1

= .

36

6

Treaps

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Erwartungswert

Definition

Der Erwartungswert einer Zufallsvariablen ist definiert als

X

E[X ] :=

X (!) Pr [!].

!2⌦

E[X ] :=

Pr [X = 7] =

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Äquivalent,

Es hat Wahrscheinlichkeit

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Zufallsvariablen

Das Ereignis {X = 7} ist

{X = 7} = {(1, 6), (2, 5), (3, 4), (4, 3), (5, 2), (6, 1)}.

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

X

r 2R

r · Pr [X = r ],

wobei diese Summe natürlich endlich ist.

GW

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Erwartungswert

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Erwartungswert - roter und blauer Würfel

Definition

Der Erwartungswert einer Zufallsvariablen ist definiert als

X

E[X ] :=

X (!) Pr [!].

E[X ] =

!2⌦

Äquivalent,

E[X ] :=

X

r 2R

r · Pr [X = r ],

wobei diese Summe natürlich endlich ist.

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Das schwache Gesetz der grossen Zahlen

Beispiel:

(6i + 21)

Hier gilt E[X ] = 12 , ein recht untypischer und eher seltener

Wert von X .

⌦ = {0, 1},

1

36

=

1

(6 · 21 + 6 · 21) = 7.

36

i=1

GW

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

E[X ] ist im allgemeinen nicht der “typische” oder “häufigste”

Wert von X .

=

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

GW

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Was sagt E[X ] über X aus?

E[X ] ist im allgemeinen nicht der “typische” oder “häufigste”

Wert von X .

Beispiel:

Beispiel:

Pr [0] = Pr [1] = 1/2,

X (!) = !.

Hier gilt E[X ] = 12 , ein recht untypischer und eher seltener

Wert von X .

GW

Treaps

⌦ = {0, 1},

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

X (!) = !.

Treaps

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Das schwache Gesetz der grossen Zahlen

E[X ] ist im allgemeinen nicht der “typische” oder “häufigste”

Wert von X .

⌦ = {0, 1},

Pr [0] = Pr [1] = 1/2,

Treaps

Das schwache Gesetz der grossen Zahlen

Was sagt E[X ] über X aus?

Was sagt E[X ] über X aus?

1

(i + j)

36

i=1 j=1

6

X

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Das schwache Gesetz der grossen Zahlen

Sei X (i, j) = i + j die Summe beider Würfelaugen.

6 X

6

X

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Theorem

Seien !1 , !2 , . . . , !n die Ergebnisse n unabhängiger

Zufallsexperimente über (⌦, Pr). Dann gilt

n

Pr [0] = Pr [1] = 1/2,

X (!) = !.

Hier gilt E[X ] = 12 , ein recht untypischer und eher seltener

Wert von X .

GW

Treaps

1X

X (!i ) !n!1 E[X ].

n

i=1

Das heisst, der durschnittliche Wert von X über viele Experimente

konvergiert gegen den Erwartungswert.

GW

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Das schwache Gesetz der grossen Zahlen - roter und blauer

Würfel

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Linearität des Erwartungswerts

Linearität des Erwartungswerts

Theorem

Seien X1 , X2 zwei Zufallsvariablen über S = (⌦, Pr). Dann gilt

Theorem

Seien X1 , X2 zwei Zufallsvariablen über S = (⌦, Pr). Dann gilt

E[X1 + X2 ] = E[X1 ] + E[X2 ],

Nach einer Million mal würfeln (Computer):

Durschnittliche Augenzahl 7.04 ⇡ E[X ] = 7.

wobei X1 + X2 die Zufallsvariable ist, die durch

(X1 + X2 )(!) := X1 (!) + X2 (!) definiert ist.

Beweis:

X

(X1 + X2 )(!) Pr [!] =

!2⌦

=

X

X1 (!) Pr [!] +

!2⌦

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Linearität des Erwartungswerts - roter und blauer Würfel

Definiere Zufallsvariablen X1 , X2 durch

X1 (i, j) = i,

X

X

(X1 (!) + X2 (!)) Pr [!]

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

(X1 + X2 )(!) Pr [!] =

=

X

X1 (!) Pr [!] +

!2⌦

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

X

X

(X1 (!) + X2 (!)) Pr [!]

!2⌦

X2 (!) Pr [!] = E[X1 ] + E[X2 ].

!2⌦

GW

Definiere Zufallsvariablen X1 , X2 durch

X1 (i, j) = i,

X

!2⌦

X2 (!) Pr [!] = E[X1 ] + E[X2 ].

Linearität des Erwartungswerts - roter und blauer Würfel

X2 (i, j) = j.

E[X1 + X2 ] =

!2⌦

!2⌦

GW

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

E[X1 + X2 ] = E[X1 ] + E[X2 ],

wobei X1 + X2 die Zufallsvariable ist, die durch

(X1 + X2 )(!) := X1 (!) + X2 (!) definiert ist.

Beweis:

E[X1 + X2 ] =

GW

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Treaps

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Linearität des Erwartungswerts - roter und blauer Würfel

Definiere Zufallsvariablen X1 , X2 durch

X2 (i, j) = j.

X1 (i, j) = i,

X2 (i, j) = j.

X = X1 + X2 ist die Summe der Augenzahlen, mit E[X ] = 7.

Es gilt

{X1 = i} = {(i, j) : 1 j 6},

X = X1 + X2 ist die Summe der Augenzahlen, mit E[X ] = 7.

Es gilt

{X1 = i} = {(i, j) : 1 j 6},

X = X1 + X2 ist die Summe der Augenzahlen, mit E[X ] = 7.

Es gilt

{X1 = i} = {(i, j) : 1 j 6},

also

also

also

1

Pr [X1 = i] = ,

6

GW

E[X1 ] =

6

X

1

21

i = .

6

6

i=1

Treaps

1

Pr [X1 = i] = ,

6

GW

E[X1 ] =

6

X

1

21

i = .

6

6

i=1

Treaps

1

Pr [X1 = i] = ,

6

GW

E[X1 ] =

6

X

1

21

i = .

6

6

i=1

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

Linearität des Erwartungswerts - roter und blauer Würfel

Für X2 analog:

E[X2 ] =

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Linearität des Erwartungswerts - roter und blauer Würfel

Für X2 analog:

6

X

1

21

j = .

6

6

Definition

Erwartungswert

Das schwache Gesetz der grossen Zahlen

Linearität des Erwartungswerts

E[X2 ] =

j=1

Definition

Seien A, B ✓ ⌦ zwei Ereignisse, B 6= ;. Die Wahrscheinlichkeit von

A, gegeben B, ist

6

X

1

21

j = .

6

6

Pr [A | B] :=

Linearität:

42

= 7.

6

E[X ] = E[X1 + X2 ] = E[X1 ] + E[X2 ] =

Definition

Totale Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit

j=1

Linearität:

E[X ] = E[X1 + X2 ] = E[X1 ] + E[X2 ] =

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

42

= 7.

6

Pr [A \ B]

.

Pr [B]

P

Bemerkung: Es gilt !2B Pr [! | B] = 1, also definiert die

bedingte Wahrscheinlichkeitsfunktion PrB : B ! R, mit

PrB [!] = Pr [! | B]

einen bedingten Wahrscheinlichkeitsraum (B, PrB ).

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Totale Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit

Pr [A \ B]

.

Pr [B]

P

Bemerkung: Es gilt !2B Pr [! | B] = 1, also definiert die

bedingte Wahrscheinlichkeitsfunktion PrB : B ! R, mit

PrB [!] = Pr [! | B]

einen bedingten Wahrscheinlichkeitsraum (B, PrB ).

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Totale Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit - roter und blauer Würfel

Definition

Seien A, B ✓ ⌦ zwei Ereignisse, B 6= ;. Die Wahrscheinlichkeit von

A, gegeben B, ist

Pr [A | B] :=

GW

Treaps

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

Definition

Totale Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit - roter und blauer Würfel

Was ist die Wahrscheinlichkeit, einen Pasch zu würfeln (Ereignis

A), gegeben, dass wir keine 6 würfeln (Ereignis B)?

Was ist die Wahrscheinlichkeit, einen Pasch zu würfeln (Ereignis

A), gegeben, dass wir keine 6 würfeln (Ereignis B)?

Es gilt A \ B = {(1, 1), (2, 2), (3, 3), (4, 4), (5, 5)}, also

Pr [A \ B] = 5/36.

Es gilt A \ B = {(1, 1), (2, 2), (3, 3), (4, 4), (5, 5)}, also

Pr [A \ B] = 5/36.

Es folgt:

Es folgt:

Pr [B] = 1 Pr [C ], wobei C das Ereignis “6 gewürfelt” ist:

C = {(1, 6), . . . , (5, 6), (6, 6), (6, 5), . . . , (6, 1)}, also

Pr [C ] = 11/36 and Pr [B] = 25/36.

Pr [A \ B]

5 36

1

Pr [A | B] =

=

·

= .

Pr [B]

36 25

5

GW

Treaps

Pr [B] = 1 Pr [C ], wobei C das Ereignis “6 gewürfelt” ist:

C = {(1, 6), . . . , (5, 6), (6, 6), (6, 5), . . . , (6, 1)}, also

Pr [C ] = 11/36 and Pr [B] = 25/36.

Pr [A | B] =

Pr [A \ B]

5 36

1

=

·

= .

Pr [B]

36 25

5

GW

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Totale Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit - roter und blauer Würfel

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Totale Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit - roter und blauer Würfel

Theorem

Wenn B1 , . . . , Bk eine Partition von ⌦ bilden, dann gilt

Was ist die Wahrscheinlichkeit, einen Pasch zu würfeln (Ereignis

A), gegeben, dass wir keine 6 würfeln (Ereignis B)?

Was ist die Wahrscheinlichkeit, einen Pasch zu würfeln (Ereignis

A), gegeben, dass wir keine 6 würfeln (Ereignis B)?

Es gilt A \ B = {(1, 1), (2, 2), (3, 3), (4, 4), (5, 5)}, also

Pr [A \ B] = 5/36.

Es gilt A \ B = {(1, 1), (2, 2), (3, 3), (4, 4), (5, 5)}, also

Pr [A \ B] = 5/36.

Pr [B] = 1 Pr [C ], wobei C das Ereignis “6 gewürfelt” ist:

C = {(1, 6), . . . , (5, 6), (6, 6), (6, 5), . . . , (6, 1)}, also

Pr [C ] = 11/36 and Pr [B] = 25/36.

für jedes Ereignis A.

Es folgt:

Es folgt:

k

X

Pr [B] = 1 Pr [C ], wobei C das Ereignis “6 gewürfelt” ist:

C = {(1, 6), . . . , (5, 6), (6, 6), (6, 5), . . . , (6, 1)}, also

Pr [C ] = 11/36 and Pr [B] = 25/36.

Pr [A | B] =

Pr [A \ B]

5 36

1

=

·

= .

Pr [B]

36 25

5

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Pr [A | B] =

Treaps

Pr [A \ B]

5 36

1

=

·

= .

Pr [B]

36 25

5

GW

Pr [A] =

k

X

i=1

Pr [A | Bi ] Pr [Bi ],

Beweis:

i=1

Pr [A | Bi ] Pr [Bi ] =

k

X

i=1

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Totale Wahrscheinlichkeit

Definition

Totale Wahrscheinlichkeit

Pr [A \ Bi ] = Pr

GW

Totale Wahrscheinlichkeit - roter und blauer Würfel

k

[

i=1

#

(A \ Bi ) = Pr [A].

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Totale Wahrscheinlichkeit

"

Definition

Totale Wahrscheinlichkeit

Totale Wahrscheinlichkeit - roter und blauer Würfel

Theorem

Wenn B1 , . . . , Bk eine Partition von ⌦ bilden, dann gilt

Pr [A] =

k

X

i=1

Was ist die Wahrscheinlichkeit, einen Pasch zu würfeln, gegeben,

dass wir (mindestens) eine 6 würfeln?

Pr [A | Bi ] Pr [Bi ],

A = “Pasch”, B1 = “keine 6 gewürfelt”, B2 = “mindestens

eine 6 gewürfelt”

für jedes Ereignis A.

Pr [A | B1 ] =

Beweis:

k

X

i=1

Pr [A | Bi ] Pr [Bi ] =

k

X

i=1

Pr [A \ Bi ] = Pr

GW

Treaps

"

k

[

i=1

#

(A \ Bi ) = Pr [A].

1

5,

Pr [B1 ] =

25

36 ,

Pr [B2 ] =

11

36 ,

Pr [A] =

1

6.

Es folgt:

Pr [A | B2 ] =

Was ist die Wahrscheinlichkeit, einen Pasch zu würfeln, gegeben,

dass wir (mindestens) eine 6 würfeln?

A = “Pasch”, B1 = “keine 6 gewürfelt”, B2 = “mindestens

eine 6 gewürfelt”

Pr [A | B1 ] = 15 , Pr [B1 ] =

25

36 ,

Pr [B2 ] =

11

36 ,

Pr [A] = 16 .

Es folgt:

Pr [A]

GW

Pr [A | B1 ] Pr [B1 ]

1

= .

Pr [B2 ]

11

Treaps

Pr [A | B2 ] =

Pr [A]

GW

Pr [A | B1 ] Pr [B1 ]

1

= .

Pr [B2 ]

11

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Totale Wahrscheinlichkeit

Totale Wahrscheinlichkeit - roter und blauer Würfel

Was ist die Wahrscheinlichkeit, einen Pasch zu würfeln, gegeben,

dass wir (mindestens) eine 6 würfeln?

A = “Pasch”, B1 = “keine 6 gewürfelt”, B2 = “mindestens

eine 6 gewürfelt”

Pr [A | B1 ] = 15 , Pr [B1 ] =

25

36 ,

Pr [B2 ] =

11

36 ,

Pr [A] = 16 .

Es folgt:

Pr [A | B2 ] =

Pr [A]

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Pr [A | B1 ] Pr [B1 ]

1

= .

Pr [B2 ]

11

Definition

Was ist die erwartete Augenzahl, gegeben, dass die beiden Würfel

sich um genau 1 unterscheiden?

B=

{(1, 2), (2, 3), (3, 4), (4, 5), (5, 6), (2, 1), (3, 2), (4, 3), (5, 4), (6, 5)}.

Für alle ! 2 B gilt

Pr [!]

1/36

1

PrB [!] = Pr [! | B] =

=

= .

Pr [B]

10/36

10

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Bedingter Erwartungswert

Definition

Bedingter Erwartungswert

Definition

Sei X eine Zufallsvariable und B ein nichtleeres Ereignis. Der

Erwartungswert von X , gegeben B, ist

X

X

E[X | B] :=

X (!) Pr [! | B] =

X (!) PrB [!]

Definition

Sei X eine Zufallsvariable und B ein nichtleeres Ereignis. Der

Erwartungswert von X , gegeben B, ist

X

X

E[X | B] :=

X (!) Pr [! | B] =

X (!) PrB [!]

Bemerkung: E[X | B] ist also der “normale” Erwartungswert von

X |B (Einschränkung von X auf B) über dem bedingten

Wahrscheinlichkeitsraum (B, PrB ).

Bemerkung: E[X | B] ist also der “normale” Erwartungswert von

X |B (Einschränkung von X auf B) über dem bedingten

Wahrscheinlichkeitsraum (B, PrB ).

!2⌦

Treaps

Bedingter Erwartungswert - roter und blauer Würfel

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

!2B

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

!2B

Treaps

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Bedingter Erwartungswert - roter und blauer Würfel

Was ist die erwartete Augenzahl, gegeben, dass die beiden Würfel

sich um genau 1 unterscheiden?

B=

{(1, 2), (2, 3), (3, 4), (4, 5), (5, 6), (2, 1), (3, 2), (4, 3), (5, 4), (6, 5)}.

Für alle ! 2 B gilt

Pr [!]

1/36

1

PrB [!] = Pr [! | B] =

=

= .

Pr [B]

10/36

10

GW

!2⌦

Treaps

Treaps

Definition

Bedingter Erwartungswert - roter und blauer Würfel

Was ist die erwartete Augenzahl, gegeben, dass die beiden Würfel

sich um genau 1 unterscheiden?

Also

E[X | B] =

5

X

5

(2i + 1)

i=1

X

1

1

+

(2j + 1) = 7.

10

10

j=1

GW

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Bedingter Erwartungswert - roter und blauer Würfel

Was ist die erwartete Augenzahl, gegeben, dass die beiden Würfel

sich um genau 1 unterscheiden?

Also

E[X | B] =

5

X

5

(2i + 1)

i=1

X

1

1

+

(2j + 1) = 7.

10

10

Bedingter Erwartungswert - roter und blauer Würfel

Was ist die erwartete Augenzahl, gegeben, dass die beiden Würfel

sich um genau 1 unterscheiden?

Definition

Wenn B1 , . . . , Bk eine Partition von ⌦ bilden, dann gilt für jede

Zufallsvariable X :

E[X ] =

E[X | B] =

5

X

(2i + 1)

i=1

1

+

10

5

X

(2j + 1)

1

= 7.

10

Interpretation: Selbst wenn Ihr Kollege, der verdeckt wüfelt,

Ihnen stets die Di↵erenz der beiden Würfel nennt, können Sie

langfristig keine bessere Vorhersage machen als 7.

Beweis:

k

X

i=1

=

X

E[X | Bi ] Pr [Bi ] =

X (!)

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Treaps

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

Totaler Erwartungswert

Definition

Wenn B1 , . . . , Bk eine Partition von ⌦ bilden, dann gilt für jede

Zufallsvariable X :

E[X ] =

k

X

i=1

Beweis:

k

X

i=1

=

X

!2⌦

E[X | Bi ] Pr [Bi ] =

X (!)

k

X

i=1

i=1

X

!2⌦

X (!) Pr [! | Bi ]

Pr [! | Bi ] Pr [Bi ] =

GW

Treaps

X

!2⌦

Pr [Bi ]

X (!) Pr [!] = E[X ].

k

X

i=1

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

X

!2⌦

X (!) Pr [! | Bi ]

X

Pr [! | Bi ] Pr [Bi ] =

Treaps

!

Pr [Bi ]

X (!) Pr [!] = E[X ].

!2⌦

Treaps

Definition

Totaler Erwartungswert - roter und blauer Würfel

Sei X (i, j) = ij das Produkt der beiden Augenzahlen, Bi das

Ereignis “roter Würfel zeigt i”.

Sei X (i, j) = ij das Produkt der beiden Augenzahlen, Bi das

Ereignis “roter Würfel zeigt i”.

1

Pr [Bi ] = .

6

Bi = {(i, j) : 1 j 6};

!

E[X | Bi ] Pr [Bi ].

Totaler Erwartungswert - roter und blauer Würfel

E[X | Bi ] Pr [Bi ].

k

X

k

X

i=1

!2⌦

GW

k

X

i=1

j=1

Definition

Totaler Erwartungswert

Also

j=1

Es kommt auch 7 heraus, gegeben, dass die beiden Würfel

sich um eine feste Zahl unterscheiden.

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Definition

E[X | Bi ] =

E[X ] =

P6

P6

i=1

j=1 ij

Pr [(i, j) | Bi ] =

|

{z

}

1/6

E[X | Bi ] Pr [Bi ] =

GW

P6

Treaps

21i

6 .

21i 1

i=1 6 6

E[X | Bi ] =

=

21·21

36

1

Pr [Bi ] = .

6

Bi = {(i, j) : 1 j 6};

=

49

4 .

E[X ] =

P6

P6

i=1

j=1 ij

Pr [(i, j) | Bi ] =

|

{z

}

1/6

E[X | Bi ] Pr [Bi ] =

GW

P6

Treaps

21i

6 .

21i 1

i=1 6 6

=

21·21

36

=

49

4 .

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Satz

Markov-Ungleichung

Markov-Ungleichung

Definition

Sei X eine nichtnegative Zufallsvariable (d.h. X (!)

! 2 ⌦). Dann gilt

1

Pr [X > t E[X ]] < ,

t

t

0 für alle

1

Pr [X > t E[X ]] < ,

t

Nach dem

E[X | B1 ] Pr [B1 ] + E[X | B2 ] Pr [B2 ]

E[X ] =

Umformen: Pr [X > t E[X ]] < 1t .

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

1

Pr [X > t E[X ]] < ,

t

1.

Nach dem

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Satz

t

E[X ] =

1.

E[X | B1 ] Pr [B1 ] + E[X | B2 ] Pr [B2 ]

E[X | B1 ] Pr [B1 ] + E[X | B2 ] Pr [B2 ]

Umformen: Pr [X > t E[X ]] < 1t .

GW

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Satz

Treaps

Satz

Markov-Ungleichung - roter und blauer Würfel

Nach dem

> t E[X ] Pr [B1 ] + 0 = t E[X ] Pr [X > t E[X ]].

Die Wahrscheinlichkeit, 10 oder mehr Augen zu würfeln, beträgt

für alle " > 0 höchstens

10 "

7

Pr X >

·7 <

.

7

10 "

Also

7

.

10

Das ist nicht die bestmögliche Schranke; die Markov-Ungleichung

ist meistens nicht “scharf”.

Pr [X

10]

Die Wahrscheinlichkeit, 10 oder mehr Augen zu würfeln, beträgt

für alle " > 0 höchstens

10 "

7

Pr X >

·7 <

.

7

10 "

Also

7

.

10

Das ist nicht die bestmögliche Schranke; die Markov-Ungleichung

ist meistens nicht “scharf”.

Pr [X

10]

Umformen: Pr [X > t E[X ]] < 1t .

Treaps

Nach dem

0 für alle

Beweis: B1 = {X > t E[X ]} und B2 = {X t E[X ]}.

Satz vom totalem Erwartungswert gilt

GW

1.

> t E[X ] Pr [B1 ] + 0 = t E[X ] Pr [X > t E[X ]].

Treaps

Markov-Ungleichung - roter und blauer Würfel

1

Pr [X > t E[X ]] < ,

t

t

0 für alle

Beweis: B1 = {X > t E[X ]} und B2 = {X t E[X ]}.

Satz vom totalem Erwartungswert gilt

E[X | B1 ] Pr [B1 ] + E[X | B2 ] Pr [B2 ]

Umformen: Pr [X > t E[X ]] < 1t .

Definition

Sei X eine nichtnegative Zufallsvariable (d.h. X (!)

! 2 ⌦). Dann gilt

Definition

Sei X eine nichtnegative Zufallsvariable (d.h. X (!)

! 2 ⌦). Dann gilt

> t E[X ] Pr [B1 ] + 0 = t E[X ] Pr [X > t E[X ]].

Treaps

Markov-Ungleichung

E[X ] =

t

0 für alle

Beweis: B1 = {X > t E[X ]} und B2 = {X t E[X ]}.

Satz vom totalem Erwartungswert gilt

> t E[X ] Pr [B1 ] + 0 = t E[X ] Pr [X > t E[X ]].

Satz

Markov-Ungleichung

Definition

Sei X eine nichtnegative Zufallsvariable (d.h. X (!)

! 2 ⌦). Dann gilt

1.

Beweis: B1 = {X > t E[X ]} und B2 = {X t E[X ]}.

Satz vom totalem Erwartungswert gilt

E[X ] =

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Satz

GW

Treaps

GW

Treaps

Endlicher Wahrscheinlichkeitsraum

Zufallsvariablen

Bedingte Wahrscheinlichkeit

Bedingter Erwartungswert

Markov-Ungleichung

Zufällige Suchbäume

Zurück zu Treaps

Satz

Markov-Ungleichung - roter und blauer Würfel

Die Wahrscheinlichkeit, 10 oder mehr Augen zu würfeln, beträgt

für alle " > 0 höchstens

10 "

7

Pr X >

·7 <

.

7

10 "

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zur Erinnerung...

Zufällige Suchbäume

Zurück zu Treaps

Konstruktion eines zufälligen Suchbaums BS mit

Schlüsselmenge S

Binäre Suchbäume können gut (kleine Höhe) oder schlecht (grosse

Höhe) sein.

Definition

BS

8

leer,

>

>

>

>

>

>

<

=

Also

7

Pr [X 10] .

10

Das ist nicht die bestmögliche Schranke; die Markov-Ungleichung

ist meistens nicht “scharf”.

GW

Zufällige Suchbäume

Zurück zu Treaps

Treaps

S <x

Konstruktion eines zufälligen Suchbaums BS mit

Schlüsselmenge S

=

BS <x

BS >x

x 2 S zufällig, sonst.

:= {s 2 S : s < x}

Zufällige Suchbäume

Zurück zu Treaps

Treaps

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Wahrscheinlichkeitsraum der BS

Zufällige Suchbäume

Zurück zu Treaps

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Wahrscheinlichkeitsraum der BS

Für festes S bilden die möglichen Bäume BS einen

Wahrscheinlichkeitsraum ⌦.

Definition

BS

>

>

>

>

>

>

:

falls S = ;, und

x

S >x := {s 2 S : s > x}

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

8

leer,

>

>

>

>

>

>

<

>

>

>

>

>

>

:

BS <x

falls S = ;, und

x

BS >x

Beispiel: S = {1, 2, 3}.

Für festes S bilden die möglichen Bäume BS einen

Wahrscheinlichkeitsraum ⌦.

5 mögliche Bäume mit ihren Wahrscheinlichkeiten

1

6

x 2 S zufällig, sonst.

1

6

1

3

1

6

1

6

1/3: Schlüssel in der Wurzel ist 2.

1/6 (links): Schlüssel in der Wurzel ist 1, Schlüssel im rechten

Kind ist 2.

S <x := {s 2 S : s < x}

S >x := {s 2 S : s > x}

GW

Treaps

GW

Treaps

GW

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Wahrscheinlichkeitsraum der BS

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Wahrscheinlichkeitsraum der BS

Rang eines Elements

Für festes S bilden die möglichen Bäume BS einen

Wahrscheinlichkeitsraum ⌦.

Für festes S bilden die möglichen Bäume BS einen

Wahrscheinlichkeitsraum ⌦.

Beispiel: S = {1, 2, 3}.

Beispiel: S = {1, 2, 3}.

5 mögliche Bäume mit ihren Wahrscheinlichkeiten

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Definition

Für S ✓ R ist der Rang von x 2 S definiert als

5 mögliche Bäume mit ihren Wahrscheinlichkeiten

rg(x) = rgS (x) := 1 + |{y 2 S : y < x}| .

1

6

1

6

1

3

1

6

1

6

1

6

1

6

1

3

1

6

1

6

1/3: Schlüssel in der Wurzel ist 2.

1/3: Schlüssel in der Wurzel ist 2.

1/6 (links): Schlüssel in der Wurzel ist 1, Schlüssel im rechten

Kind ist 2.

1/6 (links): Schlüssel in der Wurzel ist 1, Schlüssel im rechten

Kind ist 2.

GW

Zufällige Suchbäume

Zurück zu Treaps

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Rang eines Elements

GW

Zufällige Suchbäume

Zurück zu Treaps

Das heisst, das kleinste Element von S hat Rang 1.

Für einen Baumknoten v ist rg(v ) der Rang seines Schlüssels.

Treaps

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Rang eines Elements

Zufällige Suchbäume

Zurück zu Treaps

rg(x) = rgS (x) := 1 + |{y 2 S : y < x}| .

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Tiefe eines Schlüssels in BS

BS

Definition

Für S ✓ R ist der Rang von x 2 S definiert als

Treaps

Definition

Für S ✓ R ist der Rang von x 2 S definiert als

rg(x) = rgS (x) := 1 + |{y 2 S : y < x}| .

Das heisst, das kleinste Element von S hat Rang 1.

Das heisst, das kleinste Element von S hat Rang 1.

Für einen Baumknoten v ist rg(v ) der Rang seines Schlüssels.

Für einen Baumknoten v ist rg(v ) der Rang seines Schlüssels.

=

8

leer,

>

>

>

<

>

>

>

:

BS <x

falls S = ;, und

x

BS >x

x 2 S zufällig, sonst.

Definition

Die Zahl dBS (y ) definiert durch

8

falls y = x,

< 0,

1 + dBS <x (y ), falls y < x, und

dBS (y ) :=

:

1 + dBS >x (y ), sonst.

heisst Tiefe von y bzgl. BS .

GW

Treaps

GW

Treaps

GW

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufallsvariable für die Tiefe des Schlüssels vom Rang i

Definition

Zufällige Suchbäume

Zurück zu Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Zufallsvariable für die Tiefe des Schlüssels vom Rang i

Definition

(i)

Seien i, n 2 N, i n. Dn ist die Zufallsvariable für die Tiefe des

Schlüssels vom Rang i in BS .

(1)

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufallsvariable für die Tiefe des Schlüssels vom Rang i

Definition

(i)

Seien i, n 2 N, i n. Dn ist die Zufallsvariable für die Tiefe des

Schlüssels vom Rang i in BS .

(1)

(i)

Seien i, n 2 N, i n. Dn ist die Zufallsvariable für die Tiefe des

Schlüssels vom Rang i in BS .

(1)

Dn := Dn ist die Zufallsvariable für die Tiefe des kleinsten

Schlüssels in BS .

Dn := Dn ist die Zufallsvariable für die Tiefe des kleinsten

Schlüssels in BS .

Dn := Dn ist die Zufallsvariable für die Tiefe des kleinsten

Schlüssels in BS .

Ziel: Berechne E[Dn ], die erwartete Tiefe des kleinsten Schlüssels!

Ziel: Berechne E[Dn ], die erwartete Tiefe des kleinsten Schlüssels!

Ziel: Berechne E[Dn ], die erwartete Tiefe des kleinsten Schlüssels!

GW

Zufällige Suchbäume

Zurück zu Treaps

Treaps

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Kleine Fälle

Zufällige Suchbäume

Zurück zu Treaps

Treaps

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Kleine Fälle

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Die Rekursionsgleichung

Ereignis Bi : Rang der Wurzel ist i.

Nach totalem Erwartungswert gilt:

E[D1 ] = 0.

E[D2 ] =

E[D1 ] = 0.

E[D2 ] =

E[D3 ] =

1

2

1

6

·1+

·0+

1

2

1

6

· 0 = 12 .

·0+

1

3

·1+

E[D3 ] =

1

6

·1+

1

6

1

2

1

6

·1+

·0+

1

2

1

6

· 0 = 12 .

·0+

1

3

·1+

1

6

·1+

1

6

E[Dn ] =

· 2 = 56 .

i=1

· 2 = 56 .

E[Dn | Bi ] =

1

6

GW

Treaps

1

6

1

3

GW

Treaps

1

6

n

X

1

6

⇢

E[Dn | Bi ] · Pr [Bi ] .

| {z

} | {z }

0,

1 + E[Di

=1/n

falls i = 1, und

,

1 ], sonst.

Beweis: die erwartete Tiefe des kleinsten Schlüssels, gegeben, dass

die Wurzel x von BS Rang i > 1 hat, ist 1 plus die erwartete Tiefe

des kleinsten Schlüssels in BS <x , einem zufälligen Suchbaum mit

i 1 Schlüsseln.

GW

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Die Rekursionsgleichung

Ereignis Bi : Rang der Wurzel ist i.

Nach totalem Erwartungswert gilt:

n

X

i=1

E[Dn | Bi ] =

E[Dn | Bi ] · Pr [Bi ] .

| {z

} | {z }

0,

1 + E[Di

E[Dn ] =

1 ],

falls i = 1, und

,

sonst.

E[Dn | Bi ] =

Beweis: die erwartete Tiefe des kleinsten Schlüssels, gegeben, dass

die Wurzel x von BS Rang i > 1 hat, ist 1 plus die erwartete Tiefe

des kleinsten Schlüssels in BS <x , einem zufälligen Suchbaum mit

i 1 Schlüsseln.

GW

Zufällige Suchbäume

Zurück zu Treaps

n

X

i=1

=1/n

⇢

1 ],

falls i = 1, und

,

sonst.

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Für n 2 N, n

1)dn

1

= (n

1) + d1 + d2 + . . . + dn

2

2) + d1 + d2 + . . . + dn

2

GW

Treaps

+ dn

1,

Für n 2 N, n

(n

1)dn

1

= (n

= (n

1) + d1 + d2 + . . . + dn

2

2) + d1 + d2 + . . . + dn

2

+ dn

1,

und

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

3 gilt

ndn = (n

(n

3 gilt

ndn = (n

1

Zufällige Suchbäume

Zurück zu Treaps

hergeleitet. Um diese zu lösen, benutzen wir nun einen typischen

Trick.

und

1)dn

Berechnung von E[Dn ]

Für n 2 N, n

3 gilt

(n

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Berechnung von E[Dn ]

hergeleitet. Um diese zu lösen, benutzen wir nun einen typischen

Trick.

3 gilt

ndn = (n

GW

Sei dn := E[Dn ]. Wir haben die Rekursionsgleichung

⇢

0,P

falls n = 1, und

dn =

n

1

i=2 (1 + di 1 ), sonst.

n

(n

Für n 2 N, n

Treaps

Sei dn := E[Dn ]. Wir haben die Rekursionsgleichung

⇢

0,P

falls n = 1, und

dn =

n

1

i=2 (1 + di 1 ), sonst.

n

ndn = (n

hergeleitet. Um diese zu lösen, benutzen wir nun einen typischen

Trick.

=1/n

Beweis: die erwartete Tiefe des kleinsten Schlüssels, gegeben, dass

die Wurzel x von BS Rang i > 1 hat, ist 1 plus die erwartete Tiefe

des kleinsten Schlüssels in BS <x , einem zufälligen Suchbaum mit

i 1 Schlüsseln.

GW

Berechnung von E[Dn ]

Sei dn := E[Dn ]. Wir haben die Rekursionsgleichung

⇢

0,P

falls n = 1, und

dn =

n

1

i=2 (1 + di 1 ), sonst.

n

E[Dn | Bi ] · Pr [Bi ] .

| {z

} | {z }

0,

1 + E[Di

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Berechnung von E[Dn ]

Nach totalem Erwartungswert gilt:

⇢

Zufällige Suchbäume

Zurück zu Treaps

Die Rekursionsgleichung

Ereignis Bi : Rang der Wurzel ist i.

E[Dn ] =

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

1)dn

1

= (n

1) + d1 + d2 + . . . + dn

2

2) + d1 + d2 + . . . + dn

2

Subtraktion:

ndn

1) + d1 + d2 + . . . + dn

2

2) + d1 + d2 + . . . + dn

2

GW

Treaps

+ dn

1,

und

+ dn

(n

1)dn

, ndn = 1 + ndn

1

, dn = + dn 1

n

GW

1

= 1 + dn

1

für n

Treaps

3.

1

1,

und

Zufällige Suchbäume

Zurück zu Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Berechnung von E[Dn ]

Für n 2 N, n

(n

1)dn

1

Berechnung von E[Dn ]

3 gilt

Wir haben: dn =

ndn = (n

= (n

1) + d1 + d2 + . . . + dn

2

2) + d1 + d2 + . . . + dn

2

+ dn

1,

und

(n

1)dn

, ndn = 1 + ndn

1

, dn = + dn 1

n

GW

Zufällige Suchbäume

Zurück zu Treaps

1

= 1 + dn

1

n

+ dn

=

1

1

für n

1

2

3.

für n

3.

1

1

1

+ dn 1 = +

+ dn 2 = · · ·

n

n n 1

1

1

1

+

+ . . . + + d2 = Hn 1,

n n 1

3 |{z}

wobei Hn :=

Pn

1

i=1 i

die n-te Harmonische Zahl ist.

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Berechnung von E[Dn ]

GW

Zufällige Suchbäume

Zurück zu Treaps

Theorem

Die erwartete Tiefe des kleinsten Schlüssels in einem zufälligen

Suchbaum über n Schlüsseln beträgt

1 ln n.

Achtung: Das heisst aber noch lange nicht, dass jeder Schlüssel

erwartetete logarithmische Tiefe hat, und erst recht nicht, dass die

erwartete Höhe (das Maximum aller Tiefen) im Erwartungswert

logarithmisch in n ist.

GW

Treaps

+ dn

1

für n

Zusammen mit d1 = 0 und d2 =

3.

1

2

bekommen wir

1

1

1

+ dn 1 = +

+ dn 2 = · · ·

n

n n 1

1

1

1

+

+ . . . + + d2 = Hn 1,

n n 1

3 |{z}

dn =

=

1/2

wobei Hn :=

Pn

1

i=1 i

Treaps

die n-te Harmonische Zahl ist.

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Berechnung von E[Dn ]

Hn

1

n

Wir haben: dn =

bekommen wir

1/2

1

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Berechnung von E[Dn ]

Zusammen mit d1 = 0 und d2 =

dn =

Subtraktion:

ndn

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Zufallsvariable für die Höhe

Theorem

Die erwartete Tiefe des kleinsten Schlüssels in einem zufälligen

Suchbaum über n Schlüsseln beträgt

1 ln n.

Hn

Achtung: Das heisst aber noch lange nicht, dass jeder Schlüssel

erwartetete logarithmische Tiefe hat, und erst recht nicht, dass die

erwartete Höhe (das Maximum aller Tiefen) im Erwartungswert

logarithmisch in n ist.

GW

Treaps

Seien i, n 2 N, i n.

n

(i)

Xn := max Dn

i=1

ist die Zufallsvariable für die Höhe von BS .

E[Xn ] scheint aufgrund des Maximums schwierig zu sein.

Es gilt nicht

E[max(X1 , X2 )] = max( E[X1 ], E[X2 ]).

Im Gegenteil, das ist im allgemeinen völlig falsch.

GW

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Zufallsvariable für die Höhe

Seien i, n 2 N, i n.

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Zufallsvariable für die Höhe

n

Seien i, n 2 N, i n.

(i)

Xn := max Dn

i=1

n

h i

E[Xn ] = log 2 E[Xn ] log E 2Xn

(i)

Xn := max Dn

2

h

i

(i)

n

= log E 2maxi=1 Dn log E4

ist die Zufallsvariable für die Höhe von BS .

E[Xn ] scheint aufgrund des Maximums schwierig zu sein.

E[Xn ] scheint aufgrund des Maximums schwierig zu sein.

Es gilt nicht

Es gilt nicht

E[max(X1 , X2 )] = max( E[X1 ], E[X2 ]).

Treaps

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Zufällige Suchbäume

Zurück zu Treaps

Noch ein Trick...

n

(i)

(i)

n

2maxi=1 Dn = max 2Dn =

h

= log E 2

(i)

maxni=1 Dn

i

2

log E4

n

X

(i)

Dn

2

i=1, i ist Blatt

3

5.

Definiere

(i)

n

(i)

2maxi=1 Dn = max 2Dn =

i=1

n

GW

2

h

i

(i)

n

= log E 2maxi=1 Dn log E4

n

X

n

X

i=1, i ist Blatt

(i)

3

2Dn 5.

(i)

2Dn .

i=1, i ist Blatt

max

i=1, i ist Blatt

Treaps

(i)

2Dn

n

X

i=1, i ist Blatt

(i)

2D n .

3

Zufällige Suchbäume

Zurück zu Treaps

2Dn

n

X

(i)

2D n .

i=1, i ist Blatt

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Noch ein Trick...

Zn :=

Zweites :

i=1, i ist Blatt

(i)

n

max

i=1, i ist Blatt

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

h i

E[Xn ] = log 2 E[Xn ] log E 2Xn

Erstes : Jensens Ungleichung

n

Treaps

Noch ein Trick...

h i

E[Xn ] = log 2 E[Xn ] log E 2Xn

(i)

2Dn 5.

Zweites :

Im Gegenteil, das ist im allgemeinen völlig falsch.

i=1

GW

n

X

Erstes : Jensens Ungleichung

E[max(X1 , X2 )] = max( E[X1 ], E[X2 ]).

Im Gegenteil, das ist im allgemeinen völlig falsch.

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Noch ein Trick...

i=1

ist die Zufallsvariable für die Höhe von BS .

Zufällige Suchbäume

Zurück zu Treaps

die Summe der “exponentiellen Tiefen” aller Blätter.

Z0 = 0, Z1 = 1 (ein Blatt, mit exponentieller Tiefe 20 = 1)

Z2 = 2 (ein Blatt, mit exponentieller Tiefe 21 = 2)

E[Z3 ] = 4.

GW

Treaps

h i

E[Xn ] = log 2 E[Xn ] log E 2Xn

Definiere

2

h

i

(i)

n

= log E 2maxi=1 Dn log E4

n

X

Zn :=

n

X

i=1, i ist Blatt

(i)

3

2Dn 5.

(i)

2Dn .

i=1, i ist Blatt

die Summe der “exponentiellen Tiefen” aller Blätter.

Z0 = 0, Z1 = 1 (ein Blatt, mit exponentieller Tiefe 20 = 1)

Z2 = 2 (ein Blatt, mit exponentieller Tiefe 21 = 2)

E[Z3 ] = 4.

GW

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Noch ein Trick...

2

h

i

(i)

n

= log E 2maxi=1 Dn log E4

n

X

Zn :=

(i)

Dn

2

n

X

i=1, i ist Blatt

(i)

3

2Dn 5.

h i

E[Xn ] = log 2 E[Xn ] log E 2Xn

Definiere

GW

Zufällige Suchbäume

Zurück zu Treaps

2

h

i

(i)

n

= log E 2maxi=1 Dn log E4

n

X

Zn :=

.

(i)

Dn

2

n

X

i=1, i ist Blatt

(i)

3

2Dn 5.

Treaps

GW

Zufällige Suchbäume

Zurück zu Treaps

2( E[Zi

1 ]+ E[Zn i ])

=1/n

Beweis: Gegeben, dass die Wurzel x Rang i hat, sind BS <x und

BS >x zufällige Suchbäume mit jeweils i 1 und n i Schlüsseln,

deren Blätter zusammen genau die Blätter von BS enthalten. Die

exponentielle Tiefe jedes Blattes ist in BS doppelt so gross wie im

entsprechenden Teilbaum.

GW

Treaps

E[Zn ] =

n

X

i=1

2

(i)

i=1, i ist Blatt

3

2Dn 5.

.

die Summe der “exponentiellen Tiefen” aller Blätter.

Z0 = 0, Z1 = 1 (ein Blatt, mit exponentieller Tiefe 20 = 1)

Z2 = 2 (ein Blatt, mit exponentieller Tiefe 21 = 2)

E[Z3 ] = 4.

Treaps

GW

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Berechnung von E[Zn ]

E[Z | rg(Wurzel) = i] · Pr [rg(Wurzel) = i] .

| n

{z

} |

{z

}

2( E[Zi

(i)

Dn

n

X

i=1, i ist Blatt

Lemma

Für n 2,

E[Z | rg(Wurzel) = i] · Pr [rg(Wurzel) = i] .

| n

{z

} |

{z

}

n

X

Zn :=

Die Rekursionsgleichung

Lemma

Für n 2,

i=1

Definiere

2

h

i

(i)

n

= log E 2maxi=1 Dn log E4

.

die Summe der “exponentiellen Tiefen” aller Blätter.

Z0 = 0, Z1 = 1 (ein Blatt, mit exponentieller Tiefe 20 = 1)

Z2 = 2 (ein Blatt, mit exponentieller Tiefe 21 = 2)

E[Z3 ] = 4.

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

h i

E[Xn ] = log 2 E[Xn ] log E 2Xn

i=1, i ist Blatt

Die Rekursionsgleichung

n

X

Zufällige Suchbäume

Zurück zu Treaps

Noch ein Trick...

i=1, i ist Blatt

die Summe der “exponentiellen Tiefen” aller Blätter.

Z0 = 0, Z1 = 1 (ein Blatt, mit exponentieller Tiefe 20 = 1)

Z2 = 2 (ein Blatt, mit exponentieller Tiefe 21 = 2)

E[Z3 ] = 4.

E[Zn ] =

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Noch ein Trick...

h i

E[Xn ] = log 2 E[Xn ] log E 2Xn

Definiere

Zufällige Suchbäume

Zurück zu Treaps

1 ]+ E[Zn i ])

=1/n

Beweis: Gegeben, dass die Wurzel x Rang i hat, sind BS <x und

BS >x zufällige Suchbäume mit jeweils i 1 und n i Schlüsseln,

deren Blätter zusammen genau die Blätter von BS enthalten. Die

exponentielle Tiefe jedes Blattes ist in BS doppelt so gross wie im

entsprechenden Teilbaum.

GW

Treaps

Sei zn := E[Zn ]. Wir haben die Rekursionsgleichung

8

falls n = 0,

< 0,

1,

falls n = 1, und

zn =

: 4 Pn

i=1 zi 1 , sonst.

n

hergeleitet. Um diese zu lösen, benutzen wir nun einen typischen

Trick. Für n 2 N, n 3 gilt

nzn = 4(z0 + z1 + . . . + zn

(n

1)zn

1

= 4(z0 + z1 + . . . + zn

GW

Treaps

2

+ zn

2)

1 ),

und

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Berechnung von E[Zn ]

Berechnung von E[Zn ]

Sei zn := E[Zn ]. Wir haben die Rekursionsgleichung

8

falls n = 0,

< 0,

1,

falls n = 1, und

zn =

: 4 Pn

z

,

sonst.

i

1

i=1

n

hergeleitet. Um diese zu lösen, benutzen wir nun einen typischen

Trick. Für n 2 N, n 3 gilt

nzn = 4(z0 + z1 + . . . + zn

(n

1)zn

1

= 4(z0 + z1 + . . . + zn

GW

2

+ zn

1 ),

2)

1

(n

= 4(z0 + z1 + . . . + zn

2

+ zn

1 ),

(n

und

2)

= 4(z0 + z1 + . . . + zn

+ zn

1 ),

und

2)

1)zn

1

= 4zn

2

+ zn

1 ),

und

2)

nzn

(n

1)zn

1

= 4zn

1

GW

Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Berechnung von E[Zn ]

Theorem

Die erwartete Summe der exponentiellen Tiefen aller Blätter in

einem Suchbaum über n Schlüsseln beträgt

Theorem

Die erwartete Summe der exponentiellen Tiefen aller Blätter in

einem Suchbaum über n Schlüsseln beträgt

(n + 3)(n + 2)(n + 1)

.

30

1

, nzn = (n + 3)zn 1

zn

zn 1

z2

1

,

=

= ··· =

=

.

(n + 3)(n + 2)(n + 1)

(n + 2)(n + 1)n

5·4·3

30

GW

= 4(z0 + z1 + . . . + zn

, nzn = (n + 3)zn 1

zn

zn 1

z2

1

,

=

= ··· =

=

.

(n + 3)(n + 2)(n + 1)

(n + 2)(n + 1)n

5·4·3

30

(n + 3)(n + 2)(n + 1)

.

30

1)zn

1

Subtraktion:

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Berechnung von E[Zn ]

2

3 gilt

nzn = 4(z0 + z1 + . . . + zn

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Subtraktion:

nzn

1

GW

3 gilt

1)zn

1)zn

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

nzn = 4(z0 + z1 + . . . + zn

(n

nzn = 4(z0 + z1 + . . . + zn

(n

Berechnung von E[Zn ]

Für n 2 N, n

hergeleitet. Um diese zu lösen, benutzen wir nun einen typischen

Trick. Für n 2 N, n 3 gilt

und

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Berechnung von E[Zn ]

Sei zn := E[Zn ]. Wir haben die Rekursionsgleichung

8

falls n = 0,

< 0,

1,

falls n = 1, und

zn =

: 4 Pn

z

,

sonst.

i

1

i=1

n

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Für n 2 N, n

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Zufällige Suchbäume

Zurück zu Treaps

Treaps

2

E[Xn ] log E4

n

X

i=1, i ist Blatt

3

(n + 3)(n + 2)(n + 1)

2Dn 5 = log

< 3 log n.

30

(i)

GW

Treaps

2

E[Xn ] log E4

n

X

i=1, i ist Blatt

3

(n + 3)(n + 2)(n + 1)

2Dn 5 = log

< 3 log n.

30

(i)

GW

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

Berechnung von E[Xn ]

Zufällige Suchbäume

Zurück zu Treaps

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

“Tail Estimates”

Theorem

Die erwartete Höhe eines zufälligen Suchbaums über n Schlüsseln

beträgt höchstens

3 log2 n.

GW

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Markov-Ungleichung:

(n + 3)(n + 2)(n + 1)

1

Pr Zn > n ·

< .

30

n

Das heisst:

1

,

n

somit gilt, dass die Höhe nicht nur im Erwartungswert, sondern mit

hoher Wahrscheinlichkeit proportional zu log2 n ist!

Pr [Xn > 4 log2 n] <

GW

Treaps

Markov-Ungleichung:

(n + 3)(n + 2)(n + 1)

1

Pr Zn > n ·

< .

30

n

Das heisst:

1

,

n

somit gilt, dass die Höhe nicht nur im Erwartungswert, sondern mit

hoher Wahrscheinlichkeit proportional zu log2 n ist!

Pr [Xn > 4 log2 n] <

GW

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Was bedeutet das für Treaps?

Treap: Suchbaum über n Schlüsseln,

Gute und schlechte Bäume

Konstruktion

Wahrscheinlichkeitsraum

Erwartete Tiefe des kleinsten Schlüssels

Erwartete Höhe eines zufälligen Suchbaums

“Tail Estimates”

Zufällige Suchbäume

Zurück zu Treaps

Was bedeutet das für Treaps?

Zufällige Suchbäume

Zurück zu Treaps

Was bedeutet das für Treaps?

Treap: Suchbaum über n Schlüsseln,

Treap: Suchbaum über n Schlüsseln,

in dem jedes Element eine zufällige Priorität hat, und

der bzgl. dieser Prioritäten ein Heap ist.

in dem jedes Element eine zufällige Priorität hat, und

der bzgl. dieser Prioritäten ein Heap ist.

in dem jedes Element eine zufällige Priorität hat, und

der bzgl. dieser Prioritäten ein Heap ist.

) Jeder Schlüssel hat mit gleicher Wahrscheinlichkeit die

höchste Priorität und ist damit die Wurzel.

) Jeder Schlüssel hat mit gleicher Wahrscheinlichkeit die

höchste Priorität und ist damit die Wurzel.

) Jeder Schlüssel hat mit gleicher Wahrscheinlichkeit die

höchste Priorität und ist damit die Wurzel.

Ein Treap mit zufälligen Prioritäten “ist” ein zufälliger

Suchbaum!

Ein Treap mit zufälligen Prioritäten “ist” ein zufälliger

Suchbaum!

Ein Treap mit zufälligen Prioritäten “ist” ein zufälliger

Suchbaum!

Die erwartete Höhe eines Treaps mit zufälligen Prioritäten ist

höchsten 3 log2 n.

Die erwartete Höhe eines Treaps mit zufälligen Prioritäten ist

höchsten 3 log2 n.

Die erwartete Höhe eines Treaps mit zufälligen Prioritäten ist

höchsten 3 log2 n.

GW

Treaps

GW

Treaps

GW

Treaps

Zufällige Suchbäume

Zurück zu Treaps

Zufällige Suchbäume

Zurück zu Treaps

Was bedeutet das für Treaps?

Was bedeutet das für Treaps?

Treap: Suchbaum über n Schlüsseln,

in dem jedes Element eine zufällige Priorität hat, und

der bzgl. dieser Prioritäten ein Heap ist.

) Jeder Schlüssel hat mit gleicher Wahrscheinlichkeit die

höchste Priorität und ist damit die Wurzel.

Ein Treap mit zufälligen Prioritäten “ist” ein zufälliger

Suchbaum!

Theorem

In einem Treap mit n Elementen ist die erwartete Zeit für das

Suchen, das Einfügen oder das Löschen eines Elements mit hoher

Wahrscheinlichkeit proportional zu log2 n.

Die erwartete Höhe eines Treaps mit zufälligen Prioritäten ist

höchsten 3 log2 n.

GW

Treaps

GW

Treaps