Kapitel 2 Natürliche und künstliche neuronale Netze

Werbung

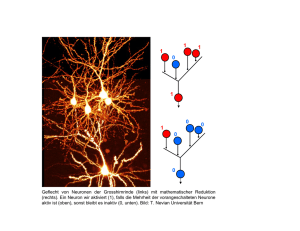

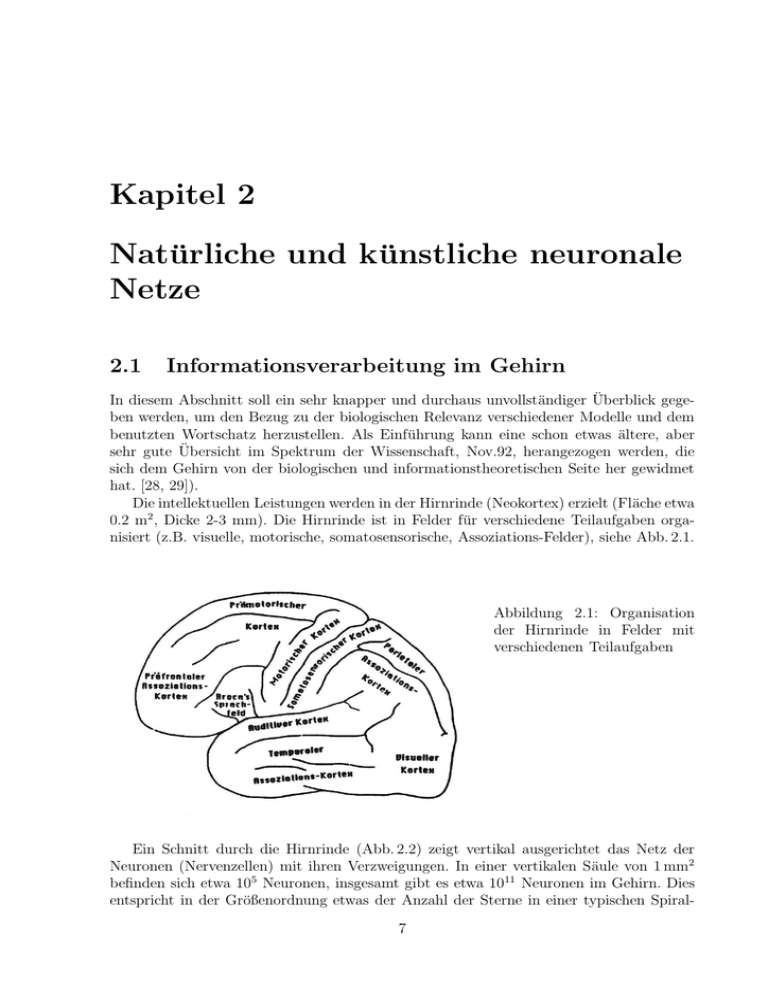

Kapitel 2 Natürliche und künstliche neuronale Netze 2.1 Informationsverarbeitung im Gehirn In diesem Abschnitt soll ein sehr knapper und durchaus unvollständiger Überblick gegeben werden, um den Bezug zu der biologischen Relevanz verschiedener Modelle und dem benutzten Wortschatz herzustellen. Als Einführung kann eine schon etwas ältere, aber sehr gute Übersicht im Spektrum der Wissenschaft, Nov.92, herangezogen werden, die sich dem Gehirn von der biologischen und informationstheoretischen Seite her gewidmet hat. [28, 29]). Die intellektuellen Leistungen werden in der Hirnrinde (Neokortex) erzielt (Fläche etwa 0.2 m2 , Dicke 2-3 mm). Die Hirnrinde ist in Felder für verschiedene Teilaufgaben organisiert (z.B. visuelle, motorische, somatosensorische, Assoziations-Felder), siehe Abb. 2.1. Abbildung 2.1: Organisation der Hirnrinde in Felder mit verschiedenen Teilaufgaben Ein Schnitt durch die Hirnrinde (Abb. 2.2) zeigt vertikal ausgerichtet das Netz der Neuronen (Nervenzellen) mit ihren Verzweigungen. In einer vertikalen Säule von 1 mm2 befinden sich etwa 105 Neuronen, insgesamt gibt es etwa 1011 Neuronen im Gehirn. Dies entspricht in der Größenordnung etwas der Anzahl der Sterne in einer typischen Spiral7 8 Kapitel 2. Natürliche und künstliche neuronale Netze galaxis wie der Milchstraße. Die zahlenmäßige Vergleichbarkeit dieser doch sehr unterschiedlichen Systeme ist wohl eher zufällig. Bevor wir uns mit dem Aufbau der Nervenzellen befassen, soll zunächst ein Überblick über den Aufbau und die Organisation der Hirnrinde gegeben werden. 2.1.1 Organisation der Hirnrinde Vertikale Schichten: wie folgt aufgebaut: Beginnend in Abb. 2.2 in der untersten Schicht ist die Hirnrinde 6. Eingabeschicht und z.T. Ursprung von langreichweitigen Assoziationsfasern 5. Hauptausgabeschicht 4. Ursprung von Fasern, die zur Eingabe zurückkoppeln 3. Hauptursprung kurzreichweitiger Assoziationsfasern, das sind Verbindungen zwischen Neuronen aus verschiedenen Feldern. 2. dito 1. Schicht enthält die Assoziationsfasern Experimentelle Untersuchungen des Gehirns werden mit Mikroelektroden, SQUIDs, NMR etc. durchgeführt, wobei die invasiven Methoden eher auf Tiere beschränkt bleiben. Experimentell konnten Gedanken, Reize etc. im Gehirn nicht in einzelnen Neuronen lokalisiert werden. Vielmehr sind immer größere Bereiche involviert. Andererseits ist aber auch bei einem Prozess nicht das ganze Gehirn beteiligt. Es werden Zusammenschlüsse von Neuronen zu funktionellen Einheiten (mit unscharfen Übergängen) beobachtet, zum Beispiel: • Rindenfelder, davon sind etwa 80 verschiedene bekannt, z.B. gibt es im Sehkortex Felder, die die Analyse von Kantenorientierungen, Farbtönen oder Geschwindigkeiten durchführen. • Vertikale Mikrosäulen mit einem Durchmesser von etwa 0.1 mm übernehmen z.B. die Analyse einer einzelnen Bildkante oder die Ansteuerung eines Muskels. • Rezeptive Felder: ein Lichtpunkt auf der Retina erregt z.B. nicht nur ein einzelnes Neuron sondern auch Nachbarn. Ein typisches Erregungsmuster ist der ‘Sombrero’ in Abb. 2.3: Das Erregungszentrum wird durch eine hemmende Umgebung eingekreist (‘laterale Inhibition’). Dieses gleichzeitige Auftreten von Erregung und Hemmung dient wahrscheinlich der Stabilisierung. • Einzelne Felder sind untereinander und mit anderen Gehirn- und Nervenstrukturen über Assoziationsfasern verbunden. 14 Strukturbildung: Mit den etwa 1013 Synapsen ergeben sich etwa 1010 mögliche Konfigurationen des Gehirns. Das kann nicht alles genetisch festgelegt sein! Genetisch kodiert sind wahrscheinlich nur Organisationsschemata und ein Strukturbildungsmechanismus. Die Verbindungen zwischen den Neuronen werden z.T. evolutionär aufgrund sensorischer Reize gebildet und können meistens auch später noch verändert werden. 2.1. Informationsverarbeitung im Gehirn 9 Abbildung 2.2: Vertikaler Schnitt durch die Hirnrinde. Die Dichte der Neuronen ist um einen Faktor 100 untersetzt 10 Kapitel 2. Natürliche und künstliche neuronale Netze Abbildung 2.3: Anregungsstruktur eines rezeptiven Feldes Abbildung 2.4: Struktur der Rindenfelder im somatosensorischen Kortex. Topographische Abbildungen: Der Lernvorgang führt offensichtlich zu Strukturen im Gehirn, die vorgegebene topographische Zusammenhänge bei den einlaufenden Sinnesreizen intakt lassen. Beispielsweise wird im somatosensorischen Kortex der Tastsinn der Hautoberfläche so abgebildet, dass benachbarte Körperbereiche benachbart bleiben (Abb. 2.4, links). Eine wesentliche Eigenschaft der Abbildung ist die Anpassung der Größe der Bildbereiche entsprechend der Wichtigkeit (oder Sensibilität) und das jeweils benötigte Auflösungsvermögen. Dieser Sachverhalt ist in der Abbildung 2.4 rechts dargetellt: Die Größenverhältnisse im Körperbau des so genannten “Homunculus” entspricht einem Sensibilitätsdiagramm verschiedener Bereiche seiner Körperoberfläche. 2.1.2 Aufbau und Funktion der Neuronen Die eigentlichen Informationsverarbeitungseinheiten des Gehirns sind die Nervenzellen oder Neuronen. Es gibt viele unterschiedliche Neuron-Typen. Um die uns interessierenden wesentlichen Eigenschaften von Neuronen zu beleuchten, konzentrieren wir uns auf die schematische Darstellung eines typischen Neurons in Abb. 2.5. Solch ein Neuron besteht aus • dem Zellkörper, Durchmesser 5-80 µm, 2.1. Informationsverarbeitung im Gehirn 11 Abbildung 2.5: Schematische Darstellung von Nervenzellen (Neuronen) und ihrer Verbindungen zu anderen Nervenzellen . • den Dendriten, die sich zu Dendritenbäumen mit einer Reichweite von 0.01-3 mm verzweigen, • dem Axon, das bis zu 1 m lang sein kann. Funktionsweise eines Neurons: • Die Dendriten sammeln in einer Umgebung bis zu etwa 400 µm Signale von benachbarten Neuronen oder von den Axonen weiter entfernter Neuronen. • Die Signalübertragung auf die Dendriten oder direkt auf den Zellkörper erfolgt über chemische Kontakte (Neurotransmitter) an den Synapsen innerhalb von O(1 ms). In der Hirnrinde hat jedes Neuron O(103 ) Synapsen (allgemein im Gehirn O(1) bis O(105 )). Die Zeitskala für die Übertragung ist 1 ms, d.h. dass z.B. die visuelle Erkennung eines Bildes mit nicht mehr als O(10) serielle Schritten erfolgen muss. • Das Summensignal aller Dendriten verändert das elektrische Potential des Zellkörpers. • Bei Überschreiten einer Schwelle erzeugt diese Potentialänderung einen Nadelpuls (Spike) auf dem Axon. Das Axonsignal wird durch eine Erhöhung des elektrischen Potenials innerhalb des Axons relativ zum umgebenden Medium gebildet. Das Signal hat eine zeitliche Dauer von etwa 2 Millisekunden und breitet sich mit einer Geschwindigkeit von etwa 10 m/s aus. Die geringe Signalgeschwindigkeit ist durch die zugrunde liegenden chemischen Prozesse begründet, die das elektrische Potenzial entlang der Nervenleitungen (im Inneren des Zellkörpers der Axonen und Dendriten) vom Ruhezustand (etwa -70 mV ) auf den Anregungszustand (etwa +20 mV ) 12 Kapitel 2. Natürliche und künstliche neuronale Netze anheben. Diese Prozesse sind im Wesentlichen Ionenaustauschprozesse (Kalium, Natrium, Chlor und einige weitere) durch die semipermeable Zellwand der Axonen und Dendriten. y y y 2 3 Ausgang Abbildung 2.6: Beispiel für ein neuronales Netz. Im Allgemeinen sind Verbindungen auch von einer “höheren” Schicht zu einer “tieferen” Schicht zulässig (Rückkopplung). .. Ruckkopplung 1 x2 x1 x3 Eingang Neuronale Vernetzung: Wesentlich für die Funktion des Gehirns und daher auch für eine angemessene Simulation ist das kollektive Verhalten eines Systems von nichtlinear gekoppelten Neuronen. Im Beispiel Abb. 2.6 werden die Eingangsreize xi (z.B. visuelle Signale) in Ausgangssignale yi (z.B. zur Bewegung eines Muskels) transformiert. x 1(t ) x 2 (t ) w1 w2 y (t + 1) w3 x 3 (t ) s .. . Abbildung 2.7: Neuron als logisches Schaltelement Einfaches Modell: das McCulloch-Pitts-Neuron: Um die Funktionsweise des Gehirns zu simulieren, muss man zunächst ein mathematisches Modell des Neurons entwerfen. Ein erster Versuch in dieser Richtung wurde schon 1949 von Warren McCullcoch und Walter Pitts gestartet. Abbildung 2.7 zeigt das McCulloch-Pitts-Neuron [1], das einem logischen Schaltelement entspricht. Die binären Eingangssignale xi erzeugen ein binäres 2.2. Künstliche neuronale Netze (KNN) 13 Ausgangssignal y (xi , y = 0 oder 1) nach der Vorschrift: y(t + 1) = Θ X j wj (t)xj − s (2.1) Dabei ist t eine diskrete Zeitvariable. Die Heaviside-Funktion ist definiert als: Θ(a) = 1 a≥0 0 sonst Die Gewichte wi entsprechen den Synapsenstärken, s ist der Schwellenwert. Das Neuron ‘feuert’ also, wenn die gewichtete Summe der Eingangssignale die Schwelle s überschreitet. Die Gewichte können > 0 (erregend) oder < 0 (hemmend) sein, wie es auch tatsächlich für Synapsen beobachtet wird. 2.1.3 Lernen und Selbstorganisation Aus eigener Erfahrung wissen wir, dass das Gedächtnis auf unterschiedlichen Zeitskalen arbeitet. Manches ist bereits nach Sekunden verflogen, wie zum Beispiel die dauernd einwirkenden visuellen und sensorischen Reize, anderes behalten wir für Minuten oder Tage, manches für Jahre. Das Speicherung von Information im Gedächtnis ist also ähnlich einem evolutionären Prozess. Generell scheint zu gelten, dass die Stärke und Häufigkeit eines Reizes das Lernen wesentlich beeinflusst. Man beachte, dass wir zum Lernen offensichtlich in der Regel nicht zu wissen brauchen, ob das Gelernte richtig ist (“Lernen ohne Lehrer”). Auf diese Beobachtungen ist die Lernregel von Donald Hebb [2] begründet: Die Synapsenstärke ändert sich proportional zu der Korrelation zwischen prä- und postsynaptischem Signal, oder mathematisch ausgedrückt: ∆wi = η · y(xi ) · xi , mit 0 < η < 1 (2.2) Der Lernparameter η legt die Lerngeschwingigkeit fest. Es ist ein besonders empfindlicher Parameter: Einerseits möchte man schnell lernen, andererseits birgt zu schnelles Lernen die Gefahr, dass bisweilen auch Unsinn abgespeichert wird. 2.2 Künstliche neuronale Netze (KNN) Künstliche neuronale Netze und neuronale Algorithmen sind in den letzten Jahren intensiv theoretisch untersucht, auf Computern simuliert und -seltener- als Hardware realisiert worden. Bei der Entwicklung von NN-Modellen wird man sich natürlich von den biologischen Befunden inspirieren lassen. Für die Anwendung ist es aber nicht wichtig, ob ein Modell tatsächlich in der Natur realisiert wird. Hier ist der praktische Erfolg ausschlaggebend. Ausgehend von den im vorigen Abschnitt entwickelten Vorstellungen über natürliche neuronale Netze definieren wir im Folgenden, welches die gemeinsamen Elemente der KNN-Modelle sein sollen. Diese Aufstellung ist nicht strikt, sondern soll eher der Orientierung dienen. • Prozessorelement: (formales) Neuron, Netzwerk-Knoten (Abb. 2.8). 14 Kapitel 2. Natürliche und künstliche neuronale Netze y i g ai w i1 w i3 w i2 x1 x3 x2 Abbildung 2.8: Struktur eines künstlichen Neurons • Eingabeaktivitäten xj (Signale auf den Dendriten) sind reelle Zahlen (oder Spannungen, Ströme), eventuell binär (-1,1) oder (0,1). • Gewichte (entspricht den Synapsen) wij , > 0 (erregend), < 0 (hemmend) • Aktivitätsfunktion a, z.B.: ai = X j wij xj − si • Ausgabefunktion (oder Transferfunktion) g: yi = g(ai ) Im Allgemeinen liegt yi im Intervall [-1,1] oder [0,1] und hat häufig ein Schwellwertverhalten mit Sättigung an den Intervallgrenzen. Neben der Θ-Funktion werden häufig folgende ‘sigmoide’ Funktionen gewählt (Abb. 2.9): 1 , bekannt auch als Fermi-Dirac-Funktion 1 + e−a/T σ(a) = tanh(a/T ) σ(a) = 1/2(1 + tanh(a/T )) σ(a) = (2.3) (2.4) (2.5) Die Funktionen (2.3) und (2.5) haben Werte im Intervall [0,1] und die Funktion (2.4) im Intervall [-1,1]. Sigmoide Funktionen haben den Vorteil im Bereich der Schwelle differenzierbar zu sein. Die ‘Temperatur’ T bestimmt den Bereich mit variabler Verstärkung: Für T → 0 geht σ in die Θ-Funktion über (binäres Neuron). T groß: “weiche” Entscheidung (siehe später). • Netzwerk-Architektur: Netzwerk mit Neuronen (“Knoten”) und Verbindungen (Verknüpfungen zwischen den Neuronen) – Vollständige Verknüpfung (‘jeder mit jedem’) 2.2. Künstliche neuronale Netze (KNN) Stufe 15 linear sigmoid Abbildung 2.9: Beispiele von Schwellenfunktionen – Nachbarschaftsverknüpfung (zellulare Automaten) – Verknüpfung uni- oder bi-direktional – Schicht-Struktur der Neuronenverbindungen mit hierarchischer Anordnung (z.B. feed-forward) – Verknüpfungen zwischen Neuronen mit oder ohne Rückkopplung • Lernen: – Anpassung der Gewichte – Anpassung der Architektur: Erzeugen und Löschen von Neuronen und Verbindungen • Lernregel: – angeleitet (mit Lehrer, “supervised”) Vergleich des Netzwerk-Outputs mit der (vom Lehrer vorgegebenen) Erwartung, Anpassung durch Fehlerminimierung (z.B. Backpropagation- Algorithmus). – selbständig (ohne Lehrer, “unsupervised”) z.B. Hebb-Regel • Update-Regel: Neubestimmung eines Netzzustandes kann synchron (für alle Neuronen gleichzeitig), sequentiell oder iterativ (wegen nichtlinearer Kopplungen) gemacht werden. • Netzwerk-Phasen: – Trainingsphase (Verwendung eines Trainings-Datensatzes) – Generalisierungsphase (Anwendung auf unbekannte Daten) 16 Kapitel 2. Natürliche und künstliche neuronale Netze