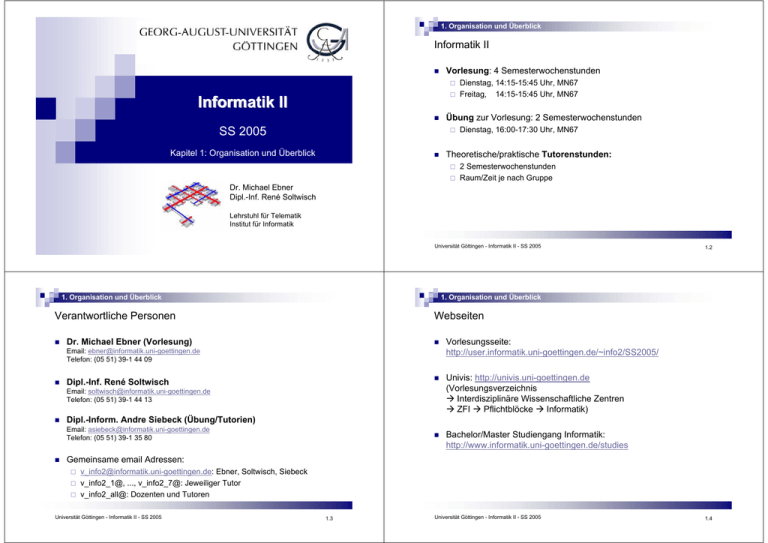

Informatik II - Institute of Computer Science, Göttingen

Werbung