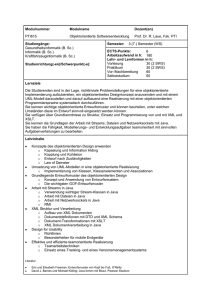

Seminarband - Institut für Informatik - Uni

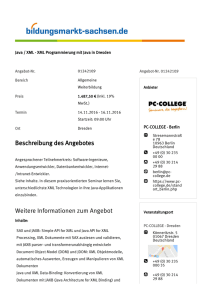

Werbung