Java aktuell

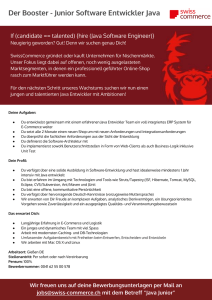

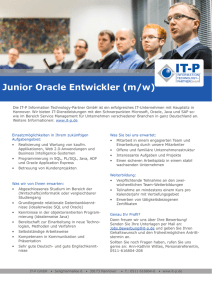

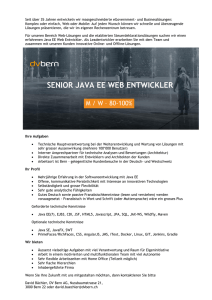

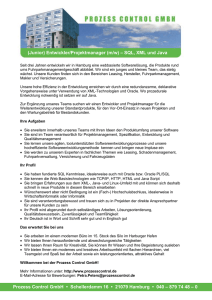

Werbung