Erlanger Universitätstage 2016_OPUS - OPUS 4

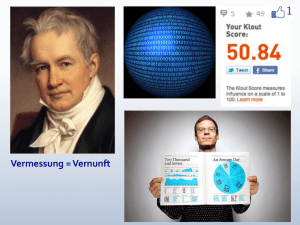

Werbung