Algorithmen und Berechnungskomplexitaet II

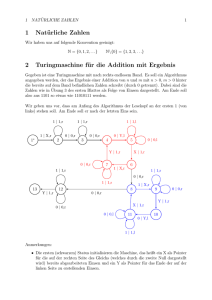

Werbung