15. Interuniversitäres Doktorandenseminar

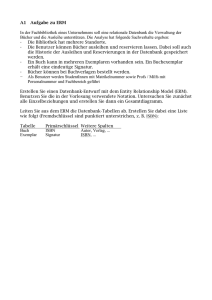

Werbung