Statistik für Betriebswirtschaft und International Management

Werbung

Statistik

für Betriebswirtschaft und International Management

Sommersemester 2014

Prof. Dr. Stefan Etschberger

Statistik

Etschberger - SS2014

Outline

1 Statistik: Einführung

4 Induktive Statistik

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der Datenerhebung

R und RStudio

2 Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3 Wahrscheinlichkeitstheorie

Kombinatorik

Zufall und Wahrscheinlichkeit

Zufallsvariablen und Verteilungen

Verteilungsparameter

Grundlagen

Punkt-Schätzung

Intervall-Schätzung

Signifikanztests

5 Datenanalyse Einleitung

Grundbegriffe

Anwendungsbereiche

Dreiteilung der Datenanalyse

Datenanalyse: Prozess

1. Einführung

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

2

Statistik

Etschberger - SS2014

Material zur Vorlesung

Kursmaterial:

2 Aufgabensätze:

Einer zu allgemeneiner Statistik als pdf,

einer zu R in moodle

1. Einführung

Handout der Folien und Aufgaben

2. Deskriptive Statistik

Alle Folien inklusive Anmerkungen

(nach der jeweiligen Vorlesung)

3. W-Theorie

4. Induktive Statistik

Beispieldaten

5. Datenanalyse

Alle Auswertungen als R-Datei

6. Repräsentation

7. Klassifikation

Literatur:

Bamberg, Günter, Franz Baur und Michael Krapp (2011). Statistik.

16. Aufl. München: Oldenbourg Verlag. ISBN: 3486702580.

Dalgaard, Peter (2002). Introductory Statistics with R. New York:

Springer.

Fahrmeir, Ludwig, Rita Künstler, Iris Pigeot und Gerhard Tutz (2009).

Statistik: Der Weg zur Datenanalyse. 7. Aufl. Berlin, Heidelberg:

Springer. ISBN: 3642019382.

Dalgaard (2002)Fahrmeir u. a. (2009) Bamberg u. a. (2011)

3

Studiengang

Vorkenntnisse,

zusätzliches Interesse,

Tempo

International

Management

normal

Vorlesung

(ab 18.3.2014)

Statistik für IM

Prüfung

Klausur für IM

Mi ab 14.00

(90 Min., 6 Credits)

Betriebswirtschaft

höher

(WiMa mind. 2,3)

normal

Statistik Plus

Statistik für BW

Di ab 14.00

Zusatzklausur

(30 Min., 2 Credits

als Wahlfach)

Mi ab 14.00

Klausur für BW

(90 Min., 6 Credits)

Prüfung

Klausur:

Klausur am Ende des Semesters

Bearbeitungszeit: 90 Minuten

Eine Aufgabe zu Anwendung von R

Hilfsmittel:

Schreibzeug,

Taschenrechner, der nicht 70! berechnen kann,

ein Blatt (DIN-A4, vorne und hinten beschrieben) mit

handgeschriebenen Notizen (keine Kopien oder Ausdrucke),

Danach (optional): Für Teilnehmer der Statistik-Plus Vorlesung

noch eine 30-minütige Teilklausur über zusätzliche Inhalte

(2 Wahlfachcredits zusätzlich möglich;

Hilfsmittel TR und ein Blatt)

Datenbasis

Fragebogen

Umfrage Statistik Sommersemester 2014

Bitte beantworten Sie folgende Fragen vollständig und füllen Sie jeweils nur eine beliebige Spalte leserlich aus.

Ihr Alter (in Jahren)

Ihre Größe (in cm)

Ihr Geschlecht (m/w)

Wie alt ist

(bzw. wäre)

Ihr Vater heute?

Wie alt ist

(bzw. wäre)

Ihre Mutter heute?

Größe Ihres Vaters (cm)

Größe Ihrer Mutter (cm)

Wie viele Geschwister haben Sie?

Wunschfarbe

für Ihr nächstes Smartphone; mögliche

Auswahl: (si)lber, (sc)hwarz, (w)eiß, (g)elb, (b)lau, (r)ot

Ausgaben für Ihre mobile Kommunikation

(egal wer bezahlt hat) in den vergangenen 12 Monaten inkl. Hardware

(Smartphone, Zubehör), Software (Apps), Vertrag

Wie viele Paar Schuhe besitzen Sie?

Ausgaben für Ihre Schuhe

(egal wer bezahlt hat) in

den letzten 12 Monaten

Ihre Note in der Matheklausur

Mathe zufrieden?

Waren Sie mir Ihrer Leistung in

Antworten: (s)ehr zufrieden, (z)ufrieden, (g)eht so, (n)icht zufrieden

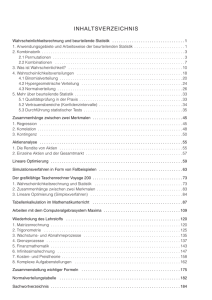

Statistik: Table of Contents

1

Statistik: Einführung

2

Deskriptive Statistik

3

Wahrscheinlichkeitstheorie

4

Induktive Statistik

5

Datenanalyse Einleitung

6

Repräsentation

7

Klassifikation

1

Statistik: Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der Datenerhebung

R und RStudio

Statistik

Etschberger - SS2014

Zitate

Leonard Henry Courteney

(1832-1918):

„ There are three kinds of lies: lies,

damned lies and statistics.“

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Winston Curchill (1874-1965)

angeblich:

„ Ich glaube nur den Statistiken, die

ich selbst gefälscht habe.“

Grundbegriffe der

Datenerhebung

R und RStudio

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Andrew Lang (1844-1912):

„ Wir benutzen die Statistik wie ein

Betrunkener einen Laternenpfahl:

Vor allem zur Stütze unseres

Standpunktes und weniger zum

Beleuchten eines Sachverhalts.“

Quellen: Wikimedia Commons

8

Statistik

Etschberger - SS2014

Bedeutungen des Begriffs Statistik

1. Einführung

Berühmte Leute zur Statistik

Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der

Datenerhebung

R und RStudio

Zusammenstellung

von Zahlen

Statistische

Methodenlehre

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

Wahrscheinlichkeitstheorie

6. Repräsentation

Deskriptive

Statistik

7. Klassifikation

Induktive

Statistik

23

Statistik

Etschberger - SS2014

Einfaches Beispiel

Beispiel

12 Beschäftigte werden nach der Entfernung zum Arbeitsplatz (in km)

befragt.

Antworten: 4, 11, 1, 3, 5, 4, 20, 4, 6, 16, 10, 6

deskriptiv:

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der

Datenerhebung

R und RStudio

2. Deskriptive Statistik

Durchschnittliche Entfernung: 7,5

Klassenbildung:

3. W-Theorie

4. Induktive Statistik

Klasse

Häufigkeit

[0; 5)

[5; 15)

[15; 30)

5

5

2

5. Datenanalyse

6. Repräsentation

7. Klassifikation

induktiv:

Schätze die mittlere Entfernung aller Beschäftigten.

Prüfe, ob die mittlere Entfernung geringer als 10 km ist.

24

Statistik

Etschberger - SS2014

Merkmale

Merkmalsträger: Untersuchte statistische Einheit

Merkmal: Interessierende Eigenschaft des Merkmalträgers

1. Einführung

Berühmte Leute zur Statistik

(Merkmals-)Ausprägung: Konkret beobachteter Wert des

Merkmals

Wie lügt man mit Statistik?

Grundgesamtheit: Menge aller relevanten Merkmalsträger

R und RStudio

Begriff Statistik

Grundbegriffe der

Datenerhebung

2. Deskriptive Statistik

Typen von Merkmalen:

a) qualitativ – quantitativ

· qualitativ: z.B. Geschlecht

· quantitativ: z.B. Schuhgröße

· Qualitative Merkmale sind quantifizierbar

(z.B.: weiblich 1, männlich 0)

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

b) diskret – stetig

· diskret: Abzählbar viele unterschiedliche Ausprägungen

· stetig: Alle Zwischenwerte realisierbar

25

Skalenniveaus

Statistik

Etschberger - SS2014

Nominalskala:

Zahlen haben nur Bezeichnungsfunktion

z.B. Artikelnummern

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Ordinalskala:

Grundbegriffe der

Datenerhebung

R und RStudio

zusätzlich Rangbildung möglich

z.B. Schulnoten

Differenzen sind aber nicht interpretierbar!

à Addition usw. ist unzulässig.

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Kardinalskala:

zusätzlich Differenzbildung sinnvoll

z.B. Gewinn

Noch feinere Unterscheidung in: Absolutskala, Verhältnisskala,

Intervallskala

26

Statistik

Etschberger - SS2014

Skalendegression und Skalenprogression

Ziel der Skalierung: Gegebene Information angemessen abbilden,

möglichst ohne Über- bzw. Unterschätzungen

1. Einführung

Es gilt:

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundsätzlich können alle Merkmale nominal skaliert werden.

Grundbegriffe der

Datenerhebung

Grundsätzlich kann jedes metrische Merkmal ordinal skaliert werden.

R und RStudio

2. Deskriptive Statistik

Das nennt man Skalendegression. Dabei: Informationsverlust

3. W-Theorie

4. Induktive Statistik

Aber:

5. Datenanalyse

Nominale Merkmale dürfen nicht ordinal- oder metrisch skaliert

werden.

6. Repräsentation

7. Klassifikation

Ordinale Merkmale dürfen nicht metrisch skaliert werden.

Das nennt nennt man Skalenprogression. Dabei: Interpretation von mehr

Informationen in die Merkmale, als inhaltlich vertretbar.

(Gefahr der Fehlinterpretation)

27

Statistik

Etschberger - SS2014

Was ist R und warum soll man es benutzen?

R ist freie Software

1. Einführung

R ist sehr mächtig und weit verbreitet

in Wissenschaft und Industrie (sogar

von mehr Leuten benutzt als z.B. SPSS)

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der

Datenerhebung

Ursprung von R: 1993 an der

Universität Auckland von Ross Ihaka

and Robert Gentleman entwickelt

R und RStudio

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

Seitdem: Viele Leute haben R

verbessert mit tausenden von Paketen

für viele Anwendungen

Nachteil (auf den ersten Blick): Kein

point und click tool

5. Datenanalyse

6. Repräsentation

7. Klassifikation

source: http://goo.gl/axhGhh

Großer Vorteil (auf den zweiten Blick):

Kein point und click tool

graphics source: http://goo.gl/W70kms

28

Whas ist RStudio?

RStudio ist ein

Integrated Development

Environment (IDE)

um R leichter benutzen

zu können.

Statistik

Etschberger - SS2014

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der

Datenerhebung

R und RStudio

2. Deskriptive Statistik

Gibt’s für OSX, Linux

und Windows

4. Induktive Statistik

Ist auch frei

5. Datenanalyse

Trotzdem: Sie müssen

Kommandos schreiben

6. Repräsentation

3. W-Theorie

7. Klassifikation

Aber: RStudio

unterstützt Sie dabei

Hausaufgabe:

Installieren Sie

RStudio von

RStudio.com

29

Erste Schritte

RStudio

Kennenlernen

Statistik

Etschberger - SS2014

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Code

Console

Grundbegriffe der

Datenerhebung

R und RStudio

2. Deskriptive Statistik

Workspace

3. W-Theorie

History

4. Induktive Statistik

5. Datenanalyse

Files

Plots

6. Repräsentation

7. Klassifikation

Packages

Help

AutoCompletion

Data Import

30

Daten einlesen und Struktur anschauen

# Arbeitsverzeichnis setzen (alternativ über Menü)

setwd("C:/ste/work/vorlesungen/2014SS_HSA_Statistik/Folien")

# Daten einlesen aus einer csv-Datei (Excel)

MyData = read.csv2(file="../Daten/Umfrage_HSA_2014_03.csv", header=TRUE)

Statistik

Etschberger - SS2014

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der

Datenerhebung

# inspect structure of data

str(MyData)

## 'data.frame': 205 obs. of 14 variables:

## $ Alter

: int 21 20 19 20 20 24 20 27 23 21 ...

## $ Groesse

: int 173 164 172 168 169 185 170 165 184 178 ...

## $ Geschlecht : Factor w/ 2 levels "Frau","Mann": 1 1 1 1 1 2 1 1 2 2 ...

## $ AlterV

: int 54 57 49 45 43 54 49 53 52 55 ...

## $ AlterM

: int 51 57 58 49 42 52 53 53 48 55 ...

## $ GroesseV

: int 187 172 193 185 182 179 182 175 182 180 ...

## $ GroesseM

: int 170 166 162 164 164 163 172 165 175 168 ...

## $ Geschwister: int 1 0 3 3 5 2 2 1 2 1 ...

## $ Farbe

: Factor w/ 6 levels "blau","gelb",..: 6 6 4 4 6 4 3 6 4 6 ...

## $ AusgKomm

: num 156 450 240 35.8 450 250 100 300 450 1300 ...

## $ AnzSchuhe : int 17 22 15 15 22 8 20 10 3 7 ...

## $ AusgSchuhe : int 50 500 400 100 450 90 250 200 300 200 ...

## $ NoteMathe : num 5 1.7 2.3 2 2 4 NA 4 2.7 2.7 ...

## $ MatheZufr : Ord.factor w/ 4 levels "nicht"<"geht so"<..: 1 4 4 4 4 2 1 1 3 3 ...

R und RStudio

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

31

Erste Zeilen der Datentabelle

Statistik

Etschberger - SS2014

# show first few lines of data matrix

head(MyData, 6)

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

1

2

3

4

5

6

1

2

3

4

5

6

1

2

3

4

5

6

Alter Groesse Geschlecht AlterV AlterM GroesseV

21

173

Frau

54

51

187

20

164

Frau

57

57

172

19

172

Frau

49

58

193

20

168

Frau

45

49

185

20

169

Frau

43

42

182

24

185

Mann

54

52

179

GroesseM Geschwister

Farbe AusgKomm AnzSchuhe

170

1

weiss

156.0

17

166

0

weiss

450.0

22

162

3 schwarz

240.0

15

164

3 schwarz

35.8

15

164

5

weiss

450.0

22

163

2 schwarz

250.0

8

AusgSchuhe NoteMathe MatheZufr

50

5.0

nicht

500

1.7

sehr

400

2.3

sehr

100

2.0

sehr

450

2.0

sehr

90

4.0

geht so

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der

Datenerhebung

R und RStudio

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

# lege MyData als den "Standard"-Datensatz fest

attach(MyData)

# Wie Viele Objekte gibt's im Datensatz?

nrow(MyData)

## [1] 205

# Wie Viele Merkmale?

ncol(MyData)

## [1] 14

32

data inspection

Statistik

Etschberger - SS2014

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

# Auswahl spezieller Objekte und Merkmale über [Zeile, Spalte]

MyData[1:3, 2:5]

##

Groesse Geschlecht AlterV AlterM

## 1

173

Frau

54

51

## 2

164

Frau

57

57

## 3

172

Frau

49

58

# Auswahl von Objekten über logische Ausdrücke

head(Geschlecht=="Frau" & Alter<20, 30)

## Error: Objekt ’Geschlecht’ nicht gefunden

# Einsetzen in Klammern und Ausgabe von Alter des Studenten, seines

# Vaters und seiner Mutter

MyData[Geschlecht=="Frau" & Alter<20, c("Alter", "AlterM", "AlterV")]

Begriff Statistik

Grundbegriffe der

Datenerhebung

R und RStudio

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

## Error: Objekt ’Geschlecht’ nicht gefunden

33

data inspection

Statistik

Etschberger - SS2014

1. Einführung

Berühmte Leute zur Statistik

Wie lügt man mit Statistik?

Begriff Statistik

Grundbegriffe der

Datenerhebung

R und RStudio

# Zeige die Männer, die mehr als 1000 Euro für Schuhe

# und Mobilfunk zusammen ausgegeben haben

MyData[Geschlecht=="Mann" & AusgSchuhe + AusgKomm > 1000,

c("Alter", "Groesse", "AusgSchuhe", "AusgKomm")]

## Error: Objekt ’Geschlecht’ nicht gefunden

2. Deskriptive Statistik

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

34

Statistik: Table of Contents

1

Statistik: Einführung

2

Deskriptive Statistik

3

Wahrscheinlichkeitstheorie

4

Induktive Statistik

5

Datenanalyse Einleitung

6

Repräsentation

7

Klassifikation

2

Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

Statistik

Etschberger - SS2014

Häufigkeitsverteilungen

Auswertungsmethoden für eindimensionales Datenmaterial

Merkmal X wird an n Merkmalsträgern beobachtet à

Urliste (x1 , . . . , xn )

Im Beispiel: x1 = 4, x2 = 11, . . . , x12 = 6

Urlisten sind oft unübersichtlich, z.B.:

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

## [1] 4 5 4 1 5 4 3 4 5 6 6 5 5 4 7 4 6 5 6 4 5 4 7 5 5

## [26] 6 7 3 7 6 6 7 4 5 4 7 7 5 5 5 5 6 6 4 5 2 5 4 7 5

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

Dann zweckmäßig: Häufigkeitsverteilungen

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

Ausprägung (sortiert)

aj

P

1

2

3

4

5

6

7

h(aj ) = hj

j

P

H(aj ) =

h(ai )

i=1

1

1

2

12

17

9

8

50

1

2

4

16

33

42

50

−

f(aj ) = h(aj )/n

j

P

F(aj ) =

f(ai )

i=1

1

50

1

50

2

50

12

50

17

50

9

50

8

50

1

1

50

2

50

4

50

16

50

33

50

42

50

1

−

6. Repräsentation

7. Klassifikation

absolute Häufigkeit

kumulierte abs. H.

relative Häufigkeit

kumulierte rel. H.

36

Statistik

Etschberger - SS2014

Graphische Darstellungen

Ê Balkendiagramm

Ë Kreissektorendiagramm

table(x)

## x

## 1

## 1

2

1

3 4 5

2 12 17

6

9

wj = 360◦ · f(aj )

Winkel:

7

8

w1 = 360◦ ·

z.B.

w7 = 360◦ ·

barplot(table(x), col="azure2")

1

50

8

50

1. Einführung

2. Deskriptive Statistik

= 7,2◦

Häufigkeiten

Lage und Streuung

= 57,6◦

Konzentration

Zwei Merkmale

15

Korrelation

pie(table(x))

Preisindizes

Lineare Regression

4

10

3. W-Theorie

4. Induktive Statistik

3

2

1

5. Datenanalyse

6. Repräsentation

5

5

7. Klassifikation

0

7

1

2

3

4

5

6

6

7

(Fläche proportional zu Häufigkeit)

(Höhe proportional zu Häufigkeit)

38

Statistik

Etschberger - SS2014

Graphische Darstellungen

Ì Histogramm

Fläche proportional zu

Häufigkeit:

Im Beispiel mit c =

1

:

12

Klasse

[0; 5)

[5; 15)

[15; 30]

h(aj )

Breitej

Höhej

5

5

5

10

2

15

1

12

1

24

1

90

Lage und Streuung

Konzentration

Zwei Merkmale

Preisindizes

Lineare Regression

3. W-Theorie

0.04

h(aj )

Breitej

Häufigkeiten

4. Induktive Statistik

0.02

Höhej = c ·

2. Deskriptive Statistik

6. Repräsentation

5. Datenanalyse

7. Klassifikation

0.00

⇒

1. Einführung

Korrelation

0.06

Höhej · Breitej = c · h(aj )

histData <- c(0,1,2,3,4,

5,6,7,10,14,

15,30)

truehist(histData,

breaks=c(0, 4.999, 14.999, 30),

col="azure2", ylab='')

0.08

für klassierte Daten

0

5

10

15

20

25

30

histData

40

Statistik

Etschberger - SS2014

Lageparameter

Modus xMod : häufigster Wert

Beispiel:

aj

h(aj )

1

4

2

3

4

1

⇒ xMod = 1

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Sinnvoll bei allen Skalenniveaus.

Zwei Merkmale

Korrelation

Preisindizes

Median xMed : ‚mittlerer Wert‘, d.h.

Lineare Regression

1. Urliste aufsteigend sortieren: x1 5 x2 5 · · · 5 xn

2. Dann

xMed

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

= x n+1 ,

2

∈ [x n2 ; x n2 +1 ],

falls n ungerade

falls n gerade (meist xMed =

7. Klassifikation

1

2

(x n2 + x n2 +1 ))

Im Beispiel oben:

1, 1, 1, 1, 2, 2, 2, 4 ⇒ xMed ∈ [1; 2], z.B. xMed = 1,5

Sinnvoll ab ordinalem Skalenniveau.

43

Statistik

Etschberger - SS2014

Lageparameter (2)

Arithmetisches Mittel x̄: Durchschnitt, d.h.

1X

1X

x̄ =

xi =

aj · h(aj )

n

n

n

i=1

k

j=1

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Im Beispiel:

Konzentration

Zwei Merkmale

x̄ =

1

8

· (1| + 1 {z

+ 1 + 1} + 2| +{z

2 + 2} + |{z}

4 ) = 1,75

1·4

2·3

4·1

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

Sinnvoll nur bei kardinalem Skalenniveau.

Bei klassierten Daten:

P

1

Klassenmitte · Klassenhäufigkeit

x̄∗ = n

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Im Beispiel:

x̄∗ =

1

12

· (2,5 · 5 + 10 · 5 + 22,5 · 2) = 8,96 6= 7,5 = x̄

44

Statistik

Etschberger - SS2014

Streuungsparameter

Voraussetzung: kardinale Werte x1 , . . . , xn

Beispiel:

a) xi

b) xi

1950

0

2000 2050

0

6000

1. Einführung

je x̄ = 2000

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Spannweite: SP = max xi − min xi

Zwei Merkmale

Im Beispiel:

Preisindizes

i

i

Korrelation

Lineare Regression

a) SP = 2050 − 1950 = 100

b) SP = 6000 − 0

= 6000

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

Mittlere quadratische Abweichung:

7. Klassifikation

1X

1X 2

s =

(xi − x̄)2 =

xi − x̄2

n

n

i=1

| i=1{z

}

n

n

2

Verschiebungssatz

46

Statistik

Etschberger - SS2014

Streuungsparameter (2)

Mittlere quadratische Abweichung im Beispiel:

a) s2 = 13 · (502 + 02 + 502 )

=

2

b) s =

1

3

1

3

1

3

· (19502 + 20002 + 20502 ) − 20002 = 1666,67

2

2

2

· (2000 + 2000 + 4000 )

· (02 + 02 + 60002 ) − 20002

= 8000000

√

Standardabweichung: s = s2

Im Beispiel:

√

a) s = 1666,67 = 40,82

√

b) s = 8000000 = 2828,43

s

Variationskoeffizient: V =

(maßstabsunabhängig)

x̄

Im Beispiel:

a) V = 40,82

= 0,02 (=

b 2 %)

2000

=

b) V =

2828,43

2000

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

= 1,41 (=

b 141 %)

47

Statistik

Etschberger - SS2014

Graphing location and variation parameters

Boxplot

boxplot(AnzSchuhe ~ Geschlecht,

col="lightblue",

data=MyData, main="")

Whiskers: max/min.

values or

√

±1.58 · IQR/ n

1. Einführung

80

Box: Interquartile range

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

60

Graphical representation

of location and variance

Korrelation

Preisindizes

Outliers: outside of

whiskers boundaries

Lineare Regression

40

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

0

20

7. Klassifikation

Frau

Mann

„Wieviel Paar Schuhe besitzen Sie?“

49

Statistik

Etschberger - SS2014

Dateninspektion:

Umfrage: Überblick über alle Variablen

1. Einführung

summary(MyData[1:10])

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

Alter

Min. :18.0

1st Qu.:20.0

Median :21.0

Mean :22.2

3rd Qu.:23.0

Max. :36.0

AlterM

Min.

:37.0

1st Qu.:48.0

Median :51.0

Mean

:51.5

3rd Qu.:54.0

Max.

:68.0

Geschwister

Min.

:0.00

1st Qu.:1.00

Median :1.00

Mean

:1.47

3rd Qu.:2.00

Max.

:9.00

Groesse

Min. :156

1st Qu.:166

Median :170

Mean :173

3rd Qu.:179

Max. :197

GroesseV

Min.

:160

1st Qu.:175

Median :180

Mean

:180

3rd Qu.:183

Max.

:202

Farbe

blau

:11

gelb

: 4

rot

:13

schwarz:97

silber :17

weiss :63

2. Deskriptive Statistik

summary(MyData[11:14])

Geschlecht

AlterV

Frau:134 Min. :38

Mann: 71 1st Qu.:50

Median :54

Mean :54

3rd Qu.:57

Max. :77

GroesseM

Min.

:150

1st Qu.:163

Median :166

Mean

:167

3rd Qu.:170

Max.

:192

AusgKomm

Min.

: 30

1st Qu.: 250

Median : 360

Mean

: 429

3rd Qu.: 570

Max.

:1868

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

##

AnzSchuhe

Min. : 2.0

1st Qu.:10.0

Median :20.0

Mean :21.6

3rd Qu.:30.0

Max. :80.0

MatheZufr

nicht

:68

geht so :47

zufrieden:43

sehr

:26

NA's

:21

AusgSchuhe

Min. :

0

1st Qu.: 150

Median : 250

Mean : 297

3rd Qu.: 400

Max. :2000

NoteMathe

Min.

:1.00

1st Qu.:2.50

Median :3.30

Mean :3.27

3rd Qu.:4.00

Max. :5.00

NA's

:34

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

50

Statistik

Etschberger - SS2014

Dateninspektion

Boxplots

for(attribute in c("Alter", "AlterV", "AlterM", "Groesse",

"AusgSchuhe", "AnzSchuhe")) {

data=MyData[, attribute]

boxplot(data, # all rows, column of attribute

col="lightblue",

# fill color

lwd=3,

# line width

cex=2,

# character size

oma=c(1,1,2,1)

)

text(0.7,max(data), attribute, srt=90, adj=1)

}

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

AnzSchuhe

80

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

60

60

1500

AusgSchuhe

2000

Groesse

190

AlterM

65

AlterV

70

Alter

35

Lineare Regression

180

20

500

170

160

0

0

40

40

20

45

50

25

50

40

7. Klassifikation

1000

55

60

30

6. Repräsentation

51

Statistik

Etschberger - SS2014

Konzentrationsmaße

Gegeben: kardinale Werte 0 5 x1 5 x2 5 · · · 5 xn

Achtung! Die Werte müssen aufsteigend sortiert werden!

1. Einführung

Lorenzkurve:

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Wieviel Prozent der Merkmalssumme entfällt

auf die x Prozent kleinsten Merkmalsträger?

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Beispiel: Die 90 % ärmsten besitzen 20 % des Gesamtvermögens.

Lineare Regression

3. W-Theorie

Streckenzug: (0,0), (u1 , v1 ), . . . , (un , vn ) = (1,1) mit

4. Induktive Statistik

5. Datenanalyse

k

P

vk = Anteil der k kleinsten MM-Träger an der MM-Summe =

i=1

n

P

6. Repräsentation

xi

7. Klassifikation

xi

i=1

uk = Anteil der k kleinsten an der Gesamtzahl der MM-Träger =

k

n

52

Statistik

Etschberger - SS2014

Lorenzkurve: Beispiel

Markt mit fünf Unternehmen; Umsätze: 6, 3, 11, 2, 3 (Mio. €)

5

P

⇒ n = 5,

xk = 25

k=1

1. Einführung

2. Deskriptive Statistik

vk

Häufigkeiten

Lage und Streuung

1

Konzentration

Zwei Merkmale

Korrelation

k

1

2

3

4

5

xk

2

3

3

6

11

pk

2

25

2

25

1

5

3

25

5

25

2

5

3

25

8

25

3

5

6

25

14

25

4

5

11

25

Preisindizes

Lineare Regression

3. W-Theorie

vk

uk

1

1

14

25

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

8

25

5

25

2

25

7. Klassifikation

uk

1

5

2

5

3

5

4

5

1

53

Statistik

Etschberger - SS2014

Lorenzkurve

Knickstellen:

Bei i-tem Merkmalsträger ⇐⇒ xi+1 > xi

Empirische Verteilungsfunktion liefert Knickstellen:

1. Einführung

2. Deskriptive Statistik

aj

2

3

6

Häufigkeiten

11

Lage und Streuung

Konzentration

h(aj )

f(aj )

F(aj )

1

2

1

1

Zwei Merkmale

1

5

1

5

2

5

3

5

1

5

4

5

1

5

Preisindizes

Korrelation

Lineare Regression

1

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

Vergleich von Lorenzkurven:

6. Repräsentation

7. Klassifikation

Gleichverteilung

extreme Konzentration

stärker konzentriert als

schwer vergleichbar

54

Statistik

Etschberger - SS2014

Lorenzkurve: Beispiel Bevölkerungsanteil gegen BSP

Bangladesch

Brasilien

Deutschland

Ungarn

USA

1,0

1. Einführung

2. Deskriptive Statistik

Anteil am BSP

0,8

(Stand 2000)

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

0,6

Preisindizes

Lineare Regression

3. W-Theorie

0,4

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

0,2

7. Klassifikation

0,2

0,4

0,6

0,8

Anteil der Bevölkerung

1,0

55

Statistik

Etschberger - SS2014

Gini-Koeffizient

Numerisches Maß der Konzentration: Gini-Koeffizient G

Fläche zwischen 45◦ -Linie und L

G=

=

Fläche unter 45◦ -Linie

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Aus den Daten:

Konzentration

Zwei Merkmale

Korrelation

2

G=

n

P

i xi − (n + 1)

i=1

n

P

i=1

n

n

P

xi

2

=

xi

n

P

Preisindizes

i pi − (n + 1)

i=1

n

i=1

Lineare Regression

wobei

xi

pi = n

P

xi

i=1

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

Problem: Gmax =

7. Klassifikation

n−1

n

à Normierter Gini-Koeffizient:

G∗ =

n

· G ∈ [0; 1]

n−1

56

Statistik

Etschberger - SS2014

Gini-Koeffizient: Beispiel

Beispiel:

P

i

1

2

3

4

xi

1

2

2

15

pi

1

20

2

20

2

20

15

20

1. Einführung

2. Deskriptive Statistik

20

Häufigkeiten

Lage und Streuung

1

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

G=

2· 1·

1

20

+2·

2

20

2

+ 3 · 20

+4·

4

15

20

− (4 + 1)

4. Induktive Statistik

= 0,525

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Mit Gmax =

4−1

4

= 0,75 folgt

G∗ =

4

· 0,525 = 0,7

4−1

57

Statistik

Etschberger - SS2014

Konzentrationsmaße: Beispiel

Verteilung der

Bruttoeinkommen in

Preisen von 2000

aus unselbständiger Arbeit

der Arbeitnehmer/-innen

insgesamt

Anteil am Einkommen

Armutsbericht der Bundesregierung 2008

1,0

1. Einführung

0,8

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

0,6

Konzentration

Zwei Merkmale

0,4

Korrelation

Preisindizes

0,2

Lineare Regression

3. W-Theorie

0,2

0,4

0,6

0,8

1,0

Anteil der Bevölkerung

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Arithmetisches Mittel

Median

Gini-Koeffizient

2002

2003

2004

2005

24.873

21.857

0,433

24.563

21.531

0,441

23.987

20.438

0,448

23.648

20.089

0,453

58

Statistik

Etschberger - SS2014

Weitere Konzentrationsmaße

Konzentrationskoeffizient:

n

X

CRg = Anteil, der auf die g größten entfällt =

pi = 1 − vn−g

i=n−g+1

1. Einführung

Herfindahl-Index:

2. Deskriptive Statistik

H=

n

X

Häufigkeiten

Lage und Streuung

p2i

(∈

1

[n

; 1])

Konzentration

Zwei Merkmale

i=1

1

Es gilt: H = n

(V 2 + 1)

Exponentialindex:

E=

n

Y

bzw.

Korrelation

V=

√

Preisindizes

n·H−1

Lineare Regression

3. W-Theorie

4. Induktive Statistik

1

∈ [n

; 1]

p

pi i

00 = 1

wobei

5. Datenanalyse

6. Repräsentation

i=1

7. Klassifikation

Im Beispiel mit x = (1, 2, 2, 15):

CR2 =

17

20

= 0,85

1 2

15 2

H=

+ ··· +

= 0,59

20

20

1

15

1

15 20

20

···

= 0,44

E=

20

20

59

Statistik

Etschberger - SS2014

Auswertungsmethoden für zweidimensionale Daten

Zweidimensionale Urliste

Urliste vom Umfang n zu zwei Merkmalen X und Y:

1. Einführung

(x1 , y1 ), (x2 , y2 ), . . . , (xn , yn )

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Kontingenztabelle:

Zwei Merkmale

Sinnvoll bei wenigen Ausprägungen bzw. bei klassierten Daten.

Preisindizes

Korrelation

Lineare Regression

3. W-Theorie

Ausprägungen von Y

Ausprägungen von X

b1

b2

...

bl

a1

a2

..

.

ak

h11

h21

..

.

hk1

h12

h22

..

.

hk2

...

...

h1l

h2l

..

.

hkl

...

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

60

Statistik

Etschberger - SS2014

Kontingenztabelle

Unterscheide:

Gemeinsame Häufigkeiten:

1. Einführung

2. Deskriptive Statistik

hij = h(ai , bj )

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Randhäufigkeiten:

Korrelation

Preisindizes

hi· =

l

X

hij

und

h·j =

j=1

k

X

Lineare Regression

3. W-Theorie

hij

4. Induktive Statistik

i=1

5. Datenanalyse

6. Repräsentation

Bedingte (relative) Häufigkeiten:

7. Klassifikation

f1 (ai | bj ) =

hij

h·j

und

f2 (bj | ai ) =

hij

hi·

61

Statistik

Etschberger - SS2014

Häufigkeiten

Beispiel: 400 unfallbeteiligte Autoinsassen:

1. Einführung

2. Deskriptive Statistik

leicht verletzt

(= b1 )

schwer verletzt

(= b2 )

tot

(= b3 )

264

(= h11 )

2

(= h21 )

90

(= h12 )

34

(= h22 )

6

(= h13 )

4

(= h23 )

360

(= h1· )

40

(= h2· )

266

(= h·1 )

124

(= h·2 )

10

(= h·3 )

400

(= n)

angegurtet

(= a1 )

nicht angegurtet

(= a2 )

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

f2 (b3 | a2 ) =

f1 (a2 | b3 ) =

4

40

4

10

7. Klassifikation

= 0,1

(10 % der nicht angegurteten starben.)

= 0,4

(40 % der Todesopfer waren nicht angegurtet.)

62

Statistik

Etschberger - SS2014

Streuungsdiagramm

Streuungsdiagramm sinnvoll bei vielen verschiedenen

Ausprägungen (z.B. stetige Merkmale)

à Alle (xi , yi ) sowie (x̄, ȳ) in Koordinatensystem eintragen.

1. Einführung

2. Deskriptive Statistik

y

Beispiel:

i

xi

yi

1 2 3

4

5

2

4

9

7

7

8

4

3

⇒ x̄ =

ȳ =

3

6

25

5

28

5

P

25

28

=5

= 5,6

9

8

7

6

5

4

3

2

1

Häufigkeiten

Lage und Streuung

x

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

y

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

x

1 2 3 4 5 6 7 8 9

63

Beispiel Streuungsdiagramm

Statistik

Etschberger - SS2014

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

(Datenquelle: Fahrmeir u. a. (2009))

64

Statistik

Etschberger - SS2014

Beispiel Streuungsdiagramm

mieten <- read.table('../../_data/MietenMuenchen.csv',

header=TRUE, sep='\t',

check.names=TRUE, fill=TRUE,

na.strings=c('',''))

x

<- cbind(Nettomieten=mieten$nm, Wohnflaeche=mieten$wfl)

1. Einführung

library("geneplotter") ## from BioConductor

smoothScatter(x, nrpoints=Inf,

colramp=colorRampPalette(brewer.pal(9,"YlOrRd")),

bandwidth=c(30,3))

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

150

3. W-Theorie

4. Induktive Statistik

100

6. Repräsentation

7. Klassifikation

50

Wohnflaeche

5. Datenanalyse

500

1000

1500

Nettomieten

65

Statistik

Etschberger - SS2014

Korrelationsrechnung

Frage: Wie stark ist der Zusammenhang zwischen X und Y?

Dazu: Korrelationskoeffizienten

Verschiedene Varianten: Wahl abhängig vom Skalenniveau

von X und Y:

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Skalierung von Y

Korrelation

Preisindizes

Skalierung von X

kardinal

kardinal

Bravais-PearsonKorrelationskoeffizient

ordinal

nominal

ordinal

nominal

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

Rangkorrelationskoeffizient von

Spearman

7. Klassifikation

Kontingenzkoeffizient

66

Statistik

Etschberger - SS2014

Korrelationskoeffizient von Bravais und Pearson

Bravais-Pearson-Korrelationskoeffizient

Voraussetzung: X, Y kardinalskaliert

n

P

n

P

(xi − x̄)(yi − ȳ)

xi yi − nx̄ȳ

s

r= s

= s

∈ [−1; +1]

n

n

n

n

P

P

P

P

(xi − x̄)2

(yi − ȳ)2

x2i − nx̄2

y2i − nȳ2

i=1

i=1

i=1

i=1

i=1

i=1

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

7

Zwei Merkmale

6

Korrelation

5

Preisindizes

1

4

2

5

3

6

4

Konzentration

3

3. W-Theorie

2

4. Induktive Statistik

1

−2

1

−1

2

0

3

4

Lineare Regression

−1

0

1

2

3

4

−1

0

1

2

3

4

5

0

1

2

3

4

5. Datenanalyse

5

6. Repräsentation

−1

−2

−2

−2

−1

−1

0

0

0

1

1

1

2

2

2

3

3

3

4

4

4

7. Klassifikation

−2

−1

0

1

2

3

4

0

1

2

3

4

5

−3

−2

−1

0

1

2

3

67

Statistik

Etschberger - SS2014

Bravais-Pearson-Korrelationskoeffizient

Im Beispiel:

i

1

2

3

4

5

P

x2i

y2i

xi yi

4

16

9

81

49

16

9

36

49

64

8

12

18

63

56

25 28 159 174

157

xi yi

2

4

3

9

7

4

3

6

7

8

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

⇒

x̄ = 25/5 = 5

Konzentration

Zwei Merkmale

Korrelation

ȳ = 28/5 = 5,6

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

r= √

157 − 5 · 5 · 5,6

√

= 0,703

159 − 5 · 52 174 − 5 · 5,62

7. Klassifikation

(deutliche positive Korrelation)

68

Statistik

Etschberger - SS2014

Rangkorrelationskoeffizient von Spearman

Voraussetzungen: X, Y (mindestens) ordinalskaliert, Ränge

eindeutig (keine Doppelbelegung von Rängen)

Vorgehensweise:

À Rangnummern Ri (X) bzw.

Wert usw.

Á Berechne

6

rSP = 1 −

n

P

Ri0

(Y) mit

(0)

Ri

= 1 bei größtem

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

(Ri − Ri0 )2

i=1

(n − 1) n (n + 1)

4. Induktive Statistik

∈ [−1; +1]

5. Datenanalyse

6. Repräsentation

Hinweise:

7. Klassifikation

rSP = +1 wird erreicht bei Ri = Ri0

rSP = −1 wird erreicht bei Ri = n + 1 − Ri0

∀ i = 1, . . . , n

∀ i = 1, . . . , n

69

Statistik

Etschberger - SS2014

Rangkorrelationskoeffizient von Spearman

Im Beispiel:

1. Einführung

xi

Ri

yi

Ri0

2

4

3

9

7

5

3

4

1

2

4

3

6

7

8

4

5

3

2

1

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

rSP

6 · [(5 − 4)2 + (3 − 5)2 + (4 − 3)2 + (1 − 2)2 + (2 − 1)2 ]

= 1−

= 0,6

(5 − 1) · 5 · (5 + 1)

70

Statistik

Etschberger - SS2014

Kontingenzkoeffizient

Gegeben: Kontingenztabelle mit k Zeilen und l Spalten

(vgl. hier)

Vorgehensweise:

À Ergänze Randhäufigkeiten

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

hi· =

l

X

und

hij

h·j =

k

X

Konzentration

hij

i=1

j=1

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

Á Berechne theoretische Häufigkeiten

4. Induktive Statistik

h̃ij =

hi· · h·j

n

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Berechne

k X

l

X

(hij − h̃ij )2

χ =

h̃ij

i=1 j=1

2

χ2 hängt von n ab! (hij 7→ 2 · hij ⇒ χ2 7→ 2 · χ2 )

71

Statistik

Etschberger - SS2014

Kontingenzkoeffizient

à Kontingenzkoeffizient:

s

K=

χ2

n + χ2

1. Einführung

∈ [0; Kmax ]

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

wobei

Zwei Merkmale

Korrelation

Preisindizes

r

Kmax =

M−1

M

Lineare Regression

mit

M = min{k, l}

4. Induktive Statistik

Ä Normierter Kontingenzkoeffizient:

K

K∗ =

Kmax

3. W-Theorie

5. Datenanalyse

6. Repräsentation

7. Klassifikation

∈ [0; 1]

K∗ = +1 ⇐⇒

bei Kenntnis von xi kann yi erschlossen werden u.u.

72

Statistik

Etschberger - SS2014

Kontingenzkoeffizient

Beispiel

X : Staatsangehörigkeit

Y : Geschlecht

(d,a)

(m,w)

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

hij

d

a

h·j

wobei h̃11 =

m

30

10

40

60·40

100

w

30

30

60

hi·

60

40

100

= 24

usw.

m

24

16

h̃ij

⇒ d

a

w

36

24

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

χ2 =

K =

K∗ =

(30−24)2

24

q

+

6,25

100+6,25

0,2425

0,7071

(30−36)2

36

+

(10−16)2

16

= 0,2425;

+

(30−24)2

24

6. Repräsentation

= 6,25

M = min{2,2} = 2;

7. Klassifikation

Kmax =

q

2−1

2

= 0,7071

= 0,3430

73

Statistik

Etschberger - SS2014

Graphische Repräsentation von Kontingenztabellen

Beispiel Autounfälle

Verletzung

leicht

schwer

tödlich

264

2

90

34

6

4

1. Einführung

2. Deskriptive Statistik

angegurtet

nicht angegurtet

360

40

Häufigkeiten

Lage und Streuung

Konzentration

266

124

10

400

Zwei Merkmale

Korrelation

Preisindizes

schwer

Lineare Regression

tödlich

<−4 −4:−2 −2:0 0:2

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Standardized

Residuals:

Gurt

Kein

Sicherheit

2:4

>4

leicht

Verletzungen

Mosaikplot Autounfälle

74

Statistik

Etschberger - SS2014

Preisindizes

Preismesszahl: Misst Preisveränderung eines einzelnen Gutes:

1. Einführung

Preis zum Zeitpunkt j

Preis zum Zeitpunkt i

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

dabei: j: Berichtsperiode, i: Basisperiode

Zwei Merkmale

Preisindex: Misst Preisveränderung mehrerer Güter

(Aggregation von Preismesszahlen durch Gewichtung)

Preisindizes

Korrelation

Notation:

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

p0 (i) :

pt (i) :

q0 (i) :

qt (i) :

Preis des i-ten Gutes in Basisperiode

0

Preis des i-ten Gutes in Berichtsperiode t

Menge des i-ten Gutes in Basisperiode

0

Menge des i-ten Gutes in Berichtsperiode t

6. Repräsentation

7. Klassifikation

78

Statistik

Etschberger - SS2014

Preisindizes

Gleichgewichteter Preisindex:

G

P0t =

n

n

X

pt (i)

1 X pt (i)

=

· g(i)

n i=1 p0 (i)

p0 (i)

i=1

mit

g(i) =

1

n

1. Einführung

2. Deskriptive Statistik

Nachteil: Auto und Streichhölzer haben gleiches Gewicht

Lösung: Preise mit Mengen gewichten!

Häufigkeiten

Lage und Streuung

Konzentration

Preisindex von Laspeyres:

Zwei Merkmale

Korrelation

n

P

L

P0t =

i=1

n

P

Preisindizes

pt (i)q0 (i)

p0 (i)q0 (i)

Lineare Regression

n

X

pt (i)

=

· g0 (i)

p0 (i)

i=1

mit

g0 (i) =

i=1

p0 (i) q0 (i)

n

P

p0 (j) q0 (j)

j=1

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Preisindex von Paasche:

n

P

P

P0t

=

i=1

n

P

i=1

pt (i)qt (i)

=

p0 (i)qt (i)

n

X

pt (i)

· gt (i)

p0 (i)

i=1

mit

gt (i) =

p0 (i) qt (i)

n

P

p0 (j) qt (j)

j=1

79

Statistik

Etschberger - SS2014

Preisindizes: Beispiel

Warenkorb: Kartoffeln und Kaffee

1. Einführung

1950

2013

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Preis

(€)

Menge pro

Woche

Preis

(€)

Menge pro

Woche

0,04

3,00

3,58

0,25

1,10

0,70

1,25

1,31

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

1 kg Kartoffeln

100 g Kaffeebohnen

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

L

P1950,

2013 =

1,10 · 3,58 + 0,70 · 0,25

≈ 4,6048

0,04 · 3,58 + 3,00 · 0,25

P

P1950,

2013 =

1,10 · 1,25 + 0,70 · 1,31

≈ 0,5759

0,04 · 1,25 + 3,00 · 1,31

6. Repräsentation

7. Klassifikation

80

Statistik

Etschberger - SS2014

Weitere Preisindizes

Idealindex von Fisher:

q

F

L PP

P0t = P0t

0t

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Marshall-Edgeworth-Index:

Lage und Streuung

Konzentration

n

P

ME

P0t

=

i=1

n

P

Zwei Merkmale

Korrelation

pt (i)[q0 (i) + qt (i)]

Preisindizes

Lineare Regression

3. W-Theorie

p0 (i)[q0 (i) + qt (i)]

4. Induktive Statistik

i=1

5. Datenanalyse

6. Repräsentation

Preisindex von Lowe:

n

P

LO

P0t

=

i=1

n

P

7. Klassifikation

Durchschn. Menge von

pt (i)q(i)

wobei

p0 (i)q(i)

q(i)=

ˆ Gut i über alle (bekannten)

Perioden

i=1

81

Statistik

Etschberger - SS2014

Weitere Preisindizes: Beispiel

Warenkorb: Kartoffeln und Kaffee

1950

2013

1. Einführung

2. Deskriptive Statistik

1 kg Kartoffeln

100 g Kaffeebohnen

Preis

(€)

Menge pro

Woche

Preis

(€)

Menge pro

Woche

0,04

3,00

3,58

0,25

1,10

0,70

1,25

1,31

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

F

P1950,2013

≈

√

4,6048 · 0,5759

= 1,6284

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

ME

P1950,2013

1,10 · (3,58 + 1,25) + 0,70 · (0,25 + 1,31)

=

0,04 · (3,58 + 1,25) + 3,00 · (0,25 + 1,31)

Lo

P1950,2013

=

= 1,3143

1,10 · 2,5 + 0,70 · 0,75

0,04 · 2,5 + 3,00 · 0,75

7. Klassifikation

= 1,3936

Annahme bei P LO : Durchschn. Mengen bei Kartoffeln bzw. Kaffebohnen von 1950 bis 2013

sind 2,5 bzw. 0,75.

82

Statistik

Etschberger - SS2014

Ausgangsdaten

Bundesliga 2008/2009

Gegeben: Daten zu

den 18 Vereinen der

ersten Bundesliga in

der Saison 2008/09

Merkmale:

Vereinssetat für

Saison (nur direkte

Gehälter und

Spielergehälter)

und Ergebnispunkte

in Tabelle am Ende

der Saison

FC Bayern

VfL Wolfsburg

SV Werder Bremen

FC Schalke 04

VfB Stuttgart

Hamburger SV

Bayer 04 Leverkusen

Bor. Dortmund

Hertha BSC Berlin

1. FC Köln

Bor. Mönchengladbach

TSG Hoffenheim

Eintracht Frankfurt

Hannover 96

Energie Cottbus

VfL Bochum

Karlsruher SC

Arminia Bielefeld

Etat

Punkte

80

60

48

48

38

35

35

32

31

28

27

26

25

24

23

17

17

15

67

69

45

50

64

61

49

59

63

39

31

55

33

40

30

32

29

28

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

(Quelle: Welt)

83

Statistik

Etschberger - SS2014

Darstellung der Daten in Streuplot

70

Bundesliga 2008/09

VfL Wolfsburg

FC Bayern

1. Einführung

VfB Stuttgart

Hertha BSC Berlin

2. Deskriptive Statistik

60

Hamburger SV

Häufigkeiten

Bor. Dortmund

Lage und Streuung

Konzentration

TSG Hoffenheim

Zwei Merkmale

Korrelation

50

Punkte

Preisindizes

FC Schalke 04

Bayer 04 Leverkusen

Lineare Regression

3. W-Theorie

SV Werder Bremen

4. Induktive Statistik

40

5. Datenanalyse

Hannover 96

1. FC Köln

6. Repräsentation

30

7. Klassifikation

Eintracht Frankfurt

VfL Bochum

Bor. Mönchengladbach

Energie Cottbus

Karlsruher SC

Arminia Bielefeld

20

40

60

80

Etat [Mio. Euro]

84

Statistik

Etschberger - SS2014

Trend als lineares Modell

Kann man die Tabellenpunkte näherungsweise über einfache

Funktion in Abhängigkeit des Vereinsetats darstellen?

Allgemein: Darstellung einer Variablen Y als Funktion von X:

1. Einführung

2. Deskriptive Statistik

y = f(x)

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Dabei:

Korrelation

X heißt Regressor bzw. unabhängige Variable

Y heißt Regressand bzw. abhängige Variable

Wichtiger (und einfachster) Spezialfall: f beschreibt einen

linearen Trend:

y = a + bx

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Dabei anhand der Daten zu schätzen: a (Achsenabschnitt)

und b (Steigung)

Schätzung von a und b: Lineare Regression

85

Statistik

Etschberger - SS2014

Fehlerquadratsumme

Pro Datenpunkt gilt mit Regressionsmodell:

yi = a + bxi + i

1. Einführung

Dabei: i ist jeweils Fehler (der Grundgesamtheit),

mit ei = yi − (â + b̂xi ): Abweichung (Residuen) zwischen

gegebenen Daten der Stichprobe und durch Modell

geschätzten Werten

Modell gut wenn alle Residuen ei zusammen möglichst klein

Einfache Summe aber nicht möglich, denn ei positiv oder

negativ

Deswegen: Summe der Quadrate von ei

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Prinzip der kleinsten Quadrate: Wähle a und b so, dass

Q(a, b) =

n

X

[yi − (a + bxi )]2 → min

i=1

86

Statistik

Etschberger - SS2014

Beste Lösung

Beste und eindeutige Lösung:

n

X

b̂ =

(xi − x̄)(yi − ȳ)

2. Deskriptive Statistik

i=1

n

X

(xi − x̄)2

i=1

n

X

=

1. Einführung

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

xi yi − nx̄ȳ

i=1

n

X

Lineare Regression

3. W-Theorie

4. Induktive Statistik

x2i − nx̄2

i=1

5. Datenanalyse

6. Repräsentation

7. Klassifikation

â = ȳ − b̂ x̄

Regressionsgerade:

ŷ = â + b̂ x

87

Statistik

Etschberger - SS2014

Bundesligabeispiel

Modell: ŷ = 25,443 + 0,634 · x

80

Berechnung eines

linearen Modells der

Bundesligadaten

70

dabei: Punkte =

ˆy

und Etat =

ˆ x:

1. Einführung

60

2. Deskriptive Statistik

Häufigkeiten

P

x2i

25209

xi yi

31474

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

18

5. Datenanalyse

20

n

50

46,89

40

y

P

Konzentration

30

33,83

Punkte

Lage und Streuung

x

6. Repräsentation

31474 − 18 · 33,83 · 46,89

25209 − 18 · 33,832

≈ 0,634

0

⇒ b̂ =

20

40

60

80

7. Klassifikation

Einkommen

Prognosewert für Etat = 30:

⇒ â = 46,89 − b̂ · 33,83

ŷ(30) = 25,443 + 0,634 · 30

≈ 25,443

≈ 44,463

88

Statistik

Etschberger - SS2014

Varianz und Information

Varianz der Daten in abhängiger Variablen yi als Repräsentant des

Informationsgehalts

Ein Bruchteil davon kann in Modellwerten ŷi abgebildet werden

80

80

1. Einführung

2. Deskriptive Statistik

70

70

60

60

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

50

Preisindizes

50

Lineare Regression

3. W-Theorie

40

40

4. Induktive Statistik

30

5. Datenanalyse

30

6. Repräsentation

7. Klassifikation

80

60

40

20

0

model

20

points

20

Empirische Varianz (mittlere quadratische Abweichung) für „rot“ bzw. „grün“

ergibt jeweils

1

18

18

X

i=1

(yi − y)2 ≈ 200,77

bzw.

1

18

18

X

(ŷi − y)2 ≈ 102,78

i=1

89

Statistik

Etschberger - SS2014

Determinationskoeffizient

Gütemaß für die Regression: Determinationskoeffizient

(Bestimmtheitskoeffizient):

n

P

R2 =

n

P

(ŷi − ȳ)2

i=1

n

P

=

(yi −

ȳ)2

i=1

i=1

n

P

1. Einführung

ŷ2i − nȳ2

= r2 ∈ [0; 1]

y2i

−

nȳ2

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

i=1

Zwei Merkmale

Korrelation

Preisindizes

Mögliche Interpretation von R2 :

Durch die Regression erklärter Anteil der Varianz

Lineare Regression

3. W-Theorie

R2 = 0 wird erreicht wenn X, Y unkorreliert

R2 = 1 wird erreicht wenn ŷi = yi ∀ i (alle Punkte auf

Regressionsgerade)

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Im (Bundesliga-)Beispiel:

18

P

R2 =

i=1

18

P

(ŷi − y)2

≈

(yi − y)2

102,78

≈ 51,19 %

200,77

i=1

90

Statistik

Etschberger - SS2014

Regression: 4 eindimensionale Beispiele

Berühmte Daten aus den 1970er Jahren:

1. Einführung

i

1

2

3

4

5

6

7

8

9

10

11

x1i

x2i

x3i

x4i

y1i

y2i

y3i

y4i

10

8

13

9

11

14

6

4

12

7

5

10

8

13

9

11

14

6

4

12

7

5

10

8

13

9

11

14

6

4

12

7

5

8

8

8

8

8

8

8

19

8

8

8

8,04

6,95

7,58

8,81

8,33

9,96

7,24

4,26

10,84

4,82

5,68

9,14

8,14

8,74

8,77

9,26

8,10

6,13

3,10

9,13

7,26

4,74

7,46

6,77

12,74

7,11

7,81

8,84

6,08

5,39

8,15

6,42

5,73

6,58

5,76

7,71

8,84

8,47

7,04

5,25

12,50

5,56

7,91

6,89

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

(Quelle: Anscombe (1973))

91

Statistik

Etschberger - SS2014

Beispieldaten

1. Einführung

2. Deskriptive Statistik

meineRegression = lm(AlterM ~ AlterV)

meineRegression

plot(AlterV, AlterM,

xlab="Alter des Vaters",

ylab="Alter der Mutter")

abline(meineRegression)

## Error: Objekt ’AlterM’ nicht

gefunden

## Error: Objekt ’meineRegression’

nicht gefunden

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

## Error: Objekt ’AlterV’ nicht gefunden

## Error: Objekt ’meineRegression’ nicht gefunden

## Error: plot.new wurde noch nicht aufgerufen

5. Datenanalyse

6. Repräsentation

7. Klassifikation

94

PLU

S

Statistik

Etschberger - SS2014

Cook’s Distanz

Oft Kritisch: Einzelne Punkte, die Modell stark beeinflussen

Idee: Was würde sich ändern, wenn solche Punkte

weggelassen würden?

Cook-Distanz: Misst den Effekt eines gelöschten Objekts

Formel für ein lineares Modell mit einem unabh. Merkmal:

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

n

P

Di =

Preisindizes

2

(ŷj − ŷj(ohne i) )

j=1

MSE

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

Dabei bedeutet:

6. Repräsentation

7. Klassifikation

ŷj : Prognosewert des kompletten Modells für das j-te Objekt

ŷj(ohne i) : Prognosewert des Modells ohne Objekt i für das j-te

Objekt

P

MSE = n1 · (ŷi − yi )2 : Normierender Term (Schätzwert für

Fehlerstreuung)

95

PLU

S

Statistik

Etschberger - SS2014

Ausreißer?

Anscombe-Daten: Regressionsmodell Nr. 3

Darstellung der Cook-Distanz neben Punkten

Faustformel: Werte über 1 sollten genau untersucht werden

1. Einführung

2. Deskriptive Statistik

1.39

Häufigkeiten

12

Lage und Streuung

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

10

Lineare Regression

3. W-Theorie

y3

4. Induktive Statistik

5. Datenanalyse

0.3

6. Repräsentation

8

0.06

0.03

7. Klassifikation

0.01

0.01

0

0

6

0

0.01

0.03

4

6

8

10

12

14

x3

96

Statistik

Etschberger - SS2014

Residualanalyse

Oft aufschlussreich: Verteilung der Residuen ei

Verbreitet: Graphische Darstellungen der Residuen

Z.B.: ei über ŷi

1. Einführung

3

12

3

2. Deskriptive Statistik

Häufigkeiten

Konzentration

1

Zwei Merkmale

Korrelation

Preisindizes

0

8

y3

Residuals

10

2

Lage und Streuung

−1

6

Lineare Regression

9

4

6

8

10

12

14

6

5

6

x3

7

8

9

10

Fitted values

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

Residuals vs Fitted

2

6. Repräsentation

9

0

−1

6

y1

8

Residuals

1

10

7. Klassifikation

4

−2

10

4

6

8

10

x1

12

14

3

5

6

7

8

Fitted values

9

10

97

Residualanalyse

Wichtige Eigenschaften der Residuenverteilung

Möglichst keine systematischen Muster

Statistik

Etschberger - SS2014

1. Einführung

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Keine Änderung der Varianz in Abhängigkeit von ŷi

(Homoskedastizität)

Nötig für inferentielle Analysen: Näherungsweise

Normalverteilung der Residuen (q-q-plots)

Konzentration

Zwei Merkmale

Korrelation

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

##

##

##

##

Error:

Error:

Error:

Error:

Objekt ’AlterV’ nicht gefunden

Objekt ’meineRegression’ nicht gefunden

plot.new wurde noch nicht aufgerufen

Objekt ’meineRegression’ nicht gefunden

5. Datenanalyse

6. Repräsentation

7. Klassifikation

98

Kausalität versus Korrelation

Statistik

Etschberger - SS2014

1. Einführung

Exkurs: Kausalität vs. Korrelation

2. Deskriptive Statistik

Häufigkeiten

Lage und Streuung

Meist wichtig für sinnvolle Regressionsanalysen:

Konzentration

Zwei Merkmale

Korrelation

Kausale Verbindung zwischen unabhängigem und

abhängigem Merkmal

Sonst bei Änderung der unabhängigen Variablen keine

sinnvollen Prognosen möglich

Oft: Latente Variablen im Hintergrund

Preisindizes

Lineare Regression

3. W-Theorie

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

99

Statistik: Table of Contents

1

Statistik: Einführung

2

Deskriptive Statistik

3

Wahrscheinlichkeitstheorie

4

Induktive Statistik

5

Datenanalyse Einleitung

6

Repräsentation

7

Klassifikation

3

Wahrscheinlichkeitstheorie

Kombinatorik

Zufall und Wahrscheinlichkeit

Zufallsvariablen und Verteilungen

Verteilungsparameter

Statistik

Etschberger - SS2014

Kombinatorik: Anzahl von Kombinationen bei Auswahl

2-mal Würfeln, das

heißt Auswahl von

k = 2 aus n = 6

Zahlen.

(1,1)

(2,1)

(3,1)

(4,1)

(5,1)

(6,1)

(1,2)

(2,2)

(3,2)

(4,2)

(5,2)

(6,2)

(1,3)

(2,3)

(3,3)

(4,3)

(5,3)

(6,3)

(1,4)

(2,4)

(3,4)

(4,4)

(5,4)

(6,4)

(1,5)

(2,5)

(3,5)

(4,5)

(5,5)

(6,5)

(1,6)

(2,6)

(3,6)

(4,6)

(5,6)

(6,6)

1. Einführung

2. Deskriptive Statistik

3. W-Theorie

Kombinatorik

Zufall und Wahrscheinlichkeit

ohne WH, ohne RF: Hälfte des letzten

Ergebnisses:

6

30

6!

2 = 15 = 4!2! = 2

mit WH, mit RF: alle Möglichkeiten,

62 = 36

ohne WH, mit RF: Diagonale entfällt,

6!

36 − 6 = 30 = 6 · 5 =

(6 − 2)!

mit WH, ohne RF: Letztes Ergebnis

plus Diagonale, 15 + 6 = 21 =

Zufallsvariablen und

Verteilungen

Verteilungsparameter

4. Induktive Statistik

5. Datenanalyse

7

2

6. Repräsentation

7. Klassifikation

Auswahl von k aus n Dingen

mit Wiederholung

nk

mit

Reihenfolge

ohne

Reihenfolge

n+k−1

k

ohne Wiederholung

n!

(n − k)!

n

k

101

Zufallsvorgänge, Ereignisse und Wahrscheinlichkeiten

Zufallsvorgang: Geschehen mit ungewissem Ausgang, z.B.

Münzwurf

Statistik

Etschberger - SS2014

1. Einführung

2. Deskriptive Statistik

Elementarereignis ω: Ein möglicher Ausgang, z.B. „ Kopf “

Elementarereignisse schließen sich gegenseitig aus

(„ Kopf “ oder „ Zahl “)!

Ergebnismenge Ω: Menge aller ω

3. W-Theorie

Kombinatorik

Zufall und Wahrscheinlichkeit

Zufallsvariablen und

Verteilungen

Verteilungsparameter

4. Induktive Statistik

Beispiel: Werfen zweier Würfel:

(1,1) (1,2)

(2,1) (2,2)

Ω:

..

..

.

.

(6,1) (6,2)

5. Datenanalyse

···

···

..

.

···

(1,6)

(2,6)

..

.

(6,6)

6. Repräsentation

7. Klassifikation

⇒ Ω = {(x1 , x2 ) : x1 , x2 ∈ {1, . . . ,6}}

102

Statistik

Etschberger - SS2014

Ereignisse und Wahrscheinlichkeiten

Ereignis A: Folgeerscheinung eines Elementarereignisses

Formal:

1. Einführung

A⊂Ω

2. Deskriptive Statistik

Ereignisse schließen sich nicht gegenseitig aus!

Beispiel: Werfen zweier Würfel:

3. W-Theorie

Kombinatorik

Zufall und Wahrscheinlichkeit

Zufallsvariablen und

Verteilungen

Verteilungsparameter

Ereignis

A

B

verbal

Augensumme = 4

Erste Zahl = 2

formal

{(1,3), (2,2), (3,1)}

{(2,1), (2,2), . . . , (2,6)}

4. Induktive Statistik

5. Datenanalyse

6. Repräsentation

7. Klassifikation

Wahrscheinlichkeit P(A): Chance für das Eintreten von A

Laplace-Wahrscheinlichkeit:

P(A) =

|A|

Anzahl der für A günstigen Fälle

=

|Ω|

Anzahl aller möglichen Fälle

103

Statistik

Etschberger - SS2014

Laplace Wahrscheinlichkeit und Urnenmodell

Beispiel: Werfen zweier Würfel:

Augensumme = 4 : A = {(1,3), (2,2), (3,1)}

|Ω| = 36, |A| = 3 ⇒ P(A) =

1. Einführung

2. Deskriptive Statistik

3

36

=

1

12

= 0,083

3. W-Theorie

Kombinatorik

Urnenmodell: Ziehe n Objekte aus einer Menge

mit N Objekten

Anzahl Möglichkeiten:

Zufall und Wahrscheinlichkeit

Zufallsvariablen und

Verteilungen

Verteilungsparameter

4. Induktive Statistik

5. Datenanalyse

mit Zurücklegen: Nn

ohne Zurücklegen: N · (N − 1) · · · (N − (n − 1)) =

6. Repräsentation

N!

(N−n)!

7. Klassifikation

Beispiel:

Wie groß ist die Wahrscheinlichkeit, aus einem gut

gemischten 32-er Kartenblatt bei viermaligem Ziehen vier

Asse zu bekommen?

a) Ziehen mit Zurücklegen,

b) Ziehen ohne Zurücklegen

104

Statistik

Etschberger - SS2014

Rechenregeln für Wahrscheinlichkeiten

Wichtige Rechenregeln:

1. Einführung

2. Deskriptive Statistik

1. P(A) 5 1

A

B