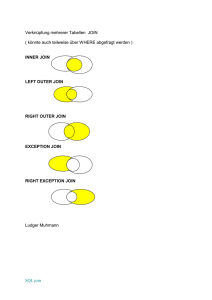

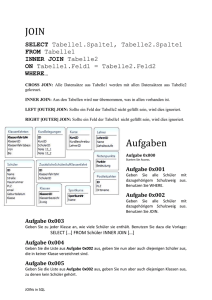

Verteilte Verarbeitung von Joins in MapReduce

Werbung