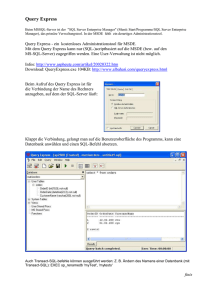

GI-Edition - Abteilung Datenbanken Leipzig

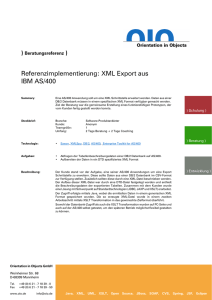

Werbung