Kap. 2: Kurzwiederholung Wahrscheinlichkeitsrechnung und

Werbung

Kap. 2: Kurzwiederholung

Wahrscheinlichkeitsrechnung und Statistik

• Empirische Fragestellung

• Datenanalyse: Schätzung, Test, Konfidenzintervall

• Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

• Punktschätzung

• Hypothesentests

• Konfidenzintervalle

2.1

Empirische Fragestellung

Bildungsökonomische Frage: Sind kleine Klassen besser?

Konkret: wie ist der Zusammenhang zwischen Klassengrösse und Lernleistung der Schüler?

• Daten bei Stock und Watson: 420 Schuldistrikte in Kalifornien für das Jahr 1998

• Variablen: Anzahl Schüler und Lehrer pro Bezirk, Ergebnisse standardisierter Tests für Lesen

und Mathematik (→ PISA), diverse demographische Variablen

• Definiere neue Variablen:

– score := Durchschnitt aus Rechen- und Leseleistungen

– stratio (“student-teacher ratio”)

Schüler-Lehrer-Quotient

:=

Anzahl Schüler

Anzahl Lehrer

(in Vollzeitäquivalenten)

C. Kleiber: Ökonometrie 1

Kap. 2-1

U Basel, HS 2009

2.2

Datenanalyse

Ein Blick auf die Daten:

R>

R>

R>

R>

data("CASchools", package = "AER")

CASchools$stratio <- with(CASchools, students/teachers)

CASchools$score <- with(CASchools, (math + read)/2)

attach(CASchools)

R> summary(stratio)

Min. 1st Qu.

14.0

18.6

Median

19.7

Mean 3rd Qu.

19.6

20.9

Max.

25.8

Mean 3rd Qu.

654

667

Max.

707

R> summary(score)

Min. 1st Qu.

606

640

C. Kleiber: Ökonometrie 1

Median

654

Kap. 2-2

U Basel, HS 2009

2.2

Datenanalyse

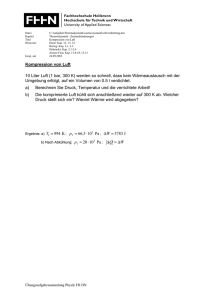

Etwas mehr zeigen Boxplots:

stratio

26

score

●

●

●

18

14

16

20

660

640

620

C. Kleiber: Ökonometrie 1

●

22

680

24

700

●

Kap. 2-3

●

●

●

●

●

U Basel, HS 2009

2.2

Datenanalyse

720

Den Zusammenhang visualisiert ein Streudiagramm:

700

●

●

● ●

●

●

● ●

● ●

●

●

●

● ●

●

●

●●

●

●●

● ●

●

●

●

●●

●

●

●

●

●

●

●

●

● ● ● ●● ● ● ●

●

●

● ●●

● ●●

●

●● ●

●

●

●● ●●

●●

●

●

●

●

●

●

●

● ●●● ●● ●

●●● ● ●

●

●

●●

●

●●

●

●

●●

●

● ●●

● ●●

●● ●● ●

●●

●●

●

●

●

●●

●

●●●

●

●

●

●

●● ● ●

●

●

●

●

●

●

● ● ● ●●

● ●●

● ●

●

● ● ●

●

●● ● ●

● ●●●

●

●●●

●●●

●

●

●

●

●

●

●●

●

●

●

● ●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●● ● ●●

●

●

●

●

●

●

●

●

●

●●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●● ●

●●●

●

●

●●

●

●

●

●

●

●

●●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●●●●●●

●●

● ● ●●●

● ●

●

● ● ●●

●

● ●● ●

●

●

●

●● ●

●

●

●

●●●

●●●●●●

●

●

●

●

●

●

●

●

●

●

●

●●

●●

●●

●

●

●●● ● ●●● ● ● ●

●

●

●

●

●

●

●

● ●

●

●

●

●

●

●

●

●

●● ● ●

●● ●

●●●

● ● ●● ● ● ●

●

●

●

●

●

●

●

●

●

●

● ●

●

●

●

● ●

●

●● ● ●●

●

●

●

●

●

660

680

●

600

620

640

score

●

10

●●

●

15

20

25

●

●

30

stratio

C. Kleiber: Ökonometrie 1

Kap. 2-4

U Basel, HS 2009

2.2

Datenanalyse

Gesucht: Belege für negativen Zusammenhang zwischen Klassengrösse und Testergebnis

Mögliche Vorgehensweisen:

1. Vergleiche durchschnittliche Testergebnisse für Bezirke mit kleinen und grossen Klassen

→ Punktschätzung

2. Teste auf Gleichheit der erwarteten Testergebnisse für Bezirke mit kleinen und grossen

Klassen

→ Hypothesentest

3. Bestimme Intervall für die Differenz der durchschnittlichen Testergebnisse

→ Intervallschätzung (Konfidenzintervall)

C. Kleiber: Ökonometrie 1

Kap. 2-5

U Basel, HS 2009

2.2

Datenanalyse

Klassengrösse: definiere Klassen als

• “klein”, falls stratio < 20

• “gross”, falls stratio ≥ 20

Klassengrösse

klein

gross

Ȳ

657.25

650.08

sY

19.39

17.85

n

239

181

Gesucht:

1. Schätzung für ∆ = Differenz zwischen Gruppen

2. Test der Hypothese ∆ = 0

3. Konfidenzintervall für ∆

C. Kleiber: Ökonometrie 1

Kap. 2-6

U Basel, HS 2009

2.2

Datenanalyse

zu 1.: mit

ng

n

k

1 X

Ȳk :=

Yi

nk i=1

und

1 X

Ȳg :=

Yi

ng i=1

ist naheliegende (Punkt-)Schätzung für Differenz ∆

ˆ = Ȳk − Ȳg = 7.17

∆

Ist dieser Unterschied gross (für praktische Zwecke)?

ˆ = 7.17 entspricht ungefähr Differenz zwischen 75- und 60-Prozent-Quantil:

∆

q0.75 − q0.60 = 666.66 − 659.4 = 7.26

→ Unterschied relativ gross (für praktische Zwecke)

C. Kleiber: Ökonometrie 1

Kap. 2-7

U Basel, HS 2009

2.2

Datenanalyse

zu 2.: Hypothesentest für H0 : ∆ = 0 vs. H1 : ∆ 6= 0

Zweistichproben-t-Test (Typ: “Welch-Test”) beruht auf

Ȳk − Ȳg

r

t=

s2k

nk

wobei

s2k =

+

s2g

ng

nk

X

1

(Yi − Ȳ )2, analog s2g

nk − 1 i=1

Hier ist

t=q

7.17

375.79

239

+ 318.76

181

7.17

=√

= 3.93

3.33

Da |t| > 1.96: lehne H0 zum Niveau α = 0.05 ab.

Bem.: Da Stichprobe relativ gross (n = 420), verwenden wir einen approximativen t-Test,

d.h. kritische Werte kommen aus der Normalverteilung.

C. Kleiber: Ökonometrie 1

Kap. 2-8

U Basel, HS 2009

2.2

Datenanalyse

Natürlich gibt es in R auch eine eingebaute Funktion für den t-Test:

R> CAsmall <- subset(CASchools, stratio < 20)

R> CAlarge <- subset(CASchools, stratio >= 20)

R> t.test(CAsmall$score, CAlarge$score)

Welch Two Sample t-test

data: CAsmall$score and CAlarge$score

t = 3.927, df = 402.3, p-value = 0.0001013

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

3.58 10.76

sample estimates:

mean of x mean of y

657.2

650.1

Die Funktion geht von ungleichen Varianzen in den Teilstichproben aus (“Welch-Version” des

Tests). Siehe ?t.test, dort steht als Voreinstellung: var.equal = FALSE.

C. Kleiber: Ökonometrie 1

Kap. 2-9

U Basel, HS 2009

2.2

Datenanalyse

zu 3.: Konfidenzintervall zum Niveau 1 − α = 0.95 für Differenz der Mittelwerte ist

(Ȳk − Ȳg ) ± 1.96 ·

q

c Ȳk − Ȳg ) = 7.17 ± 1.96 · 1.83 = (3.58, 10.76)

Var(

Folgende Aussagen sind äquivalent:

• das 95%-Konfidenzintervall für ∆ enthält nicht 0

• die Hypothese H0 : ∆ = 0 wird zum Niveau α = 0.05 abgelehnt

Bem.: Auch hier ein approximatives Intervall, da Stichprobe relativ gross (n = 420).

C. Kleiber: Ökonometrie 1

Kap. 2-10

U Basel, HS 2009

2.3

Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

• Grundgesamtheit (GG): alle (denkbaren) Schulbezirke

• Zufallsvariable: Testergebnis, Lehrer-Schüler-Quotient vor Durchführung des Zufallsexperiments (d.h. Auswahl des Schulbezirks, Jahres)

• Realisation: Testergebnis, Lehrer-Schüler-Quotient nach Durchführung des Zufallsexperiments

• Verteilung:

– W’keiten für einzelne Ausprägungen von Y in GG (falls Y diskret)

Bsp.: P (Y = 611)

– W’keiten für Mengen (Intervalle) von Ausprägungen von Y in GG (falls Y stetig)

Bsp.: P (Y ≤ 643)

• Momente:

– Erwartungswert E(Y ) =: µY

– Varianz Var(Y ) = E[(Yp− E(Y ))2] =: σY2

– Standardabweichung Var(Y ) =: σY

C. Kleiber: Ökonometrie 1

Kap. 2-11

U Basel, HS 2009

2.3

Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

Bedingte Verteilung:

Verteilung von Y gegeben eine andere Zufallsvariable X

Bsp.: Verteilung der Testergebnisse für Bezirke mit kleinen Klassen

Y Testergebnis, X Klassengrösse, also Vtlg. von Y |(stratio < 20)

Wichtige Kenngrössen von bedingten Verteilungen sind

• bedingter Erwartungswert

• bedingte Varianz

E(Y |X = x) =: µY |X

Var(Y |X = x) =: σY2 |X

Beispiele:

• E(Testergebnis |stratio < 20)

• ∆ = E(Testergebnis |stratio < 20) – E(Testergebnis |stratio ≥ 20)

• erwartetes Einkommen von Männern (hier ist X Geschlecht)

C. Kleiber: Ökonometrie 1

Kap. 2-12

U Basel, HS 2009

2.3

Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

Bedingte Erwartungen:

Sei Y diskret mit Werten y1, . . . , yk . Dann ist

E(Y |X = x) =

k

X

yiP (Y = yi|X = x)

i=1

Wichtiges Resultat zu bedingten Erwartungen:

Satz über iterierte Erwartungen: (“law of iterated expectations”)

E(Y ) = E(E(Y |X))

= EX (EY |X (Y |X))

Bsp.: Sei Y Einkommen, X Geschlecht, dann

E(Y ) = E(Y |Frau)P (Frau) + E(Y |Mann )P (Mann ) = E(E(Y |X))

Wir werden später oft folgendes Argument verwenden: aus E(Y |X) = 0 folgt E(Y ) = 0.

C. Kleiber: Ökonometrie 1

Kap. 2-13

U Basel, HS 2009

2.3

Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

●

●

660

●

●

●

●

●

●

650

mean(score)

670

Empirisches Gegenstück zu bedingten Erwartungen: Gruppenmittelwerte.

Für unsere Daten ist das durchschnittliche Testergebnis als Funktion des stratio:

●

●

●

640

●

●

14

16

18

20

22

24

26

stratio

C. Kleiber: Ökonometrie 1

Kap. 2-14

U Basel, HS 2009

2.3

Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

Kovarianz:

Cov(Y, Z) = E[(Y − E(Y ))(Z − E(Z))] =: σY Z

Eigenschaften:

• misst linearen (!!) Zusammenhang zwischen Y und Z

• falls Y und Z stoch. unabh., dann Cov(Y, Z) = 0 (Umkehrung falsch!)

• Kovarianz zwischen Y und Y ist Varianz:

Cov(Y, Y ) = E[(Y − E(Y ))(Y − E(Y ))] = E[(Y − E(Y ))2] = σY2 (= σY Y )

C. Kleiber: Ökonometrie 1

Kap. 2-15

U Basel, HS 2009

2.3

Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

Korrelation:

Cor(Y, Z) := p

σY Z

Cov(Y, Z)

p

=

Var(Y ) Var(Z) σY σZ

Eigenschaften:

• −1 ≤ Cor(Y, Z) ≤ 1

• Cor(Y, Z) = ±1 bedeutet perfekter linearer Zusammenhang

• Cor(Y, Z) = 0 bedeutet kein linearer Zusammenhang

• E(Y |Z) = const., dann ist Cor(Y, Z) = 0 (Umkehrung falsch!)

C. Kleiber: Ökonometrie 1

Kap. 2-16

U Basel, HS 2009

2.3

Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

720

Für unsere Daten ist Cor(score, stratio) = −0.23

700

●

●

● ●

●

●

● ●

● ●

●

●

●

● ●

●

●

●●

●

●●

● ●

●

●

●

●●

●

●

●

●

●

●

●

●

● ● ● ●● ● ● ●

●

●

● ●●

● ●●

●

●● ●

●

●

●● ●●

●●

●

●

●

●

●

●

● ●●● ●● ●

●●● ●● ●

●

●

●●

●

●●

●

●

●●

●

● ●●

● ●●

●● ●● ●

●●

●●

●

●

●

●●

●

●●●

●

●

●

●

●● ● ●

●

●

●

●

●

●

● ● ● ●●

● ●●

● ●

●

● ● ●

●

●● ● ●

● ●●●

●

●●●

●●●

●

●

●

●

●

●

●●

●

●

●

● ●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●● ● ●●

●

●

●

●

●

●

●

●

●

●●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●● ●

●●●

●

●

●●

●

●

●

●

●

●

●●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●●●●●●

●●

● ● ●●●

● ●

●

● ● ●●

●

● ●● ●

●

●

●

●● ●

●

●

●

●●●

●●●●●●

●

●

●

●

●

●

●

●

●

●

●

●●

●●

●●

●

●

●●● ● ●●● ● ● ●

●

●

●

●

●

●

●

● ●

●

●

●

●

●

●

●

●

●● ● ●

●● ●

●●●

● ● ●● ● ● ●

●

●

●

●

●

●

●

●

●

●

● ●

●

●

●

● ●

●

●● ● ●●

●

●

●

●

●

660

680

●

600

620

640

score

●

10

●●

●

15

20

25

●

●

30

stratio

C. Kleiber: Ökonometrie 1

Kap. 2-17

U Basel, HS 2009

2.3

Grundbegriffe der Wahrscheinlichkeitsrechnung und Statistik

Stichproben und Stichprobenfunktionen:

Formaler Rahmen in Statistik 2:

Einfache Zufallsstichprobe, d.h. jede Stichprobe vom Umfang n wird mit gleicher W’keit

ausgewählt.

Folgerungen:

• Y1, Y2, . . . , Yn sind stochastisch unabhängig

• Y1, Y2, . . . , Yn sind identisch verteilt

Kurzschreibweise: Y1, Y2, . . . , Yn sind u.i.v. (unabhängig und identisch verteilt).

Engl.: i.i.d. (für “independently and identically distributed”)

Eine Zufallsvariable Z, die als Funktion der Stichprobenvariablen Y1, Y2, . . . , Yn definiert ist,

also Z = g(Y1, Y2, . . . , Yn), heisst eine Stichprobenfunktion oder auch eine Statistik.

Typische Stichprobenfunktionen sind Punktschätzer, Intervallschätzer und Teststatistiken.

C. Kleiber: Ökonometrie 1

Kap. 2-18

U Basel, HS 2009

2.4

Punktschätzung

Naheliegend: schätze µY durch Ȳ – Welche Eigenschaften hat der Schätzer, wenn Yi u.i.v.?

X

n

n

1

1

1X

E(Ȳ ) = E

Yi =

E(Yi) = · n · µy = µy

n i=1

n i=1

n

und

X

n

1

Var(Ȳ ) = Var

Yi

n i=1

=

n

n

n

1 X X

1 X

Var(Yi) + 2

Cov(Yi, Yj )

n2 i=1

n i=1

j=1,j6=i

n

C. Kleiber: Ökonometrie 1

=

1 X 2

σY + 0

2

n i=1

=

σY2

n

Kap. 2-19

U Basel, HS 2009

2.4

Punktschätzung

Ergebnis: E(Ȳ ) = µY und Var(Ȳ ) = σY2 /n

Interpretation:

• Ȳ ist ein unverzerrter Schätzer für µY

• Var(Ȳ ) ist umgekehrt proportional zu n – Schätzer wird mit grösserem n genauer!

√

• Standardabweichung der Verteilung von Ȳ ist proportional zu 1/ n

Dies sind nur die Momente der Verteilung von Ȳ – was ist die exakte Verteilung?

Bsp.: Sei Y ∼ Bin (1, p), also E(Y ) = p und Var(Y ) = p(1 − p). Exakte Verteilung von Ȳ

für kleines n sehr kompliziert.

Aber: für “grosses” n wird es einfach!

Wegen Var(Ȳ ) = σ 2/n ist mit wachsendem n Verteilung stärker konzentriert um µY .

Statistik für “grosses” n hat zwei Hauptresultate:

(1) Gesetz der grossen Zahlen und (2) zentraler Grenzwertsatz.

C. Kleiber: Ökonometrie 1

Kap. 2-20

U Basel, HS 2009

2.4

Punktschätzung

Gesetz der grossen Zahlen: (engl.: law of large numbers, LLN)

Falls Y1, Y2, ..., Yn u.i.v. und σY2 < ∞, dann gilt für alle > 0

P (|Ȳ − µY | < ) → 1 für n → ∞

P

Notation: Ȳ −→ µY oder auch p lim(Ȳ ) = µY , für “Ȳ konvergiert in W’keit gegen µY ”

[Beweis: folgt direkt aus der Tschebyschev-Ungleichung!]

Statistische Sprechweise: der Schätzer Ȳ ist konsistent für µY

C. Kleiber: Ökonometrie 1

Kap. 2-21

U Basel, HS 2009

2.4

Punktschätzung

0.0

0.2

0.4

Y

0.6

0.8

1.0

Illustration: das Stichprobenmittel als Funktion von n.

Simulation von Yi ∼ Bin (1, p), i = 1, ..., 400, mit p = 0.68.

0

100

200

300

400

n

C. Kleiber: Ökonometrie 1

Kap. 2-22

U Basel, HS 2009

2.4

Punktschätzung

Zentraler Grenzwertsatz: (engl. “central limit theorem”, CLT)

Falls Y1, Y2, . . . , Yn u.i.v. und σY2 < ∞, dann gilt für n → ∞

√ Ȳ − µY d

n

−→ N (0, 1)

σY

d.h. die linke Seite konvergiert “in Verteilung” gegen eine standardnormalverteilte Zufallsvariable. Etwas technischer: hier konvergieren die Verteilungsfunktionen, nämlich

√ Ȳ − µY

P

n

≤y

σY

→ Φ(y) ∀y.

Anwendung: für grosse n gilt näherungsweise

√ Ȳ − µY a

n

∼ N (0, 1)

σY

C. Kleiber: Ökonometrie 1

d.h.

Kap. 2-23

Ȳ ≈ N µY ,

σY2

n

U Basel, HS 2009

2.4

Punktschätzung

10

0

5

Density

15

Illustration: Simulation der Verteilung des Stichprobenmittels Ȳ bei Yi ∼ Bin (1, p), i =

1, ..., 400, mit p = 0.68. (10’000 Simulationen)

0.60

C. Kleiber: Ökonometrie 1

0.65

0.70

Kap. 2-24

0.75

U Basel, HS 2009

2.4

Punktschätzung

Zusammenfassung: Eigenschaften von Ȳ als Schätzer von µY

Falls Y1, Y2, . . . , Yn u.i.v. und σY2 < ∞, dann

• Ȳ unverzerrt für µY mit Varianz σY2 /n

• exakte Verteilung meist kompliziert, aber

P

– es gilt Ȳ −→ µY (Konsistenz)

2

a

σ

– es gilt Ȳ ∼ N µY , nY für n “gross” (approximative Normalverteilung)

Weitere Eigenschaften: Ȳ ist der Kleinstquadrate-Schätzer (KQ-Schätzer) für µY , d.h. er löst

das Optimierungsproblem

n

X

(Yi − m)2

i=1

C. Kleiber: Ökonometrie 1

Kap. 2-25

→ min!

m

U Basel, HS 2009

2.5

Hypothesentest

Hypothesentest: entscheide, ob Daten gegen Nullhypothese sprechen. Dabei

H0 : E(Y ) = µY,0 vs. H1 : E(Y ) > µY,0

einseitiges Testproblem

H0 : E(Y ) = µY,0 vs. H1 : E(Y ) < µY,0

einseitiges Testproblem

H0 : E(Y ) = µY,0 vs. H1 : E(Y ) 6= µY,0

zweiseitiges Testproblem

Signifikanzniveau: vorgegebene W’keit, Nullhypothese zu Unrecht abzulehnen (bei wiederholter Durchführung des Tests)

Fehler: Beim Testen statistischer Hypothesen kann man zwei Fehler machen

• ablehnen, obwohl man das nicht sollte (H0 wahr) – Fehler 1. Art

• nicht ablehnen, obwohl man das sollte (H0 falsch) – Fehler 2. Art

Vorsicht: die Hypothesen H0 und H1 werden nicht symmetrisch behandelt!

Statistische Tests sind so konstruiert, dass sie den Fehler 1. Art kontrollieren.

C. Kleiber: Ökonometrie 1

Kap. 2-26

U Basel, HS 2009

2.5

Hypothesentest

Vorgehen in Statistik 2 nach Lehrbuch:

• gebe Signifikanzniveau vor

• berechne Teststatistik

• vergleiche Teststatistik mit kritischem Wert zu vorgegebenem Signifikanzniveau

Beim Arbeiten mit statistischer Software geht man anders vor, man benutzt p-Werte.

p-Wert: W’keit, einen mindestens so extremen Wert der Teststatistik zu erhalten wie aus den

Daten berechnet, gegeben die Nullhypothese ist wahr.

Heisst oft auch marginales Signifikanzniveau: kleinstes Niveau, zu dem H0 gerade noch verworfen werden kann.

Für das Beispiel Ȳ :

p-Wert = PH0 (|Ȳ − µY,0| > |ȳ − µY,0|).

Berechnung erfordert Verteilung von Ȳ .

C. Kleiber: Ökonometrie 1

Kap. 2-27

U Basel, HS 2009

2.5

Hypothesentest

Falls n gross, kann wieder approximative Verteilung (hier Normalverteilung) benutzt werden.

Betrachte dazu

Ȳ − µY,0 ȳ − µY,0 √ > √ p-Wert = PH0 (|Ȳ − µY,0| > |ȳ − µY,0|) = PH0 σY / n

σY / n

Leider ist σ 2 in der Regel unbekannt – schätze σY2 durch

n

X

1

(Yi − Ȳ )2

s2Y =

n − 1 i=1

P

Es gilt: falls Y1, Y2, . . . , Yn u.i.v. und E(Y 4) < ∞, dann s2Y −→ σY2 .

C. Kleiber: Ökonometrie 1

Kap. 2-28

U Basel, HS 2009

2.5

Hypothesentest

Mit Schätzung von σY2 gilt approximativ

p-Wert

Ȳ − µY,0 ȳ − µY,0 √ > √ = PH0 (|Ȳ − µY,0| > |ȳ − µY,0|) = PH0 σY / n

σY / n

Ȳ − µY,0 ȳ − µY,0 √ > √ = PH0 (|t| > |t∗|)

≈ PH0 sY / n

sY / n

≈ 2(1 − Φ(|t∗|))

Ȳ −µ

die t-Statistik und t∗ deren Stichprobenwert.

Dabei ist t = s /√Y,0

n

Y

Praxis: Lehne H0 zu vorgegebenem Niveau α = 0.05 ab, falls

• |t| > 1.96 bzw.

• p-Wert ≤ 0.05.

Statistische/ökonometrische Softwarepakete verwenden generell p-Werte!

C. Kleiber: Ökonometrie 1

Kap. 2-29

U Basel, HS 2009

2.5

Hypothesentest

Bemerkungen:

• falls Y1, Y2, . . . , Yn u.i.v. N (µY , σY2 ), dann gilt exakt: t ∼ tn−1 (t-Verteilung mit n − 1

Freiheitsgraden)

• für n > 30 sind tn- und N (0, 1)-Verteilung sehr ähnlich

• häufig Normalverteilungsannahme nicht gerechtfertigt

• t-Verteilung von eher theoretischem Interesse, historisch bedingt

Diese Veranstaltung wird überwiegend Argumente basierend auf approximativen Verteilungen

verwenden.

C. Kleiber: Ökonometrie 1

Kap. 2-30

U Basel, HS 2009

2.6

Intervallschätzung

Ein 95%-Konfidenzintervall für µY überdeckt den wahren Wert des Parameters µY in 95%

der Fälle.

Ein Konfidenzintervall zum Niveau 1 − α kann konstruiert werden als Menge aller Werte von

µY , die von Hypothesentest zum Niveau α nicht abgelehnt werden.

Beispiel: Konfidenzintervall für µY , α = 0.05

{µY

Ȳ − µY Ȳ − µY

√ ≤ 1.96} = {µY : −1.96 ≤

√ ≤ 1.96}

: sY / n

sY / n

√

√

= {µY : −1.96 sY / n ≤ Ȳ − µY ≤ 1.96 sY / n}

√

√

= {µY ∈ (Ȳ − 1.96 sY / n, Ȳ + 1.96 sY / n)}

Auch hier wird wieder die Normalverteilungsapproximation benutzt.

C. Kleiber: Ökonometrie 1

Kap. 2-31

U Basel, HS 2009

2.6

Intervallschätzung

Zwischenfazit: Unter den (plausiblen) Annahmen

1. einfache Zufallsstichprobe, d.h. Y1, Y2, . . . , Yn u.i.v.

2. 0 < E(Y 4) < ∞

wurden Punktschätzung, Hypothesentests und Intervallschätzung entwickelt.

Ursprüngliche Frage:

wie ist der Zusammenhang zwischen Klassengrösse und Lernleistung der Schüler?

Erster Schritt unter Verwendung der Methoden aus Statistik 2:

Vergleich kleine und grosse Klassen.

Eigentliches Ziel:

wie verändert sich das Testergebnis bei Veränderung der Klassengrösse?

C. Kleiber: Ökonometrie 1

Kap. 2-32

U Basel, HS 2009