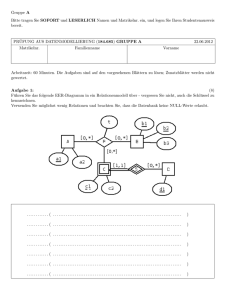

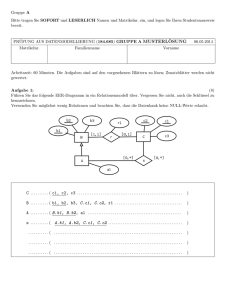

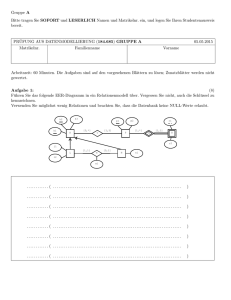

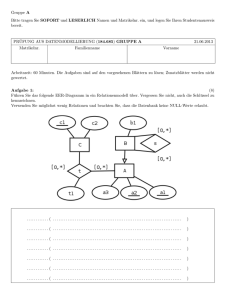

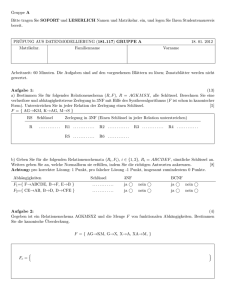

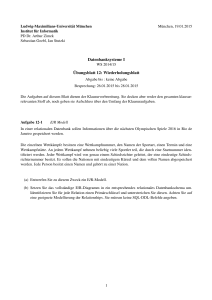

Datenbanksysteme I - Praktische Informatik

Werbung