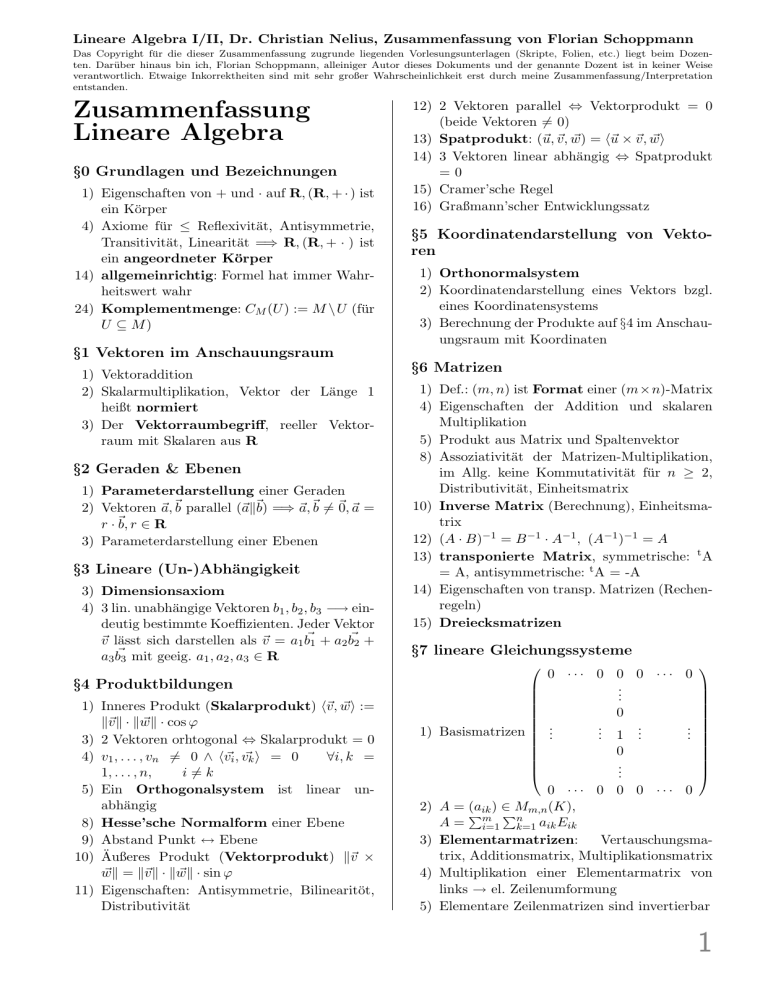

Zusammenfassung Lineare Algebra

Werbung

Lineare Algebra I/II, Dr. Christian Nelius, Zusammenfassung von Florian Schoppmann

Das Copyright für die dieser Zusammenfassung zugrunde liegenden Vorlesungsunterlagen (Skripte, Folien, etc.) liegt beim Dozenten. Darüber hinaus bin ich, Florian Schoppmann, alleiniger Autor dieses Dokuments und der genannte Dozent ist in keiner Weise

verantwortlich. Etwaige Inkorrektheiten sind mit sehr großer Wahrscheinlichkeit erst durch meine Zusammenfassung/Interpretation

entstanden.

Zusammenfassung

Lineare Algebra

§0 Grundlagen und Bezeichnungen

1) Eigenschaften von + und · auf R, (R, + · ) ist

ein Körper

4) Axiome für ≤ Reflexivität, Antisymmetrie,

Transitivität, Linearität =⇒ R, (R, + · ) ist

ein angeordneter Körper

14) allgemeinrichtig: Formel hat immer Wahrheitswert wahr

24) Komplementmenge: CM (U ) := M \U (für

U ⊆ M)

12) 2 Vektoren parallel ⇔ Vektorprodukt = 0

(beide Vektoren 6= 0)

13) Spatprodukt: (~u, ~v , w)

~ = h~u × ~v , wi

~

14) 3 Vektoren linear abhängig ⇔ Spatprodukt

=0

15) Cramer’sche Regel

16) Graßmann’scher Entwicklungssatz

§5 Koordinatendarstellung von Vektoren

1) Orthonormalsystem

2) Koordinatendarstellung eines Vektors bzgl.

eines Koordinatensystems

3) Berechnung der Produkte auf §4 im Anschauungsraum mit Koordinaten

§1 Vektoren im Anschauungsraum

1) Vektoraddition

2) Skalarmultiplikation, Vektor der Länge 1

heißt normiert

3) Der Vektorraumbegriff, reeller Vektorraum mit Skalaren aus R

§2 Geraden & Ebenen

1) Parameterdarstellung einer Geraden

2) Vektoren ~a, ~b parallel (~ak~b) =⇒ ~a, ~b 6= ~0, ~a =

r · ~b, r ∈ R

3) Parameterdarstellung einer Ebenen

§3 Lineare (Un-)Abhängigkeit

3) Dimensionsaxiom

4) 3 lin. unabhängige Vektoren b1 , b2 , b3 −→ eindeutig bestimmte Koeffizienten. Jeder Vektor

~v lässt sich darstellen als ~v = a1 b~1 + a2 b~2 +

a3 b~3 mit geeig. a1 , a2 , a3 ∈ R

§6 Matrizen

1) Def.: (m, n) ist Format einer (m×n)-Matrix

4) Eigenschaften der Addition und skalaren

Multiplikation

5) Produkt aus Matrix und Spaltenvektor

8) Assoziativität der Matrizen-Multiplikation,

im Allg. keine Kommutativität für n ≥ 2,

Distributivität, Einheitsmatrix

10) Inverse Matrix (Berechnung), Einheitsmatrix

12) (A · B)−1 = B −1 · A−1 , (A−1 )−1 = A

13) transponierte Matrix, symmetrische: t A

= A, antisymmetrische: t A = -A

14) Eigenschaften von transp. Matrizen (Rechenregeln)

15) Dreiecksmatrizen

§7 lineare Gleichungssysteme

0 ··· 0 0 0 ··· 0

..

.

§4 Produktbildungen

1) Inneres Produkt (Skalarprodukt) h~v , wi

~ :=

k~v k · kwk

~ · cos ϕ

3) 2 Vektoren orhtogonal ⇔ Skalarprodukt = 0

4) v1 , . . . , vn 6= 0 ∧ h~

vi , v~k i = 0

∀i, k =

1, . . . , n,

i 6= k

5) Ein Orthogonalsystem ist linear unabhängig

8) Hesse’sche Normalform einer Ebene

9) Abstand Punkt ↔ Ebene

10) Äußeres Produkt (Vektorprodukt) k~v ×

wk

~ = k~v k · kwk

~ · sin ϕ

11) Eigenschaften: Antisymmetrie, Bilinearitöt,

Distributivität

.

1) Basismatrizen

..

0

..

.

1

0

..

.

..

.

..

.

0 ··· 0 0 0 ··· 0

2) A = (aik ) ∈ Mm,n (K),

P

Pn

A= m

i=1

k=1 aik Eik

3) Elementarmatrizen:

Vertauschungsmatrix, Additionsmatrix, Multiplikationsmatrix

4) Multiplikation einer Elementarmatrix von

links → el. Zeilenumformung

5) Elementare Zeilenmatrizen sind invertierbar

1

Lineare Algebra I/II, Dr. Christian Nelius, Zusammenfassung von Florian Schoppmann

Das Copyright für die dieser Zusammenfassung zugrunde liegenden Vorlesungsunterlagen (Skripte, Folien, etc.) liegt beim Dozenten. Darüber hinaus bin ich, Florian Schoppmann, alleiniger Autor dieses Dokuments und der genannte Dozent ist in keiner Weise

verantwortlich. Etwaige Inkorrektheiten sind mit sehr großer Wahrscheinlichkeit erst durch meine Zusammenfassung/Interpretation

entstanden.

6) LGS Ax = b inhomogen, wenn b 6= 0, sonst

homogen, (erweiterte) Koeffizientenmatrix

7) Lös(A, b) = Lös(BA, Bb), b ∈ GLm (R)

Einschub: Rechtfertigung des Induktionsbeweises auf Grundlage der Peano-Axiome

10) Rang einer Matrix

11) A sei quadr. Matrix: A invertierbar ⇔

rg(A) = n ⇔ T(A) = En ⇔ A ist Produkt

von Elementarmatrizen

12) Berechnung der inversen Matrix (vgl. §6.10)

14) Lös(A, b) = v0 +Lös(A, 0m )

(Lösung des

inhomogenen LGS setzt sich zusammen aus

spezieller und allgemeiner“ Lösung des zu”

gehörigen homogenen LGS)

15) Abgeschlossenheit der Lösungsmenge → Vektorraum

§8 Gruppen, Ringe & Körper

1) Gruppen (Abgeschlossenheit, Assoziativität, neutr. El., inverse El., (wenn abelsch:

Kommutativität)

Halbgruppe: Menge mit assoziativer Verknüpfung (z.B. (N, +))

3) Modulo-Restklassen

4 Untergruppe

6) Ringe: R ist Ring ⇔ (R, +) ist abelsche

Gruppe, (R, ·) Halbgruppe mit neutr. El.,

Distributiv-Gesetz

7) Rechenregeln

9) Unterring: U ist Unterring ⇔ U Untergruppe

von (R, +), U abgeschlossen bzgl. · und 1R ∈

U

10) Schiefkörper: Ring, bei dem 1 6= 0 und jedes Element 6= 0 invert. Wenn Mult. kommuativ: Körper

11) Beispiele!

12) Unterkörper: Unterring, das Inverse jedes El.

6= 0 ist wieder im Unterkörper

§9 Vektorräume

1) formale Definition

2) Beispiele: Lösungsmengen hom. LGS’e, R

über sich selbst

3) Nullteilerfreiheit

4) Unterraum: Abgeschlossenheit bzgl. Addition & skalarer Multiplikation, Nullelement

enthalten

6) Schnitt, Addition zweier Unterräume wieder

Unterraum, Vereinigung i.A. nicht

7) ,→ Erweiterung auf bel. # von Unterräumen

2

8) Linearkombination, sei E = {v1 , . . . , vn },

P

LK (E) = ni=1 Kvi

9) Die Menge aller Linearkombinationen einer

bel. Teilmenge eines Vektorraumes ist ein

Unterraum

10) LC (1) = {z · 1|z ∈ C} = C

11) LK (E) ist der kleinste Unterraum von V , der

E umfasst

LK (E) ist der Durchschnitt aller Unterräume

von V , die E umfassen

12) Erzeugendensystem E: LK (E) = V . Falls

V ein ednl. EZW besitzt, ist V endlich erzeugbar.

13) Beispiel: R ist als Q-Vektorraum nicht endl.

erzeugbar

14) vi ∈ LK (v1 , . . . , vi−1 , vi+1 , . . . , vn ) ⇔

LK (v1 , . . . , vn ) =

LK (v1 , . . . , vi−1 , vi+1 , . . . , vn )

15) Neue Definition für linear abhängig: mind.

ein Vektor lässt sich als Linearkombination

der anderen darstellen

17) Beispiele: {1, i} ist lin. abh. über C, unabh.

über R

§10 Die Dimension eines Vektorraumes

1) lin. unabh. Basis ⇔ eindeutige Darstellung

jedes Vektors darüber

2) Basis =

b lin. unabh. EZS

5) T = {v1 , . . . , vn } ⊆ V lin. unabh. ⇒ (∀v ∈

V : T ∪ {v} lin. unabh. ⇔ v ∈

/ LK (T ))

6) Basis von V =

b min. EZS von V =

b max. lin.

unabh. Teilmenge von V

7-8) Endl. erzeugbare VR’e haben endl. Basen

10) Austauschlemma

11) Austauschsatz von Steinitz

13) Alle Basen haben gleich viele Elemente

14) Dimension eines VR’s, Zeichen für unendlichDimensionalität: dim(V ) = ∞

15) Auch unendl.-dim. VR’e besitzen (undendl.)

Basen → Zorn’sches Lemma

2. Semester

16) V sei K−VR mit dimK (V ) = n

Jede lin. unabh. Teilmenge hat ≤ n Elemente, jede lin. unabh. Menge T ⊆ V mit genau

n El. ist Basis, jedes EZS E hat mind. n Elemente, jedes EZS E mit genau n El. ist eine

Basis

Lineare Algebra I/II, Dr. Christian Nelius, Zusammenfassung von Florian Schoppmann

Das Copyright für die dieser Zusammenfassung zugrunde liegenden Vorlesungsunterlagen (Skripte, Folien, etc.) liegt beim Dozenten. Darüber hinaus bin ich, Florian Schoppmann, alleiniger Autor dieses Dokuments und der genannte Dozent ist in keiner Weise

verantwortlich. Etwaige Inkorrektheiten sind mit sehr großer Wahrscheinlichkeit erst durch meine Zusammenfassung/Interpretation

entstanden.

17) V endl. erzeugbar ⇒ Jede lin. unabh. Teilmenge T eines VR V lässt sich durch Hinzunahme geeigneter Vekotren zu einer Basis

ergänzen.

18) Folgerung: U ⊆ V Unterraum, V endl. erzeugbarer VR ⇒ dim(U ) ≤ dim(V ), jede

Basis von U lässt sich zu einer Basis von V

ergänzen

19) Sei V endl.-dim. VR ⇒ ∀ U ⊆ V Unterraum:

∃ U 0 ⊆ V Unterraum: U + U 0 = 0 ∧

U ∩ U0 = 0

20) Direkte Summe zweier Unterräume, direkter Summand, direktes Komplement

21) V sei K-VR, U1 , U2 ⊆ V Unterräume ⇒

(V = U1 ⊕ U2 ⇔ Jeder Vektor v ∈ V

lässt sich darstellen als v = u1 + u2 mit

ui ∈ Ui (i = 1, 2))

22) Direkte Summe mehrerer Vektorräume

23) V sei endl.-dim. K-VR, U1 und U2 Unterräume ⇒ dimK (U1 + U2 ) = dimK (U1 ) +

dimK (U2 ) − dimK (U1 ∩ U2 )

Einschub: Abbildungen und Mengen

1) M und N seien Mengen: Eine Abbildung

ordnet jedem Element aus M genau ein Element aus N zu.

2) Weitere Definitionen: Definitionsbereich,

Wertemenge, Zuordnungsvorschrift, Graph

einer Abbildung (eine Relation zwischen M

und N ), linkstotal, rechtseindeutig

Eine partielle Abbildung ist nur rechtseindeutig

3) Gleichheit zweier Abbildungen ist definiert

durch Gleichheit von Wertemenge, Bildbereich und Bildwert jeder einzelnen Stelle der

Wertemenge

4) f |U : U −→ N, (f |U )(x) = f (x) ∀x ∈ U

5) Bildmenge einer Teilmenge des Wertebereichs, Bildmenge des Wertebereichs =: Bild

der Abbildung f , Urbildmenge einer Teilmenge der Wertemenge

6) g ◦ f heißt die Hintereinanderausführung von

f und g

7) ,→ es gilt das Assoziativgesetz

8) injektiv, surjektiv, bijektiv

11) f und g beide injektiv (surjektiv bzw. bijektiv) ⇒ g ◦ f injektiv (surjektiv bzw. bijektiv)

g ◦ f injektiv (surjektiv) ⇒ f injektiv (g surjektiv)

g ◦ f bijektiv ⇒ f injektiv und g surjektiv

12) f bijektiv ⇔ ∃! g : N −→ M mit g ◦ f = idM

und f ◦ g = idN

13) ,→ g = f −1 Umkehrabbildung (inverse

Abbildung)

15) M und N seien nichtleere Mengen: M

gleichmächtig zu N (M ∼ N ), wenn es eine bijektive Abb. M −→ N gibt, endliche

Mengen, die leere Menge ist endlich |∅| = 0,

unendliche Mengen (|M | = ∞)

16) N ist eine unendliche Menge, jedoch abzählbar unendlich (|N| = |N0 | = |Z| = |Q| =

ℵ0 ), R ist überabzählbar (|R| = ℵ1 )

19) M und N seien nichtleere endliche Mengen

mit |M | = |N |. Für f : M −→ N gilt: f

bijektiv ⇔ f injektiv ⇔ f surjektiv

20) ,→ für unedliche Mengen gilt dies i.A. nicht

21) Jede nichtleere endliche Menge natürlicher

Zahlen besitzt ein kleinstes und ein größtes

Element

20) Wohlordnung der geordneten Menge

(N, ≤): Jede nichtleere Teilmenge von N

besitzt ein kleinstes Element

§11 Lineare Abbildungen

1) V und W seien K-VR’e. Eine Abb. f : V −→

W heißt K-linear, wenn gilt: L1 ) f (v + v 0 ) =

f (v) + f (v 0 ) ∀ v, v 0 ∈ V und L2 ) f (av) =

a · f (v) ∀ a ∈ K, v ∈ V

HomK (V, W ) =

b Menge aller K-lin. Abb. von

V in W

3) Eigenschaften (Rechenregeln)

4) V und W seien K-VR’e

⇒HomK (V, W ) ⊆Abb(V, W ) K-Unterraum

5) f und g K-lin. ⇒ g ◦ f K-linear (sofern Definitionsbereich von g und Wertemenge von f

gleich)

6) f : V −→ W, f K-linear im Folgenden

⇒ Kern(f ) := {v|v ∈ V, f (v) = 0W } ⊆ W

7) U ⊆ V Unterraum ⇒ f (U ) ⊆ W Unterraum

X ⊆ W Unterraum ⇒ f −1 (X) ⊆ V Unterraum

8) Bild(f ) = f (V ) ist Unterraum von W ,

Kern(f ) = f −1 ({0W }) ist Unterraum von

V

9) f injektiv ⇔ Kern(f ) = 0

f surjektiv ⇔ Bild(f ) = W

10) Eine bijektive K-lin. Abb. f : V −→ W ist

K-Isomorphismus von V auf W

V heißt K-isomorph zu W (V ∼

= W ), wenn

∃ K-Isomorphismus von V nach W

3

Lineare Algebra I/II, Dr. Christian Nelius, Zusammenfassung von Florian Schoppmann

Das Copyright für die dieser Zusammenfassung zugrunde liegenden Vorlesungsunterlagen (Skripte, Folien, etc.) liegt beim Dozenten. Darüber hinaus bin ich, Florian Schoppmann, alleiniger Autor dieses Dokuments und der genannte Dozent ist in keiner Weise

verantwortlich. Etwaige Inkorrektheiten sind mit sehr großer Wahrscheinlichkeit erst durch meine Zusammenfassung/Interpretation

entstanden.

11) idV : V −→ V ist K-Isomorphismus

f : V −→ W K-Isomporphismus

⇒ f −1 : W −→ V K-Isomorphismus,

f : V −→ W und

g : W −→ XK-Isomorphismen

⇒ g ◦ f : V −→ XK-Isomorphismus

12) (vgl. §16.16) V ∼

= V, V ∼

= W ⇒ W ∼

= V,

∼

∼

∼

V =W ∧W =X ⇒V =X

13) Für eine K-lin. Abbildung gilt:

Die Bildmenge einer lin. unabh. Menge ist

wieder lin. unabh.

Ein EZS wird auf ein EZS des Bildes der Abb.

abgebildet

Ein EZS wird auf ein EZS der Wertemenge

abgebildet, wenn die Abb. surjektiv ist.

Ist das Bild der Abb. ein EZS der Wertemenge, so ist die Abb. surjektiv.

14) f, g : V −→ W K−lin. Abbildungen. Ist

die Bildmenge eines beliebigen EZS’s unter

f und g gleich, so folgt f = g (f |E = g|E ⇒

f = g, E bel. EZS von V ).

15) Lineare Fortsetzung Um eine lin. Abb. zu

definieren, braucht man die Zuordnungsvorschrift nur für die Elemente einer (endl.) Basis von V anzugeben. Die Abb. ist dann auf

ganz V definiert.

16) V , W endl.-dim. VR’e: V ∼

= W ⇔

dimK (V ) = dimK (W )

18) rgK (f ) := dim(Bild(f ))

21) f : V −→ W , g : W −→ X, h : X −→ Y Klineare Abbildungen. Es gilt: f surjektiv ⇒

rgK (g ◦ f ) = rgK (g), h injektiv ⇒ rgK (h ◦

g) = rgK (g), f surjektiv und h injektiv ⇒

rgK (h ◦ g ◦ f ) = rgK (g)

22) V endl.-dim. ⇒ ∃U ⊆ V Unterraum mit V =

Kern(f ) ⊕ U und U ∼

= Bild(f )

23) V endl.-dim. ⇒ rgK (f ) < ∞ und dimK (V ) =

dimK (Kern(f ))+rgK (f )

24) dimK (V ) = dimK (W ) und V und W endl.dim. ⇒ (f injektiv ⇔ f surjektiv ⇔ f bijektiv)

§12 Darstellungsmatrix einer K-lin. Abbildung K n −→ K m

1) Es gelte im Folgenden: f : K n −→ K m ,

Darstellungsmatrix von f bezeichnet mit

M(f )

3) Zu jeder Matrix A ∈Mm,n (K) gibt es eine

entspr. K-lin. Abb.

4

5) ϕ(f ) : HomK (K n , K m ) −→ Mm,n (K),

ϕ(f ) :=M(f ) ∀f ∈HomK (K n , K m ) ist ein

K-Isomorphismus

6) M(g ◦ f ) =M(g)·M(f ) (sofern hintereinander

ausführbar)

7) ,→ Beweis der Assoziativität der Matrizenmultiplikation möglich (vgl. §6.8)

8) f injektiv ⇒ Spalten von M(f ) lin. anabh.

f surjektiv ⇒ Spalten von M(f ) bilden ein

EZS von K m

f bijektiv ⇒ Spalten von M(f ) bilden eine

Basis von K m

9 f ist K-Isomprohismus ⇔ M(f ) invertierbar.

Es gilt dann M(f )−1 =M(f −1 )

10) A invert. ⇔ Spaltenvektoren von A bilden

eine Basis von K n ⇔ Spaltenvektoren von A

sind lin. unabh.

11) A invert. ⇔ ∃ C ∈Mn (K) : C · A = En ⇔

∃ D ∈ Mn (K) : A · D = En

Spaltenraum, Zeilenraum

12) Spaltenrang, Zeilenrang

14-19) Spaltenrang = Zeilenrang = Rang der Abbildung = Rang der Darstellungsmatrix

21) rg(A) = rg(B) ⇔ ∃ P ∈ GLm (K) und Q ∈

GLn (K) mit B = P · A · Q

§13 Lineare Gleichungssysteme (II)

2) Sei A ∈ Mm,n (K):

dimK (Lös(A, 0m )) =

|

{z

Anz. der frei

wählbaren Parameter

}

n

|{z}

− rg(A)

Anz. der

Unbekannten

3) Lösungsraum eines homogenen LGS

6) Entzerrungsalgorithmus

§14 Determinantenformen

1) V ist K-VR, n ∈ N und f : V n −→ K eine

Abb.

Eigenschaften: n-linear, alternierend,

schiefsymmetrisch

2) Die Menge der n-lin. (bzw. alternierenden

bzw. schiefsymm.) Abb. von V n nach K ist

ein Unterraum des K-VR’s Abb(V n , K).

3) Für eine alternierende n-lin. Abb. f : V n −→

K gilt: Die Addition eines Vielfachen eines Funktionsarguments zu einem anderen

ändert nichts am Funktionswert; f ist schiefsymmetrisch; sind die Funktionsargumente

lin. abh., so ist der Funktionswert von f =

0; dimK < n ⇒ f = 0

4) Sn ist die Menge aller Permutationen der

Zahlen 1, 2, . . . , n

Lineare Algebra I/II, Dr. Christian Nelius, Zusammenfassung von Florian Schoppmann

Das Copyright für die dieser Zusammenfassung zugrunde liegenden Vorlesungsunterlagen (Skripte, Folien, etc.) liegt beim Dozenten. Darüber hinaus bin ich, Florian Schoppmann, alleiniger Autor dieses Dokuments und der genannte Dozent ist in keiner Weise

verantwortlich. Etwaige Inkorrektheiten sind mit sehr großer Wahrscheinlichkeit erst durch meine Zusammenfassung/Interpretation

entstanden.

5) Sei n ∈ N: (Sn , ◦) ist symmetrische Gruppe von n Elementen; (Sn , ◦) abelsch ⇔ n ≤

2; |Sn | = n!

8) V ist K-VR der Dim. n. Eine Abbildung d :

V n −→ K heißt Determinantenform auf

V , wenn gilt: d ist n-linear und alternierend,

d 6= 0 (Nullabbildung)

9) d(v1 , . . . , vn ) 6= 0 ⇔ {v1 , . . . , vn } lin. unabh.

⇔ {v1 , . . . , vn } ist eine Basis von V

10-13) Eindeutigkeit von Determinantenformen:

∃! (d : V n −→ K) : d(v1 , . . . , vn ) = 1K

§15 Die Determinante einer Matrix

1) Sei A = (aik ) ∈Mn (K).

det(A)

:=

(

a11

(n = 1)

Pn

1+k

0

a1k · det(A1k ) (n > 1)

k=1 (−1)

2) det(A) ist eine Determinantenform auf K n

4) A ∈ Mn (K) ⇒ (A invertierbar ⇔ det(A) 6=

0K )

5) Laplace’scher Entwicklungssatz (Entwicklung nach der i-ten Zeile)

P

det(A) := nk=1 (−1)i+k aik · det(A0ik )

6) A, B ∈ Mn (K) ⇒ det(A·B) = det(A)·det(B)

7) A ∈ GLn (K) ⇒ det(A−1 ) = det(A)−1

9) A ∈ Mn (K) ⇒ det(t A) = det(A)

11) Laplace’scher Entwicklungssatz (Entwicklung nach der i-ten Spalte)

P

det(A) := ni=1 (−1)i+k aik · det(A0ik )

12) Leibniz’sche Determinantenformel

P

det(A) := π∈Sn sign(π) · aπ(1),1 · . . . · aπ(n),n ,

mit sign(π) := (−1)ν(π)

13) A = (aik ) ∈ Mn (K) (n ≥ 2). Die Matrix Aad := (αik ) ∈ Mn (K) mit αik :=

(−1)i+k det(A0ki ) heißt die zu A adjungierte

Matrix.

14) A · Aad = Aad · A = det(A) · En

16) Cramer’sche Regel: Sei A ∈ GLn (K)

mit den Spalten s1 , . . . , sn und b ∈ K n .

Dann ist die eindeutig bestimmte Lösung

t (a , . . . , a )

∈ K n des LGS’s Ax =

1

n

b gegeben durch: ai =

(det(A))−1 ·

det(s1 , . . . , si−1 , b, si+1 , . . . , sn ) (i = 1, . . . , n)

17) Eine Matrix A ∈ Mm,n (K) hat genau denn

den Rang r ≥ 1, wenn die beiden folgenden Bedingungen erfüllt sind: A besitzt eine

r-reihige Unterdeterminante 6= 0K und jede

(r + 1)-reihige Unterdeterminante von A ist

gleich 0K

18-20) Vandermonde’sche Determinante

21-22) Blockmatrizen:

A1

A2

det

..

.

0

∗

At

Qt

=

j=1 det(Aj )

Einschub: Das Vorzeichen einer Permutation

1-4)

5)

6-7)

8)

Inversion, Vorzeichen sign(π)

π, ρ ∈ Sn : sign(π ◦ ρ) = sign(π)· sign(ρ)

Transposition

An bezeichnet die Menge aller geraden Permutationen (d.h. ν(π) ist gerade)

9-10) An ist Untergruppe von Sn , (An , ◦) heißt alternierende Gruppe von n Elementen

§16 Das Normalformenproblem

a1

..

κB (v) = . ∈ K n heißt der Koordinaan

tenvektor von v bzgl. der Basis B

Darstellungsmatrix bzgl. zweier Basen

B = {v1 . . . vn } geordnete Basis

MB

C (f ) = (κC (f (v1 )) . . . κC (f (vn )))

Rang der Darstellungsmatrix = Rang der

Abbildung

Die Abb. φB

C : HomK (V, W ), die jeder Abb.

ihre Darstellungsmatrix bzgl. B und C zuordnet, ist ein K-Isomorphismus.

dimK (HomK (V, W )) = dimK (V ) · dimK (W )

C

B

MB

D (g ◦ f ) = MD (g)· MC (f )

B

−1

MC (f ) ∈ GLn (K) mit MB

=

C (f )

C

−1

MB (f ) ⇔ f K-Isomporphismus

MB

B 0 (idV ) ist die Matrix zum Basiswechsel

−1 = MB 0 (id )

von B nach B 0 . MB

V

B

B0 0 (idV )

B

−1

f : V −→ W , MB

C 0 (f ) = P · MC (f ) · Q .

Es gibt solche P ∈ GLn (K), Q ∈ GLn (K),

wobei |B| = |B 0 | = n ∧ |C| = |C 0 | = m

0

f : V −→ V K-Endomorphismus. MB

B 0 (f ) =

−1 . Es gibt solch ein P ∈

P · MB

B (f ) · P

GLn (K).

Es gibt Basen bzgl. derer die Darstellungsmatrix einer !

K-lin. Abb. vom Rang r die Form

Er 0

hat.

0 0

Äquivalenz: M ∼ N ⇔ M und N sind beide Darst.-matr. einer (derselben) Abb. bezgl.

unterschiedlicher Basen

Äquivalenzrelation: Reflexivität, Symmetrie, Transitivität

1)

2)

3)

4)

5)

6)

7)

8)

9)

10)

11)

12)

13)

16)

5

Lineare Algebra I/II, Dr. Christian Nelius, Zusammenfassung von Florian Schoppmann

Das Copyright für die dieser Zusammenfassung zugrunde liegenden Vorlesungsunterlagen (Skripte, Folien, etc.) liegt beim Dozenten. Darüber hinaus bin ich, Florian Schoppmann, alleiniger Autor dieses Dokuments und der genannte Dozent ist in keiner Weise

verantwortlich. Etwaige Inkorrektheiten sind mit sehr großer Wahrscheinlichkeit erst durch meine Zusammenfassung/Interpretation

entstanden.

17) Ordnungsrelation: Reflexivität, Antisymmetrie, Transitivität

19) Äquivalenzklasse

22) M/R := {[x]R |x ∈ M } heißt Quotientenmenge von M nach R; S ⊆ M vollst. Vertretersystem von M/R, wenn S aus jeder

Äquivalenzklasse von M/R genau ein Element enthält.

24) M ≈ N ⇔ ∃ P ∈ GLn (K) : M = P · N · P −1

25) M ≈ N ⇔ M ∼ N

§17 Eigenwerte und Eigenvektoren

6) Eigenraum zum Eigenwert λ: Eig(f, λ) :=

Kern(f − λ·idV )

8-9) Eine Menge von Eigenvektoren zu paarweise verschiedenen Eigenwerten ist lin. unabh.

11) Entsprechung Eigenvektor einer Mn (K)Matrix ↔ eines K-Endomorphismus

12) λ Eigenwert von M ⇔ det(M − λ · En ) = 0

dimK (Eig(M, λ)) = n−rg(M − λ · En )

13) Sei Mn ∈ Mn (K). Dann ist det(M −λ·En ) =

Pn

i

i=0 ai λ , also ein Polynom n-ten Grades.

14) ,→ Charakteristisches Polynom einer

Matrix

15) Ähnliche Matrizen haben das gleiche char.

Polynom und daher auch dieselben Eigenwerte

16) Entsprechung charakteristisches Polynom einer Matrix ↔ eines Endomorphismus

17-18) Abspalten“ von Nullstellen

”

19) µ(p, α) ≤ grad(p) bezeichnet die Vielfachheit

der Nullstelle α im Polynom p.

21) Fundamentalsatz der Algebra: Ein beliebiges Polynom p über C vom Grad ≥ 0

hat mindestens eine Nullstelle in C. D.h. p

zerfällt in Linearfaktoren.

§18 Diagonalisierbare Endomorphismen

und Matrizen

1) diagonalisierbar: Matrix: ähnlich zu Diagonalmatrix, Endomorphismus: Darstellungsmatrix zu einer geeigneten Basis ist Diagonalmatrix

4) f sei K-End. in V . Es gilt: f diagonalisierbar ⇔ Es ex. eine Eigenbasis von V ⇔

Sind v1 , . . . , vs ∈ K alle (paarw. verschiedenene) Eigenwerte von f , so gilt: V =

Ls

i=1 Eig(f, λ − i)

6

5) dimK (V ) = n. Es gilt für einen Eigenwert λ:

1 ≤ dimK (Eig(f, λ)) ≤ µ(pf , λ) ≤ n

|

{z

}

geometrische Vielfachheit

| {z }

algebraische

Vielfachheit

6) f diagonalisierbar ⇔ Das char. Polynom

pf zerfällt in K[T ] in Linearfaktoren, und

für jeden Eigenwert gilt: dimK (Eig(f, λ)) =

µ(pf , λ)

§19 Trigonalisierbare Endomorphismen

und Matrizen

1) trigonalisierbar: Matrix: ähnlich zu oberer Dreiecksmatrix, Endomorphismus: Darstellungsmatrix zu einer geeigneten Basis ist

obere Dreickecksmatrix

3) M ∈ Mn (K), es gilt: M trigonalisierbar ⇔

das char. Polynom pM von M zerfällt in K[T ]

in Linearfaktoren

4) Jeder C-Endomorphismus über einem endl.dim. C-VR ist trigonalisierbar.

6) Ein Unterraum U eines Vektorraums heißt

f -invariant, falls im End. f gilt: f (U ) ⊆ U

7) V unzerlegbar bzgl. f ⇔ V 6= 0 und V

ist nicht direkte Summe zweier f -invarianter

Unterräume 6= 0 von V .

8) f besitze einen Eigenwert λ ∈ K. V unzerlegbar bzgl. f

⇒ Es ex. eine Basis

B von V mit

λ 1 ··· 0

. .

..

. . . . . ...

B

MB (f ) = .

= Jn (λ) ∈

..

.

.

1

.

0 ··· ··· λ

Mn (K)

Jn (λ) heißt Jordan-Matrix zum Eigenwert

λ von f .

9) Jordan’sche Normalform, B geeignete

Basis

Jn1 (λ1 )

0

Jn2 (λ2 )

B

MB (f ) =

..

.

0

Jns (λs )

∈Mn (K)

Diese Matrix heißt Jordan’sche Normalform

(JNF) von f .

13) Satz von Cayley-Hamilton (für Matrizen): Einsetzen einer Matrix als Unbekannte (für T ) in ihr char. Polynom ergibt 0 (die

Nullmatrix).

14) Zu einer Matrix M ∈ Mn (K) ex. ein eindeutig bestimmtes normiertes Polynom kleinsten

Lineare Algebra I/II, Dr. Christian Nelius, Zusammenfassung von Florian Schoppmann

Das Copyright für die dieser Zusammenfassung zugrunde liegenden Vorlesungsunterlagen (Skripte, Folien, etc.) liegt beim Dozenten. Darüber hinaus bin ich, Florian Schoppmann, alleiniger Autor dieses Dokuments und der genannte Dozent ist in keiner Weise

verantwortlich. Etwaige Inkorrektheiten sind mit sehr großer Wahrscheinlichkeit erst durch meine Zusammenfassung/Interpretation

entstanden.

Grades qM mit qM (M ) = 0. Dieses Polynom

heißt Minimalpolynom von M .

§20 Euklidische Vektorräume

1) V sei bel. VR über R. Eine Abb. s : V ×

V −→ R heißt Skalarprodukt auf V , wenn

gilt: s bilinear, s symmetrisch, s positiv definit (d.h. s(v, v) > 0 ∀v ∈ V

{0V }).

(V, s) heißt dann

p euklidischer R-VR.

3) Norm: kvk := hv, vi

Eigenschaften: ∀v ∈ V : kvk ≥ 0 ∧ kvk =

0 ⇔ v = 0V , ∀a ∈ R ∀v ∈ V : kavk =

|a| · kvk, ∀v, w ∈ V : kv + wk ≤ kvk + kwk

(Dreiecksungleichung)

4) Cauchy-Schwarz’sche Ungleichung

|hv, wi| ≤ kvk · kwk ∀v, w ∈ V

Es lässt sich ein Winkel zwischen v und w

hv,wi

definieren: cos(φ) = kvk·kwk

5) Definition Orthonormalsystem wie in §5.1

8) Zu einem n-dim. euklidischen VR (V, h, iV )

gibt es einen R-Isomoprphismus f : V −→

Rn mit der Eigenschaft:

hf (v), f (w)i = hv, wiV ∀v, w ∈ V

9) Ein R-Endomorphismus f auf V heißt

orthogornal, wenn hf (v), f (w)i =i =

hv, wi ∀v, w ∈ V ;

Eine Matrix M ∈ Mn (R) heißt orthogornal,

wenn t M · M = En gilt.

10) Eine Abbildung ist genau dann orthogonal,

wenn sie längentreu ist;

Eine Matrix ist genau dann orthogonal, wenn

ihre Spalten bzw. Zeilen ein Orthonormalsystem in Rn bilden.

11) B sei beliebige Orthonormalbasis: f orthogonal ⇔ MB

B (f ) ist orthogonale Matrix

13) Ein orthonogonaler Endomorphismus setzt

sich ausschließlich aus Spiegelungen, Drehungen oder Beibehaltung von Basisvektoren zusammen.

14) Ein Endomorphismus f auf V heißt

symmetrisch, wenn gilt: hf (v), wi =

hv, f (w)i ∀v, w ∈ V

15) Ist (V, h, i) ein n-dim. euklidischer VR, so

ist f ∈ EndR (V ) genau dann symmetrisch,

wenn MB

B (f ) bzgl. einer bel. Orthonormalbasis B von V eine symmetrische Matrix ist.

16) Spektralsatz: V sei n-dim. eukl. VR, f symmetrisch: Dann ex. eine Orthonormalbasis B

von V mit MB

B (f ) = diag(λ1 , . . . , λn ) (λi ∈

R ∀i = 1, . . . , n)

17) Eine symm. Matrix M ∈ Mn (R) besitzt n

reele Eigenwerte und ist diagonalisierbar.

§21 Unitäre Vektorräume

1) V sei ein C-VR. Eine Abb. h : V × V −→

C heißt Hermite’sche Form auf V , wenn

gilt: H ist C-linear im ersten Argument und

h(v, w) = h(w, v) ∀v, w ∈ V .

Eine Hermite’sche Form h auf V heißt positiv definit, wenn gilt: h(v, v) > 0∀v ∈ V, v 6=

0V .

Ein Skalarprodukt s auf V ist eine positiv definite Hermite’sche Form auf V . (V, s) heißt

dann ein unitärer C-VR.

Beispiel: Das kanonische Skalarprodukt

7