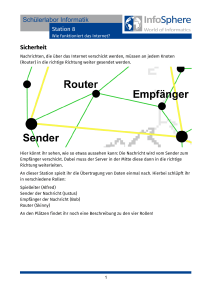

Kapitel 1 Transmission Principles

Werbung