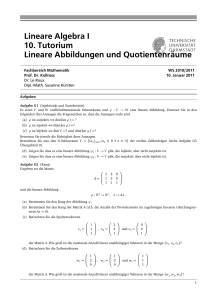

Vorlesung Abbildungen und Matrizen

Werbung

Vorlesung Abbildungen und Matrizen

Ferienkurs Lineare Algebra 1

Wintersemester 2009/10

09.03.2010

In diesem Abschnitt befassen wir uns mit linearen Abbildungen zwischen Vektorräumen und deren Darstellung als Matrizen. Dabei sollen alle betrachteten Vektorräume von endlicher Dimension sein. Zwar

gelten einige der eingeführten Begriffe unverändert im Unendlichdimensionalen, aber in diesem Falle

treten Probleme auf denen wir hier lieber aus dem Weg gehen wollen. Außerdem gelten, soweit nicht

anders explizit angeben, alle Sätze und Definitionen sowohl für einen rellen, als auch einen komplexen

Skalarkörper. Alle Sätze und Definitionen werden für Vektorräume formluiert, da dies der angemessene

Rahmen für lineare Algebra ist, allerdings wird immer noch angeben, wie die entsprechende Formulierung

für Gruppen aussehen müsste.

1 Abbildungen

Zunächst legen wir einige allgemeine Begriffe fest, und beginnen mir der Definition von Abbildungen.

Definition 1.1: Abbildungen: Seien X,Y zwei beliebige Mengen, dann dann ordnet eine Abbildung

f : X → Y jedem Element von X genau ein Element von Y zu. Die Menge aller Abbildungen von X nach

Y bezeichnen wir mit Abb(X, Y ), speziell wenn X = Y schreibt man auch nur Abb(X).

Man sagt auch, dass eine Abbildung f jedem x ∈ X eindeutig ein y ∈ Y zuordnet; man schreibt dann

f (x) = y. Dies lässt sich auch als

x = y ⇒ f (x) = f (y)

(1)

symbolisch formulieren.

Die lineare Abbildung ist der zentrale Typ von Abbildung mit dem sich die lineare Algebra beschäftigt,

da diese die Struktur der Vektorräume respektiert.

Definition 1.2: Linearität einer Abbildung: Seien X und Y Vektorräume über dem Körper R. Eine

Abbildung f : X → Y nennt man linear, falls ∀λ ∈ R und ∀x1 , x2 ∈ X gilt:

1. f (x1 + x2 ) = f (x1 ) + f (x2 )

2. f (λx1 ) = λ · f (x1 )

Hinweise 1.3:

1. Eine alternative Bedingung, welche die Beiden aus Definition 1.2 vereinigt ist (für ∀λ, µ ∈ R und

∀x1 , x2 ∈ X )

f (λx1 + µx2 ) = λ · f (x1 ) + µ · f (x2 )

2. Eine lineare Abbildung über Vektorräumen nennt man auch einen Vektorraumhomomorphismus,

oder kurz Homomorphismus, wenn die zugrunde liegende Struktur aus dem Kontext klar wird.

1

3. Bei der Schreibweise in Definition 1.2 muss man gegebenenfalls etwas vorsichtig sein. Die Verknüpfungen sind jeweils im richtigen Vektorraum zu bilden, d.h. für x1 + x2 die Addition in X, aber

für f (x1 ) + f (x2 ) die Addition wie sie in Y definiert ist.

4. Wenn man nun zwei Gruppen (G, ◦) und (H, ·) gegeben hat, dann nennt man Φ : (G, ◦) → (H, ·)

einen Gruppenhomomorphismus, wenn

Φ(g1 ◦ g2 ) = Φ(g1 ) · Φ(g2 )

gilt.

5. Der Raum L(X, Y ) der linearen Abbildung zwischen den Vektorräumen X und Y ist ein Untervektorraum von Abb(X, Y ), falls man die Addition und sklare Multiplikation punktweise definiert,

d.h.

(f + g)(x) := f (x) + g(x)

(λf )(x) := λf (x)

Beispiele 1.4:

1. Sei X = R3 , Y = K und für x ∈ X sei f (x) = x1 − 2x3 . xi ( i = 1, 2, 3 ) bezeichnen hier die

Komponenten von x, bezüglich der Standardbasis in X. Dann ist f linear, was man durch folgende

Rechnung erkennt:

f (x + y) = (x1 + y1 ) − 2(x3 + y3 )

= (x1 − 2x3 ) + (y1 − 2y3 )

= f (x) + f (y)

f (λx) = (λx1 ) − 2(λx3 )

= λ(x1 − 2x3 )

Also Beweis durch Einsetzen der Definition.

√

2. Sei X, Y = K+ und f (x) := x, dann ist f ersichtlicherweise nicht linear. Man zeigt dies schnell

durch ein Gegenbeispiel

√

√

4 = 2 6= 2 · 2

Satz 1.5 (Elementare Eigenschaften linearer Abbildungen): Sei f : X → Y eine Abbildung

zwischen Vektorräumen, dann gelten:

1. f (0) = 0

2. Ist die Familie von Vektoren (xi )i∈I mit xi ∈ X linear-abhängig, so ist auch (f (xi ))i∈I linearabhängig in Y.

3. Ist X 0 ⊂ X ein Untervektorraum, so ist auch f (X 0 ) ⊂ Y ein Untervektorraum.

4. Ist Y 0 ⊂ Y ein Untervektorraum, so ist auch f −1 (Y 0 ) ⊂ X ein Untervektorraum.

Beweis: Übung!

Mit f (0) = 0 hat man ein einfaches Ausschlusskritrium, ob eine Abbildung linear ist oder nicht. Eine

Abbildung mit f (0) 6= 0 kann niemals linear sein.

Für Gruppen (G, ◦) und (H, ·) gilt entsprechend Φ(eG ) = eH , wenn Φ : (G, ◦) → (H, ·) einen Gruppenhomomorphismus und ei für i = G, H die neutralen Elemente der Gruppen bezeichnen.

Beispiel 1.6: Sei g(x) := ax + b, dann ist g für b 6= 0 nicht linear, da g(0) = b gilt.

Die Folgerungen (3) und (4) in Satz 1.5 drücken eben die Tatsache, dass eine lineare Abbildung die

Vektorraumstruktur nicht zerstört. Das Bild und Urbild von Vektorräumen einer linearen Abbildung

sind wieder Vektorräume.

Definition 1.7: Bild, Urbild und Kern einer Abbildung: Sei f eine lineare Abbildung f : X → Y

zwischen zwei Mengen X,Y und U ⊂ X, V ⊂ Y , dann nennt man:

2

1. f (U ) = {f (x) ∈ Y ; x ∈ U } ⊂ Y das Bild von U unter f.

2. f −1 (V ) = {x ∈ X; ∃y ∈ V : f (x) = y} ⊂ X das Urbild von U unter f.

3. Der Kern von f ist das Urbild der Menge {0} [ ker(f ) := f −1 ({0}) ]

Hinweise 1.8:

1. Falls U = X (X ist hier der Definitionsbereich), dann nennt man f(X) einfach das Bild von f und

schreibt Bild(f ) := f (X).

2. Es gilt immer ker(f ) 6= ∅ für eine lineare Abbildung f , da f (0) = 0 ⇒ 0 ∈ ker(f ) gilt. Hierbei

beachte man, dass wir eine lineare Abbildung immer nur zwischen Vektorräumen definert haben,

also stets 0 ∈ X gilt.

3. Für den Fall von Gruppen ändern sich die Definitionen für Bild und Urbild im Wesentlichen nicht.

Nur für die Definition des Kernes ist zu beachten, dass dieser als das Urbild, des neutralen Elementes

definiert ist.

4. Aus Satz 1.5 folgt insbesondere, dass auch Bild(f ) und ker(f ) Untervektorräume sind. Ein entsprechender Satz gilt für Gruppen, nur dass man Untervektorraum durch Untergruppe ersetzten

muss.

Beispiele 1.9:

1. Sei h : R → R, x 7→ sin(x), dann gilt:

• U = [0, 2π] ⇒ f (U ) = [−1, 1]

• U = [0, 2π) ⇒ f (U ) = [−1, 1]

• U = [0, 12.56] ⇒ f (U ) = [−1, 1]

• U =]0, π[⇒ f (U ) =]0, 1]

2. Sei f : R → R, x 7→ x2 und V = [4, 9], dann ist f −1 (V ) = [2, 3]

3. Sei g : R → R+ , x 7→ ex , dann ist ker f = ∅.

Definition 1.10: Injektiv, Surjektiv: Eine Abbildung f : X → Y zwischen zwei Mengen heißt

1. surjektiv, falls Bild(f ) ≡ Y gilt.

2. injektiv, falls f (x1 ) = f (x2 ) ⇒ x1 = x2 für x1 , x2 ∈ X gilt.

Hinweise 1.11:

1. Um zu zeigen, dass eine Menge surjektiv sei, ist ein probates Mittel damit zu beginnen, ein Element

y ∈ Y zu betrachten und dann zu zeigen, dass es für dieses ein x ∈ X mit f (x) = y gibt. Da y

beliebig war, gilt dies für jedes y ∈ Y . Das Gegenteil zu beweisen ist i.A. noch einfacher: Man finde

nur ein y ∈ Y , welches nicht im Bild von der Abbildung liegt.

2. Man beachte, dass man die Definition für die Injektivität einer Funktion nicht mit der Definition

einer Abbildung zu verwechseln darf. Für eine Abbildung gilt

x1 = x2 ⇒ f (x1 ) = f (x2 )

Dieses ist allerdings für alle Zuordnungen, die wir betrachten, erfüllt.

3. Eine äquivalente Bedingung für die Injektivität ist

x1 6= x2 ⇒ f (x1 ) 6= f (x2 )

welche man durch negieren der obigen Definition erhält.

Satz 1.12 Eine lineare Abbildung f ist genau dann injektiv, wenn ker(f ) = 0.

Beweis: Angenommen f sei injektiv und ker(f ) 6= 0, dann gibt es ein x ∈ ker(f ) mit x 6= 0. Daher

gilt x 6= 0 ⇒ f (x) = f (0) = 0 und die Funktion kann nicht injektiv sein. Widerspruch! Daher und weil

0 ∈ ker(f ) gilt ker(f ) = {0}.

3

Nun nehme man an ker(f ) = 0, dann folgt

f (x1 ) = f (x2 ) ⇔ f (x1 − x2 ) = 0

⇔ x1 = x2

Daher ist f injektiv. Beispiel 1.13: Wieder sei eine Funktion f : R → [−1, 1], x 7→ cos(x) gegeben. Die Funktion ist surjektiv.

Dies zeigt man folgendermaßen: Es gilt f (0) = 1 und f (π) = −1, daher reicht es den Bereich [0, π] zu

betrachten. Da f stetig und [0, π] kompakt ist, nimmt f |[0,π] nach dem Zwischenwertsatz jeden Wert in

[−1, 1] mit f (x) ∈ [−1, 1] für ein x ∈ [0, π] an. Da außerdem [0, π] ⊂ R und |cos(x)| 5 1 gilt, ist auch die

Funktion f : R → [−1, 1] sujektiv.

Dass f nicht injektiv ist, sieht man an deren Periodizität. Ein Gegenbeispiel genügt: cos(0) = 1 = cos(2π).

Die Funktion f |[0,π] ist wegen der strengen Monotonie auf ]0, π[ auch injektiv, daher bijektiv.

Definition 1.14: Endomorphismus, Isomorphismus Automorphismus: Sei f : X → Y eine lineare

Abbildung zwischen Vektorräumen, dann nennt man

1. f einen Endomorphismus, falls X = Y.

2. f einen Isomorphismus, falls f bijektiv, d.h. sowohl surjektiv, als auch injektiv ist.

3. f einen Automorphismus, falls f ein bijektiver Endomorphismus ist.

Satz 1.15: Falls f : X → Y ein Isomorphismus ist, dann ist f −1 : Y → X linear, f −1 ist sogar wieder

ein Isomorphismus.

Beispiele 1.16:

1. Die identische Abbildung ist klarerweise ein Automorphismus.

2. Die Abbildung f : R → R definiert durch

(

x , falls x ∈ Q

f (x) =

0 , sonst

dann ist sie per Definition ein Endomorphismus. Aber sie ist weder injektiv (für alle irrationalen

Zahlen hat f den Wert 0) noch surjektiv (im Bild von f liegt keine irrationale Zahl). Die Einschränkung von f auf Q ist dann natürlich ein Automorphismus.

Definition 1.17: Rang einer linearen Abbildung Der Rang einer linearen Abbildung f ist definiert

als Rang(f ) := dim(Bild(f )).

Satz 1.18: (Dimensionssatz linearer Abbildungen): Seien X, Y Vektorräume, und f : x → Y linear,

dann gilt

dim(X) = dim(ker(f )) = dim(Bild(f )) = dim(ker(f )) + Rang(f )

Diesen Satz wollen wir hier nicht beweisen. Der Beweis findet sich überall in der einschlägigen Literatur.

Aber was sagt der Satz aus? Zunächst wissen wir, dass immer Rang(f ) 5 dim(X) gelten muss. Ist der

Rang der linaren Abbildung nun maximal, also Rang(f ) = dim(X), dann folgt aus dem Dimensionssatz,

dass dim(ker(f )) = 0 und die Abbildung somit injektiv ist. Außerdem lässt sich folgendes Korollar damit

leicht zeigen.

Korollar 1.19: Sei dim(X) = dim(Y ), dann sind folgende Bedingungen gleichwertig:

1. f ist injektiv

2. f ist surjektiv

3. f ist bijektiv

4

Für eine lineare Abbildung zwischen gleichdimensionalen Vektorräumen braucht man also nur eine der

Bedingungen nachzuprüfen.

Zwei Räume X, Y zwischen denen ein Isomorphismus φ : X → Y existiert nennt man zueinander isomorph,

d.h. die Räume sind (algebraisch) strukturgleich, da man jedem Element aus X genau ein Element aus

Y zuordnen kann. Man schreibt dann auch X w Y . Folgender Satz soll hier zitiert werden, da er häufig

ein gutes Kriterium für die Isomorphie zweier Vektorräume gibt.

Satz 2.20 Seien X, Y Vektorräume, dann gilt

dim(X) = dim(Y ) ⇔ X w Y

Eine häufig gestellte Aufgabe ist, dass man eine Familie aus Paaren von Vektoren aus zwei Vektorräumen

vorgibt und dann überprüft, ob es eine lineare Abbildung gibt, welche jeweils die beiden Vektoren eines

Paares verbindet. Folgender Satz gibt ein positives Ergebnis, wenn die Vektoren des Definitionsbereiches

eine Basis bilden.

Satz 2.21 Seien X, Y Vektorräume und {xi }i=1,··· ,n eine Basis von X, sowie {yi }i=1,··· ,n beliebige Vektoren aus Y , dann gibt es genau eine lineare Abbildung f , welche

f (xi ) = yi

i = 1, · · · , n

Für den Fall das {yi }i=1,··· ,n eine Basis von Y ist, gilt, dass f sogar ein Isomorphismus ist.

Beispiel 2.22: Gibt es eine lineare Abbildung f : R2 → R2 , welche

1

4

−2

2

f(

)=

, f(

=

)

3

0

1

6

erfüllt?

1

−2

eine Basis des R2 bildet, ist die Antwort

3

1

”Ja”. Vorsicht! Es ist hier nicht danach gefragt einen Homomorphismus explizit zu konstruieren. Dies

wäre zwar eine anderer, völlig legitimer Beweis, ist aber meist viel zeitaufwendiger.

Die Antwort gibt uns geradewegs Satz 2.21. Da

Wenn nun die Vektoren in X keine Basis bilden, kann man dann daraus direkt schließen, dass keine

lineare Abbildung existiert, welche die Bedingungen erfüllt? Nein, im Allgemeinen ist dieser Schluss nicht

richtig. Folgendes Beispiel soll die demonstrieren:

Wieder ist eine lineare Abbildung f : R2 → R2 gesucht, welche diesmal

1

1

2

2

f(

)=

, f(

=

)

3

3

6

6

erfüllen soll. Dann existieren sogar unendlich viele lineare Abbildung, da die Bedingungen die Abbildung

nur in einer Richtung festlegen. Ein Beispiel für eine dieser unendlich vielen Abbildungen,

wäre die

1

2

identische Abbildung. Es existiert also eine lineare Abbildung, obwohl die Vektoren

keine Basis

3

6

des R2 bilden. Eine sicheres Ausschlusskriterium für die Existenz einer linearen Abbildung ist natürlich

immer die Verletzung der Linearität durch die vorgegeben Bedingungen.

2 Matrizen als Darstellungen linearer Abbildungen

Mit Hilfe der Basis eines Vektorraumes, lassen sich seine Elemente, die Vektoren, in der bekannten

Spaltenform darstellen. Wir betrachten hier zunächst den Spezialfall des Kn . Der Vektor x ∈ Kn lässt

sich nach der Standard-Basis {ei }i=1,...,n entwickeln

x=

n

X

i=1

5

ai ei

wobei die Familie {ai }i=1,...n Elemante aus K sind. Dies lässt sich folgendermaßen darstellen :

a1

a2

..

.

an

Etwas Ähnliches kann man nun auch mit linearen Abbildungen machen und diese, auf eine bestimmte

Basis bezogene Repräsentation, lassen sich als die sogenannten Matrizen darstellen. Sei F : Kn → Km

eine lineare Abbildung und {ei }i=1,...,n Standard-Basis für Kn , sowie {f i }i=1,...,m Standard-Basis von Km .

Wendet man nun die lineare Abbildung auf die Basis von Kn an, d.h. man betrachtet F (ei ) ∀i ∈ {1, · · · , n},

so ist dies ein Familie von Vektoren in Y . Daher kann man nach obigem diese Vektoren wiederum nach

der Basis in Km entwickeln.

m

X

F (ei ) =

aij · f j

j=1

Die Koeffizienten ergeben dann die Einträge einer Matrix. Diese notiert man folgendermaßen:

a11 a12 · · · a1m

a21 a22 · · · a2m

A := .

..

..

..

.

···

.

an1

an2

···

anm

Hierbei bezeichnet konventionell der erste Index die Zeilen, der zweite die Spalte. Man ”sortiert” die

Matrizen nach ihrer Größe und nennt diese Räume Mat(n × m, K), wobei wieder die Faustregel gilt, erste

Ziffer entspricht der Anzahl der Zeilen und die zweite der Anzahl der Spalten der Matrix.

Einer linearen Abbildung F : Kn → Km lässt sich also genau eine Matrix A ∈ Mat(n × m, K) zuordnen.

Man schreibt dann

F (x) = A · x

wobei x ∈ Kn .

Man kann einen Isomorphismus definieren, welcher erlaubt die obigen Konstruktion auf einen beliebigen

Vektorraum

X zu übertragen. Sei dim(X) = n dieser Isomorphismus mit mit Ψ : Kn → X, (x1 , · · · , xn ) 7→

Pn

i

i

i

i

i=1 xi · b , wobei {b }i=1,··· ,n eine Basis von X ist. Außerdem gilt Ψ(e ) = b ∀i. Daher kann man nach

einer Wahl von Basen für den Definitionsraum und den Bildraum einer linearen Abbildung, dieser eine

eindeutig bestimmte Matrix zuweisen. Diese Matrizen nennt man auch Darstellungsmatrizen.

Über die Verknüpfung von linearen Abbildungen definiert man nun die Multiplikation von Matrizen.

Definition 2.2: (Matrixmultiplikation) Seien A ∈ Mat(n × l, K), B ∈ Mat(l × m, K), und C ∈

Mat(n × m, K) dann definiert man die Verknüpfung · als A · B := C über

cij =

l

X

aik bkj

i = 1, · · · , n; j = 1, · · · m

k=1

Zur Überprüfung der Wohldefiniertheit bedient man sich einfach des Spezialfalles Kn und er Darstellung

F (x) = A · x. Damit ergibt sich für beliebiges x ∈ Km

C · x = FC (x) = (FA ◦ FB )(x) = FA (FB (x)) = FA (B · x) = (A · B) · x

6

Die Gleichung für die Koeffizienten ergibt sich durch yk = (B · x)k =

Pm

j=1 bkj xj

und

(Cx)i = ((A · B)x)i = (Ay)i

=

l

X

aik yk

k=1

=

=

l X

m

X

aik bkj xj

k=1 j=1

m

X

cij xj

j=1

Die Koeffizientengleichung gibt auch direkt eine praktische Regel zur Berechnung von Matrizen zur Hand.

Zunächst betrachten wir den Fall A ∈ Mat(1 × n, K) und B ∈ Mat(n × 1, K), welcher dem Skalarprodukt

äquivalent ist.

b1

n

. X

a1 · · · an · .. =

ai bi

i=1

bn

Genau auf diese Art und Weise Multipliziert man Matrizen, indem man aus den Zeilen der ersten Matrix

und den Spalten der zweiten Matrix das ” Skalarprodukt ” bildet und daraus die neue Matrix bildet.

Beispiel 2.3: Gegeben seien die Matrizen

A=

3

−1

7

B= 0

−2

1 2

0 2

dann ergibt sich nach der Regel von oben

7

1

3 1 2

3 · 7 + 1 · 0 + 2 · (−2)

· 0 −5 =

−1 0 2

(−1) · 7 + 0 · 0 + 2 · (−2)

−2 3

1

−5

3

3 · 1 + 1 · (−5) + 2 · 3

17

=

(−1) · 1 + 0 · (−5) + 2 · 3

−11

4

5

Definition 2.4: (Transponierte einer Matrix): Sei A ∈ Mat(n × m, K), dann definiert man die

transponierte Matrix AT ∈ Mat(m × n, K) von A durch (AT )ij = (A)ji . Außerdem nennt man eine

Matrix symmetrisch, wenn A = AT gilt.

Satz 2.5: (Rechenregeln für die Transposition): Sei A, B ∈ Mat(n × m, K) dann gilt:

1. (A · B)T = B T · AT

2. (AT )T = A

3. (λA)T = λAT

Beispiel 2.6: Sei

A=

2

1

5

0

4

3

dann ergibt sich

2

AT = 5

4

1

0

3

Häufig will man wissen, ob eine Matrix A ∈ Mat(n × m, K) invertierbar ist oder nicht, bzw. ob ein

dazu assoziiertes Gleichungssystem lösbar ist. Damit wollen wir uns hier nicht beschäftigen, sondern zum

7

Schluss nur noch eine Definition anbringen, welche für die Untersuchung der Lösbarkeit eines LGS sehr

nützlich ist. Hierzu sei im folgenden:

ZR(A) := span({z1 , · · · , zn })

(z1 )T

der Zeilenraum, wobei {z1 , · · · , zn } die Zeilenvektoren der Matrix A, also A = ... , sind. Analog

(zn )T

definiert man den Spaltenraum als

SR(A) := span({s1 , · · · , sm })

mit den Spaltenvektoren {s1 , · · · , sm }.

Definition 2.7: (Zeilenrang und Spaltenrang einer Matrix) Sei A ∈ Mat(n × m, K), dann ist der

Zeilenrang von A definiert als dim(ZR(A)) und der Spaltenrang dementsprechend als dim(SR(A)).

Diese etws technische Definition vereinfacht sich erheblich durch folgenden Satz.

Satz und Definition 2.8: (Wohldefiniertheit des Ranges einer Matrix) Für eine Matrix A ∈

Mat(n × m, K) gilt immer

dim(ZR(A)) = dim(SR(A))

also Spaltrang gleich Zeilenrang. Daher definiert man den Rang einer Matrix als Rang(A) := dim(ZR(A)) =

dim(SR(A)).

Natürlich haben lineare Abbildung und zugehörige Darstellungsmatrix den gleichen Rang.

Beispiel 2.8: Für die Matrix

4 3

A = 0 1

0 0

0

−1

0

gilt Rang(A) = 2.

Hinweise 2.9:

1. Es gilt Rang(A) = Rang(AT ).

2. Natürlich haben lineare Abbildung und zugehörige Darstellungsmatrix den gleichen Rang.

8