Lineare Algebra I

Werbung

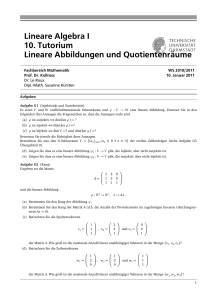

Lineare Algebra I LVA 405.070 C. Fuchs Inhaltsübersicht 08.06.2017 Inhaltsübersicht Die einführende Vorlesung über lineare Algebra gehört neben der Grundlagenausbildung, die man an der PLUS in der Lehrveranstaltung “Grundlagen der Mathematik” erhält, und neben dem AnalysisVorlesungszyklus zu den Grundpfeilern des Mathematikstudiums. Thema der lineare Algebra sind lineare Räume (sogenannte Vektorräume) und lineare Abbildungen. Diese Begriffe stellen einerseits einen konzeptuellen Zugang zur Vektorrechnung dar, die viele bereits in der Schule kennengelernt haben. Andererseits können damit lineare Gleichungssysteme systematisch gelöst werden; eine Fähigkeit, die in vielen Bereichen der Mathematik essentiell ist. Die Vorlesung beginnt mit einer Motivation, wo lineare Gleichungen auftreten und welches Lösungsverhalten beobachtet werden kann. Weiter wird gleich am Beginn der für die ganze Theorie entscheidende Gauß-Algorithmus zur Lösung von linearen Gleichungssystemen vorgestellt. Erst im Anschluss widmen wir uns der allgemeinen Theorie der Vektorräume. Dabei werden die Begriffe Basis und Dimension genau behandelt. Dann wenden wir uns den “strukturverträglichen” Abbildungen zwischen Vektorräumen zu. Wir werden sehen, dass jede lineare Abbildung (nach Wahl von Basen) durch eine Matrix beschrieben werden kann, womit dann der Zusammenhang zu den linearen Gleichungssystemen hergestellt ist. Die Vorlesung schließt mit dem Begriff der Determinante ab. Die Vorlesung behandelt (voraussichtlich) die folgenden Themen: §0. Lineare Gleichungssysteme Der Raum Rn , Geraden im R2 , Geraden und Ebenen im R3 , Gauß-Elimination §1. Vektorräume Gruppen, Ringe und Körper, Vektorräume, Basis und Dimension, Summen von Vektorräumen §2. Lineare Abbildungen Definition und Beispiele, Bild, Kern und Faktorraum, LGS, Koordinatisierung, Multiplikation, Koordinatentransformationen, Elementarmatrizen und Matrixumformungen §3. Determinanten Beispiele und Definition, Existenz und Eindeutigkeit Bei Fragen oder Bemerkungen (speziell Hinweise auf Fehler aller Art sind willkommen) schicken Sie ein Email an [email protected]. §0. Lineare Gleichungssysteme 0.1 Der Raum Rn 0.1.1 R, R2 , Rn 0.1.2 Addition und skalare Multiplikation, Nullvektor, −v 1 0.2 Geraden im R2 , Geraden und Ebenen im R3 0.2.1 Geraden im R2 Beispiele: a) x1 −x2 = 1, x2 = 2, b) x1 −x1 = 1, 2x1 −2x2 = b, c) x1 −x2 = 1, x1 +3x2 = 9, x1 +x2 = 2. 0.2.2 Geraden im R3 0.2.3 Ebenen im R3 0.3 LGS und das Gaußsche Eliminationsverfahren 0.3.1 Gleichungssysteme, Vereinfachungen der Darstellung, Lösungsmenge, Grundfragen 0.3.2 Matrizen, transponierte Matrix, Addition und skalare Multiplikation, Matrix-Vektor-Produkt Es seien gegeben a11 a12 · · · a1n a21 a22 · · · a2n m×n A = .. , .. .. ∈ R . . . . . . am1 am2 · · · amn b11 b12 · · · b1n b21 b22 · · · b2n ∈ Rm×n . B = .. .. . . .. .. . . bm1 bm2 · · · bmn Transponierte Matrix: Die zu A transponierte Matrix t A ∈ Rn×m ist gegeben durch :::::::::::::::::::::: a11 a21 · · · am1 a12 a22 · · · am2 n×m t . A = .. .. .. ∈ R . . . . . . a1n a2n · · · amn Bei dieser Operation werden die Zeilen von A zu den Spalten von t A und die Spalten von A zu den Zeilen von t A; somit wird aus der m × n-Matrix eine n × m-Matrix. Addition und skalare Multiplikation: Wir definieren die folgenden Matrix-Operationen (beachte, dass ::::::::::::::::::::::::::::::::::::: die Matrizen diesselbe “Dimension” haben!): a11 + b11 a12 + b12 · · · a1n + b1n a21 + b21 a22 + b22 · · · a2n + b2n A+B = .. .. .. ... . . . am1 + bm1 am2 + bm2 · · · amn + bmn λa11 λa12 · · · λa1n λa21 λa22 · · · λa2n λA = .. .. .. . . . . . . λam1 λam2 · · · λamn mit λ ∈ R. Kurz schreiben wir für A = (aij ), B = (bij ) und λ ∈ R diese Operationen in der Form: t A = 2 (aji ), A + B = (aij + bij ), λA = (λaij ). 0.3.3 Gleichungssysteme in der Form Ax = b, zulässige Umformungen für LGS 0.3.4 Elementare (Zeilen-)Umformungen für Matrizen, A ; B Beispiel 0.3.5 Zeilenform/Zeilenstufenform/Treppenform einer Matrix Beispiel 0.3.6 Satz (Gaußsches Eliminationsverfahren) Jede Matrix lässt sich in endlich vielen Schritten in :::::::::::::::::::::::::::::::::::::::::: Zeilenstufenform bringen. Der Beweis erfolgt durch den folgenden Algorithmus (Gaußsches Eliminationsverfahren): Eingabe: Matrix A = (aij ) ∈ Rm×n mit Zeilenvektoren zi und Spaltenvektoren sj . Ausgabe: T A ∈ Rm×n in Treppenform mit A ; T A. (0) Falls A = 0, dann T A = A, fertig. Andernfalls sei r = 1 und wir interieren die folgenden Schritte; dabei wird in jedem Schritt eine Matrix B mit A ; B erzeugt, die wir dann wieder A nennen. (1) Sei sjr der erste Spaltenvektor von A, der ab (einschließlich) der rten Zeile nicht nur Komponenten gleich 0 besitzt. Dann existiert ein erster Zeilenvektor zi mit i ≥ r und aijr 6= 0. Wende Air an; in der neuen Matrix gilt arjr 6= 0. (2) Für jedes i > r wende die Zeilenumformung Air (−aijr /arjr ) an. (3) Gibt es noch Spaltenvektoren, die ab der (r + 1)ten Komponente nicht nur Einträge gleich 0 haben, so ersetze r durch r + 1 und fahre mit (1) fort. Andernfalls T A = A, fertig. Beispiel 0.3.7 Bemerkungen 0.4 LGS und ihre Lösungen 0.4.1 Zeilenpivotierung Beispiel 0.4.2 Treppennormalform einer Matrix Beispiel 0.4.3 Satz (Gauß-Jordan Verfahren) :::::::::::::::::::::::::::::::: Dieser Algorithmus lautet wie folgt (Gauß-Jordan Verfahren): Eingabe: Matrix A = (aij ) ∈ Rm×n mit Zeilenvektoren zi und Spaltenvektoren sj . Ausgabe: T ∗ A ∈ Rm×n in Treppennormalform mit A ; T ∗ A. (0) Falls A = 0, dann T ∗ A = A, fertig. Andernfalls sei r = 1 und wir interieren die folgenden Schritte; dabei wird in jedem Schritt eine Matrix B mit A ; B erzeugt, die wir dann wieder A nennen. (1) Sei sjr der erste Spaltenvektor von A, der ab (einschließlich) der rten Zeile nicht nur Komponenten gleich 0 besitzt. Dann existiert ein erster Zeilenvektor zi mit i ≥ r und aijr 6= 0. Wende Air an; in der neuen Matrix gilt arjr 6= 0. (2) Wende die Zeilenpivotierung πrjr an. (3) Gibt es noch Spaltenvektoren, die ab der (r + 1)ten Komponente nicht nur Einträge gleich 0 haben, so ersetze r durch r + 1 und fahre mit (1) fort. Andernfalls T ∗ A = A, fertig. 3 Beispiel 0.4.4 Bemerkungen: Eindeutigkeit von r im G- und G-J-Verfahren (im Moment ohne Beweis), Rang und Defekt von Matrizen, Beweistechnik, Eindeutigkeit der Treppennormalform, praktisches Rechnen 0.4.5 Elementare Spaltenumformungen und die Normalform einer Matrix 0.4.6 Anwendung auf lineare Gleichungssysteme, Äquivalenz von Gleichungssystemen von Kronecker-Kapelli 0.4.7 Satz ::::::::::::::::::::::::::::: 0.4.8 Die allgemeine Lösung eines LGS Beispiel 0.4.9 Spezialfälle: r = n, b = 0 0.5 Determinanten 0.5.1 Leibniz-Formel zur Definition der Determinante einer Matrix in Rn 0.5.2 Spezialfälle: n = 2, n = 3, Diagonalmatrizen 0.5.3 Rechenregeln im allgemeinen Fall (für den Beweis siehe §3): A ;Aij B ⇒ det A = − det(B), A ;Ai (λ) B ⇒ λ det A = det B, A ;Aij (λ) B ⇒ det A = det B, det A = det t A. 0.5.4 Die Determinante kann also berechnet werden, indem das Gaußsche-Eliminationsverfahren auf die Matrix angewandt wird und obige Rechenregeln verwendet werden. §1. Vektorräume 1.0 Grundlagen 1.0.0 Bemerkungen über Mengen und Abbildungen: Mengen, Operationen der Mengenlehre (Gleichheit, Teilmenge, Durchschnitt, Vereinigung, Differenz), geordnete Paare und das kartesische Produkt, Relationen und Abbildungen (Bildmenge, Urbildmenge, Einschränkung, injektiv, surjektiv, bijektiv, inverse Abbildung), Komposition von Abbildungen 1.0.1 Familien 1.0.2 n-Tupel, Zusammenhang zwischen M n und M {1,...,n} 1.0.3 Matrizen 1.1 Gruppen 1.1.1 Operationen/Verknüpfungen Beispiele 4 1.1.2 Gruppen Beispiele 1.1.3 Eigenschaften: Das neutrale und inverse Elemente sind eindeutig, a−1 a = aa−1 = e, (a−1 )−1 = a, (ab)−1 = b−1 a−1 , Kürzungsregel 1.1.4 Verknüpfungstafel 1.1.5 Untergruppen 1.1.6 Satz (Untergruppenkriterium) ::::::::::::::::::::::::::::::: Beispiele 1.1.7 Gruppenhomomorphismen Beispiele: a) exp, b) R2 → R, (x, y) 7→ 3x + 2y (Eigenschaften von Gruppenhomomorphismen) 1.1.8 Satz ::::: 1.2 Ringe und Körper 1.2.1 Definition von Ringen Beispiele: Z, Q, R, M → R mit (f + g)(m) = f (m) + g(m), (f · g)(m) = f (m)g(m), Z/nZ 1.2.2 Unterring, Ringhomomorphismen 1.2.3 Körper Beispiele: Q, R, C, endliche Körper wie z.B. Z/pZ mit p prim 1.2.4 Satz (Eigenschaften): Ein Körper ist ein kommutativer Ring mit 1, 0 6= 1, a · 0 = 0 · a = 0, ::::: Produktnullsatz, a(−b) = (−a)b = −ab, (−a)(−b) = ab, Kürzungsregel 1.2.5 Charakteristik eines Körpers, char(K) = 0 oder eine Primzahl 1.2.6 Unterkörper, Körperhomomorphismen 1.3 Vektorräume 1.3.1 Rn und M (n, m)(R) revisited zur Motivation 1.3.2 Vektorraum Weitere Beispiele 1.3.3 Satz λ · 0 = 0, 0 · v = 0, (−1) · v = −v, λ · v = 0 ⇒ λ = 0 ∨ v = 0, v + w = w + v ::::: 1.3.4 Unterraum Beispiele 1.3.5 Satz Unterraumkriterium ::::: 5 1.3.6 Satz Der Durchschnitt von Unterräumen ist ein Unterraum. ::::: 1.3.7 Hülle Bemerkungen und Beispiele 1.3.8 Linearkombination Die Hülle ist die Menge der Linearkombinationen. 1.3.9 Satz ::::: 1.3.10 Lineare Unabhängigkeit Beispiele 1.3.11 ::::: Satz Charakterisierung von linearer Unabhängigkeit über eindeutige Linearkombinationen. Beispiele / hM i so ist M ∪ {v} lu. 1.3.12 Eine la Menge ist nie leer und jede Obermenge ist la; ist M lu und v ∈ 1.4 Basis und Dimension 1.4.1 Erzeugendensystem, endlich erzeugt, Basis Beispiele: kanonische Basis in V = K n Beispiele: Elementarmatrizen und die kanonische Basis in V = K m×n , V = {0}, V = K Charakterisierung von Basen als minimale Erzeugendensysteme bzw. maximal linear un1.4.2 Satz ::::: abhängige Mengen. 1.4.3 Satz Jede linear unabhängige Menge ist in einer maximal linear unabhängigen Menge enthal::::: ten. Beispiele 1.4.4 Verkürzen eines Erzeugendensystems zu einer Basis. 1.4.5 Satz Jeder Vektorraum besitzt eine Basis. ::::: 1.4.6 Basiserg änzungssatz :::::::::::::::::::::: 1.4.7 Numerierte Basis, geordnete Basis Die Darstellung eines jeden Vektors als Linearkombination in einer numerierten Basis ist 1.4.8 Satz ::::: eindeutig. 1.4.9 Austauschlemma :::::::::::::::::::: 1.4.10 Austauschsatz von Steinitz :::::::::::::::::::::::::::::: 1.4.11 Jede Basis eines endlich-erzeugten Vektorraumes hat endlich viele Elemente; zwei Basen sind gleichmächtig. 6 1.4.12 Dimension, endlich-dimensional, unendlich-dimensional Beispiele 1.4.13 Folgerungen 1.4.14 Berechnungsmethode einer Basis in Rn Beispiel 1.5 Summen 1.5.1 Summe von Vektorräumen: U1 + U2 = hU1 ∪ U2 i = {u1 + u2 ; u1 ∈ U1 , u2 ∈ U2 } 1.5.2 Dimensionssatz für Summen: dim(U1 ∩ U2 ) + dim(U1 + U2 ) = dim U1 + dim U2 ::::::::::::::::::::::::::::::: Beispiel: dim V = 5, dim U1 = 2, dim U2 = 3 1.5.3 Direkte Summe: U1 ⊕ U2 = U1 + U2 mit U1 ∩ U2 = {0} Beispiele: V = V ⊕ {0}, R2 = h{e1 }i ⊕ h{e2 }i, R3 = Ebene durch den Ursprung ⊕ Gerade durch den Ursprung, die nicht in der Ebene liegt. 1.5.4 Unterraumverband, U1 ∩ U2 = ggT(U1 , U2 ), U1 + U2 = kgV(U1 , U2 ) 1.5.5 Komplement, komplementär Beispiele Jeder Unterraum U eines Vektorraumes V besitzt ein Komplement. 1.5.6 Satz ::::: (Charakterisierung der direkten Summe). Sei V ein Vektorraum und U1 , U2 Unterräume 1.5.7 Satz ::::: von V . Für U = U1 + U2 sind die folgenden Aussagen äquivalent: a) U = U1 ⊕ U2 . b) Jedes u ∈ U besitzt eine eindeutige Darstellung der Form u = u1 + u2 mit u1 ∈ U1 , u2 ∈ U2 . c) Ist U endlich-dimensional, so ist dies weiter äquivalent zu dim U = dim U1 + dim U2 . Beweis: “a)⇒ b)”: Nach 1.5.1 besitzt jedes u ∈ U eine Darstellung u = u1 + u2 mit u1 ∈ U1 , u2 ∈ U2 . Angenommen u = u01 + u02 ist eine weitere Darstellung dieser Bauart. Dann gilt u1 − u01 = u02 − u2 ∈ U1 ∩ U2 = {0} und daher u1 = u01 , u2 = u02 . Die Darstellung ist also stets eindeutig. “b)⇒ a)”: Wir müssen zeigen, dass U1 ∩ U2 = {0}. Sei u ∈ U1 ∩ U2 . Dann sind aber u = u + 0 = 0 + u zwei verschiedene Darstellungen der obigen Bauart, woraus u = 0 folgt. “a)⇔ c)”: Diese Äquivalenz folgt sofort aus dem Dimensionssatz 1.5.2, denn es gilt dim U1 ∩ U2 = 0 ⇔ U1 ∩ U2 = {0}. // 1.5.8 Wir können die obigen Begriffe sofort auf mehr P als zwei S Summanden verallgemeinern: Sei (Ui )i∈I eine Familie von Unterräumen von V . Dann ist i∈I = h i∈I i. (Insbesondere für I = {1, . . . , n} ist U1 + · · · + Un = hU1 ∪ · · · ∪ Un i). Wir sagen die Summe ist direkt und schreiben X M Ui = Ui , i∈I i∈I P falls Ui ∩ ( j∈I\{i} Uj ) = {0} für alle i = 1, . . . , n. Es gilt dann ein analoger Satz zu 1.5.7 (siehe 9. Übungsblatt, wo auch diskutiert wird, warum der Begriff der direkten Summe hier so aussieht). Beachte, dass der Fall mit drei Summanden im Beweis von 1.5.2 bereits mitgespielt hat. 7 §2. Lineare Abbildungen 2.1 Definition und Beispiele 2.1.1 Motivierende Beispiele: a) Aus der Schule ist die folgende Abbildung bekannt: f : R → R, x 7→ ax. Der Graph ist eine Gerade durch den Ursprung. Es gilt f (x + y) = a(x + y) = ax + ay = f (x) + f (y), f (λx) = a(λx) = λ(ax) = λf (x). b) Wir wollen eine Drehung f im R2 um den Winkel α betrachten. Sei e1 = t (1, 0), e2 = t (0, 1) die kanonische Basis von R2 . Dann ist f (e1 ) = t (cos α, sin α) und f (e2 ) = t (− sin α, cos α) aufgrund der Definition von sin, cos. Für einen beliebigen Punkt x = t (x1 , x2 ) ∈ R2 gilt dann f (x) = f (x1 e1 + x2 e2 ) = x1 f (e1 ) + x2 f (e2 ) = t (x1 cos α − x2 sin α, x1 sin α + x2 cos α). Schreiben wir das in eine Matrix so gilt: f (x) = Ax mit cos α − sin α A= . sin α cos α Beachte: In den Spalten stehen die Bilder der Basisvektoren e1 , e2 . c) Wir können allgemeiner zwei beliebige Vektoren a = t (a1 , a2 ), b = t (b1 , b2 ) als Bilder von e1 , e2 vorgeben und erhalten eine Abbildung f (x) = Ax mit a1 b 1 A= . a2 b 2 d) Noch allgemeiner: Sei A ∈ Rm×n . Die Abbildung f : Rn → Rm definiert durch f (v) = Av für v ∈ Rn erfüllt f (v1 + v2 ) = f (v1 ) + f (v2 ) sowie f (λv) = λf (v) für alle v1 , v2 , v ∈ Rn , λ ∈ R. Sind e1 , . . . , en die kanonischen Basisvektoren. Dann ist f (e1 ) = Ae1 , . . . , f (en ) = Aen der Reihe nach die 1., 2. etc. n. Spalte von A. Auch hier: In den Spalten von A stehen die Bilder der Basisvektoren. e) Sei V der Vektorraum der stetigen Funktionen vom Intervall [a, b] nach R und int: V → R gegeben Rb durch f 7→ a f (x)dx. Die bekannten Rechenregel aus der Schule liefern int(f + g) = int(f )+ int(g) sowie int(λf ) = λ int(f ). f) Sei V der R-Vektorraum der beliebig oft stetig differenzierbaren Funktionen auf dem Interval I = [a, b]. Dann erfüllt die Abbildung diff: V → V, f 7→ f 0 die Eigenschaften diff(f + g) = diff(f )+ diff(g) sowie diff(λf ) = λ diff(f ). 2.1.2 Seien V, W Vektorräume über demselben Körper K und f : V → W eine Abbildung. f heißt eine lineare Abbildung (oder Homomorphismus von K-Vektorräumen oder K-linear), falls: L1) f (v + w) = f (v) + f (w) für alle v, w ∈ V L2) f (λv) = λf (v) für alle v ∈ V und λ ∈ K gilt; wir hätten beide Bedinungen auch gleichzeitig durch die Forderung L3) f (λv + µw) = λf (v) + µf (w) für alle v, w ∈ V, λ, µ ∈ K erfassen können. Eine lineare Abbildung ist also insbesondere ein Gruppenhomomorphismus zwischen den zugrundeliegenden Gruppen von V und W , der zudem verträglich mit der skalaren Multiplikation ist. L1) nennt man Additivität und L2) Homogenität von f . Zudem nennen wir f einen Monomorphismus/Epimorphismus/Isomorphismus, falls f injektiv/surjektiv/bijektiv ist. Ist V = W so heißt f ein Endomorphismus. Ist V = W und f bijektiv, so heißt f ein Automorphismus. Beispiel: Sei V = U ⊕ T ein Vektorraum. Die Abbildung πU : V → U, v = u + t 7→ u ist linear; sie heißt die Projektion von V (entlang T ) auf U . (Nachweis: Hausaufgabe) 2.1.3 :::::: Satz Sei f : V → W eine lineare Abbildung. Es gelten die folgenden Eigenschaften: a) f (0) = 0 und f (−v) = −f (v) für alle v ∈ V . b) f (λ1 v1 + · · · + λn vn ) = λ1 f (v1 ) + · · · + λn f (vn ) und somit 8 f (hM i) = hf (M )i. c) Ist {v1 , . . . , vn } l.a. so ist {f (v1 ), . . . , f (vn )} ebenfalls l.a. d) f (U ) ist ein Unterraum von W , falls U ein Unterraum von V ist, und f −1 (T ) = {v ∈ V ; f (v) ∈ T } ist ein Unterraum von V , falls T ein Unterraum von W ist. e) dim f (U ) ≤ dim W , f) ist f ein Isomorphismus, so ist f −1 ebenfalls linear. Beweis: a) f (0) = f (0 · 0) = 0f (0) = 0 und f (−v) = f ((−1)v) = (−1)f (v) = −f (v). b) Hausaufgabe. c) Angenommen λ1 v1 + · · · + λn vn = 0 sei eine nicht-triviale LK von 0. Dann folgt f (λ1 v1 +· · ·+λn vn ) = f (0) = 0 = λ1 f (v1 )+· · ·+λn f (vn ). Daher die Aussage. d) Da f (0) = 0 ∈ f (U ) ist f (U ) 6= ∅. Seien w1 , w2 , w ∈ f (U ), d.h. ∃u1 , u2 , u ∈ U : f (u1 ) = w1 , f (u2 ) = w2 , f (u) = w. Dann ist w1 + w2 = f (u1 ) + f (u2 ) = f (u1 + u2 ) ∈ f (U ) sowie λw = λf (u) = f (λu) ∈ f (U ) und somit das Unterraumkriterium erfüllt (beachte, dass u1 + u2 , λu ∈ U , da U ein Unterraum ist). Seien u1 , u2 , u ∈ f −1 (T ), d.h. f (u1 ), f (u2 ), f (u) ∈ T . Da T ein Unterraum ist, ist auch f (u1 ) + f (u2 ) = f (u1 + u2 ) ∈ T sowie λf (u) = f (λu) ∈ T . Somit ist u1 + u2 , λu ∈ f −1 (T ). Da f (0) = 0 ∈ T ist 0 ∈ f −1 (T ) und daher die Aussage gezeigt. e) Folgt sofort aus c). f) Sei w1 , w2 ∈ W, λ, µ ∈ K mit f (v1 ) = w1 , f (v2 ) = w2 , so folgt f (λv1 + µv2 ) = λw1 + µw2 . Anwenden von f −1 ergibt: f −1 (λw1 + µw2 ) = λv1 + µv2 = λf −1 (w1 ) + µf −1 (w2 ) und somit die Aussage. // 2.1.4 Zusammensetzung von linearen Abbildungen: Seien V1 , V2 , V3 Vektorräume über K und f : V1 → V2 , g : V2 → V3 lineare Abbildungen. Dann ist g ◦ f : V1 → V3 ebenfalls linear. Wir bezeichnen mit HomK (V, W ) = {f : V → W ; f ist K-linear}. Dies ist ein Unterraum des K-Vektorraums W V . Beweis: g ◦ f ist linear: (g ◦ f )(v + w) = g(f (v + w)) = g(f (v) + f (w)) = g(f (v)) + g(f (w)) = (g ◦ f )(v) + (g ◦ f )(w), (g ◦ f )(λv) = g(f (λv)) = g(λf (v)) = λg(f (v)) = λ(g ◦ f )(v). HomK (V, W ) ist Unterraum: Die Nullabbildung ist neutrales Element und linear, daher ist HomK (V, W ) 6= ∅. Seien f, g ∈ HomK (V, W ). Dann ist (f + g)(v + w) = f (v + w) + g(v + w) = f (v) + f (w) + g(v) + g(w) = f (v)+g(v)+f (w)+g(w) = (f +g)(v)+(f +g)(w) sowie (f +g)(λv) = f (λv)+g(λv) = λf (v)+λg(v) = λ(f (v) + g(v)) = λ(f + g)(v) und daher f + g ∈ HomK (V, W ). Genauso überprüft man λf ∈ HomK (V, W ) (Nachweis: Hausaufgabe) und somit folgt die Behauptung nach dem Unterraumkriterium. // 2.1.5 Insbesondere erhalten wir den K-Vektorraum End(V ) := HomK (V, V ) der Endomorphismen eines Vektorraums V . Dieser hat mit der Verknüpfung f · g = g ◦ f auch noch eine multiplikative Struktur. (End(V ), +, ·) ist ein Ring, für den gilt (λf + µg)h = λf h + µgh, f (λg + µh) = λf g + µf h für alle f, g, h ∈ End(V ) und λ, µ ∈ K gilt. Man sagt der Endomorphismenring End(V ) ist eine assoziative K-Algebra. 2.2 Bild, Kern und Faktorraum 2.2.1 Sei f ∈ HomK (V, W ). Dann heißt ker(f ) := f −1 (0) = {v ∈ V ; f (v) = 0} der Kern von f , im(f ) := f (V ) heißt das Bild von f . Paradebeispiel: V = W = R2 , f ( t (x1 , x2 )) = t (−2x1 + 2x2 , −x1 + x2 ). −1 2.2.2 Für jedes w ∈ W nennen wir fS (w) = {v ∈ V ; f (v) = w} die Fasern über w bzgl. f . Aus der Definition einer Abbildung folgt: w∈W f −1 (w) = V und zwei Fasern sind entweder gleich oder haben leeren Durchschnitt. 2.2.3 Satz Sei f ∈ HomK (V, W ). Dann gilt: a) ker(f ) und im(f ) sind Unterräume von V bzw. W . ::::: b) f ist injektiv ⇔ ker(f ) = {0}. c) f ist surjektiv ⇔ im(f ) = W . d) Ist f injektiv und {v1 , . . . , vn } 9 l.u., so ist auch {f (v1 ), . . . , f (vn )} l.u. e) Ist u ∈ f −1 (w) beliebig, so gilt f −1 (w) = u + ker(f ). 2.2.4 Affine Unterräume: Eine Teilmenge X eines K-Vektorraums V heißt ein affiner Unterraum, falls ∃v ∈ V und ein Unterraum W von V mit X = v +W . Es gilt: Ist v 0 ∈ X, so ist X = v 0 +W . Ist v 0 ∈ V und W 0 ein weiterer Unterraum von V mit X = v 0 + W 0 , so folgt W = W 0 und v − v 0 ∈ W (der Unterraum ist also eindeutig, der “Aufhängungspunkt” beliebig in W ). Wir definieren: dim X := dim W . 2.2.5 Rang und Defekt: Sei f ∈ HomK (V, W ). Wir nennen rg(f ) := dim im(f ) = dim f (V ) den Rang von f und df(f ) := dim ker(f ) den Defekt von f . Beispiel: Ist f : K n → K m , v 7→ Av mit A ∈ K m×n . Sei e1 , . . . , en die kanonische Basis von K n . In den Spalten von A stehen die Bilder dieser Basis (also f (e1 ) = Ae1 , . . . , f (en ) = Aen ). Diese Vektoren spannen in K m den Bildraum im(f ) auf, d.h. im(f ) = hAe1 , . . . , Aen i = SR(A). Daher ist der (Spalten-)Rang der Matrix A gleich rg(f ). 2.2.6 Satz (Rangformel) Sei f : V → W linear und dim V < ∞. Dann gilt dim V = rg(f )+ :::::::::::::::::::: df(f ). Genauer: Sei {v1 , . . . , vk } eine Basis von ker(f ) und {w1 , . . . , wr } eine Basis von im(f ). Wähle ui ∈ f −1 (wi ) für i = 1, . . . , r beliebig. So ist {u1 , . . . , ur , v1 , . . . , vk } eine Basis von V . 2.2.7 Folgerungen: a) dim f −1 (w) = dim V − rg(f ). b) Zwei endlich-dimensionale Vektorräume V, W sind genau dann isomorph, wenn dim V = dim W . c) f : V → W mit dim V = dim W . Dann sind äquivalent: i) f ist injektiv, ii) f ist surjektiv, iii) f ist bijektiv. Faktorisierungssatz Sei f ∈ HomK (V, W ) und {v1 , . . . , vk , u1 , . . . , ur } eine Basis von V 2.2.8 ::::::::::::::::::::::: mit ker(f ) = h{v1 , . . . , vk }i. Definiere U = h{u1 , . . . , ur }i. Dann gilt: a) V = U ⊕ ker(f ). b) f |U : U → im(f ) ist ein Isomorphismus. c) Sei πU die Projektion auf U , so gilt f = f |U ◦ πU . d) Jede nichtleere Faser f −1 (w) schneidet U in genau einem Punkt und es gilt {πU (v)} = f −1 (f (v)) ∩ U . 2.2.9 Faktorraum: Sei V ein K-Vektorraum und U ein Unterraum von V . Wir definieren auf V eine Relation durch v1 ∼ v2 ⇔ v1 − v2 ∈ U . Dies ist eine Äquivalenzrelation. Die zugehörige Partition von V bezeichnen wir mit V /U . Eine Äquivalenzklasse {v 0 ∈ V ; v ∼ v 0 } von v ∈ V bzgl. ∼ hat die Gestalt v + U ! Wir definieren π : V → V /U, v 7→ v + U . Es gibt nun genau eine Art wie wir V /U zu einem K-Vektorraum machen können, so dass π linear wird: (v1 + U ) + (v2 + U ) := (v1 + v2 ) + U , λ(v + U ) := (λv) + U für alle v1 + U, v2 + U, v + U ∈ V /U, λ ∈ K. Weiters gilt: π ist surjektiv, ker(π) = U und dim V /U = dim V − dim U falls dim V < ∞. für lineare Abbildungen Sei f ∈ HomK (V, W ) und U ein Unterraum von 2.2.10 Homomorphiesatz :::::::::::::::::::::::::::::::::::::::::::::: V mit U ⊆ ker(f ). Dann gibt es genau eine lineare Abbildung f 0 : V /U → W mit f = f 0 ◦ π. Weiters gilt: ker(f 0 ) = ker(f )/U . Veranschaulichung Sei V = U ⊕ T und π : V → V /T . Dann ist π|U : U → V /T ein Isomorphismus. 2.2.11 Satz ::::: 2.3 LGS 2.3.1 Präzisierung der Begriffe: Sei A ∈ K m×n , b ∈ K m . Ein LGS mit m Gleichungen und n Unbekannten ist gegeben durch Ax = b. Das LGS heißt homogen, falls b = 0, und inhomogen sonst. Wir haben mit L(A, b) = {x ∈ K n ; Ax = B} die Lösungsmenge des LGS Ax = b bezeichnet. Betrachte nun die lineare Abbildung f : K n → K m , x 7→ Ax. Dann ist L(A, b) = f −1 (b), L(A, 0) = ker(f ) und 10 Ax = b lösbar genau dann, wenn b ∈ im(f ). Die Größe des Lösungsraums ist festgelegt durch r = rg(f ) = rg(A)= Spaltenrang von A. Es gilt: a) L(A, 0) ist ein Unterraum von K n der Dimension n − r. b) L(A, b) ist ein affiner Raum mit Dimension n − r und falls v eine beliebige Lösung ist, d.h. Av = b, so gilt L(A, b) = v + L(A, 0). Ist {w1 , . . . , wr } eine Basis von L(A, 0), man spricht von einem Fundamentalsystem von Lösungen des homogenen LGS, und v eine spezielle Lösung des LGS, man spricht von einer Partikulärlösung, so gilt L(A, b) = v + Kw1 + · · · + Kwr . 2.3.2 Wir beweisen nun noch einmal den Satz von Kronecker-Kapelli (siehe 0.4.7): Die Matrix A gibt eine Abbildung fA : K n → K m , die erweiterte Koeffizientenmatrix B = (A, b) eine Abbildung fB : K n+1 → K m . Seien e1 , . . . , en die kanonische Basis von K n und e1 , . . . , en+1 die kanonische Basis von K n+1 so gilt fA (e1 ) = fB (e1 ), . . . , fA (en ) = fB (en ), fB (en+1 ) = b ∈ im(fB ). Es gilt im(fA ) ⊆ im(fB ), daher dim im(fA ) ≤ dim im(fB ) und daher rg(fA ) ≤ rg(fB ). Somit gilt rg(fA ) = rg(fB ) ⇔ im(fA ) = im(fB ) ⇔ b ∈ im(fA ). // 2.3.3 Alle Überlegungen aus Kapitel 0.4 gelten, wenn R durch einen beliebigen Körper K ersetzt wird. 2.3.4 Sei Cx = d mit C in Treppennormalform gegeben und seien j1 , . . . , jr die Inidizes aus der Treppennormalform von C sowie ej1 , . . . , ejr die zu diesen Indizes gehörigen kanonischen Basisvektoren von K n . Dann ist fC (ej1 ), . . . , fC (ejr ) ∈ K m eine Basis von im(fC ). Der Unterraum U := h{ej1 , . . . , ejr }i ⊆ K n ist der direkte Summand aus dem Faktorisierungssatz 3.2.8. 2.3.5 Wir betrachten nun 0.4.8 genauer: Wir hatten die Lösung von Ax = b ja in der Form x = d + λ1 v1 + · · · + λn−r vn−r mit −c1,r+1 · · · −cr,n .. .. . . (v1 , . . . , vk ) = −cr,r+1 , · · · −cr,n En−r mit k = n − r zusammengebaut (dabei hatten wir die Voraussetzung, dass {j1 , . . . , jr } = {1, . . . , r}). Die Vektoren v1 , . . . , vk sind eine Basis von kerfC , wobei Cx = d das LGS mit C in Treppennormalform bezeichet. Setzen wir C 0 := (v1 , . . . , vk ) ∈ K m×k . Sei Φ0 : K n−r → L(A, 0), λ = t (λ1 , . . . , λn−r ) 7→ C 0 λ. Es gilt Φ : K n−r → L(A, b), λ 7→ d + Φ0 (λ). An der Matrix C sieht man, dass Φ0 eine injektive lineare Abbildung ist; da dim L(A, 0) = n − r = dim K n−r folgt daraus die Bijektivität von Φ0 . Wir erhalten also einen Isomorphismus Φ0 : K n−r → L(A, 0) und eine Bijektion Φ : K n−r → L(A, b) = d + L(A, 0). Beispiel Noch immer offen: Warum ist der Zeilenrang einer Matrix gleich dem Spaltenrang und somit gleich dem Rang als lineare Abbildung? Was bedeuten die Zeilenumformungen und wie hängen die Abbildungen fA und fC zusammen, wenn A ; C? 2.4 Lineare Abbildungen und Matrizen für lineare Abbildungen Seien V, W Vektorräume über K, B eine Basis von 2.4.1 Fortsetzungssatz :::::::::::::::::::::::::::::::::::::::::::: 0 V und f : B → W eine beliebige Abbildung. Dann kann f auf genau eine Weise zu einer linearen Abbildung f ∈ HomK (V, W ) fortgesetzt werden, d.h. es gilt f (v) = f 0 (v) Für alle v ∈ B. 11 2.4.2 Folgerung 1 (Anwendung auf Standardräume): Zu jeder Abbildung f ∈ HomK (K n , K m ) gibt es genau eine Matrix A ∈ K m×n mit f (x) = Ax für alle x ∈ K n . 2.4.3 Berechnungsmethode der Matrix A Beispiel 2.4.4 Folgerung 2 (Koordinatisierung): Sei V ein n-dimensionaler Vektorraum über K. Jede geordnete Basis β = (v1 , . . . , vn ) von V wird umgekehrt eindeutig durch einen Isomorphismus Φβ : K n → V beschrieben. 2.4.5 Seien V, W Vektorräume über K, β eine Basis von V und γ eine Basis von W . Jede Abbildung f ∈ HomK (V, W ) wird bzgl. β und γ umgekehrt eindeutig durch eine Matrix Mβγ (f ) ∈ K m×n beschrieben. Beispiele 2.4.6 Satz Die Abbildung f 7→ Mβγ (f ) ist ein Isomorphismus von HomK (V, W ) auf K m×n . ::::: 2.4.7 Für V = W setzt man üblicherweise β = γ und erhält einen Isomorphismus von End(V ) auf K n×n . (Normalformenproblem für lineare Abbildungen) 2.4.8 Satz :::::::::::::::::::::::::::::::::::::::::::::::::::::::: Beispiel 2.5 Matrizenmultiplikation 2.5.1 Matrizenprodukt mit Rechenregeln 2.5.2 Satz Verkettung und Matrizenprodukt: Mβ1 β3 (g ◦ f ) = Mβ2 β3 (g)Mβ1 β2 (f ). ::::: 2.5.3 Assoziativgesetz für die Matrizenmultiplikation: (AB)C = A(BC). 2.5.4 Quadratische Matrizen: regulär, singulär 2.5.5 Satz A ∈ K n×n ist genau dann regulär, wenn A Koordinatenmatrix eines Automorphismuses ::::: eines n-dimensionalen K-Vektorraumes V ist. 2.5.6 ::::: Satz Die regulären (n×n)-Matrizen bilden mit der Matrizenmultiplikation eine Gruppe GLn (K). Diese Gruppe ist, nach Wahl einer Basis β, isomorph zur Gruppe GL(V ) = AutK (V ) der Automorphismen eines n-dimensionalen Vektorraumes V . Es folgt: Die inverse Matrix B zu A ist eindeutig bestimmt (wir schreiben B = A−1 ) und es gilt (A−1 )−1 = A, (AB)−1 = B −1 A−1 . Außerdem: Mββ (f −1 ) = Mββ (f )−1 für f ∈ GL(V ). 2.5.7 Berechnungsmethode der zu A ∈ K n×n inversen Matrix: a) A|En ; En |A−1 durch elementare Zeilenumformungen; b) A = Mηη (fA ) ⇒ A−1 = Mηη (fA−1 ) mit der Methode von 2.4.3 durch elementare Spaltenumformungen. Beispiel 2.5.8 Reguläre Matrizen und ihre Transponierte: Für A ∈ K n×n ist äquivalent: a) A ∈ GLn (K); b) t A ∈ GLn (K); c) der Spaltenrang von A ist n; d) der Zeilenrang von A ist n. In diesem Fall ist 12 ( t A)−1 = t (A−1 ). 2.6 Koordinatentransformation 2.6.1 Koordinatenwechsel, Transformationsmatrizen Beispiele 2.6.2 Mβγ (idV ) = Tβγ Beispiel (Transformationsformel) Mβ 0 γ 0 (f ) = Tγγ 0 Mβγ (f )Tβ 0 β ; Spezialfall für β = γ, β 0 = γ 0 . 2.6.3 Satz ::::::::::::::::::::::::::::::: 2.6.4 Äquivalente und ähnliche Matrizen 2.6.5 Lösung des Normalformenproblems: a) Zwei Matrizen sind genau dann äquivalent/ähnlich, wenn sie diesselbe lineare Abbildung/denselben Endomorphismus bzgl. geeigneter Basen beschreiben. b) Zwei Matrizen sind genau dann äquivalent, wenn sie denselben Rang haben; jede Matrix A ist äquivalent zur Matrix in Normalform mit Rang r = rg(A). 2.6.6 Satz Für jede Matrix A gilt: Zeilenrang von A = Spaltenrang von A =: Rang von A. ::::: 2.7 Elementarmatrizen und Matrixumformungen 2.7.1 Elementarmatrizen: Pij , Si (λ), Sij (λ) 2.7.2 Eigenschaften 2.7.3 Satz Jede invertierbare Matrix ist Produkt von Elementarmatrizen. ::::: 2.7.4 Berechnungsmethode der Zerlegung von A in ein Produkt von Elementarmatrizen Beispiel 2.7.5 Berechnungsmethode der Normalform von A inklusive der regulären Matrizen S, T mit SAT −1 = Normalform von A Beispiel 2.7.6 Berechnungsmethode einer regulären Matrix S mit SA hat Treppenform/Treppennormalform Beispiel 2.7.7 Elementarmatrizen und LGS: Sei A ∈ K m×n , b ∈ Km , P ∈ GLn (K), Q ∈ GLm (K). Dann gilt −1 −1 L(A, b) = fA−1 (b) = fQA (fQ (b)) = fP (fAP (b)) bzw. L(A, b) = {x ∈ K n ; Ax = b} = {x ∈ K n ; (QA)x = Qb} = {P y; y ∈ L(AP, b)}. §3. Determinanten 3.1 Definition und Beispiele 3.1.1 Motivierende Beispiele 13 3.1.2 Axiomatische Definition der Determinante 3.1.3 Satz Rechenregel ::::: 3.1.4 Praktische Berechnungsmethode Beispiele 3.2 Existenz und Eindeutigkeit 3.2.1 Wiederholung der Leibniz-Formel aus 0.5.1 3.2.2 Existenzund Eindeutigkeitssatz ::::::::::::::::::::::::::::::::::: det(A) = det( t A) 3.2.3 Satz ::::: 3.3 Berechnung und Entwicklung von Determinanten 3.3.1 Kofaktoren und Kofaktormatrix A# 3.3.2 Satz AA# = A# A = (det(A))En ::::: von Laplace 3.3.3 Entwicklungssatz ::::::::::::::::::::::::::::::::: 3.3.4 Inverse und Kofaktor (Cramersche Regel) 3.3.5 Satz :::::::::::::::::::::::::: Beispiel 3.4 Determinante eines Endomorphismus und Orientierung 3.4.1 Sei f ∈ End(V ) und β eine Basis von V , dann det(f ) = det Mββ (f ); dies ist wohldefiniert. 3.4.2 Begriffe gleichsinnig, gegensinnig, gleichorientiert und orientierte Vektorräume (über R) Beispiel Literatur 1. G. Fischer, Lineare Algebra, Vieweg+Teubner, 2010, ISBN978-3-8348-0996-4 2. H. Havlicek, Lineare Algebra für Technische Mathematiker, Heldermann, 2012, ISBN-10: 388538-116-8, ISBN-13: 978-3-88538-116-7 3. S. Lang, Linear Algebra, Springer, 2004, ISBN-10: 0387964126, ISBN-13: 978-0387964126 14