Lineare Algebra Inhaltsverzeichnis 1 Begriffe 2 Matrizen f

Werbung

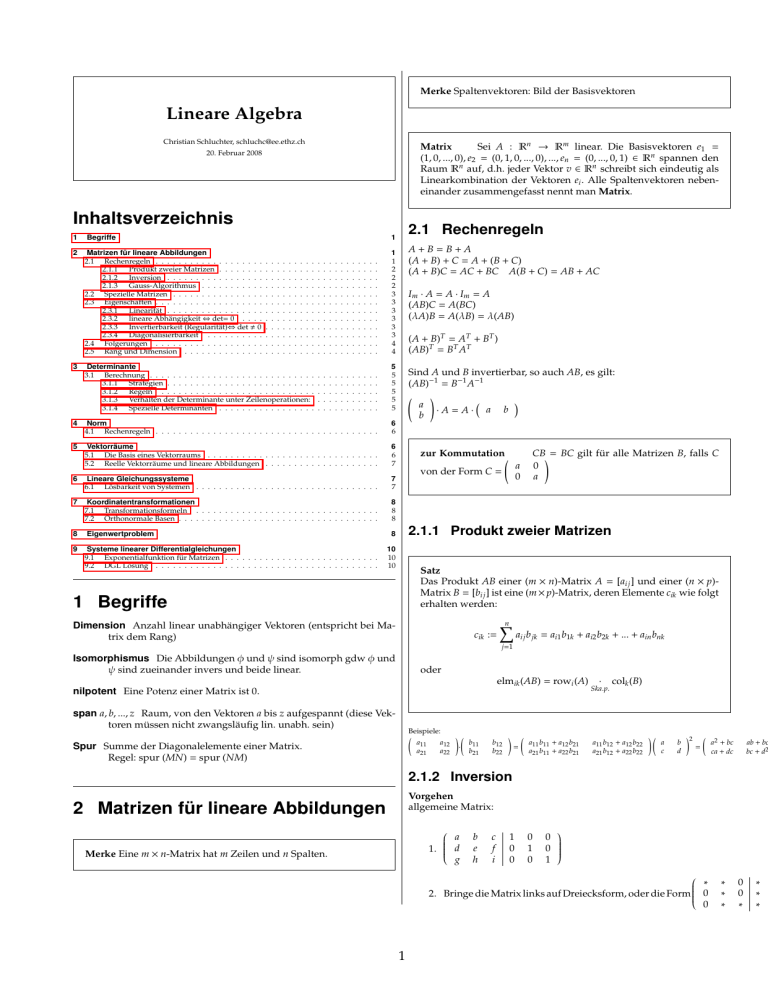

Merke Spaltenvektoren: Bild der Basisvektoren Lineare Algebra Christian Schluchter, [email protected] Matrix Sei A : Rn → Rm linear. Die Basisvektoren e1 = (1, 0, ..., 0), e2 = (0, 1, 0, ..., 0), ..., en = (0, ..., 0, 1) ∈ Rn spannen den Raum Rn auf, d.h. jeder Vektor v ∈ Rn schreibt sich eindeutig als Linearkombination der Vektoren ei . Alle Spaltenvektoren nebeneinander zusammengefasst nennt man Matrix. 20. Februar 2008 Inhaltsverzeichnis 1 Begriffe 2 Matrizen für lineare Abbildungen 2.1 Rechenregeln . . . . . . . . . . . . . . . . . . . 2.1.1 Produkt zweier Matrizen . . . . . . . . 2.1.2 Inversion . . . . . . . . . . . . . . . . . 2.1.3 Gauss-Algorithmus . . . . . . . . . . . 2.2 Spezielle Matrizen . . . . . . . . . . . . . . . . 2.3 Eigenschaften . . . . . . . . . . . . . . . . . . . 2.3.1 Linearität . . . . . . . . . . . . . . . . . 2.3.2 lineare Abhängigkeit ⇔ det= 0 . . . . 2.3.3 Invertierbarkeit (Regularität)⇔ det , 0 2.3.4 Diagonalisierbarkeit . . . . . . . . . . 2.4 Folgerungen . . . . . . . . . . . . . . . . . . . 2.5 Rang und Dimension . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1 1 2 2 2 3 3 3 3 3 3 4 4 Determinante 3.1 Berechnung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3.1.1 Strategien . . . . . . . . . . . . . . . . . . . . . . . . . . 3.1.2 Regeln . . . . . . . . . . . . . . . . . . . . . . . . . . . 3.1.3 Verhalten der Determinante unter Zeilenoperationen: 3.1.4 Spezielle Determinanten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5 5 5 5 5 5 4 Norm 4.1 Rechenregeln . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6 6 5 Vektorräume 5.1 Die Basis eines Vektorraums . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5.2 Reelle Vektorräume und lineare Abbildungen . . . . . . . . . . . . . . . . . . . . 6 6 7 6 Lineare Gleichungssysteme 6.1 Lösbarkeit von Systemen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7 7 7 Koordinatentransformationen 7.1 Transformationsformeln . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7.2 Orthonormale Basen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8 8 8 8 Eigenwertproblem 9 Systeme linearer Differentialgleichungen 9.1 Exponentialfunktion für Matrizen . . . . . . . . . . . . . . . . . . . . . . . . . . . 9.2 DGL Lösung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3 2.1 Rechenregeln 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . A+B=B+A (A + B) + C = A + (B + C) (A + B)C = AC + BC A(B + C) = AB + AC Im · A = A · Im = A (AB)C = A(BC) (λA)B = A(λB) = λ(AB) (A + B)T = AT + BT ) (AB)T = BT AT Sind A und B invertierbar, so auch AB, es gilt: (AB)−1 = B−1 A−1 ! a ·A=A· a b b zur Kommutation a 0 von der Form C = CB! = BC gilt für alle Matrizen B, falls C 0 a 2.1.1 Produkt zweier Matrizen 8 10 10 10 Satz Das Produkt AB einer (m × n)-Matrix A = [aij ] und einer (n × p)Matrix B = [bij ] ist eine (m × p)-Matrix, deren Elemente cik wie folgt erhalten werden: 1 Begriffe Dimension Anzahl linear unabhängiger Vektoren (entspricht bei Matrix dem Rang) cik := n X aij b jk = ai1 b1k + ai2 b2k + ... + ain bnk j=1 Isomorphismus Die Abbildungen φ und ψ sind isomorph gdw φ und ψ sind zueinander invers und beide linear. oder elmik (AB) = rowi (A) nilpotent Eine Potenz einer Matrix ist 0. span a, b, ..., z Raum, von den Vektoren a bis z aufgespannt (diese Vektoren müssen nicht zwangsläufig lin. unabh. sein) · Ska.p. colk (B) Beispiele: a11 a21 Spur Summe der Diagonalelemente einer Matrix. Regel: spur (MN) = spur (NM) a12 a22 ! · b11 b21 b12 b22 ! = a11 b11 + a12 b21 a21 b11 + a22 b21 a11 b12 + a12 b22 a21 b12 + a22 b22 ! a c b d !2 = a2 + bc ca + dc ab + bc bc + d2 2.1.2 Inversion Vorgehen allgemeine Matrix: 2 Matrizen für lineare Abbildungen a 1. d g Merke Eine m × n-Matrix hat m Zeilen und n Spalten. b e h c f i 1 0 0 0 1 0 0 0 1 ∗ 2. Bringe die Matrix links auf Dreiecksform, oder die Form 0 0 1 ∗ ∗ ∗ 0 0 ∗ ∗ ∗ ∗ 1 3. Weiteres auflösen nach der Form 0 0 0 1 0 0 0 1 ∗ ∗ ∗ ∗ ∗ ∗ ∗ ∗ ∗ Satz Zu jeder Matrix M ∈ Rm×n existiert eine lineare Abbildung A : Rn → Rm mit Mat(A) = M Dreiecksmatrix 1 0 Bestimme die Inverse zu 0 0 1 0 a b c 1 0 1 d e 0 1 0 1 f 0 0 0 0 0 0 1 0 0 Umwandlung mit Gauss zu: ∗ ∗ 0 0 0 1 0 1 0 0 ∗ ∗ 0 ∗ ∗ 0 1 0 0 0 0 1 ∗ ∗ In diesem Beispiel: 1 −a 0 0 0 1 0 1 0 0 0 1 0 0 1 0 0 0 0 0 0 0 0 1 a 1 0 0 0 0 1 0 ∗ ∗ ∗ ∗ b d 1 0 0 0 0 1 ∗ ∗ ∗ ∗ c e f 1 b d 0 b 0 d b a b Merke Die Summe zweier linearer Funktionen ist wieder eine lineare Funktion. Das Produkt einer linearen Funktion mit einer Konstanten ist wieder eine lineare Funktion. → Die Menge aller linearen Funktionen ist ein UVR. −b + ad −d 1 0 spezielle Matrizen ! a b 1 A= → A−1 = det(A) c d 1 0 0 0 a 0 −1 A = → A = 0 0 1 1 0 b 0 a 0 −1 A = → A = 0 0 1 a A = c 0 a A = 0 c a b A = b b f − ad f − c + ae −e + d f −f 1 d −c 1 0 0 1 0 0 d 0 −c 1 0 → A−1 = det(A) e 0 d 0 1 −c e → A−1 = det(A) 0 0 b c −1 b → Ansatz : A = d d a 1 a 0 0 1 0 2.3.2 lineare Abhängigkeit ⇔ det= 0 linear abhängig Die Vektoren v1 , v2 , ..., vn ∈ V sind linear abhängig, falls es Zahlen λ1 , λ2 , ..., λn ∈ R gibt, nicht alle 0, so dass λ1 v1 + λ2 v2 + ... + λn vn = 0. ! −b a 0 0 0 1 −b 0 1 −b a 0 0 0 Merke Ist die Anzahl Vektoren grösser als deren Dimension, sind sie linear abhängig. det(A) e −b a det(A) 0 e d d c d d c 0 0 Merke Zum testen der linearen Abhängigkeit von Vektoren, schreibe sie als Zeilenvektoren in eine Matrix und wende das Gaussverfahren an oder berechne die Determinante. Entsteht eine 0-Zeile, oder ist die Determinante =0, sind sie linear abhängig. 2.3.3 Invertierbarkeit (Regularität)⇔ det , 0 2.1.3 Gauss-Algorithmus Satz erlaubte Operationen • Multiplikation einer Zeile mit einer Zahl 1. Alle Elementarmatrizen sind invertierbar. • Vertauschen von Zeilen (nicht aber Spalten) 2. Jede invertierbare Matrix A ∈ Rn×n ist ein Produkt von Elementarmatrizen. • Vielfaches einer Zeile zu einer anderen addieren 3. A ist invertierbar, wenn der Rang(A) = n (d.h. wenn A regulär ist ⇔ det(A) , 0). 2.2 Spezielle Matrizen Spiegelung SG an der Geraden y = ba x MSG = cos(2α) sin(2α) sin(2α) − cos(2α) ! α = arctan a b Merke Eine reguläre Matrix ist invertierbar. Eine nicht invertierbare Matrix heisst singulär. Drehung Dα um 0 mit Drehwinkel α MDα = cos(α) sin(α) − sin(α) cos(α) 2.3.4 Diagonalisierbarkeit ! diagonalisierbar Eine Matrix M ∈ Rn×n heisst diagonalisierbar, falls eine invertierbare Matrix T ∈ Rn×n existiert, so dass T−1 · M · T Diagonalform hat. Es gibt eine Basis aus EV (Eigenbasis). 2.3 Eigenschaften 2.3.1 Linearität Folgerungen: • Zwei Abbildungsmatrizen einer linearen Abbildung A : V → V sind immer konjugiert. lineare Abbildung Eine Abbildung A : Rn → Rm heisst linear, falls gilt: A(p + tv) = A(p) + tA(v) ∀p, v ∈ Rn , t ∈ R Es muss gelten A(0) = 0. • Eine reelle, symmetrische Matrix ist diagonalisierbar. 2 Satz Eine Matrix A ∈ Rn×n /Cn×n ist genau dann über R/C diagonalisierbar, wenn Dimensionsformel Es sei A eine (m × n)−Matrix und L0 der Lösungsraum des homogenen Gleichungssystems Ax = 0 (der Kern). Dann gilt 1. χA (t) n reelle Nullstellen hat dim L0 = n − rang A 2. Die Eigenräume Eλ (Menge der EV zu λ) haben als Dimension die Vielfachheit der Nullstelle λ Merke Abb. A : V → W mit (m × n)-Matrix Merke Quadrieren einer Diagonalmatrix quadriert die Diagonalmatrixeinträge: !2 ! a 0 a2 0 = 0 b 0 b2 dim V = n dim W = m dim(im A) = rang A ≤ m Bsp Abbildung A : R3 → R2 ⇒ dim A = 3 L0 = z − Achse (wird auf 0 abgebildet) Merke λ1 λ2 .. . λn λ a 1 11 λ a 2 21 = .. . λn an1 a 11 a 21 . . . an1 λ1 a12 λ2 a22 .. . λn an2 ... ... ... ... ... ... λ1 a1p λ2 a2p .. . λn anp a1p a2p .. . anp n = 3; dim L0 = 1 ⇒ dim Bild = 2 3 Determinante Satz Seien A, B ∈ Rn×n (Determinante nur für quadratische Matrizen definiert). 1. A ist singulär ⇔ det (A) = 0 2.4 Folgerungen 2. Es gilt det(AB) = det(A)det(B) ∀A, B. A symmetrisch (A = AT ) . • alle EW sind reell • es existiert eine Orthonormalbasis von EV 3.1 Berechnung A orthogonal (AT = A−1 ) . 3.1.1 Strategien • Abb. ist längentreu • die Spalten von A bilden eine orthonormale Basis in Rn • Überprüfe lineare Abhängigkeit, dann det=0 A, B schiefsymmetrisch (antisymmetrisch) . • Umformen zu Kästchenform, dann Produkt der Determinanten der Kästchen • Ai,j = −A j,i • 0 −a −b a 0 −c b c 0 • Umformen zu Dreiecksmatrix, dann Produkt der Diagonalelemente det(A) , 0 . • • • • • • • • Auflösen nach Zeilen/Spalten A ist invertierbar, also regulär Rang(A)=Anzahl Zeilen von A alle Vektoren der Matrix sind linear unabhängig (A−1 )−1 = A (AT )−1 = (A−1 )T Ax = b für jedes b eindeutig lösbar Ax = 0 hat nur triviale Lösung x = 0 3.1.2 Regeln A : (n × n)-Matrix det(−A) = (−1)n det(A) det(λA) = λn det(A) det(AB) = det(A)det(B) 2.5 Rang und Dimension det(A−1 ) = 1 det(A) det(A + B) , det(A) + det(B) Satz Ist eine (m × n)−Matrix gegeben, so spannen die m Zeilenvektoren einen Unterraum Z von Rn auf, den Zeilenraum von A, und die n Kolonnenvektoren einen Unterraum K von Rn , den Kolonnenraum. Z und K besitzen dieselbe Dimension, den Rang der Matrix A. det(A) = det(AT ) für A schiefsymmetrisch, mit n ungerade: det= 0 3 4 Norm Determinante = Produkt der Diagonalele- Dreiecksmatrizen mente euklidsche Norm ||x||2 := p x1 2 + x2 2 + x3 2 Maximumsnorm ||x||∞ :=max(|x1 |, |x2 |, |x3 |) Norm einer Funktion || f || :=max| f (x)| Kästchenform Hat die Matrix A Kästchenform mit quadratischen Teilmatrizen A1 und A2 : [A1 ] 0 A= so gilt 0 [A2 ] Lp -Norm ||x||2 := 4.1 Rechenregeln ||v|| ≥= 0 ||v|| = 0 ⇔ v = 0 ||a + b|| ≤ ||a|| + ||b|| ||λa|| = |λ| ||a|| x, y orthogonal: ||x + y||2 = ||x||2 + ||y||2 = ||x − y||2 ! a c b d ! 2 × 2-Matrix det 5 Vektorräume Beispiel für 3 × 3-Matrix c i +gdet x1 2 + x2 2 + x3 2 ! detA = detA1 · detA2 Auflösen nach Spalten + b− c+ a e f = det d− + g h i ! e f b adet −ddet h i h p p b e Körper Ein Körper ist eine Menge mit Addition und Multiplikation und zu k ∈ K ∃ − k zu k ∈ K mit k , 0 ∃ k−1 (k · k−1 = 1). ! c f = ad − bc Vektorraum Ein Vektorraum über einem Körper R (C) ist eine Menge V auf welcher eine Addition + : V×V → V und eine skalare Multiplikation · : R × V → V existieren und es gelten folgende Bedingungen: ∀v, w, u ∈ V, α ∈ R 1. v + w = w + v (u + v) + w = u + (v + w) 3.1.3 Verhalten der Determinante unter Zeilenoperationen: 2. Es existiert ein Element 0 ∈ V, so dass 0 + v = v Zeilen-/Spaltentausch: Die det ändert Vorzeichen. 3. Zu jedem v ∈ V existiert ein additiv Inverses ”−v”. v + (−v) = 0 Multiplikation einer Zeile mit λ: det multiplizert sich mit λ. Add. des Vielfachen einer Zeile zu einer anderen: det bleibt 4. α(x + y) = αx + αy, (α + β)x = αx + βx (αβ)x = α(βx), 1 · x = x 3.1.4 Spezielle Determinanten Vandermonde-Determinante V(λ1 , ..., λn ) := det 1 λ1 λ1 2 .. . λ1 n−1 1 λ2 λ2 2 .. . λ2 n−1 ... 1 λn λn 2 .. . λn n−1 Unterraum Eine Teilmenge U eines Vektorraums V heisst ein Unterraum (Untervektorraum UVR) von V, wenn U bezüglich der in V erklärten Operationen abgeschlossen ist, das heisst: Für beliebige x, y ∈ U, λ ∈ R müssen x + y und λx wieder in U liegen. 5.1 Die Basis eines Vektorraums Es gilt V(λ1 , ..., λn ) = Y Basis Ein linear unabhängiges Erzeugendensystem eines Vektorraums V heisst eine Basis von V. Ist (b1 , b2 , ..., bn ) eine Basis des Vektorraums V, so besitzt jeder Vektor x ∈ V eine Darstellung (λ j − λi ) i<j Bsp. V(λ1 , λ2 , λ3 ) = det 1 λ1 λ1 2 1 λ2 λ2 2 1 λ3 λ3 2 = (λ2 − λ1 )(λ3 − λ1 )(λ3 − λ2 ) Insbesondere ist genau dann V(λ1 , ..., λn ) = 0, wenn zwei λi übereinstimmen. x = ξ1 b1 + ξ2 b2 + ... + ξn bn = n X k=1 mit eindeutig bestimmten Koeffizienten ξk . 4 ξk bk Satz Alle Basen eines endlich erzeugten Vektorraums V bestehen aus derselben Anzahl Vektoren. Satz 1. Ein reguläres System A · x = c ist für jedes c ∈ R eindeutig lösbar. 2. Ein singuläres n × n -System ist nicht immer lösbar. Es hat für gewisse rechte Seiten c keine Lösung, für andere unendlich viele. Es gilt jedoch L0 , ∅, sogar dim(L0 ) ≥ 1. Satz Jede Menge linear unabhängiger Vektoren in V lassen sich zu einer Basis von V ergänzen. 6.1 Lösbarkeit von Systemen Merke Um einen linear unabhängigen Vektor v zu finden, suche senkrechten Vektor. Dazu schreibe die vorhandenen Vektoren als Zeilen in eine Matrix A. Das Gleichungssystem Av = 0 liefert v. 5.2 Reelle Vektorräume und lineare Abbildungen Bsp Für welche a, b, c, d ist ax3 + bx2 + cx + d Linearkombination von x3 , (x + 1)3 , (x + 2)3 ? reeller Vektorraum Rn mit komponentenweiser Addition und Streckung mit reellen Zahlen heisst reeller Vektorraum. ax3 + bx2 + cx + d hat dim= 4 ex3 + f (x + 1)3 + g(x + 2)3 hat dim= 3 a, b, c oder d ist also frei wählbar! Merke Eine Abbildung A : V → V ist regulär, wenn sie den Rang n hat, sonst singulär 7 Koordinatentransformationen 7.1 Transformationsformeln Satz Es seien V , W zwei endlich-dim. Vektorräume, A : V → W linear. Dann existieren zwei Basen v und w von V und W, so dass die Abbildungsmatrix Matv,w (A) folgende Form hat: v,w Mat (A) = | 1 0 .. . | 0 .. . {z ... 1 } r {z 0 ... .. . . . . | {z } k 0 Transformationsmatrix Tv,v = (tij ) ∈ Rn×n ist eine Transfor0 mationsmatrix. Es gilt also: v0 = v · Tv,v Merke In den Kolonnen von T stehen die alten Koordinaten der neuen Basisvektoren. } n=r+k Hier ist r = Rang(A), Merke Für eine zulässige Koordinatentransformation muss die Inverse T−1 zu T existieren. k =dim(Kern(A)) Merke Die Spur einer Matrix ist invariant unter Basistransformation. 6 Lineare Gleichungssysteme Merke Ein Punkt x = (x1 , ..., xn ) kann geschrieben werden als Kern Lösungsmenge des homogenen Gleichungssystems Ax = 0 L0 = Kern(A) = {v ∈ Rn | A(v) = 0}L0 ist ein UVR in Rn x= n X xi ei i=1 bzw. in neuen Koordinaten Satz Ein homohenes Gl.System hat nicht triviale Lösungen gdw r < n. Wobei r: Rang und n: Anzahl Zeilen x= n X k=1 5 x0k e0k Es folgt xi = n X tik x0k Merke : Alternative chp Berechnung 2 × 2-Matrix pA (λ) = λ2 − tr(A)λ + det(A) (1 ≤ i ≤ n) k=1 In Matrizenform 3 × 3-Matrix 0 x=T·x Satz 0 0 Transformationsformel für Matrizen Matv ,v (A) 0 v,v v,v Mat (A) · T 0 0 (Tv,v = T; Tv ,v = T−1 ) pA (λ) = λ3 − tr(A)λ2 + (det(A1 ) + det(A2 ) + det(A3 ))λ − det(A) = 0 Tv ,v · Merke • Jeder Vektor e , 0 ist EV zum EW 0. Ist kern A = {0}(d.h. A ist regulär), so ist 0 kein EW von A. 7.2 Orthonormale Basen • Die Summe der Diagonaleinträge (die Spur) jeder Matrix ist gleich der Summe der EW. • Wenn Eigenvektoren die Spalten von einer Matrix T sind, bildet T Vektoren in der neuen Basis auf Vektoren in der alten Basis ab. Merke Ist die neue Basis ebenfalls orthonormal, ist T orthogonal, es gilt T−1 = TT • Nullvektor ist nie ein EV, Null kann aber ein EW sein. • Bei einer Diagonalmatrix sind EW gerade die Diagonalelemente −→ det ist Produkt der EW konjugiert Zwei quadratische Matrizen M0 und M ∈ Rn×n heissen konjugiert, falls eine invertierbare Matrix T ∈ Rn×n existiert mit M0 = T−1 MT Satz A reell, symmetrisch, dann gilt: Zwei konjugierte Matrizen beschreiben die gleiche Abbildung mit einer anderen Basis. • A ist diagonalisierbar Bedingung für konjugiert: gleicher Rang • Es gibt eine orthonormale Eigenbasis zu A • Es gibt eine orthogonale Matrix T, sodass T−1 AT = TT AT diagonal ist. In der Diagonalen stehen die EW von A, Spalten von T sind normierte EV von A. 8 Eigenwertproblem • EV von versch. EW stehen senkrecht aufeinander Definitionen Eigenvektor, Eigenwert Ein Vektor e , 0, für den mit einem geeigneten λ ∈ R gilt Ae = λe, heisst ein Eigenvektor der Abbildung A; die betreffende Zahl λ ist der zugehörige Eigenwert von A. Satz Zu verschiedenen EW gehörende EV sind linear unabhängig. Eigenvektoren ändern durch die Multiplikation mit der zugehörigen Matrix ihre Wirkungslinie nicht. λ0 ist EW zu EV v Berechnung der EV zu EW: Satz über symmetrische Matrizen Ist A ∈ Rn×n eine symmetrische Matrix mit Eigenwerten λ1 , ..., λn , so gilt: ⇔ f (v) = λ0 · v ⇔ det( f − λ0 Id ) = 0 1. Alle EW sind reell. ⇒ (A − λ0 Id )v = 0 2. EV, die zu verschiedenen EW gehören, stehen aufeinander senkrecht. geometrische Vielfachheit Anzahl der frei wählbaren Parameter eines EV. 3. Es gibt eine orthonormale Basis (e01 , ..., e0n ) von Rn mit α − β 1 −1 β Beispiel: u = = α 0 + β 1 α 1 0 → geom.Vielfachheit 2 A0 = diag(λ1 , ..., λn ) Eigenraum Der Eigenraum Eλ zum EW λ enthält sämtliche EV zum EW λ. Eλ := {x ∈ V|Ax = λx} 4. Es gibt eine orthogonale Matrix T mit A = T · diag(λ1 , ..., λn ) · T0 6 3. Berechne Berechnung von Ak 2. T = (EV1 , EV2 , ...), D EW1 = 0 0 . . . EWn 3. Ak = (T−1 DT)k = T−1 Dk T 9 Systeme linearer Differentialgleichungen . 0 0 1 0 0 1 0 . . . . . .. 0 −a0 0 −a1 ... ... 0 0 .. . 0 ... ... 1 −an−1 = = x0 x 1 . . . x n−1 . . 0 y (t) y00 (t) .. . (n) y (t) = x1 (t) .. . xn−1 (t) −an−1 xn−1 − an−2 xn−2 − ... − a0 x −λ 0 = 0 −a0 Exponentialfunktion Unter der Exponentialfunktion für die 2 3 Matrix M ∈ Rn×n verstehen wir eM = 1 + M + M2! + M3! + ... .. 4. Zur Berechnung von etA müssen wir die EW von A bestimmen. Berechne χA (λ) = chp(λ) = det(A − λId ) 9.1 Exponentialfunktion für Matrizen λ1 Merke Falls A = 0 tλ 0 e 1 .. . tλ 0 e n = d dt x(t) 1. EW und EV berechnen x00 (t) x01 (t) .. . x0n−1 (t) 1 −λ 0 1 0 . . . . . 0 −a1 ... ... . . ... ... 0 0 . . . . . −λ 1 −an−1 − λ = Entwicklung nach letzter Zeile n a1 λ + a0 )(−1) 0 diagonal ist, dann gilt etA = λn (λn + an−1 λn−1 + ... + Alternative zur direkten Berechnung von etA 1. Bestimme die EW von A: λ1 − λn 2. Bestimme die zugehörigen EV: v1 − vn Merke Falls AN = 0 ist, dann gilt etA = 1 + tA + (tA)2 2! + ... + 3. Dann bilden die Vektoren eλ1 t v1 −eλn t vn die Lösungsmatrix. (tA)N−1 (N−1)! λ 0 e 1 −1 −1 .. eTDT = T T . λ n 0 e Allgemein: Falls A diagonalisierbar ist, d.h. es existiert T ∈ Rn×n mit −1 T−1 AT = D = diagonal , dann gilt: etA = et(TDT ) = TetD T−1 . Hauptsatz Sei A ∈ Rn×n eine quadratische Matrix, dann bilden die Spalten der Matrix etA eine Basis für den Lösungsraum der Diff.-gleichung x0 = Ax(t). 9.2 DGL Lösung Satz aus Analysis Die Lösungen der DGL y(n) + ... + a0 y = 0 sind von der Form y(t) = b1 eλ1 t + b2 eλ2 t + ... + bn eλn t , wobei die λi Nullstellen von χA (λ) sind. Falls ein λi zu hohe Multiplizität hat (grosse Vielfachheit), dann muss man noch die Ausdrücke der Form teλi t , t2 eλi t ,etc. dazunehmen. Wie bringe ich die DGL y(n) + an−1 y(n−1) + ... + a0 y in die Form d dt x(t) = Ax(t)? 1. Setze x0 (t) = y(t), x1 (t) = y0 (t), ..., xn−1 (t) = y(n−1) (t) 2. Fasse diese Koordinaten zu einem Vektor x(t) = x0 (t) x1 (t) .. . xn−1 (t) 7