Skript zur Vorlesung Analysis 2

Werbung

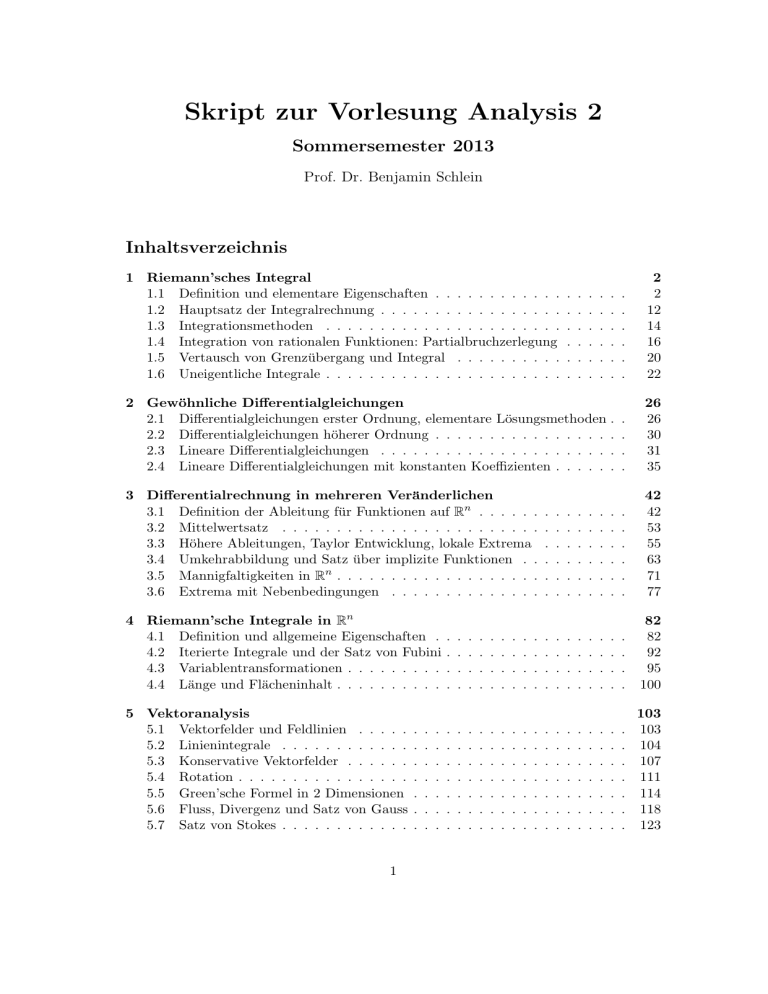

Skript zur Vorlesung Analysis 2

Sommersemester 2013

Prof. Dr. Benjamin Schlein

Inhaltsverzeichnis

1 Riemann’sches Integral

1.1 Definition und elementare Eigenschaften . . . . . . . . . . . .

1.2 Hauptsatz der Integralrechnung . . . . . . . . . . . . . . . . .

1.3 Integrationsmethoden . . . . . . . . . . . . . . . . . . . . . .

1.4 Integration von rationalen Funktionen: Partialbruchzerlegung

1.5 Vertausch von Grenzübergang und Integral . . . . . . . . . .

1.6 Uneigentliche Integrale . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

2

2

12

14

16

20

22

2 Gewöhnliche Differentialgleichungen

2.1 Differentialgleichungen erster Ordnung, elementare Lösungsmethoden .

2.2 Differentialgleichungen höherer Ordnung . . . . . . . . . . . . . . . . .

2.3 Lineare Differentialgleichungen . . . . . . . . . . . . . . . . . . . . . .

2.4 Lineare Differentialgleichungen mit konstanten Koeffizienten . . . . . .

.

.

.

.

26

26

30

31

35

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3 Differentialrechnung in mehreren Veränderlichen

3.1 Definition der Ableitung für Funktionen auf Rn . . . . . .

3.2 Mittelwertsatz . . . . . . . . . . . . . . . . . . . . . . . .

3.3 Höhere Ableitungen, Taylor Entwicklung, lokale Extrema

3.4 Umkehrabbildung und Satz über implizite Funktionen . .

3.5 Mannigfaltigkeiten in Rn . . . . . . . . . . . . . . . . . . .

3.6 Extrema mit Nebenbedingungen . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

42

42

53

55

63

71

77

4 Riemann’sche Integrale in Rn

4.1 Definition und allgemeine Eigenschaften .

4.2 Iterierte Integrale und der Satz von Fubini

4.3 Variablentransformationen . . . . . . . . .

4.4 Länge und Flächeninhalt . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

82

82

92

95

100

.

.

.

.

.

.

.

103

103

104

107

111

114

118

123

5 Vektoranalysis

5.1 Vektorfelder und Feldlinien . . . . .

5.2 Linienintegrale . . . . . . . . . . . .

5.3 Konservative Vektorfelder . . . . . .

5.4 Rotation . . . . . . . . . . . . . . . .

5.5 Green’sche Formel in 2 Dimensionen

5.6 Fluss, Divergenz und Satz von Gauss

5.7 Satz von Stokes . . . . . . . . . . . .

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1.1

Riemann’sches Integral

Definition und elementare Eigenschaften

Ziel: für eine Funktion f : [a; b] → [0; ∞) möchten wir den Flächeninhalt von {(x, y) :

a ≤ x ≤ b, 0 ≤ y ≤ f (x)} berechnen (und definieren).

Intuitive Konstruktion. Wir wählen Punkte x0 , x1 , . . . , xn ∈ R, mit a = x0 < x1 <

· · · < xn−1 < xn = b. Das zerlegt [a; b] in n Intervalle [x0 ; x1 ], [x1 ; x2 ], . . . , [xn−1 ; xn ].

Für jede j = 1, . . . , n, wählen wir einen Repräsentanten ξj ∈ [xj−1 ; xj ]. Die Fläche von

{(x, y) : xj−1 ≤ x ≤ xj , 0 ≤ y ≤ f (ξj )} ist ungefähr f (ξj )(xj −xj−1 ). Die gesamte Fläche

von {(x, y) : a ≤ x ≤ b, 0 ≤ y ≤ f (x)} ist ungefähr aus der Riemann’sche Summe

n

X

f (ξj )(xj − xj−1 )

j=1

gegeben. Die Hoffnung ist dann, dass die Riemann’sche Summe konvergiert, als die

Teilung unendlich fein wird. Das Integral ist dann als der Grenzwert der Riemann’sche

Summe definiert.

Genaue Konstruktion. Wir betrachten ein kompaktes Intervall I = [a; b] und eine beschränkte R-wertige Funktion f auf I. Eine Teilung von [a; b] ist eine endliche Teilmenge

T = {x0 < x1 < · · · < xn−1 < xn } von [a; b], mit x0 = a und xn = b. Zu einer gegebenen

Teilung T , definieren wir die Intervalle Ij = [xj−1 , xj ], für j = 1, 2, . . . , n. Es gilt

I = I1 ∪ I2 ∪ · · · ∪ In

Die Intervalle Ij sind fast disjunkt, mit

Ij ∩ Ij+1 = {xj } und Ii ∩ Ij = ∅, falls i 6= j, j ± 1

Sei T eine Teilung von [a; b]. Eine zu T entsprechende Familie von Repräsentanten ist

ein n-Tupel ξ = (ξ1 , ξ2 , . . . , ξn } mit ξj ∈ Ij für alle j = 1, . . . , n. Für gegebene Teilung

T und Familie von Representanten ξ definieren wir die Riemann’sche Summe

S(T, ξ) =

n

X

f (ξj )(xj − xj−1 )

j=1

wobei (xj − xj−1 ) = |Ij | die Länge von Ij ist. Wir definieren nun die obere Riemann’sche

Summe zur Teilung T :

S(T ) = sup S(T, ξ) =

ξ

n

X

sup{f (x) : x ∈ Ij } |Ij |

j=1

Die untere Riemann’sche Summe zur Teilung T ist

S(T ) = inf S(T, ξ) =

ξ

n

X

inf{f (x) : x ∈ Ij }|Ij |

j=1

Offenbar gilt S(T ) ≥ S(T ) für alle Teilungen T von [a; b]. Intuitiv sollte es gelten S(T ) ≤

Flächeninhalt ≤ S(T ).

Wir sagen, eine Teilung T 0 ist eine Verfeinerung von T falls T 0 ⊃ T (eine feinere

Teilung ist eine grössere Menge).

2

Lemma 1.1. Wir haben die folgenden Eigenschaften:

a) Sei T 0 ⊃ T eine Verfeinerung von T . Dann gilt S(T 0 ) ≤ S(T ) und S(T 0 ) ≥ S(T ).

b) Es gilt

sup S(T ) ≤ inf S(T )

T

T

Beweis. a) Es genügt, den Fall |T 0 | = |T |+1 zu betrachten. Wir haben also T 0 = T ∪{x̂},

für ein x̂ ∈ [a; b]. Ist T = {x0 < x1 < · · · < xn−1 < xn }, dann gibt es ein k ∈ {1, 2, . . . , n}

mit xk−1 < x̂ < xk . Also T 0 = {x0 < x1 < · · · < xk−1 < x̂ < xk < · · · < xn }. Es gilt

0

0

Ij0 = Ij für 1 ≤ j ≤ k − 1, Ij+1

= Ij für k + 1 ≤ j ≤ n, und Ik = Ik0 ∪ Ik+1

. Da

sup f ≤ sup f

sup f ≤ sup f,

Ik0

0

Ik+1

Ik

Ik

finden wir

0

0

|Ik0 | sup f + |Ik+1

| sup f ≤ (|Ik0 | + |Ik+1

|) sup f = |Ik | sup f

Ik0

0

Ik+1

Ik

Ik

Also

S(T ) = |I1 | sup f + · · · + |Ik | sup f + · · · + |In | sup f

I1

≥

|I10 |

Ik

sup f + · · · +

I10

|Ik0 |

In

sup f +

Ik0

0

|

|Ik+1

sup f + · · · + |In | sup f

0

Ik+1

In

= S(T 0 )

Ähnlich kann man zeigen, dass S(T ) ≤ S(T 0 ).

b) Seien T1 , T2 zwei Teilungen von [a; b]. Wir setzen T3 = T1 ∪ T2 . T3 ist eine Verfeinerung von T1 und von T2 . Aus a), und weil offenbar S(T ) ≤ S(T ) für jede Teilung T ,

bekommen wir

S(T1 ) ≤ S(T3 ) ≤ S(T3 ) ≤ S(T2 )

Also S(T1 ) ≤ S(T2 ) für jede zwei Teilungen T1 , T2 . Das impliziert, dass supT S(T ) ≤

inf T S(T ).

Definition 1.2. Die reelwertige beschränkte Funktion f auf [a; b] heisst Riemann integrierbar, falls

sup S(T ) = inf S(T ) .

T

T

In diesem Fall definieren wir das (Riemann’sche) Integral von f auf [a; b] durch

Z b

f (x)dx := sup S(T ) = inf S(T )

a

T

T

Rb

Rb

Bemerkungen. Wir benutzen auch die Notation a f dx oder einfach a f für das Integral

von f auf [a; b]. Das Differntial dx erinnert an der ∆x = xj − xj−1 in der Riemann’schen

Summe; es hat aber keine Bedeutung im Integral. In Analysis 3 werden wir sehen, dass

eine andere alternative Konstruktion des Integrals existiert, das Lebesgue-Integral. Der

Hauptvorteil des Lebesgue-Integrals ist, dass es für allgemeinere Funktionen existiert

(und dass es bessere Eigenschaften bezüglich Vertausch von Grenzwert und Integral hat).

Wann das Riemann Integral existiert, stimmt es mit dem Lebesgue Integral überein.

3

Proposition 1.3.

a) f ist genau dann integrierbar, wenn inf T S(T ) − S(T ) = 0.

b) Sei Tn eine Familie von Teilungen mit S(Tn ) − S(Tn ) → 0, als n → ∞. Dann ist

f integrierbar und

Z b

Z b

f (x)dx, und S(Tn ) →

f (x)dx

S(Tn ) →

a

a

Weiter, falls ξ (n) eine beliebige Familie von Representanten zur Teilung Tn ist,

haben wir

Z b

(n)

f (x)dx

S(Tn , ξ ) →

a

Bemerkung: Da S(T

) ≥ S(T ) für alle T , die Bedingung inf S(T ) − S(T ) = 0 ist mit

inf S(T ) − S(T ) ≤ 0 äquivalent.

Beweis. a) Nehmen wir an, die Bedingung inf S(T ) − S(T ) = 0 ist erfüllt. Dann

0 = inf S(T ) − S(T ) ≥ inf S(T ) − sup S(T )

und sup S(T ) ≥ inf S(T ). Da die umgekehrte Ungleichung immer gilt, ist sup S(T ) =

inf S(T ). Das bedeutet, dass f integrierbar ist.

Nehmen wir nun an, f ist integrierbar. Sei nun ε > 0, T1 , T2 zwei Teilungen mit

S(T1 ) − inf S(T ) ≤ ε/2

T

und

sup S(T ) − S(T2 ) ≤ ε/2

T

Da f integriebar ist, ist inf S = sup S. Also

S(T1 ) − S(T2 ) ≤ ε

Sei nun T3 = T1 ∪ T2 . Da T3 eine Verfeinerung von T1 , T2 ist, gilt S(T3 ) ≤ S(T1 ) und

S(T3 ) ≥ S(T2 ). Deswegen

S(T3 ) − S(T3 ) ≤ S(T1 ) − S(T2 ) ≤ ε

Da ε > 0 beliebig, gilt

inf S(T ) − S(T ) ≤ 0

T

b) Aus S(Tn ) − S(Tn ) → 0 folgt, dass inf(S(T ) − S(T )) = 0. Aus a) folgt, dass f

integrierbar ist. Da

Z b

S(Tn ) ≤

f (x)dx ≤ S(Tn )

a

wir finden, dass S(Tn ) →

Rb

a

f (x)dx und auch S(Tn ) →

Rb

a

S(Tn ) ≤ S(Tn , ξ (n) ) ≤ S(Tn )

muss auch S(Tn , ξ (n) ) →

Rb

a

f (x)dx.

4

f (x)dx. Weiter, da

Es folgt aus der Proposition, dass um Integrale zu berechnen (und Integrierbarkeit zu

prüfen) es genügt, eine spezielle Folge von Teilungen zu betrachten, nämlich eine Folge

mit der Eigenschaft S(Tn ) − S(Tn ) → 0. Ist die Funktion integrierbar, so konvergieren

obere und untere Summe gegen das Integral von f , für beliebige Folgen von Teilungen

Tn , falls die Länge jedes Intervalls von Tn gegen Null strebt. Für eine Teilung T von [a; b]

setzen wir kT k = maxj=1,...,n |xj −xj−1 |. D.h. kT k ist die Länge des grössten Intervalls in

der Teilung. Für eine beliebige Menge J und eine R-wertige Funktion f auf J definieren

wir auch die Oszillation von f auf J durch

σ(f, J) = sup{f (x) : x ∈ J} − inf{f (x) : x ∈ J} = sup{|f (x) − f (y)| : x, y ∈ J}

Dann ist, für eine beliebige Teilung T ,

S(T ) − S(T ) =

n

X

σ(f, Ij )|Ij |

j=1

Proposition 1.4. Sei f auf [a; b] integrierbar, und Tn eine Folge von Teilungen, mit

kTn k → 0. Dann gilt

Z

a

b

f dx = lim S(Tn ) = lim S(Tn ) = lim S(Tn , ξ (n) )

n→∞

n→∞

n→∞

wobei, für alle n ∈ N, ξ (n) eine Familie von Repräsentanten zur Teilung Tn ist.

Beweis. Es genügt, die folgende Tatsache zu überprüfen: Ist T eine Teilung von [a; b],

mit δ = minj=1,...,n |Ij |. Dann gilt

S(T 0 ) − S(T 0 ) ≤ 3 S(T ) − S(T )

(1)

für alle Teilungen T 0 von [a; b] mit kT 0 k = max |Ij | < δ. In der Tat, nehmen wir an (1)

ist korrekt. Dann können wir wie folgt argumentieren. Da f integrierbar ist, finden wir,

für alle ε > 0, eine Teilung Te mit

S(Te) − S(Te) <

ε

3

Wir setzen dann δ = min |Iej |, wobei Iej die zur Teilung Te entsprechenden Intervalle sind.

Da kTn k → 0, für n → ∞, finden wir N mit kTn k ≤ δ, für alle n > N . Gleichung (1)

impliziert dann, dass

S(Tn ) − S(Tn ) < ε

für alle n > N . Also S(Tn ) − S(Tn ) → 0, für n → ∞. Proposition 1.3 zeigt dann die

Behauptung.

Es bleibt (1) zu zeigen. Wir bezeichnen mit Ij und Ij0 die zu T und zu T 0 entsprechenden Intervalle. Es gilt maxj |Ij0 | < mink |Ik |. Deswegen schneidet jedes Intervall Ij0

höchstens zwei I-Intervalle. Wir definieren εij = 1 falls Ii Ij0 schneidet(für jedes j gibt

es höchstens zwei Indizien i, mit εij 6= 0). Wir bemerken, dass

X

σ(f, Ij0 ) ≤

εij σ(f, Ii )

i

5

Deswegen finden wir

!

S(T 0 ) − S(T 0 ) =

X

σ(f, Ij0 )|Ij0 | ≤

j

X X

j

εij σ(f, Ii ) |Ij0 |

i

X

X

X

=

σ(f, Ii )

εij |Ij0 | ≤ 3

σ(f, Ii )|Ii | = 3(S(T ) − S(T ))

i

j

i

P

weil j εij |Ij0 | die gesamte Länge aller I 0 -Intervalle ist, die Ii schneiden, was höchstens

3|Ii | sein kann (weil die I 0 -Intevalle alle kürzer als Ii sind).

Um die letzte Proposition anzuwenden, und Integrale mit Hilfe beliebige Folge von

Teilungen Tn , mit kTn k → 0 zu berechnen, müssen wir zunächst wissen, ob f auf [a; b]

integrierbar ist. Die folgende Proposition gibt eine erste wichtige hinreichende Bedingung

für Integrierbarkeit.

Proposition 1.5. Ist f stetig auf [a; b], so ist f integrierbar auf [a; b].

Beweis. Eine stetige Funktion auf [a; b] ist gleichmässig stetig. Sei ε > 0 fest. Dann

existiert δ > 0 mit

ε

|x − y| ≤ δ ⇒ |f (x) − f (y)| ≤

b−a

Sei nun T = {x0 < x1 < · · · < xn } eine Teilung mit |xj+1 − xj | < δ für alle 1 ≤ j ≤ n.

Dann gilt σ(f, Ij ) ≤ ε/(b − a) für alle j = 1, . . . , n und also

S(T ) − S(T ) =

n

X

j=1

n

ε X

σ(f, Ij )|Ij | ≤

|Ij | = ε

b−a

j=1

Das impliziert, dass

inf S(T ) − S(T ) ≤ 0

und damit, dass f integrierbar ist.

Beispiel: Die Funktion f (x) = 1/x ist stetig auf [1; a]. Wir möchten das Integral

Z a

1

dx

1 x

berechnen. Wir wählen die Teilung Tn = {aj/n : 0 ≤ j ≤ n}. Dann Ij = [a(j−1)/n , aj/n ],

j = 1, . . . , n. Da 1/x monoton fallend ist, gilt

sup{f (x) : x ∈ Ij } = a−(j−1)/n

Also

S(Tn ) =

n

X

−j/n

a

j/n

(a

(j−1)/n

−a

n

X

)=

(1 − a−1/n ) = n(1 − a−1/n )

j=1

und

S(Tn ) =

inf{f (x) : x ∈ Ij } = a−j/n

und

j=1

n

X

a−(j−1)/n aj/n − a(j−1)/n = a1/n S(Tn )

j=1

6

Sei f (t) = at . Dann gilt

S(Tn ) = n(1 − a−1/n ) =

f (0) − f (−1/n)

→ f 0 (0) = log a

1/n

für n → ∞. Da S(Tn ) = a1/n S(Tn ) → log a, folgt, dass

Z a

1

dx = log a

1 x

Beispiel: Sei

f (x) =

falls x ∈ Q

falls x ∈ R\Q

1

0

und [a; b] ⊂ R ein beliebiges Intervall. Es gilt σ(f, I) = 1 für jedes Intervall I ⊂ R. Also

gilt, für eine beliebige Teilung T von [a; b],

S(T ) − S(T ) =

n

X

σ(f, Ij )|Ij | =

j=1

n

X

|Ij | = (b − a)

j=1

Die Funktion f ist deswegen nicht integrierbar.

Proposition 1.6. Sei a < b < c, und f eine beschränkte Funktion auf [a; c]. Dann ist

f integrierbar auf [a; c] g.d.w. f integrierbar auf [a; b] und auf [b; c] ist. In diesem Fall

gilt

Z b

Z c

Z c

f dx =

f dx +

f dx

a

a

b

Beweis. Sei f integrierbar auf [a; b] und auf [b; c]. Wir finden Folgen T1,n und T2,n ,

Teilungen von [a; b] und, bzw. von [b; c], mit

S [a;b] (T1,n ) − S [a;b] (T1,n ) → 0

und

S [b;c] (T2,n ) − S [b;c] (T2,n ) → 0

für n → ∞. Wir setzen T3,n = T1,n ∪ T2,n . Tn ist dann eine Folge von Teilungen von [a; c]

mit

S [a;c] (T3,n ) = S [a;b] (T1,n ) + S [b;c] (T2,n )

S [a;c] (T3,n ) = S [a;b] (T1,n ) + S [b;c] (T2,n )

für alle n. Das impliziert, dass f auf [a; c] integrierbar ist, weil

S [a;c] (T3,n ) − S [a;c] (T3,n ) = S [a;b] (T1,n ) − S [a;b] (T1,n ) + S [b;c] (T2,n ) − S [b;c] (T2,n ) → 0

für n → ∞, und, dass

Z c

f dx = lim S [a;c] (T3,n ) = lim S [a;b] (T1,n ) + lim S [b;c] (T2,n )

a

n→∞

n→∞

n→∞

Übung: Zeige, dass f integrierbar auf [a; c] impliziert, dass f integrierbar auf [a; b] und

auf [b; c] ist.

7

Als Anwendung der letzten Proposition zeigen wir, dass jede auf [a; b] beschränkte

Funktion, mit endlich vielen Unstetigkeitstellen, integrierbar ist.

Proposition 1.7. Sei f auf [a; b] beschränkt, mit endlich vielen Unstetigkeitstellen.

Dann ist f auf [a; b] integrierbar.

Beweis. Seien y1 < y2 < · · · < ym−1 die Unstetigkeitstellen von f in (a; b). Wir setzten

auch y0 = a und ym = b. Ist f integrierbar auf [yj−1 ; yj ] für alle j = 1, . . . m, so ist f

integrierbar auf [a; b] (aus Proposition 1.6). Es genügt also zu zeigen, dass f stetig auf

(a; b) und beschränkt auf [a; b] impliziert, dass f integrierbar auf [a; b] ist. Sei dazu M > 0

s.d. |f (x)| ≤ M auf [a; b]. Für ein beliebiges ε > 0, ist f auf Iε := [a+(ε/8M ); b−(ε/8M )]

integrierbar, weil f stetig auf diesem Intervall ist. Es existiert also eine Teilung T von

Iε mit

S Iε (T ) − S Iε (T ) ≤ ε/2

Wir betrachten nun die Teilung T 0 = T ∪ {a; b} von [a; b]. Es gilt

S [a;b] (T 0 ) − S [a;b] (T 0 )

= (σ(f, [a; a + (ε/8M )]) + σ(f, [b − (ε/8M ); b]))

ε

+ S Iε (T ) − S Iε (T ) ≤ ε

8M

weil σ(J; f ) ≤ 2M für jede Menge J ⊂ [a; b]. Da ε > 0 beliebig ist, ist f auf [a; b]

integrierbar.

Bemerkung: Die Bedingung für Integrierbarkeit in der letzten Proposition ist hinreichend, aber nicht notwendig. Eine Menge N ⊂ R heisst eine Lebesgue Nullmenge, falls

für alle ε > 0 eine endlich oder abzählbare Familie {Ji } von offenen Intervallen existiert,

mit

[

X

N⊂

Ji und

|Ji | ≤ ε

i

i

Jede abzählbare Menge ist offenbar eine Lebesgue Nullmenge, aber es existieren auch

überabzählbare Nullmengen. Tatsache: Eine beschränkte Funktion f auf [a; b] ist genau

dann auf [a; b] integrierbar, falls {x ∈ [a; b]; f unstetig an der Stelle x} eine Lebesgue

Nullmenge ist (Beweis: Analysis 3).

Wir untersuchen nun elementare Eigenschaften vom Integral.

Proposition 1.8. Seien f, g integrierbar über [a; b].

a) Für alle α, β ∈ R ist αf + βg integrierbar auf [a; b] und

Z b

Z b

Z b

(αf + βg) dx = α

f dx + β

gdx

a

a

(Das Integral ist linear).

b) Gilt f (x) ≥ g(x) für alle x ∈ [a; b], so ist

Z b

Z b

f dx ≥

gdx

a

a

(Das Integral ist monoton).

8

a

c) |f | ist integrierbar auf [a; b] und

Z b

Z b

|f |dx

f dx ≤

a

a

(Dreiecksungleichung für Integrale). Es folgt, dass max(f, g), min(f, g) integrierbar

auf [a; b] sind.

Beweis: c) Aus der gewöhnlichen Dreiecksungleichung gilt

||f (x)| − |f (y)|| ≤ |f (x) − f (y)|

D.h. die Oszillationen von |f | auf jedem Intervall J ⊂ R sind durch die Oszillationen

von f beschränkt:

σ(|f |, J) ≤ σ(f, J) for all J ⊂ R

Also

S(|f |, T ) − S(|f |, T ) ≤ S(f, T ) − S(f, T )

für alle Teilungen T . Das impliziert, dass

inf S(|f |, T ) − S(|f |, T ) ≤ inf S(f, T ) − S(f, T ) = 0

T

T

und deswegen, dass |f | integrierbar ist. Die Dreiecksungleichung für Integrale folgt aus

−|f (x)| ≤ f (x) ≤ |f (x)| und aus der Monotonie des Integrals (Teil b), Beweis unten). Die

Integrierbarkeit von max(f, g) und min(f, g) folgt aus der Bemerkung, dass max(f, g) =

(f + g)/2 + |f − g|/2 und min(f, g) = (f + g)/2 − |f − g|/2, aus der Linearität (Teil a),

Beweis unten), und aus der Integrierbarkeit des Absolutbetrags.

a) Es genügt zu zeigen, dass

Z

Z

Z

i) (f + g)dx = f dx + gdx

Z

Z

ii) (αf )dx = α f dx für alle α > 0

Z

Z

iii) (−f )dx = − f dx

Wir zeigen zunächst i). Für eine beliebige Teilung T von [a; b] gilt

sup{f (x) + g(x) : x ∈ Ij } ≤ sup{f (x) : x ∈ Ij } + sup{g(x) : x ∈ Ij }

Also

S(f + g, T ) ≤ S(f, T ) + S(g, T )

Ähnlicherweise

S(f + g, T ) ≥ S(f, T ) + S(g, T )

Seien nun Tnf und Tng Folgen von Teilungen mit der Eigenschaften

S(f, Tnf ) − S(f, Tnf ) → 0

9

und

S(g, Tng ) − S(g, Tng ) → 0

für n → ∞. Sei nun Tn = Tnf ∪ Tng . Dann gilt (da Tn eine Verfeinerung von Tnf ist)

S(f, Tn ) − S(f, Tn ) ≤ S(f, Tnf ) − S(f, Tnf )

und also S(f, Tn ) − S(f, Tn ) → 0, für n → ∞. Ähnlicherweise S(g, Tn ) − S(g, Tn ) → 0,

für n → ∞. Damit

S(f + g, Tn ) − S(f + g, Tn ) ≤ S(f, Tn ) + S(g, Tn ) − S(f, Tn ) − S(g, Tn )

= S(f, Tn ) − S(f, Tn ) + S(g, Tn ) − S(g, Tn ) → 0

Das zeigt, dass f + g integrierbar ist. Es gilt

Z b

S(f, Tn ) + S(g, Tn ) ≤ S(f + g, Tn ) ≤

(f + g)dxS(f + g, Tn ) ≤ S(f, Tn ) + S(g, Tn )

a

Da

b

Z b

f dx +

gdx und

a

a

Z b

Z b

S(f, Tn ) + S(g, Tn ) →

f dx +

gdx

Z

S(f, Tn ) + S(g, Tn ) →

a

a

für n → ∞, folgt, dass

Z

b

Z

b

(f + g)dx =

a

Z

f dx +

a

b

gdx

a

Wir beweisen nun ii). Offenbar gilt

S(αf, T ) = αS(f, T ),

und

S(αf, T ) = αS(f, T )

für jede Teilung T . Ist Tn eine Folge von Teilungen, mit S(f, Tn ) − S(f, Tn ) → 0, so gilt

auch

S(αf, Tn ) − S(αf, Tn ) = α S(f, Tn ) − S(f, Tn ) → 0

Damit ist αf integrierbar, und

Z b

Z b

αf dx = lim S(αf, Tn ) = α lim S(f, Tn ) = α

f dx

a

n→∞

n→∞

a

Um iii) zu zeigen, bemerken wir, dass

S(−f, T ) = −S(f, T )

und S(−f, T ) = −S(f, T )

für jede Teilung T , weil sup(−f ) = − inf f . Ist Tn eine Teilung mit S(f, Tn )−S(f, Tn ) →

0, so gilt auch

S(−f, Tn ) − S(−f, Tn ) = −S(f, Tn ) + S(f, Tn ) → 0

10

für n → ∞. Damit ist −f integrierbar, und

Z b

Z b

(−f )dx = lim S(−f, Tn ) = − lim S(f, Tn ) = −

f dx

n→∞

a

n→∞

a

Damit ist Teil a) bewiesen.

b) Ist f ≥ g, so ist f − g ≥ 0 auf [a; b]. Da aus a) f − g integrierbar ist, muss

Z b

(f − g)dx ≥ 0

a

(weil jede Riemannsche Summe positiv ist). Wieder aus a) folgt, dass

Z b

Z b

Z b

Z b

Z b

gdx

f dx ≥

(f − g)dx ≥ 0 ⇒

gdx =

f dx −

a

a

a

a

a

Damit ist auch Teil b) gezeigt.

Die elementare Eigenschaften des Integrals aus der letzten Proposition haben einige

einfache aber wichtige Folgerungen.

Satz 1.9.

a) Konstante Funktionen sind integrierbar,

Z b

cdx = c(b − a)

a

b) Sei f integrierbar auf [a; b], und

m = inf{f (x) : x ∈ [a; b]},

M = sup{f (x) : x ∈ [a; b]}

Dann gilt

b

Z

f dx ≤ M (b − a)

m(b − a) ≤

a

c) (Mittelwertsatz für Integrale). Ist f stetig auf [a; b], dann existiert ξ ∈ (a; b) mit

Z b

f dx = f (ξ)(b − a)

a

Beweis. a) f (x) = c impliziert, dass S(f, T ) = S(f, T ) = c(b − a) für alle Teilungen T .

Damit ist

Z b

cdx = c(b − a)

a

b) Es gilt m ≤ f (x) ≤ M für alle x ∈ [a; b]. Die Monotonie des Integrals impliziert, dass

Z b

Z b

Z b

m(b − a) =

mdx ≤

f dx ≤

M dx = M (b − a)

a

a

a

c) Aus b) folgt, dass

m≤

1

b−a

Z

b

f dx ≤ M

a

11

Aus dem Satz von Maximum folgt, dass x0 , x1 ∈ [a; b] mit f (x0 ) = m und f (x1 ) = M

existiert. Aus dem Zwischenwertsatz, existiert ξ zwischen x0 und x1 mit

f (ξ) =

1.2

1

b−a

b

Z

f dx

a

Hauptsatz der Integralrechnung

Satz 1.10 (Hauptsatz). Sei f stetig auf [a; b],

Z x

F (x) =

f (t)dt

a

für x ∈ (a; b].

a) F ist differenzierbar auf (a; b) mit F 0 (x) = f (x).

b) Sei G stetig auf [a; b], differenzierbar auf (a; b) mit G0 (x) = f (x). Dann gilt

F (x) = G(x) − G(a)

für alle a < x ≤ b.

Beweis. a) Sei x0 ∈ (a; b) fest. Wir berechnen F 0 (x0 ). Sei zunächst h > 0. Dann

x0 +h

Z

F (x0 + h) =

Z

f dt =

a

x0

Z

x0 +h

f dt +

a

f dt = F (x0 ) + f (ξ)h

x0

für ein ξ ∈ (x0 ; x0 + h). Also

F (x0 + h) − F (x0 )

= f (ξ) → f (x0 )

h

für h ↓ 0, aus Stetigkeit von f . Für h < 0 haben wir ähnlich

Z x0

F (x0 + h) − F (x0 )

F (x0 ) − F (x0 − |h|)

1

=

=

f dt = f (ξ)

h

|h|

|h| x0 −|h|

für ein x0 − |h| < ξ < x0 . Die Stetigkeit von f zeigt, dass

lim

h↑0

F (x0 + h) − F (x0 )

= f (x0 )

h

Damit ist F differenzierbar an der Stelle x0 , mit F 0 (x0 ) = f (x0 ).

b) Es gilt G0 (x) = f (x) = F 0 (x). Also (F − G)0 = 0, und deswegen, G(x) = F (x) + c

für eine Konstante c ∈ R, und alle x ∈ (a; b). Da limx↓a F (x) = 0, und (aus Stetigkeit

von G), limx↓a G(x) = G(a), gilt c = G(a). Damit ist F (x) = G(x) − G(a), für alle

x ∈ (a; b).

12

Man nennt eine Funktion G, stetig auf [a; b], differenzierbar auf (a; b), mit G0 (x) =

f (x) für alle x ∈ (a; b), eine Stammfunktion von f auf [a; b]. Ist G eine Stammfunktion

einer stetigen Funktion f , so gilt

b

Z

f dt = G(b) − G(a)

a

Beachte: Nicht stetige integrierbare Funktionen brauchen keine Stammfunktion zu haben

(z.B. hat die integrierbare Funktion f , definiert durch f (x) = 0 für x < 0 und f (x) = 1

für x ≥ 0, keine Stammfunktion auf [−1; 1]). Anderseits impliziert die Existenz einer

Stammfunktion von f nicht, dass f integrierbar ist.

Bemerkung: Ist G eine Stammfunktion von f , dann ist auch G + c, für irgendeine Konstante c ∈ R, eine Stammfunktion von f . Alle Stammfunktionen von f haben diese Form.

Wir definieren das unbestimmtes Integral von f , als die Familie aller Stammfunktionen

von f :

Z

f dx = G(x) + c

falls G0 (x) = f (x). Manchmal ist es wichtig, das Intervall zu schreiben, wo die Relation

Rb

G0 = f gilt. Zusammenfassend: Das bestimmte Integral a Rf dx ist eine Zahl (Grenzwert

von Riemann’schen Summen). Das unbestimmte Integral f dx ist dagegen die Familie

aller Stammfunktionen von f . Gemäss Hauptsatz ist die Berechnung des unbestimmten

Integrals von grosser Hilfe in der Berechnung des bestimmten Integrals.

Notation: Für b < a setzen wir

Z b

Z a

f dx := −

f dx

a

b

Für b = a, dagegen,

Z

a

f dx := 0

a

Damit gilt

Z

b

f dx = G(b) − G(a)

a

falls f stetig ist, und falls G eine Stammfunktion von f ist, unabhängig von der Ordnung

von a, b.

Die Berechnung von unbestimmten Integralen ist nicht immer einfach. Unbestimmte

Integrale sind nicht immer durch die bekannten Elementarfunktionen darstellbar (die

Ableitung jeder durch Elementarfunktionen darstellbaren Funktion ist dagegen wieder

durch elementare Funktionen darstellbar). Ein wichtiges Beispiel einer Funktion, deren

2

Stammfunktion (die “error-function”) nicht elementar darstellbar ist, ist f (x) = e−x .

Hier sind dagegen einige einfache Beispiele, für welche die Stammfunktion elementar

13

darstellbar ist.

•

•

•

•

•

•

•

•

•

•

1.3

Z

d α

xα+1

α−1

x = αx

⇒

xα dx =

+ c,

dx

α+1

für alle α 6= −1 und, falls α < 0, für alle x 6= 0

Z

d

1

1

log |x| =

⇒

dx = log |x| + c, für alle x 6= 0

dx

x

x

Z

d λx

1

e = λeλx ⇒

eλx dx = eλx + c

dx

λ

Z

d

sin x = cos x ⇒

cos x dx = sin x + c

dx

Z

d

cos x = − sin x ⇒

sin xdx = − cos x + c

dx

Z

d

sinh x = cosh x ⇒

cosh x dx = sinh x + c

dx

Z

d

cosh x = sinh x ⇒

sinh x dx = cosh x + c

dx

Z

d

1

1

arctan x =

⇒

dx = arctan x + c

2

2

dx

1+x

x +1

Z

1

d

1

√

⇒

dx = arcsin x + c, für x ∈ (−1; 1)

arcsin x = √

2

dx

1 − x2

1

−

x

Z

d

1

1

√

arcsinh x = √

⇒

dx = arcsinh x + c

2

dx

1+x

1 + x2

Integrationsmethoden

Es gibt zwei allgemeine Bemerkungen, die bei der Berechnung von Integralen nützlich

sein können; die Substitutionsformel und partielle Integration.

Satz 1.11 (Substitutionsformel). Sei f stetig und g stetig differenzierbar auf geeigneten

Intervallen. Ist

Z

f (x)dx = F (x) + c

so ist

Z

f (g(t))g 0 (t)dt = F (g(t)) + c

(2)

Mit anderen Worten, falls f stetig auf [g(a); g(b)] ist, und g stetig differenzierbar auf

[a; b], haben wir

Z b

Z g(b)

0

f (g(x))g (x)dx =

f (t)dt

a

g(a)

(Es ist hier nicht nötig, dass g(b) > g(a)).

Beweis. Da F eine Stammfunktion von f ist, gilt F 0 (x) = f (x). Aus der Kettenregel

folgt, dass

d

F (g(x)) = f (g(x))g 0 (x)

dx

14

D.h., F (g(x)) ist eine Stammfunktion von f (g(x))g 0 (x). Also

Z b

Z g(b)

f (g(x))g 0 (x)dx = F (g(b)) − F (g(a)) =

f (t)dt

a

g(a)

Man kann den Faktor g 0 (t) in der Substitutionsformel (2) als die Transformation des

Differentials dt betrachten. Sei F eine Stammfunktion für f . Um das Integral

Z

f (g(t))g 0 (t)dt

zu berechnen, setzen wir x = g(t). Dann ist f (g(t)) = f (x), und dx = g 0 (t)dt. Damit

Z

Z

0

f (g(t))g (t)dt = f (x)dx = F (x) + c = F (g(t)) + c

Beispiele: Mit Hilfe der Substitutionsformel berechnen wir die folgenden unbestimmten

Integrale.

1) Für a ∈ R fest, gilt

Z

1

1

1 + (x/a)2

dx

=

x

x2 + a2

a2

d

Sei y = x/a. Dann ist dx = (1/a)dx, und

Z

Z

1

1

1

1

1

dx =

dy = arctan y + c = arctan(x/a) + c

2

2

2

x +a

a

1+y

a

a

Z

2) Wir untersuchen nun

Z

Z

tan x dx =

sin x

dx

cos x

Sei y = cos x. Dann ist dy = − sin xdx und

Z

Z

1

tan x dx = −

dy = − log y + c = − log cos x + c

y

3) Wir berechnen

Z

x

p

1 + x2 dx

indem wir t = 1 + x2 setzen. Dann ist dt = 2xdx und

Z p

Z

1

1

1

2

t1/2 dt = t3/2 + c = (1 + x2 )3/2 + c

x 1 + x dx =

2

3

3

Proposition 1.12 (Partielle Integration). Seien u, v ∈ C 1 ([a; b]). Dann gilt auf diesem

Intervall

Z

Z

0

u(x)v (x)dx = u(x)v(x) − u0 (x)v(x)dx

Es folgt

Z

b

Z

0

u(x)v (x)dx = u(b)v(b) − u(a)v(a) −

a

a

15

b

u0 (x)v(x)dx

Beweis. Wir bemerken, dass

d

(u(x)v(x)) = u0 (x)v(x) + u(x)v 0 (x)

dx

Damit

Z

u0 (x)v(x)dx +

Z

u(x)v 0 (x)dx = u(x)v(x) + c

Beispiele: Wir untersuchen das Integral von xex . Wir setzen u = x und v 0 = ex . Dann

ist u0 = 1 und v = ex . Damit

Z

Z

x

x

xe dx = xe − ex dx = xex − ex + c = ex (x − 1) + c

Ein anderes Beispiel ist das Integral von x2 sin x. Auch hier setzen wir u = x2 und

v 0 = sin x. Dann ist u0 = 2x und v = − cos x, und

Z

Z

2

2

x sin xdx = −x cos x + 2 x cos xdx

Wir wenden noch ein Mal die partielle Integration an. Sei nun u = x und v 0 = cos x.

Dann gilt u0 = 1 und v = sin x, und

Z

Z

x cos xdx = x sin x − sin xdx = x sin x + cos x + c

Also

Z

x2 sin xdx = −x2 cos x + 2x sin x + 2 cos x + c = (2 − x2 ) cos x + 2x sin x + c .

Auch mit Substitution und partieller Integration Stammfunktionen zu finden ist i.A.

eine schwierige Aufgabe. Es gibt aber einige spezielle Methoden, die die Berechnung von

Integralen von besonderen Klassen von Funktionen erlauben. Die wichtigste Klasse von

Funktionen, für die man immer eine elementare Stammfunktion finden kann, besteht

aus allen rationalen Funktionen.

1.4

Integration von rationalen Funktionen: Partialbruchzerlegung

Das Integral einer rationalen Funktion kann immer mit der Methode der Partialbruchzerlegung berechnet werden. Eine rationale Funktion hat die Form p/q, wobei p, q Polynome

sind. Es bezeichne degp und degq den Grad der Polynome p, q. Ist degp ≥ degq, so kann

man p durch q teilen. Man findet Polynome r, s mit degs < degq und mit p = rq + s.

Damit ist p/q = r +s/q. Das Integral von r kann sehr einfach berechnet werden; es bleibt

das Integral von s/q zu berechnen. Mit anderen Worten, es genügt, rationale Funktionen

p/q zu betrachten, mit deg p < deg q.

Es lohnt sich, komplexe Zahlen zu benutzen, um die Polynome q und p zu faktorisieren. Es existieren immer paarweise unterschiedliche z1 , . . . , zn ∈ C, eine Konstante a

und α1 , . . . , αn ∈ N, mit

n

Y

q(x) = a

(x − zj )αj

j=1

16

Die Zahlen z1 , . . . , zn sind die Nullstellen von q; sie heissen die Pole der rationalen

Funktion

Pn p/q. Der Exponent αj ist die Vielfachkeit oder die Ordnung, der Pol zj . Es

gilt j=1 αj = degq. O.B.d.A können wir annehmen, dass p und q keine gemeinsame

Nullstelle haben (sonst kann man die zwei Faktoren kürzen). Unter dieser Annahme

finden wir, dass

p(x)

lim (x − zj )αj

=: A 6= 0

x→zj

q(x)

Dann hat

p(x)

A

−

q(x) (x − zj )αj

höchstens einen Pol der Ordnung (m − 1) an der Stelle zj . In der Tat, sei das Polynom

q̂ so definiert, dass q(x) = (x − zj )αj q̂(x). Es gilt q̂(zj ) 6= 0, und A = p(zj )/q̂(zj ). Damit

A

p(x) − Aq̂(x)

p(x)

−

=

q(x) (x − zj )αj

q(x)

Da der Numerator p(zj ) − Aq̂(zj ) = 0, hat p/q − A/(x − zj )αj höchstens einen Pol der

Vielfachkeit αj − 1 in zj . Durch Wiederholung dieses Arguments, finden wir Konstanten

A1 , . . . , Aαj , s.d.

αj

A`

p(x) X

−

q(x)

(x − zj )`

`=1

keinen Pol an der Stelle zj hat. Wiederholen wir das Argument für alle Pole, erhalten

wir: es existieren (eindeutig bestimmte) Konstanten A1,1 , . . . , A1,α1 , . . . , An,1 , An,αn mit

n

αj

p(x) X X Aj,`

=

q(x)

(x − zj )`

j=1 `=1

Diese Darstellung der rationalen Funktion p/q heisst eine Partialbruchzerlegung. Integration einer beliebigen rationalen Funktion wird somit auf das Problem der Berechnung

der Integralen 1/(x−zj )k reduziert. Bemerke, dass auch für reellen rationale Funktionen

(d.h. rationale Funktionen mit reellen Keoffizienten), die Nullstellen zj des Polynoms q

sind i.A. komplex. Nur auf C kann ein Polynom mit Sicherheit so einfach zerlegt werden. Wir müssen also komplex-wertige Funktionen integrieren. Wir definieren hier das

(unbestimmte) Integral einer C-wertige Funktion f durch

Z

Z

Z

f dx = Re f dx + i Im f dx

R

R

(mit dieser Definition ist der Realteil von f dx gleich zu Re f dx, und analog für den

Imaginärteil). Für k > 1 gilt, ähnlich wie im Fall zj ∈ R,

Z

1

−1

1

dx =

+c

(3)

k − 1 (x − zj )k−1

(x − zj )k

17

Für k = 1 schreiben wir zj = aj + ibj und wir berechnen

Z

Z

1

1

dx =

dx

x − zj

(x − aj ) − ibj

Z

(x − aj ) + ibj

=

dx

(x − aj )2 + b2j

Z

Z

(x − aj )

1

dx

+

ib

dx

=

j

2

2

(x − aj ) + bj

(x − aj )2 + b2j

x − aj

1

= log (x − aj )2 + b2j + i arctan

2

bj

x − Re zj

= log |x − zj | + i arctan

Im zj

(4)

Damit können wir das Integral (bestimmt oder unbestimmt) jeder rationalen Funktion

berechnen. Zusammenfassend ist die Strategie um das Integral einer rationale Funktion

zu bestimmen die folgende: Zunächst wird durch geeignete Division und Kürzung, das

Problem auf die Berechnung des Integrals von p/q reduziert, wobei deg p < deg q und

p, q keine gemeinsamen Faktoren haben. Dann findet man alle PoleQz1 , . . . , zn von p/q,

mit der entsprechenden Vielfachkeit αj . Angenommen q(x) = a nj=1 (x − zj )αj , wir

berechnen dann die Partialbruchzerlegung

α

j

n

p(x) X X Aj,`j

=

.

q(x)

(x − zj )`

j=1 `j =1

von p/q. Die Berechnung der Koeffizienten Aj,`j reduziert sich nach Koeffizientenvergleich zur Lösung eines linearen Systems. Schlussendlich benutzen wir (3) und (4), um

das Integral jeder Term auszurechnen.

Als Beispiel betrachten wir die rationale Funktion

R(x) =

(x2

1

+ 1)2

Der Nenner hat die zwei Nullstellen x = ±i, beide mit Multiplizität zwei. Es existieren

also Konstanten A, B, C, D ∈ C mit

R(x)

B

C

D

A

+

+

+

2

x + i (x + i)

x − i (x − i)2

2

A(x + i)(x − i) + B(x − i)2 + C(x + i)2 (x − i) + D(x + i)2

=

(x2 + 1)2

A(x3 − ix2 + x − i) + B(x2 − 2ix − 1) + C(x3 + ix2 + x + i) + D(x2 + 2ix − 1)

=

(x2 + 1)2

x3 (A + C) + x2 (−iA + B + iC + D) + x(A − 2iB + C + 2iD) − (iA + B − iC + D)

=

(x2 + 1)2

=

Wir bekommen also die 4 Gleichungen

A + C = 0, −iA + B + iC + D = 0, A − 2iB + C + 2iD = 0, −iA − B + iC − D = 1

18

für die vier Unbekannten A, B, C, D. Die erste Gleichung gibt C = −A, die dritte also

B = D. Die zweite Gleichung wird iA = B, und die vierte A = −1/4i = i/4. Also:

1

1

1

i 1

1

i 1

1

=

−

−

−

(x2 + 1)2

4 x + i 4 (x + i)2 4 x − i 4 (x − i)2

und damit

Z

1

1

i

1

1

= (log |x + i| + i arctan x − log |x − i| + i arctan x) +

+

(x2 + 1)2

4

4 x+i x−i

1

1 x

= − arctan x +

2

2 x2 + 1

weil |x − i| = |x + i|. Wie erwartet, ist das Endresultat reell (alle imaginären Beiträge

kürzen sich weg).

Eine andere Klasse von Integralen, die man immer in geschlossene Form ausrechnen

kann, sind Integrale der Form

Z

R(cos x; sin x)dx

wobei R(s; t) eine rationale Funktion von den zwei Variablen s, t ist (d.h. R(s; t) =

p(s; t)/q(s; t) für p, q Polynome in den Variablen s, t). Der Trick in diesem Fall ist die

Substitution u = tan(x/2) durchzuführen. Dann ist x = 2 arctan(u), und

dx =

2

du

1 + u2

Weiter gilt

cos2 (x/2) =

1

1

=

2

1 + u2

1 + tan (x/2)

und aus

cos2 (x/2) =

1 − cos x

2

findet man

cos x = 1 − 2 cos2 (x/2) = 1 −

2

u2 − 1

=

1 + u2

u2 + 1

und

sin x = 2 sin(x/2) cos(x/2) = 2 tan(x/2) cos2 (x/2) =

Also, nach Substitution, wird

Z

2u

1 + u2

Z

R(cos x; sin x)dx =

e

R(u)du

e Das Integral von R

e kann man dann durch die Mefür eine neue rationale Funktion R.

thode der Partialbruchzerlegung berechnen.

Beispiel: Wir möchten das Integral

Z

1

dx

cos x

19

berechnen. Wir setzen u = tan(x/2), und finden

Z

Z 2

Z

1

u +1 2

1

dx =

du = 2

du

2

2

2

cos x

u −11+u

u −1

Z 1

1

du

=

−

u−1 u+1

| tan2 (x/2) − 1|

= log |u − 1| − log |u + 1| + c = log

+c

| tan2 (x/2) + 1|

Bemerke, dass trigonometrische Funktionen oft einfacher integriert werden können,

ohne den Trick mit u = tan(x/2) zu benutzen.

Integrale der Form

Z

R(x;

p

1 − x2 )dx,

für eine rationale Funktion R, können mit der Substitution √

x = sin t berechnet werden.

In der Tat, mit dieser Substitution finden wir dx = cos t dt, 1 − x2 = cos t, und damit

Z

Z

p

2

e

R(x; 1 − x )dx = R(sin

t; cos t)dt

e Das Integral auf der rechten Seite kann dann, wie

für eine neue rationale Funktion R.

oben erklärt, mit der Substitution u = tan(t/2) berechnet werden.

Integrale der Form

Z

R(x;

Z

p

p

x2 − 1)dx, oder

R(x; 1 + x2 )dx ,

für eine rationale Funktion R, können mit der Substitution x = cosh t, bzw. x = sinh t

berechnet werden Mit dieser Substitution reduziert sich das Problem auf der Berechnung

von Integralen der Form

Z

e

R(cosh

t; sinh t)dt

e Die Substitution u = et , reduziert dann das Problem

für eine neue rationale Funktion R.

auf die Berechnung vom Integral von rationalen Funktionen in u. Da sich jeder quadratische Ausdruck ax2 + bx + c durch quadratische Ergänzung und lineare Substitution y

in der Form 1 − y 2 , 1 + y 2 oder y 2 − 1 schreiben lässt, folgt, dass man jedes Integral der

Form

Z

p

R(x; ax2 + bx + c)dx

explizit berechnen kann.

1.5

Vertausch von Grenzübergang und Integral

In dieser Sektion untersuchen wir die folgende Frage: Sei fn eine Folge von auf [a; b]

integrierbare Funktionen, mit fn → f . Ist dann f auf [a; b] integrierbar? Falls ja, ist das

20

Integral von f aus dem Grenzwert der Integrale von fn gegeben? Mit anderen Worten,

unter welchen Bedingungen gilt

b

Z

lim

n→∞ a

fn dx =

Z b

lim fn dx

n→∞

a

Beispiel: Sei fn die Folge von Funktionen auf [−1; 1], definiert durch

n + n2 x für − 1/n ≤ x < 0

n − n2 x für 0 < x < 1/n

fn (x) =

0

sonst

Es gilt fn → 0 punktweise. Jede fn ist auf [−1; 1] integrierbar, mit

Z

fn dx = 1

für alle n (der Graph von f beschreibt ein Dreieck, mit Basis 2/n und Höhe n). Also,

in diesem Fall

Z 1

Z 1

1 = lim

fn dx 6=

lim fn dx = 0

n→∞ −1

n→∞

−1

Das Beispiel zeigt, dass punktweise Konvergenz von fn nach f nicht genügt, um

Grenzwert mit Integral zu vertauschen. Der nächste Satz zeigt, dass gleichmässige Konvergenz hinreichend ist.

Satz 1.13. Sei fn eine Folge von auf [a; b] integrierbaren Funktionen, mit fn → f

gleichmässig auf [a; b]. Dann ist f auf [a; b] integrierbar und

b

Z

Z

b

f dx = lim

a

n→∞ a

fn dx

Beweis. Sei ε > 0 fest. Wir finden dann n ∈ N mit

|fn (x) − f (x)| <

ε

4(b − a)

für alle x ∈ [a; b]. Da fn integrierbar ist, finden wir auch eine Teilung T von [a; b] mit

S(fn , T ) − S(fn , T ) <

ε

2

Dann gilt

S(f, T ) =

≤

m

X

j=1

=

sup{f (x) : x ∈ Ij } |Ij |

j=1

m X

ε

+ sup{fn (x) : x ∈ Ij } |Ij |

4(b − a)

ε

+ S(fn , T )

4

21

Analog

S(f, t) ≥ S(fn , T ) −

und damit

ε

4

ε

+ S(fn , T ) − S(fn , T ) ≤ ε

2

S(f, T ) − S(f, T ) ≤

Also, ist f integrierbar. Weiter gilt

Z b

Z b

Z b

|f − fn |dx ≤ (b − a) sup |f − fn |

fn dx ≤

f dx −

a

x

a

a

Da die rechte Seite gegen Null konvergiert, muss

Z

b

Z

fn dx →

b

f dx

a

a

für n → ∞.

Bemerkung: Gleichmässige Konvergenz ist zwar hinreichend, aber nicht notwendig für

Konvergenz der Integrale. Mit der alternativen (und modernen) Definition des Integrals

(das Lebesgue Integral, wird in der Vorlesung Analysis III diskutiert) ist es relativ einfach

Bedingungen für Konvergenz von Integrale von Funktionenfolge die viel schwächer, und

damit viel nützelicher sind, als gleichmässige Konvergenz der Folge.

1.6

Uneigentliche Integrale

Bis jetzt haben wir Integrale von beschränkten Funktionen auf kompakte Intervalle

untersucht. Die Definition mit Riemann’schen Summen funktioniert für Integrale der

Form

Z ∞

Z 1

1

1

√ dx

dx oder

2

1+x

x

0

0

nicht. Diese Integrale, die man als uneigentliche Integrale bezeichnet, kann man trotzdem

als Grenzwerte von “eigentlichen Integrale” definieren. Für beliebige y > 0, gilt

Z y

1

dx = arctan(y) − arctan(0) = arctan(y)

2

0 1+x

Also können wir

Z

0

∞

1

dx := lim

y→∞

1 + x2

Z

0

y

1

π

dx = lim arctan(y) =

2

y→∞

1+x

2

definieren. Ähnlich können wir

Z 1

Z 1

1

1

√

√ dx = lim

√ dx = lim (2 − 2 y) = 2

y↓0 y

y↓0

x

x

0

definieren. Die allgemeinere Definition ist die folgende.

22

Definition 1.14. Sei f auf [a; b) definiert (b = +∞ ist zugelassen), und auf [a; y]

integrierbar, für alle y ∈ (a; b). Existiert der Limes

Z y

f dx

lim

y↑b

a

dann sagen wir, f sei auf [a; b) uneigentlich integrierbar, und wir definieren das uneigentliche Integral von f auf [a; b) durch

b

Z

y

Z

f dx

f dx := lim

y↑b

a

a

Ähnlich, falls f auf (a; b] (a = −∞ zugelassen) definiert ist, auf [y; b] integrierbar ist,

für alle y ∈ (a; b), und falls der Limes

b

Z

f dx

lim

y↓a

y

existiert, so definieren wir

b

Z

Z

b

f dx := lim

y↓a

a

f dx

y

Ist f auf (a; b) definiert (a = −∞ und/oder b = +∞ sind zugelassen) und falls die

uneigentlichen Integrale

Z c

Z b

f dx und

f dx

a

c

für ein c ∈ [a; b] existieren, so definieren wir

b

Z

c

Z

f dx =

Z

f dx +

a

a

b

f dx

c

Bemerkung: Ist das Integral auf beiden Seiten uneigentlich, so müssen die zwei Grenzwerte y ↓ a und y ↑ b unabhängig voneinander genommen werden. Z.B. das Integral

Z ∞

xdx

−∞

existiert nicht, obwohl

y

Z

xdx = 0

−y

für alle y > 0.

Beispiel: Es gilt

Z ∞

1

1

dx = lim

y→∞

xα

Z

1

y

1

−1

1

1

1

dx = lim

+

=

α

α−1

y→∞ α − 1 y

x

α−1

α−1

für alle α > 1. Das Integral

Z

1

∞

1

dx

xα

23

existiert dagegen nicht, für α < 1. Es gilt weiter

Z 1

Z 1

1

1

y 1−α

1

1

dx

=

lim

= lim

−

=

α

α

y→0

y→0

x

x

1

−

α

1

−

α

1

−

α

y

0

für alle α < 1. Das Integral

1

Z

0

1

dx

xα

existiert nicht, für α > 1. Die Integrale

Z ∞

1

dx = lim log y = +∞

y→∞

x

1

und

Z

0

1

1

dx = lim − log y = +∞

y→0

x

existieren nicht.

Proposition 1.15 (Vergleichskriterium). Seien a ∈ R ∪ {−∞}, b ∈ R ∪ {+∞}, mit

a < b. Seien f, g integrierbar auf (α; β), für alle a < α < β < b. Es gelte g(x) ≥ 0 und

|f (x)| ≤ g(x) für alle x ∈ (a; b) und es existiere das (uneigentliche) Integral

Z b

gdx

a

Dann existiert auch das (uneigentliche) Integral

Z b

f dx

a

Beweis. Wir betrachten den Fall, dass f integrierbar auf [a; y], für alle y ∈ (a; b), ist.

Wir möchten zeigen, dass

Z y

lim

f dx

y↑b

a

existiert. Sei yn eine beliebige Folge, mit yn < b für alle n ∈ N und yn → b als n → ∞.

Wir zeigen, dass

Z yn

f dx

a

eine Cauchy-Folge ist. Dazu bemerken wir, dass (unter Annahme, dass, zB., ym < yn )

Z yn

Z yn

Z yn

Z ym

Z yn

Z yn

Z ym

=

≤

f

dx

−

f

dx

f

dx

|f

|dx

≤

gdx

≤=

gdx

−

gdx

a

a

ym

ym

ym

a

R yn

a

Die Existenz des IntegralsR von g auf [a; b] impliziert, dass die Folge a gdx eine RCauchyy

y

Folge ist. Damit ist auch a n f dx eine Cauchy-Folge. Also konvergiert die Folge a n f dx.

Es ist weiter einfach zu sehen, dass der Limes unabhängig von der Wahl der Folge yn

ist; man nimmt dazu an, es existieren zwei Folgen y1,n → b und y2,n → b, so dass

Z y1,n

Z y2,n

f dx 6= lim

f dx

lim

n→∞ a

n→∞ a

24

Dann man definiert die Folge y3,n , die, alternierend, Werte aus y1,n und y2,n annimmt.

Die Folge

Z y3,n

f dx

lim

n→∞ a

sollte dann zwei Häufungspunkten haben; da aber y3,n → b, muss die Folge

konvergieren.

Anwendung: das Integral

∞

Z

1

R y3,n

a

f dx

(log x)m

dx

xα

existiert, für alle α > 1, und alle m > 0. Das folgt aus der Tatsache, dass, für alle ε > 0

es existiert eine Konstante Cε mit

(log x) ≤ Cε xε

Für 0 < ε < α − 1 gilt also

(log x)m

1

(log x)m

Cε

≤

sup

≤ 1+ε

xα

x1+ε x≥1 xα−1−ε

x

Die Existenz des Integrals von 1/x1+ε auf [1; ∞) impliziert also die Existenz des Integrals

von (log x)m /xα .

Uneigentliche Integrale können auch benutzt werden, um die Konvergenz von Reihen

zu prüfen.

Proposition 1.16 (Integralkriterium

für Reihen). Sei f positiv, monoton

fallend auf

R∞

P

f

dx

existiert.

f

(n)

konvergent,

genau

dann

wenn

[1; ∞). Dann ist die Reihe ∞

n=1

1

P

Beweis. Da f positiv ist die Reihe n f (n)

konvergent, genau dann wenn sie beschränkt

R∞

ist.

Aus

dem

selben

Grund,

das

Integral

1 f dx existiert, genau dann wenn die Folge

Rm

1 f dx beschränkt ist. Aus der Monotonie von f gilt

Z

n+1

Z

n

f dx ≤ f (n) ≤

n

für alle n ∈ N. Also

Z m+1

m Z

X

f dx =

2

n+1

n=2 n

f dx

n−1

f dx ≤

m

X

f (n) ≤

n=2

m Z

X

n

n=2 n−1

Z

f dx =

m−1

f dx

1

für alle m ∈ N, m > 2. Also die Reihe ist beschränkt, genau dann wenn das Integral

beschränkt ist.

Beispiel: konvergiert die Reihe

∞

X

n=2

1

?

n log n

25

Die Funktion f (x) = (x log x)−1 ist positiv und monoton fallend auf x > 1. D.h. die

Reihe konvergiert g.d.w. das uneigentliche Integral von f auf [2; ∞) existiert. Da (mit

der Substitution u = log x)

Z

2

y

Z

1

dx =

x log x

log y

log 2

du

= log log y − log log 2

u

divergiert, als y → ∞, es folgt, dass

X

n≥2

1

=∞

n log n

Ähnlicherweise kann man zeigen, dass

X

n≥2

1

n(log n)α

konvergiert, g.d.w. α > 1.

2

Gewöhnliche Differentialgleichungen

Differentialgleichungen sind Gleichungen, bei denen die Unbekannten Funktionen sind.

Die Differentialgleichung definiert eine Beziehung zwischen den gesuchten Funktionen

und ihren Ableitungen. Gewöhnliche Differentialgleichugen (auf Englisch “ordinary differential equations” oder einfach ODEs) sind Differentialgleichungen, wo die unbekannten

Funktionen einer einzelnen reellen Variablen sind. Bei partiellen Differentialgleichungen

sind dagegen die unbekannten Funktionen von mehreren Variablen.

Differentialgleichungen haben sehr viele Anwendungen. Die ganze Physik wird z.B.

durch Differentialgleichungen formuliert: Die Newtonsche Gleichung der klassischen Mechanik, die Maxwell Gleichungen der Elektrodynamik, die Schrödingergleichung der

Quantenmechanik, die Einsteingleichung der allgemeinen Relativitätstheorie sind alle Beispiele von Differentialgleichungen. Dabei ist nur die Newtonsche Gleichung eine

gewöhnliche Differentialgleichung, die anderen sind partielle Differentialgleichungen.

In dieser Vorlesung werden wir nur eine kurze Einführung in der Analysis von

gewöhnliche Differentialgleichungen geben. Eine vollständiger Diskussion von gewöhliche Differentialgleichungen wird dann in der Vorlesung Analysis 3 im nächsten Semester stattfinden (insbesondere das wichtige Kriterium für Existenz und Eindeutigkeit

von Lösungen von gewöhnliche Differentialgleichungen, das sogenannte Picard-Lindelöf

Theorem, wird erst in Analysis 3 bewiesen).

2.1

Differentialgleichungen erster Ordnung, elementare Lösungsmethoden

Wir betrachten hier gewöhnliche Differentialgleichungen erster Ordnung.

Definition 2.1. Sei n ≥ 1, U ⊂ Rn+1 , f ∈ C(U ; Rn ). Dann ist

y 0 (x) = f (x, y(x))

26

(5)

eine gewöhnliche Differentialgleichung erster Ordnung. Eine Lösung dieser Differentialgleichung auf einem Intervall I ⊂ R ist eine Funktion y ∈ C 1 (I; Rn ) so, dass

(x, y(x)) ∈ U und (5) erfüllt für alle x ∈ I ist. Für x0 ∈ R, y0 ∈ Rn mit (x0 , y0 ) ∈ U

heisst

0

y (x) = f (x, y(x))

(6)

y(x0 ) = y0

ein Anfangswertproblem oder ein Cauchy-Problem. Eine Lösung des Anfangswertproblems (6) ist eine Lösung der Differentialgleichung (5), die auch die Anfangsbedingung

y(x0 ) = y0 erfüllt (insbesondere muss x0 ∈ I sein). Ist n = 1, so heisst die Differentialgleichung skalar (die gesuchte Funktion hat Werten in R). Ist dagegen n > 1, so heisst

die Differentialgleichung vektoriell (man spricht in diesem Fall von einem System von

Diferentialgleichungen).

Wir betrachten ein paar Beispiele von Differentialgleichungen, wo die Lösungen explizit berechnet werden können (der Einfachheit halber betrachten wir hier Beispiele von

skalaren Gleichungen; wir werden einige Beispiele von vektoriellen Gleichungen später

betrachten, wenn wir lineare Differentialgleichungen untersuchen werden).

Beispiele:

• Sei n = 1, I ⊂ R ein offenes Intervall, U = I × R, und f (x, y) = g(x) (unabhängig

von y), für ein g ∈ C(I). Wir betrachten die Differentialgleichung

ϕ0 (x) = g(x)

Sei G ∈ C 1 (I) eine Stammfunktion von g, mit G0 = g. Dann ist G eine Lösung der

Differentialgleichung. Sei ϕ eine andere Lösung der Differentialgleichung. Dann gilt

(ϕ−G)0 (x) = 0 für alle x ∈ I. Das zeigt, dass jede Lösung die Form ϕ(x) = G(x)+c

hat, für eine Konstante c ∈ R. Betrachten wir nun das Anfangswertproblem

0

ϕ (x) = g(x)

ϕ(x0 ) = y0

für ein x0 ∈ I und ein y0 ∈ R. Die Lösung des Anfangswertproblems ist insbesondere die Lösung der Differentialgleichung und hat deswegen die Form

ϕ(x) = G(x) + c

Die Bedingung

y0 = ϕ(x0 ) = G(x0 ) + c

⇒

c = y0 − G(x0 )

bestimmt die Konstante c eindeutig. Die einzige Lösung des Anfangswertproblems

ist aus

ϕ(x) = G(x) − G(x0 ) + y0

gegeben. Bemerke, dass die eindeutige Lösung auch als

Z x

ϕ(x) = y0 +

g(t)dt

x0

geschrieben werden kann.

27

• Sei wieder n = 1, U = R2 , und f (x, y) = −y. Die Differentialgleichung (5) nimmt

dann die Form

ϕ0 (x) = −ϕ(x)

(7)

Die Funktion ϕ(x) = ce−x erfüllt diese Differentialgleichung auf R, für beliebige

c ∈ R. Wir behaupten jede Lösung auf R hat diese Form. Sei in der Tat ϕ eine

Lösung von (7) auf R. Dann gilt

d x

(e ϕ(x)) = ex (ϕ(x) + ϕ0 (x)) = 0

dx

für alle x ∈ R. Es existiert also eine Konstante c ∈ R mit ex ϕ(x) = c für alle x ∈ R,

d.h. mit ϕ(x) = ce−x für alle x ∈ R. Betrachten wir nun das Anfangswertproblem

0

ϕ (x) = −ϕ(x)

ϕ(x0 ) = y0

für x0 , y0 ∈ R. Die Lösung des Anfangswertproblem hat die Form y(x) = ce−x .

Die Anfangsbedingung y(x0 ) = y0 bestimmt die Konstante c ∈ R durch

y0 = y(x0 ) = ce−x0

⇒

c = y 0 e x0

Die eindeutige Lösung des Anfangswertproblems ist also y(x) = y0 exp(−(x − x0 )).

• Wir betrachten das Anfangswertproblem

0

ϕ (x) = a(ϕ(x) − bϕ2 (x))

ϕ(0) = y0

(8)

für a, b, y0 > 0. Die Differentialgleichung in (8) heisst die logistische Gleichung

oder die Differentialgleichung des beschränkten exponentiellen Wachstums, und

hat z.B. Anwendungen in der Biologie (die Lösung beschreibt das Wachstum einer

idealen Bakterienpopulation). Um die Gleichung zu lösen bemerken wir, dass

1

ϕ0 (x) = a

ϕ(x) − bϕ2 (x)

Integration über x gibt

Z x

0

1

ϕ0 (t)dt = a

ϕ(t) − bϕ2 (t)

Z

x

dt = ax

0

Wir substituieren y = ϕ(t) und bekommen

Z ϕ(x)

1

dy = ax

y

−

by 2

ϕ(0)

Aus

1

1

b

1

=

= +

2

y − by

y(1 − by)

y 1 − by

finden wir

log

ϕ(x)(1 − by0 )

= ax

y0 (1 − bϕ(x))

28

Nach leichter algebraischer Manipulationen bekommen wir die eindeutige Lösung

des Anfangswertsproblems

ϕ(x) =

y0 eax

1 + by0 (eax − 1)

Im letzten Beispiel haben wir die Methode der Trennung der Variablen benutzt. Wir

zeigen im nächsten Satz, dass diese Methode immer angewandt werden kann, falls die

Funktion f (x, y) auf der rechten Seite von (5) das Produkt einer Funktion von x mit

einer Funktion von y ist.

Satz 2.2. Seien I, J ⊂ R offene Intervalle, g ∈ C(I), h ∈ C(J), mit 0 6∈ h(J). Sei

(x0 , y0 ) ∈ I × J. Seien

Z x

Z y

1

G(x) =

g(t)dt, und H(y) =

dt

x0

y0 h(t)

Weiter, sei I 0 ⊂ I ein offenes Intervall mit G(I 0 ) ⊂ H(J) und x0 ∈ I 0 . Dann existiert

genau eine Lösung ϕ ∈ C 1 (I 0 ) des Anfangswertproblems

0

ϕ (x) = g(x)h(ϕ(x))

(9)

ϕ(x0 ) = y0

Ferner ist ϕ : I 0 → J die einzige Funktion mit

H(ϕ(x)) = G(x)

für alle x ∈ I 0 .

(10)

Bemerkung: Die Aussage impliziert, dass Differentialgleichungen der Form (9) durch

Trennung der Variablen gelöst werden können. Das bedeutet, dass (9) zunächst als

1

ϕ0 (x) = g(x)

h(ϕ(x))

umgeschrieben werden kann. Integration über x ergibt dann

Z x

Z x

1

ϕ0 (t)dt =

g(t)dt

x0 h(ϕ(t))

x0

und damit

Z

ϕ(x)

ϕ(x0 )

1

dy =

h(y)

Z

x

g(t)dt

x0

und

H(ϕ(x)) = G(x)

Die eindeutige Lösung des Anfangswertproblems kann dann durch Umkehrung der Funktion H bestimmt werden.

Beweis: Da H ∈ C 1 (J) mit H 0 (y) = 1/h(y) 6= 0 für alle y ∈ J ist H injektiv. Damit ist

H : J → H(J) bijektiv und also invertierbar. Sei T : H(J) → J die Umkehrfunktion.

Dann ist T ∈ C 1 (H(J)) mit T 0 (z) = 1/H 0 (T (z)) = h(T (z)), für alle z ∈ H(J). Die

Gleichung (10) definiert eindeutig eine Funktion ϕ = T ◦ G ∈ C 1 (I 0 ). Diese Funktion

29

erfüllt ϕ0 (x) = h(T ◦ G(x))G0 (x) = h(ϕ(x))g(x) und ϕ(x0 ) = T ◦ G(x0 ) = T (0) = y0 .

D.h. ϕ ist eine Lösung des Anfangswertsproblems. Das zeigt die Existenz der Lösung.

Es bleibt die Eindeutigkeit zu zeigen. Sei dazu ϕ

e ∈ C 1 (I 0 ) eine andere Lösung des

0

Anfangswertproblems. Es folgt, dass ϕ(I

e ) ⊂ J. Sei ψ = H ◦ ϕ

e − G. Dann gilt

ψ 0 = (H 0 ◦ ϕ)

eϕ

e0 − G0 =

1

ϕ

e0 − g = 0

h◦ϕ

e

auf I 0 , Damit muss ψ konstant auf I 0 sein. Da aber ψ(x0 ) = H(ϕ(x

e 0 )) − G(x0 ) = 0,

muss ψ(x) = 0 für alle x ∈ I 0 . D.h. H ◦ ϕ

e = G auf I 0 , und deswegen, ϕ

e = ϕ. Das zeigt

die Eindeutigkeit der Lösung.

Differentialgleichungen der Form (9) können durch Trennung der Variable gelöst werden. In diesem Fall kann die Lösung auf der Berechnung eines Integrales zurückgeführt

werden. In allgemein ist das nicht möglich. Nur die wenigstens Differentialgleichungen

können explizit gelöst werden. Numerische Methoden müssen dann angewandt werden,

um Approximationen für die Lösung von Differentialgleichungen zu finden. Bevor man

numerische Methoden benutzt ist aber wichtig zu wissen, ob eine Lösung existiert, und

ob sie eindeutig ist. Der folgende Satz gibt ein hinreichendes Kriterium für die Existenz und die Eindeutigkeit der Lösung einer Differentialgleichung. Der Beweis wird in

Analysis 3 kommen.

Satz 2.3 (Picard-Lindelöf). Sei I = [a; b] ⊂ R ein nicht-leeres kompaktes Intervall,

x0 ∈ I, f ∈ C(I × Rn , Rn ) Lipschitz-stetig in der zweiten Variablen. D.h. es existiere

L > 0 mit

kf (x, y) − f (x, y 0 )k ≤ Lky − y 0 k

für alle x ∈ I, y, y 0 ∈ Rn . Dann hat für jede y0 ∈ Rn das Anfangswertproblem

0

ϕ (x) = f (x, ϕ(x))

ϕ(x0 ) = y0

(11)

eine eindeutige Lösung ϕ ∈ C 1 (I; Rn ).

2.2

Differentialgleichungen höherer Ordnung

Differentialgleichungen höherer Ordnung hängen auch von den höheren Ableitungen der

gesuchten Funktion y(x) ab.

Definition 2.4. Seien n, k ∈ N\{0} fest, Ω ⊂ R × Rn×k offen, f ∈ C(Ω, Rn ). Dann ist

y (k) (x) = f (x, y(x), y 0 (x), . . . , y (k−1) (x))

(12)

eine Differentialgleichung k-ter Ordnung. Eine Lösung von (12) auf einem Intervall

I ⊂ R ist eine Funktion y ∈ C k (I; Rn ) so, dass

x, y(x), y 0 (x), . . . , y (k) (x) ∈ Ω

und (12) gilt, für alle x ∈ I. Für gegebene (x0 , y0 , y1 , . . . , yk ) ∈ Ω ist

(k)

y = f (x, y(x), . . . , y (k−1) (x))

y (j) (x0 ) = yj ,

für j = 0, 1, . . . , (k − 1)

ein Anfangswertproblem oder ein Cauchy-Problem k-ter Ordnung.

30

(13)

Man kann Resultate über die Existenz und Eindeutigkeit der Lösung von Anfangswertproblemen k-ter Ordnung aus den entsprechenden Resultaten für Gleichungen erster Ordnung herleiten, indem man bemerkt, dass eine Gleichung k-ter Ordnung zu

einer Gleichung erster Ordnung in mehreren Variablen äquivalent ist. In der Tat, das

Anfangswertproblem (13) kann wie folgt umgeschrieben werden. Wir definieren die neue

Funktion ψ(x) = (y(x), y 0 (x), . . . , y (k−1) (x)). Dann ist ψ eine Funktion mit Werten in

Rn×k . Wir definieren ferner

fe(x, z0 , z1 , . . . , zk−1 ) := (z1 , z2 , . . . , zk−1 , f (x, z0 , z1 , . . . , zk−1 ))

für alle (x, z0 , z1 , . . . , zk−1 ) ∈ Ω. Auch fe hat Werte in Rn×k . Es ist dann leicht zu sehen,

dass (13) zu dem Anfangswertproblem

ψ 0 (x) = fe(x, ψ(x))

mit der Anfangsbedingung ψ(x0 ) = (y0 , y1 , . . . , yk−1 ) ∈ Rn×k äquivalent ist. Damit

haben wir ein Problem k-ter Ordnung in Dimension n in einem Problem erster Ordnung

in Dimension nk umgeschrieben. Wir erhalten deswegen das folgende Existenz- und

Eindeutigkeitsresultat.

Satz 2.5. Seien n, k ∈ N\{0} fest, I = [a; b] ⊂ R ein nicht-leeres kompaktes Intervall,

x0 ∈ I, f ∈ C(I × Rnk ) , Lipschitz-stetig in Lipschitz-stetig in alle Argumenten nach

dem ersten. D.h. es existiere L > 0 mit

f (x, z0 , z1 , . . . , zk−1 ) − f (x, z00 , z10 , . . . , z 0 ) ≤ Lkz − z 0 k

k−1

0

) ∈ Rnk . Dann existiert für

für alle x ∈ I, z = (z0 , z1 , . . . , zk−1 ), z 0 = (z00 , z10 , . . . , zk−1

jede (y0 , y1 , . . . , yk−1 ) ∈ Rnk eine eindeutige Lösung des Anfangswertproblem (13).

Beweis: Gemäss Satz 2.3, genügt es zu zeigen, dass die Funktion

fe(x, z0 , z1 , . . . , zk−1 ) = (z1 , z2 , . . . , zk−1 , f (x, z0 , z1 , . . . , zk−1 ))

Lipshitz-stetig in z = (z0 , z1 , . . . , zk−1 ) ist. Dazu bemerken wir, dass

e

0

, f (x, z) − f (x, z 0 ))

f (x, z) − fe(x, z 0 ) = (z1 − z10 , z2 − z20 , . . . , zk−1 − zk−1

≤ kz − z 0 k + kf (x, z) − f (x, z 0 )k ≤ (L + 1)kz − z 0 k .

2.3

Lineare Differentialgleichungen

Die Differentialgleichung erster Ordnung

y 0 (x) = f (x, y(x))

(14)

heisst linear, falls die Funktion f (x, y) affin in der Variable y ∈ Rn ist, d.h. falls eine offene Teilmenge A ⊂ R, eine matrixwertige Funktion a ∈ C(A; Rn×n ) und eine

vektorwertige Funktion b ∈ C(A; Rn ) existieren mit

f (x, y) = a(x)y + b(x)

31

(15)

Für ein beliebiges x ∈ A bezeichnet hier a(x)y die Anwendung der n × n Matrix a(x)

auf dem Vektor y ∈ Rn . Die Differentialgleichung (14) heisst linear und homogen, falls

f (x, y) linear in y ist, d.h. falls f die Form (15) hat, mit b = 0.

Skalare lineare Differentialgleichungen: Wir betrachten zunächst den skalaren Fall, mit

n = 1. Sei I ⊂ R ein Intervall und a ∈ C(I). Für x0 ∈ I und y0 ∈ R beliebig, untersuchen

wir das skalare, lineare und homogene Anfangswertproblem

(

y 0 (x) = a(x)y(x)

y(x0 ) = y0

Das Anfangswertproblem hat eine eindeutige Lösung (aus Satz 2.3). Durch Trennung

der Variablen finden wir, dass die eindeutige Lösung aus

Z x

ϕ(x) = y0 exp

a(t)dt

x0

gegeben ist.

Sei nun, wie vorher, I ⊂ R ein Intervall und a ∈ C(I). Weiter, sei b ∈ C(I). Für

beliebige x0 ∈ I und y0 ∈ R, untersuchen wir das skalare, lineare (aber inhomogene)

Anfangswertproblem

(

y 0 (x) = a(x)y(x) + b(x)

y(x0 ) = y0

Aus Sazt 2.3, hat dieses Anfangswertproblem eine eindeutige Lösung. Die Lösung kann

durch die Methode der Variation der Konstante gefunden werden. Man findet zunächst

die allgemeine Lösung der homogenen Differentialgleichung y 0 (x) = a(x)y(x), die aus

Z x

y(x) = c exp

a(t)dt

x0

für eine beliebige Konstante c ∈ R gegeben ist. Um die inhomogene Gleichung zu lösen,

betrachtet man den Ansatz

Z x

y(x) = c(x) exp

a(t)dt

x0

bei welchem die Konstante c aus der Lösung der homogenen Gleichung nun von x

abhängt. Dann ist

Z x

Z x

0

0

y (x) = c (x) exp

a(t)dt + c(x)a(x) exp

a(t)dt

x0

x0

Z x

0

= c (x) exp

a(t)dt + a(x)y(x)

x0

Wir sehen also, dass y(x) eine Lösung des inhomogenen Anfangswertproblems ist, g.d.w.

Z x

Z x

0

0

c (x) exp

a(t)dt = b(x)

⇐⇒

c (x) = b(x) exp −

a(t)dt

x0

x0

32

Wir finden also, dass die eindeutige Lösung des inhomogenen Anfangswertproblems aus

Z x

Z t

Z x

a(s)ds dt exp

a(t)dt

b(t) exp −

ϕ(x) = y0 +

x0

x0

x0

gegeben ist.

Vektorielle lineare Differentialgleichungen: Wir kommen nun zum allgemeinen Fall n ≥

1. Sei I ⊂ R ein Intervall, x0 ∈ I, a ∈ C(I, Rn×n ) eine matrix-wertige stetige Funktion

auf I. Wir untersuchen das lineare, homogene Anfangswertproblem

0

y (x) = a(x)y(x)

(16)

y(x0 ) = y0

für ein beliebiges y0 ∈ Rn .

Es lohnt sich in diesem Fall zunächst eine matrix-wertige Differentialgleichung zu

lösen. Aus Satz 2.3 folgt nämlich, dass eine eindeutige Lösung ϕ ∈ C 1 (I, Rn×n ) des

Anfangswertproblems

0

ϕ (x) = a(x)ϕ(x)

(17)

ϕ(x0 ) = 1

existiert, wobei 1 die Identitätsmatrix auf Rn ist. Bemerke, dass, für alle x ∈ I, ϕ(x)

hier eine n × n Matrix bezeichnet. Die Ableitung ϕ0 (x) ist wieder eine Matrix, mit

Einträgen (ϕ0 (x))ij = ϕ0ij (x), wobei ϕij (x) die Einträge von ϕ(x) sind (d.h. die Matrix

wird Einträge-weise differenziert). Das Produkt a(x)ϕ(x) soll dann als Produkt von

zwei Matrizen verstanden werden. Die Matrixgleichung (17) ist einfach ein System von

n2 Differentialgleichungen, oder äquivalent, eine vektorielle Differentialgleichung für eine

Unbekannte ϕ(x) mit n2 Komponenten (deswegen kann man Satz 2.3 anwenden). Analog

existiert eine eindeutige Lösung ψ ∈ C 1 (I; Rn×n ) des Anfangswertproblems

0

ψ (x) = −ψ(x)a(x)

(18)

ψ(x0 ) = 1

Wir behaupten nun, dass

ψ(x)ϕ(x) = 1

für alle x ∈ I. In der Tat, die Anfangsbedingung impliziert, dass ψ(x0 )ϕ(x0 ) = 1.

Anderseits

d

[ψ(x)ϕ(x)] = ψ 0 (x)ϕ(x) + ψ(x)ϕ0 (x) = −ψ(x)a(x)ϕ(x) + ψ(x)a(x)ϕ(x) = 0

dx

D.h. ψ(x)ϕ(x) ist konstant auf I und deswegen ψ(x)ϕ(x) = 1, für alle x ∈ I. Das

impliziert insbesondere, dass die Lösungen ϕ(x) und ψ(x) invertierbar sind, für alle

x ∈ I.

Wir können nun die Lösung ϕ(x) des Anfangswertproblems (17) benutzen, um die

Lösung von (16) zu konstruieren. Aus Satz 2.3 wissen wir nämlich schon, dass (16) eine

eindeutige Lösung besitzt. Wir behaupten nun, dass die eindeutige Lösung von (16) aus

y(x) = ϕ(x)y0 gegeben ist. In der Tat, y(x0 ) = ϕ(x0 )y0 = 1y0 = y0 und

y 0 (x) = ϕ0 (x)y0 = a(x)ϕ(x)y0 = a(x)y(x)

33

(19)

Mit anderen Worten, die eindeutige Lösung von (16) bekommt man einfach durch Anwendung der Matrix ϕ(x) auf die Anfangsbedingung y0 ∈ Rn .

Aus der Darstellung der Lösung von (16) als y(x) = ϕ(x)y0 folgt einfach, dass der

Lösungsraum der linearen Differentialgleichung in (16) eine lineare Struktur hat. Für

gegebene a ∈ C(I; Rn×n ) definieren wir nämlich den Lösungsraum der Differentialgleichung y 0 (x) = a(x)y(x) als

Lh := y ∈ C 1 (I; Rn ) : y 0 (x) = a(x)y(x)

(d.h. Lh ist die Menge aller Lösungen der Differentialgleichung, unabhängig von der

Anfangsbedingung). Wir haben schon bewiesen, dass ein beliebiges y ∈ L die Form

y(x) = ϕ(x)y(x0 ) hat. Das impliziert offenbar, dass Lh ein Vektorraum ist. Da die

Matrix ϕ(x) invertierbar ist, folgt auch, dass y (1) , . . . , y (m) ∈ Lh genau dann linear unabhängig sind, wenn y (1) (x0 ), . . . , y (m) (x0 ) ∈ Rn linear unabhängig sind. Das impliziert,

dass dim Lh = dim Rn = n (mit anderen Worten, die Formel y(x) = ϕ(x)y(x0 ) erlaubt

uns Lh mit Rn zu identifizieren).

Die Lösung der Matrix-Gleichung (17) erlaubt uns auch inhomogene lineare Differentialgleichungen zu berechnen. Sei nämlich I ⊂ R ein Intervall, x0 ∈ I, y0 ∈ Rn ,

a ∈ C(I; Rn×n ) und b ∈ C(I; Rn ). Dann hat das Anfangswertproblem

0

y (x) = a(x)y(x) + b(x)

(20)

y(x0 ) = y0

die eindeutige Lösung

Z

y(x) = ϕ(x) y0 +

x

−1

ϕ

(t)b(t)dt

(21)

x0

wobei ϕ ∈ C 1 (I; Rn×n ) die eindeutige Lösung von (17) ist. In der Tat, aus ϕ(x0 ) = 1

folgt sofort, dass (21) die Bedingung y(x0 ) = y0 erfüllt. Weiter gilt

Z x

0

0

−1

y (x) = ϕ (x) y0 +

ϕ (t)b(t) + ϕ(x)ϕ−1 (x)b(x) = a(x)y(x) + b(x)

x0

Wir haben in (21) benutzt, dass ϕ(x) für alle x ∈ I invertierbar ist. Es folgt aus diesem

Ausdruck für die Lösung des Anfangswertproblems (20), dass der Lösungsraum der

inhomogenen linearen Differentialgleichung y 0 (x) = a(x)y(x) + b(x), definiert durch

Li = y ∈ C 1 (I; Rn ) : y 0 (x) = a(x)y(x) + b(x), für alle x ∈ I

aus

Z

x

Li = Lh + ϕ(x)

ϕ−1 (t)b(t) =

Z

x

y(x) = yh (x) + ϕ(x)

x0

ϕ−1 (t)b(t) : yh ∈ Lh

x0

gegeben ist. Allgeiner, für eine beliebige Lösung z ∈ Li , gilt Li = z + Lh . D.h. Li ist ein

affiner Raum.

Bemerke, dass es im Gegensatz zum skalaren Fall n = 1, wo die Lösung von homogenen und inhomogenen Problemen mit Trennung der Variablen und Variationen der

Konstanten immer gefunden werden kann, bei vektoriellen linearen Problemen (und also

bei Probleme höheren Ordnung) kein allgemeines Rezept gibt, um Lösungen zu finden.

Eine Ausnahme ist der Fall von linearen Gleichungen mit konstanten Koeffizienten, die

durch Konstanten a ∈ Rn×n und b ∈ Rn charakterisiert ist.

34

2.4

Lineare Differentialgleichungen mit konstanten Koeffizienten

Sei n ∈ N und A ∈ Rn×n eine festgewählte n × n Matrix. Wir betrachten die lineare

homogene Differentialgleichung mit konstanten Koeffizienten

y 0 (x) = Ay(x)

(22)

für eine unbekannte Funktion y ∈ C 1 (R; Rn ). Sei

Lh = y ∈ C 1 (R; Rn ) : y 0 (x) = Ay(x)

der Lösungsraum der Differentialgleichung (22). Wir wissen schon, dass Lh ein Vektorraum der Dimension n ist. Ist eine Basis y (1) , . . . , y (n) des Lösungsraums Lh gegeben, so

kann man die eindeutige Lösung des Anfangswertproblems

0

y (x) = Ay(x)

(23)

y(x0 ) = y0

bestimmen, indem man den Vektor y0 als eine lineare Kombination der Basisvektoren

ausdruckt:

n

X

y0 =

cj y (j) (x0 )

j=1

Das ist möglich, weil {y (j) (x0 )}nj=1 eine Basis von Rn ist. Dann ist die eindeutige Lösung

von (23) aus

n

X

y(x) =

cj y (j) (x)

j=1

gegeben.

Wie können wir nun eine Basis von Lh finden? Sei v ∈ Rn ein Eigenvektor von A

mit Eigenwert λ, d.h. Av = λv. Dann ist y(x) = veλx ∈ Lh , weil

y 0 (x) = λveλx = Aveλx = Ay(x) .

Nehmen wir nun an, dass die Matrix A n linear unabhängige Eigenvektoren v1 , . . . , vn ∈

Rn , mit Eigenwerten λ1 , . . . , λn ∈ R (nicht notwendigerweise verschiedenen), besitzt.

Dann sind die Funktionen yj (x) = vj eλj x , für j = 1, . . . , n, linear unabhängig und damit

eine Basis von Lh .

Es passiert oft, dass eine Matrix A ∈ Rn×n auf C, aber nicht auf R diagonalisierbar

ist. Sei λ = γ + iω ∈ C\R ein komplexer Eigenwert von A, mit Eigenvektor v ∈ Cn \{0};

wir zerlegen v = u + iw, mit u, w ∈ Rn . Da A reelle Einträge hat, ist auch λ = γ − iω

ein Eigenwert von A, mit Eigenvektor v = u − iw. Die zwei Funktionen

ye1 (x) = veλx = (u + iw)eiωx eγx = [(u cos ωx − w sin ωx) + i (u sin ωx + w cos ωx)] eγx

ye2 (x) = (u − iw)e−iωx eγx = [(u cos ωx − w sin ωx) − i (u sin ωx + w cos ωx)] eγx

35

sind dann komplexe Lösungen der Differentialgleichung (22). Weil wir uns vor allem für

reelle Lösungen interessieren, möchten wir ye1 und ye2 durch die reellen linearen Kombinationen

ye1 (x) + ye2 (x)

= (u cos ωx − w sin ωx) eγx

2

ye1 (x) − ye2 (x)

y2 (x) =

= (u sin ωx + w cos ωx) eγx

2i

y1 (x) =

(24)

ersetzen.

Seien also ve1 , . . . , ven ∈ Cn linear unabhängige Eigenvektoren von A, zu den Eigenwerten λ1 , . . . , λn ∈ C. Für jedes j = 1, . . . , n unterscheiden wir zwei Fälle. Sei zunächst

λj ∈ R. Dann ist mit vej auch vej ein Eigenvektor von A zum Eigenwert λ. Mindestens

einer der zwei Vektoren Re vej = (e

vj + vej )/2 und Im vej = (e

vj − vej )/2i ist nicht Null und

deswegen ein reeller Eigenvektor v ∈ Rn von A zum Eigenwert λ. Wir setzen, dann

yj (x) = veλx

Sei nun λj ∈ C\R. Dann ist mit λj auch λj ein Eigenwert von A. D.h. es existiert i 6= j

mit λi = λj . Dann setzen wir, gemäss (24),

yj (x) = (Re vj cos(Im λj ) − Im vj sin(Im λj ) eRe λj