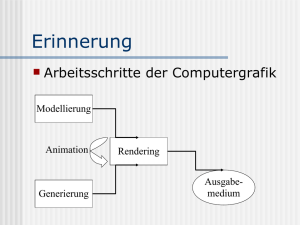

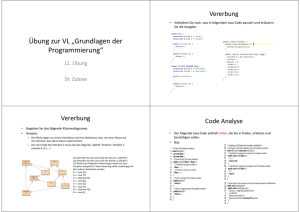

Dokumentation Gegenüberstellung vom Direct3D und Java3D

Werbung