Optimierungstheorie

Werbung

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

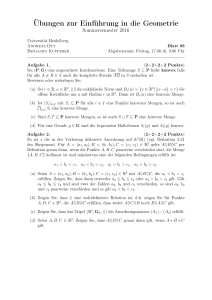

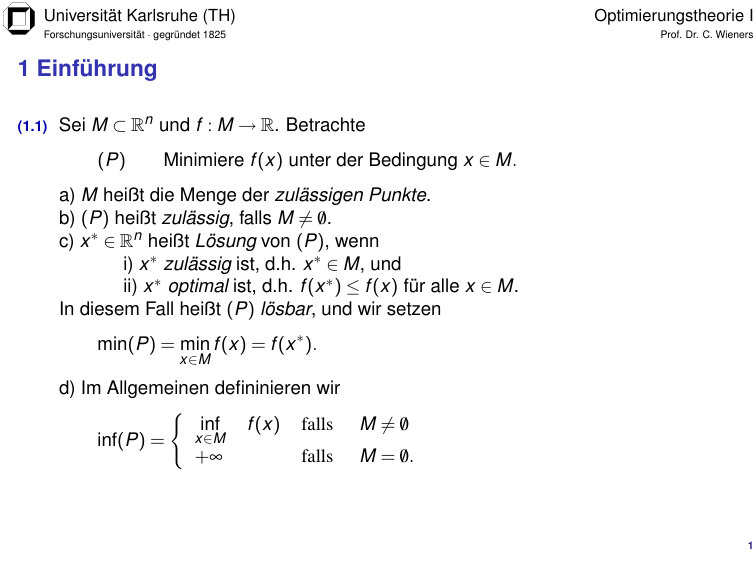

1 Einführung

(1.1)

Sei M ⊂ Rn und f : M → R. Betrachte

(P)

Minimiere f (x) unter der Bedingung x ∈ M.

a) M heißt die Menge der zulässigen Punkte.

b) (P) heißt zulässig, falls M 6= 0.

/

c) x ∗ ∈ Rn heißt Lösung von (P), wenn

i) x ∗ zulässig ist, d.h. x ∗ ∈ M, und

ii) x ∗ optimal ist, d.h. f (x ∗ ) ≤ f (x) für alle x ∈ M.

In diesem Fall heißt (P) lösbar, und wir setzen

min(P) = min f (x) = f (x ∗ ).

x∈M

d) Im Allgemeinen defininieren wir

(

inf f (x) falls

x∈M

inf(P) =

+∞

falls

M 6= 0/

M = 0.

/

1

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

2.1 Konvexe Mengen und Polyeder – Konvexe Mengen

(2.1)

(2.2)

a) Eine Menge V ⊂ Rn heißt linearer Teilraum / Unterraum, wenn

x, y ∈ V , λ , µ ∈ R

⇒

λ x + µy ∈ V .

b) Eine Menge V ⊂ Rn heißt affiner Teilraum, wenn

x, y ∈ V , λ ∈ R

⇒

(1 − λ )x + λ y ∈ V .

c) Eine Menge K ⊂ Rn heißt konvex, wenn

x, y ∈ K , λ ∈ [0, 1]

⇒

(1 − λ )x + λ y ∈ K .

d) Eine Menge C ⊂ Rn heißt Kegel, wenn

x ∈ C, λ ≥ 0

⇒

λ x ∈ C.

a) V ⊂ Rn ist genau dann ein linearer Teilraum, wenn

x i ∈ V , λi ∈ R,

m

∑ λi x i ∈ V .

⇒

i = 1, . . . , m, m beliebig

i=1

b) V ⊂ Rn ist genau dann ein affiner Teilraum, wenn

x i ∈ V , λi ∈ R,

m

i = 1, . . . , m, m beliebig,

c) K ⊂ Rn ist genau dann konvex, wenn

x i ∈ K , λi ≥ 0,

i = 1, . . . , m, m beliebig,

m

⇒

∑ λi = 1

i=1

i=1

m

m

⇒

∑ λi = 1

i=1

d) C ⊂ Rn ist genau dann ein konvexer Kegel, wenn

x i ∈ C, λi ≥ 0, i = 1, . . . , m, m beliebig

⇒

∑ λi x i ∈ V .

∑ λi x i ∈ K .

i=1

m

∑ λi x i ∈ C.

i=1

2

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

2.1 Konvexe Mengen und Polyeder – Konvexe Mengen

(2.5)

a) Ein konvexer Kegel C ⊂ Rn heißt endlich erzeugt,

wenn eine endliche Teilmenge S = {u 1 , ..., u m } ⊂ Rn existiert mit

C = cone(S) =

n

m

∑ λi u i :

o

λi ≥ 0 = {Uλ : λ ≥ 0} .

i=1

Dabei ist U

= (u 1 |...|u m ) ∈ Rn,m .

b) Eine Menge E = x ∈ Rn : aT x = γ mit a ∈ Rn , a 6= 0, und γ ∈ R

heißt (Hyper-)Ebene im Rn ,

c) Eine Menge H = x ∈ Rn : aT x ≤ γ mit a ∈ Rn , a 6= 0, und γ ∈ R

heißt abgeschlossener Halbraum.

d) Eine Menge M ⊂ Rn heißt polyedral (oder auch Polyeder), wenn sie als

Durchschnitt von endlich vielen abgeschlossenen Halbräumen darstellbar ist,

m,n und einen Vektor b ∈ Rm gibt mit

d. h. wenn es eine Matrix

A∈R

n

M = x ∈ R : Ax ≤ b .

e) Beschränkte Polyeder M ⊂ Rn heißen Polytope.

3

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

2.2 Konvexe Mengen und Polyeder – Satz von Weyl / Farkas Lemma

(2.6)

(2.7)

(2.8)

Jeder endlich erzeugte konvexe Kegel C = {Uλ : λ ≥ 0} ist polyedral

und von der Form C = {x ∈ Rn : Ax ≤ 0}.

Insbesondere sind endlich erzeugte konvexe Kegel abgeschlossen.

Sei K ⊂ Rn eine konvexe, abgeschlossene Menge, K 6= 0.

/ Dann existiert zu

jedem x ∈ Rn genau ein x ∗ ∈ K mit kx − x ∗ k ≤ kx − y k für alle y ∈ K .

x ∗ ist eindeutig durch (x − x ∗ )T (x − y ) ≤ 0 für alle y ∈ K charakterisiert.

Sei K ⊂ Rn eine konvexe, abgeschlossene Menge, K 6= 0,

/ und x ∈

/ K.

Dann existiert eine Hyperebene, die x und K trennt, d. h.

es existiert a ∈ Rn , a 6= 0, und γ ∈ R mit

aT z ≤ γ < aT x

für alle z ∈ K .

Ist K sogar ein konvexer Kegel, so kann γ = 0 gewählt werden.

(2.9)

Seien A ∈ Rm,n und b ∈ Rm gegeben.

Dann gilt genau eine der beiden folgenden Aussagen:

(i)

{x ∈ Rn : Ax = b, x ≥ 0} 6= 0/

(ii)

{y ∈ Rm : AT y ≤ 0, bT y > 0} 6= 0/

4

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

2.3 Konvexe Mengen und Polyeder – Hauptsatz der Polyedertheorie

⊂ Rn sei beliebige konvexe Menge.

a) x ∈ M heißt Ecke / Extremalpunkt von M, wenn sich x nicht als echte

Konvexkombination zweier verschiedener Punkte von M darstellen lässt,

d. h., wenn gilt:

(2.10) M

y,z ∈ M ,

λ ∈ (0, 1) ,

x = λ y + (1 − λ )z

⇒

y =z.

∈ Rn ,

b) Ein Vektor u

u 6= 0, heißt freie Richtung von M, wenn es x ∈ M gibt,

so dass der ganze Strahl {x + tu : t ≥ 0} zu M gehört.

c) Eine freie Richtung u ∈ Rn , u 6= 0, heißt extremale Richtung von M, wenn

sie sich nicht als echte Konvexkombination zweier linear unabhängiger freier

Richtungen schreiben lässt, d. h., wenn gilt:

v , w freie Richtungen, λ ∈ (0, 1) , u = λ v + (1 − λ )w

⇒

v , w linear abhängig .

Strahlen der Form S = {x + tu : t ≥ 0} ⊂ M mit Ecke x ∈ M und extremaler

Richtung u heißen Extremalstrahlen.

Mit extrP(M) bezeichnen wir die Menge aller Extremalpunkte von M.

Mit extrS(M) bezeichnen wir die Vereinigung aller Extremalstrahlen von M.

5

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

2.3 Konvexe Mengen und Polyeder – Hauptsatz der Polyedertheorie

Polyeder M = {x ∈ Rn : Ax ≤ b} hat nur endlich viele Ecken.

I ⊂ {1, ..., m}, I 6= 0.

/ Dann heißt MI = {x ∈ M : (Ax)i = bi für i ∈ I} eine

Seite von M.

(2.13) Es gilt extrP(MI ) ⊂ extrP(M) und extrS(MI ) ⊂ extrS(M).

(2.15) Für den relativen Rand

(2.11) Ein

(2.12) Sei

∂rel M = {x ∈ Rn : Bε (x) ∩ M 6= 0/ und Bε (x) ∩ (affine M \ M) 6= 0/ für alle ε > 0}

eines Polyeders gilt

o

[ n

∂rel M ⊂

MI : I ⊂ {1, ..., n}, dim MI < dim M .

(2.16) Sei

M ⊂ Rn konvex, M 6= 0.

/ Dann ist das relative Innere

intrel M = {x ∈ M : es exisitert ein ε > 0 mit Bε (x) ∩ affine M ⊂ M}

nicht leer.

(2.18) Sei M ⊂ Rn konvex, M 6= 0

/ und M geradenfrei. Dann gilt M ⊂ conv ∂rel M.

(2.19) Sei M ⊂ Rn ein geradenfreies Polyeder. Dann ist

M = conv extrP(M) ∪ extrS(M) .

(2.20) Jedes (nichtleere) Polytop M ist die konvexe Hülle seiner Ecken.

(2.21) Ein (nichtleerer) Polyeder M ist genau dann geradenfrei, wenn er Ecken

besitzt.

6

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

3 Existenz- und Dualitätstheorie für Lineare Programme

(3.1)

Seien A ∈ Rm,n , b ∈ Rm und c ∈ Rn gegeben. Betrachte

Minimiere c T x auf M := {x ∈ Rn : Ax = b, x ≥ 0} .

Wenn µ ∗ := inf c > x : x ∈ M > −∞, dann gilt:

a) Wenn (P) zulässig ist (d.h. M 6= 0),

/ dann ist (P) auch lösbar.

b) Falls (P) lösbar ist, so existiert auch eine Ecke als Lösung.

Das duale Problem zu (P) lautet

(D)

Maximiere bT y auf N := y ∈ Rm : A> y ≤ c .

(P)

(3.4)

Sei x ∈ M und y ∈ N. Dann gilt bT y ≤ c T x.

(3.6)

a) (P) und (D) zulässig ⇒ (P) und (D) lösbar und min(P) = max(D)

b) (P) zulässig und (D) nicht zulässig ⇒ inf(P) = −∞.

c) (D) zulässig und (P) nicht zulässig ⇒ sup(D) = ∞

(3.7)

Primale Lösungen x ∗ und duale Lösungen y ∗ sind komplementär:

xk∗ = 0 oder (AT y ∗ − c)k = 0 für k = 1, ..., n.

7

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

4.1 Anwendungen in der Linearen Optimierung – Flussprobleme

(4.1)

a) Eine Kapazitätsmatrix C = (cij ) ∈ Rn,n mit cij ≥ 0 beschreibt einen Graphen

mit Knoten 1, ..., n und Kanten {(i, j) : cij > 0} mit den Eigenschaften

1) cij cji = 0, cii = 0

2) ci1 = 0, cnj = 0

n

3)

n

∑ cij > 0, j = 2, ..., n und ∑ cij > 0, i = 1, ..., n − 1

i=1

j=1

b) Ein Fluss X = (xij ) ∈ Rn,n zu C ist eine Matrix mit 0 ≤ xij ≤ cij und

n

∑ xij

n

=

i=1

für alle j = 2, . . . , n − 1 .

∑ xjk

k =1

n

c) W (X ) = ∑ x1j heißt Wert des Flusses.

j=1

n

(4.1)

n

Für einen Fluss gilt ∑ x1j = ∑ xkn

j=1

k =1

Netzwerksflussoptimierungsproblem

n

Maximiere W (X ) =

n

n

∑ xkn unter 0 ≤ xij ≤ cij und ∑ xij = ∑ xjk , j = 2, ..., n − 1.

k =1

i=1

k =1

8

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

4.1 Anwendungen in der Linearen Optimierung – Flussprobleme

(4.3)

Ein Schnitt (J − , J + ) ist eine Zerlegung J + ∪ J − = {1, . . . , n} mit J + ∩ J − = 0,

/

1 ∈ J − , n ∈ J + . Die Kapazität eines Schnittes ist K (J − , J + ) :=

cij .

∑

(i,j)∈J − ×J +

(4.4)

Für jeden Schnitt

W (X ) =

(J − , J + )

∑

(i,j)∈J − ×J +

(4.5)

(4.6)

und jeden Fluss X gilt

xij −

∑

Max-Flow-Min-Cut:

max W (X ) : X Fluss = min K (J − , J + ) : (J − , J + ) Schnitt

Ein ungesättigter Pfad vom Knoten j zum Knoten k ist ein Indexvektor

(p1 , . . . , pm ) mit pi ∈ {1, . . . , n}, i = 1, . . . , m, p1 = j, pm = k , und für jedes

i = 1, . . . , m − 1 gilt:

a) xpi pi+1 < cpi pi+1 falls cpi pi+1 > 0,

(4.7)

xji ≤ K (J − , J + ) .

(i,j)∈J − ×J +

b) xpi+1 pi > 0 falls cpi pi+1 = 0 .

Sei X ein maximaler Fluss, und setze

J − := {1} ∪ k ∈ {2, . . . , n} : es gibt einen ungesättigten Pfad von 1 nach k .

Dann gilt: n 6∈ J − , (J − , J + ) mit J + = {1, ..., n} \ J − ist ein Schnitt, und

W (X ) = K (J − , J + ).

9

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

4.1 Anwendungen in der Linearen Optimierung – Flussprobleme

Algorithmus von Ford-Fulkerson

S0) Wähle Fluss X

(z. B. X = 0)

S1) J − = {1}

S2) Wähle (j, k ) mit j ∈ J − , k ∈

/ J−

mit xjk < cjk falls cjk > 0 oder xkj > 0 falls cjk = 0

falls kein solches (j, k ) existiert: STOP (X maximal)

S3) J − := J − ∪ {k } falls n ∈

/ J − gehe zu S2)

S4) Erzeuge Pfad (p1 , . . . , pm ) mit p1 = 1, pm = n, pi ∈ J − und bestimme

d > 0 mit

n

o n

o

d = min cpi pi+1 − xpi pi+1 : cpi pi+1 > 0 ∪ xpi+1 pi : cpi pi+1 = 0

S5) setze xpi pi+1 := xpi pi+1 + d für cpi pi+1 > 0

xpi+1 pi := xpi+1 pi − d für cpi pi+1 = 0

gehe zu S1)

10

Universität Karlsruhe (TH)

Forschungsuniversität · gegründet 1825

Optimierungstheorie I

Prof. Dr. C. Wieners

4.2 Anwendungen in der Linearen Optimierung – Matrix-Spiele

(4.8)

Ein Matrix-Spiel zweier Personen PA und PB wird durch A ∈ Rm,n bestimmt,

wobei aij ausgezahlt wird, falls PA den Spielzug j und und PB den Spielzug i

ausführt.

Seien MA = {x ∈ Rn : eT x = 1, x ≥ 0} und MB = {y ∈ Rm : eT y = 1, y ≥ 0}

zulässige Strategien. Dann ist Φ(x, y ) = y T Ax die erwartete mittlere

Auszahlung.

(4.9)

Es gilt maxy ∈MB Φ(x, y ) = maxi=1,...,m (Ax)i für festes x ∈ Rm .

Es gilt minx∈MA Φ(x, y ) = minj=1,...,n (AT y )j für festes y ∈ Rm .

gibt optimale Strategien x ∗ ∈ MA und y ∗ ∈ MB mit

Φ(x ∗ , y ) ≤ Φ(x ∗ , y ∗ ) ≤ Φ(x, y ∗ ) für alle x ∈ MA und y ∈ MB .

Es gilt Φ(x ∗ , y ∗ ) = minx∈MA maxy ∈MB Φ(x, y ) = maxy ∈MB minx∈MA Φ(x, y ).

Falls der Wert des Spiels Φ(x ∗ , y ∗ ) = 0 ist, heißt das Spiel fair.

(4.10) Es

(4.11) Falls

A = −AT schiefsymmetrisch, so ist der Wert der Spiels Φ(x ∗ , y ∗ ) = 0.

(4.12) Falls

minj=1,...,n maxi=1,...,m aij = maxi=1,...,m minj=1,...,n aij , so heißt das Spiel

Sattelpunkt-Spiel.

besitzen eine optimale reine Strategie x ∗ = es und y ∗ = er

mit ars = minj=1,...,n maxi=1,...,m aij .

(4.13) Sattelpunkt-Spiele

11

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

5 Das Simplex-Verfahren

Seien A ∈ Rm,n , b ∈ Rm und c ∈ Rn gegeben. Betrachte

(P)

(5.1)

(5.2)

(5.3)

Minimiere c T x auf M := {x ∈ Rn : Ax = b, x ≥ 0} .

Zu J ⊂ {1, ..., n} definiere AJ = (a∗j )j∈J . Sei AJ invertierbar. Dann heißt

x ∈ Rn mit xJ = A−1

J b und xk = 0 für k 6∈ J ein Basislösung, und wenn x ∈ M

ist, heißt x zulässige Basislösung. Sie heißt nicht entartet, wenn xJ > 0 ist.

Sei (P) zulässig und beschränkt. Dann ist (P) lösbar, und es existiert eine

zulässige Basislösung als Lösung von (P).

Jede zulässige Basislösung z ∈ M ist Ecke des Polyeders M.

Sei j = (j1 , ..., jm ) ein Pivotvektor, d. h. jk ∈ {1, ..., n} und ji 6= jk für i 6= k .

Sei rang A = m. Dann existiert eine Darstellung

{x ∈ Rn : Ax = b} = {x ∈ Rn : Âx = b̂} mit Â(j) = Im .

Gauß-Jordan-Verfahren: für k = 1, ..., m

S1) wähle j = jk ∈ {j1 , ..., jk −1 } mit akj 6= 0

S2) für i 6= k eliminiere Spalte j durch ail := ail − (aij /akj )akl für l = 1, ..., n

für i 6= k setze bi := bi − (aij /akj )bk ;

normiere die Zeile k durch akl := akl /akj für l = 1, ..., n und bk := bk /akj

12

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

5 Das Simplex-Verfahren

Phase I

Konstruiere einen Pivotvektor ĵ zu Ax = b mit Basislösung ẑ, einen Vektor

ĉ ∈ Rn und eine Darstellung M = {x ∈ Rn : Âx = b̂, x ≥ 0} von M mit

i) Ist ĵ = (j1 , . . . , jm ), so ist â∗jk = ek für k = 1, . . . , m,

ii) ĉjk = 0 für alle k = 1, . . . , m (also auch ĉ T ẑ = 0), und b̂ ≥ 0,

iii) f (x) = ĉ T x + f (ẑ) für alle x mit Ax = b. Setze γ̂ = f (ẑ).

Phase II

S1) Falls ĉ ≥ 0 STOP (ẑ optimal)

S2) Wähle s 6∈ J(ĵ) mit ĉs < 0.

S3) Falls â∗s ≤ 0 STOP (inf(P) = −∞)

S4) Wähle r mit ârs > 0 und b̂r /ârs ≤ b̂i /âis für i ∈ {1, ..., m} mit âis > 0.

S5) Definiere j̃ mit j̃k = ĵk für k 6= r und j̃r = s

S6) Gauß-Jordan-Schritt: für l = 1, ..., n, i 6= r , k = 1, ..., m setze ãrl = ârl /ârs ,

b̃r = b̂r /ârs , ãil = âil − âis ãrl , b̃i = b̂i − âis b̃r , c̃l = ĉl − ĉs ãrl , −γ̃ = −γ̂ − ĉs b̃r ,

z̃j̃ = b̃k und z̃l = 0 für l 6∈ J(j̃)

k

S7) Â = Ã, b̂ = b̃, ĉ = c̃, ẑ = z̃, γ̂ = γ̃, gehe zu S1)

13

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

5 Das Simplex-Verfahren

(5.4)

a) Für jedes x gilt: Ãx = b̃ ⇐⇒ Âx = b̂ ⇐⇒ Ax = b.

b) ĉ T x + γ̂ = c̃ T x + γ̃ für alle x ∈ Rn mit Ax = b.

c) z̃, j̃ ist zulässige Basislösung zu Ãx = b̃, für die 1), 2), 3) erfüllt sind.

Es ist ãrs = 1 und γ̃ = c T z̃ = f (z̃). Insbesondere ist (P) äquivalent zu

(P̂)

Minimiere ĉ T x + γ̂

auf M = {x ∈ Rn : Âx = b̂ , x ≥ 0} ,

und dies äquivalent zu

(P̃)

Minimiere c̃ T x + γ̃

auf M = {x ∈ Rn : Ãx = b̃ , x ≥ 0} .

d) f (z̃) = c T z̃ = γ̃ = ĉj b̂i /âij + γ̂ ≤ γ̂ = c T ẑ = f (ẑ).

e) Ist ĉ ≥ 0, so ist c T x ≥ c T ẑ für alle x ∈ M, d.h. ẑ ist optimal.

f) Ist ĉs < 0 und â∗s ≤ 0, so ist ĉ T x auf M nicht beschränkt, d.h. inf(P) = −∞.

14

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

5 Das Simplex-Verfahren

Pivot-Regel von Bland

i) Pivot-Spalte ist die Spalte s = min l : ĉl < 0 .

Sei qs = min{b̂i /âis : âis > 0}.

ii) Pivot-Zeile ist die Zeile r mit jr = min{ji : âis > 0 und b̂i /âis = qs }.

(5.5)

Das Simplex-Verfahren mit der Pivot-Regel von Bland wiederholt kein

Tableau.

Phase I

(PI )

(5.6)

Sei e = (1, 1, . . . , 1)> ∈ Rm , und sei o.E. b ≥ 0.

Minimiere eT (b − Ax) unter

Ax ≤ b , x ≥ 0 ,

(PI ) ist zulässig, und (P) ist genau dann zulässig, wenn min(PI ) = 0.

m

m

− ∑ ai1

− ∑ ai2

···

c1

a11

..

.

am1

c2

a12

..

.

am2

···

···

i=1

i=1

m

− ∑ ain

0

cn

a1n

..

.

amn

0

1

..

.

0

···

m

0

i=1

···

− ∑ bi

i=1

···

···

..

.

···

0

0

..

.

1

0

b1

..

.

bm

15

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

5 Das revidierte Simplex-Verfahren

(5.7)

Sei ẑ Basislösung zum Pivot-Vektor j, und sei k = (k1 , . . . , kn−m ) ein

Komplement von j, d. h. {j1 , . . . , jm } ∪ {k1 , . . . , kn−m } = {1, . . . , n}. Dann gilt:

a) A(j) ∈ Rm×m ist regulär, ẑ(j) = A(j)−1 b, ẑ(k ) = 0, Â = A(j)−1 A.

T

b) ĉ(k ) = c(k ) − A(j)−1 A(k ) c(j) .

Phase II

S0) Starte mit ẑ(ĵ) = A(ĵ)−1 b, γ̂ = c(ĵ)T A(ĵ)−1 b. Speichere A(ĵ)−1 ∈ Rm,m .

S1) Setze y := A(ĵ)−T c(ĵ), d = A(k̂ )T y . Falls d ≤ c(k̂ ) STOP (ẑ optimal)

S2) Bestimme Index ks ∈ {k1 , . . . , kn−m } mit ds > cks .

S3) Berechne w = A(ĵ)−1 a∗ks . Falls w ≤ 0 STOP (inf(P) = −∞)

S4) Bestimme r ∈ {1, . . . , m} mit ẑjr /wr = min ẑjr /wl : wl > 0 .

S5) Setze j̃ = (j1 , . . . , jr −1 , s, jr +1 , . . . , jm ), bestimme Komplement k̃ von j̃, setze

!

ẑj

(w − er )(er )T

−1

A(ĵ)−1 , z̃(j̃) = A(j̃)−1 b , γ̃ = γ̂ + r cks − ds

A(j̃) = I −

wr

wr

S6) Update ĵ = j̃ gehe zu S1).

16

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

6.1 Konvexe Optimierung – Konvexe Funktionen

(6.1)

Sei D ⊂ Rn konvex.

a) Eine Funktion f : D → R heißt konvex, wenn für alle x, y ∈ D, t ∈ [0, 1] gilt

f tx + (1 − t)y ≤ t f (x) + (1 − t)f (y ) .

b) f heißt strikt konvex, wenn für alle x, y ∈ D, x 6= y und alle t ∈ (0, 1) gilt:

f tx + (1 − t)y < t f (x) + (1 − t)f (y ) .

c) f heißt gleichmäßig konvex, wenn es c0 > 0 gibt, so dass für alle x, y ∈ D,

t ∈ [0, 1] gilt

f tx + (1 − t)y + c0 t(1 − t) kx − y k2 ≤ t f (x) + (1 − t)f (y ) .

(6.2)

Sei D ⊂ Rn offen und konvex, f : D → R zweimal stetig differenzierbar.

Dann gilt: f ist gleichmäßig konvex auf D

⇐⇒

(1) es ex. c0 > 0 mit f (x) − f (y ) ≥ Df (y )(x − y ) + c0 kx − y k2 ∀x, y ∈ D

(2) es ex. c0 > 0 mit Df (x) − Df (y ) (x − y ) ≥ 2c0 kx − y k2 ∀x, y ∈ D

⇐⇒

(3) es ex. c0 > 0 mit z T D 2 f (x) z ≥ 2c0 kzk2

⇐⇒

∀x ∈ D , z ∈ Rn

17

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

6.2 Konvexe Optimierung – Existenz und Eindeutigkeit

Seien K ⊂ Rn konvex, f : K −→ R, gi : K −→ R konvex (i = 1, . . . , p),

A ∈ Rm×n , b ∈ Rm . Betrachte

(P)

Minimiere f (x) auf M := x ∈ Rn : x ∈ K , g(x) ≤ 0, Ax = b .

(6.3)

Sei M ⊂ Rn konvex, f : M → R konvex und x ∗ ein lokales Minimum von f auf

M, d.h. es existiert ε > 0 mit f (x ∗ ) ≤ f (x) für alle x ∈ M mit kx − x ∗ k ≤ ε.

Dann ist x ∗ sogar globales Minimum, d.h. f (x ∗ ) ≤ f (x) für alle x ∈ M.

(6.4)

Es sei M 6= 0,

/ inf(P) > −∞ und

Λ := (f (x) + r , g(x) + z, Ax − b) ∈ R × Rp × Rm : r ≥ 0, z ≥ 0, x ∈ K

sei abgeschlossen. Dann besitzt (P) eine Lösung.

(6.5)

Ist M 6= 0/ und f strikt konvex, so besitzt (P) höchstens eine Lösung.

(6.6)

Sei D ⊂ Rn offen und konvex, und sei f : D −→ R konvex. Dann ist f stetig.

(6.7)

Sei M 6= 0,

/ M abgeschlossen, und sei f gleichmäßig konvex.

Dann ist (P) eindeutig lösbar.

18

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

6.3 Konvexe Optimierung – Das duale Problem

Seien K ⊂ Rn konvex, f : K −→ R, gk : K −→ R konvex (k = 1, . . . , p),

A ∈ Rm×n , b ∈ Rm .

(P)

Minimiere f (x) auf M := x ∈ Rn : x ∈ K , g(x) ≤ 0, Ax = b .

Definiere

Λ := (f (x) + r , g(x) + z, Ax − b) ∈ R × Rp × Rm : r ≥ 0, z ≥ 0p , x ∈ K .

(P̃)

Minimiere φ (β , u, v ) := β

unter (β , u, v ) ∈ Λ ∩ R × {0p } × {0m } .

Definiere den Halbraum

H(γ, u, v ) := (t, w, z) ∈ R × Rp × Rm : t + u T w + v T z ≥ γ .

Maximiere ψ(γ, u, v ) := γ unter Λ ⊂ H(γ, u, v ) .

Setze F (u, v ) = inf f (x) + u T g(x) + v T (Ax − b) .

(D̃)

x∈K

(D) Maximiere F (u, v ) auf N =

(u, v ) ∈ Rp × Rm : u ≥ 0 , F (u, v ) > −∞ .

19

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

6.4 Konvexe Optimierung – Dualitätssätze

alle x ∈ M und (u, v ) ∈ N gilt f (x) ≥ F (u, v ) .

Ist f (x ∗ ) = F (u ∗ , v ∗ ) für x ∗ ∈ M, (u ∗ , v ∗ ) ∈ N, so sind x ∗ und (u ∗ , v ∗ ) optimal.

(6.12) Für

(6.13) Es

sei K = Rn , f , g seien stetig, und es gelte die Slaterbedingung (SB):

(SB1) rang A = m ≤ n,

(SB2) es gibt x̂ ∈ Rn mit Ax̂ = b und gk (x̂) < 0 für k = 1, . . . , p .

Das Problem (P) sei lösbar durch x ∗ ∈ M. Dann gibt es auch eine Lösung

(u ∗ , v ∗ ) ∈ N von (D) mit f (x ∗ ) = F (u ∗ , v ∗ ) und uk∗ gk (x ∗ ) = 0 für k = 1, . . . , p.

(6.14) Lagrangefunktion

L(x, u, v ) := f (x) + u T g(x) + v T (Ax − b)

x∗

Sei

∈ M optimal für (P) und die Slaterbedingung (SB) sei erfüllt.

Dann existieren u ∗ ∈ Rp , v ∗ ∈ Rn mit u ∗T g(x ∗ ) = 0 und

(6.15) a)

L(x ∗ , u, v ) ≤ L(x ∗ , u ∗ , v ∗ ) ≤ L(x, u ∗ , v ∗ )

p

für alle x ∈ Rn , u ∈ R≥0 , v ∈ Rm .

p

b) Falls (x ∗ , u ∗ , v ∗ ) ∈ Rn × R≥0 × Rm ein Sattelpunkt von L ist,

so ist x ∗ Lösung von (P) und (u ∗ , v ∗ ) Lösung von (D).

seien f : Rn → R, gk : Rn → R, k = 1, . . . , p, konvex und differenzierbar, und

die Slaterbedingung (SB) sei erfüllt. Dann gilt: x ∗ ∈ M ist genau dann eine

p

Lösung von (P), wenn es u ∗ ∈ R≥0 und v ∗ ∈ Rm gibt mit

(6.17) Es

Df (x ∗ ) + u ∗T Dg(x ∗ ) + v ∗T A = 0

und

uk∗ gk (x ∗ ) = 0 k = 1, . . . , p .

20

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

7.1 Differenzierbare Optimierung – Lagrangesche Multiplikatoren

(7.2)

(7.4)

Sei h : Rn → Rm stetig differenzierbar und h(x̂) = 0. Die Funktionalmatrix

Dh(x̂) ∈ Rm,n habe den Rang m (also insbesondere m ≤ n). Sei ferner z ∈ Rn

mit Dh(x̂)z = 0.

Dann existiert δ > 0 und eine stetig differenzierbare

Funktion r : (−δ , δ ) → Rn

mit r (0) = 0 und r 0 (0) = 0 und h x̂ + tz + r (t) = 0 für alle t ∈ (−δ , δ ).

Sei D ⊂ Rn offen, f : D −→ R, g : D −→ Rp , h : D −→ Rm stetig differenzierbar,

und sei x ∗ ein (lokales) Minimum von f auf der Menge

M = x ∈ D : g(x) ≤ 0 , h(x) = 0 .

Es gelte die constraint qualification

(CQ1)

(i)

(ii)

Rang Dh(x ∗ ) = m ≤ n ,

es gibt ẑ ∈ Rn mit g(x ∗ ) + Dg(x ∗ )ẑ < 0 und Dh(x ∗ )ẑ = 0 .

Dann existiert (u ∗ , v ∗ ) ∈ Rp × ∈ Rm , so dass (x ∗ , u ∗ , v ∗ ) in KKT-Punkt ist, d. h.

a)

∇x L(x ∗ , u ∗ , v ∗ ) = ∇f (x ∗ ) + Dg(x ∗ )u ∗ + Dh(x ∗ )v ∗ = 0 ,

b)

g(x ∗ ) ≤ 0,

c)

h(x ∗ ) = 0 .

u ∗ ≥ 0,

g(x ∗ )T u ∗ = 0 ,

21

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

7.2 Differenzierbare Optimierung

Ordnung

– Bedingungen zweiter

(7.6)

Sei x ∗ ∈ M optimal, und sei I(x ∗ ) = i ∈ {1, . . . , p} : gi (x ∗ ) = 0 die Menge der

aktiven Indizes mit q = |I|. Dann folgt (CQ1) aus

DgI (x ∗ )

(CQ2)

Rang

= q +m .

∗

Dh(x )

(7.7)

Notwendige Optimalitätsbedingung 2. Ordnung: Sei x ∗ lokales Minimum von

f auf M, und sei (CQ2) erfüllt. Es seien zusätzlich f , g und h zweimal stetig

differenzierbar in x ∗ . Dann existiert (u ∗ , v ∗ ) ∈ Rp × ∈ Rm , so dass (x ∗ , u ∗ , v ∗ )

in KKT-Punkt

ist. Zusätzlich gilt auf dem Unterraum

V = z ∈ Rn : Dh(x ∗ )z = 0 , Dgi (x ∗ )z = 0 für alle i ∈ I(x ∗ )

z > Dx2 L(x ∗ , u ∗ , v ∗ ) z ≥ 0

(7.8)

für alle z ∈ V .

Hinreichende Optimalitätsbedingung

2. Ordnung:

(x ∗ , u ∗ , v ∗ ) sei ein

+ = i ∈ I(x ∗ ) : u ∗ > 0 definiere den Kegel

KKT-Punkt,

und

zu

I

i

K = z ∈ Rn : Dh(x ∗ )z = 0 , Dgi (x ∗ )z = 0 für i ∈ I + , Dgi (x ∗ )z ≤ 0 für i ∈

I \ I + . Zusätzlich gelte

z > Dx2 L(x ∗ , u ∗ , v ∗ )z > 0

Dann ist

x∗

für alle z ∈ K , z 6= 0 .

striktes lokales Minimum von f auf M.

22

Universität Karlsruhe (TH)

Optimierungstheorie I

Forschungsuniversität · gegründet 1825

Prof. Dr. C. Wieners

8 Quadratische Optimierung

(8.1)

(8.2)

Seien Q ∈ Rn,n , A ∈ Rm,n , c ∈ Rn , b ∈ Rm . Betrachte

1

(P) Minimiere f (x) := x T Qx + c T x auf M := x ∈ Rn : x ≥ 0, Ax = b

2

Sei (P) zulässig und inf(P) > −∞. Dann ist (P) lösbar.

Betrachte das lineare Optimierungsproblem (mit Q = 0).

Dann existiert y ∗ ∈ Rm mit

c + AT y ∗ ≥ 0,

i)

(8.3)

a) Sei

i)

x∗

ii)

(c + AT y ∗ )T x ∗ = 0 .

∈ M Lösung von (P). Dann gibt es y ∗ ∈ Rm mit

Qx ∗ + c + AT y ∗ ≥ 0

(Qx ∗ + c + AT y ∗ )T x ∗ = 0 .

ii)

x∗

(8.4)

b) Sei Q symmetrisch und positiv semidefinit,

∈ M, und es gebe y ∗ ∈ Rm

∗

mit i), ii). Dann ist x Lösung von (P).

Betrachte

1

(P2 ) Minimiere f (x) := x T Qx + c T x auf M := x ∈ Rn : Ax ≤ b .

2

a) Sei x ∗ ∈ M Lösung von (P2 ). Dann gibt es u ∗ ∈ Rm mit u ∗ ≥ 0 und

i)

Qx ∗ + c + AT u ∗ = 0

ii)

(b − Ax ∗ )T u ∗ = 0 .

b) Sei Q symmetrisch und positiv semidefinit, x ∗ ∈ M, und es gebe u ∗ ∈ Rm

mit u ∗ ≥ 0 und i), ii). Dann ist x ∗ Lösung von (P2 ).

23