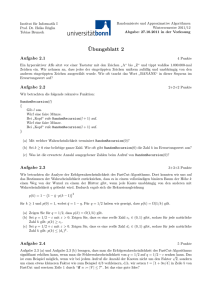

Lösung

Werbung

Lösung

Lösung 20

(a) Sei f (r) = ln r und g(r) = r − 1. Dann folgt f (r) ≤ g(r) für jedes nichtnegative r aus den

folgenden Gründen:

• f und r sind zweifach stetig differenzierbar

• f (1) = 0 = g(1),

• f ′ (1) = 1 = g ′ (1),

• f ′′ (r) = − r12 ≤ 0 = g ′′ (r) für jedes nichtnegative r

(b)

Qn

n

Y

g(xi | h)

g(xi | h)

L(K | h)

= ln Qni=1

ln

= ln

L(K | h0 )

g(xi | h0 )

i=1 g(xi | h0 )

i=1

n

n

X

X g(xi | h)

g(xi | h)

ln

=

≤

−1 .

g(xi | h0 )

g(xi | h0 )

i=1

i=1

(c)

Xn

i=1

X

X

X

g(x | h)

g(x | h) X

g(xi | h)

=

=

·

x∈X

1≤i≤n

1≤i≤n 1

x∈X

#(K, xi )

xi =x #(K, x)

xi =x

#(K,x)6=0 #(K, x)

X

X

g(x | h)

=

· #(K, x) =

g(x | h) ≤ 1 .

x∈X

x∈X

#(K,x)6=0 #(K, x)

#(K,x)6=0

(d)

X

n n X

g(xi | h)

L(K | h)

g(xi | h)

n·

ln

≤

−1 =

−1

L(K | h0 )

g(xi | h0 )

#(K, xi )

i=1

i=1

=n·

n

X

g(xi | h)

−n ≤ n·1−n= 0 .

#(K,

xi )

i=1

L(K|h)

≤ 1, also L(K | h) ≤ L(K | h0 ). Da das für jede Hypothese h gilt, ist

Daher ist L(K|h

0)

h0 = argmaxh∈H L(K | h).

Lösung 21 Diese Schätzung ist aus zweierlei Gründen nicht realistisch. Erstens gibt es bei

kleinen Korpora große Streuungen. Das heißt, dass der Korpus stark von der eigentlichen Wahrscheinlichkeitsverteilung abweichen kann. Die Stärke der Streuungen nimmt mit wachsender Korpuslänge ab: je größer der Korpus desto genauer bildet er die eigentliche Verteilung ab. Somit

ist die Schätzung bei dem Korpus mit 100 Würfen (und davon 80 Mal Kopf) als realistischer

einzuschätzen.

Grob gesagt liegt das daran, dass die Binomialverteilung (siehe Aufgabe) für wachsende n

zunehmend schmaler wird: der Hügel“ in dem Diagramm auf Folie 33 der 5. Vorlesung wird

”

zunehmend schmaler für eine wachsende Anzahl an Würfen.

3

Zweitens nimmt die MLE an, dass der Prior uniform ist. Normalerweise weiß man aber, dass

eine Münze meist fair ist und nur gering von einer idealen Münze abweicht. Münzen, die stark

von einer fairen Münzen abweichen, sind sehr unwahrscheinlich. Ein realistischer Prior wäre also

nicht uniform. Nutzt man einen solchen nichtuniformen Prior, dann wird die Schätzung nicht bei

P (Kopf) = 0.8 liegen, sondern näher an 0.5.

Lösung 22

(a) Die Menge der Beobachtungen ist S = {1, . . . , 6}. Die Menge der Hypothesen ist die Menge

aller Wahrscheinlichkeitsfunktionen f auf {1, . . . , 6}, also

X6

H = f : {1, . . . , 6} → [0, 1] |

x=1

f (x) = 1 .

Die bedingte Wahrscheinlichkeitsfunktion ordnet dann jeder Hypothese die entsprechende Wahrscheinlichkeitsfunktion zu, also

g(x | f ) = f (x) .

(für jedes x ∈ {1, . . . , 6} und f ∈ H)

Das Problem ist offensichtlich unbeschränkt, da es zu jeder möglichen Wahrscheinlichkeitsfunktion auf {1, . . . , 6} eine entsprechende Hypothese gibt. Für einen Korpus K = x1 , . . . , xn über

{1, . . . , 6} ist der Maximum Likelihood Estimator die Verteilung f0 , so dass

f0 (x) =

#(K, x)

.

n

(für jedes x ∈ {1, . . . , 6})

(b) Die Menge der Beobachtungen ist offensichtlich {Kopf, Zahl} × {Kopf, Zahl}. Wir wissen

nichts weiter über die beiden Münzen als dass sie unabhängig sind.

Bevor wir die Menge der Hypothesen und die zugehörige bedingte Wahrscheinlichkeitsverteilung definieren, stellen wir folgende Überlegung an. Angenommen, wir werfen beide Münzen

einmal. Z1 und Z2 seien die Zufallsvariablen

• Z1 =

die erste Münze zeigt . . .“ über {Kopf, Zahl},

”

• Z2 = die zweite Münze zeigt . . .“ über {Kopf, Zahl}.

”

Da die beiden Münzen unabhängig sind, gilt für jedes z1 , z2 ∈ {Kopf, Zahl} und jede Hypothese

h ∈ H, dass P (Z1 = z1 , Z2 = z2 | Y = h) = P (Z1 = z1 | Y = h) · P (Z2 = z2 | Y = h).

Sehen wir uns jetzt die Zufallsvariablen X1 , . . . , Xn zu dem Korpus x1 , . . . , xn an. Jede dieser

Zufallsvariablen hat die gleiche bedingte Wahrscheinlichkeitsfunktion

g(x | h) (wir nahmen

ja

an, dass diese bedingt iid unter Y sind). Dann ist g (z1 , z2 ) | h = P Xi = (z1 , z2 ) | Y = h für

jedes z1 , z2 ∈ {Kopf, Zahl}.

Es ist leicht zu sehen, dass P Xi = (z1 , z2 ) | Y = h = P (Z1 = z2 , Z2 = z2 | Y = h ist.

Setzen wir das alles zusammen, dann gilt also

g (z1 , z2 ) | h = P (Z1 = z1 | Y = h) · P (Z2 = z2 | Y = h) .

Sei g1 die bedingte Wahrscheinlichkeitsfunktion von Z1 unter Y und entsprechend g2 von Z2

unter Y ; dann ist g also wie folgt dekomponierbar:

g (z1 , z2 ) | h = g1 (z1 | h) · g2 (z2 | h) .

g1 steht für die möglichen Wahrscheinlichkeitsverteilungen der ersten Münze und g2 für die

möglichen Wahrscheinlichkeitsverteilungen der zweiten Münze. Beide Münzen sollen beliebig sein

4

und jede der beiden Münzen kann eine andere Wahrscheinlichkeitsverteilung annehmen. Demnach

soll unsere Hypothesenmenge jede Kombination von Wahrscheinlichkeitsfunktionen f1 , f2 für die

beiden Münzen umfassen. Dann ist

H = (f1 , f2 ) | fi : {Kopf, Zahl} → [0, 1], fi (Kopf) + fi (Zahl) = 1 ,

und g (z1 , z2 ) | (f1 , f2 ) = f1 (z1 ) · f2 (z2 ).

Dieses MLE-Problem ist nicht unbeschränkt. Der Korpus K = (Kopf, Kopf), (Zahl, Zahl) hat

die relativen Häufigkeiten

# K, (Kopf, Kopf)

# K, (Kopf, Zahl)

= 0.5 ,

=0,

2

2

# K, (Zahl, Zahl)

# K, (Zahl, Kopf)

=0,

= 0.5 .

2

2

Es ist leicht zu sehen, dass es keine Hypothese (f1 , f2 ) gibt, die diese relative Häufigkeit repräsentiert.

Lösung 23

(a)

Y

#(K3 ,x)

L K3 | (h1 , h2 ) =

g3 x | (h1 , h2 )

x∈S3

Y

#(K3 ,(z1 ,z2 ))

=

g3 (z1 , z2 ) | (h1 , h2 )

(z1 ,z2 )∈S1 ×S2

Y

#(K3 ,(z1 ,z2 ))

=

g1 (z1 | h1 ) · g2 (z2 | h2 )

(z1 ,z2 )∈S1 ×S2

Y

=

g1 (z1 | h1 )#(K3 ,(z1 ,z2 )) · g2 (z2 | h2 )#(K3 ,(z1 ,z2 ))

(z1 ,z2 )∈S1 ×S2

Y

Y

g2 (z2 | h2 )#(K3 ,(z1 ,z2 ))

g1 (z1 | h1 )#(K3 ,(z1 ,z2 )) ·

=

(z1 ,z2 )∈S1 ×S2

(z1 ,z2 )∈S1 ×S2

=

Y

=

Y

g1 (z1 | h1 )

Y

Y

g1 (z1 | h1 )#(K1 ,z1 ) ·

g2 (z2 | h2 )#(K2 ,z2 )

Y

z1 ∈S1 z2 ∈S2

Y

g1 (z1 | h1 )#(K3 ,(z1 ,z2 )) ·

z1 ∈S1

g2 (z2 | h2 )#(K3 ,(z1 ,z2 ))

z2 ∈S2 z1 ∈S1

P

z2 ∈S2

#(K3 ,(z1 ,z2 ))

z1 ∈S1

=

Y

Y

P

·

g2 (z2 | h2 ) z1 ∈S1 #(K3 ,(z1 ,z2 ))

z2 ∈S2

z2 ∈S2

= L(K1 | h1 ) · L(K2 | h2 ) .

Laut Definition ist ĥi = argmaxh∈Hi L(Ki | h); also:

ĥ3 = argmaxh∈H3 L(K3 | h) = argmax(h1 ,h2 )∈H1 ×H2 L K3 | (h1 , h2 )

= argmax(h1 ,h2 )∈H1 ×H2 L(K1 | h1 ) · L(K2 | h2 ) .

Hier soll ein Produkt maximiert werden, wobei die Parameter für beide Faktoren unabhängig

voneinander gewählt werden können. Dann ist

= argmaxh1 ∈H1 L(K1 | h1 ), argmaxh2 ∈H2 L(K2 | h2 ) = (ĥ1 , ĥ2 ) .

5

(b) In Aufgabenteil (b) der vorherigen Aufgabe ist

• H3 = H, H1 = H2 = {f | f : {Kopf, Zahl} → [0, 1], fi (Kopf) + fi (Zahl) = 1 ,

• S1 = S2 = {Kopf, Zahl}, S3 = {Kopf, Zahl}2 ,

• g3 = g, g1 (z | f ) = g2 (z | f ) = f (z),

• K3 = K

Lediglich die Korpora K1 und K2 sind nicht gegeben. Wir konstruieren sie so, dass

X

#(K1 , z1 ) =

#(K3 , (z1 , z2 )) ,

z2 ∈S2

X

#(K2 , z2 ) =

#(K3 , (z1 , z2 )) .

z1 ∈S1

erfüll ist. Das ist immer möglich. Nun ist klar, dass Aufgabenteil (a) dieser Aufgabe anwendbar

ist und es gilt ĥ3 = (ĥ1 , ĥ2 ). Es genügt also, ĥ1 und ĥ2 zu bestimmen. Es ist leicht ersichtlich,

dass die MLE-Probleme 1 und 2 unbeschränkt sind. Daher muss folgendes gelten:

#(K1 , Kopf)

,

n

#(K2 , Kopf)

,

g2 (Kopf | ĥ2 ) =

n

#(K1 , Zahl)

,

n

#(K2 , Zahl)

g2 (Zahl | ĥ2 ) =

.

n

g1 (Kopf | ĥ1 ) =

g1 (Zahl | ĥ1 ) =

Schließlich erhalten wir, dass ĥ3 = (f1 , f2 ), wobei

#(K, (Kopf, Kopf)) + #(K, (Kopf, Zahl))

,

n

#(K, (Zahl, Kopf)) + #(K, (Zahl, Zahl))

f1 (Zahl) =

,

n

#(K, (Kopf, Kopf)) + #(K, (Zahl, Kopf))

,

f2 (Kopf) =

n

#(K, (Kopf, Zahl)) + #(K, (Zahl, Zahl))

.

f2 (Zahl) =

n

f1 (Kopf) =

(c) Auch im Fall der zwei unabhängigen Würfel können wir die Eigenschaft aus Aufgabenteil (a) dieser Aufgabenstellung nutzen. Dann ist zu einem gegebenen Korpus K das Maximum

Likelihood Estimate ĥ das Paar (f1 , f2 ), wobei fi die relative Häufigkeit von Ki ist, wobei

X

#(K1 , z1 ) =

#(K, (z1 , z2 )) ,

z ∈S

X2 2

#(K2 , z2 ) =

#(K, (z1 , z2 )) .

z1 ∈S1

Lösung 24 Seien X und Y über den Mengen SX und SY definiert. Dann ist e : SX → SY .

Ist für jedes x ∈ SX : P (X = x) = 1, P (X = x) = 0 pder P (Y = e(x)) = 1, dann sind X und

Y unabhängig: wir zeigen, dass dann immer P (X = x, Y = y) = P (X = x) · P (Y = y) (oder

äquivalente Formulierungen). Wir betrachten drei Fälle.

• Wenn P (X = x) = 1, dann ist wegen Übungsaufgabe 8(b) P (Y = y | X = x) = P (Y = y).

6

• Wenn P (X = x) = 0, dann ist wegen Übungsaufgabe 8(b) P (X = x | Y = y) = 0 =

P (X = x).

• Wenn P (Y = e(x)) = 1, dann unterscheiden wir zwei Fälle:

– Wenn y = e(x), dann P (X = x | Y = e(x)) = P (X = x) wegen Übungsaufgabe 8(b).

– Wenn y 6= e(x), dann P (Y = y) = 0 und wegen Übungsaufgabe 8(b) ist P (Y = y |

X = x) = 0 = P (Y = y).

Gibt es ein x ∈ SX mit 0 < P (X = x) < 1 und P (Y = e(x)) 6= 1, dann sind X und Y abhängig:

da X = x die Aussage Y = e(x) impliziert, ist P (Y = e(x) | X = x) = 1 6= P (Y = e(x)) wegen

Übungsaufgabe 2(d).

Lösung 25 Wir bestimmen exemplarisch einen Wert der Wahrscheinlichkeitsfunktion f von

X +Y:

X

f (6) = P (X + Y = 6) =

P (X = x, Y = y)

(x,y)∈e−1 (6)

=

X

P (X = x) · P (Y = y)

(x,y)∈e−1 (6)

= P (X = 1) · P (Y = 5) + P (X = 2) · P (Y = 4) + P (X = 3) · P (Y = 3)

+ P (X = 4) · P (Y = 2) + P (X = 5) · P (Y = 1)

= 0.2 · 0.1 + 0.3 · 0.1 + 0.1 · 0.3 + 0.1 · 0.1 + 0.2 · 0.3

= 0.02 + 0.03 + 0.03 + 0.01 + 0.06 = 0.15 .

Allgemein ist

z

f (z)

2

0.06

3

0.11

4

0.12

5

0.15

6

0.15

7

0.14

8

0.12

9

0.07

10

0.04

11

0.03

12

0.01

Lösung 26

(a) Sei f : N∞ → [0, 1] die Wahrscheinlichkeitsfunktion der Zufallsvariablen e(X1 , X2 , . . .). Sei

n ∈ N (Hinweis: in diesem Beispiel betrachten wir N als die Menge der positiven ganzen Zahlen;

die Null zählt also nicht dazu). Wir bestimmen f (n). Dazu betrachten wir zunächst die Aussage

e(X1 , X2 , . . .) = n. Laut Definition ist sie äquivalent zu

_

(X1 = x1 ∧ X2 = x2 ∧ X3 = x3 ∧ . . .) .

−1

(x1 ,x2 ,...)∈e

(n)

Für die Menge e−1 (n) gilt:

e−1 (n) = (x1 , x2 , . . .) ∈ {K, Z}N | e(x1 , x2 , . . .) = n

= (x1 , x2 , . . .) ∈ {K, Z}N | min{1 ≤ i | xi = K} = n

= (x1 , x2 , . . .) ∈ {K, Z}N | x1 , x2 , . . . , xn−1 = Z, xn = K .

Dann ist e(X1 , X2 , . . .) = n äquivalent zu

_

(x1 ,x2 ,...)∈{K,Z}N (X1 = x1 ∧ X2 = x2 ∧ X3 = x3 ∧ . . .)

x1 ,x2 ,...,xn−1 =Z,xn =K

7

≡

_

(X1 = Z ∧ . . . ∧ Xn−1 = Z ∧ Xn = K ∧ Xn+1 = xn+1 ∧ Xn+2 = xn+2 ∧ . . .)

_

= Z ∧ Xn = K ∧

X

=

x

∧

X

=

x

∧

.

.

.

n+1

n+1

n+2

n+2

(xn+1 ,xn+2 ,...)∈{K,Z}N

= Z ∧ Xn = K ∧ wahr

(xn+1 ,xn+2 ,...)∈{K,Z}N

≡ X1 = Z ∧ . . . ∧ Xn−1

≡ X1 = Z ∧ . . . ∧ Xn−1

≡ X1 = Z ∧ . . . ∧ Xn−1 = Z ∧ Xn = K .

Dann ist

f (n) = P e(X1 , X2 , . . .) = n = P (X1 = Z ∧ . . . ∧ Xn−1 = Z ∧ Xn = K)

= P (X1 = Z) · . . . · P (Xn−1 = Z) · P (Xn = K)

= (1 − p)n−1 · p .

Für den Fall einer fairen Münze ergibt sich f (n) = 2−n .

Es verbleibt, f (∞)

P zu bestimmen. Die Zufallsvariable e(X1 , X2 , . . .) ist diskret, da N∞ abzählbar ist. Dann ist a∈N∞ f (n) = 1, also

f (∞) = 1 −

X

∞

X

f (n) = 1 −

(1 − p)n−1 · p

n=1

n∈N

Wenn p = 0, dann ist jeder Summand 0 und die Summe ist 0; Für diesen Fall gilt also f (∞) = 1.

Ansonsten ist

=1−p·

∞

X

(1 − p)n−1 = 1 − p ·

n=1

∞

X

(1 − p)n

n=0

1

=1−p· =1−1=0.

p

Wenn es also unmöglich ist, mit der Münze Kopf zu werfen (p = 0), dann wird man mit sicherer

Wahrscheinlichkeit unendlich oft Zahl werfen. In allen anderen Fällen wird man mit sicherer

Wahrscheinlichkeit früher oder später Kopf werfen.

(b) Sei f : {0, . . . , n} → [0, 1] die Wahrscheinlichkeitsfunktion der Zufallsvariablen e(X1 , . . . , Xn ).

Sei i ∈ {0, . . . , n}. Wir bestimmen f (i):

_

f (i) = P e(X1 , . . . , Xn ) = i = P

(X1 = x1 ∧ . . . ∧ Xn = xn )

−1

(x1 ,...,xn )∈e (i)

_

=P

(x1 ,...,xn )∈{K,Z}n (X1 = x1 ∧ . . . ∧ Xn = xn )

e(x1 ,...,xn )=i

=P

_

(x1 ,...,xn )∈{K,Z}n (X1

|{1≤j≤n|xj =K}|=i

= x1 ∧ . . . ∧ Xn = xn )

=

X

(x1 ,...,xn )∈{K,Z}n

|{1≤j≤n|xj =K}|=i

P X1 = x1 ∧ . . . ∧ Xn = xn

=

X

(x1 ,...,xn )∈{K,Z}n

|{1≤j≤n|xj =K}|=i

P (X1 = x1 ) · . . . · P (Xn = xn )

=

X

(x1 ,...,xn )∈{K,Z}n

|{1≤j≤n|xj =K}|=i

Y

P (Xj = K) ·

=

X

(x1 ,...,xn )∈{K,Z}n

|{1≤j≤n|xj =K}|=i

Y

p·

1≤j≤n

xj =K

1≤j≤n

xj =K

Y

Y

1≤j≤n (1

xj =Z

8

1≤j≤n

xj =Z

− p)

P (Xj = Z)

=

X

(x1 ,...,xn )∈{K,Z}n

|{1≤j≤n|xj =K}|=i

= pi · (1 − p)n−i ·

X

pi · (1 − p)n−i

(x1 ,...,xn )∈{K,Z}n

|{1≤j≤n|xj =K}|=i

1.

Wie groß ist die Summe? Es ist die Anzahl aller Tupel (x1 , . . . , xn ) ∈ {K, Z}n , so dass an genau

i Positionen in dem Tupel das Element K steht. Es gibt genau ni solche Tupel. Also ist

n

f (i) =

· pi · (1 − p)n−i .

i

Wie immer bei abzählbaren Zufallsvariablen müssen sich die Einzelwahrscheinlichkeiten der

Funktion f zu 1 aufsummieren. Das ist mit Hilfe des Binomischen Lehrsatzes leicht nachzuprüfen:

n

X

i=0

f (i) =

n X

n

i=0

i

· pi · (1 − p)n−i = (p + (1 − p))n = 1n = 1 .

9