Lösungen zu ¨Ubungsblatt 6

Werbung

Informationstheorie, FS 2017

ETH Zürich, Dept. Informatik

Dr. Luis Haug

Nico Gorbach

Lösungen zu Übungsblatt 6

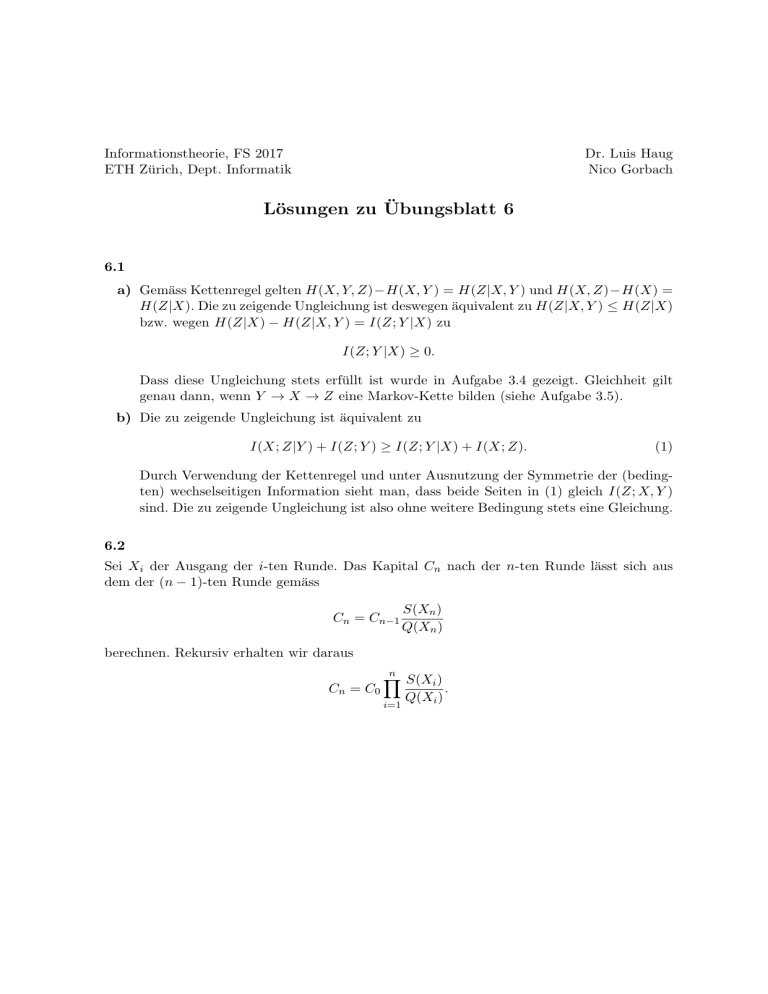

6.1

a) Gemäss Kettenregel gelten H(X, Y, Z)−H(X, Y ) = H(Z|X, Y ) und H(X, Z)−H(X) =

H(Z|X). Die zu zeigende Ungleichung ist deswegen äquivalent zu H(Z|X, Y ) ≤ H(Z|X)

bzw. wegen H(Z|X) − H(Z|X, Y ) = I(Z; Y |X) zu

I(Z; Y |X) ≥ 0.

Dass diese Ungleichung stets erfüllt ist wurde in Aufgabe 3.4 gezeigt. Gleichheit gilt

genau dann, wenn Y → X → Z eine Markov-Kette bilden (siehe Aufgabe 3.5).

b) Die zu zeigende Ungleichung ist äquivalent zu

I(X; Z|Y ) + I(Z; Y ) ≥ I(Z; Y |X) + I(X; Z).

(1)

Durch Verwendung der Kettenregel und unter Ausnutzung der Symmetrie der (bedingten) wechselseitigen Information sieht man, dass beide Seiten in (1) gleich I(Z; X, Y )

sind. Die zu zeigende Ungleichung ist also ohne weitere Bedingung stets eine Gleichung.

6.2

Sei Xi der Ausgang der i-ten Runde. Das Kapital Cn nach der n-ten Runde lässt sich aus

dem der (n − 1)-ten Runde gemäss

Cn = Cn−1

S(Xn )

Q(Xn )

berechnen. Rekursiv erhalten wir daraus

Cn = C0

n

Y

S(Xi )

.

Q(Xi )

i=1

a) Die “Gewinnrate” auf lange Sicht, R∞ = limn→∞ Rn , ist gegeben durch

Cn

n→∞

C0

n

Y

1

S(Xi )

= lim log

n→∞ n

Q(Xi )

R∞ = lim log

i−1

= EP log

=

=

K

X

k=1

K

X

k=1

S(X)

Q(X)

P (k) log

S(k)

Q(k)

P (k)

S(k) P (k) log

+ log

Q(k)

P (k)

= DKL (P kQ) − DKL (P kS).

Das dritte Gleichheitszeichen folgt aus dem Gesetz der grossen Zahlen.

b) An der Gleichung oben sieht man, dass R∞ genau dann maximal ist, wenn DKL (P kS)

minimal ist. Das ist genau dann der Fall, wenn S = P gilt, d.h. wenn der Spieler

seine Einsätze gemäss der wahren Verteilung der Ausgänge platziert. In dem Fall gilt

R∞ = DKL (P kQ).

6.3

a) Wir setzen p := P (a1 ). Dann gilt P (a2 ) = P (a3 ) = P (a4 ) = 1−p

3 . Bei der Konstruktion

des entsprechenden Huffman-Codes werden im ersten Iterationsschritt z.B. a3 und a4

kombiniert; die Summe ihrer Wahrscheinlichkeiten ist 2(1−p)

. Im nächsten Schritt kann

3

daher a1 genau dann mit a2 kombiniert werden, wenn p ≤ 2(1−p)

gilt, was äquivalent

3

2(1−p)

2

2

ist zu p ≤ 5 ; wenn dagegen p >

ist, d.h. p > 5 , ist `1 = 1 garantiert. Die

3

2

gesuchte Zahl ist daher q = 5 . Im Fall p = 25 gibt es z.B. einen Huffman-Code für X

mit Codewörtern {00, 01, 10, 11}; insbesondere gilt `1 = 2.

b) Damit `1 > 1 eintreten kann, muss P (a3 ) + P (a4 ) ≥ P (a1 ) gelten, damit im zweiten

Iterationsschritt der Huffman-Codierung a1 mit a2 kombiniert werden kann. Da auch

P (a2 ) ≥ 1−P3(a1 ) gilt, folgt

1 = P (a1 ) + P (a2 ) + P (a3 ) + P (a4 ) ≥ 2P (a1 ) +

1 + 5P (a1 )

1 − P (a1 )

=

,

3

3

und damit P (a1 ) ≤ 25 = q. Falls P (a1 ) > q gilt, ist `1 = 1 also auch unter der angenommenen Bedingung garantiert.

c) Nach dem ersten Iterationsschritt gibt es drei Knoten, und a1 wird mit einem der

anderen kombiniert, falls P (a1 ) < 31 ist (denn einer der anderen muss dann Wahrscheinlichkeit > 13 haben). Falls dagegen P (a1 ) ≥ 31 ist, ist die Wahrscheinlichkeit der beiden

im Allgemeinen jeweils < 31 , so dass diese kombiniert werden und `1 = 1 gilt. Damit ist

q 0 = 31 der grösste Wert, so dass P (a1 ) < q 0 impliziert, dass `1 > 1 ist.

6.4

1

1

Es gilt 112 = 24 · 7, und daher ensteht ein Huffman-Codebaum für p = ( 112

, . . . , 112

) da1

1

durch, dass wir an die Blätter eines Huffman-Codebaums für ( 7 , . . . , 7 ) jeweils einen für

( 214 , . . . , 214 ) anhängen (natürlich entsteht er bei der Verwendung des Huffman-Algorithmus

nicht so, sondern wird von den Blättern her aufgebaut). Die Wortlängen für ( 17 , . . . , 17 )

sind (2, 3, 3, 3, 3, 3, 3), und die für ( 214 , . . . , 214 ) sind (4, . . . , 4). Ein Huffman-Code für p =

1

1

( 112

, . . . , 112

) hat daher 16 Wörter der Länge 6 und 96 Wörter der Länge 7.