doc

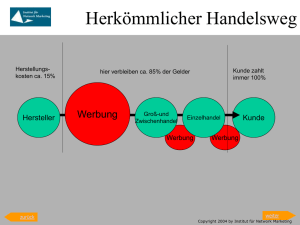

Werbung