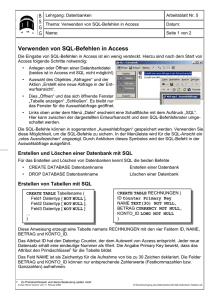

CMD_DWH_Kurzreferenz_V3

Werbung