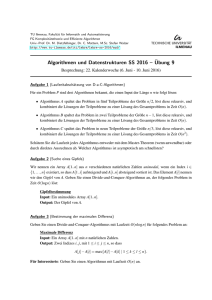

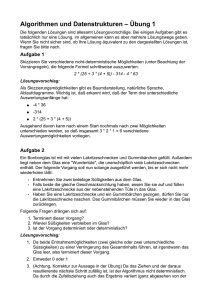

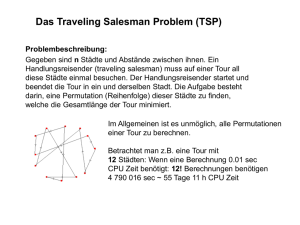

Algorithmen und Datenstrukturen 2

Werbung