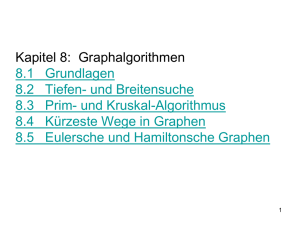

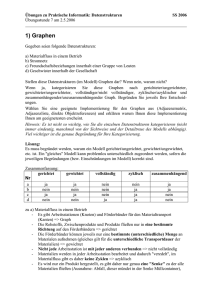

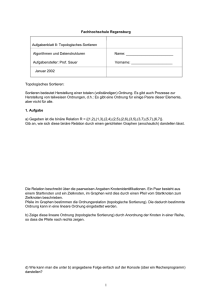

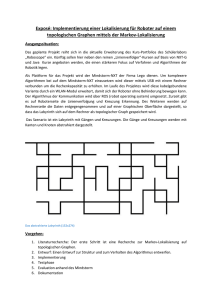

Algorithmische Diskrete Mathematik

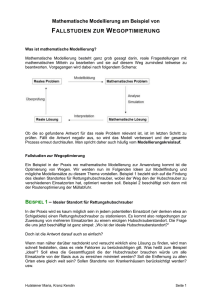

Werbung